简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

Torch.onnx.export执行流程:1、如果输入到torch.onnx.export的模型是nn.Module类型,则默认会将模型使用torch.jit.trace转换为ScriptModule2、使用args参数和torch.jit.trace将模型转换为ScriptModule,torch.jit.trace不能处理模型中的循环和if语句3、如果模型中存在循环或者if语句,在执行tor

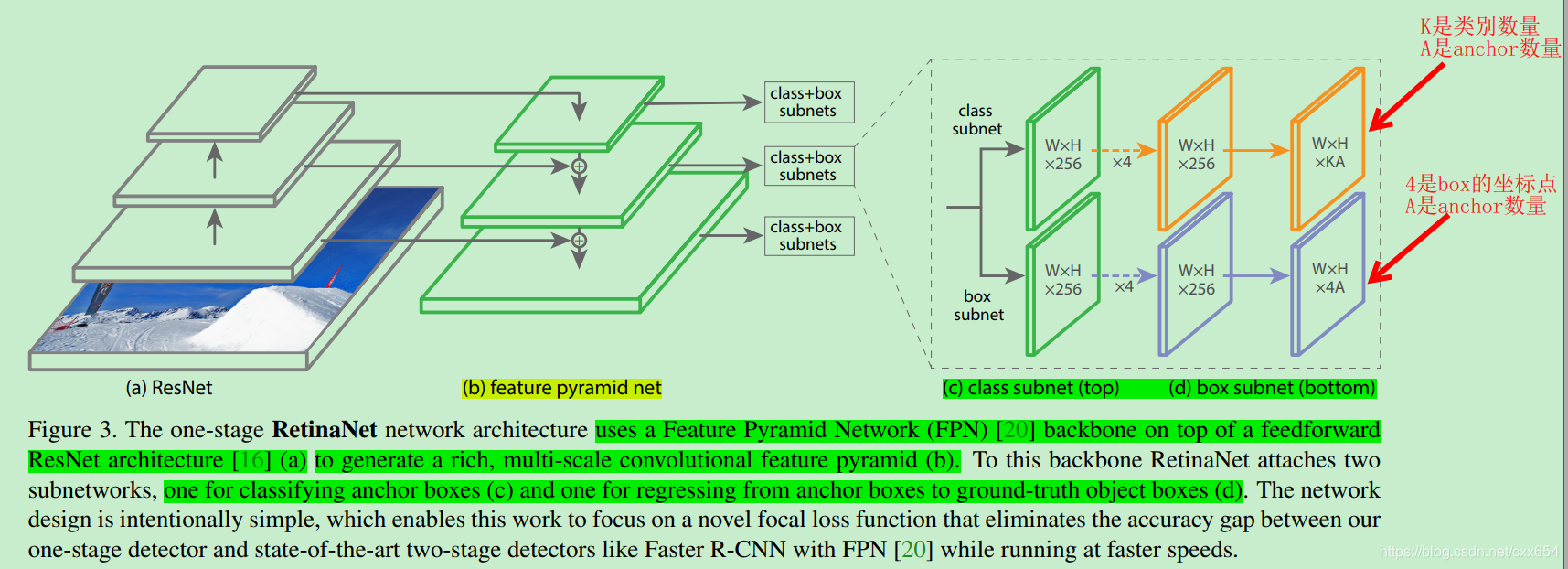

RetinaNet论文主旨思想:1、two-stage目标检测网络,首先RPN网络预测出可能包含目标的区域region proposal,然后使用分类和回归分支进一步确定region proposal区域的类别和bbox,在RPN网络中给出的区域包含目标的概率极大,极大限度的过滤掉了负样本,那么在第二阶段进行精炼预测时,处理的基本上都是正样本,网络更容易学习预测。2、one-stage目标检测网络

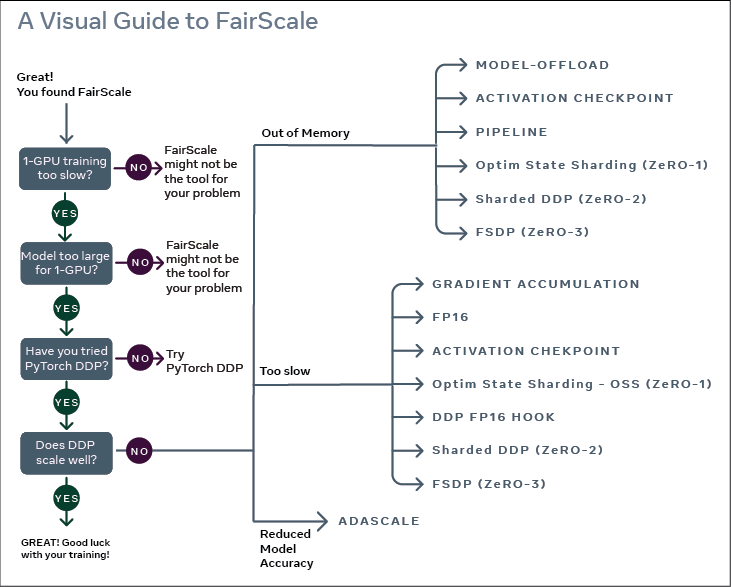

收集到的完整参数将在计算后立即释放,释放的内存可用于下一层的计算。FSDP是一种数据并行训练,但与传统的数据并行训练不同,传统的数据并行训练在每一片GPU上独立维护模型参数、梯度和优化器状态,FSDP可以在多个worker之间将所有这些状态分片,并可以有选择的将分片的模型参数卸载到cpu上。Scatter与Broadcast非常相似,都是一对多的通信方式,不同的是Broadcast的0号节点将相同

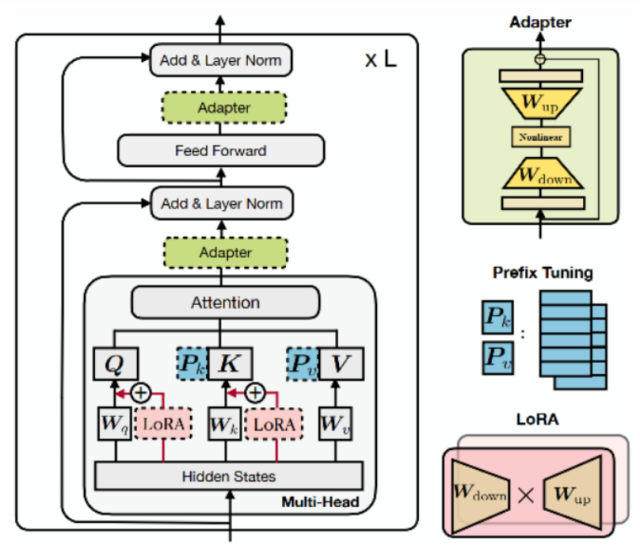

对于Auto-Encoding类型的任务,在模型的训练和预测阶段,self-attention都可以并行计算。在hugging face实现的self-attention模块中,为了复用decode生成阶段的key和value,会传入一个past_key_values参数,如果past_key_values不是None,表示前面时间步已经有计算结果了,直接复用上一步的结果,然后将当前时间步的key

关于AP和mAP的定义可以参考以下链接:参考:https://blog.csdn.net/qq_35916487/article/details/89076570参考:https://zhuanlan.zhihu.com/p/56961620代码来源:https://github.com/rbgirshick/py-faster-rcnn/blob/master/lib/datasets/voc_

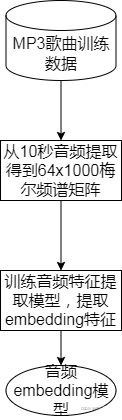

在第二篇中,我们已经从每首歌曲中提取了20个相互之间重合度在50%~97.5%的10秒音乐片段,并将这些片段转换成了大小为[64, 1001]的梅尔频谱矩阵。假如我们现在的训练集中有10000首不同的歌曲,那么我们现在就有20 * 10000共20万个[64, 1001]的训练样本。本篇我们就使用度量学习方法训练模型来提取embedding特征。关于度量学习方法,这里再次强调一下度量学习的几个核心

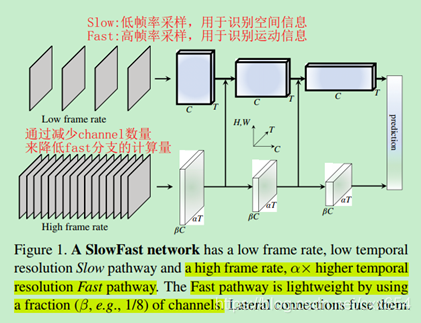

核心思想:Slow Path:低帧率采样,用于识别空间信息。空间语音信息变化缓慢,可以很容易通过空间信息完成类别判断,所以使用低帧率采样就可以。Fast Path:高帧率采样,用于识别运动信息。时间维度运动信息变化较快,为了捕获更强的运动上下文信息,需要使用高帧率采样。生物学启发:论文受到视觉系统的视网膜神经细胞启发,视网膜神经细胞中有80%左右的P-cells用于识别细粒度的空间信息和颜色等,同

以iris数据集合SVM分类器为例,使用sklearn的learning_curve函数绘制分类器的学习曲线,并根据学习曲线判断模型的状态,是欠拟合还是过拟合。1、加载iris数据集2、划分训练集和测试集3、设置超参数C=0.05, gamme=0.1训练SVM模型交叉验证结果准确率0.86,结果好像还不错!!!4、使用learning_curve绘制分类器学习曲线...

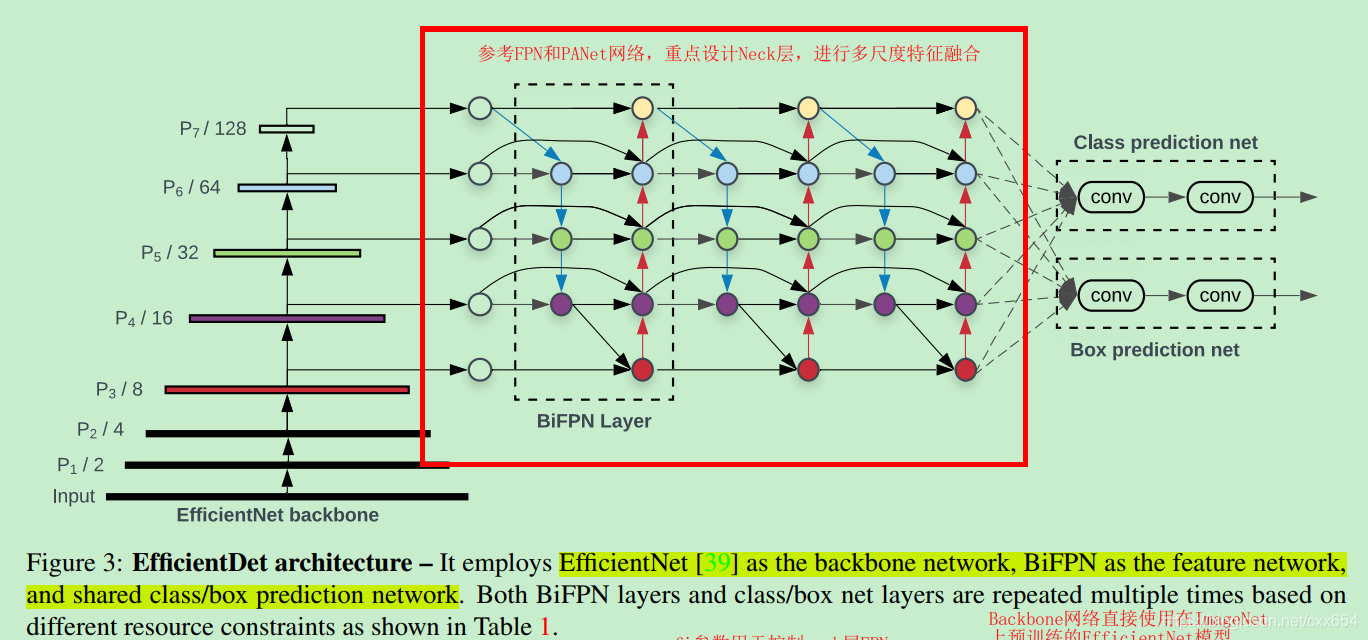

EfficientDet特点:采用了带权重的双向FPN网络BiFPN进行特征融合,并通过模型学习得到不同特征的权重参数,不同的特征融合方式P3-P7,就得到了不同大小的EfficientDet模型提出了对于resolution、depth、width进行联合扩展进行模型尺度缩放,提升模型性能上图中,FPN是特征将金字塔网络,PANet是基于FPN的改进,NAS-FPN是使用网络搜索的方式自动确定特

在知乎上有这样一个问题:acc很高,但预测正确的样本占比又很低,怎么回事? - 知乎关于这个问题,在这个问题的回答中,有许多大佬从数据的分布、模型的结构、数据集的划分,以及验证指标等层面进行了解答。在这里按照我的理解,简单描述一下这个问题:模型训练正常,模型测试效果很差,甚至在训练集上的测试效果都很差。简单分析一下大概有以下几个方面的原因可以排查:1、检查模型训练和模型测试的数据处理pipelin