简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

目标检测概述之前的MTCNN实现了单类多目标的高效检测,而现实中更普遍的任务是多类多目标检测。目标检测可划分为3个发展阶段:传统的目标检测区域选择:滑动窗口特征提取:Harr、SIFT、HOG等特征提取算法分类器:如常用的SVM模型基于滑动窗口的区域选择策略没有针对性,时间复杂度高,窗口冗余;手工设计特征费时费力,且对于多样性的变化没有很好的鲁棒性。基于Region Proposal的深度学习目标

本文目的是用最简单的代码,展示DQN玩游戏的效果,不涉及深度学习原理讲解。毕竟,入门如此艰难,唯一的动力不过是看个效果,装个biu……安装OpenAI的游戏库gympip install gym看一下运行效果import gymenv = gym.make('CartPole-v1')print('State shape:', env.observation_space.shape)print('

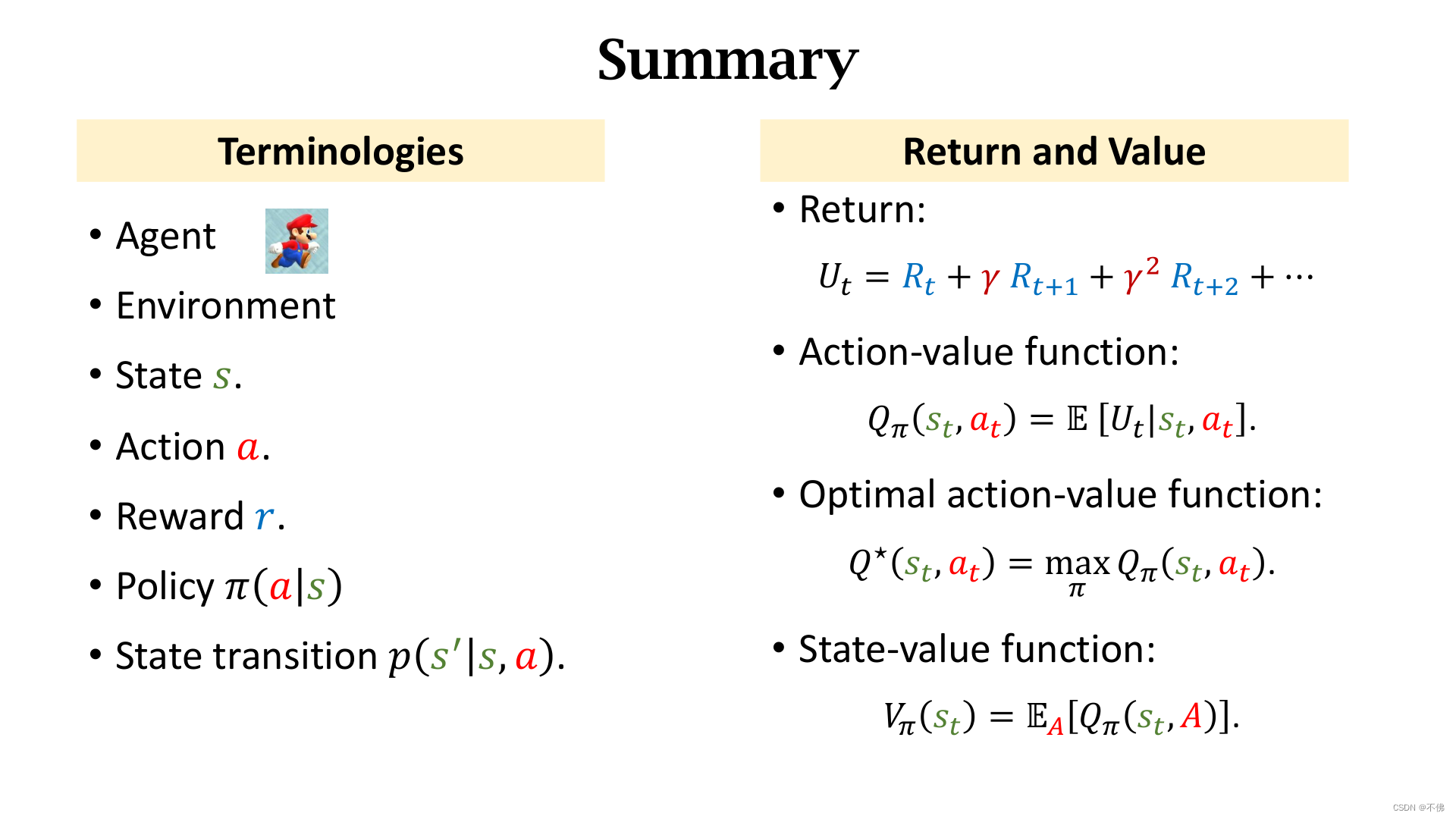

策略学习算法步骤:这里还有一个问题我们一直没有考虑,就是这个QπQ_\piQπ的值怎么算?第一种方法是REINFORCE。因为QπQ_\piQπ的定义是回报UtU_tUt的期望,所以我们可以玩完一局游戏后,把真实观测到的utu_tut作为qtq_tqt的近似。第二种方法是再用一个神经网络来近似QπQ_\piQπ,这就有了两个网络,一个负责动作,一个负责评价,这就是Actor-Criti

用TensorRT部署YOLOv5,用的最多的方式就是通过:https://github.com/wang-xinyu/tensorrtx/tree/master/yolov5步骤和教程都已经很详细了,我只是记录一下遇到的问题。

循环神经网络RNN和长短期记忆网络LSTM的原理,许多文章都讲的很清晰,我就不到处抄了……听说实现车牌识别还挺简单的,来尝试一下叭~首先找车牌图片,虽然有一些生成车牌的软件,但是一般不能批量生成,而且我们还要拿到标签进行训练,好叭,自己先写一个看看。软件生成的车牌:我用最简单的代码生成的车牌:emmm,怎么说呢,假得很有层次感。不管了,先把效果跑出来再说,真实数据集反正咱也没办法,让老板花钱去买好

本文目的是用最简单的代码,展示DQN玩游戏的效果,不涉及深度学习原理讲解。毕竟,入门如此艰难,唯一的动力不过是看个效果,装个biu……安装OpenAI的游戏库gympip install gym看一下运行效果import gymenv = gym.make('CartPole-v1')print('State shape:', env.observation_space.shape)print('

首先,网上有好几个显示中文标签的教程了,我为什么还要写呢?哼,很显然,是觉得他们实现的不够完美嘛~YOLOv5在标签显示上,是花了点心思的,标签字体的大小,会根据图片尺寸进行调整,背景颜色条是为了避免图片中的内容干扰标签的展示,网上有的教程直接把字体大小定死了,背景颜色条也去除了,根本就不合理嘛!完全算不上实现。因为OpenCV不支持中文,所以原代码中用来计算字体尺寸的方法cv2.getTextS

目标检测概述之前的MTCNN实现了单类多目标的高效检测,而现实中更普遍的任务是多类多目标检测。目标检测可划分为3个发展阶段:传统的目标检测区域选择:滑动窗口特征提取:Harr、SIFT、HOG等特征提取算法分类器:如常用的SVM模型基于滑动窗口的区域选择策略没有针对性,时间复杂度高,窗口冗余;手工设计特征费时费力,且对于多样性的变化没有很好的鲁棒性。基于Region Proposal的深度学习目标

首先,网上有好几个显示中文标签的教程了,我为什么还要写呢?哼,很显然,是觉得他们实现的不够完美嘛~YOLOv5在标签显示上,是花了点心思的,标签字体的大小,会根据图片尺寸进行调整,背景颜色条是为了避免图片中的内容干扰标签的展示,网上有的教程直接把字体大小定死了,背景颜色条也去除了,根本就不合理嘛!完全算不上实现。因为OpenCV不支持中文,所以原代码中用来计算字体尺寸的方法cv2.getTextS