简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

其二、Google发布的首个预大模型BERT,从而引爆了预练大横型的潮流和的势,BERT强调了不再像以往一样采用传统的单向语言模型或者把两个单向语言横型进行浅层拼接的方法进行预认训练,而是采用新的masked language model(MLM),以致能生成深度的双向语言表征。GPT-3:OpenAI发布的首个百亿规模的大模型,应该非常具有开创性意义,现在的大模型都是对标GPT-3,GPT-3依

PyTorch 是 Facebook 发布的一款非常具有个性的深度学习框架,它和 Tensorflow,Keras,Theano 等其他深度学习框架都不同,它是动态计算图模式,其应用模型支持在运行过程中根据运行参数动态改变,而其他几种框架都是静态计算图模式,其模型在运行之前就已经确定。在 PyTorch 中 Tensor 代表多维数组,类似 TensorFlow 中的 matrix...

而且是目前对此方面研究最新的综述。

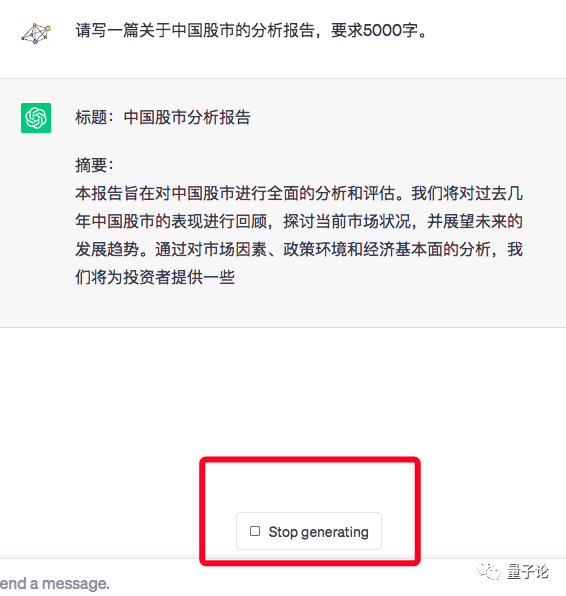

之前 AutoGPT 大火,很多人尝试用它来分析金融数据、自动编写爬虫脚本、抓取数据做市场调研、生成可视化报告等等。但是,由于 AutoGPT 做的是一个通用性实验方案,因此很多东西在定制性上比较差,这就导致脚本在实际运行中,会出现很多不可控因素。比如,脚本会自动给你生成一堆乱七八糟的文件,跑了半天还是没抓到重点,每次运行都需要重新再来一遍,内容产出性价比很低等等。

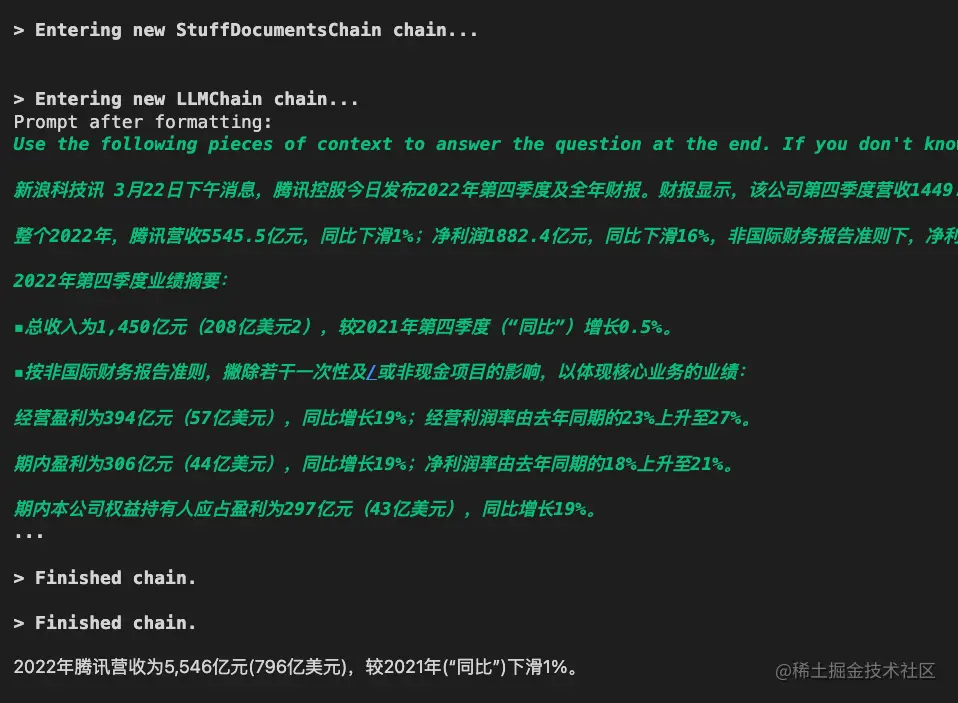

本文使用LangChain+ChatGLM来实现一个简单的基于本地知识库的问答系统,可以在完全不使用openai提供的api来完成本地知识库问答系统的搭建,如果有需要做本地私有化知识库问答系统的,可以参考此方案。

之前 AutoGPT 大火,很多人尝试用它来分析金融数据、自动编写爬虫脚本、抓取数据做市场调研、生成可视化报告等等。但是,由于 AutoGPT 做的是一个通用性实验方案,因此很多东西在定制性上比较差,这就导致脚本在实际运行中,会出现很多不可控因素。比如,脚本会自动给你生成一堆乱七八糟的文件,跑了半天还是没抓到重点,每次运行都需要重新再来一遍,内容产出性价比很低等等。

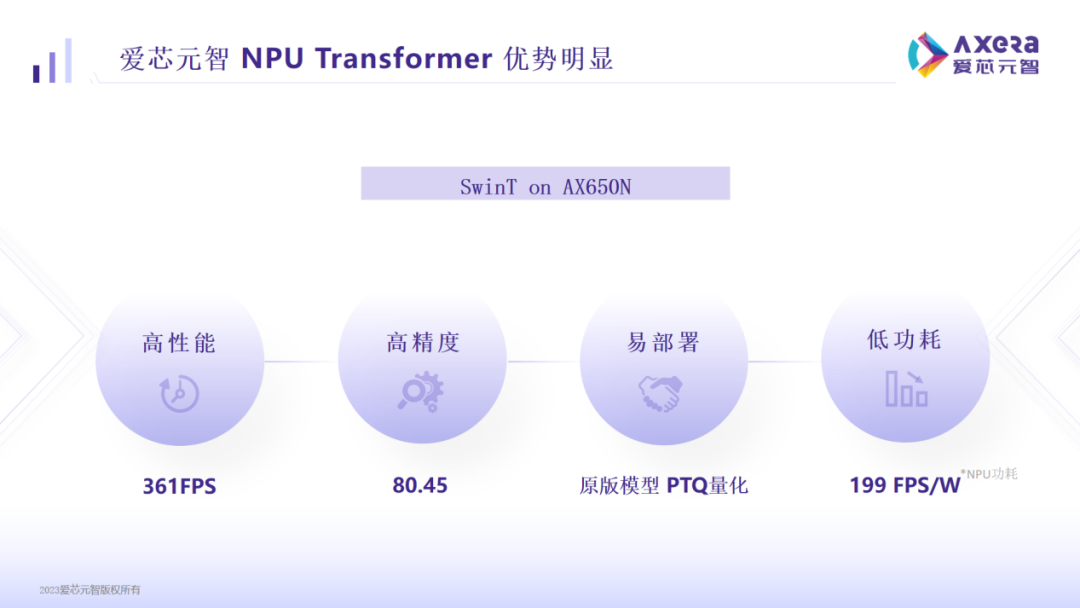

在模型压缩方面,前文中我们提到了一些在算法层面的压缩方法,如剪枝、稀疏等,爱芯元智联合创始人、副总裁刘建伟指出,低比特也是压缩模型的一个方法,而且是对硬件最友好(便宜)的方式。2023年3月,爱芯元智推出了第三代高算力、高能效比的SoC芯片——AX650N,依托其在高性能、高精度、易部署、低功耗等方面的优异表现,AX650N受到越来越多有大模型部署需求用户的青睐,并且成为业内首屈一指的Transf

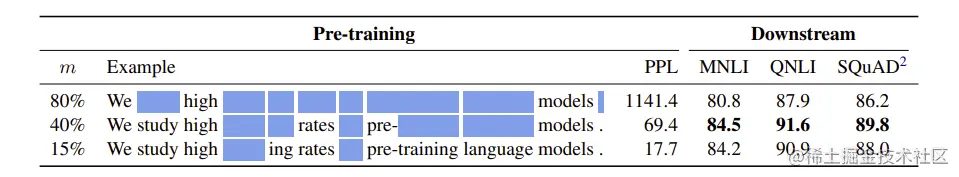

具体来说,最有效的修改是 N-gram mask 和相似的单词替换,这是对 mask 的语言模型任务的修改。令人惊讶的是,我们发现 40% 的遮蔽概率的输入序列可以优于 15% 的基线,通过对下游任务的微调来衡量可以发现,甚至遮蔽 80% 的字符也可以保留大部分性能。huggingface 中 data allcator 使用的是动态 mask,但不是复制数据,而是每一个 epoch 的 mask

其二、Google发布的首个预大模型BERT,从而引爆了预练大横型的潮流和的势,BERT强调了不再像以往一样采用传统的单向语言模型或者把两个单向语言横型进行浅层拼接的方法进行预认训练,而是采用新的masked language model(MLM),以致能生成深度的双向语言表征。GPT-3:OpenAI发布的首个百亿规模的大模型,应该非常具有开创性意义,现在的大模型都是对标GPT-3,GPT-3依

在这个AI能力飞速提升的时代,不少人正处迷茫之中:我对人工智能需要了解到何种程度?