简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

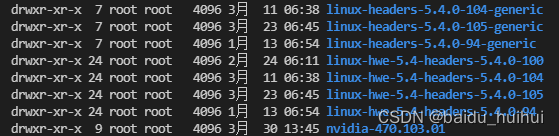

这是由于重启服务器,linux内核升级导致的,由于linux内核升级,之前的Nvidia驱动就不匹配连接了,但是此时Nvidia驱动还在,可以通过命令。如果失败了,别急,接着往下看>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>如果安装失败了,请跟者本文走>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>此时,我们需要把新安装的

之前一直在linux上用nvidia-smi查看显卡的使用相关情况,但是在windows的命令行下却用不了,但是本地明明已经安装了NVIDIA的显卡,这种情况往往就是因为没有添加环境变量!!!一、分析原因如果你已经在Windows系统中安装了NVIDIA的驱动,但是windows的命令行中输入nvidia-smi命令之后显示如下错误:'nvidia-smi' 不是内部或外部命令,也不是可运行的程序

怎么进入华为路由器终端管理系统知道合伙人互联网行家2016-12-15一、物理连接1、将配置电缆DB-25插头接到要对路由器进行配置的电脑串口上。2、将配置电缆的RJ-45一端连到路由器的Console口上。二、设置电脑参数1、打开电脑,在电脑上运行终端仿真程序,Windows的超级终端。2、设置终端参数,设置波特率为9600,数据位为8,奇偶校验为无,停止位为1,流量控制为...

别再把 AI 当聊天工具了!2025 年,真正能替你“动脑又动手”的 AI 智能体已悄悄上岗:从帮你一键扒视频文案,到自动做海报、剪书单号,甚至 15% 的职场决策都将由它们代劳。这篇零基础入门指南,只用 5 分钟带你穿越 70 年进化史,看懂智能体到底“智”在哪;再送 6 步搭建流程+100 个即用模板,让你零代码也能拥有自己的数字员工。

aarch64-linux-gnu作为一种新的架构,在移动设备和嵌入式系统等领域得到了广泛应用。在开发过程中,需要搭建相应的开发环境,并且需要注意与arm-linux-gnueabi存在的不兼容性。虽然会遇到一些问题,但是技术社区提供了许多支持和理解,最终我们可以编写出高效、高质量的程序。

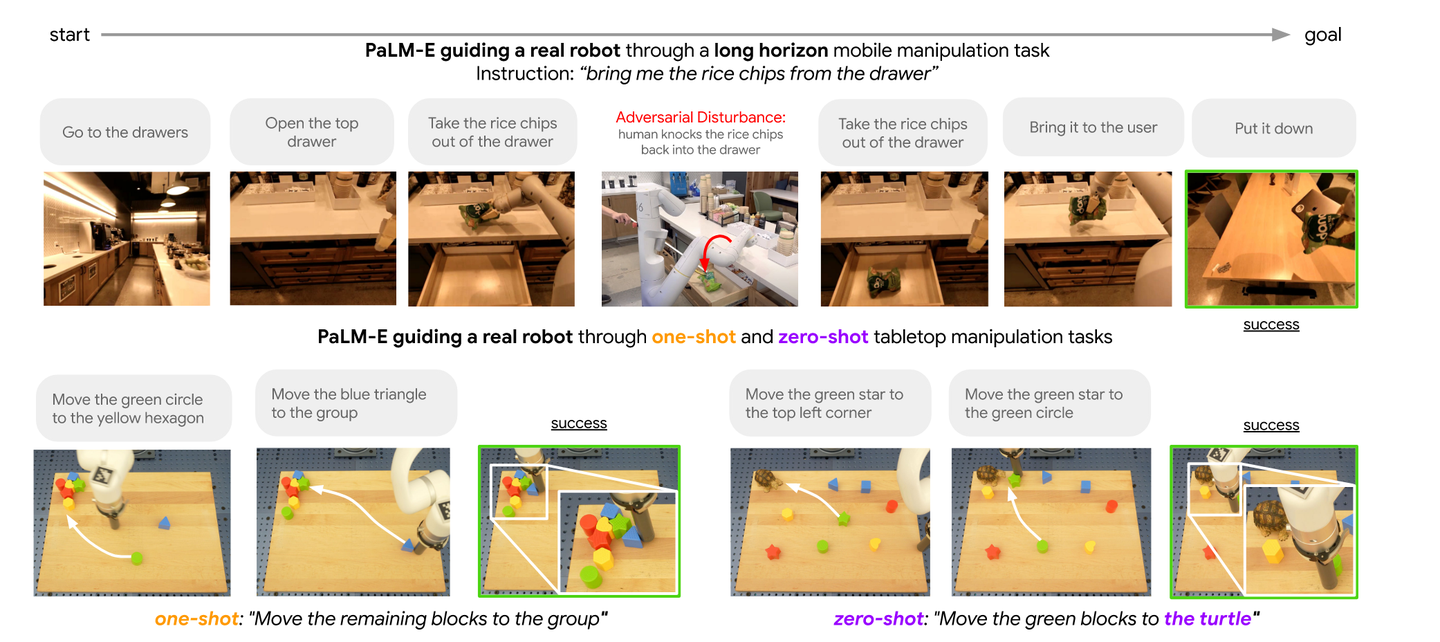

大型语言模型已被证明可以执行复杂的任务。然而,在现实世界中实现一般推理,例如机器人问题,会带来接地气的挑战。论文提出了具体化的语言模型,以将真实世界的连续传感器模态直接结合到语言模型中,从而建立单词和感知之间的联系。具体语言模型的输入是多模态语句,它们交织了视觉连续状态估计和文本输入编码。结合预训练的大型语言模型,对这些编码进行端到端训练,用于多个具体任务,包括顺序机器人操作规划视觉问题解答和图像

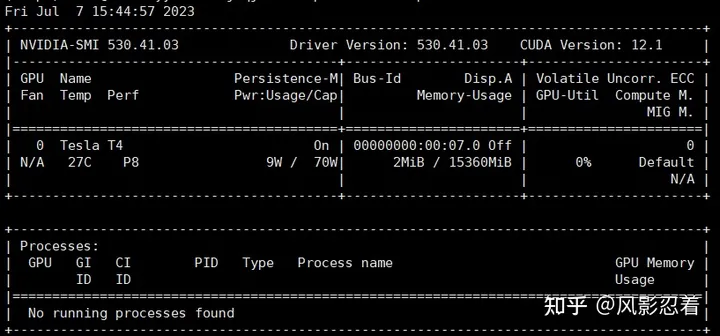

目录一、安装显卡驱动二、安装 CUDA三、配置 CUDA 的环境变量四、安装 cuDNN五、检查 CUDA、cuDNN 是否安装成功六、卸载 CUDA首先确认电脑上安装了 NVIDIA 显卡。

通过一段时间的项目实践和agent学术研究的学习,可以明显的感受agent已经成为构建数字生产力的重要技术路径,它的主要突破在于,本身贴合强化学习理念的"行动-反馈"机制与大模型的推理能力的配合使用,实现了“1+1>>2”的组合效应。

CNTK与深度强化学习笔记之二: Cart Pole游戏示例前言前面一篇文章,CNTK与深度强化学习笔记之一: 环境搭建和基本概念,非常概要的介绍了CNTK,深度强化学习和DQN的一些基本概念。这些概念希望后面还有文章继续展开深入:),但是只看理论不写代码,很容易让人迷惑。学习应该是一个理论和实践反复的过程。上一章的公式太多,这一章没有公式,只有代码。建议大家这两章来回看,把理论和代码对应起来。我

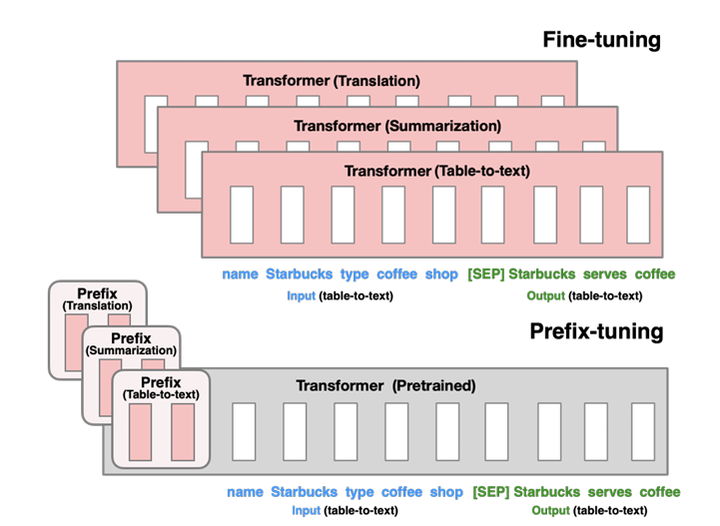

以上这些 PEFT 方法,都是在原来模型参数之外,添加不到原参数量 1% 的参数。在这些新添加的参数上做微调,很多时候就可以媲美全参数微调了。以我个人经验来说,LoRA 和 QLoRA 是现在比较常用的,库也很好地支持了这两种方法。像是 Adapter 以及基于 pseudo soft prompt 的一些方法比较少会用到。【一家之言,欢迎评论区交流】一些论文几篇博文解密Prompt系列3. 冻结