简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

OpenManus 定位为通用型开源 AI 智能体框架,旨在复刻商业产品 Manus 的核心能力,降低 AI Agent 开发门槛,支持单 / 多智能体(实验性)协作,适合快速原型验证与二次开发,助力开发者构建自主执行复杂任务的 AI 代理。

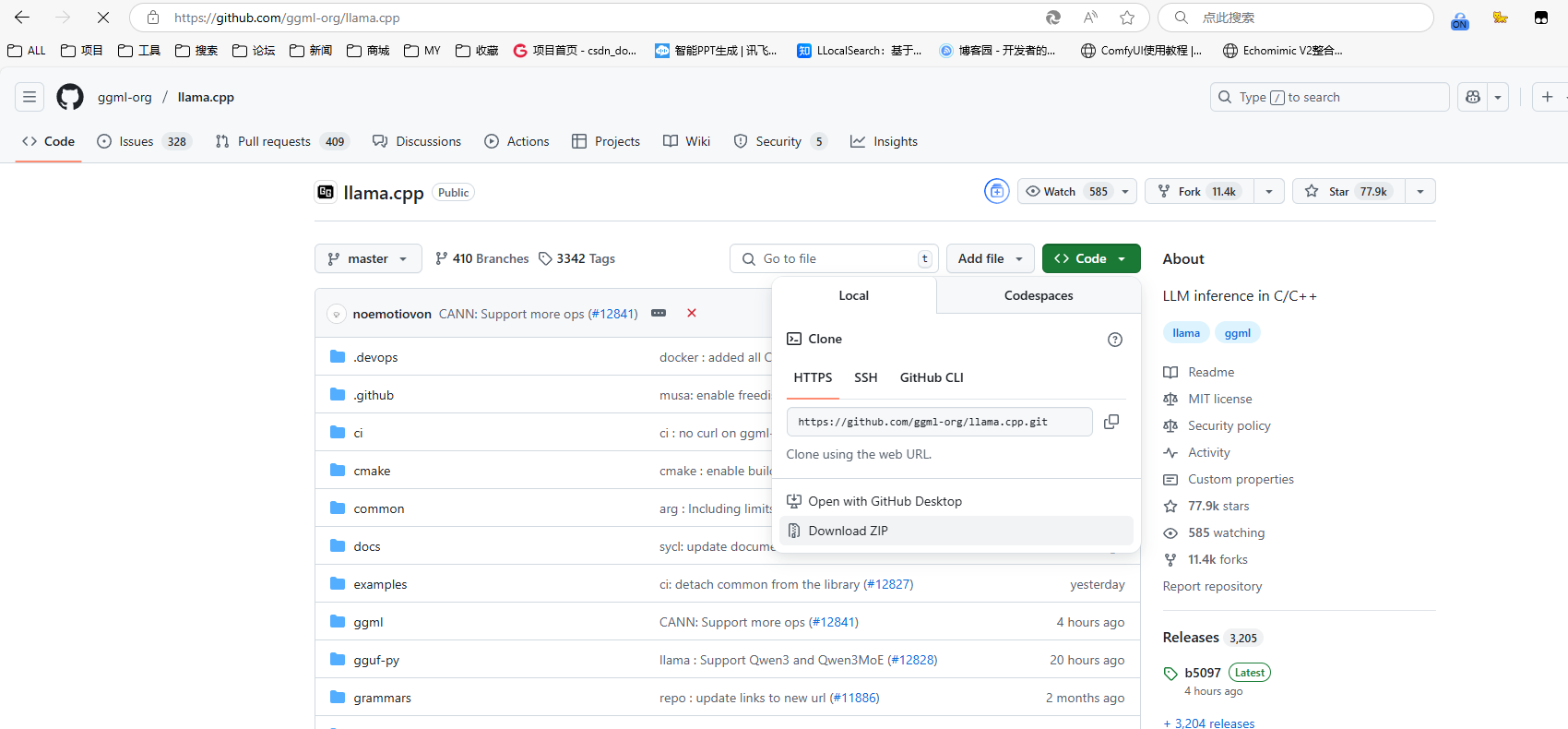

llama.cpp进行转换大模型格式

可视化工作流编排:通过零代码拖拽式界面,无需编写代码就能构建复杂的AI工作流程,降低开发门槛,提高开发效率。多模型支持:可无缝集成GPT系列、Llama、Mistral等数百种语言模型,兼容OpenAI API兼容的私有化模型,也支持本地部署的LLaMA2、ChatGLM3等开源模型,让企业能根据业务需求和成本灵活选择。RAG增强检索。

如果上传了附件需要调用解析文件的插件,该插件只支持域名链接的文件地址,不支持ip格式的地址。需求:整合用户需求+文件内容,要求支持上传文件附件。添加一个大模型用户整合用户需求以及文件的内容。选择器判断是否需要解析文件。

先查看是不是自己防火墙的问题,我这里防火墙的端口都已开放了不是这个问题。找到dify的api容器 和 xinference容器。,以后哪个容器访问不到它,就将它加入一下相关网络就行。访问不到,但是我在浏览器和服务器上访问时可以访问的。

官网首页直接提供的Desktop脚本安装,只能够个人使用,无法多人使用。方式进行安装可以满足多人同时使用。我这里的模型是 本地。

要使用python依赖来更新ComfyUI,只有在python依赖有问题时才需要运行此命令。:用于更新ComfyUI,如果官网有ComfyUI最新版本运行此脚本进行更新升级。:插件节点的安装目录,如果有需要的插件从github上下载下来解压到此目录即可。下载后解压,双击运行 run_cpu.bat。目录下,自己下载好模型后放到对应的文件夹下。文件夹下的命令时用来跟新ComfyUI相关的。Comfy

也可以用收费的模型,只需要把API的KEY拿过来。API_KEY:从deepseek官网申请。还有其他的功能,大家可以探索探索。可以使用免费的大模型引擎。

Ollama 是一个本地运行大型语言模型的简易框架,支持一键安装和部署。文章提供了 Linux环境下的 Docker 安装配置、Ollama 容器部署、Deepseek 模型下载以及 Open WebUI 可视化界面安装等功能,简化了本地大模型的运行流程。安装完成后,用户可通过指定端口访问 Ollama 服务和 Web 管理界面。

ollama是一个简明易用的本地大模型运行框架,只需一条命令即可在本地跑大模型。开源项目,专注于开发和部署先进的大型语言模型(LLM)1b是10亿参数,通常1B,意味着需要机器需要1G以上的内存,大的数据通常在需要更高性能的任务中使用。Python3.13.0版本安装open-webui时报错。默认是7b,但是需要切换下,这样右边的命令参数才会变。双击下载的OllamaSetup.exe,无脑安装