简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

文章摘要: yield关键字用于创建生成器函数,这种函数不会一次性执行完毕,而是可以暂停和恢复执行。生成器通过yield返回一个值并暂停,下次调用时从上一次暂停处继续执行。与普通函数不同,生成器保存了函数状态,实现了惰性计算。yield from语法可以简化生成器嵌套。生成器典型应用包括:处理大文件流(逐行读取避免内存不足)、生成无限序列、构建数据处理管道等。生成器还支持双向通信,通过.send(

相对于深度学习,传统机器学习的流程往往由多个独立的模块组成,比如在一个典型的自然语言处理(Natural Language Processing)问题中,包括分词、词性标注、句法分析、语义分析等多个独立步骤,每个步骤是一个独立的任务,其结果的好坏会影响到下一步骤,从而影响整个训练的结果,这是非端到端的。而深度学习模型在训练过程中,从输入端(输入数据)到输出端会得到一个预测结果,与真实结果相比较..

小科普人工智能(Artificial Intelligence),英文缩写为AI。它是研究、开发用于模拟、延伸和扩展人的智能的理论、方法、技术及应用系统的一门新的技术科学。人工智能是计算机科学的一个分支,它企图了解智能的实质,并生产出一种新的能以人类智能相似的方式做出反应的智能机器,该领域的研究包括机器人、语言识别、图像识别、自然语言处理和专家系统等。人工智能从诞生以来,理论和技术日益成熟,应用领

数据增广是提升模型泛化能力重要的手段之一,CopyPaste 是一种新颖的数据增强技巧,已经在目标检测和实例分割任务中验证了有效性。利用 CopyPaste,可以合成文本实例来平衡训练图像中的正负样本之间的比例。相比而言,传统图像旋转、随机翻转和随机裁剪是无法做到的。这样就比较好地提升了样本丰富度,同时也增加了模型对环境的鲁棒性。如下图所示,通过在左下角的图中裁剪出来的文本,随机旋转缩放之后粘贴到

error: Microsoft Visual C++ 14.0 or greater is required. Get it with “Microsoft C++ Build Tools”: https://visualstudio.microsoft.com/visual-cpp-build-tools/对于 error: Microsoft C++ Build Tools 报错问题,大多数

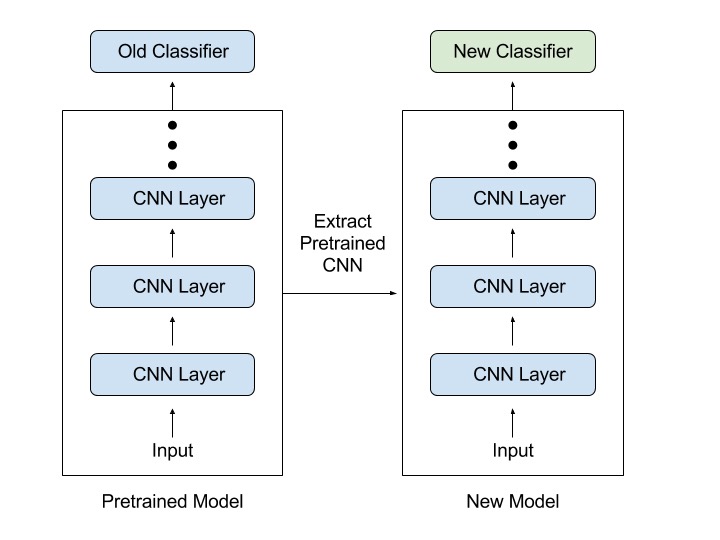

迁移学习的训练策略:1、先冻结卷积层只训练全链接层,这一步需要把结果最好的那个模型保存起来。2、加载上一步保存的那个最优模型,在这个模型的基础上,再以更小的学习率训练所有层,更新网络的所有权重参数,微调,并且学习率衰减,以达到更好的效果。 当自己的数据集少的时候,可以除了最后几层用作初始化,前面层的权值进行微调,一般不进行大的更改,冻住参数;当自己的数据集中的时候,只冻住前面 1/2 层的参数,后

在深度学习训练中,我们经常遇到 GPU 的内存太小的问题,如果我们的数据量比较大,别说大批量(large batch size)训练了,有时候甚至连一个训练样本都放不下。但是随机梯度下降(SGD)中,如果能使用更大的 Batch Size 训练,一般能得到更好的结果。那么问题来了:当 GPU 的内存不够时,如何使用大批量(large batch size)样本来训练神经网络呢?这篇文章将以 PyT

PaddleOCR 算是OCR算法里面较好用的,支持的内容多,而且社区维护的好(手把手教你,生怕你学不会),因此在国内常采用。目前已经更新到 2.8版本了,功能更加丰富、强大;目前支持通用OCR、表格识别、图片信息提取以及文档场景信息提取,基本覆盖了常用的场景首先下载模型代码需要视频课程的可以看。

1、自定义 Params Pytorch依据其内建接口自己写代码获取模型参数情况,大家可以参考Pytorch提供的model.parameters() 接口来获取相应参数的size来实现,对于该参数是否属于可训练参数,那么可以依据Pytorch提供的requires_grad标志位来进行判断,具体方法如下代码所示:

Transformer 是 Google 的团队在 2017 年提出的一种 NLP 经典模型,现在比较火热的 Bert 也是基于Transformer。Transformer 模型使用了 Self-Attention机制,不采用RNN顺序结构,使得模型可以并行化训练,而且能够拥有全局信息。一切从 Self-Attention 开始1.1 处理Sequence数据的模型:Transformer是一个