简介

该用户还未填写简介

擅长的技术栈

未填写擅长的技术栈

可提供的服务

暂无可提供的服务

Scala编写Kafka连接程序

pom.xml<dependencies><!-- 导入scala的依赖 --><dependency><groupId>org.scala-lang</groupId><artifactId>scala-library</artifactId><version>${scala.vers

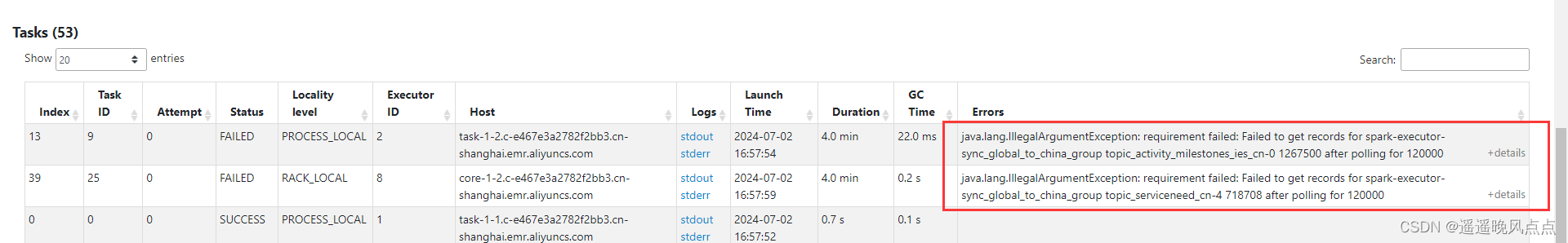

SparkStreaming直连kafka报错:requirement failed: Failed to get records for spark-executor-xxx topic_xxxx

依次排查后,确认是kafka服务端网络问题,因为sparkStreaming连接kafka走得是公网,数据量大网络不稳定是常有的情况,由于超过spark.streaming.kafka.consumer.poll.ms设置的120s时长,task没获取到对应的topic分区的数据,就会导致类似连接超时的异常,那这个task就fail掉了。:奇了怪了,这个任务之前一直在生产上跑的好好的,突然今天发现

hive SQL struct类型和Array<struct>类型转json字符串

数据格式:default_address是struct类型,address是Array<struct>类型:例如:array<struct<id:string,customer_id:string>>目标格式:[{"id": "1111","customer_id": "2222"},{"id": "3333","customer_id": "444

到底了