简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

Meta 杨立昆团队“最难LLM评测榜”加州大学伯克利分校工具准确性评测。谷歌提出的指令理解测试。

整个过程采用 JSON 格式的消息进行数据传输,这样做的好处是确保了上下文在多次交互中得以保持,实现了“连续对话”的功能,而不仅仅是一次性 API 调用。:技术社区出现首批基于Claude 3.5 + MCP的应用案例,如通过MCP协议实现Claude与本地文件系统、数据库的自动化交互。通过这种架构,MCP 协议消除了传统上每种数据源都需要单独集成的繁琐步骤,使得 AI 应用能够通过统一的接口与各

当前大家对AI的使用热情高涨,deepseek因为其在大模型中的优秀表现而被大家熟知。但最近其官网服务的承载能力显然满足不了大家不断增长的使用需求,经常出现稍后重试的情况。同时也有人希望能自己来部署大模型,使用RAG,满足特定需求。但大模型对服务硬件配置的高要求,使得很多人无法自己在自己电脑上运行一个基本能玩的大模型。那么寻找免费的云服务就是一个很自然的选择,很多云厂商都有免费资源可供短期使用。这

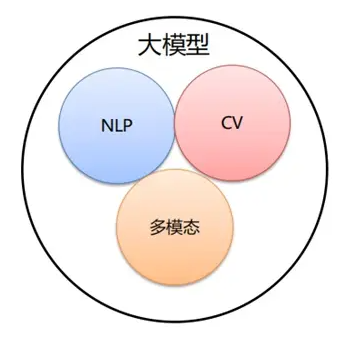

大模型是指具有大规模参数和复杂计算结构的机器学习模型。本质上是一个使用海量数据训练而成的深度神经网络模型,拥有数十亿甚至数千亿个参数,其巨大的数据和参数规模,实现了智能的涌现展现出类似人类的智能。大模型有用例写作思路,可以输出覆盖主要流程的测试用例,并具有可执行性但只有豆包等部分大模型可满足需要,其他大模型输出效果不佳实际业务prd中截图等内容,大模型识别不够全面,因此逻辑上需要人工干预输出的结果

这里对大模型评测需要关注的一些内容做了分类和细化,希望能带来一些借鉴参考。

谷歌在Google Cloud Next 25大会上(4月9号),开源了首个标准智能体交互协议Agent2Agent Protocol(简称A2A)。这是一种开放式互操作性协议,旨在实现跨不同框架和供应商的 AI 代理之间的无缝协作。A2A 得到了包括 Salesforce、SAP、ServiceNow 和 MongoDB 在内的 50 多家技术合作伙伴的支持,为 AI 代理提供了一个通用框架,使

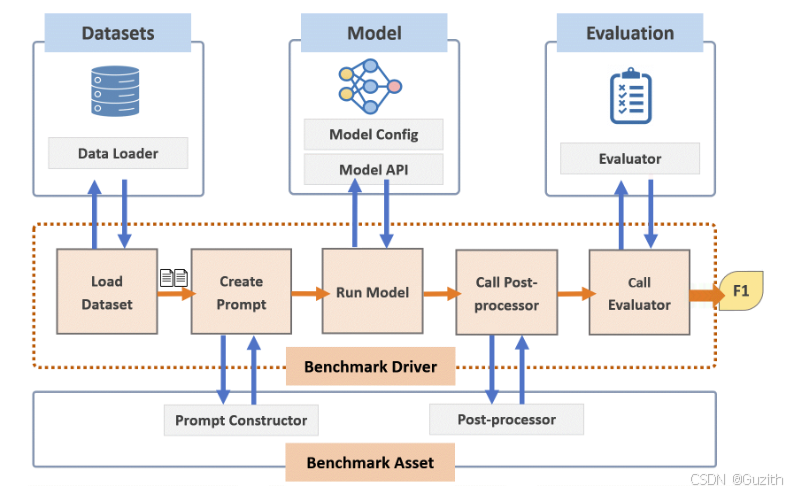

例如,为了评估医学知识理解能力,可以选择医学文本分类、医学实体识别等任务。在进行大模型基准测试时,首先需要确定测试的指标体系,明确评测的维度和对应指标。例如,医学问答模型需要具备医学知识理解、问题理解、答案生成等能力。例如,对于医学文本分类任务,可以选择准确率、F1分数等指标。根据模型的应用目标,确定需要评测的场景。例如,若要评测一个医学问答模型,则场景为医学问答。对评测结果进行分析,评估模型在不

在大模型评测过程中首先明确的是评测目的,在之前提过比较常见情形,比如大模型研发人员、使用者和评测机构他们关注的方向不同,导致评测的目的也不一样。确定评测目的,就基本可以确定评测的范围,是做全面评估还是做特定场景的验证。选择做评测的大模型不同(通用的、垂直的还是其他)评测的方向也不同。确定评测的方向时,关注的是哪些能力哪些性能,针对关注的内容确定评测的指标。然后是确定评测分数的计算方式,这里和策略倾

前面基本把整个基准评测体系讲完了。有了评测体系,可以按照步骤一步步去执行。不过在实际执行过程中还有许多细节需要注意,同时还有一些挑战需要我们去应对。这里简单做一下介绍,这样对大模型评测能有更进一步的认识。

一、性能评测工具1.深度学习框架自带的评测工具PyTorch:它提供了如库,该库包含了一系列用于评估模型性能的指标计算函数。例如,在分类任务中可以方便地计算准确率(Accuracy)、精确率(Precision)、召回率(Recall)和 F1 - score 等。以计算准确率为例,使用函数,只需将模型的预测结果和真实标签传入,就能快速得到准确率的值。TensorFlow:它有模块,提供了多种用于