简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

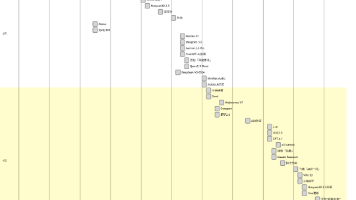

文章摘要:大模型可通过简单提示词直接生成各类Mermaid图表(思维导图、架构图、泳道图等),无需人工修改。其工作原理是:输入文本→AI生成Mermaid代码→代码渲染成图。Mermaid作为基于JavaScript的图表工具,能以极简代码创建复杂图表。相比传统制图软件(如Xmind)需要长期学习,现在只需向AI描述需求即可快速生成专业图表。目前大模型的编程能力越强,生成的图表完成度和美观度越高。

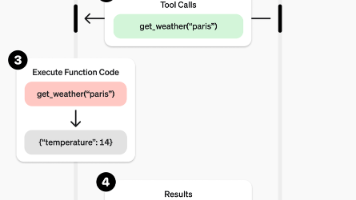

对大模型而言,不能满足人们需求关键问题有二:一是大模型的知识更新问题:大模型存在知识更新问题,大模型在训练完成后,其知识也已固化无法更新。因此通过提示工程及RAG技术(本质上也是提示工程的一种)把新知识输入到大模型中。但这还远远不够,比如获取实时信息(例如天气、数据检索等)、执行相关任务(例如发送邮件、自动化任务等),因此又提出了Function Calling技术,通过程序调用的方式让大模型自动

本文介绍了大模型上下文协议(MCP)及其在天气信息查询中的应用。MCP是一种标准化协议,允许大语言模型与外部系统安全交互,提供实时数据访问和复杂操作执行能力。相比传统API调用方式,MCP具有安全性高、集成简单、支持双向通信等优势。文章通过一个实战项目详细展示了如何基于MCP开发天气查询工具,包括服务器和客户端实现,以及使用MCPInspector进行调试的过程。该工具可查询城市天气预警和未来天气

对大模型而言,不能满足人们需求关键问题有二:一是大模型的知识更新问题:大模型存在知识更新问题,大模型在训练完成后,其知识也已固化无法更新。因此通过提示工程及RAG技术(本质上也是提示工程的一种)把新知识输入到大模型中。但这还远远不够,比如获取实时信息(例如天气、数据检索等)、执行相关任务(例如发送邮件、自动化任务等),因此又提出了Function Calling技术,通过程序调用的方式让大模型自动

本文系统介绍了大语言模型应用中的关键技术概念:Agent(智能体)是基于LLM结合外部工具完成复杂任务的实体;FunctionCalling是让LLM生成结构化指令调用外部函数的机制;MCP是标准化模型与工具连接的协议;A2A则实现了不同Agent间的协作。文章通过天气查询示例展示了Agent工作流程,分析了各项技术的必要性及相互关系:FunctionCalling/MCP解决工具调用问题,而A2

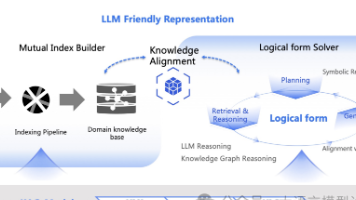

KAG框架(Knowledge Augmented Generation)旨在提升检索增强生成(RAG)技术在多跳任务和跨段落任务中的性能,特别是在法律、医学和科学等需要分析推理的专业领域。RAG技术通过外部检索系统提升大语言模型的时效性并减少模型幻觉,但在生成文本的连贯性和逻辑性方面仍有不足。KAG框架通过整合知识图谱和RAG技术,提出KAG-Builder、KAG-Solver和KAG-Mod

还记得三月初的时候 Manus 刚刚发布轰动全球,产生了一码难求的局面,甚至在某鱼上一个激活码被炒到天价,接近六位数。短短两个月过去了,很多公司也都跟进了这方面,比如 Coze 平台推出的扣子空间,上来就让大家免费使用。Manus 应该也是反应过来了,再不开放用户就都要丢失了。不过目前国内版的 Manus 还是在开发中,国际版的 Manus 已经免费开放给所有用户使用。

人类之间的沟通大量基于长期已有认知,即便表达存在模糊性也仍然可以顺畅理解对方意思。特别在网络时代,大量图像的输入以及如网络用语、“梗”的使用导致对语言表达的偏废,也就导致缺乏主动寻求意义的动力。因此,在人工智能时代,如何表达精准成为人类需要学习的与人工智能对话的最基本要领。将人工智能大语言模型用于合同审查,可能是法律人利用人工智能的主要方式之一,但是由于表达的不精准和模糊,往往会使大语言模型的输出

摘要:本文介绍了如何利用DeepSeek工具生成交互式数据分析图表,并将其嵌入Excel和PPT中,以提升演示效果。传统AI生成图表的方法通常只能生成静态图像,缺乏交互性。而通过DeepSeek,用户可以生成代码模板,结合数据生成可交互的图表。具体步骤包括选择图表模板、使用DeepSeek生成代码,并将代码嵌入Excel或PPT中。这种方法不仅提高了图表的可修改性和稳定性,还使得非技术人员也能轻松

阿里开源Qwen3系列大模型全线发布,在代码、数学等基准测试中表现优异。文章介绍了通过Ollama(需≥0.6.6版本)快速本地部署Qwen3模型的方法,包括模型选择、显存占用分析和推理速度测试。特别说明该系列支持关闭思考模式(添加/no_think)以提升效率。同时展示了Python调用技巧:使用ollama库实现文本生成/对话任务,以及基于pydantic-ai构建支持函数调用的智能体应用。文