简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

词向量的诞生标志着 NLP 从规则驱动迈向数据驱动,其发展历程不仅是技术的革新,更是对人类语言本质的深入探索。从早期捕捉单一语义的静态向量,到如今动态感知上下文的预训练模型,词向量已成为现代 NLP 的底层基石。未来,随着技术的持续突破,词向量将在通用人工智能(AGI)领域扮演更关键的角色,推动机器从 “理解语言” 走向 “理解世界”。相关资源推荐。

随着国人对小米这个品牌的认可,不少人发现雷军 真的是爽文男主,两年完成四年学业,武汉大学的高材生,漂亮的代码,甚至被编入了教材,现在经常活跃在短视频,给广大网友报备日常生活,我回头发现,就连我们平常用的wps,金山打字通都和雷军有很深的渊源,这个神一般的男人,就让我们梳理一下他都做了哪些常人做不到的事情。

BERT是由Google于2018年推出的基于Transformer架构的预训练语言模型。其核心创新在于双向编码机制,通过掩码语言模型(MLM)和下一句预测(NSP)任务进行预训练,使模型能同时利用上下文信息。BERT提供Base(12层)和Large(24层)两种版本,广泛应用于文本分类、命名实体识别、问答系统等NLP任务。模型输入包含Token、Position和Segment三种Embedd

分类算法 分类器

在深度学习的广袤天地里,激活函数宛如隐匿于神经网络架构中的神奇密码,掌控着模型学习与表达的关键力量。今天,就让我们一同深入探究这些激活函数的奇妙世界,揭开它们神秘的面纱。

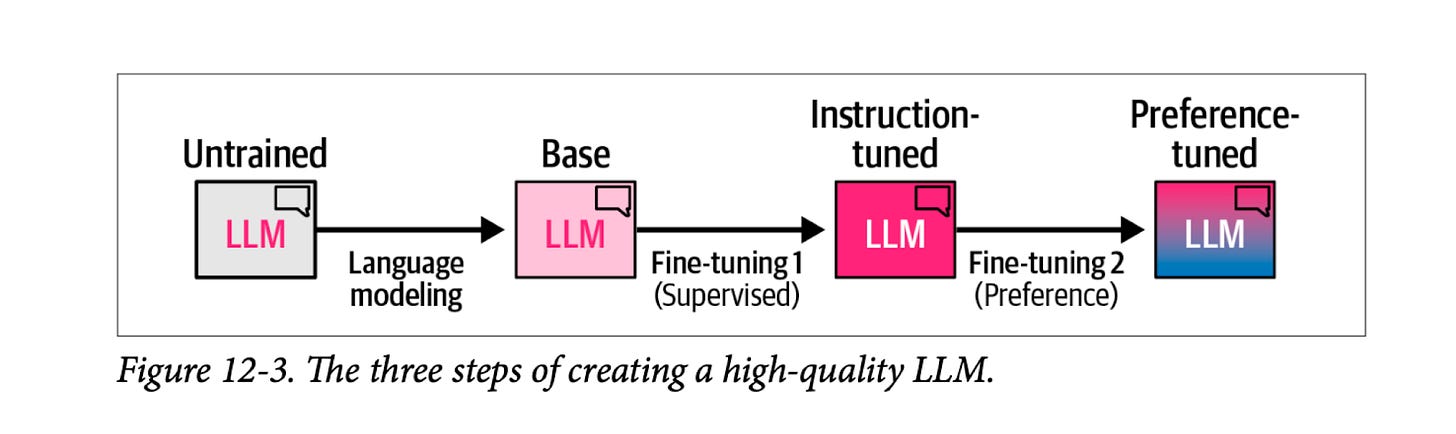

预训练是基础,让模型具备语言和知识能力;SFT是初步校准,让模型学会遵循指令;RLHF(结合奖励模型和强化学习)是深度优化,让模型符合人类偏好;PPO/DPO是实现强化学习的具体算法工具。这一流程(预训练→SFT→RLHF)已成为主流大语言模型(如 GPT、Claude 等)的标准训练范式。

你考试的时候是不是有自己的小技巧?比如先做简单题、最后检查作文。AI 在 “冲刺班” 里也有 “答题技巧”,就是 PPO 和 DPO 这些算法。简单说,PPO 是让 AI “稳扎稳打”,每次进步一点点,别一下子改太多导致 “翻车”;DPO 更直接,相当于告诉 AI“就照着这个好例子学,不用绕弯子”。有了这些技巧,AI 能更快地学会人类喜欢的表达方式。启蒙班(预训练):狂读海量内容,打基础;提高班(

BERT是由Google于2018年推出的基于Transformer架构的预训练语言模型。其核心创新在于双向编码机制,通过掩码语言模型(MLM)和下一句预测(NSP)任务进行预训练,使模型能同时利用上下文信息。BERT提供Base(12层)和Large(24层)两种版本,广泛应用于文本分类、命名实体识别、问答系统等NLP任务。模型输入包含Token、Position和Segment三种Embedd

通过对基于 RNN 的股票预测代码的优化,我们去掉了不必要的预测结果重塑操作,使代码更加简洁、健壮和高效。这种优化不仅提升了代码的质量,还为后续的开发和维护提供了便利。在实际开发中,我们应该时刻关注代码的简洁性和性能,不断优化代码,以提高开发效率和系统的稳定性。希望本文对大家理解代码优化的思路和方法有所帮助。如果你对 RNN 股票预测或代码优化有任何疑问,欢迎在评论区留言讨论。

DeepSeek-R1