AIGC 算力提升:多维度协同优化路径

AIGC(生成式人工智能)的算力需求随模型规模(如千亿参数大模型)、生成任务复杂度(如图像高清生成、长文本创作)呈指数级增长,单纯依赖硬件堆叠难以高效满足需求。算力提升需从硬件升级、算法优化、软件框架、系统架构、数据处理五大维度协同推进,实现 “算力密度提升” 与 “算力利用率优化” 双重目标。

AIGC(生成式人工智能)的算力需求随模型规模(如千亿参数大模型)、生成任务复杂度(如图像高清生成、长文本创作)呈指数级增长,单纯依赖硬件堆叠难以高效满足需求。算力提升需从硬件升级、算法优化、软件框架、系统架构、数据处理五大维度协同推进,实现 “算力密度提升” 与 “算力利用率优化” 双重目标。

一、硬件层:算力基础的 “扩容与增效”

硬件是 AIGC 算力的物理载体,核心方向是通过 “专用化芯片设计”“存储 - 计算协同”“集群架构优化” 突破算力瓶颈。

1. 专用芯片:从 “通用” 到 “定制化” 的算力聚焦

传统 CPU 因并行计算能力弱,难以支撑 AIGC 大规模矩阵运算(如 Transformer 模型的自注意力机制),专用芯片成为核心选择:

- GPU(图形处理器):当前 AIGC 主流算力载体,凭借海量 CUDA 核心(或 AMD 的 ROCm 核心)支持高效并行计算,适合模型训练与推理。例如英伟达 H100 GPU 的 Tensor Core 可提供 4PFlops 的 FP8 精度算力,较前代 A100 提升 3 倍以上,能显著加速 Stable Diffusion、GPT 类模型的生成速度。

- ASIC(专用集成电路):为 AIGC 场景定制电路,能效比远超 GPU。例如谷歌 TPU v5e,针对 Transformer 模型优化,算力密度达 500 TOPS/W,适合云端大规模推理;国内华为昇腾 910B、壁仞 BR100 等 ASIC 芯片,通过自研架构(如昇腾的 Da Vinci 架构)提升大模型训练效率。

- FPGA(现场可编程门阵列):兼具灵活性与高效性,可根据 AIGC 任务动态调整硬件逻辑,适合中小规模模型的推理场景(如边缘端 AIGC 生成),代表产品如赛灵思 Alveo 系列。

2. 存储 - 计算协同:解决 “数据搬运瓶颈”

AIGC 计算中,数据在内存、显存间的传输延迟(“内存墙” 问题)常导致 GPU 算力闲置。存储 - 计算协同技术通过 “靠近计算单元部署存储” 减少数据搬运:

- 存算一体芯片:将存储单元(如 DRAM、NAND)与计算单元集成,直接在存储内部完成数据运算,避免数据传输损耗。例如美光的存算一体 AI 芯片,针对 AIGC 推理场景,能效比提升 10 倍以上。

- 高带宽存储(HBM):为 GPU 配备堆叠式 HBM 显存(如 HBM3),带宽较传统 GDDR6 提升 3-4 倍(HBM3 带宽达 1TB/s 以上),可支撑千亿参数模型的参数加载与中间数据存储,减少 “算力等数据” 的闲置时间。

3. 集群架构:从 “单卡” 到 “分布式扩展”

单芯片算力有限,通过集群化部署实现算力叠加:

- 异构计算集群:融合 GPU、ASIC、CPU 等多种芯片,按任务类型分配算力(如 GPU 负责训练、ASIC 负责推理)。例如阿里云 “飞天智算平台” 采用 GPU+FPGA 异构架构,支持万卡级集群,可承载 GPT-4 级模型的训练。

- 高速互联技术:通过 NVLink、PCIe 5.0、RDMA(远程直接内存访问)等技术实现集群内芯片间低延迟通信。例如英伟达 DGX SuperPOD 集群,通过 NVLink Switch 实现 8 块 H100 GPU 间的高速互联,通信延迟低于 1 微秒,保障分布式训练的效率。

二、算法层:用 “智能设计” 降低算力消耗

算法优化是 “以少胜多” 的核心 —— 通过改进模型结构、减少冗余计算,在不增加硬件成本的前提下提升算力利用效率,是 AIGC 算力提升的 “软核心”。

1. 模型压缩:在 “精度损失可控” 下减小计算量

通过削减模型冗余参数或降低计算精度,实现 “轻量型” 算力需求:

- 量化(Quantization):将模型参数从高精度(如 FP32、FP16)转为低精度(如 INT8、INT4,甚至 FP8),减少计算量与内存占用。例如 GPT-3 模型经 INT8 量化后,显存占用降低 75%,推理速度提升 3 倍,且生成文本质量损失小于 5%;英伟达 TensorRT 工具可自动完成量化优化,适配 AIGC 推理场景。

- 剪枝(Pruning):移除模型中 “贡献度低” 的参数(如权重接近 0 的神经元),保留核心结构。例如 ResNet 网络经剪枝后,参数数量减少 60%,但图像生成精度仅下降 2%,适合边缘端 AIGC 应用(如手机端 AI 绘画)。

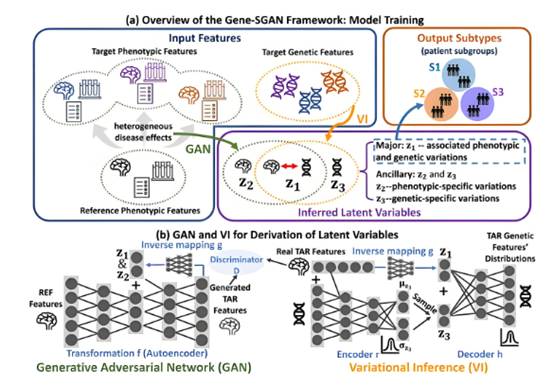

- 蒸馏(Knowledge Distillation):用 “大模型(教师模型)” 的知识训练 “小模型(学生模型)”,让小模型具备接近大模型的生成能力。例如用 1750 亿参数的 GPT-3 作为教师模型,蒸馏出 10 亿参数的学生模型,推理算力需求降低 90%,可部署于普通服务器。

2. 高效模型架构:从 “冗余设计” 到 “算力友好”

优化模型结构(尤其是 Transformer 架构),减少不必要的计算步骤:

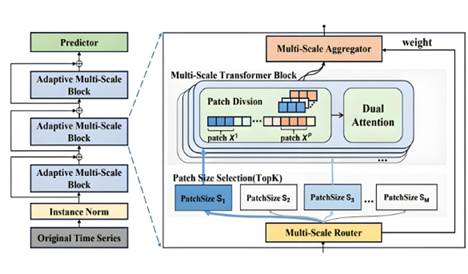

- 稀疏注意力(Sparse Attention):传统 Transformer 的自注意力机制需计算 “所有 token 间的关联”(复杂度 O (n²)),稀疏注意力仅计算 “关键 token 关联”(如局部窗口内、或基于内容匹配的 token),复杂度降至 O (n)。例如谷歌的 Sparse Transformer、OpenAI 的 FlashAttention,可将长文本生成(如 1 万字小说)的算力需求降低 50% 以上。

- 分层架构(Layer-wise Design):针对 AIGC 任务的 “粗细粒度需求”,设计分层模型。例如图像生成时,先通过轻量层生成低分辨率图像,再通过高精度层优化细节,而非全程用高算力模型;百度文心一言的 “分层推理” 架构,可根据文本长度动态调用不同层数的 Transformer,短文本推理算力降低 40%。

3. 动态计算策略:按需分配算力

根据生成任务的实时需求,动态调整算力投入,避免 “算力浪费”:

- 自适应精度(Adaptive Precision):训练时用高精度(如 FP32)保障模型收敛,推理时用低精度(如 INT8)提升速度;生成关键内容(如文本的核心观点、图像的主体元素)时用高算力,生成背景或辅助内容时用低算力。

- 早停机制(Early Stopping):在模型生成过程中,若已满足质量要求(如文本通顺度、图像清晰度达标),则提前终止计算。例如 AI 绘画工具 MidJourney 的 “动态迭代终止” 功能,平均减少 20% 的迭代次数,算力消耗降低 15%。

三、软件与框架层:打通 “硬件 - 算法” 的算力通道

软件框架是连接硬件算力与 AIGC 算法的 “桥梁”,优化框架可减少 “算力损耗”,让硬件性能充分释放。

1. 深度学习框架优化:算子级效率提升

优化框架中的核心计算单元(算子),减少冗余调用与数据传输:

- 算子融合(Operator Fusion):将多个独立算子(如卷积、激活、批归一化)合并为一个 “融合算子”,减少算子间的数据传输开销。例如 PyTorch 的 TorchScript、TensorFlow 的 XLA 编译器,可自动完成算子融合,AIGC 模型训练速度提升 20%-30%。

- 定制化算子开发:针对 AIGC 核心算子(如 Transformer 的自注意力算子、扩散模型的采样算子),开发硬件友好的定制算子。例如英伟达为 Stable Diffusion 开发的 “Diffusion 算子库”,将图像生成速度提升 2 倍;国内 MindSpore 框架的 “AI 算子自动生成工具”,可针对昇腾芯片优化算子,算力利用率提升至 90% 以上。

2. 并行计算框架:最大化集群算力利用率

通过 “多维度并行” 策略,将大模型任务拆解到多个硬件节点,避免单节点算力瓶颈:

- 数据并行(Data Parallelism):将训练数据拆分到多个 GPU,每个 GPU 训练部分数据,再同步参数。适合模型较小、数据量较大的场景(如 AIGC 图像预训练),主流框架如 Horovod、PyTorch DDP(Distributed Data Parallel)。

- 模型并行(Model Parallelism):将大模型的不同层拆分到多个 GPU,每个 GPU 负责部分层的计算。例如 GPT-3 的 1750 亿参数模型,通过模型并行拆到 1024 块 GPU 上,解决单卡显存不足问题,代表工具如 Megatron-LM。

- 流水线并行(Pipeline Parallelism):将模型训练流程拆分为 “数据加载 - 计算 - 参数更新” 等阶段,不同 GPU 并行处理不同阶段,减少空闲时间。例如谷歌的 GPipe 框架,可将 Transformer 模型训练速度提升 3 倍。

四、系统与架构层:全局算力的 “调度与协同”

通过优化算力调度、云边端协同等系统级设计,提升整体算力利用效率,避免 “算力闲置” 或 “资源错配”。

1. 智能算力调度:让算力 “按需分配”

通过调度系统动态分配硬件资源,匹配 AIGC 任务的算力需求:

- 任务优先级调度:将高优先级任务(如大模型紧急训练)分配给高算力节点,低优先级任务(如小规模推理)分配给闲置资源。例如阿里云的 “Volcano 调度系统”,可实现 GPU 资源利用率从 50% 提升至 80% 以上。

- 分时复用(Time Sharing):同一硬件节点在不同时间段处理不同任务(如白天处理推理、夜间处理训练),避免算力闲置。例如腾讯云的 “AIGC 算力池”,通过分时复用将 GPU 利用率提升至 90%。

2. 云边端协同:分层承载算力需求

将 AIGC 任务按 “算力强度” 拆分到云端、边缘端、终端,实现 “算力分级承载”:

- 云端:承载大模型训练(如 GPT-4、文心一言的预训练)、大规模推理(如百万用户同时使用的 AI 写作工具),依赖大规模 GPU/ASIC 集群。初步实施可使用线上云服务器:如“智算云扉https://waas.aigate.cc/productService、算吧 https://www.suanba.cc/index”等租赁平台,支持按量计费。

- 边缘端:承载中等规模推理(如园区内的 AI 视频生成、门店的 AI 设计工具),使用边缘服务器(如搭载 4-8 块 GPU 的边缘节点),减少云端传输延迟。

- 终端:承载轻量级 AIGC 任务(如手机端 AI 贴纸生成、PC 端短文本改写),依赖终端芯片(如苹果 A17 Pro 的神经网络引擎、高通骁龙 8 Gen3 的 NPU),通过模型压缩适配终端算力。

五、数据层:减少 “算力空转” 的源头优化

AIGC 计算中,数据预处理(如图像裁剪、文本分词)和数据传输的延迟常导致 GPU “空等数据”,优化数据处理可间接提升算力利用率。

1. 并行数据预处理:避免 “算力等数据”

通过并行化工具加速数据预处理,让数据供给速度匹配 GPU 计算速度:

- 专用预处理框架:使用 DALI(NVIDIA Data Loading Library)、TF Data(TensorFlow Data)等工具,通过 CPU 多线程并行处理数据(如图像解码、归一化、增强),预处理速度提升 3-5 倍,避免 GPU 闲置。

- 数据预缓存(Pre-caching):将高频使用的训练数据(如 AIGC 图像数据集)提前缓存到高速存储(如 SSD、内存),减少从硬盘读取数据的延迟。

2. 数据传输优化:减少 “数据在路上” 的时间

通过高速传输协议与压缩技术,降低数据在 “存储 - 内存 - GPU” 间的传输延迟:

- RDMA(远程直接内存访问):跳过 CPU 直接在存储与 GPU 显存间传输数据,传输延迟降低至微秒级,适合分布式训练中的数据同步。

- 数据压缩:对预处理后的数据(如文本 token、图像特征)进行轻量级压缩(如 LZ4、Snappy 算法),减少传输数据量,提升传输速度。

总结:AIGC 算力提升的核心逻辑

AIGC 算力提升并非单一维度的 “硬件堆砌”,而是 **“硬件筑基 + 算法提效 + 软件搭桥 + 系统调度 + 数据优化” 的协同工程 **:

- 硬件是 “基础”:通过专用芯片、存算协同、集群扩展提升算力上限;

- 算法是 “关键”:通过模型压缩、架构优化减少算力需求,实现 “降本增效”;

- 软件与系统是 “保障”:打通硬件与算法的通道,优化资源分配,避免算力浪费。

未来,随着量子计算(如量子 AI 芯片)、脑启发计算(如类脑芯片)等新兴技术的发展,AIGC 算力提升将迎来 “范式突破”,进一步支撑更复杂的生成任务(如实时 3D 场景生成、多模态长内容创作)。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)