克隆语音技术:Clone-Voice实践指南

Clone-Voice是一款基于CoquiAI XTTS_v2模型的开源语音克隆工具,支持16种语言的文本转语音和音色转换。其核心功能包括TTS合成、实时录音克隆和GPU加速处理,技术架构整合了WavLM特征提取和FreeVC24语音转换模块。项目提供预编译版和源码部署两种方式,具有易用性强、多语言支持等优势,但在中文效果和网络依赖方面存在局限。适用于配音创作、教育学习等场景,未来将扩展语言支持并

引言

语音克隆技术(Voice Cloning)作为人工智能领域的重要分支,近年来在语音合成(Text-to-Speech, TTS)和语音转换(Voice Conversion)领域取得了显著进展。Clone-Voice 是一个基于 Coqui AI 的 XTTS_v2 模型开发的开源语音克隆工具,以其简单易用的 Web 界面和对多语言支持的强大功能受到广泛关注。本文将深入剖析 Clone-Voice 的技术架构、使用方法以及潜在的应用场景,并探讨其在语音克隆领域的优势与局限性。

Clone-Voice 项目概述

Clone-Voice 是一个基于 Web 界面的语音克隆工具,支持将任意人类音色用于文本到语音的合成,或将一种声音转换为另一种音色。它基于 Coqui AI 的 XTTS_v2 模型,遵循 Coqui Public Model License 1.0.0 开源协议。该项目支持 16 种语言,包括中文、英文、日语、韩语、法语、德语等,适用于从配音到个性化语音生成等多种场景。

核心功能

- 文本到语音(Text-to-Speech, TTS):用户可以输入文本或导入 SRT 字幕文件,结合目标音色生成逼真的语音。

- 语音到语音(Voice-to-Voice, V2V):支持将输入的音频文件(MP3/WAV/FLAC 格式)转换为目标音色。

- 实时录音与音色克隆:通过 Web 界面,用户可直接录制 5-20 秒的音频作为音色样本,生成个性化语音模型。

- 多语言支持:支持 16 种语言,覆盖主流语言,中文和英文效果尤为突出。

- GPU 加速:若设备具备 NVIDIA GPU 和正确配置的 CUDA 环境,可自动启用 CUDA 加速,提升处理效率。

技术架构

Clone-Voice 的核心依赖于 Coqui AI 的 XTTS_v2 模型,这是一个基于深度学习的语音合成模型,结合了 WavLM 和 FreeVC24 等模块,用于音色特征提取和语音转换。以下是其技术架构的简要分析:

- XTTS_v2 模型:XTTS_v2 是一种多语言语音合成模型,基于 Transformer 架构,能够捕捉语音的音色、语调和韵律特征。它通过预训练的大规模语音数据集,实现了高质量的音色克隆和多语言支持。

- WavLM:用于音色特征提取的预训练模型,能够从短音频样本中提取高质量的音色表示,确保克隆音色的逼真度。

- FreeVC24:用于语音转换的模块,支持将源音频的音色转换为目标音色,同时保留语音内容和语义。

- Web 界面:基于 Python 的 Flask 框架(

app.py),提供直观的交互界面,简化用户操作。 - 依赖管理:项目通过

requirements.txt和environment.yml管理依赖,支持 Python 3.9-3.11 环境,并需要 FFmpeg 作为音频处理工具。

安装与部署

Clone-Voice 提供了两种使用方式:预编译版本和源码部署。以下分别介绍两种方式的步骤。

1. 预编译版本(Windows)

预编译版本适合对技术要求较低的用户,操作简单,适合快速上手。

- 下载文件:

- 从 Releases 页面 下载预编译主文件(约 1.7GB)和模型文件(约 3GB)。

- 解压到指定目录(如

E:/clone-voice)。

- 运行程序:

- 双击

app.exe,等待 Web 界面自动打开。 - 模型文件需解压到

tts文件夹,目录结构如下:E:/clone-voice/ ├── tts/ │ ├── tts_models--multilingual--multi-dataset--xtts_v2/ │ ├── voice_conversion_models--multilingual--vctk--freevc24/ │ └── wavlm/ ├── app.exe └── ...

- 双击

- 注意事项:

- 运行时请关注命令行窗口的提示,错误信息会在这里显示。

- 若设备支持 NVIDIA GPU,需确保 CUDA 环境正确配置以启用加速。

2. 源码部署(Linux/Mac/Windows)

源码部署适合需要自定义或优化性能的高级用户,但需要稳定的网络代理以访问外部模型资源。

- 环境准备:

- 确保安装 Python 3.9-3.11 和 Git。

- 下载 FFmpeg 并将其可执行文件放置于项目根目录。

- 克隆仓库:

git clone https://github.com/jianchang512/clone-voice.git cd clone-voice - 创建虚拟环境:

python -m venv venv source venv/scripts/activate # Windows source venv/bin/activate # Linux/Mac - 安装依赖:

若需 CUDA 加速,执行以下命令:pip install -r requirements.txt --no-depspip uninstall -y torch pip install torch torchaudio --index-url https://download.pytorch.org/whl/cu121 - 配置代理:

- 在

.env文件中设置HTTP_PROXY(如HTTP_PROXY=http://127.0.0.1:7890),以确保从 Hugging Face 和 GitHub 下载模型。

- 在

- 下载模型:

同意协议后,等待模型下载完成。python code_dev.py - 启动服务:

python app.py

常见问题

- 模型下载失败:由于模型文件较大(约 3GB),需确保代理稳定。若提示“Downloading WavLM model”错误,可手动修改

venv/Lib/site-packages/aiohttp/client.py,在if proxy is not None:前添加代理地址。 - 音质问题:建议录制 5-20 秒清晰、无背景噪声的音频样本,以确保克隆效果。

使用指南

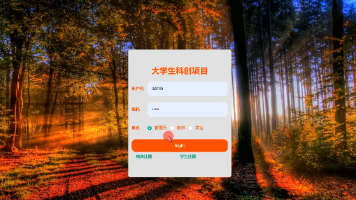

Clone-Voice 的 Web 界面直观易用,以下是两种主要功能的操作步骤。

1. 文本到语音(TTS)

- 打开 Web 界面,选择“文字->声音”按钮。

- 在文本框输入目标文本,或导入 SRT 字幕文件。

- 从下拉框选择预设音色,或上传/录制 5-20 秒的音频样本。

- 点击“立即开始”,等待生成结果。

2. 语音到语音(V2V)

- 选择“声音->声音”按钮。

- 上传源音频文件(支持 MP3/WAV/FLAC 格式)。

- 选择目标音色(预设或自定义)。

- 点击“立即开始”,生成转换后的音频。

录音建议

- 时长:5-20 秒,过短可能导致音色特征不足,过长则无显著提升。

- 环境:无背景噪声,清晰发音。

- 格式:WAV 或 MP3,推荐 16kHz 采样率。

优势与局限性

优势

- 易用性:Web 界面简化操作,无需复杂配置即可实现语音克隆。

- 多语言支持:支持 16 种语言,中文和英文效果尤为突出,适合国际化应用。

- 开源免费:遵循 Coqui Public Model License 1.0.0,代码和模型公开,适合开发者扩展。

- 低硬件要求:无需高端 GPU,普通 CPU 也能运行,降低使用门槛。

- 灵活性:支持实时录音、文件上传和预设音色,满足多样化需求。

局限性

- 中文效果有限:尽管支持中文,但与英文相比,中文语音的自然度和情感表现稍逊。

- 模型下载依赖网络:国内用户需稳定代理以访问 Hugging Face 和 GitHub。

- 训练复杂性:若需自定义训练,需调整

params.json并运行train.py,对新手有一定门槛。 - 音质依赖输入:输入音频的质量直接影响克隆效果,需严格控制录音环境。

应用场景

Clone-Voice 的功能使其在多个领域具有广泛应用潜力:

- 内容创作:为视频配音、播客制作或有声书生成个性化语音。

- 教育与语言学习:生成多语言发音样本,辅助语言学习或发音纠正。

- 娱乐与创意:克隆名人或卡通角色音色,制作趣味音频或短视频。

- 无障碍技术:为失声者提供个性化语音生成工具,增强沟通能力。

- 商业应用:在广告、客服语音或虚拟助手中嵌入品牌专属音色。

未来改进方向

基于社区反馈和项目现状,以下是一些可能的改进方向:

- 扩展语言支持:如越南语等更多语言的加入(参考 GitHub Issue #122)。

- 优化中文效果:通过引入更多中文语音数据集或改进模型训练,提升中文语音的自然度。

- 降噪算法集成:如 Web 结果 [15] 所述,增加音频预处理模块,提升低质量输入音频的克隆效果。

- 离线模型支持:优化模型加载机制,减少对网络的依赖。

- 移动端支持:开发移动端界面,进一步降低使用门槛。

结语

Clone-Voice 凭借其简单易用的 Web 界面、强大的多语言支持和开源特性,成为语音克隆领域的一款优秀工具。无论是内容创作者、教育工作者还是开发者,都可以通过 Clone-Voice 快速实现高质量的语音克隆和转换。尽管在中文效果和模型下载方面存在一定局限,但其灵活性和低门槛使其在众多场景中具有广泛应用前景。未来,随着社区的持续贡献和模型的优化,Clone-Voice 有望在语音克隆领域发挥更大作用。

参考资料:

- Clone-Voice GitHub 项目:https://github.com/jianchang512/clone-voice

- Coqui AI 模型协议:https://coqui.ai/cpml.txt

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)