【DeepSeek部署】Windows系统本地部署DeepSeek详细教程

最近DeepSeek非常火爆,因其卓越的推理能力和低成本特性而广受欢迎,DeepSeek开源了部分模型,通过蒸馏技术可以将大模型参数压缩为更小的版本(如1.5B、7B等),显著降低对显存和计算资源的需求,这使得普通家用电脑也能部署,无需依赖高端硬件。本地部署不仅能规避网络延迟和隐私风险,还能根据需求定制模型功能,成为高效办公、学习研究的利器。此外,本地部署使数据完全存储于自有服务器或私有云,避免第

前言

最近DeepSeek非常火爆,因其卓越的推理能力和低成本特性而广受欢迎,DeepSeek开源了部分模型,通过蒸馏技术可以将大模型参数压缩为更小的版本(如1.5B、7B等),显著降低对显存和计算资源的需求,这使得普通家用电脑也能部署,无需依赖高端硬件。

本地部署不仅能规避网络延迟和隐私风险,还能根据需求定制模型功能,成为高效办公、学习研究的利器。 此外,本地部署使数据完全存储于自有服务器或私有云,避免第三方平台的数据泄露风险,尤其适用于医疗、金融等涉及敏感信息的行业。本文介绍如何在自己的电脑上本地部署 DeepSeek-R1-8B 模型。

你是否还在为**「DeepSeek高阶应用」挠破头?🤯 想一键收割全网稀缺的大模型实战干货**?💡

🎯 本期**「DeepSeek高能拆解」直击核心——

✅ 从底层原理到行业顶配实战**,手撕技术黑箱!

✅ 100+前沿案例+代码级解析,小白也能秒变大神!

✅ 独家曝光**官 仲 号「拉吉卜的知识宝库」**私藏资源,助你弯道超车🚗💨

01

硬件配置要求

DeepSeek推出了多款开源模型,覆盖从推理到创作的多元场景。特别是DeepSeek-R1系列,具有低成本、高效推理的优势,可在本地部署。此外还有将R1的推理能力迁移至小型模型的知识蒸馏模型,不同版本的DeepSeek模型的硬件需求根据参数规模和应用场景具有显著差异,下面是DeepSeek R1 不同版本模型的硬件要求:

| 模型版本 | RAM需求 | 推荐 GPU(单卡) | 适用场景 |

|---|---|---|---|

| DeepSeek-R1-671B | 512GB+ | 8x A100/H100(服务器集群) | 国家级/超大规模 AI 训练,超高性能计算 |

| DeepSeek-R1-70B | 128GB+ | 2x A100 80GB/4x RTX 4090(多卡并行) | 科研机构/大型企业,大规模数据分析处理 |

| DeepSeek-R1-32B | 64GB+ | 2x A100 40GB(24GB显存) | 高精度专业领域任务、多模态数据分析 |

| DeepSeek-R1-14B | 32GB+ | RTX 4090(24GB)/A5000(16GB显存) | 中型企业/科研团队/专业服务机构,企业级复杂任务(合同分析、报告生成)、长文本理解与生成 |

| DeepSeek-R1-8B | 16GB+ | RTX 4070/3060/3070(12GB显存) | 需更高精度的轻量级任务(代码生成、逻辑推理) |

| DeepSeek-R1-7B | 16GB+ | RTX 3060/3070/4060(8GB显存) | 中等复杂度的逻辑推理和生成任务、轻量级多轮对话系统 |

| DeepSeek-R1-1.5B | 8GB+ | GTX 1650(4GB显存) | 低资源设备的基础推理任务,如简单问答、文本摘要、轻量级数据分析 |

模型参数越大,对显存和内存需求越高,我的电脑系统为Windows11,内存为32GB,显卡为英伟达RTX 4060,本文部署DeepSeek-R1-8B模型。

02

部署DeepSeek

2.1

安装Ollama

Ollama是运行本地AI模型的核心工具,支持一键部署,支持Windows/macOS/Linux,本文在Windows下部署:

a. 访问官网(https://ollama.com/),下载Windows版安装包OllamaSetup.exe;

b. 双击OllamaSetup.exe安装会默认安装到C盘,建议使用如下命令安装到其它盘:

$ cd D:\devWorkspace\AI_tools$ OllamaSetup.exe /DIR="D:\devWorkspace\AI_tools\Ollama"

c. 安装完成后打开终端输入 ollama -v 验证是否成功。

$ ollama -vollama version is 0.5.12

2.2

将Ollama模型保存路径设置到D盘

添加环境变量OLLAMA_MODELS ,值为:D:\devWorkspace\AI_tools\Ollama\models

2.3

让Ollama使用GPU

为了让推理跑在GPU上,可设置环境变量OLLAMA_GPU_LAYER, 值为:cuda,如果需要指定特定的 GPU,可以添加以下环境变量

变量名:CUDA_VISIBLE_DEVICES变量值:GPU的UUID:

可在控制台窗口输入 nvidia-smi -L 命令查看GPU的UUID:

$ nvidia-smi -LGPU 0: NVIDIA GeForce RTX 4060 Laptop GPU (UUID: GPU-1ff78f94-b4af-2a60-cedf-cbaaa65beb38)

环境变量配置完成后需要重启一下电脑,让配置生效。

2.4

下载DeepSeek模型

2.4.1 下载deepseek-r1:8b

deepseek-r1各版本可在这里查看:https://ollama.com/library/deepseek-r1,使用Ollama命令行下载模型:

$ ollama pull deepseek-r1:8bpulling manifestpulling 6340dc3229b0... 100% ▕████████████████████████████████████████████████████████▏ 4.9 GBpulling 369ca498f347... 100% ▕████████████████████████████████████████████████████████▏ 387 Bpulling 6e4c38e1172f... 100% ▕████████████████████████████████████████████████████████▏ 1.1 KBpulling f4d24e9138dd... 100% ▕████████████████████████████████████████████████████████▏ 148 Bpulling 0cb05c6e4e02... 100% ▕████████████████████████████████████████████████████████▏ 487 Bverifying sha256 digestwriting manifestsuccess

模型会下载到前面配置的目录下:D:\devWorkspace\AI_tools\Ollama\models

2.4.2 运行模型并对话

输入ollama run deepseek-r1:8b命令,然后输入问题与DeepSeek进行对话:

$ ollama run deepseek-r1:8b>>> 请用Java语言写一个快速排序<think>嗯,我现在得想办法用Java来实现快速排序。首先,快速排序是什么呢?我记得它是基于分治策略的一种高效排序算法,平均时间复杂度大概是O(n log n)对吧。那它的基本思想应该是,每次把数组分成两部分,一半较小,一半较大,然后递归地排序这两部分,对吧。那我得先想想怎么实现这个过程。快速排序通常有几个步骤:选择枢轴元素,partition,递归排序左右子数组。那在Java中,可能需要写一个方法来处理这些步骤。首先,选择枢轴是什么呢?常见的选择是中位数或者前导元素。比如,我可以选数组中的第一个元素作为枢轴,这样实现起来简单些。那如何找到中位数呢?或许不一定需要精确找中位数,只要能保证枢轴位置正确就行。然后,partition步骤,也就是将数组分成小于等于枢轴和大于枢轴的两部分。这个过程可以用双指针来实现:一个指针从左边开始扫描找到第一个比枢轴大的元素,另一个指针从右边开始扫描找到第一个比枢轴小的元素,然后交换它们的位置。这样整个数组就被分成了两部分。接下来是递归排序左右子数组。我需要考虑如何处理这些子数组,比如确定起始和结束的索引,避免重复计算或者越界。那我得想想怎么编写这个快速排序的方法。可能是一个静态的方法,接受数组和左、右索引作为参数。然后基线情况是什么呢?比如,当左 >= 右的时候,说明子数组只包含一个或没有元素,此时不需要再进行分割了。那我可能会写出以下结构:.....

可使用 Ctrl + d 或者 /bye 退出会话。

03

安装图形化界面

使用命令行的方式不是很友好,可以安装一个WebUI,可用的交互界面有很多:

a. Page Assist浏览器插件:https://github.com/n4ze3m/page-assist

b. chatbox:https://github.com/Bin-Huang/chatbox

c. AnythingLLM:https://anythingllm.com/desktop

d. Open WebUI:https://openwebui-doc-zh.pages.dev/,需要使用docker运行

3.1

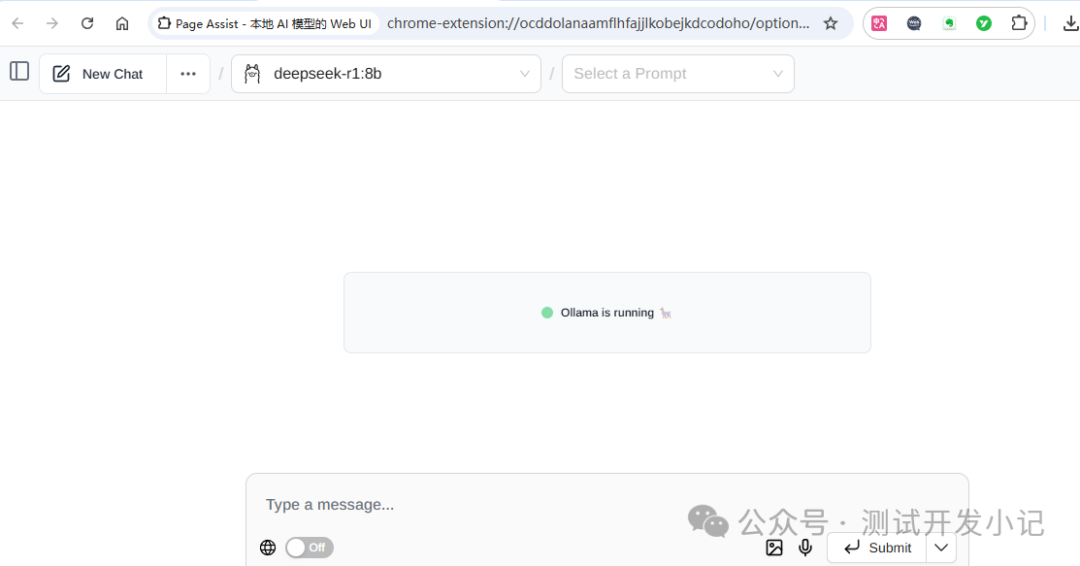

Page Assist浏览器插件

到这里下载https://github.com/n4ze3m/page-assist/releases,以Chrome插件为例,下载pageassist-1.5.3-chrome.zip,下载完成后,拖入Chrome浏览器扩展程序中。

3.2

Chatbox

到官网下载安装即可:https://chatboxai.app/zh#download

在设置中选择“Ollama API”,绑定本地模型。

3.3

AnythingLLM

AnythingLLM可用来构建私有知识库和智能问答系统,支持导入分析多种类型的文档,可以根据自己的需求创建不同的AI代理,实现高度定制化功能。

下载Windows桌面版双击安装即可:https://anythingllm.com/desktop

安装完成后选择Ollama:

配置完成后就可以进行聊天了。

可使用AnythingLLM来创建个人知识库,比如上传一个本地文档,添加到工作区,并嵌入到模型中。

免费领!全网最全DeepSeek学习资料合集!速戳→

免费领!全网最全DeepSeek学习资料合集!速戳→

你是否曾在深夜对着电脑屏幕,为找一份靠谱的 DeepSeek 学习资料翻遍全网?从论坛帖子到公众号文章,收藏夹里攒了上百个链接,真正能用的却没几个;想跟着教程实操,不是内容太浅像 “隔靴搔痒”,就是太深奥看不懂,最后只能对着满屏代码叹气…

针对学习者面临的资料碎片化难题,我们精心整理39份PDF「DeepSeek 学习资料合集」,帮助大家轻松高效地掌握实用的AI应用技巧(附带实操案例),全都给你整理得明明白白~

你想要的AI资料包,都帮你整理好了!

添加【Ai学习官】免费领取

部分资料抢先看!

一、新手入门:3 天搭起 AI 应用框架

01.【104页超详细】DeepSeek从入门到精通.pdf

全面解析DeepSeek,包含提示语设计、多场景应用技巧(如文本生成、代码开发、营销策划等)等实用技巧,适用于不同背景人群。

02.Deepseek喂饭级指令.pdf

AI 学习者的实操指南,提供 6 大分类 30 + 场景的 “傻瓜式” 指令模板,含明确输入输出格式与示例。适合快速落地解决实际问题的新手。

二、进阶提效:从 “会用” 到 “精通” 的关键

03.小白入门DeepSeek必备的50个高阶提示词.pdf

场景覆盖更细分多元,含职场、副业、生活等 50 个场景,且聚焦 “高阶”:有提示词优化、多 AI 联合作战等进阶技巧,新增变现策略(如知识付费、私域 SOP)与趣味玩法(AI 算命、元宇宙营销)。更重实战与技能提升,兼顾新手入门与进阶需求。

04.清华大学第二弹:DeepSeek 赋能职场.pdf

职场人的提效秘籍,系统对比 DeepSeek 不同模型(V3/R1)特性,提供 RTGO、CAP 等专业提示语框架,涵盖可视化图表、PPT、海报等多职场场景实操案例。适用于数据处理、内容生成等职场任务,兼具理论深度与实操指导。

三、实战案例:学生 / 职场人 / 创业者都能用

05.清华大学第三弹:普通人如何抓住DeepSeek红利.pdf

通过 “理论 + 实战 + 案例” 三位一体的体系,包含代码生成、创意写作、多轮对话优化技巧、项目书撰写、社交困境处理等60 + 真实场景解决方案:如课堂知识查漏补缺、编程入门代码调试、1 小时生成万字项目方案、新员工入职培训 SOP等等,帮助学习者突破 “工具使用” 与 “任务落地” 的双重瓶颈。

最后说句真心话:

AI 不是少数人的专利,普通人也能通过系统学习掌握这门技术,让它成为提升效率、创造价值的利器。这份资料合集,就是我们为你搭建的 “AI 学习阶梯”,从基础到进阶,从理论到实战,一步步带你走进 DeepSeek 的世界。现在扫码,免费领取资料,开启你的 AI 进阶之旅吧!说不定下一个用 AI 搞定复杂项目、实现效率翻倍的,就是你!

独家整理!超全AI学习资料

不用费力寻找,pdf全套分享

资料持续更新,添加

【Ai学习官】免费领取!

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)