DeepSeek低调开源LPLB:用线性规划破解MoE训练负载均衡难题

**摘要:**DeepSeek低调开源LPLB项目,这是一个基于线性规划的MoE模型负载均衡器,旨在优化专家并行架构中的动态负载分配问题。LPLB通过动态重排序、构建副本和线性规划求解三个步骤,解决MoE训练中GPU资源利用不均的痛点。该项目目前处于研究阶段,支持多种拓扑结构,但存在求解延迟和非线性计算成本等局限。LPLB的创新在于利用数学工具优化实时分配,为MoE训练加速提供了重要参考。

1.新项目:LPLB

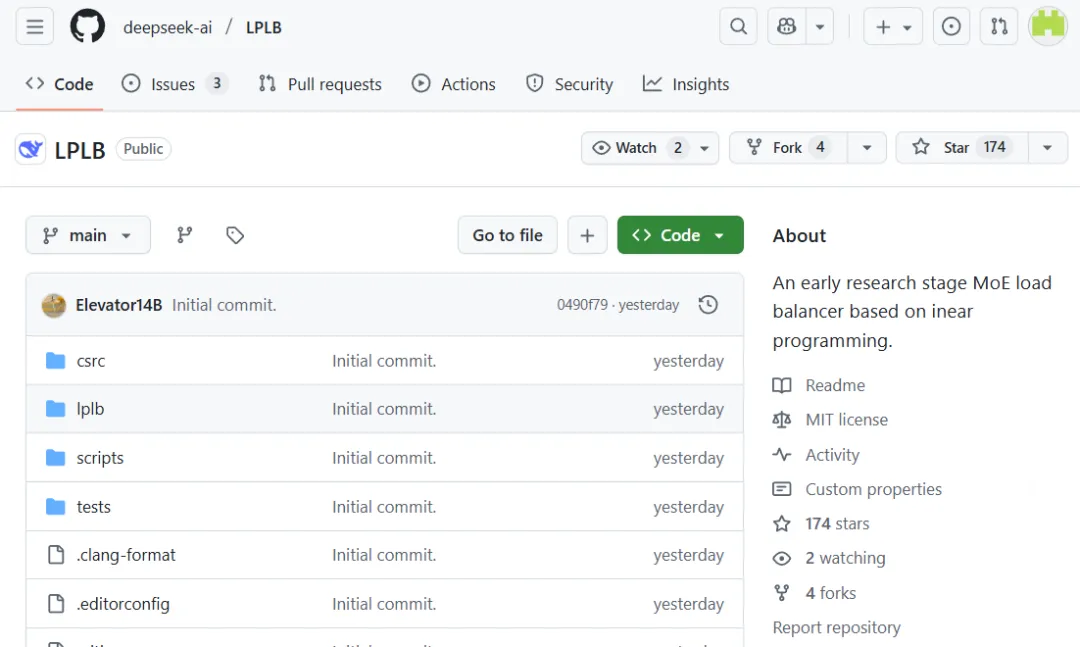

前天,DeepSeek在GitHub上悄然发布了一个新的代码库:LPLB。

(项目地址:https://github.com/deepseek-ai/LPLB)

与往常不同的是,这次发布异常低调——没有官方推文,没有公众号更新,仅有少数技术博主分享的相关推文也未引起太多关注。截至目前,该项目star数量尚未突破200。然而,仔细研究后我们发现,这个看似普通的项目实际上蕴含着重要价值。X平台网友@gm8xx8评论认为,这表明DeepSeek正在着力解决模型训练中的正确性和吞吐量瓶颈,为下一版模型发布做准备。

2.LPLB项目介绍

LPLB,全称Linear-Programming-Based Load Balancer(基于线性规划的负载均衡器),是一个专门为MoE(混合专家)模型设计的并行负载均衡器。

它创新性地利用线性规划算法来优化专家并行架构中的工作负载分配问题,具体通过三个核心步骤实现:

-

动态重排序:基于实时工作负载统计信息对专家进行智能重排序。

-

构建副本:结合静态拓扑结构创建专家副本。

-

求解最优分配:针对每个批次的数据,运用线性规划求解最优Token分配方案。

值得一提的是,LPLB的专家重排序过程由EPLB协助完成,而实时工作负载统计信息可以通过多种方式获取:用户提供、通过torch.distributed收集,或直接从Deep-EP缓冲区的内部通信器获取。

3.技术核心:解决MoE训练的关键痛点

LPLB瞄准的是MoE模型中长期存在的负载不均问题——在MoE模型中,某些“专家”可能比其他专家接收到更多的Token,导致部分GPU忙碌而其他GPU空闲的资源浪费现象。

X平台网友@big_goose指出,该方案与英伟达用于调度SM(Streaming Multiprocessor,英伟达GPU核心计算单元)的技术非常相似,只是将抽象层次提升到了pipeline级别。LPLB特别强调“单SM”,意味着其求解过程设计得极其轻量化,不会占用过多计算资源。

需要说明的是,LPLB目前尚未进入生产流程。DeepSeek在README中明确表示:“LPLB目前处于早期研究阶段,性能改进情况仍在评估中。”

4.技术原理深度解析

EPLB与LPLB的分工。

EPLB:主要处理静态不均衡(如由于数据分布特性,某些专家长期过载)

LPLB:专注于动态波动(训练过程中小批次数据随机性引起的瞬时负载抖动)

5.核心机制

冗余专家 (Redundant Experts): 每个冗余专家(副本)都链接到一个原始专家,从而在 GPU 之间形成连接边。

边容量 (Edge Capacity): 一条边的容量定义为当前批次中分配给该冗余专家的 Token 数量,这决定了用于平衡负载的最大 Token 流量。

LP 优化 (LP Optimization): LPLB 求解一个线性规划问题,在遵守边容量限制的前提下,沿着这些边重新分配 Token,以最小化专家并行(EP)组内的负载不均衡。

6.局限性

尽管 LPLB 提供了动态优化,但目前仍存在一些局限:

1)忽略非线性计算成本: 当前的规划器仅平衡 Token 总数,未考虑分组矩阵乘法(Grouped GEMM)时间成本的非线性特征。这可能导致在某些情况下性能并非绝对最优。

2) 求解延迟: 求解器在节点内(intra-node)优化大约需要 100 µs(跨节点时间更长)。对于非常小的 Batch Size,这个延迟可能不可忽略。

3)极端不均衡情况: 在全局负载极端不均衡的情况下,LPLB 的表现可能不如 EPLB。这是因为 LPLB 在分配冗余专家时存在差异(LPLB 避免将多个副本分配给同一个原始专家)

7.典型拓扑结构

LPLB允许通过修改r2o矩阵来定义专家副本分布方式,支持多种拓扑结构:

- 立方体*

特点:在GPU子集上复制专家,形成带对角边的立方体图。

要求:每个GPU至少2个专家。

适用场景:8 GPU的EP子组内平衡,不牺牲跨节点通信性能。

- 超立方体*

特点:类似立方体但不含对角边。

要求:16个GPU。

适用场景:跨16个GPU的专家并行。

- 环面*

特点:在同一节点内的邻居GPU上复制专家,在邻节点GPU上复制另一专家。

要求:每个GPU至少2个专家。

优缺点:对全局平衡有效,但节点内通信更多,效率通常低于立方体。

8.结语

DeepSeek此次开源的LPLB库,本质上是在攻克大模型训练中的“木桶效应”难题——训练速度往往取决于负载最重的那个GPU。

其创新之处在于引入了线性规划这一数学工具进行实时最优分配计算,并利用底层的NVSHMEM技术打破通信瓶颈。对于正在研究MoE架构训练加速的开发者而言,这无疑是一个极具价值的参考实现。

(具体安装和测试指南请访问原代码库查阅。)

更多推荐

已为社区贡献59条内容

已为社区贡献59条内容

所有评论(0)