大模型battle?LLM排行榜出炉,清华竟位列第五!

【CSDN 编者按】自GPT爆火之后,当下流行的开源大型语言模型越来越多,LMSYS 组织(UC伯克利博士Lianmin Zheng牵头举办)建立了 Chatbot Arena 基准平台通过匿名随机竞争来评估他们,随后发布 Elo 等级排行榜,排行榜至现在仍在定期更新,期待更多的用户贡献模型,进行投票,开发者们也可以参与进来!作者 |LMSYS 组织译者|陈静琳 责编 |屠敏出品 | CSDN(.

【CSDN 编者按】自GPT爆火之后,当下流行的开源大型语言模型越来越多,LMSYS 组织(UC伯克利博士Lianmin Zheng牵头举办)建立了 Chatbot Arena 基准平台通过匿名随机竞争来评估他们,随后发布 Elo 等级排行榜,排行榜至现在仍在定期更新,期待更多的用户贡献模型,进行投票,开发者们也可以参与进来!

作者 |LMSYS 组织

译者|陈静琳 责编 | 屠敏

出品 | CSDN(ID:CSDNnews)

开源大模型太多?

LMSYS Org 直接建立了一个竞技场,以众包方式让他们匿名、随机的进行对抗,形成排行榜。并邀请整个社区加入这项工作,贡献新模型,所有人都可以参与提问和投票来评估它们,到底谁是你心目中的 NO.1 !

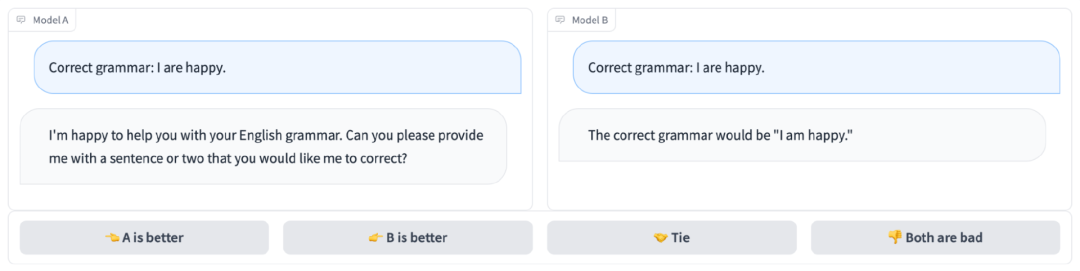

大模型们直接进行比拼(图1),就像下图中,模型 B 完美说出正确答案,而模型 A 牛头不对马嘴,遗憾出局。

图 1. 并排聊天和投票界面

根据大数据分享的4.7K投票数据计算 Elo 评分,得出表 1 排行榜。vicuna 以 1169 分稳居榜首,遥遥领先第二名 koala,他们都是 130 亿参数,而来自清华大学的 chatglm 只有 60 亿参数还仍在前五的序列,相比而言,有强大基础的 llama 就落后许多,已经排到第八位了,stablem 的大模型排名最后,与前一名相差近百分。

表 1. 开源大型语言模型排行榜

序号 | 模型 | Elo等级 | 描述 |

1 | vicuna-13b | 1169 | LLaMA 对 LMSYS 的用户共享对话进行微调的聊天助手 |

2 | koala-13b | 1082 | BAIR 的学术研究对话模型 |

3 | oast-pythia-12b | 1065 | LAION 人人可用的开放助手 |

4 | alpaca-13b | 1008 | LLaMA 在斯坦福的指令遵循演示中微调的模型 |

5 | chatglm-6b | 985 | 清华大学开放式双语对话语言模型 |

6 | fastchat-t5-3b | 951 | LMSYS 从 FLAN-T5 微调的聊天助手 |

7 | dolly-v2-12 | 944 | Databricks 的指令调优开放大型语言模型 |

8 | llama-13b | 932 | Meta 开放高效的基础语言模型 |

9 | stablem-tuned-alpha-7b | 858 | 稳定性 AI 语言模型 |

怎样评估大模型们?

https://arena.lmsys.org 这里就是大模型们的竞技场啦!

LMSYS 组织在这里进行数据收集。

当用户进入竞技场时,他们可以与两个并排的匿名模型聊天,如图1所示。

在得到两个模型的回应后,用户可以继续聊天或为他们认为更好的模型投票。

一旦提交投票,模特的名字就会被披露。用户可以继续聊天或与两个新的随机选择的匿名模特重新开始新的战斗。

在他们的分析中,只使用模型名称被隐藏时的投票,这个竞技场记录了所有用户的互动。

竞技场大约在一周前就推出了,现已经收集了4.7万张有效的匿名投票,LMSYS 组织分享了一些探索性的分析,并在此提出一个简短的总结。

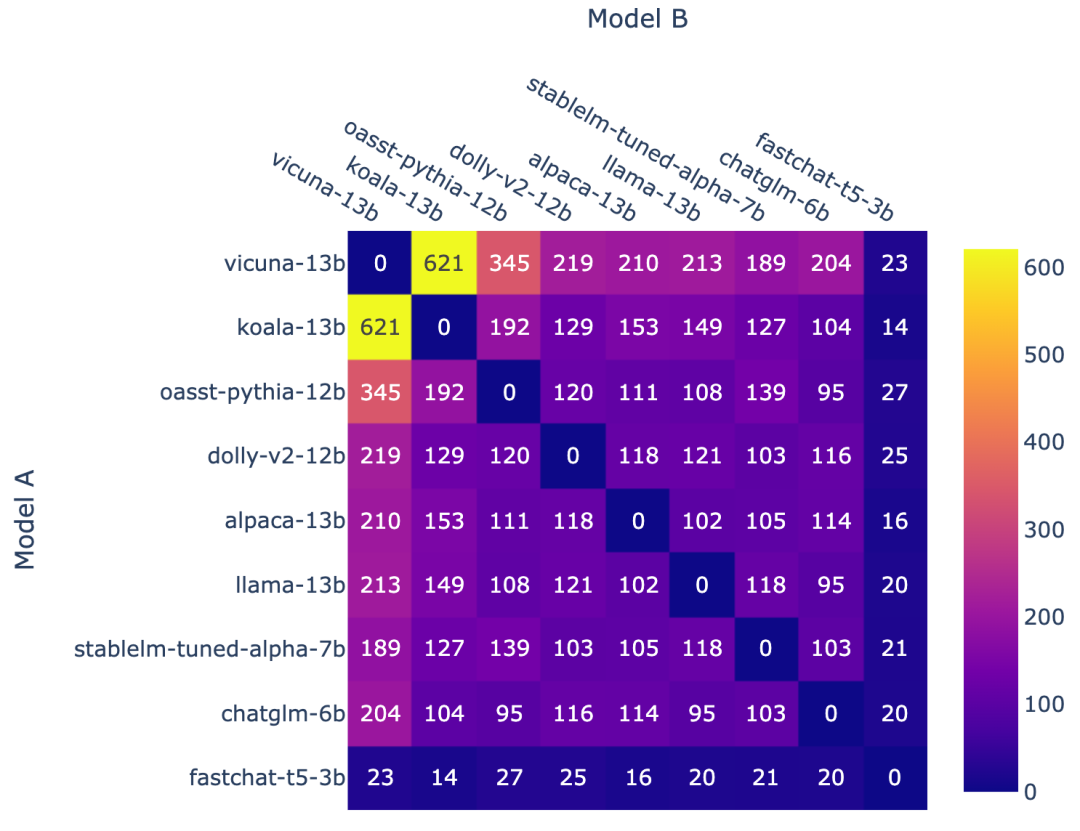

图 2:每个模型组合的战斗计数

图 2 显示了每个模型组合的战斗计数,最初发起比赛时,LMSYS 组织根据他们的基准来配对模型,优先考虑他们认为会是强配对的东西,然后再改用均匀采样来获得更好的排名整体覆盖。最后,在比赛接近尾声时 LMSYS 组织还推出了一种新模型 fastchat-t5-3b ,这样就形成了不均匀的模型频率。

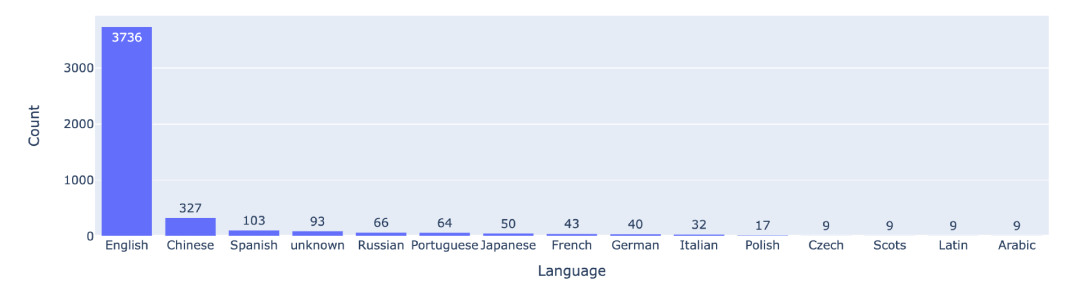

图 3:前 15 种语言的战斗计数

还有,在所有数据中描绘了语言分布,显示大多数用户提示都是英语。

测试模型面临巨大挑战

随着 ChatGPT 的巨大成功,经过微调以遵循指令的开源大型语言模型激增,这些模型能够针对用户的问题/提示提供有价值的帮助。例如,基于 LLaMA 的 Alpaca 和 Vicuna,以及基于 Pythia 的 OpenAssistant 和 Dolly。

尽管每周都会不断发布新模型,但社区在对 LLM 助手进行基准测试极具挑战,因为问题可以是开放式的,响应质量很难评估。在这种情况下,我们通常不得不求助于基于成对比较的人工评估,也是基于成对比较的良好基准系统有一些所需的属性:

可扩展性:当无法为所有可能的模型对收集足够的数据时,系统应该扩展到大量模型。

增量性:该系统应该能够使用相对较少的试验来评估新模型。

独特的秩序:系统应该为所有模型提供唯一的顺序。给定任何两个模型,应该能够分辨出哪个排名更高或者它们是否并列。

但是,其实现有的 LLM 基准系统很少满足所有这些属性。

经典的 LLM 基准框架,例如 HELM 和 lm-evaluation-harness ,为学术研究中常用的任务提供多指标测量。但是,它们不是基于成对比较,所以不能有效地评估开放式问题。OpenAI 也推出了 evals 项目来收集更好的问题,但这个项目不提供所有参与模型的排名机制。LMSYS 组织推出 Vicuna 模型时,他们使用了基于 GPT-4 的评估管道,但它没有提供可扩展和增量评级的解决方案。

Elo 评级系统有望提供上述所需的所有属性!

Chatbot Arena 是一个以众包方式提供匿名随机战斗的 LLM 基准平台。采用 Elo 评分系统,这是一种在国际象棋和其他竞技游戏中广泛使用的评分系统。

为了收集数据,LMSYS 组织在一周前推出了几个流行的开源 LLM 的竞技场。在竞技场中,用户可以与两个匿名模特并排聊天,并投票选出哪个更好。

HELM / lm-评估-线束 | HELM / lm-evaluation-harness | OpenAI/eval | Alpaca Evaluation | Vicuna Evaluation | Chatbot Arena |

题源 | 学术数据集 | 混合 | 自指导评估集 | GPT-4 生成 | 用户提示 |

评估员 | 程序 | 程序/模型 | 人类 | GPT-4 | 用户 |

指标 | 基本指标 | 基本指标 | 赢率 | 赢率 | Elo 评级 |

Elo评级系统

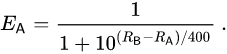

LMSYS 组织根据Elo评分系统来计算玩家相对技能水平,这种方法现已广泛应用于竞技游戏和体育运动中。两名球员之间的评分差异可以预测比赛的结果。

如果玩家 A 的评分为 Ra ,玩家 B 的评分为 Rb ,则玩家 A 获胜概率的确切公式(使用以 10 为底的逻辑曲线)为:

玩家的评分可以在每场战斗后线性更新。假设玩家 A(具有 Rating Ra)被期望得分 Ea 但实际得分 Sa 。更新玩家评分的公式是:

使用收集到的数据,计算了该笔记本中模型的 Elo 评分,并将主要结果放在表 1 中。欢迎大家自己尝试使用投票数据来计算评分。并且,数据只包含投票结果,没有对话历史,因为公开对话历史会引起隐私和病毒等担忧。

双赢率

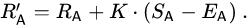

作为校准的基础,LMSYS 组织还展示了锦标赛中每个模型的成对获胜率(图 4)以及使用 Elo 评级估算的预测成对获胜率(图 5)。通过比较数据,发现 Elo 评级可以相对较好地预测胜率。

图 4:模型 A 在所有非平局 A 与 B 战斗中获胜的比例。

图 5:在 A 对 B 战斗中使用模型 A 的 Elo 评级预测胜率

未来的计划

LMSYS 组织计划在以下项目上开展工作:

添加更多闭源模型(ChatGPT-3.5 现已在匿名竞技场可用)

添加更多开源模型

发布定期更新的排行榜(例如,每月)

实施更好的采样算法、锦标赛机制和服务系统以支持更多模型

提供不同任务类型的细粒度排名。

希望所有用户能进行反馈,以使竞技场变得更好。

LMSYS 组织邀请整个社区通过贡献各自的模型并为能提供更好答案的匿名模型投票来加入这项基准测试工作。参与者可以访问 https://arena.lmsys.org 为更好的模型投票。如果想在竞技场中查看特定模型,可以按照指南(https://github.com/lm-sys/FastChat/blob/main/docs/arena.md#how-to-add-a-new-model)添加它。

演示:https: //arena.lmsys.org

排行榜:https: //leaderboard.lmsys.org

GitHub: https://github.com/lm-sys/FastChat

Colab 笔记本:https://colab.research.google.com/drive/1lAQ9cKVERXI1rEYq7hTKNaCQ5Q8TzrI5 ?usp=sharing

推荐阅读:

▶谷歌全面反攻 ChatGPT!PaLM 2、Gemini 双杀,Bard 正式开放

▶OpenAI 最新“神”操作:让 GPT-4 去解释 GPT-2 的行为!

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)