MCP传输层自我革命 - Streamable HTTP协议深度解析

Streamable HTTP的设计基于四大核心原则:最大化兼容性、灵活性、资源效率和可靠性。这一全新协议通过巧妙的设计,完美解决了传统方案的所有痛点。统一端点设计摒弃了专用的 /sse 端点,将所有通信整合到单一的 /message 端点;按需流式传输让服务器可以灵活选择返回标准HTTP响应或升级为SSE流;会话标识机制通过引入会话ID支持状态管理和恢复;灵活初始化允许客户端通过空的GET请求主

Streamable HTTP传输层的推出,标志着MCP协议的重大演进。通过巧妙结合HTTP和SSE的优势,同时克服各自局限性,这一创新为AI应用提供了更加灵活可靠的通信解决方案。它不仅解决了原有传输机制的痛点,更为未来更复杂的AI交互模式奠定了坚实基础。

在人工智能技术飞速发展的今天,AI模型与工具之间的通信协议正在经历一场深刻的变革。近日,Anthropic公司的Model Context Protocol(MCP)迎来了一次重大升级,GitHub上的 #PR206 提出了全新的Streamable HTTP传输层,这一创新性设计将彻底改变现有的AI通信模式。

Model Context Protocol作为连接AI模型与外部工具的桥梁,其重要性不言而喻。随着AI应用场景日益复杂、部署规模不断扩大,原有的通信机制开始暴露出诸多局限性。本文将深入分析这一协议革新的设计理念、技术细节以及实际应用价值。

传统HTTP+SSE模式:看似简单却问题重重

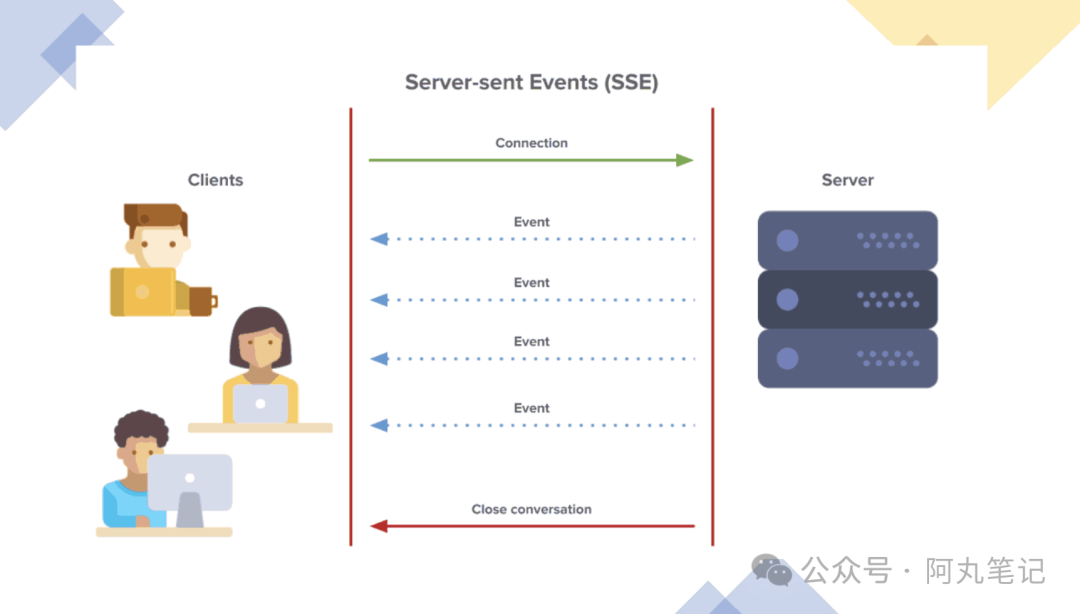

在MCP的原始实现中,客户端与服务器之间采用双通道通信模式:一方面通过标准HTTP请求发送消息,另一方面依赖专用的/sse端点接收服务器推送的事件流。这种设计虽然直观易懂,但在实际应用中却暴露出一些痛点。

重连恢复能力缺失是最严重的问题。当SSE连接因网络波动而中断时,所有会话状态都会丢失,客户端必须重新建立连接并重新初始化整个会话。试想一个场景:用户正在进行大型文件分析任务,但因为WiFi信号不稳定导致连接中断,整个分析过程必须从头开始,用户体验极其糟糕。

服务器资源消耗问题同样严峻。每个客户端都需要维护长期的SSE连接,在高并发场景下会导致服务器资源大量消耗。当服务器需要重启或扩容时,所有连接都会被强制中断,严重影响用户体验和系统可靠性。

更令人困扰的是,即使是简单的请求-响应交互,服务器也必须通过SSE通道返回信息,这种设计不仅增加了不必要的复杂性,还带来了额外的性能开销。某些特定环境(如云函数)根本不适合维护长期的SSE连接。

基础设施兼容性限制则进一步放大了这些问题。许多现有的Web基础设施——包括CDN、负载均衡器和API网关——可能无法正确处理长期的SSE连接。企业防火墙往往会强制终止超时连接,导致服务不稳定。

Streamable HTTP:重新定义AI通信标准

Streamable HTTP的设计基于四大核心原则:最大化兼容性、灵活性、资源效率和可靠性。这一全新协议通过巧妙的设计,完美解决了传统方案的所有痛点。

相比原有机制,Streamable HTTP带来了重要改进:

- 统一端点设计摒弃了专用的 /sse 端点,将所有通信整合到单一的 /message 端点;

- 按需流式传输让服务器可以灵活选择返回标准HTTP响应或升级为SSE流;

- 会话标识机制通过引入会话ID支持状态管理和恢复;

- 灵活初始化允许客户端通过空的GET请求主动建立SSE流。

技术实现:工作流程详解

首先是会话初始化阶段:客户端向/message端点发送初始化请求,服务器可选择性地生成并返回会话ID,该ID将用于标识后续请求中的会话。

客户端到服务器的通信统一通过HTTP POST请求发送到/message端点,如果存在会话ID,则在请求中包含该标识。

服务器响应方式具备三种灵活模式:

- 标准响应直接返回HTTP响应,适用于简单交互;

- 流式响应将连接升级为SSE,发送一系列事件后关闭;

- 长期连接维护SSE连接以持续传递事件。

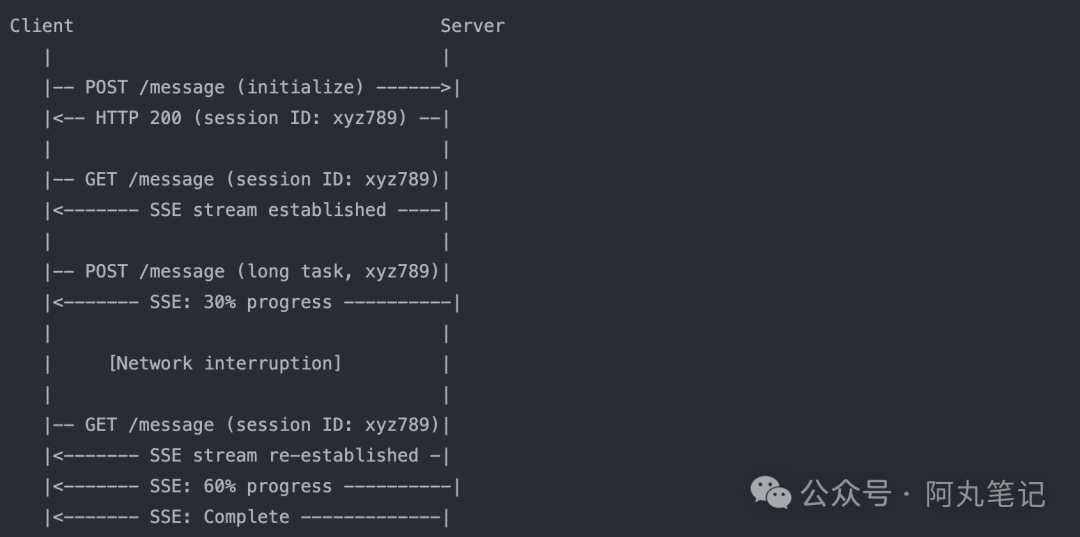

主动SSE流建立是一大创新:客户端可以向/message端点发送GET请求主动建立SSE流,服务器通过此流推送通知或请求。当连接中断时,客户端可以使用之前的会话ID重新连接,服务器能够恢复会话状态并继续之前的交互。

四大应用场景:从简单到复杂的全覆盖

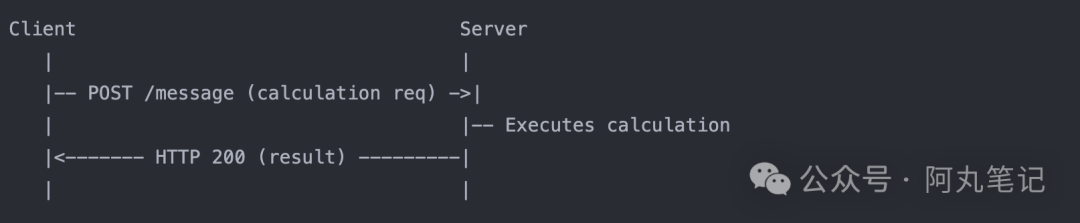

无状态服务器模式

适用于数学计算或文本处理等简单工具API服务。客户端发送计算请求,服务器执行计算后直接返回HTTP 200响应。这种模式的优势在于部署简单、无需状态管理,完美适配无服务器架构和微服务环境。

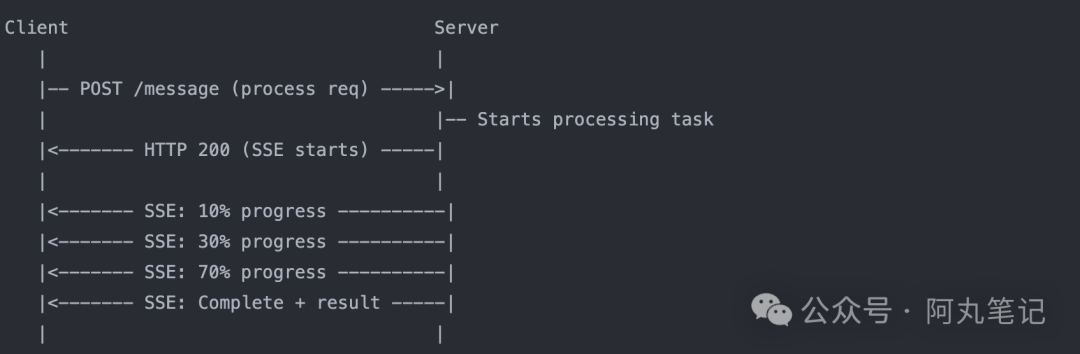

流式进度反馈模式

专为大文件处理或复杂AI生成等长期任务设计。客户端发送处理请求,服务器启动任务并通过SSE流实时推送进度更新(10%、30%、70%等),最终推送完成结果。这种方式提供实时反馈,无需维护永久连接状态。

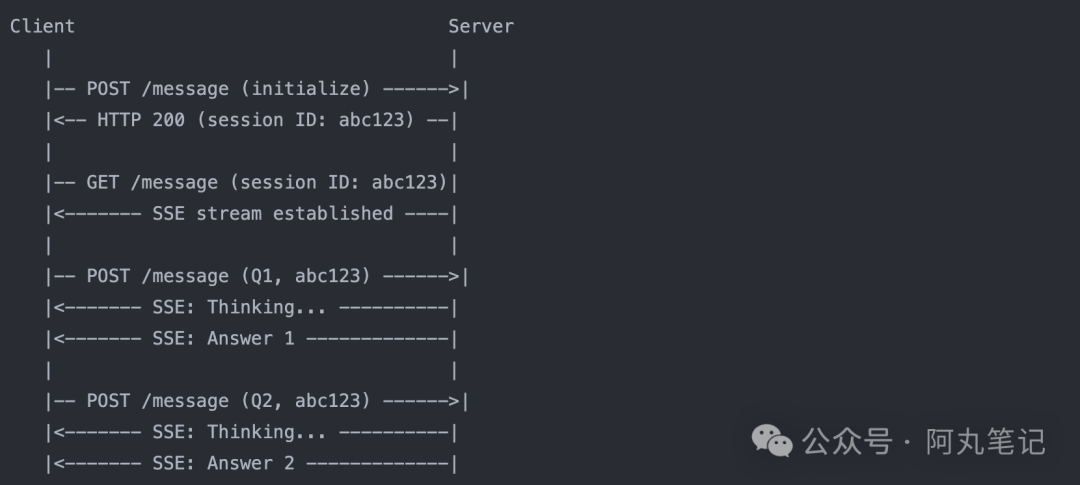

复杂AI会话模式

面向需要维护上下文的多轮AI助手。系统首先初始化会话并分配ID,建立SSE流后,支持多轮问答交互,每次都能保持完整的对话上下文。这种模式不仅维护会话状态,还支持水平扩展,能够处理复杂的交互场景。

断线恢复模式

专门应对网络不稳定环境下的AI应用。当网络中断发生时,客户端可以使用相同的会话ID重新建立连接,服务器能够从中断点继续处理,确保长期任务不会因为网络波动而失败。这大大提升了弱网环境下的用户体验。

核心优势:技术与商业价值双重提升

从技术角度看,Streamable HTTP带来了六大显著优势:

- 实现方式简化,可在标准HTTP服务器上运行,无特殊要求;

- 资源效率大幅提升,按需分配资源,避免为每个客户端维护长期连接;

- 基础设施兼容性优秀,与现有Web基础设施(CDN、负载均衡器、API网关)完美配合;

- 支持水平扩展,可通过消息总线将请求路由到不同服务器节点;

- 渐进式采用策略,服务提供者可根据需求选择实现复杂度;

- 重连支持机制确保会话恢复,显著提升可靠性。

商业价值同样不容小觑:

- 降低运营成本,减少服务器资源消耗,简化部署架构;

- 通过实时反馈和可靠连接显著改善用户体验;

- 适用性广泛,从简单工具到复杂AI交互全面覆盖;

- 扩展性强,支持更多样化的AI应用场景;

- 开发者友好,降低MCP实现的技术门槛。

实现指南:开发者必知要点

服务器端实现需要关注四个核心方面:

- 端点设计要实现单一的/message端点处理所有请求,同时支持POST和GET两种HTTP方法;

- 状态管理需要设计会话ID生成和验证机制,实现会话状态存储(内存、Redis等);

- 请求处理要能够解析请求中的会话ID,确定响应类型,正确处理流式响应的内容类型和格式;

- 连接管理则需要实现SSE流的初始化和维护,妥善处理断连和重连逻辑。

客户端实现同样需要重点关注四个方面:

- 请求构建要能构建符合协议规范的消息,正确包含会话ID;

- 响应处理需要检测响应是标准HTTP还是SSE,解析和处理SSE事件;

- 会话管理要存储和管理会话ID,实现重连逻辑;错

- 误处理则需要处理网络错误和超时,实现指数退避重试策略。

未来展望:AI通信协议的演进方向

Streamable HTTP传输层的推出,标志着MCP协议的重大演进。通过巧妙结合HTTP和SSE的优势,同时克服各自局限性,这一创新为AI应用提供了更加灵活可靠的通信解决方案。它不仅解决了原有传输机制的痛点,更为未来更复杂的AI交互模式奠定了坚实基础。

这一协议设计体现了实用主义哲学,在技术先进性与现有Web基础设施兼容性之间取得了完美平衡。其灵活性使得开发者可以根据自身需求选择最适合的实现方案,从简单的无状态API到复杂的交互式AI应用都能得到很好的支持。

随着这一PR的合并,MCP社区的技术生态将变得更加丰富,为更多开发者降低了采用门槛。可以预见,在不久的将来,我们将看到基于Streamable HTTP的MCP实现在各种AI应用中广泛采用,推动整个行业向更高效、更可靠的方向发展。

这不仅仅是一次技术升级,更是AI通信协议标准化进程中的重要里程碑。Streamable HTTP的成功实施,将为AI应用的大规模部署和商业化应用提供更强有力的技术保障,助力人工智能技术在更广泛的场景中发挥价值。

AI大模型学习福利

作为一名热心肠的互联网老兵,我决定把宝贵的AI知识分享给大家。 至于能学习到多少就看你的学习毅力和能力了 。我已将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

一、全套AGI大模型学习路线

AI大模型时代的学习之旅:从基础到前沿,掌握人工智能的核心技能!

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获取

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获

三、AI大模型经典PDF籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获

四、AI大模型商业化落地方案

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获

作为普通人,入局大模型时代需要持续学习和实践,不断提高自己的技能和认知水平,同时也需要有责任感和伦理意识,为人工智能的健康发展贡献力量

更多推荐

已为社区贡献47条内容

已为社区贡献47条内容

所有评论(0)