深入浅出:大语言模型的“瘦身”秘籍——数值计算精度全解析二

格式总位数指数位尾数位核心特点主要应用场景FP3232823高精度、高范围的标杆传统科学计算,正被训练淘汰FP1616510速度快,但范围窄,易梯度下溢推理,部分训练的混合精度BF161687范围广,训练稳定,精度适中大模型混合精度训练的主力INT88极致压缩,推理加速,需校准模型部署与推理的首选INT4/NF44极限压缩,用于资源极端受限场景边缘设备,手机端侧部署。

上一篇我们了解了数值计算精度的基本概念,就像为模型选择不同的“背包”来装参数。今天,我们将打开这些“背包”,仔细检视其中的内容——主流的数值精度格式。

引言:精度格式的“星辰大海”

如果把大语言模型的训练和推理比作一场远征,那么不同的精度格式就是不同类型的运输工具:有的像重型卡車,运载量大且安全(如FP32);有的像高速跑车,速度快但载重有限(如FP16);还有的像精干的无人机,小巧灵活,能深入前沿阵地(如INT8)。

选择正确的“交通工具”,是决定远征效率与成败的关键。

一、 浮点数的世界:IEEE 754标准

绝大多数深度学习中的数值格式都基于IEEE 754标准。理解它,就理解了精度格式的基石。其核心思想是科学计数法,将一个数字表示为:

数值 = 符号 × 尾数 × 基数^指数

在二进制中,基数为2。一个浮点数由三个字段组成:

• 符号位:决定正负。

• 指数位:决定数值的范围(尺度)。

• 尾数位:决定在该范围内的精度。

接下来,我们看看在这个标准下的几位“主角”。

二、 主流精度格式深度剖析

1. FP32:曾经的“黄金标准”

• 位宽分配:32位 = 1位(符号) + 8位(指数) + 23位(尾数)

• 特点:

◦ 高精度:宽达23位的尾数,提供了非常精细的数值表示能力。

◦ 宽动态范围:8位指数,可以表示非常巨大和微小的数字。

• 优势与劣势:

◦ 优点:计算精确,训练稳定,是传统科学计算的标杆。

◦ 缺点:内存占用大,计算速度慢。存储一个参数需要4字节,对于百亿参数的模型来说,仅权重就需要数百GB内存,难以承受。

• 现状:在LLM的训练中已被混合精度取代,但在某些需要高精度计算的科学仿真中仍是主力。

2. FP16:速度与风险的“双刃剑”

• 位宽分配:16位 = 1位(符号) + 5位(指数) + 10位(尾数)

• 特点:

◦ 内存减半:相比FP32,内存占用和带宽需求直接减半。

◦ 计算加速:能充分利用现代GPU的Tensor Core进行高速计算。

• 核心困境:

◦ 表示范围过窄:仅有5位指数,其能表示的最大正值约为 65,504,最小正规范值约为 5.96×10⁻⁸。这在训练中极易导致梯度下溢——即梯度值小于最小表示范围,直接被舍入为0,导致训练停滞。

• 现状:因其范围问题,在训练中已逐渐被BF16取代,但在推理中仍广泛使用。

3. BF16:为深度学习而生的“黑马”

• 位宽分配:16位 = 1位(符号) + 8位(指数) + 7位(尾数)

• 设计哲学:牺牲精度,保全范围。

◦ 它的指数位与FP32完全一致(8位),因此继承了FP32的宽动态范围。

◦ 它的尾数位只有7位,这意味着在同一个数量级内,它能表示的数值“刻度”比FP16还要稀疏。

• 为什么它在训练中更胜一筹?

◦ 深度学习对数值范围的敏感性远高于对绝对精度的敏感性。一个微小的梯度(如1e-10)如果因为范围不够而下溢为0,是灾难性的;而一个梯度从1.1001变为1.1010,这点精度损失模型完全可以容忍。

◦ BF16完美地避免了FP16的梯度下溢问题,同时保持了FP16的速度和内存优势。

• 现状:已成为大模型混合精度训练中事实上的低精度标准。

4. INT8:推理阶段的“性价比之王”

• 位宽分配:8位,用于表示整数(通常是无符号uint8或有符号int8)。

• 工作原理:量化。它不再是浮点数,而是通过一个缩放因子和一个零点,将一片FP32的数值范围线性映射到256个(2^8)离散的整数上。

◦ 公式简化:FP32_value ≈ scale × (INT8_value - zero_point)

• 特点:

◦ 极致压缩:模型大小仅为FP32的25%。

◦ 整数计算:硬件对整数运算有更好的支持,能极大提升推理速度。

• 挑战:精度损失。由于从无限稠密的浮点数映射到有限的整数,必然会引入误差。这需要通过校准来选择最优的缩放因子,以最小化信息损失。

• 现状:后训练量化是推理加速最主流、最成熟的技术之一。

5. 更低比特的探索:INT4与NF4

当模型需要部署在手机、嵌入式设备等极端资源受限的环境中时,更极致的压缩登场了。

• INT4:

◦ 仅用4位,表示16个等级。压缩率极高,但精度损失风险巨大。

◦ 需要更精巧的量化算法,如GPTQ、AWQ等。

• NF4:

◦ 这是一种在QLoRA微调技术中提出的非均匀数据类型。

◦ 它意识到权重值通常服从一个正态分布,大部分值集中在零点附近。

◦ 因此,NF4设计的量化等级不是均匀分布的,而是在值密集的区域“刻度”更密,在值稀疏的区域“刻度”更疏。这样可以在同样的4比特下,更高效地保留信息。

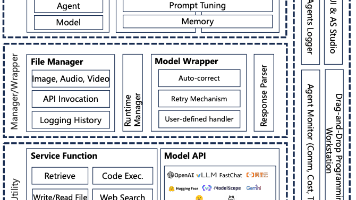

三、 总结与对比

为了让各位读者一目了然,我将这些格式总结成下表:

| 格式 | 总位数 | 指数位 | 尾数位 | 核心特点 | 主要应用场景 |

|---|---|---|---|---|---|

| FP32 | 32 | 8 | 23 | 高精度、高范围的标杆 | 传统科学计算,正被训练淘汰 |

| FP16 | 16 | 5 | 10 | 速度快,但范围窄,易梯度下溢 | 推理,部分训练的混合精度 |

| BF16 | 16 | 8 | 7 | 范围广,训练稳定,精度适中 | 大模型混合精度训练的主力 |

| INT8 | 8 | - | - | 极致压缩,推理加速,需校准 | 模型部署与推理的首选 |

| INT4/NF4 | 4 | - | - | 极限压缩,用于资源极端受限场景 | 边缘设备,手机端侧部署 |

四、 如何选择:没有最好,只有最合适

选择哪种精度格式,是一个典型的权衡艺术。

• 训练阶段:首选BF16与FP32的混合精度。在保证训练稳定性和最终收敛性的前提下,最大化训练速度。BF16因其卓越的稳定性已成为主流。

• 推理阶段:追求极致的效率和延迟。根据对精度损失容忍度和硬件支持情况,依次考虑FP16 -> INT8 -> INT4。INT8是目前性价比最高的选择。

展望未来,我们将会看到更多像NF4这样的非均匀、自适应的精度格式,它们能更智能地匹配模型权重的数据分布。同时,硬件与软件的协同设计也将催生更多专为低精度计算而生的芯片,持续推动大模型技术的普惠化。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)