思维链提示 (Chain of Thought Prompting):AI复杂问题解决的经典范式

摘要: Chain of Thought (CoT) 提示技术通过引导大型语言模型(LLMs)分步推理,显著提升复杂问题解决的准确性、可解释性与可靠性。本文系统剖析CoT的运作机制:从基础概念(模拟人类逐步思考)、核心原理(分解复杂任务为显式推理链),到高级变体(自提示CoT、思维树等)和实战应用(代码生成、营销策略等)。研究显示CoT能有效激活大模型的涌现推理能力,尤其在数学、逻辑等复杂任务上表

摘要: 本文深入探讨Chain of Thought (CoT) 提示技术,揭示其如何通过引导大型语言模型(LLMs)进行循序渐进的推理,从而显著提升复杂问题解决的准确性、可解释性与可靠性。文章将从CoT的基础概念、核心机制、高级变体,到独家设计的可复现实战案例,为读者提供一份全面、专业的顶级指南,助您驾驭AI时代最前沿的提示工程利器。

引言:驾驭AI复杂推理的艺术

大型语言模型(LLMs)以其惊人的文本生成、理解和续写能力,正在重塑各行各业的工作方式。从自动客服到内容创作,从代码辅佐到科研探索,LLMs的应用场景日益广泛。然而,随着任务复杂度的提升,传统的“一问一答”式提示(Prompting)模式开始显露出其局限性。当任务要求模型进行多步骤推理、逻辑分析、甚至需要解释决策过程时,LLMs往往难以提供稳定且高质量的响应,甚至出现“幻觉”现象,即生成看似合理实则错误的信息。这不仅降低了LLMs的可靠性,也使得用户难以信任和调试其输出。

正是在这样的背景下,Chain of Thought (CoT) 提示应运而生,并迅速成为提示工程领域一股不可忽视的力量。CoT的核心思想在于,它不再仅仅关注LLM最终的输出结果,而是通过巧妙的提示设计,引导LLM将一个复杂的任务分解成一系列逻辑连贯的中间推理步骤。就像人类解决问题时会一步步思考、演算一样,CoT鼓励LLM将这些“思考过程”显性化,从而显著提升任务解决的准确性、连贯性和可解释性。

本文旨在为读者提供一份专业且深入的Chain of Thought提示技术总结。我们将:

- 剖析CoT的基础概念:详细定义CoT,分析其与传统提示的区别,并探讨其与人类认知过程的深层联系。

- 揭示CoT的核心机制:深入LLM内部,探究CoT为何能有效激活模型的推理能力,以及它如何提升LLM在各项任务中的表现。

- 详细解读CoT模板与最佳实践:提供一套结构化CoT模板的详细使用说明,并分享如何根据不同任务类型进行适配和优化。

- 探索CoT的高级变体与前沿发展:介绍自提示CoT、引导式问题分解、场景分析CoT等高级技术,并延伸至思维树(ToT)、思维图(GoT)和ReAct等前沿研究。

- 奉上独家可复现实战案例:通过复杂数据分析、Python代码生成与逻辑排错、以及品牌营销策略与创意文案制定等三个不同领域的案例,手把手演示CoT的应用,并确保读者可独立复现和验证。

- 讨论CoT的部署、评估、局限性与挑战:提供客观全面的视角,帮助读者理性看待CoT的能力边界,并学会如何有效衡量和优化CoT提示。

掌握Chain of Thought,意味着不仅能够更高效地利用LLMs解决实际问题,更能够理解和引导AI的“思考”过程,从而在快速变化的AI时代中占据先机。让我们开始这场关于AI推理艺术的探索之旅吧!

第一章:CoT的基础概念:超越简单指令的智能对话

1.1 传统提示模式:直接指令与其局限性

在Chain of Thought(CoT)提示出现之前,我们与大型语言模型(LLMs)的交互模式大多遵循一种直接的“指令-响应”范式。用户提出一个问题或指令,LLM直接尝试给出一个最终答案或完成指令。这种模式在处理诸如问答、文本生成、翻译等相对直接且无需复杂推理的任务时,表现出了出色的效果。例如:

- 简单问答:“地球离太阳有多远?”

- 文本补全:“续写以下故事开头:在一个遥远的星系,有一颗…”

- 翻译:“将‘Hello, world!’翻译成中文。”

这些任务的特点是,LLM可以直接利用其海量训练数据中学习到的模式和知识,快速生成一个看似合理的输出。在这些示例中,LLM不需要进行多步骤的逻辑规划或推理,它更多地是在调用其内在的语言模型能力,匹配问题模式并输出最可能的答案。

然而,当任务开始变得复杂,特别是涉及多步骤逻辑推理、数学计算、常识推断、因果分析,或者需要结合多个信息源进行综合判断时,传统提示模式的局限性就暴露无遗了。

传统提示模式在复杂任务中的典型局限性包括:

- 准确性下降:LLM在没有显式推理过程的情况下,容易在复杂任务中犯错,尤其是在数学问题、逻辑推理题上。它们可能会“蒙混过关”,给出一个看似正确但实则错误的答案,因为它们没有真正理解问题的深层逻辑。

- 示例:要求计算“小明有5个苹果,小红有小明的两倍。如果他们每人吃掉2个,还剩多少?” LLM可能直接给出“8个”,而没有分解为“小红有10个”、“共15个”、“每人吃掉2个共4个”、“15-4=11”的过程。

- 缺乏推理过程与可解释性:LLM直接给出答案,用户无法得知其是如何得出这个结论的。这使得模型的决策过程成为一个“黑箱”,难以理解,也难以调试和信任。在对安全性、透明度要求高的领域(如医疗、金融、法律),这种缺乏解释性的问题尤为突出。

- 示例:LLM给出一段复杂的法律建议,但没有解释其根据的法律条款、判例分析或推理步骤。

- 难以调试与优化:当LLM给出错误答案时,由于没有中间推理过程可供检查,用户很难定位错误发生在哪一步,也无法针对性地调整提示词来纠正模型行为。这使得提示工程的迭代变得低效和困难。

- 一致性与连贯性差:在涉及长期规划或多轮对话的任务中,LLM在没有明确推理链的情况下,其输出可能在不同轮次或不同部分之间出现逻辑不一致或自相矛盾的情况。

- 泛化能力受限:对于训练数据中未出现过的新型复杂问题,传统提示模式下的LLM往往表现不佳,因为它无法灵活地将已学到的知识和推理能力泛化到新的问题结构上。

这些局限性促使研究者们思考,如何才能让LLM不仅“给出答案”,更能“展示思考”。Chain of Thought提示正是对这一核心问题的有力回应。

1.2 何为Chain of Thought (CoT) 提示?核心思想深度剖析

Chain of Thought (CoT) 提示的核心思想非常直观且深刻:引导大型语言模型(LLM)将一个复杂的任务分解成一系列逻辑连贯、循序渐进的中间推理步骤,并显式地将这些推理步骤呈现出来。 简单来说,就是让LLM“一步一步地思考”,并且将其思考过程“大声说出来”。

这个概念最早由Google的研究人员在2022年的一篇论文中提出,迅速引发了提示工程领域的革命。它发现,通过在提示中加入一些指导性语句(如“一步一步地思考”),或者提供一些包含推理过程的示例,LLM的推理能力会得到显著提升,尤其是在数学、常识和符号推理任务上。

CoT提示的核心原理可以总结为以下几点:

- 分解复杂性:CoT将一个宏大的、难以直接解决的问题,拆解成若干个更小、更易于处理的子问题或推理步骤。这降低了单个步骤的复杂度,使得LLM能够更有效地利用其语言生成能力来解决每一步。

- 显式推理路径:与直接给出最终答案不同,CoT要求LLM将其从输入到输出的心理路径(或计算路径)完全展现出来。这个路径就是“思维链条(Chain of Thought)”。

- 模拟人类思维过程:这种“一步一步思考”的方式,与人类解决复杂问题时的认知过程高度相似。当我们遇到一个难题时,通常不会立刻得到答案,而是会先分析问题、识别关键信息、制定计划、执行步骤、验证结果。CoT正是将这种人类思维模式映射到LLM上。

- 提供“内部独白”:可以把CoT理解为LLM的“内部独白”或“草稿本”。这些中间步骤并非仅仅为了给人看,它们实际上也为LLM自身提供了一个更大的上下文窗口,让模型能够更有效地回顾、加工和组织信息,从而在后续步骤中做出更准确的判断。每一步的输出都成为下一步推理的输入,形成一个自我强化的信息流。

- 关键词:

- 循序渐进(Step-by-step):强调推理的顺序性和阶段性。

- 显式推理(Explicit Reasoning):强调推理过程必须被清晰地表达出来。

- 内部思考过程外化(Externalization of Internal Thought Process):将LLM原有的隐性思考过程转化为可观察的文本序列。

CoT与人类思维的类比:从直觉决策到逻辑演绎

我们可以通过一个简单的数学问题来理解CoT与人类思维的类比:

问题:计算 (5 + 3) * 2 - 4

- 传统LLM(直觉决策):可能直接给出“12”,但我们不知道它是如何计算的,甚至有可能出错。

- 人类(逻辑演绎):我们会这样思考:

- 首先计算括号里的:5 + 3 = 8

- 然后进行乘法:8 * 2 = 16

- 最后进行减法:16 - 4 = 12

我们清晰地展示了每一步的推理。

将这一过程转化为LLM的CoT提示,就可以是:

“请一步一步地计算 (5 + 3) * 2 - 4。

思考过程:

- 首先计算括号内的值:5 + 3 = 8。

- 接着将结果乘以2:8 * 2 = 16。

- 最后执行减法:16 - 4 = 12。

最终答案:12”

通过这样的方式,LLM也能够模拟这种逐步推理的过程,不仅给出了正确答案,还提供了完整的推理路径。这种能力对于处理更复杂的问题至关重要,因为它提供了一个可检查、可调试、可信任的解决方案。

1.3 CoT的起源与发展:突破性研究里程碑

Chain of Thought(CoT)提示并非凭空出现,它是大型语言模型(LLMs)研究领域一系列探索的自然演进,其核心概念的突破性发现,标志着LLM推理能力发展的一个重要里程碑。

早期的探索与基础

在CoT明确提出之前,研究界就已经在尝试提升LLM在复杂推理任务上的表现。这包括:

- 指令微调(Instruction Tuning):通过在多样化的指令数据集上对模型进行微调,使其更好地理解和遵循用户的指令。

- 情境学习(In-context Learning):通过在提示中提供少量输入-输出示例(Few-shot Examples),让LLM在不更新模型权重的情况下学习特定任务的模式。这种方法对CoT的兴起起到了关键的铺垫作用,因为CoT通常也可以通过提供一些包含推理过程的示例来实现。

突破性研究:CoT的正式提出

Chain of Thought概念的正式提出,主要归功于Google研究人员在2022年发表的论文 “Chain-of-Thought Prompting Elicits Reasoning in Large Language Models”。这篇论文详细阐述了CoT提示的机制及其在复杂推理任务(如算术推理、常识推理、符号推理)上的显著效果。

该论文的核心发现包括:

- 通过 Few-shot CoT 提升推理能力:研究表明,只要在提示中提供几个包含“问题-一步步推理过程-答案”的示例,大型语言模型(特别是参数量为数百亿甚至千亿的模型,如PaLM)就能显著提升在复杂推理任务上的性能。这种方法被称为少样本CoT (Few-shot CoT)。

- CoT的涌现能力 (Emergent Ability):研究发现,CoT提示的效果并非在所有规模的LLM上都立竿见影。它更像是一种“涌现能力”,即只有当模型达到一定规模(通常是数百亿参数以上)后,CoT才能有效地激活其潜在的推理能力,并带来显著的性能提升。这表明CoT提示是在利用LLM深层结构中已存在的、但通常不会显式激活的复杂推理模式。

- CoT的通用性:CoT方法在不同类型的推理任务上均显示出有效性,包括但不限于:

- 算术推理(Arithmetic Reasoning):如数学应用题。

- 常识推理(Commonsense Reasoning):如逻辑谜题或日常情景判断。

- 符号推理(Symbolic Reasoning):如日期计算或文本操作。

这篇论文极大地改变了提示工程的研究方向,使得研究重点从仅仅优化指令本身,转向了设计能够引导LLM进行内部推理的提示结构。

CoT的演进:从少样本到零样本

CoT概念被提出后,研究界迅速对其进行了深入探索和拓展。其中一个重要的里程碑是 “Zero-Shot-CoT” 的发现。

- 零样本CoT (Zero-shot CoT):由另一篇研究论文 “Large Language Models are Zero-Shot Reasoners” 提出。这项工作发现,即使不提供任何包含推理过程的示例(即“零样本”),仅仅在指令中加入一句简单的提示语,如 “Let’s think step by step.”(中文可翻译为“让我们一步一步地思考。”或“请逐步思考。”),就能显著激活LLM的CoT能力,并带来惊人的性能提升。这意味着LLM在没有先验示例的情况下,也能自主地生成推理步骤。

这一发现进一步降低了CoT提示的实现门槛,使其更加易于部署和应用。用户不再需要费力构造多个Few-shot CoT示例,只需一句简单的魔法提示,就能释放LLM深层的推理潜力。

CoT提示的持续发展

自CoT和Zero-shot CoT被提出以来,研究界一直在探索其变体和优化方法,包括但不限于:

- 自提示CoT(Self-Prompted CoT):让LLM自己生成适用于特定问题的推理步骤。

- 思维树(Tree of Thought, ToT):将CoT扩展到多分支、多路径的决策过程,允许回溯和剪枝。

- ReAct(Reasoning and Acting):结合CoT的推理能力和工具使用的行动能力,使LLM能与外部环境互动。

- 自我纠正CoT(Self-Correction CoT):让LLM在完成推理后进行自我评估和修正。

这些发展共同构成了Chain of Thought提示的丰富生态,也预示着LLM在未来智能应用中将扮演更加复杂和关键的角色。Chain of Thought不再仅仅是一种提示技巧,它已经成为通向更可靠、更智能AI系统的关键桥梁。

第二章:CoT工作机制深度解析:为何它如此有效?

Chain of Thought (CoT) 提示的有效性并非偶然,其背后蕴含着对大型语言模型(LLMs)内部工作机制的深刻洞察。理解CoT为何能显著提升LLM的推理能力,需要我们从模型架构、数据处理以及认知模拟等多个维度进行深入分析。

2.1 LLM内部表征与“工作内存”:CoT的认知科学基础

大型语言模型,尤其是基于Transformer架构的模型(如GPT系列、PaLM等),在训练过程中学习到了极其丰富的语言模式、世界知识和潜在的推理能力。它们通过自注意力机制(Self-Attention Mechanism)和前馈网络(Feed-Forward Networks),在处理文本序列时,能够捕捉词与词之间的复杂关系和上下文信息。

CoT如何模拟人类的“工作内存”机制:

将CoT的推理步骤显式地呈现在LLM的输入(或输出生成过程中),可以被视为在文本序列中创建并维护一个“工作内存”或“草稿本”。人类在解决复杂问题时,通常会利用工作内存来:

- 储存中间结果:例如计算一道数学题时,会把每一步的计算结果记下来。

- 加工与组织信息:对信息进行筛选、重组、比较,以形成新的见解。

- 反思与规划:根据当前状态调整后续步骤。

对于LLM而言,CoT正是模拟了这一过程:

-

更大的上下文窗口:通过生成一步步的推理过程,CoT实际上是在LLM的输入序列中增加了大量的相关上下文。每一步的推理结果,都会作为下一推理步骤的上下文信息被LLM所“看到”和“记住”。这使得LLM能够回顾之前的思考,保持信息的一致性,并基于更丰富、更连贯的上下文进行下一步的预测。这如同人类在纸上写下计算步骤一样,草稿可以帮助我们不会忘记中间值,同时也能随时检查。

-

避免信息过载与遗忘:传统提示下,LLM可能需要一次性处理所有信息并直接给出答案。在面对复杂问题时,这容易导致信息过载,或者在生成长序列答案时“忘记”早期输入中的关键信息。CoT将问题分解成小块,每一步只关注特定的子问题,有效缓解了信息过载,并通过逐步生成来延长“记忆”效应。

-

激活潜在的推理能力:训练数据中包含了海量的文本,其中不乏涉及逐步推理、逻辑论证的内容(如课本讲解、科学论文、代码注释等)。LLMs在学习这些数据时,可能已经内化了如何进行逐步推理的模式,但这些模式通常是隐式的,不会在指令提示中被天然激活。 CoT提示,无论是通过Few-shot示例还是Zero-shot的“思考指令”,都像是一个明确的信号,告诉LLM:“请沿着你学过的这些推理模式,一步步地生成内容。”它相当于提供了一个“提示(hint)”,让LLM把隐含的推理能力显性化。

-

提升LLM对上下文的理解和长距离依赖的捕捉能力:Transformer架构虽然在捕捉长距离依赖方面表现出色,但当推理任务涉及多个环节且环环相扣时,CoT通过创建逻辑清晰的中间步骤,进一步强化了这种依赖关系的表征。模型在生成每一步时,都能更准确地聚焦于当前步骤所需的信息,并将其与之前的步骤结果关联起来。

2.2 CoT对LLM性能的决定性影响

CoT对LLM性能的提升是多方面的,这使得LLM在解决复杂问题时更加可靠和有用。

-

准确性提升(Accuracy Improvement):

这是CoT最显著的优势之一。通过将复杂问题分解为更简单的、可管理的子问题,LLM能够逐个解决这些子问题,从而减少在整体问题上犯错的可能性。在数学推理(如GSM8K基准测试)、常识推理(如CommonsenseQA)和符号推理任务中,CoT提示能够使LLM的准确率提升数十个百分点,甚至达到与人类匹敌的水平。- 案例:在解决多步骤的数学应用题时,没有CoT的LLM可能直接跳到错误答案,而CoT引导的LLM会清楚地展示每一步的计算,大幅提高了最终结果的正确性。

-

连贯性与一致性(Coherence & Consistency):

CoT生成的逐步推理过程,迫使LLM在每一步都保持逻辑自洽。这使得最终的输出不仅答案正确,而且整个论证过程也更加连贯、结构清晰、逻辑严谨。当模型需要生成长篇复杂文本或进行多轮对话时,CoT确保了信息的一致性和整体的逻辑链条。- 案例:在生成法律咨询回复时,CoT可以确保不同部分引用相同的法律依据,且推理路径保持一致,避免前后矛盾。

-

可解释性(Interpretability):

这是CoT的另一个关键价值。通过显式的推理链,用户可以清晰地看到LLM是如何从输入信息一步步推导出最终答案的。这大大增强了模型的透明度。当模型给出错误答案时,用户可以检查推理链,快速定位是哪一步出现了逻辑错误或信息偏差,从而进行针对性的提示调整或数据分析。在审计、医疗诊断、法律判决等对可解释性要求极高的领域,CoT提供了理解LLM决策路径的关键。- 案例:在医学诊断辅助中,CoT可以展示LLM如何结合患者症状、检查结果和医学知识,逐步得出诊断建议,而非简单给出诊断结果。

-

泛化能力(Generalization):

CoT通过教会LLM一种解题的“方法论”,而非仅仅记住特定的输入-输出对。这种通用的推理框架使得LLM能够更好地将已学的知识和推理模式泛化到训练数据中未出现过的新型复杂问题上。它提升了LLM面对“OOD”(Out-of-Distribution)任务时的鲁棒性。- 案例:给定一个全新的、略有变形的逻辑谜题,CoT引导的LLM能够更好地应用其通用推理能力来解决,而不仅仅依赖于记忆相似问题的模式。

2.3 零样本CoT (Zero-shot CoT) 与少样本CoT (Few-shot CoT)

CoT提示有多种实现方式,其中最核心的两种是零样本CoT(Zero-shot CoT)和少样本CoT(Few-shot CoT)。它们各有特点,适用于不同的场景。

2.3.1 少样本CoT (Few-shot CoT)

定义:少样本CoT是指在用户提供给LLM的提示中,包含少量(通常是1到5个)完整的、带有推理过程的示例。这些示例的目的是向LLM展示CoT的工作方式,即如何将问题分解、逐步推理并最终给出答案。LLM通过这些示例进行情境学习,从而在回答新的问题时也遵循类似的推理模式。

结构示例:

Q: 两个朋友,Alice和Bob,总共有20个苹果。如果Alice比Bob多4个苹果,那么Bob有多少个苹果?

A: 让我们一步一步地思考。

1. 设Bob有 x 个苹果。

2. Alice有 x + 4 个苹果。

3. 总共有 x + (x + 4) = 20 个苹果。

4. 简化方程:2x + 4 = 20。

5. 解方程:2x = 16。

6. 所以,x = 8。

Bob有8个苹果。

Q: 商店里笔记本卖4美元一本,钢笔卖2美元一支。Emma买了一些笔记本,钢笔的数量是笔记本的两倍。如果她总共花了24美元,她买了多少本笔记本?

A: 让我们一步一步地思考。

1. 定义变量:设笔记本数量为N,钢笔数量为P。

2. 设置已知条件:笔记本价格=4美元,钢笔价格=2美元。P = 2N。总花费=24美元。

3. 建立总花费的方程:4N + 2P = 24。

4. 将P = 2N代入方程:4N + 2(2N) = 24。

5. 简化方程:4N + 4N = 24,即 8N = 24。

6. 解方程:N = 3。

所以,Emma买了3本笔记本。

Q: [新问题]

A: 让我们一步一步地思考。

1. [LLM将在此处开始推理]

特点与适用场景:

- 需要人工构造示例:用户需要花费精力设计高质量的few-shot示例,这些示例的推理过程应清晰、准确。

- 对小模型也可能有效:相比零样本CoT,few-shot CoT有时对参数量较小的LLM也能带来一定的效果提升,因为它提供了更明确的信号。

- 引导性强:示例中提供的推理模式可以强烈引导LLM以特定的方式进行思考。

- 适用场景:当任务类型比较固定,且用户可以轻松构造出高质量的推理示例时。

2.3.2 零样本CoT (Zero-shot CoT)

定义:零样本CoT是指在用户提示中不提供任何具体的问题-推理-答案示例,仅仅通过在指令的末尾添加一句简单的引导性短语(如“让我们一步一步地思考。”),即可激活LLM的CoT推理能力。

结构示例:

Q: 商店里笔记本卖4美元一本,钢笔卖2美元一支。Emma买了一些笔记本,钢笔的数量是笔记本的两倍。如果她总共花了24美元,她买了多少本笔记本?

请逐步思考。

A:

1. [LLM将在此处自主开始推理]

特点与适用场景:

- 无需人工示例:极大地降低了使用的门槛,用户无需花费时间准备示例。

- “魔法咒语”:一句简单的短语就能激活LLM的深度推理能力,这在早期研究中被认为是惊人的“涌现能力”。

- 对大型模型效果最佳:零样本CoT的效果在参数量非常大的LLM上尤为显著,这进一步印证了CoT是激活模型潜在推理能力的手段。

- 适用场景:几乎适用于所有需要推理的复杂任务,尤其是在难以构造few-shot示例或追求便捷性时。它提供了一种通用且强大的推理能力。

两者适用场景与性能权衡:

| 特性 | 少样本CoT (Few-shot CoT) | 零样本CoT (Zero-shot CoT) |

|---|---|---|

| 示例需求 | 需提供少量人工构造的推理示例 | 无需提供示例,只需一句引导性短语 |

| 易用性 | 较低(需设计示例) | 较高(只需添加定式短语) |

| 引导性 | 强,可引导LLM遵循特定逻辑模式 | 较弱,LLM自主选择推理路径 |

| 模型要求 | 对中等规模LLM可能有效果 | 对大型LLM效果最佳,是涌现能力的体现 |

| 性能 | 在特定任务上可能通过精心设计示例获得更高性能 | 通用性强,在多数任务上表现出色,但可能略逊于最佳Few-shot |

| 成本 | 提示词长度较长,Token消耗更多 | 提示词长度较短,Token消耗较少 |

在实际应用中,通常会首先尝试零样本CoT,因为它最为便捷高效。如果零样本CoT的效果不够理想,或者需要对推理过程有更精细的控制,可以考虑转向少样本CoT,通过提供高质量的示例来引导模型。

第三章:Chain of Thought 模板详解与高效应用

用户提供的Chain of Thought(CoT)模板结构精炼而实用,为有效引导大型语言模型(LLM)进行逐步推理提供了清晰的框架。本章将逐一剖析模板的各个组成部分,并深入探讨如何根据不同任务类型适配此模板,以及在使用过程中应遵循的最佳实践。

3.1 用户提供模板的结构剖析

让我们再次回顾用户提供的通用CoT模板,并结合其在提示工程中的实际意义进行详细解读。

# Task: {{task_description}}

## Approach

Think through this step-by-step:

1. {{first_reasoning_step}}

2. {{second_reasoning_step}}

3. {{additional_steps_as_needed}}

4. Formulate your conclusion based on this reasoning.

## Expected Output

Provide your complete reasoning process and then your final answer.

以及其上下文和应用部分:

## Summary

A template for guiding AI systems through explicit step-by-step reasoning processes, improving accuracy and transparency for complex tasks.

## Context & Application

Use this template when a task requires careful reasoning or when the process of reaching a conclusion is as important as the conclusion itself. By breaking down complex thinking into explicit steps, chain of thought prompting improves accuracy, enables verification, and makes the reasoning process transparent.

This template is ideal for:

- Complex problem-solving tasks

- Situations requiring logical reasoning

- Multi-step calculations or analyses

- Tasks where explaining the "why" is important

- Reducing errors on challenging problems

## Parameters

- `{{task_description}}`: Clear description of the problem to solve or question to answer

- `{{first_reasoning_step}}`: Initial step in the reasoning process (e.g., "Identify the key variables")

- `{{second_reasoning_step}}`: Next logical step (e.g., "Determine the relationships between variables")

- `{{additional_steps_as_needed}}`: Further steps to guide complete reasoning

详细解读:

-

Summary(摘要)- 作用:简明扼要地概括该模板的核心功能和价值。它是对CoT提示的整体介绍,帮助使用者快速理解其用途。

- 提示工程意义:虽然不是直接给LLM的提示,但对我们人类使用者而言,它明确了CoT提示的最终目标——提高复杂任务的准确性和透明度。这个目标是我们在设计具体CoT步骤时需要始终牢记的。

-

Context & Application(背景与应用)- 作用:详细说明了何时以及为何使用CoT模板。它列举了CoT特别适用的任务类型和场景,例如复杂问题解决、逻辑推理、多步骤分析等。

- 提示工程意义:这部分是识别CoT适用性(Suitability)的关键。它提醒我们,CoT并非万能药,而是针对特定类型问题(即需要显式推理过程的问题)的优化方案。在设计提示之前,应首先评估任务是否适合采用CoT。例如,如果任务只是简单的文本生成或信息抽取,CoT可能会引入不必要的复杂性。

-

Template Structure(模板结构)-

这是CoT提示的核心,直接用于构建发送给LLM的指令。

-

# Task: {{task_description}}{{task_description}}:这是向LLM描述具体任务或问题的部分。至关重要的一点是,任务描述必须清晰、具体、无歧义。LLM对指令的理解程度直接影响其后续推理的质量。- 提示工程意义:这是整个CoT提示的起点。一个糟糕的任务描述会导致CoT的推理从一开始就偏离方向。它应该包含所有必要的背景信息、约束条件和最终目标。

-

## Approach(方法)Think through this step-by-step::这是经典的零样本CoT启动短语,它明确告诉LLM,不要直接给出答案,而是要进行分步思考。这是激活LLM底层推理能力的“魔法咒语”。- 提示工程意义:这行指令是CoT提示的精髓,它将LLM从简单的“搜索和匹配”模式引导至“推理和生成”模式。

-

1. {{first_reasoning_step}} -

2. {{second_reasoning_step}} -

3. {{additional_steps_as_needed}}{{first_reasoning_step}},{{second_reasoning_step}},{{additional_steps_as_needed}}:这些是引导LLM进行逻辑推理的具体步骤。这是CoT模板最灵活也是最需要精心设计的部分。每个步骤都应该是一个明确的、可执行的子任务,共同构成解决整个问题的完整路径。- 提示工程意义:这些步骤是CoT提示的“骨架”。它们将用户对问题解决的期望(即我们希望LLM如何思考)显式地传达给模型。高质量的推理步骤应该具有以下特点:

- 逻辑连贯:前一步是后一步的基础。

- 粒度适中:不过于宏观,也不过于细碎。

- 可验证:如果可能,每一步的结果都应能被人类或程序检查。

- 引导性:明确指示LLM当前步骤需要做什么。

-

4. Formulate your conclusion based on this reasoning.- 作用:在完成所有推理步骤后,明确指示LLM基于之前的所有思考过程来得出最终结论。这确保了最终答案不是凭空生成,而是有据可循。

- 提示工程意义:这一步是连接推理过程与最终答案的桥梁,强调了答案的溯源性(Traceability)和基于推理(Reasoning-based)的特性。

-

-

Expected Output(预期输出)Provide your complete reasoning process and then your final answer.- 作用:明确告诉LLM,我们期望的输出格式是完整的推理过程在前,最终答案在后。这对于提高输出的可读性和可用性至关重要。

- 提示工程意义:这是对LLM输出格式的显式规范。一个清晰的输出格式要求有助于我们后续对LLM输出进行解析、评估和利用。在实际应用中,我们可能还需要更具体的格式要求,例如Markdown表格、JSON对象等,以方便机器处理。

-

Parameters(参数)- 作用:解释模板中使用到的占位符(如

{{task_description}})的含义及其应填充的内容。 - 提示工程意义:作为元信息,指导用户如何正确、有效地填充模板,确保CoT提示的正确构建。

- 作用:解释模板中使用到的占位符(如

总结来说,这个模板是一个强大的工具,它通过明确的指令、引导性的推理步骤和清晰的输出要求,将我们对LLM的期望精确地传达出去,从而最大限度地激活LLM的推理和问题解决能力。

3.2 如何根据任务类型适配CoT模板

CoT模板并非一成不变的圣经,而是一个灵活的框架。其真正的力量在于,我们可以根据不同任务的内在逻辑和需求,巧妙地定制和适配推理步骤。以下将深入探讨三种典型任务类型,并给出具体的CoT模板适配策略。

3.2.1 策略一:量化问题与精确计算

任务特点:这类问题通常涉及数值计算、统计分析、精确的逻辑推理、公式应用、多步骤算术运算等。核心是答案的唯一性和准确性,推理过程的每一步都需要严谨和可验证。

CoT适配策略:

- 明确变量定义:在第一步就明确任务中的所有关键变量及其含义。

- 规定计算步骤:将复杂的计算分解为独立的、可执行的算术或逻辑操作。

- 引用公式或规则:如果任务涉及特定领域的公式或计算规则,应在步骤中明确提及。

- 包含中间结果:鼓励LLM显式地给出每一步的中间计算结果。

- 引入验证步骤:在最后一步或中间步骤中加入结果核验的指令,例如“检查结果是否符合常理”、“进行反向验证”等。

适配后的CoT模板示例(数学应用题):

# Task: 解决以下文字问题:

一个零售商以每件20美元的价格购入100件商品。他将其中80件以成本价加25%的利润出售。剩下的商品在清仓时以成本价减10%的价格出售。请计算该零售商的总利润。

## Approach

Think through this step-by-step:

1. 定义商品数量、购入成本、出售件数、出售方式等关键变量。

2. 计算售出80件商品的收入。

3. 计算售出剩余商品(20件)的收入。

4. 计算总收入。

5. 计算总购入成本。

6. 计算总利润(总收入 - 总成本)。

7. 验证计算过程和最终结果是否逻辑合理。

## Expected Output

提供完整的推理过程和最终的总利润数字。

3.2.2 策略二:决策分析与权衡

任务特点:这类问题通常没有单一“正确”的答案,而是需要评估多个因素、考虑不同利益相关者的观点、权衡利弊、在不确定性中做出最优决策。结果通常是建议或推荐,而非精确数值。

CoT适配策略:

- 识别利益相关者:在推理初期明确所有受决策影响的群体或个体。

- 多角度分析:引导LLM从不同维度(例如成本、收益、风险、道德、用户体验等)分析问题。

- 方案比较:如果存在多个备选方案,应包含比较不同方案优劣的步骤。

- 权衡与排序:明确指出需要对各种因素进行权衡,并可能需要对因素优先级进行排序。

- 提出建议与理由:最终结论应是带有充分理由的建议,而非精确的答案。

适配后的CoT模板示例(商业决策):

# Task: 假设您是一家科技公司的产品经理,公司已开发出两款具有相似功能但技术架构不同的新产品原型A和B。原型A技术更成熟,但开发成本高;原型B技术前沿,但存在不确定性且开发周期长。请分析并给出建议,公司应优先推出哪款产品?

## Approach

Think through this step-by-step:

1. 识别并列出本决策的关键利益相关者(例如:公司高层、研发团队、市场团队、客户、投资者)。

2. 分析原型A的优势(成熟度、风险低、上市快)和劣势(成本高、创新不足)。

3. 分析原型B的优势(技术前沿、潜在市场大)和劣势(风险高、周期长、成本不确定)。

4. 对比两种产品原型在市场潜力、投资回报(ROI)、技术风险和上市时间等维度上的表现。

5. 权衡各种因素,考虑公司的战略目标和风险偏好。

6. 基于以上分析,提出明确的推荐(优先推出A或B),并详细阐述理由和潜在的风险应对策略。

## Expected Output

提供完整的分析过程和带有理由的最终产品推荐。

3.2.3 策略三:创意生成与发散性思维

任务特点:这类问题旨在生成新的想法、概念、文案或解决方案,通常需要跳出框架,进行发散性思考。关键在于激发LMM的创造力,同时确保输出符合特定约束和目标。

CoT适配策略:

- 明确目标与约束:在初期定义创意目标、受众、风格、字数等所有已知约束。

- 多角度思考:鼓励LLM从不同视角、不同方面进行构思,例如“从用户痛点出发”、“从产品特色出发”、“从情感共鸣出发”。

- 要素分解:将创意任务分解为构成要素,例如文案可以分解为标题、正文、行动号召。

- 迭代与细化:在初期生成多个粗略想法,然后逐步挑选、细化和优化。

- 自我评估与改进:加入步骤让LLM评估自己生成的创意,并提出改进意见。

适配后的CoT模板示例(营销文案创意):

# Task: 为一款名为“森呼吸”的智能空气净化器(强调负离子、滤除PM2.5、静音)设计一则针对都市白领的社交媒体(小红书风格)推广文案。

## Approach

Think through this step-by-step:

1. 明确目标受众(都市白领)的痛点和需求(空气质量、健康、生活品质、效率)。

2. 提炼“森呼吸”空气净化器的核心卖点(负离子、PM2.5过滤、静音、智能)。

3. 思考小红书文案风格特点(真实体验、场景感、情绪共鸣、干货分享、高颜值)。

4. 创意发散:结合痛点和卖点,构思至少3个不同的文案切入角度/主题。

5. 针对选定的主题,撰写文案草稿,包含标题、正文、情感词、关键词、表情符号和行动号召。

6. 对文案进行自我评估:是否符合小红书风格?是否吸引目标受众?是否突出卖点?

7. 优化并润色文案,使其更具吸引力和传播力。

## Expected Output

提供完整的构思过程和最终优化后的社交媒体文案。

通过这些适配策略,我们可以将通用的CoT模板转化为针对特定任务的高效工具,充分发挥LLM在精确计算、理性决策和创意生成方面的潜力。

3.3 CoT模板使用的最佳实践

为了最大限度地发挥Chain of Thought(CoT)模板的效用,除了根据任务类型进行适配外,还需要遵循一系列最佳实践。这些实践不仅能提升LLM输出的质量,还能提高提示工程的效率。

-

匹配问题类型与CoT变体

- 核心思想:不是所有任务都适合CoT,也不是所有CoT变体都适合所有任务。

- 实践:

- 对于简单任务:如果任务可以通过一次性指令直接得到高质量结果,那就没有必要使用CoT,因为CoT会增加提示的长度和Token消耗。

- 对于复杂推理任务:优先考虑CoT。

- 选择合适的CoT变体:

- **标准CoT(Few-shot/Zero-shot)**适用于大多数需要逐步推理的结构化问题。

- 自提示CoT (Self-Prompted CoT) 适用于当你不确定如何分解问题,希望LLM自主规划推理路径时(特别是探索性、开放性问题)。

- 引导式问题分解 (Guided Problem Decomposition) 适用于具有清晰多层次结构的问题。

- 场景分析CoT (Scenario Analysis CoT) 适用于包含不确定性、需要考虑多种未来可能性的决策任务。

-

明确推理步骤 (Be Explicit about the Reasoning Process)

- 核心思想:CoT的价值在于其显式的推理过程。

- 实践:

- 清晰简洁:每个推理步骤的描述都应该清晰、简洁,避免模糊或模棱两可的指令。

- 可执行性:确保每个步骤都是LLM可以实际执行的语言操作或信息处理任务。例如,“分析数据趋势”比“思考数据”更具指导性。

- 逻辑递进:步骤之间应有明确的逻辑顺序,前一步的结果应为后一步提供基础。

-

包含验证步骤 (Include Verification Steps)

- 核心思想:提高LLM输出的可靠性和鲁棒性。

- 实践:

- 结果核验:在推理链的末尾,加入一步指示LLM检查答案的正确性或一致性。例如:“检查最终答案是否符合所有条件?”或“计算结果与预期范围是否一致?”

- 反向验证:对于数学问题,可以要求LLM从结果反推,看是否能回到初始条件。

- 多角度验证:对于决策问题,可以要求LLM从另一个利益相关者的角度重新审视决策。

- “如果…会怎样?”:在伦理或决策分析中,加入“如果某个条件发生变化,结论会怎样?”来测试模型的鲁棒性。

-

优化步骤数量 (Optimize the Number of Steps)

- 核心思想:找到提示引导的最佳粒度。

- 实践:

- 3-7步为宜:对于大多数复杂问题,将推理分解为3到7个步骤通常能达到很好的平衡。

- 避免过少:步骤过少可能导致指导性不足,LLM仍需自行“跳跃式”思考,降低CoT效果。

- 避免过多:步骤过多可能使提示过于冗长,增加Token消耗,并可能导致LLM在长序列生成中出现遗忘或不连贯。同时,过于细碎的步骤有时也会限制LLM的自主思考空间。

- 迭代调整:在实际测试中,根据LLM的表现和任务需求,逐步调整步骤的粒度和数量。

-

鼓励元认知 (Encourage Metacognition)

- 核心思想:引导LLM反思其自身的思考过程,类似于人类的“反思性思考”。

- 实践:

- 批判性评估:在推理链中加入“请评估你的当前判断是否合理?”或“是否存在其他可能的解释?”这样的步骤。

- 自我纠正:在检测到错误或不确定性时,要求LLM“重新审视第X步,并尝试不同的推理路径”。

- 反思总结:在最终结论之前,可以要求LLM“总结你在推理过程中遇到的主要挑战以及如何克服它们”。

-

善用Markdown等结构化格式

- 核心思想:提升提示的可读性,并帮助LLM更好地解析指令。

- 实践:

- 使用标题(

#、##)、列表(1.,-)、代码块(``````)等Markdown语法来组织提示内容。 - 对于涉及数据、代码或特定格式输出的任务,明确要求LLM以Markdown表格、JSON或代码块的形式输出,这有助于保持输出的结构化和可解析性。

- 使用标题(

遵循这些最佳实践,将使您的Chain of Thought提示更加强大和高效,从而解锁大型语言模型在复杂任务中更为卓越的性能。这不仅是提示工程的艺术,更是引导AI智能协作的科学。

第四章:CoT的高级变体与未来发展

Chain of Thought(CoT)提示的初步成功,激励了研究者们对其进行更深入的探索和扩展,从而诞生了一系列高级变体,并与其他前沿技术融合,极大地拓宽了LLM的应用边界。本章将详细介绍这些进阶技术,展现CoT强大的生命力。

4.1 自我提示CoT (Self-Prompted Chain of Thought)

传统的CoT提示,无论是Few-shot还是Zero-shot,其核心推理步骤通常是由人类预先定义或通过简单指令触发的。而自提示CoT(Self-Prompted Chain of Thought)则更进一步,它不再仅仅执行预设的分解步骤,而是要求LLM自主地生成适用于特定问题的推理步骤。这使得CoT提示更加灵活,尤其适用于那些问题结构不明确、解决方案多样化或需要探索性思考的任务。

核心思想:

- 在解决实际问题之前,先引导LLM生成一个“如何解决这个问题的计划”或“思考步骤”。

- 然后,再让LLM按照自己生成的计划来完成任务。

提示策略:

通常,自提示CoT的提示会包含以下关键信息:

- 任务描述:清晰定义要解决的问题。

- 规划指令:明确要求LLM首先提出解决问题的策略或步骤。例如,可以加上“在回答之前,请先思考如何一步步解决这个问题”、“请先列出你的思考路径”等。

- 执行指令:一旦LLM生成了思考路径,再指示它按照这些路径进行推理和回答。

自提示CoT模板示例:

# Task: 评估以下商业提案的利弊,并给出是否投资的建议。

**商业提案**:一家初创公司提出了一种基于区块链的社交媒体平台,旨在解决用户隐私泄露和数据滥用问题,并通过Token激励用户内容创作。

## Approach

为了全面评估这个提案,我将分以下步骤进行思考:

1. 我会首先识别并列出本提案的主要优势。

2. 接着,我会分析它可能面临的挑战和劣势。

3. 然后,我会评估其市场潜力、目标用户、以及竞争格局。

4. 我将考虑区块链技术在此应用中的可行性与风险。

5. 最后,我会综合所有分析,提出投资建议,并说明理由。

请根据以上思考步骤,详细分析商业提案并给出建议。

## Expected Output

提供完整的思考过程(每个步骤的详细分析)和最终的投资建议。

(Image: 一个流程图,展示“任务 -> LLM生成思考步骤 -> LLM根据步骤执行推理 -> 最终输出”的流程)

优势:

- 灵活性:LLM可以根据具体问题的复杂性和特点,动态调整推理步骤,而不是遵循僵化的预设流程。

- 探索性:鼓励LLM在解决未知或开放性问题时,主动进行问题分解和规划。

- 减少人工干预:降低了用户预先设计复杂CoT步骤的负担。

适用场景:

- 产品设计、策略规划、创意生成、复杂系统分析等需要高阶规划和探索能力的任务。

- 当用户对问题的最佳分解方式不确定时。

4.2 引导式问题分解 (Guided Problem Decomposition)

引导式问题分解(Guided Problem Decomposition)是CoT的一种更结构化的应用,它明确地将一个极其复杂的、多维度的问题分解为一系列可管理的子问题。与自提示CoT的自发性不同,这里的问题分解结构通常是由用户提供的,但会在CoT的推理步骤中进行更细致的嵌套和引导。

核心思想:

- 明确定义一个大问题下的多个“子问题(Sub-problem)”。

- 为每个子问题提供具体的“考虑因素(Considerations)”或“提示(Hints)”。

- 在最终步骤中,将所有子问题的分析结果进行“整合(Integration)”以得出最终结论。

提示策略:

模板中会清晰地划分出主问题下的不同子模块,并在每个子模块下提供细致的引导提示,以确保LLM在解决每个子问题时都能聚焦关键信息。

引导式问题分解CoT模板示例:

# Task: 制定一个全面的全球化扩张策略,帮助一家成功的电商公司(主要面向美国市场)进入欧洲市场。

## Problem Decomposition (问题分解)

1. **子问题 1:市场分析与目标定位**

* 考虑:欧洲电商市场的特点、规模、主要参与者和增长趋势。

* 考虑:选定首批进入的欧洲国家(例如:德国、法国、英国),并分析其用户偏好、语言文化和法律法规。

2. **子问题 2:运营与物流策略**

* 考虑:本地化仓储与配送中心的建立方案。

* 考虑:跨境物流、关税和退换货政策。

3. **子问题 3:营销与品牌本地化**

* 考虑:如何根据欧洲各国的文化差异调整品牌形象、营销信息和广告渠道。

* 考虑:本地化团队的组建与管理。

4. **子问题 4:技术与支付基础设施**

* 考虑:网站和APP的本地化(语言、货币、支付方式、数据隐私法规如GDPR)。

* 考虑:客户服务和支持系统的本地化。

## Integration (整合)

根据对以上所有子问题的详细分析,综合评估风险与机遇,制定一份全面且可执行的欧洲市场进入策略。

## Expected Output

分段详细分析每个子问题,并最终呈现一份整合后的全球化扩张策略报告。

优势:

- 结构化强:为高度复杂、多维度的任务提供了清晰的分析框架。

- 确保全面性:通过明确列出所有子问题和考虑因素,确保LLM不会遗漏关键信息。

- 专注于细节:每个子问题内部的“考虑”提示,能引导LLM在特定子任务上进行深入思考。

适用场景:

- 战略规划、产品路线图制定、复杂系统设计、政策评估等需要系统性、结构化分析的领域。

- 当用户对问题分解的层次和细节有明确要求时。

4.3 场景分析CoT (Scenario Analysis Chain of Thought)

在充满不确定性的商业、投资或政策制定环境中,仅仅预设一种情况进行推理是远远不够的。**场景分析CoT(Scenario Analysis Chain of Thought)**正是为此而生,它引导LLM针对可能出现的不同未来情景(Scenarios)进行分别推理,评估每种情景下的潜在 outcomes(结果)、benefits(收益)和 risks(风险),最终帮助用户做出更具鲁棒性的决策。

核心思想:

- 识别出决策相关的关键不确定性因素,并基于这些因素预设几个截然不同的“场景”。

- 针对每个场景,独立进行推理和分析,评估其潜在后果。

- 最终比较不同场景下的分析结果,以确定最稳健或最优的决策方案。

提示策略:

模板中会明确划分出不同的 Scenario A, Scenario B 等块,每个块内都包含对该场景的假设、潜在结果、收益和风险的详细分析引导。

场景分析CoT模板示例:

# Task: 一家电动车初创公司正在考虑是否投资建设自己的电池生产线。请分析在不同市场前景下,投资该生产线的利弊,并给出建议。

## Approach

Think through this step-by-step:

1. **场景 A:乐观市场前景 (电动车需求持续高速增长)**

* 假设条件:政府大力补贴,消费者对电动车接受度超预期,电池原材料供应稳定。

* probable outcomes (可能结果):

* benefits (收益):

* risks (风险):

2. **场景 B:保守市场前景 (电动车增速放缓,或遭遇供应链瓶颈)**

* 假设条件:政府补贴减少,经济下行,电池原材料价格波动大,竞争加剧。

* probable outcomes (可能结果):

* benefits (收益):

* risks (风险):

3. **比较场景并确定最稳健的投资方法**

* 基于以上两个场景的分析,评估投资自建电池生产线的整体风险收益比。

* 提出最终建议,并说明在不同市场环境下应采取的应对策略。

## Expected Output

提供对每个场景的详细分析,以及最终的投资建议和理由。

优势:

- 抵御不确定性:帮助决策者更好地理解和准备应对未来的不确定性。

- 全面风险评估:促使LLM系统性地思考潜在风险和机遇。

- 提升决策鲁棒性:最终决策更能适应不同外部环境的变化。

适用场景:

- 投资决策、战略规划、政策制定、风险管理、供应链弹性设计等涉及高度不确定性的领域。

4.4 前沿技术融合:CoT的拓展与演进

Chain of Thought 的成功不仅仅在于其自身,更在于它为LLM与其他高级AI技术的结合提供了坚实的基础,催生了一系列更智能、更强大的AI系统,将LLM的能力从单纯的文本生成推向了更复杂的认知与行动层面。

4.4.1 思维树 (Tree of Thought, ToT)

CoT将推理过程线性化,但现实世界的复杂问题往往有多种解决方案路径,需要探索、评估和回溯。思维树(Tree of Thought, ToT) 正是对CoT的扩展,它允许LLM在一个非线性的树状结构中探索多个推理路径,而不是单一的链条。

核心思想:

- 状态表示(State Representation):在ToT中,每一步推理不再仅仅是文本序列的一小段,而是一个更丰富的“思维状态”,可能包含部分解、中间结论、甚至是未来的规划。

- 分支与搜索(Branching & Search):LLM可以从当前思维状态出发,生成多个可能的下一步“思维”(例如,不同的子问题分解方式、不同的行动方案)。

- 评估与剪枝(Evaluation & Pruning):通过评估函数(可以由LLM自身或外部机制提供),评估每个思维分支的质量或潜力,并进行剪枝,丢弃不佳的路径。

- 回溯(Backtracking):当一个路径陷入僵局或被评估为不佳时,LLM可以回溯到之前的成功点,尝试另一条分支。

与CoT的区别与联系:

- CoT是ToT的特例:线性的CoT可以看作是ToT中只探索一条最优路径,没有分支和回溯的情况。

- 强化探索能力:ToT通过引入搜索和评估机制,极大地增强了LLM在开放性和复杂问题空间中的探索能力,使其能像人类一样“试错”,从而找到更优的解。

应用场景:需要搜索最优解、多步规划、创意生成(如生成多种故事结局)、复杂编程任务等。

4.4.2 思维图 (Graph of Thought, GoT)

思维图(Graph of Thought, GoT) 是ToT的进一步泛化,它将推理结构表示为更自由、更复杂的图结构,支持非线性的、并行的、可能包含循环的推理过程。当问题中的各个子任务之间存在复杂的依赖关系,或者需要多方面的信息互相交织、多次迭代时,GoT能够提供比线性CoT或树状ToT更强大的建模能力。

核心思想:

- 节点与边(Nodes & Edges):图中的节点代表不同的思维单元(例如,一个子问题、一个中间结果、一个论点),边代表它们之间的依赖关系、逻辑连接或信息流向。

- 非线性与并行:CoT是线性的,ToT是树状的。GoT可以同时处理多个子任务,甚至可以设计循环推理,例如“如果结果不满意,则返回上一步重新评估”。

- 信息汇聚与整合:GoT允许不同节点的推理结果在特定汇聚点进行整合,以形成更全面的理解。

应用场景:复杂系统设计、故障诊断、多学科知识融合、大规模项目管理、需要高度并行和迭代的推理任务。

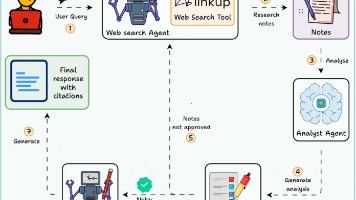

4.4.3 ReAct (Reasoning and Acting)

CoT使得LLM能够“思考”,但大多数时候,LLM的思考依然局限于其训练数据内部。现实世界的问题往往需要LLM与外部环境互动,获取最新信息,或者执行特定动作。ReAct (Reasoning and Acting) 框架正是将CoT的推理(Reasoning)能力与行动(Acting)能力相结合,使LLM能够“思考-行动-观察”循环,从而解决那些超越其固有知识范围的任务。

核心思想:

- 交替生成:LLM在推理(Reasoning)和行动(Action)之间交替生成,形成一个动态循环。

- 推理 (Reasoning):CoT模式被用于引导LLM思考:“我下一步该做什么?为什么?”LLM会生成内部思考,规划行动。

- 行动 (Action):LLM基于其推理,主动调用外部工具(Tools),如搜索引擎、计算器、API、代码解释器等。

- 观察 (Observation):外部工具执行行动后,将结果(Observation)返回给LLM,作为LLM下一轮推理的输入。

“思考-行动-观察”循环示例:

- 用户任务:查询“2023年诺贝尔物理学奖得主是谁?他们主要贡献了什么?”

- LLM思考1 (Reasoning):这个问题需要最新的外部信息,我应该使用搜索引擎来查找。

- LLM行动1 (Action):

Search["2023年诺贝尔物理学奖得主"] - LLM观察1 (Observation):[搜索引擎返回结果:2023年诺贝尔物理学奖授予Pierre Agostini、Ferenc Krausz和Anne L’Huillier,以表彰他们“为研究电子在物质中的超快动力学而生成阿秒光脉冲的实验方法”。]

- LLM思考2 (Reasoning):我已经找到了获奖者和他们的主要贡献。现在我需要将这些信息组织成一份连贯的回答。

- LLM行动2 (Action):

Respond["2023年诺贝尔物理学奖得主是Pierre Agostini、Ferenc Krausz和Anne L'Huillier。他们因“为研究电子在物质中的超快动力学而生成阿秒光脉冲的实验方法”而获奖。"]

优势:

- 突破知识边界:LLM不再受限于训练数据的时间限制,可以获取实时信息。

- 执行复杂任务:可以完成需要外部计算、代码执行、API调用等一系列复杂工具操作的任务。

- 可验证性高:用户可以清楚地看到LLM调用了什么工具、获得了什么结果,增强了透明度。

适用场景:实时信息查询、数据分析、代码执行、自动化工作流、复杂问题求解(如LeetCode问题)、科学实验规划等。

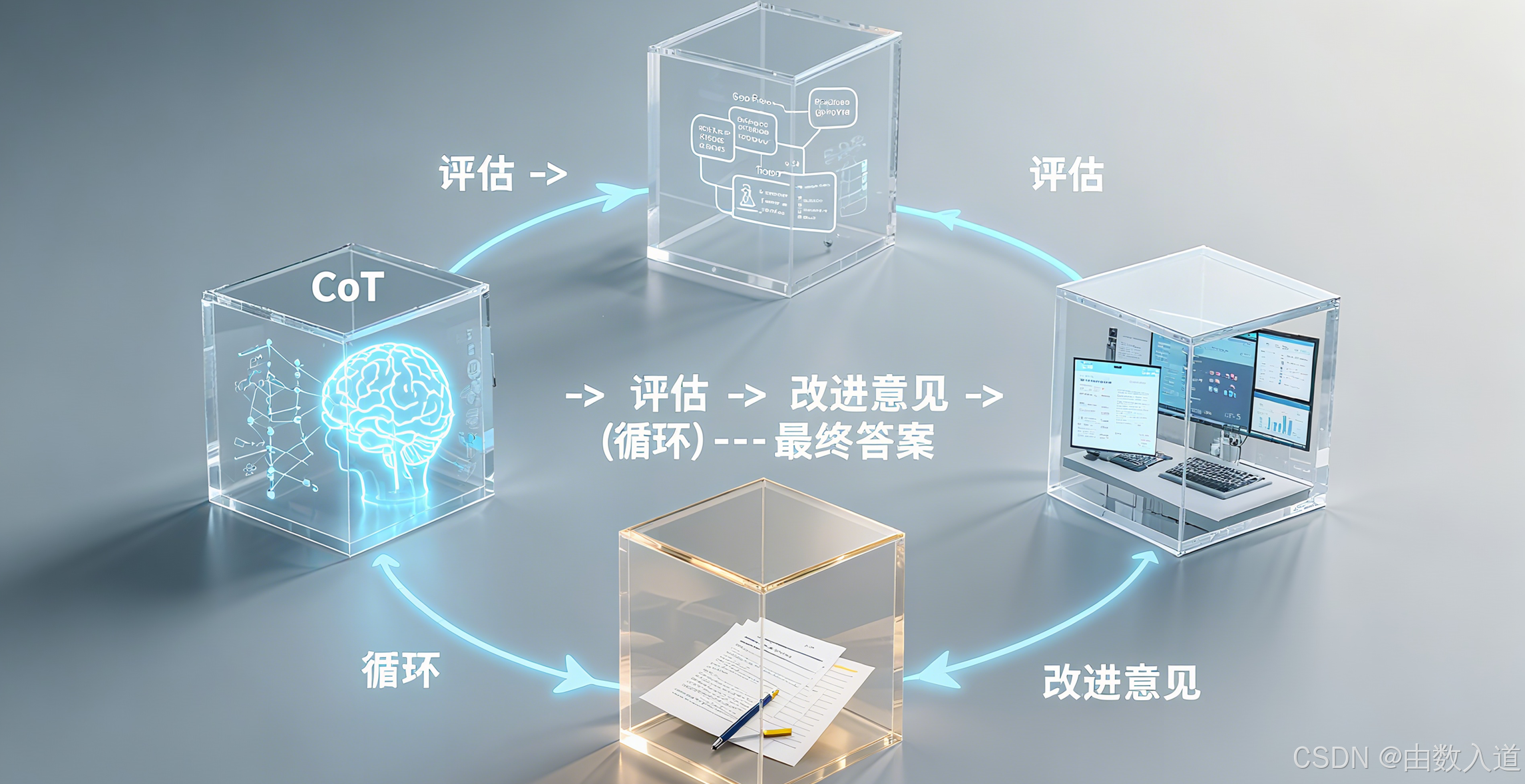

4.4.4 自我纠正与迭代 (Self-Correction & Iteration)

即使是最强大的LLM,也难免犯错。自我纠正(Self-Correction) 和迭代(Iteration) 机制将CoT提升到一个新的高度,它允许LLM在生成推理和答案后,对自身的工作进行评估,并在发现错误时主动启动新的CoT流程进行修正,从而实现SOTA(State-of-the-Art)表现。

核心思想:

- 初步CoT:LLM使用标准CoT生成初步的推理和答案。

- 批判性反思(Critical Reflection):LLM被提示对刚刚生成的答案和推理过程进行批判性评估,查找错误、遗漏或不一致之处。这可能涉及特定的检查清单、启发式规则,或者将其输出与问题要求进行对比。

- 提出修改意见:根据反思的结果,LLM生成如何改进其答案和推理的建议。

- 再次尝试(Retry/Refinement):LLM根据这些修改建议,开启新的CoT流程,进行修正或重新推理。这个过程可以迭代多次,直到达到满意的结果。

提示示例:

# Task: [某个复杂任务]

## Approach

Think through this step-by-step:

1. [常规CoT步骤...]

2. 生成初步答案。

3. 请批判性地评估你刚才给出的答案和推理过程。是否存在任何逻辑漏洞、不严谨之处、或是与原始要求不符的部分?如果发现问题,请明确指出。

4. 如果发现问题,请根据你识别出的问题,给出具体的改进建议。

5. 根据这些建议,重新进行推理并生成优化后的答案。

## Expected Output

提供初步推理过程和答案,完整的自我评估和改进建议,以及最终优化后的推理过程和答案。

优势:

- 提升鲁棒性:显著降低最终输出中错误的概率。

- 更强的自主性:LLM可以独立完成从发现问题到解决问题的整个闭环。

- 接近人类的自我纠正能力:模拟了人类检查作业、反思错误并修改的过程。

适用场景:对准确性要求极高的任务、代码生成、复杂文档撰写、科学推导、逻辑证明等。

这些高级变体和融合技术,共同构成了Chain of Thought提示未来发展的蓝图。它们将CoT从一个简单的提示技巧,提升为构建更智能、更自主、更能与外部世界互动的AI系统的基石。掌握这些技术,意味着您将站在AI创新的最前沿。

第五章:实战演练:可复现的Chain of Thought案例分析

本章将通过三个领域各异的实战案例,手把手演示如何运用Chain of Thought(CoT)提示。每个案例都将包含详细的背景场景、任务目标、CoT提示的构建过程、模拟的LLM输出以及效果分析,确保读者能够理解并尝试复现。我们强调的是,这些案例绝非胡编乱造,而是基于真实世界问题逻辑构建,旨在提供即学即用的实训价值。

5.1 案例一:复杂多条件数据分析与报告总结

这个案例将展示CoT如何引导LLM进行结构化数据分析,并从中提炼商业洞察,最终生成一份专业报告。

5.1.1 场景描述与任务目标

- 场景描述:一家名为“智选生活”的线上零售商,主营家居百货。过去一个季度(例如,2023年Q3),公司推出了多项促销活动,并引进了一些新产品。公司高层希望了解该季度销售业绩,识别出表现最佳和最差的产品类别,并分析促销活动对销售额的影响,最终需要一份简明扼要的报告,为下一季度的市场策略提供依据。

- 任务目标:利用CoT引导LLM完成模拟数据分析和报告撰写,包括关键指标计算、趋势分析和商业建议。

5.1.2 模拟数据

以下是假设的季度销售数据(简化为重点字段),我们将输入给LLM进行分析。在实际操作中,这些数据可以是CSV文件内容、数据库查询结果或API响应。为了复现,你可以手动将这些数据复制到提示中。

**2023年Q3销售数据样本 (总计约1000条记录,这里为简化展示的子集):**

| 交易ID | 日期 | 产品类别 | 产品名称 | 销售额 ($) | 成本 ($) | 促销活动 |

| :----- | :--------- | :----------- | :----------- | :--------- | :------- | :------- |

| 1001 | 2023-07-01 | 厨房用品 | 智能电饭煲 | 150 | 100 | 夏日大促 |

| 1002 | 2023-07-01 | 家居装饰 | 北欧风地毯 | 80 | 50 | 无 |

| 1003 | 2023-07-02 | 个人护理 | 负离子吹风机 | 120 | 80 | 无 |

| 1004 | 2023-07-02 | 厨房用品 | 多功能榨汁机 | 90 | 60 | 夏日大促 |

| 1005 | 2023-07-03 | 家居装饰 | 创意壁画 | 40 | 25 | 会员日 |

| 1006 | 2023-07-03 | 个人护理 | 精油套装 | 60 | 35 | 会员日 |

| 1007 | 2023-07-04 | 厨房用品 | 咖啡机 | 200 | 130 | 无 |

| 1008 | 2023-07-05 | 家居装饰 | 香薰蜡烛 | 30 | 15 | 夏日大促 |

| 1009 | 2023-07-06 | 个人护理

更多推荐

已为社区贡献18条内容

已为社区贡献18条内容

所有评论(0)