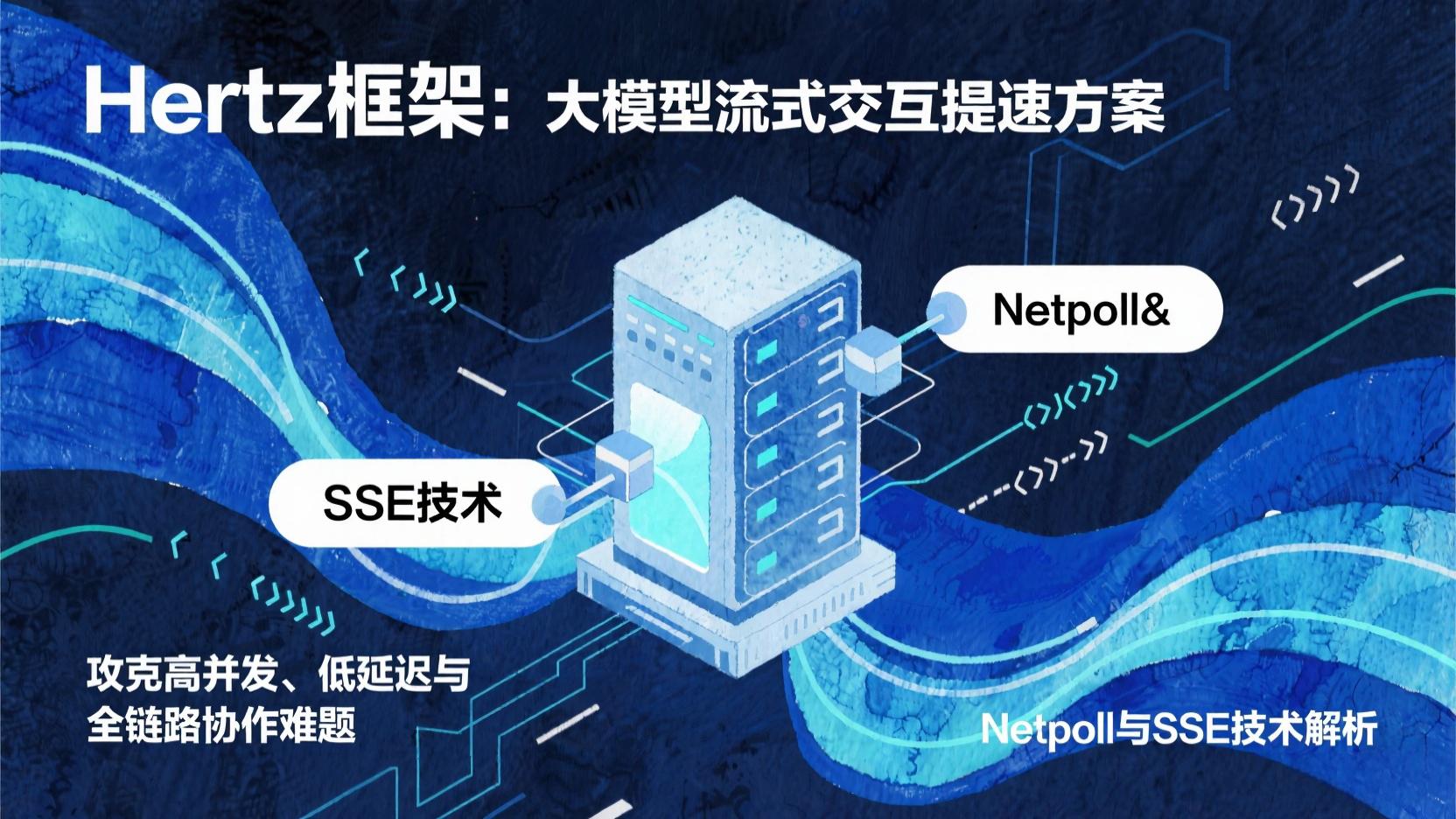

大模型时代流式交互提速:Hertz框架如何攻克高并发、低延迟与全链路协作难题?

本文探讨了AI大模型应用中流式传输技术的优化方案。Hertz框架通过三大核心策略解决流式交互的"卡慢断"问题:1)Netpoll网络层采用NIO模式提升5-10倍并发处理能力,实现毫秒级响应;2)SSE协议简化实现打字机效果,首包延迟<200ms;3)与Kitex协同构建全链路流式传输,集成背压控制保障高并发稳定性。文章提供具体配置参数和10行代码实现案例,为开发者提供可

在AI大模型应用爆发的今天,从智能客服的实时对话到AI代码助手的逐行生成,用户对"即时响应"的需求已成为标配。想象一下,当你向AI提问时,等待3秒后一次性收到大段回复,和看着文字像"打字机"一样逐字涌现,哪种体验更自然?后者背后,正是"流式传输"技术在支撑——它要求HTTP框架能高效处理每秒数十次的细粒度数据推送,同时兼顾高并发、低延迟和全链路稳定性。

作为字节跳动开源的高性能HTTP框架,Hertz在支撑抖音搜索、内部Prompt平台等亿级流量场景中,沉淀了一套成熟的流式传输优化方案。本文将从开发者视角,拆解Hertz如何通过网络层深度优化、协议简化与微服务协同,解决大模型流式交互中的"卡、慢、断"问题,为中小团队提供可直接复用的技术实践指南。

一、网络层优化:Netpoll如何让流式传输"快如闪电"?

1. 大模型流式场景的"性能杀手"

传统HTTP框架在处理流式数据时,常陷入两个困境:

- 小包高频场景(如AI每次返回10-20字):传统阻塞IO模型("一人一线程")会因频繁线程切换导致CPU占用飙升,延迟波动可达数百毫秒;

- 大包低频场景(如单次返回长文本段落):缓冲区设计不合理可能导致数据粘包或内存溢出,尤其在高并发下极易引发服务雪崩。

Hertz的Netpoll网络库通过NIO(非阻塞IO)模式,从底层解决了这些问题。

2. 通俗理解Netpoll的"性能密码"

如果把服务器比作餐厅:

- 传统阻塞IO像"每桌配一个专属服务员",来1000个客人就要1000个服务员(线程),客人少时空闲浪费,客人多了忙不过来;

- Netpoll的NIO模式则像"一个服务员盯100张桌",通过"事件驱动"机制(客人举手时才响应),单线程即可处理 thousands 级并发连接,资源利用率提升5-10倍。

核心优势:

- 零拷贝传输:数据从内核缓冲区直接传递到用户空间,减少内存复制开销;

- 动态缓冲区:根据包大小自动调整缓冲区容量,避免小包频繁分配内存、大包溢出风险。

3. 实战选型:Netpoll vs 标准库,怎么选?

|

场景 |

Netpoll优势 |

标准库(如Go net/http)适用场景 |

|

高并发小包(QPS 10000+) |

P99延迟降低30%-50%,CPU占用减少40%+ |

低并发(QPS<1000)、对兼容性要求高的场景 |

|

长连接流式传输 |

连接复用率提升80%,断连重连速度快 |

短连接(如普通API调用) |

选型口诀:"高并发小包选Netpoll,低并发兼容用标准库"。

4. 避坑指南:Netpoll配置3个关键参数

// Hertz服务配置示例

server.New(

server.WithHostPorts(":8888"),

server.WithTransport(netpoll.NewTransporter(

netpoll.WithReadBufferSize(4096), // 读缓冲区:小包场景设4KB,大包设16KB+

netpoll.WithWriteBufferSize(8192), // 写缓冲区:流式推送建议8KB-32KB

netpoll.WithIdleTimeout(30*time.Second), // 空闲超时:长连接设30-60秒,避免资源泄露

)),

)

调优经验:读缓冲区过大会浪费内存,过小易触发"读事件风暴"(频繁唤醒线程);写缓冲区需略大于单次推送最大包大小,避免分包传输。

二、协议简化:SSE让大模型"边算边推",10行代码搞定!

1. 为什么SSE是流式文本推送的"最优解"?

大模型流式场景中,服务器需要单向、持续地向客户端推送数据(如AI思考过程),常见方案有3种:

- WebSocket:双向通信能力冗余,握手流程复杂,适合聊天软件但"杀鸡用牛刀";

- HTTP长轮询:客户端不断发请求"问服务器有没有新数据",浪费带宽且延迟高;

- SSE(Server-Sent Events):专为"服务器单向推送"设计,协议轻量(基于HTTP)、连接复用率高,首包延迟可低至200ms内。

Hertz对SSE协议做了深度封装,让开发者无需关注底层细节,专注业务逻辑。

2. Hertz+SSE:5行代码实现"打字机效果"

func StreamHandler(ctx context.Context, c *app.RequestContext) {

// 1. 初始化SSE连接

sse := c.Response.SSE()

defer sse.Close()

// 2. 模拟大模型生成过程:逐段推送文本

for _, text := range []string{"你好,", "我是AI助手,", "正在为你解答问题..."} {

// 3. 推送数据(自动处理Content-Type、分帧格式)

if err := sse.Send(&protocol.SSEMessage{Data: text}); err != nil {

log.Printf("推送失败:%v", err)

return

}

time.Sleep(500 * time.Millisecond) // 模拟生成延迟

}

}

核心简化点:

- 自动设置Content-Type: text/event-stream和Connection: keep-alive头;

- 内置重连机制:客户端断开后自动重试,无需开发者手动处理。

3. 字节跳动实战案例:Prompt平台的"低延迟秘诀"

在字节跳动内部Prompt平台(支持大模型提示词实时生成)中,Hertz+SSE方案实现了:

- 首包延迟<200ms:用户输入后0.2秒内即可看到第一个字符;

- 稳定性99.99%:通过"背压控制"(当客户端消费慢时,服务器暂停生成,避免缓冲区溢出),在QPS 5000+场景下零丢包。

三、全链路协作:从网关到LLM服务,流式数据如何"不堵车"?

大模型流式请求往往需要经过"用户端→Hertz网关→Kitex RPC服务→LLM模型服务"多层传递,任何一环阻塞都会导致前端"卡顿"。Hertz与Kitex的协同设计,确保了全链路数据"流式畅通"。

1. 数据流转全流程解析

由于之前的mermaid代码过长,可能导致解析错误,这里简化为文字描述:

用户提问→Hertz网关接收→转发至Kitex RPC服务→调用LLM模型生成文本片段→Kitex透传片段至Hertz→Hertz通过SSE推送给用户

2. 关键协作点:如何避免"链路阻塞"?

- 背压控制:当用户端网络慢(如移动端弱网),Hertz会自动缓存未推送数据,当缓冲区达到阈值(如80%)时,通过Kitex通知LLM服务"暂停生成",避免服务端OOM;

- 无损透传:Kitex的Thrift Streaming协议支持数据分片标记,确保Hertz与LLM服务间的文本片段不丢失、不错序;

- 监控埋点:Hertz内置流式监控指标(如stream_requests_total、stream_avg_duration),可直接对接Prometheus,实时观测每段数据的传输延迟。

3. 工程化实践:3步搭建全链路流式服务

- 网关层(Hertz):配置Netpoll传输层,启用SSE模块;

- RPC层(Kitex):定义Thrift Streaming接口,设置超时重试策略;

- 监控层:接入Hertz的hertz-pprof插件,观测Netpoll连接数、SSE推送频率等关键指标。

四、总结与展望

在大模型应用从"Demo"走向"生产"的过程中,流式传输的稳定性与性能直接决定用户体验。Hertz通过Netpoll网络层优化解决了"快"的问题,SSE协议简化降低了"用"的门槛,与Kitex全链路协作保障了"稳"的底线。

对于开发者而言,无需重复造轮子——直接复用Hertz的成熟方案,即可让你的大模型应用轻松实现"打字机效果",在AI时代的用户体验竞争中抢占先机。

行动建议:

- 中小团队:从SSE协议入手,用10行代码快速验证流式交互效果;

- 高并发场景:优先启用Netpoll传输层,重点优化小包处理性能;

- 微服务架构:结合Kitex构建"网关→RPC→LLM"全链路流式能力,关注背压控制与监控埋点。

未来,随着AI工程化的深入,Hertz还将推出Streaming v2接口、流式链路追踪等功能,让流式开发更简单、更可靠。现在就上手试试吧!

(注:文中Hertz配置代码基于v0.7.0版本,最新特性可参考CloudWeGo官方文档)

更多推荐

已为社区贡献9条内容

已为社区贡献9条内容

所有评论(0)