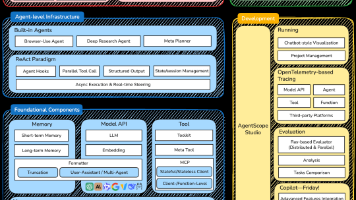

大模型时代智能生产调度AI系统架构:架构师探索LLM与调度算法结合新范式

生产调度:在给定的资源(机器、人员、物料)约束下,为任务(工单、工序)分配时间与资源,实现"成本最低、效率最高、交期最准"的目标。传统调度算法:基于数学模型的精确优化方法,如遗传算法(GA)、蚁群算法(ACO)、禁忌搜索(TS)等,擅长处理结构化、确定性问题。大语言模型(LLM):基于Transformer架构的预训练语言模型(如GPT-4、Claude 3、Llama 3),具备自然语言理解、上

大模型时代智能生产调度AI系统架构:架构师探索LLM与调度算法结合新范式

1. 引入:当老调度员遇到新问题——生产调度的"不确定性危机"

凌晨3点,某汽车零部件工厂的调度室依然亮着灯。资深调度员老张盯着屏幕上的红色警报,额角渗出细汗:

- 半小时前,关键机床M1突然报故障,需要停机维修4小时;

- 10分钟前,大客户紧急追加1000件订单,要求明天上午10点前交货;

- 现在,系统提示"工人小李因突发感冒请假",而他负责的工序没有替补人员。

老张揉了揉眼睛——这已经是这个月第5次应对此类"黑天鹅"事件。传统的ERP系统还停留在"按计划排产"的逻辑,面对这些动态约束、模糊需求、跨环节依赖的问题,根本无力应对。他打开Excel,开始手动调整工单:先把M1的任务转移到M3,再把小李的工序分给小王,还要计算追加订单的物料是否足够…整个过程像在解一道不断变化的魔方,稍有不慎就会导致交期延误或资源浪费。

这不是老张一个人的困境。根据《2023年制造业生产调度痛点调研报告》,78%的制造企业仍依赖"人工+传统系统"的调度模式,面对以下挑战几乎无解:

- 非结构化信息处理难:工人的语音报告、客户的自然语言需求、设备的异常日志等无法被传统系统解析;

- 动态环境适应性差:机器故障、订单变更、人员缺勤等突发情况需要重新建模,耗时久;

- 复杂约束协同难:多工厂、多车间、多资源的协同调度需要整合跨部门知识,传统算法难以处理;

- 决策解释性不足:调度结果对工人和管理者来说是"黑箱",无法快速理解和执行。

直到大语言模型(LLM)的出现,这道"生产调度的世纪难题"终于有了新的解题思路——用LLM的"智能大脑"弥补传统调度算法的"机械短板",构建"精确优化+灵活推理"的双引擎智能调度系统。

2. 概念地图:拆解智能生产调度系统的"认知框架"

在深入架构设计前,我们需要先明确核心概念的边界与关联,用一张"知识图谱"建立整体认知:

2.1 核心概念定义

- 生产调度:在给定的资源(机器、人员、物料)约束下,为任务(工单、工序)分配时间与资源,实现"成本最低、效率最高、交期最准"的目标。

- 传统调度算法:基于数学模型的精确优化方法,如遗传算法(GA)、蚁群算法(ACO)、禁忌搜索(TS)等,擅长处理结构化、确定性问题。

- 大语言模型(LLM):基于Transformer架构的预训练语言模型(如GPT-4、Claude 3、Llama 3),具备自然语言理解、上下文推理、知识融合、生成解释四大核心能力,擅长处理非结构化、不确定性问题。

- 智能生产调度系统:以"数据+算法+知识"为核心,整合传统调度算法的"精确优化"与LLM的"灵活推理",应对动态复杂生产环境的智能决策系统。

2.2 系统认知图谱

┌───────────────────┐

│ 应用层:调度工作台 │ → 可视化界面、预警系统、报告生成

└───────────────────┘

▲

│

┌───────────────────┐

│ 决策层:动态&协同调度│ → 实时事件处理、多工厂协同、决策解释

└───────────────────┘

▲

│

┌───────────────────┐

│ 模型层:双引擎融合 │ → 传统调度算法库 + LLM服务 + 融合引擎

└───────────────────┘

▲

│

┌───────────────────┐

│ 数据层:全要素整合 │ → 结构化数据(ERP/MES)+ 非结构化数据(语音/文本/图像)+ 知识库

└───────────────────┘

这张图谱的核心逻辑是:数据是基础,模型是引擎,决策是目标,应用是落地。而LLM的价值,正是在"数据-模型-决策"的每一层中,填补传统系统的"能力缺口"。

3. 基础理解:LLM与传统调度算法的"能力互补论"

要理解两者的结合逻辑,我们需要先回答一个问题:传统调度算法的"短板"是什么?LLM的"长板"又在哪里?

3.1 传统调度算法的"三个局限"

传统调度算法本质是"数学优化工具",其性能依赖于精确的模型假设和结构化的输入数据。但现实生产环境中,这两个条件往往不成立:

- 局限1:无法处理非结构化数据:客户的"紧急订单"需求是语音,工人的故障报告是文本,设备的异常状态是图像——这些信息无法直接转化为算法的"约束条件"。

- 局限2:动态适应性差:当生产环境变化(如机器故障),算法需要重新调整模型参数甚至重构目标函数,耗时几分钟到几小时,无法应对"秒级响应"的需求。

- 局限3:决策解释性不足:算法输出的调度计划是"工单-机器-时间"的表格,工人和管理者无法理解"为什么这样排",导致执行阻力大。

3.2 LLM的"四个核心能力"

LLM是"知识密集型推理机器",其能力恰好覆盖传统算法的局限:

- 能力1:非结构化信息解析:能将语音、文本、图像等转化为结构化约束(比如把"客户要求明天上午10点前交货"解析为"订单A的截止时间=2024-05-20 10:00")。

- 能力2:上下文动态推理:能记住"之前的调度决策"和"当前的突发情况",比如"上午M1故障,已将订单B转移到M3",当下午追加订单时,自动避免M3的冲突。

- 能力3:知识融合:能整合行业经验(如"汽车零部件生产中,热处理工序不能中断")、历史案例(如"去年类似故障时的调度方案")和实时数据(如"当前物料库存"),做出更符合实际的决策。

- 能力4:自然语言解释:能将调度结果转化为人类能理解的语言(比如"订单A安排在M2的9:00-11:00,因为M2空闲且能满足交期,同时不影响订单B的热处理工序")。

3.3 用"老工匠+精密仪器"类比两者的结合

如果把传统调度算法比作"精密的瑞士手表"——准确、可靠,但难以调整;那么LLM就是"经验丰富的老工匠"——灵活、有经验,能处理突发情况。两者结合的效果,就像"老工匠用瑞士手表校准时间,再根据经验调整行程":

- 瑞士手表(传统算法)保证"时间的精确性";

- 老工匠(LLM)保证"行程的灵活性"。

4. 层层深入:LLM与调度算法结合的"四层级架构设计"

基于"能力互补"的逻辑,我们可以将智能生产调度系统拆解为数据层、模型层、决策层、应用层四个层级,每个层级都有LLM与传统算法的融合点。

4.1 第一层:数据层——全要素整合,解决"信息孤岛"问题

数据是调度系统的"燃料",但传统系统的数据往往分散在ERP(企业资源计划)、MES(制造执行系统)、IoT传感器、工人终端等多个系统中,且以**结构化数据(如工单数量、机器状态)+非结构化数据(如语音报告、故障文本)**混合存在。

LLM在数据层的核心作用是**“非结构化数据结构化”**,具体实现步骤:

- 数据采集:通过API对接ERP/MES系统获取结构化数据,通过语音识别(ASR)、OCR获取非结构化数据(如工人的语音报告、设备的故障日志)。

- 数据预处理:

- 结构化数据:用Python的Pandas库清洗(如缺失值填充、异常值过滤);

- 非结构化数据:用LLM做命名实体识别(NER)和信息抽取(比如从"机器M1的传送带凌晨2点坏了"中抽取"设备=M1,故障类型=传送带损坏,时间=2024-05-20 02:00")。

- 知识库构建:将行业规则(如"热处理工序温度需保持在150℃以上")、历史调度案例(如"2023年10月M1故障时的调度方案")、客户需求(如"紧急订单优先级高于常规订单")存入向量数据库(如Pinecone),供LLM后续检索。

案例:某电子厂用LLM处理工人的语音报告——工人说"机器3的芯片贴装头卡住了,需要1小时维修",LLM自动抽取"设备=机器3,故障类型=贴装头卡住,维修时间=1小时",并将这些信息同步到MES系统,为后续调度提供数据支持。

4.2 第二层:模型层——双引擎融合,解决"精确与灵活"的矛盾

模型层是系统的"心脏",核心问题是如何让传统调度算法的"精确优化"与LLM的"灵活推理"协同工作。根据融合方式的不同,可分为三种模式:

模式1:LLM作为"前置处理器"——解析需求,转化约束

传统调度算法需要结构化的约束条件(如"订单A的截止时间=2024-05-20 10:00"),但现实中的需求往往是自然语言(如客户说"这个订单很急,明天上午必须交货")。LLM的作用是将自然语言需求转化为算法能理解的约束。

实现流程:

- 客户/工人输入自然语言需求(如"紧急追加1000件订单,明天上午10点前交货");

- LLM调用Few-Shot Learning(少样本学习)解析需求:

- 抽取关键信息:订单类型=追加,数量=1000,截止时间=2024-05-20 10:00;

- 转化为约束条件:

order_priority["追加订单"] = 最高,deadline["追加订单"] = 2024-05-20 10:00;

- 将约束条件传入传统调度算法(如遗传算法),算法根据约束优化调度计划。

技术细节:用OpenAI的GPT-4 API实现需求解析,Prompt设计如下:

你是生产调度系统的需求解析助手,请将用户的自然语言需求转化为结构化约束条件。要求:

1. 抽取关键信息(订单类型、数量、截止时间、优先级等);

2. 用键值对格式输出。

示例:

用户输入:"客户要加100件产品,后天下午5点前要"

输出:{"订单类型": "追加", "数量": 100, "截止时间": "2024-05-22 17:00", "优先级": "高"}

用户输入:"紧急订单A必须明天上午10点前交货"

模式2:LLM作为"后置优化器"——解释结果,优化决策

传统调度算法能输出精确的调度计划,但无法解释"为什么这样排",导致工人和管理者难以执行。LLM的作用是将算法结果转化为自然语言解释,并根据反馈优化计划。

实现流程:

- 传统算法输出调度计划(如"订单A安排在M2的9:00-11:00,订单B安排在M3的13:00-15:00");

- LLM调用知识图谱检索(从向量数据库中获取行业规则和历史案例),生成解释:

- “订单A安排在M2的9:00-11:00,因为M2当前空闲,且能满足明天上午10点的交期;订单B安排在M3的13:00-15:00,因为M3的热处理工序需要连续运行,避免中断。”;

- 调度员/工人反馈意见(如"M2的工人今天请假,能不能调整?");

- LLM将反馈转化为新的约束条件(如

machine_availability["M2"] = 不可用),重新传入算法优化计划。

技术细节:用Llama 3开源模型实现结果解释,结合向量数据库的**检索增强生成(RAG)**技术——当需要解释"为什么选M2"时,LLM从向量数据库中检索"M2的当前状态"和"订单A的交期要求",再生成解释。

模式3:LLM作为"嵌入式优化器"——优化算法参数,提升效率

传统调度算法的性能依赖于参数设置(如遗传算法的种群大小、交叉概率),但参数调整需要经验,且无法动态适应环境变化。LLM的作用是根据实时数据动态调整算法参数,提升优化效率。

实现流程:

- 传统算法(如遗传算法)初始化参数(种群大小=100,交叉概率=0.8);

- LLM根据实时数据(如"当前有10个订单待处理,机器利用率70%")调整参数:

- “当订单数量较多时,增大种群大小(如150)以探索更多解;当机器利用率较高时,降低交叉概率(如0.6)以保持现有解的稳定性”;

- 算法用新参数重新优化,输出更优的调度计划。

技术细节:用强化学习(RL)结合LLM实现参数调整——将算法的"优化效果"(如准时交货率)作为奖励,LLM通过试错学习"如何调整参数才能获得更高奖励"。

4.3 第三层:决策层——动态协同,解决"复杂场景"问题

生产调度的核心需求是应对动态变化(如机器故障、订单变更)和协同复杂系统(如多工厂、多车间)。LLM在决策层的核心作用是**“上下文记忆"和"跨域协同”**。

场景1:动态调度——处理突发情况

当生产环境发生变化(如机器故障),传统系统需要重新建模,耗时久;而LLM能记住之前的调度决策,快速调整计划。

案例:某汽车厂的M1机床突然故障,需要维修4小时。LLM的处理流程:

- 接收故障信息(从数据层获取);

- 检索历史案例(向量数据库中"2023年M1故障时的调度方案");

- 结合当前状态(如"M3当前空闲,能处理M1的工序");

- 生成调整方案:“将M1的订单C转移到M3,时间调整为10:00-14:00,同时通知采购部门补充M3的物料”;

- 将方案传入传统算法验证(如遗传算法验证"转移后是否满足交期");

- 输出最终调度计划,并生成解释。

场景2:多工厂协同——整合跨域资源

当企业有多个工厂(如上海工厂、苏州工厂),需要协同调度时,传统系统难以整合跨工厂的资源和约束;而LLM能理解跨域需求,协调多工厂的资源。

案例:某家电企业的上海工厂接到紧急订单,但物料库存不足,而苏州工厂有剩余物料。LLM的处理流程:

- 解析需求:“上海工厂需要1000个电机,明天上午10点前交货”;

- 检索资源:“苏州工厂有2000个电机库存,运输时间2小时”;

- 协调约束:“苏州工厂的电机需要在今天18:00前发出,才能保证明天上午8点到达上海”;

- 生成协同方案:“苏州工厂今天18:00发出1000个电机,上海工厂明天8:00接收,安排在M5的9:00-11:00生产”;

- 将方案传入多工厂调度算法(如分布式遗传算法)验证;

- 输出最终计划,并通知上海和苏州工厂的调度员。

4.4 第四层:应用层——可视化与交互,解决"落地最后一公里"问题

应用层是系统与用户(调度员、工人、管理者)的交互界面,核心目标是降低使用门槛,提升执行效率。LLM在应用层的作用是**“自然语言交互"和"可视化解释”**。

组件1:调度工作台——可视化与交互

调度工作台是调度员的"操作面板",具备以下功能:

- 实时监控:显示机器状态、订单进度、工人排班等信息(用Dashboard可视化);

- 自然语言交互:调度员可以用语音或文本输入需求(如"把订单A的优先级调高"),LLM解析后自动调整计划;

- 预警系统:LLM根据实时数据预测可能的延误(如"订单B的物料将在1小时后耗尽,可能导致交期延误"),并给出解决方案(如"从仓库调运物料")。

组件2:工人终端——简单易懂的指令

工人终端是工人的"执行指南",LLM将调度计划转化为口语化的指令(如"小王,你今天的任务是在M3上生产订单C,时间9:00-11:00,注意检查物料是否齐全"),避免工人理解复杂的表格。

组件3:管理者报告——数据驱动的决策支持

管理者需要的是宏观的生产情况,LLM将调度数据转化为自然语言报告(如"本周准时交货率95%,比上周提升3%;机器利用率80%,比上周提升5%;主要问题是M1的故障导致2个订单延误,建议增加M1的备用零件库存"),帮助管理者快速做出决策。

5. 多维透视:LLM与调度算法结合的"过去、现在、未来"

5.1 历史视角:生产调度的"三次进化"

生产调度的发展历程,本质是"从人工到智能"的进化:

- 第一次进化(1960s-1980s):手动调度→自动化调度(MRP/ERP系统)——用计算机替代人工计算,但无法处理复杂约束;

- 第二次进化(1990s-2010s):自动化调度→智能调度(AI算法)——用遗传算法、蚁群算法等优化调度,提升精确性,但无法处理非结构化和动态问题;

- 第三次进化(2020s至今):智能调度→LLM增强的智能调度——用LLM弥补传统算法的短板,应对动态复杂环境。

5.2 实践视角:企业的"落地案例"

案例1:某汽车零部件厂——LLM+遗传算法提升准时交货率

- 痛点:传统遗传算法无法处理客户的自然语言需求(如"紧急订单"),准时交货率仅85%;

- 解决方案:用LLM解析自然语言需求,转化为遗传算法的约束条件,同时用LLM解释调度结果;

- 效果:准时交货率提升至95%,调度周期从2小时缩短至30分钟。

案例2:某电子厂——LLM+多工厂调度算法降低成本

- 痛点:多工厂协同调度需要人工协调,成本高(每月协调成本约10万元);

- 解决方案:用LLM整合多工厂的资源和需求,传入多工厂调度算法优化;

- 效果:协调成本降低至2万元/月,资源利用率提升15%。

5.3 批判视角:LLM的"局限性"与"解决思路"

LLM不是"万能药",其局限性需要用技术手段弥补:

- 局限性1:幻觉问题:LLM可能生成错误的调度建议(如"把订单A安排在M2,但M2实际已损坏");

- 解决思路:用传统算法验证LLM的结果(如遗传算法检查"M2是否可用"),或加入人工审核环节。

- 局限性2:上下文窗口限制:LLM的上下文窗口有限(如GPT-4的上下文窗口是8k tokens),无法处理长周期的调度(如一个月的计划);

- 解决思路:用**检索增强生成(RAG)**技术,将长周期的信息存入向量数据库,LLM需要时检索,不用记住所有内容。

- 局限性3:计算成本高:调用LLM API的成本较高(如GPT-4的成本是0.03美元/1k tokens);

- 解决思路:用开源LLM(如Llama 3)部署在本地,降低成本;或对高频需求进行微调(Fine-Tuning),提升推理效率。

5.4 未来视角:LLM与调度算法结合的"三大趋势"

- 趋势1:多模态LLM:结合机器视觉(监控设备状态)、语音识别(工人报告)、传感器数据(设备温度、振动),实现"视、听、感"多模态融合的调度;

- 趋势2:实时边缘计算:将LLM部署在边缘端(如车间的边缘服务器),降低延迟(从秒级到毫秒级),应对"实时调度"需求;

- 趋势3:自主学习调度系统:结合强化学习(RL),让系统从"经验"中学习——比如"上次M1故障时的调度方案效果好",下次遇到类似情况自动复用。

6. 实践转化:搭建LLM增强的智能生产调度系统的"五步指南"

6.1 步骤1:需求分析——明确场景与目标

首先要明确企业的核心痛点和目标:

- 是动态调度问题(如机器故障、订单变更)?

- 还是多工厂协同问题?

- 目标是提升准时交货率?还是降低成本?还是提升资源利用率?

比如,某电子厂的核心痛点是"无法处理客户的紧急订单",目标是"将紧急订单的准时交货率从80%提升至95%"。

6.2 步骤2:数据准备——整合全要素数据

- 结构化数据:对接ERP(订单数据)、MES(生产数据)、IoT(设备数据)系统,收集工单数量、机器状态、工人排班等数据;

- 非结构化数据:部署语音识别(ASR)、OCR系统,收集工人的语音报告、设备的故障日志、客户的自然语言需求等数据;

- 知识库:整理行业规则(如"热处理工序不能中断")、历史调度案例(如"2023年M1故障时的方案")、客户需求(如"紧急订单优先级高"),存入向量数据库。

6.3 步骤3:模型选择——匹配场景与算法

- 传统调度算法:根据场景选择(如流水车间调度用遗传算法,作业车间调度用蚁群算法,多工厂调度用分布式遗传算法);

- LLM模型:根据成本和隐私需求选择(如预算充足且无隐私问题用GPT-4,有隐私需求用开源的Llama 3);

- 融合方式:根据需求选择(如处理自然语言需求用"前置处理器"模式,处理动态调度用"嵌入式优化器"模式)。

6.4 步骤4:系统开发——实现端到端流程

- 数据层:用Python的Pandas、Spark处理结构化数据,用LLM(如GPT-4)处理非结构化数据,用Pinecone构建向量数据库;

- 模型层:用DEAP库实现遗传算法,用OpenAI API或Llama 3实现LLM服务,用Flask构建融合引擎(对接算法和LLM);

- 决策层:用Redis实现实时数据缓存(处理动态事件),用Celery实现异步任务(处理多工厂协同);

- 应用层:用React构建调度工作台(可视化),用Flutter构建工人终端(跨平台),用FastAPI构建API接口(对接前端)。

6.5 步骤5:测试与迭代——用数字孪生验证

- 数字孪生模拟:用Unity或西门子的Tecnomatix构建车间的数字孪生模型,模拟机器故障、订单变更等场景,测试系统的性能;

- 指标评估:用准时交货率、调度周期、资源利用率、成本降低率等指标评估系统效果;

- 迭代优化:根据测试结果调整模型参数(如LLM的Prompt设计、遗传算法的种群大小),提升系统性能。

7. 整合提升:LLM与调度算法结合的"核心逻辑"与"未来展望"

7.1 核心逻辑回顾

- 不是替代,而是增强:LLM不会取代传统调度算法,而是弥补其"非结构化处理、动态适应、决策解释"的短板;

- 数据是基础:全要素数据整合是系统的"燃料",非结构化数据的结构化是关键;

- 融合是关键:根据场景选择合适的融合方式(前置、后置、嵌入式),实现"精确优化+灵活推理"的双引擎;

- 落地是目标:应用层的可视化与自然语言交互是系统能否被用户接受的"最后一公里"。

7.2 给架构师的思考问题

- 你所在企业的生产调度有哪些痛点?LLM能解决其中的哪些?

- 如何平衡LLM的"灵活性"与传统算法的"精确性"?

- 如何解决LLM的"幻觉问题"和"上下文窗口限制"?

- 如何评估LLM与调度算法结合的效果?

7.3 学习资源推荐

- 调度算法:《生产调度理论与方法》(陈国华等)、《智能优化算法及其应用》(王凌等);

- LLM技术:《Attention Is All You Need》(Transformer论文)、《GPT-4 Technical Report》(OpenAI);

- 开源项目:DEAP(遗传算法库)、LangChain(LLM应用框架)、Pinecone(向量数据库);

- 行业案例:《2024年制造业智能调度白皮书》(IDC)、《LLM在工业中的应用》(麦肯锡)。

结语:从"机械调度"到"智能调度"——大模型时代的生产变革

大模型时代的智能生产调度系统,不是技术的堆砌,而是以解决实际问题为核心的"能力融合"。它让传统调度算法的"精确性"与LLM的"智能性"结合,让生产调度从"机械的数学优化"变成"有温度的智能决策"——就像老张再也不用凌晨3点加班,因为系统会自动处理机器故障、追加订单和人员缺勤,还会用自然语言告诉他"为什么这样排"。

未来,随着多模态LLM、实时边缘计算、自主学习等技术的发展,智能生产调度系统将变得更"聪明"、更"灵活"、更"懂人"。而作为架构师,我们的任务不是追逐最新的技术,而是用技术解决企业的实际痛点,让智能调度真正落地,成为企业提升竞争力的"核心引擎"。

大模型时代,生产调度的未来已来——你,准备好了吗?

更多推荐

已为社区贡献39条内容

已为社区贡献39条内容

所有评论(0)