大模型王者Qwen3系列全解析:17个模型详解与应用指南

本文全面解析阿里大模型Qwen3系列17个模型的发展历程、性能对比与应用场景。从初始8个模型到最新Qwen3-Max-Preview,详细介绍了各模型特点及适用场景。同时提供了本地部署指南,包括Ollama安装和图形界面使用方法,帮助开发者根据显存条件选择合适模型进行开发应用。

本文全面解析阿里大模型Qwen3系列17个模型的发展历程、性能对比与应用场景。从初始8个模型到最新Qwen3-Max-Preview,详细介绍了各模型特点及适用场景。同时提供了本地部署指南,包括Ollama安装和图形界面使用方法,帮助开发者根据显存条件选择合适模型进行开发应用。

前排提示,文末有大模型AGI-CSDN独家资料包哦!

一次性讲清楚大模型王者 Qwen3 系列的 17 个模型

Qwen3 模型发展历程

第一阶段

2025年4月29日,阿里推出了 Qwen3 模型,包含8个模型,覆盖各种 GPU 要求。

-

- 两个 MoE 模型:

Qwen3-235B-A22B和Qwen3-30B-A3B

- 两个 MoE 模型:

-

- 六个 Dense 模型:

Qwen3-32B、Qwen3-14B、Qwen3-8B、Qwen3-4B、Qwen3-1.7B和Qwen3-0.6B

- 六个 Dense 模型:

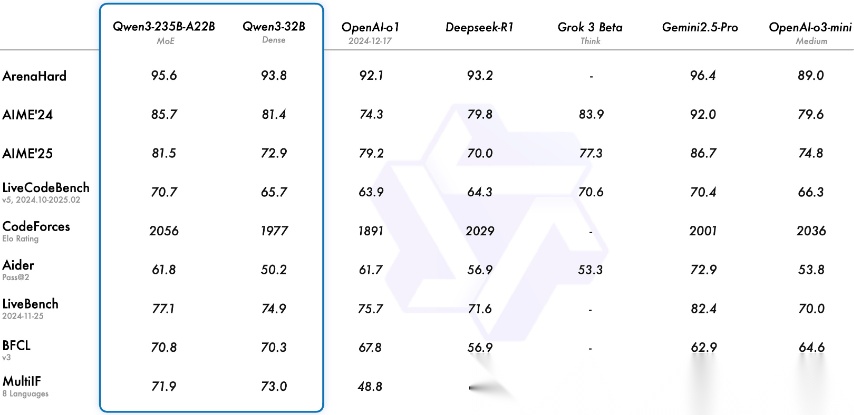

其中 Qwen3-235B-A22B 是最优模型,各项评分超过 DeepSeek-R1、Qwen32B 和 OpenAI-o1,与 Gemini-2.5-Pro 的比较中,各有优势,官方比较指标如下:

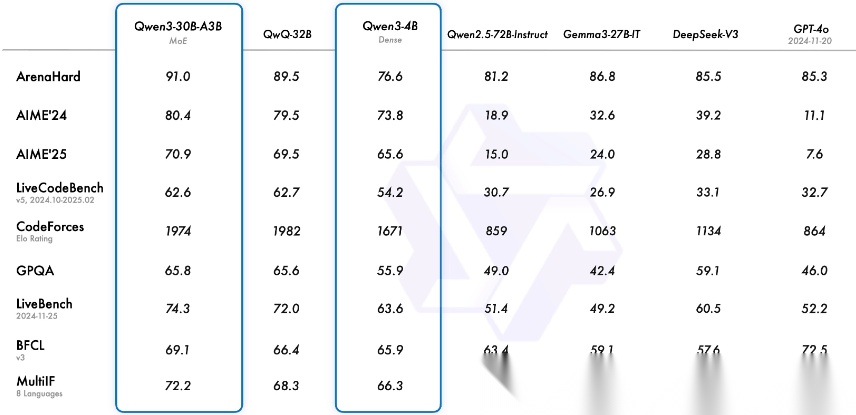

Qwen3-30B-A3B 相较于上一代的 Qwen32B,也更胜一筹。

综合官方的比较,发现 Qwen3 的8个模型的从优到劣分别是:Qwen3-235B-A22B > Qwen3-32B > Qwen3-30B-A3B > …,本地24G显存可以部署 Qwen3-32B 和 Qwen3-30B-A3B 的量化版。

第二阶段

2025年7月21日到8月8日,阿里推出了 Qwen3 的升级模型,核心包含6个模型。

-

Qwen3-235B-A22B-Instruct-2507和Qwen3-235B-A22B-Thinking-2507,是针对上一代旗舰模型Qwen3-235B-A22B的升级,前者是非思考模式,后者是思考模式模型。是新的旗舰模型。

-

Qwen3-30B-A3B-Instruct-2507和Qwen3-30B-A3B-Thinking-2507,是针对Qwen3-30B-A3B的升级,前者是非思考模式,后者是思考模式模型。

-

Qwen3-4B-Instruct-2507和Qwen3-4B-Thinking-2507,是针对Qwen3-4B的升级,前者是非思考模式,后者是思考模式模型。

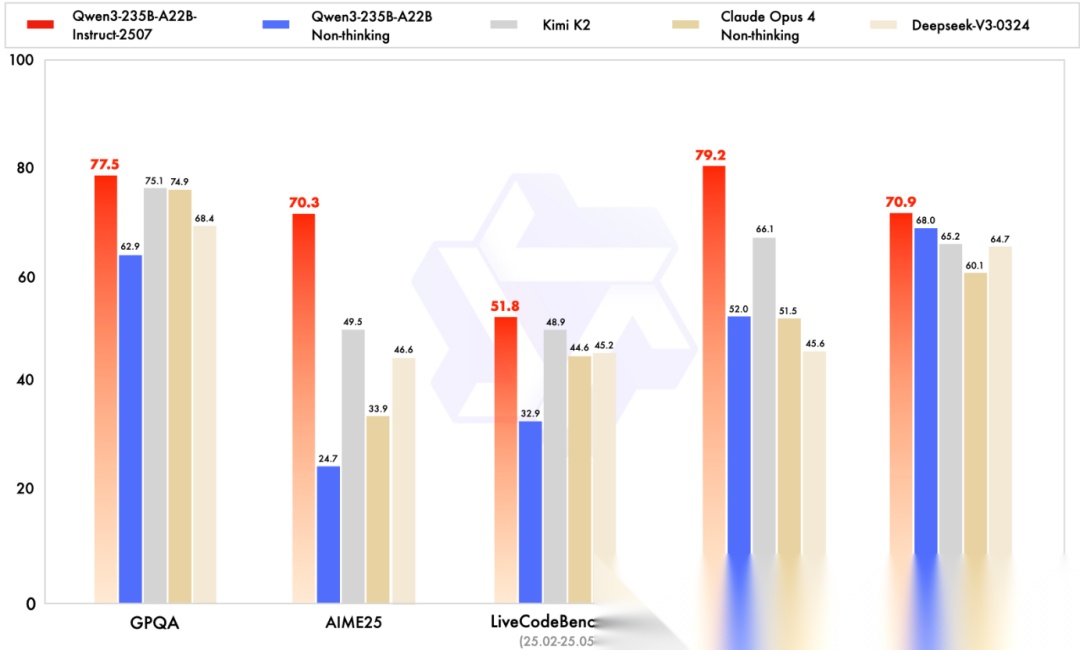

其中 Qwen3-235B-A22B-Instruct-2507 与其他开闭源模型的性能对比如下,可以说是遥遥领先。

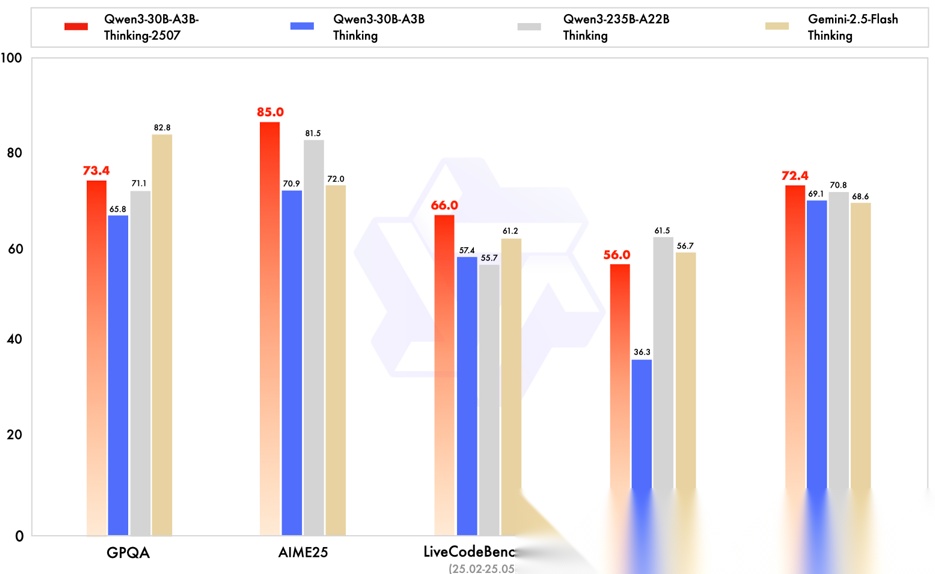

Qwen3-30B-A3B-Thinking-2507 的性能评测图如下,在大部分场景超过了上一代的 Qwen3-235B-A22B 模型的思考模式。

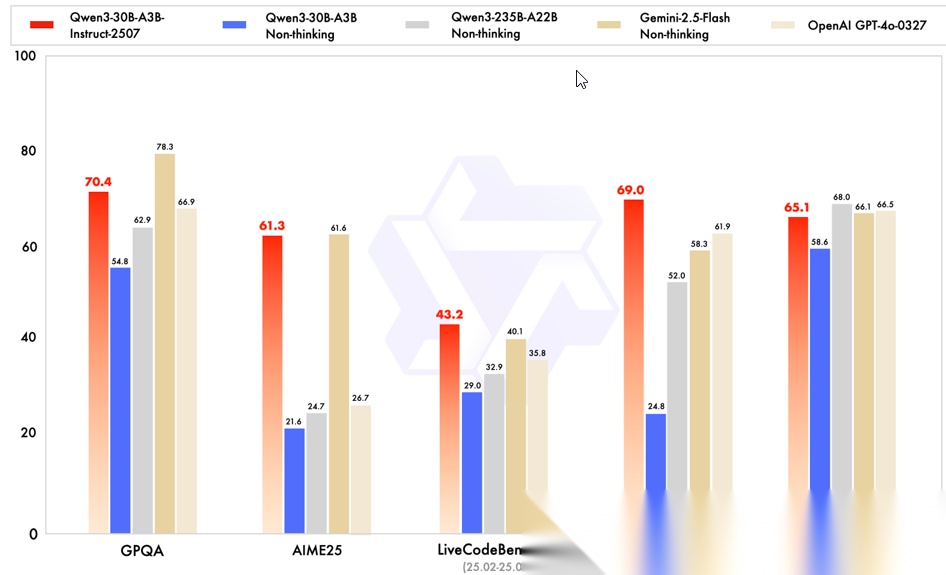

Qwen3-30B-A3B-Instruct-2507 的性能评测图如下,全面大幅度超过了上一代的 Qwen3-235B-A22B 模型非思考模式。

本地24G显存最高可以部署 Qwen3-30B-A3B-Instruct-2507 和 Qwen3-30B-A3B-Thinking-2507 的量化版本。

除了以上的通用模型之外,Qwen3 还提供了两个垂类编码模型 Qwen3-Coder-480B-A35B-Instruct 和 Qwen3-Coder-30B-A3B-Instruct

第三阶段

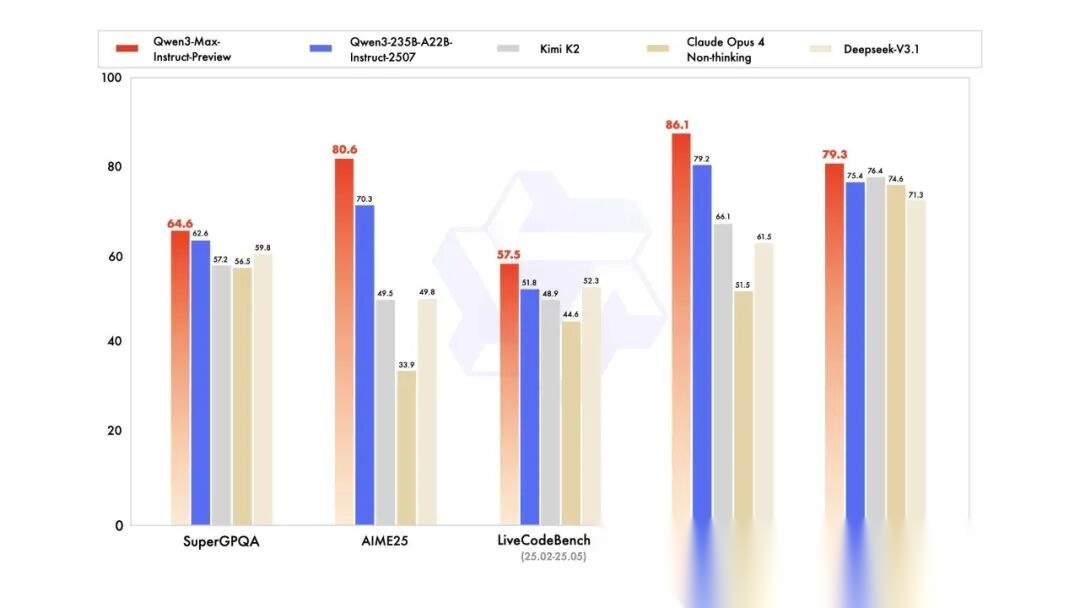

2025年9月5日,阿里推出了当前系列的最强模型 Qwen3-Max-Preview,估计很快就会推出 Qwen3-Max 正式版,该模型具有1万亿参数,是同系列 Qwen3-235B-A22B 参数的四倍。官方测评如下,超过了 Qwen3-235B-A22B-Instruct-2507/Kimi K2/Claude Opus4/Deepseek-V3.1

该模型当前可以在 https://chat.qwen.ai/ 免费使用。

综上所述,如果是远程使用模型,则可以选择 Qwen3-Max-Preview;如果是本地使用模型,24G 显存可以选择 Qwen3-30B-A3B-Instruct-2507 和 Qwen3-30B-A3B-Thinking-2507 的量化版本。

本地使用

通过 ollama 进行安装,确保先安装过 ollama,若无,先参考 https://www.aileading.cn/docs/llm/ollama.html 安装 ollama。

在 ollama 官网 https://ollama.com/library/qwen3 选择一个适合自己显存的模型进行下载。下载的过程中,如果发现突然变慢,可以 ctrl+c 终止下载流程,之后继续使用如下命令进行下载(会接着之前的进度)

复制命令,在 cmd 中执行,即可下载并运行模型

ollama run qwen3:30b-a3b-thinking-2507-q4_K_M

如果模型没有下载过,则会先下载模型,再运行。简单测试:

>>> 0.8和0.11谁大0.8 比 0.11 大。### 解释:- 0.8 可以写成 0.80(小数点后补零,便于比较)。- 比较小数部分:0.80 的十分位是 8,0.11 的十分位是 1。- 8 > 1,因此 0.80 > 0.11。- 用分数验证:0.8 = 80/100,0.11 = 11/100,80/100 > 11/100。所以,**0.8 > 0.11**。(简单来说:0.8 是 8 个十分之一,0.11 是 11 个百分之一,相当于 1.1 个十分之一,所以 0.8 更大。)

目前在终端中就可以使用 Qwen3 模型了,但是终端的界面不太友好,接下来通过 PageAssist 图形化界面进行使用,关于 PageAssist 的安装和使用见 https://www.aileading.cn/docs/llm/page-assist.html。也可以使用 OpenWebUI 图形界面使用,关于 OpenWebUI 的安装和使用见 https://www.aileading.cn/docs/llm/open-web-ui.html

读者福利:倘若大家对大模型感兴趣,那么这套大模型学习资料一定对你有用。

针对0基础小白:

如果你是零基础小白,快速入门大模型是可行的。

大模型学习流程较短,学习内容全面,需要理论与实践结合

学习计划和方向能根据资料进行归纳总结

包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。带你从零基础系统性的学好大模型!

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

👉AI大模型学习路线汇总👈

大模型学习路线图,整体分为7个大的阶段:(全套教程文末领取哈)

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉大模型实战案例👈

光学理论是没用的,要学会跟着一起做,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

👉大模型视频和PDF合集👈

这里我们能提供零基础学习书籍和视频。作为最快捷也是最有效的方式之一,跟着老师的思路,由浅入深,从理论到实操,其实大模型并不难。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

更多推荐

已为社区贡献26条内容

已为社区贡献26条内容

所有评论(0)