突破Transformer困局!中科院打造新一代类脑脉冲大模型,提升百倍训练效率!

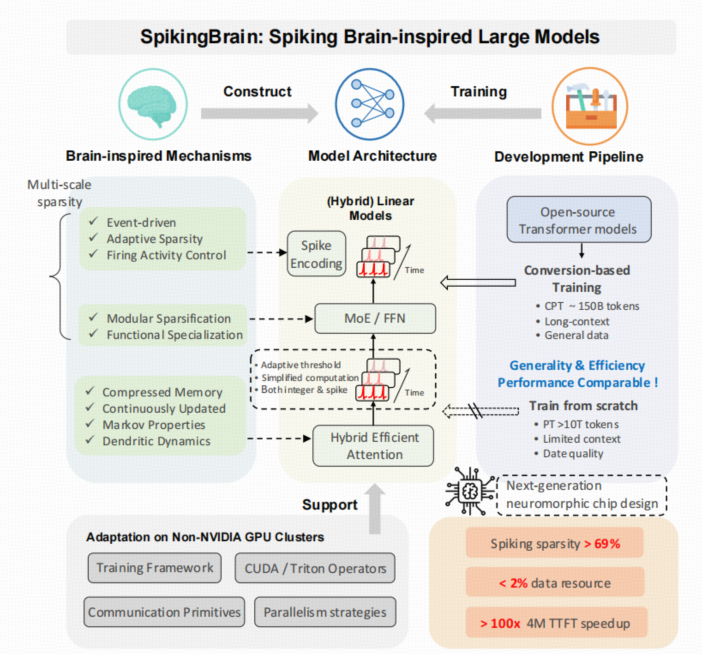

中科院自动化所与沐曦MetaX联合发布全球首款类脑脉冲大模型"瞬息1.0"(SpikingBrain),创新性地采用内生复杂性理论,在国产GPU平台上实现全流程训练和推理。该模型突破传统Transformer架构局限,通过混合线性架构、高效模型转换和自适应阈值脉冲三大创新,将计算能耗降低97.7%。在沐曦MetaX曦云C550集群上训练的参数模型性能与主流开源模型相当,长序列处

你是否想过,让AI像人脑一样按需思考,处理百万字小说时仅消耗传统模型2%的算力?

近日,中科院自动化所与沐曦MetaX联合发布的全球首款类脑脉冲大模型“瞬息1.0”(SpikingBrain),基于内生复杂性理论将这一设想变成现实。

瞬息大模型摆脱了对于Transformer架构的依赖,实现了在国产千卡GPU算力平台上完成全流程训练和推理!

传统的Transformer架构通过增加节点规模、算力和数据量来提升模型的智能水平,是一种以资源堆叠为核心、靠硬投入换性能突破的 “暴力美学”。

与不断增加的结构复杂性相对应的是,每一个神经元节点内部结构都十分简单,因此这种方法被成为基于外生复杂性的通用智能实现方法。这种模式依赖高性能的GPU,算力因此成为模型竞争的决定性资源。

而瞬息大模型基于内生复杂性路径,采用事件驱动计算模拟生物神经元对输入强度的自适应响应,将计算能耗降低了97.7%!

研究在沐曦MetaX的曦云C550组成的集群上共训练了SpikingBrain-7B和SpikingBrain-76B两个模型,证明了在非NVIDIA平台大规模LLM开发可行性。在150B tokens的持续预训练下,模型性能与开源Transformer基线相当,且长序列训练效率得到显著提升。

类脑脉冲的三重革新:模型如何架构

传统的基于Transformer的大语言模型面临训练计算量随着序列长度增加平方级增长、推理内存随着序列长度增加线性增长的低效困境。这带来的算力需求使得大规模模型很难在国产GPU上稳定运行。

对此,SpikingBrain从人脑的工作机制中寻找灵感,针对Transformer的效率困境在模型架构上进行混合线性架构、高效模型转换、自适应阈值脉冲三个层面的创新,有效降低了模型训练的算力需求。

混合线性架构

传统Transformer依赖Softmax函数进行全局注意,将每个token与所有历史token进行对比,直接带来了上述计算量的爆炸式增长和内存的大量占用。

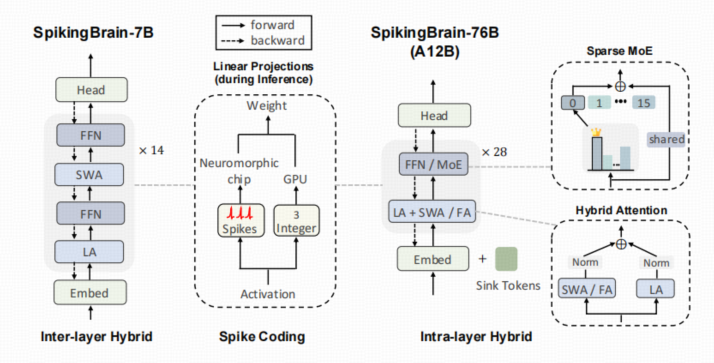

对此,SpikingBrain将全局注意力、局部注意力与线性注意力按需组合,用滑动窗口注意(Sliding Window Attention,SWA)捕捉局部细节、用线性注意力压缩长期信息,将历史信息汇总成一个固定大小的记忆包,减少重复计算,再搭配少量全局注意力保证全局关联。

在不同注意力机制的混合方法方面,主要有层间顺序混合和层内并行混合两种方式,前者将不同的注意力模块跨层堆叠,后者让不同模块并行处理相同的输入并合并输出,通过调整不同注意力类型的比例,可以在建模准确性与效率之间权衡。

具体而言,SpikingBrain-7B采用线性注意力和SWA的层间混合,而SpikingBrain-76B则采用了线性注意力、SWA和全局注意力的层内混合。

高效模型转换

传统模型训练的成本极高,而SpikingBrain能直接改造先有的开源模型,避免从头开始重新训练。

对于注意力模块,它通过统一的注意力图分析,重新映射Transformer模型的权重,将二次注意力模块转换为稀疏滑动窗口和低秩线性注意力,显著降低了训练和推理成本,只需要从头开始训练不到2%的计算量。

此外,对于SpikingBrain-76B,团队还采用了**混合专家(MoE)**技术进行升级,把原本密集的FFN权重复制成多个专家,进一步降低内存开销。

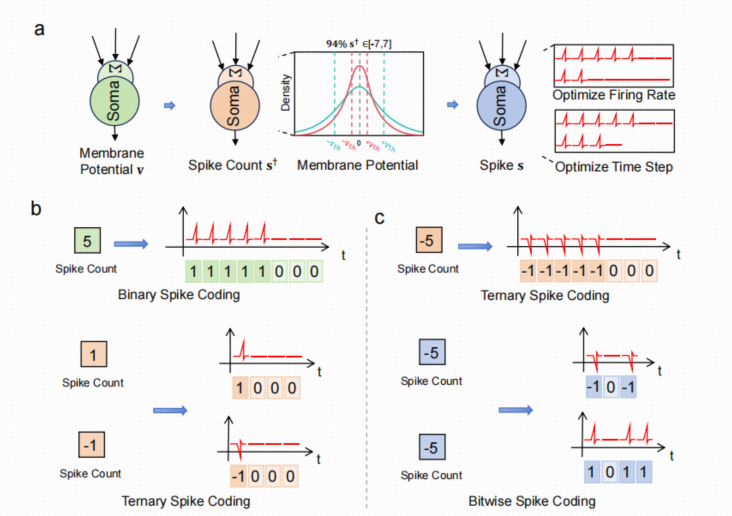

自适应阈值脉冲

传统模型的激活值通常是浮点数,每个值都要进行处理,功耗高。受到人脑神经元的启发,研究团队把SpikingBrain的激活值转换为了脉冲计数,如{0,1}、{-1,0,1}或者按位脉冲编码。这种稀疏、事件驱动的技术方式进一步降低了能耗。

工程应用中常用的LIF(Leaky Integrate-and-Fire)神经元能够在一定程度上模拟生物神经元的机制,但面临激活和沉默不稳定的问题。对此,研究团队提出了自适应阈值脉冲神经元。这种神经元通过动态调整激活阈值,防止神经元过度激活或沉默,使神经元保持再适度的活跃状态。

不依赖NVIDIA!国产GPU的逆袭战

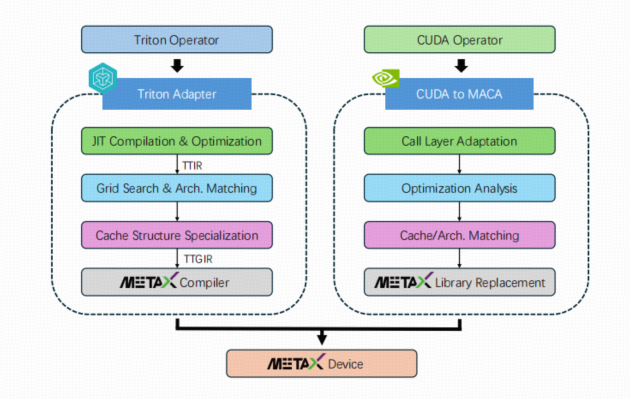

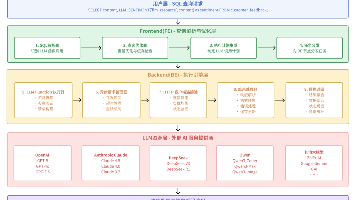

有了好架构,还要能落地训练。国产GPU训练面临低效、不稳定的痛点。SpikingBrain团队针对国产MetaX GPU,从训练流程到硬件适配,做了一整套优化,不仅跑通了7B、76B参数模型的训练,还能稳定运行几周。

在持续预训练(CPT)阶段,研究团队将序列长度由8k逐步扩展到128k,确保模型损失稳定收敛,逐步提高上下文处理能力,这种逐步训练的方式让训练的过程更加稳定。

监督微调(SFT)也分为三个阶段,每个阶段分别使用特定领域的数据来增强模型在常识、对话和推理方面的能力。

其中,第一阶段使用Infinity Instruct基础数据集提高基础语言理解和领域知识、第二阶段使用Infinity Instruct聊天数据集提高对话和指令遵循能力、第三阶段使用通过DeepSeek-R1提炼出的推理数据集提高推理能力。

之后,模型还按照团队的设计进行了脉冲化编码。在团队提出的三种编码方式中,二元脉冲编码简单、能耗低;三元脉冲编码能够让模型更好模拟生物神经系统中的兴奋/抑制调节过程;按位脉冲编码有效压缩了时间步长,适用于高精度、低功耗和时间敏感的计算任务。

由于GPU无法完全利用脉冲化方案的性能优势,后续需要结合专门的异步硬件如脉冲处理器等,才能更好体现脉冲化编码的优势。

研究团队仍然选择在国产的沐曦MetaX GPU集群上训练模型。为了能够实现高效稳定的训练,MetaX平台和研究团队提供了一套全栈适配策略,覆盖了从分布式训练适配、算子适配到并行拓扑等方面**。**其中,算子适配方面,MetaX用Triton适配、CUDA向MACA框架迁移两条路径对模型内部的算子进行优化。

最终,两个模型在数百个MetaX C550 GPU上稳定运行,首次在非NVIDIA 平台上大规模训练类脑LLM,实现了76B参数的稳定训练。

性能验证:长文本处理能力飙升

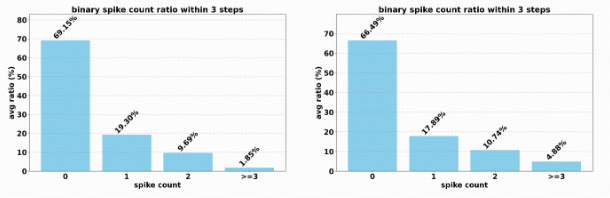

经过验证,SpikingBrain的两个模型能够实现与开源的Transformer基线相当的性能,且显著提高了长序列训练效率,并通过部分恒定的内存和事件驱动的脉冲行为进行推理。此外,研究所提出的脉冲方案实现了69.15%的稀疏性,显著降低了运行功耗。

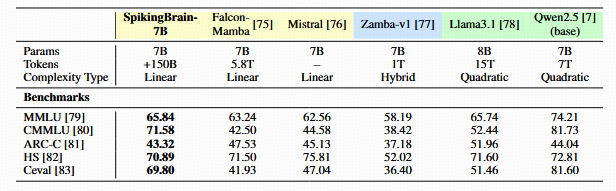

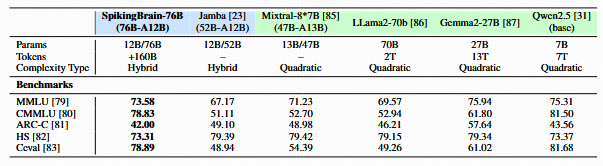

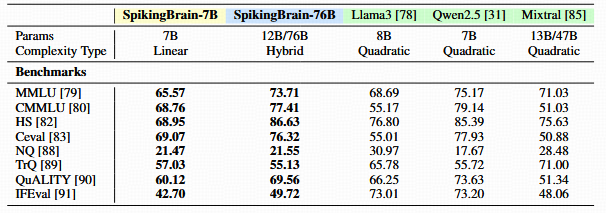

在下游任务评估层面,团队将训练的两个SpikingBrain模型与类似规模、不同架构类型的基线模型进行了比较,所有评估在OpenCompass框架的相同设置下进行。

可以发现,SpikingBrain-7B在追求效率的同时,恢复了近 90% 的基础模型性能,与Mistral-7B和Llama3-8B等优秀模型表现相当。而SpikingBrain-76B以更少的激活参数达到与基础模型相当的性能。

在经过三阶段监督微调后,模型在常识、长序列建模和指令遵循方面实现了与类似规模的开源聊天基线相当的性能,且未表现出过拟合或能力降低,这表明混合线性架构在训练的过程中依然保持了稳定性和可扩展性。

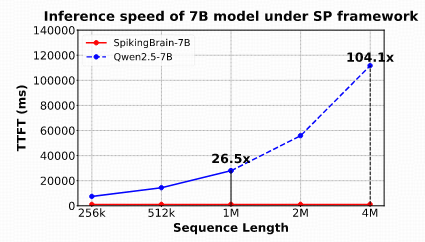

在长序列推理层面,两种SpikingBrain模型得益于混合线性注意架构和MoE的集成,表现出明显的推理加速。通过比较SpikingBrain-7B与Qwen2.5-7B在不同输入长度下的TTFT(生成第一个token的时间)可以发现,在输入为1M情况下达到26.5倍加速,在输入为4M的情况下与Qwen2.5-7的拟合曲线比较加速预计达到104.1倍。

脉冲方案的能效提升同样惊艳。在评测中,**这一方案实现69.15%稀疏性。**与FP16 MAC相比,方案降低了97.7%的能耗,与INT8 MAC相比降低了85.2%,能效分别提高了43.48倍和6.76倍。

结语:迈向更高效的AI未来

SpikingBrain不仅是技术突破,更是生物机理对AI开发的深刻启示。它证明了生物神经系统能够为破解传统大模型的效率瓶颈提供有效方案。

此外,这项研究在非NVIDIA平台上的成功,也标志着AI硬件生态的多元化,为国产GPU和神经形态芯片的发展注入动力。

未来,SpikingBrain的脉冲机制和混合架构,有望推动AI在端侧计算、工业控制等场景落地,实现“绿色高效”的智能革命。

人脑的智慧,正引领我们走向一个更可持续、更贴近自然的AI时代。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)