LLM应用开发社区、框架与未来发展方向

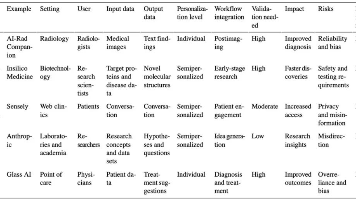

摘要:本文推荐了5个LLM应用开发学习社区:1)LangChain博客(最热框架前沿);2)Dify博客(Agent应用开发);3)Huggingface专栏(模型信息);4)OpenLLM博客(部署方案);5)OpenAI社区(API开发)。同时对比了主流开发框架:LangChain(全能但复杂)、LlamaIndex(专注RAG)、aisuite(轻量接口)、SemanticKernel(微软

·

01. LLM 应用开发社区

值得推荐的学习社区,在这里我们可以了解一线的 LLM 应用开发相关的内容、发展趋势、框架前沿知识等。这里我也整理了一些,希望能在课程之外能帮助大家持续学习。

① LangChain 博客

LangChain 是目前最热门、更新最快、社区最活跃、star 数最高的 LLM 应用开发框架,并且涵盖了 Python 和 JavaScript 两个版本,如果想在第一时间了解这个框架的新特性、LLM 应用开发前沿支持、新 的模型特性,LangChain 博客是最低成本的形式。

在这里你可以了解该框架的案例研究、产品更新和行业新闻,以及对各项新技术的见解,如果觉得英文 阅读麻烦,也可以借助 LLMOps 编排一个 Agent,快速解析指定网页的内容。

链接:https://blog.langchain.dev/

② Dify 博客

Dify.ai 是 2023 年 5 月发布的 LLMOps 产品,在当时也是第一个将 RAG 与知识库融入可视化编排的应 用,近两年的时间过去,Dify 也从最开始的基础 Agent,添加了各类 RAG 策略、工作流、ChatFlow 等 功能,市面上绝大部分 Agent 应用开发平台的功能也都参考了 Dify 的设计,例如:Coze、百度千帆 Builder、阿里百宝箱等,课程在设计的早期就参考了 Dify 的设计思路。

所以如果想关注前沿 LLM/Agent 应用的发展方向,Dify 官方的博客是一个绝佳的渠道,在 Dify 博客中,你可以了解到 Dify 各类模块的设计思路、复杂 Agent 的编排参考、官方产品的更新日志等内容。 链接:https://dify.ai/blog③ Huggingface 专栏博文 Huggingface 是一个机器学习和数据科学平台社区,可以看成是 AI 届的Github,除了有众多开源的大语言模型之外,Huggingface 专栏博文也非常值得关注,在这里你可以看到关于 LLM 模型的最新信息、发布计划、排行信息等内容。 链接:https://huggingface.co/posts

④ OpenLLM 博客

和 Ollama 一样,OpenLLM 也是一个自托管 LLMs 的解决方案,OpenLLM 允许开发人员使用单个命令将任何开源LLMs(Llama 3.3、Qwen2.5、Phi3 等)或自定义模型作为与 OpenAI 兼容的 API 运行。相比 Ollama,OpenLLM 还提供了内置的聊天 UI 与推理后端,在其博客下也分享了大量 LLM 部署、Deepseek、ComfyUI 自定义节点、LangGraph 等方面的内容。

链接:https://bentoml.com/blog⑤ OpenAI 开发者社区 作为掀起 LLM 浪潮的 OpenAI,其社区也是目前活跃度最高的,在 OpenAI 开发者社区里你可以看到关于 API、模型、ChatGPT、插件、Agent 开发、提示词技巧等内容的探讨。 链接:https://community.openai.com/

当然除了上述的社区之外,课程中提供的学习群内也会经常探讨+提供一些关于 LLM/Agent/AI 应用前沿 的信息,学习到这个位置,还没有进群的小伙伴,现在以进群了,QQ群:230085472,进群时注意按照提示信息填写相关内容。

02. 其他 LLM 开发框架

在企业业务中选择不同的 LLM 开发框架,就意味着后期几乎没有可迁移的可能(除非重构),所以选择框架是一项巨大的投资,要考虑框架的维护与更新频率、社区是否活跃等,在这方面 LangChain 是无可挑剔的第一,2 年多的时间提交 12836 次更新,斩获了 100k+ 个 star,并且同时支持 Python 和 JavaScript 两个版本。 但是也能在网上经常看到关于 LangChain 的相关吐槽,例如:我为什么放弃了 LangChain?为什么都放 弃了 LangChain?LangChain 塌方?深入解读开发者是否该弃用?等内容,这也是 LangChain 的一个 老毛病了,过于大而全,从提示词、消息、模型、插件、Agent、工作流、向量数据库、回调管理、监 控追踪应有尽有,以 langchain 为前缀的 Python 包就有数百个,并且过于抽象的封装也让新手学起来 比较吃力。所以如果更专注于 AI 应用的某个方向,不想使用这么庞大复杂的架构,可以考虑其他 LLM 应用开发框

架,例如:

1. LlamaIndex:这是一个专门用于构建 RAG 系统的框架,提供基于 LLM 的应用程序获取、构建和 访问私有或特定领域的数据,对比微服务的业务开发框架 Spring Cloud 和数据代理框架 MyBatis, LangChain 就是 AGI 时代的新 Sprint Cloud,而 LlamaIndex 就是 AGI 时代的 MyBatis,仓库地址:https://github.com/run-llama/llama_index。

2. aisuite:如果不需要框架这么复杂的功能,更希望使用原生的 Python 进行开发,但是又不想手动对齐多个 LLM 接口的差异,这时候可以考虑吴恩达老师开源的 aisuite,这个三方库围绕目前最流行的大语言模型(LLM)提供一个类似OpenAI 的API,使开发人员可以使用 OpenAI 的请求与响应格式快速接入其他第三方模型,仓库地址:https://github.com/andrewyng/aisuite。

3. Semantic Kernel:这是微软开源的一个轻量级的开源开发套件,它让你可以轻松构建 AI Agent,并将最新的 AI 模型集成到您的 C#、Python 或 Java 代码库中;它提供了一个简单易用的 API,可以连接到各种 AI 服务,例如 OpenAI、Azure OpenAI 和 Hugging Face 等;并且它作为业高效的中 间件,能够快速交付企级解决方案,仓库地址:https://github.com/microsoft/semantic-kernel。

4. AutoChain:AutoChain是一款源自 LangChain 和 AutoGPT 的新一代开发框架,旨在解决这两种工具存在的问题,如果有 LangChain 的相关经验,上手 AutoChain 会非常迅速,不过这个框架目前更新频率并不是很高,仓库地址:https://github.com/Forethought-Technologies/AutoChain。

03. Agent 发展探讨

2025年初,以 DeepSeek R1 系列模型为代表的AI技术突破,标志着智能 Agent 技术进入新阶段。

DeepSeek 通过混合专家模型(MoE)、多投潜注意力算法(MLA)以及强化学习优化,将训练成本降 至 OpenAI 模型的 1/70,同时推理效率提升显著。这种“重推理、轻训练”的模式不仅降低了算力门槛,还通过开源策略推动生态扩展,让 Agent 在业务端落地成为了可能。

关于 Agent 未来的发展,我也整理了一些个人看法,和大家一起交流探讨下,希望能给大家未来的学习方向一些思路。

① 模型能力持续优化

以 DeepSeek/OpenAI 为首的大语言模型通过参数规模扩大与架构优化,大模型将突破语言理解、逻辑推理等能力边界。例如,在任务规划、工具使用等方面,效率能力更高;在模型思考推理速度等方面模型响应将更快,甚至是在不久的将来实现千亿级参数模型的分布式推理优化,降低模型所需硬件功耗,实现边缘设备也能运行 LLM(想象下家里的智能电灯泡也称为分布式 LLM/Agent 节点计算网络的一部分)。

② 多模态融合成为标配

随着近两年的发展,LLM 的多模态输入/输出已成为常态(文本/语音/视频/图片输入),未来的 Agent 将整合文本、图像、语音等多模态输入输出能力,例如医疗 Agent 可同时分析 CT 影像(视觉)和病历 文本(语言),生成综合诊断报告。

③ 协作生态体系形成 由于不同的 LLM 在不同业务方向上的能力表现会有差异,构建更强大的通用型 LLM 可能还需要一段时

间,但是多 Agent 协作已经开始落地了,多 Agent 系统将建立分工协作机制,通过博弈论框架实现动态任务分配。例如在物流调度场景中,路径规划 Agent、库存管理 Agent 等可基于强化学习算法形成协同决策,并且多 Agent 协作之间的通信也会逐步形成规范标准。

④ RAG 与成本优化越来越多的企业会开始采用 RAG(检索增强生成)技术,无需重新训练即可更新知识库,而非微调或者重新花海量时间与金钱成本重新训练 or 微调模型,RAG 会成为每个 Agent 应用的标配。例如金融Agent 通过实时接入市场数据源,快速响应政策变化。

⑤ 伦理安全更加规范

随着 Agent 应用普及,数据隐私、算法偏见问题也开始暴露出来。可以通过联邦学习实现数据隐私保护,目前的方案是将模型分块,模型主体放在远程,降低本地资源要求。在客户端和模型服务端,进行加解密转换。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)