【AI论文】MiniCPM-V 4.5:通过架构、数据及训练方案打造高效的多模态大语言模型

摘要:研究团队推出高效多模态大语言模型MiniCPM-V4.5,通过统一3D重采样器架构、无数据工程学习范式和混合强化学习策略三大创新,在8B参数量下实现超越GPT-4o等大模型的性能。实验显示,该模型在OpenCompass评估中平均得分77.0,视频理解任务内存占用仅为同行46.7%,推理时间缩短91.3%,同时具备优秀的文档解析能力。研究为平衡模型性能与效率提供了新思路,但长视频理解等方向仍

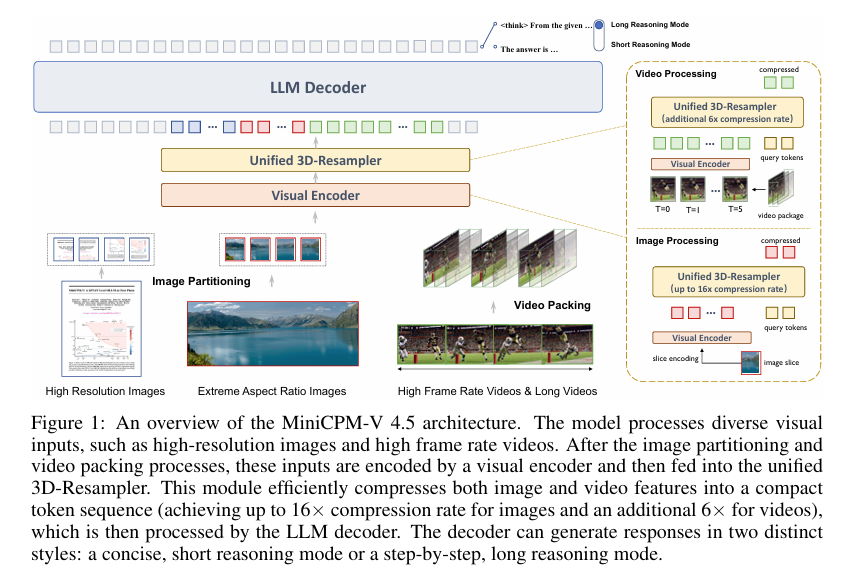

摘要:多模态大语言模型(MLLMs)正迅猛发展,代表着人工智能发展的前沿方向。然而,其训练和推理效率已成为让多模态大语言模型更易获取、更具可扩展性的核心瓶颈。为应对这些挑战,我们推出了MiniCPM-V 4.5,这是一款拥有80亿参数的模型,旨在实现高效率与强性能。我们在模型架构、数据策略和训练方法上进行了三项核心改进:采用统一的3D重采样器模型架构,可对图像和视频进行高度紧凑的编码;采用统一的学习范式,无需大量数据工程即可实现文档知识学习和文本识别;采用混合强化学习策略,使模型在短推理和长推理模式下均能表现出色。在OpenCompass评估中进行的全面实验结果显示,MiniCPM-V 4.5超越了广泛应用的专有模型(如最新版GPT-4o)以及参数量大得多的开源模型(如Qwen2.5-VL 72B)。值得注意的是,该模型在取得优异性能的同时,还具备极高的效率。例如,在广泛采用的VideoMME基准测试中,MiniCPM-V 4.5在参数量小于300亿的模型中取得了最优性能,且GPU内存占用仅为Qwen2.5-VL 7B的46.7%,推理时间仅为Qwen2.5-VL 7B的8.7%。Huggingface链接:Paper page,论文链接:2509.18154

研究背景和目的

研究背景:

随着人工智能技术的飞速发展,多模态大型语言模型(Multimodal Large Language Models, MLLMs)已成为推动AI进步的前沿领域。

这些模型能够深度理解和推理跨模态信息(如文本和图像),在多个领域展现出巨大的应用潜力。然而,MLLMs的训练和推理效率成为制约其广泛应用和可扩展性的核心瓶颈。具体来说,高分辨率图像和视频编码需要大量的视觉标记,导致计算成本高昂;从文档中提取高质量的多模态知识面临复杂布局和多样领域的挑战;以及复杂推理能力训练中存在的效率问题。这些问题共同限制了MLLMs的进一步发展和应用。

研究目的:

本研究旨在通过架构创新、数据策略优化和训练方法改进,开发一个高效且性能强大的MLLM模型——MiniCPM-V 4.5。

具体目标包括:

- 提高编码效率:通过引入统一的3D-Resampler架构,减少图像和视频编码的视觉标记数量,从而降低计算成本和内存占用。

- 简化数据工程:提出一种统一的学习范式,使模型能够直接从文档图像中学习知识和文本识别,减少对外部解析工具的依赖。

- 增强推理能力:采用混合强化学习策略,使模型在短推理和长推理模式下均表现出色,提高整体推理效率和准确性。

研究方法

模型架构:

MiniCPM-V 4.5的架构主要包括三个核心模块:轻量级视觉编码器、统一的3D-Resampler和LLM解码器。

- 轻量级视觉编码器:灵活处理高分辨率图像,采用特殊的分区策略,将图像分割成多个部分,每部分通过交叉注意力机制生成固定长度的序列。

- 统一的3D-Resampler:扩展2D-Resampler到3D,同时压缩图像和视频的空间和时间信息。通过联合压缩空间和时间冗余,显著减少视觉标记数量。

- LLM解码器:理解图像、视频和文本,生成文本输出。解码器能够以两种不同的风格生成响应:简洁的短推理模式或详细的逐步推理模式。

数据策略:

- 预训练数据:结合大规模公共图像-标题数据集、精心策划的中文图像-文本对、OCR丰富数据、文档数据和视频标题数据,分阶段优化模型的基础能力。

- 统一学习范式:提出一种从文档图像中直接学习知识和文本识别的统一范式,通过动态破坏文本区域并要求模型重建文本,增强模型的鲁棒OCR能力和上下文推理能力。

训练方法:

- 分阶段预训练:预训练过程分为三个阶段,逐步解冻不同模型组件,引入越来越复杂的数据,优化学习效率。

- 监督微调(SFT):首先训练模型的通用交互能力,然后培养专门技能以支持长推理模式和高帧率视频理解。

- 强化学习(RL):结合基于规则验证的奖励和基于概率的奖励,优化复杂推理能力,支持短推理和长推理模式的灵活切换。

研究结果

性能表现:

- 综合多模态理解能力:在OpenCompass评估中,MiniCPM-V 4.5的平均得分达到77.0,超越了广泛使用的专有模型(如GPT-4o-latest)和更大的开源模型(如Qwen2.5-VL 72B)。

- 视频理解能力:在VideoMME等视频理解基准测试中表现出色,特别是在高帧率和长视频理解方面展现出强大能力。

- OCR和文档分析能力:在OCRBench上取得领先性能,超过专有模型如GPT-4o-latest;在OmniDocBench上实现了一般的MLLMs中最先进的PDF文档解析能力。

效率提升:

- 推理效率:MiniCPM-V 4.5在推理过程中显著提高了效率,包括短推理和长推理模式。在RL训练中,通过随机交替短推理和长推理样本,实现了两种推理模式的通用性能增强。

- 内存和时间效率:在VideoMME基准测试中,MiniCPM-V 4.5仅使用46.7%的GPU内存成本和8.7%的推理时间就达到了30B以下模型的最佳性能。

研究局限

尽管MiniCPM-V 4.5在性能和效率上均取得了显著成果,但该研究仍存在一些局限:

- 数据依赖性:模型性能高度依赖于训练数据的质量和多样性,数据工程的质量直接影响模型性能。

- 模型大小与效率平衡:虽然MiniCPM-V 4.5在效率上取得了显著成果,但模型大小与效率之间的平衡仍需进一步优化。

- 长视频理解:尽管在视频理解方面取得了进展,但对长视频和极端长视频的理解能力仍有待提高。

未来研究方向

基于MiniCPM-V 4.5的研究成果和局限,未来研究可以从以下几个方面展开:

- 数据自主性:减少对外部解析工具的依赖,进一步提高模型从文档图像中直接学习知识的能力。

- 长视频理解:改进模型对长视频和极端长视频的理解能力,特别是在处理低分辨率视频时的性能。

- 模型压缩与加速:探索更高效的模型压缩技术,减少模型参数数量,同时保持或提高模型性能。

- 通用推理能力:进一步优化模型的通用推理能力,减少对单一长推理模式的依赖,提高模型在短推理和长推理模式下的通用性和灵活性。

- 多语言与多领域支持:扩展模型支持的语言和领域范围,提高模型在不同文化和领域背景下的适用性。

通过上述方向的深入研究,可以进一步提升MLLMs的效率、通用性和可靠性,推动AI技术向更广泛的实际应用场景发展。

更多推荐

已为社区贡献13条内容

已为社区贡献13条内容

所有评论(0)