简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

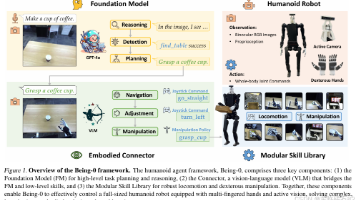

构建能够在现实世界具身任务中实现人类水平表现的自主机器人智能体,是人形机器人研究领域的终极目标。近期的研究进展在利用基础模型(Foundation Models, FMs)实现高级认知以及为人形机器人开发低级技能方面取得了显著成果。然而,由于长时程任务中的复合误差以及不同模块之间的延迟差异,直接将这些组件组合在一起往往会导致系统鲁棒性和效率低下。我们推出了Being-0,这是一种将基础模型与模块化

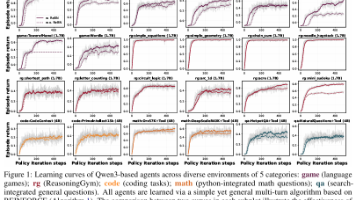

GEM框架:面向大语言模型的通用经验生成器 本文提出GEM(通用经验生成器)框架,为大型语言模型(LLMs)提供标准化的强化学习环境接口。GEM支持多轮交互、工具集成和异步并行执行,包含24个多样化环境以及REINFORCE、PPO等基准算法。特别提出带回报批归一化的REINFORCE变体(ReBN),在多轮任务中展现出更优表现。实验验证了工具集成对模型性能的提升作用,并展示了算法在不同折扣因子下

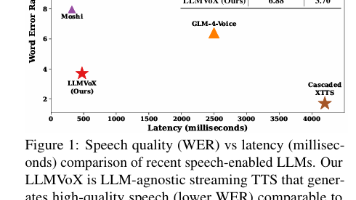

近期,语音对话系统在利用大型语言模型(LLM)进行多模态交互方面取得了进展,但仍受到微调需求、高计算开销以及文本与语音不对齐等问题的制约。现有的支持语音的LLM往往通过修改LLM来损害对话质量,从而削弱了其语言能力。相比之下,我们提出了LLMVoX,这是一个轻量级的3000万参数、与LLM无关的、自回归流式文本转语音(TTS)系统,它能够在低延迟下生成高质量语音,同时完全保留基础LLM的能力。我们

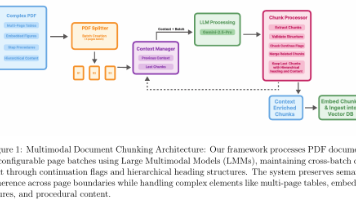

本文提出了一种基于多模态LMM的文档块划分方法,用于改进RAG系统处理复杂PDF文档的性能。传统文本分割方法在处理跨页表格、嵌入式图表等复杂结构时存在局限。本研究创新性地采用视觉引导的批处理机制(每批4页),通过保留上下文摘要和标题层级结构,实现了跨页内容的语义连贯性。实验表明,该方法显著提升了多页表格完整性保持(94.3%)和程序序列准确率(88.7%),生成的块数量增加5倍,RAG系统准确率提

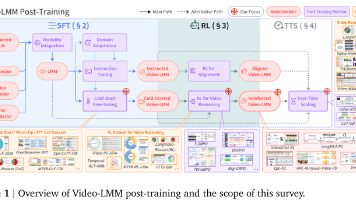

视频理解是计算机视觉的前沿方向,要求模型处理复杂的时空关系和多模态信息。近期出现的视频大语言多模态模型(Video-LMMs)将视觉编码器与语言模型结合,展现出强大能力。本文首次系统综述了Video-LMMs的后训练方法,包括三大支柱:基于思维链的监督微调(SFT)、基于可验证目标的强化学习(RL)以及测试时扩展(TTS)。研究提出了结构化分类体系,分析了这些技术在视频任务中的适配与挑战,如时间定

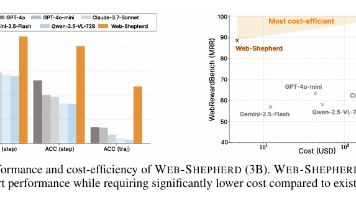

本文介绍了Web-Shepherd,这是一个专门用于评估网络导航轨迹的过程奖励模型(PRM),旨在提高网络代理的性能和可靠性。研究首先构建了包含40K个步骤级别偏好对和标注清单的WebPRMCollection数据集,并引入了首个用于评估PRM的元评估基准WebRewardBench。实验结果显示,Web-Shepherd在WebRewardBench上的准确率显著高于GPT-4o,并在WebAr

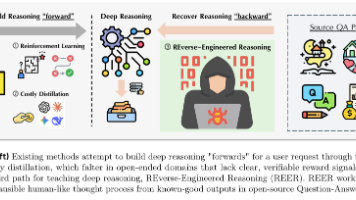

摘要:本研究提出逆向工程推理(REER)新范式,通过从高质量输出反向推导推理过程,解决开放式生成任务中深度推理的应用难题。研究采用迭代局部搜索算法构建含20,000条推理轨迹的DeepWriting-20K数据集,并基于此训练的DeepWriter-8B模型在多个基准测试中超越开源基线,部分指标媲美GPT-4o等专有模型。该方法突破了传统强化学习和指令蒸馏的局限,为开放式任务推理提供了新思路,但仍

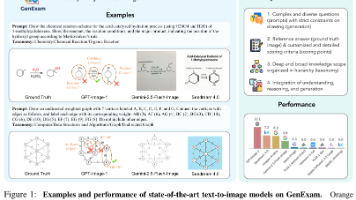

摘要: 本研究提出首个跨学科文生图考试基准GenExam,包含10个学科的1000个样本,配备真实图像答案和细粒度评分标准。通过四级分类体系设计考试风格提示语,对生成图像的语义正确性和视觉合理性进行严格评估。实验显示,GPT-Image-1等先进模型的严格得分不足15%,多数模型接近0%,凸显基准的挑战性。该研究填补了现有生成测试忽视绘图类考试的空白,为评估模型知识整合与生成能力提供新范式,推动A

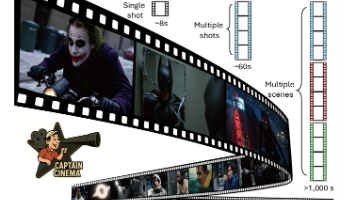

《电影队长:基于关键帧规划与长上下文学习的短片生成框架》摘要 本研究提出"电影队长"(CaptainCinema)短片生成框架,通过双向方法实现叙事连贯的自动视频创作。采用自上而下的关键帧规划生成叙事关键帧序列,结合自下而上的视频合成技术,利用改进的多模态扩散变换器(MM-DiT)进行长上下文视频生成。创新性地引入交错训练策略和GoldenMem记忆机制,有效处理长视频数据。实

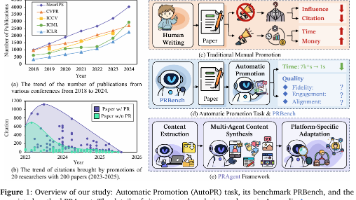

摘要:本研究提出"自动学术推广"(AutoPR)任务,旨在将学术论文自动转化为适合社交平台传播的内容,以提升学术成果的可见性。研究构建PRBench多模态基准测试集(包含512篇论文及其推广文案),从保真度、吸引力和适配度三个维度评估系统性能。同时开发PRAgent多智能体框架,通过内容提取、协作合成和平台适配三阶段实现推广内容自动化生成。实验表明,PRAgent相比直接使用大