【必藏】从GenAI到Agentic AI:全面解析AI系统架构与安全威胁,程序员必读指南

文章系统分析了AI应用架构的三大发展阶段:GenAI、AI Agents和Agentic AI,详细阐述了各自的特点、架构及安全威胁。GenAI专注于内容生成,AI Agents具备任务执行能力,Agentic AI强调自主决策。文章通过OWASP等权威框架,解析了各类型AI系统的TOP威胁特征及应对措施,强调理解AI架构对安全分析的重要性,为AI系统安全防护提供了系统性的方法论。

AI系统的安全威胁与其架构密不可分,分析AI安全性首先需要理解其应用架构。目前AI应用架构经历了从GenAI到AI Agents,再到Agentic AI的演进过程,形成三个不同发展阶段,且各方向都在独立发展。

安全分析需要系统性的方法论,而权威机构的研究成果为此提供了重要基础。本文将从AI系统分类及架构出发,分析不同类型AI系统的威胁特征,并介绍现有的威胁分析框架。主要内容:

全文较长,约7200字,阅读时间18分钟。文中包含较多的图片及表格内容,用电脑阅读更合适。

01 AI系统的分类及架构

目前AI应用系统基本可以分为三个大类:生成式人工智能(GenAI),AI智能体(AI Agents)和代理式AI(Agentic AI)。

鉴于AI系统还在快速发展,形态均未最终确定,目前对相关的定义还未达成统一。本文会介绍一些主流定义。

1.1 生成式人工智能(GenAI)

GenAI NIST的定义,参考资料1

在NIST的定义中,首先引用了 美国第 14110 号行政命令将生成式人工智能(GenAI)定义为 “一类模仿输入数据的结构和特征,以生成衍生合成内容的人工智能模型。这类内容可包括图像、视频、音频、文本及其他数字内容”。

然后增加了补充:

就本文档而言,生成式人工智能(GAI)通常指生成式基础模型。

MIT认为:

生成式人工智能可以被认为是一种机器学习模型,它被训练来创建新数据,而不是对特定数据集进行预测。生成式人工智能系统能够学习生成更多与其训练数据相似的对象。(https://news.mit.edu/2023/explained-generative-ai-1109)

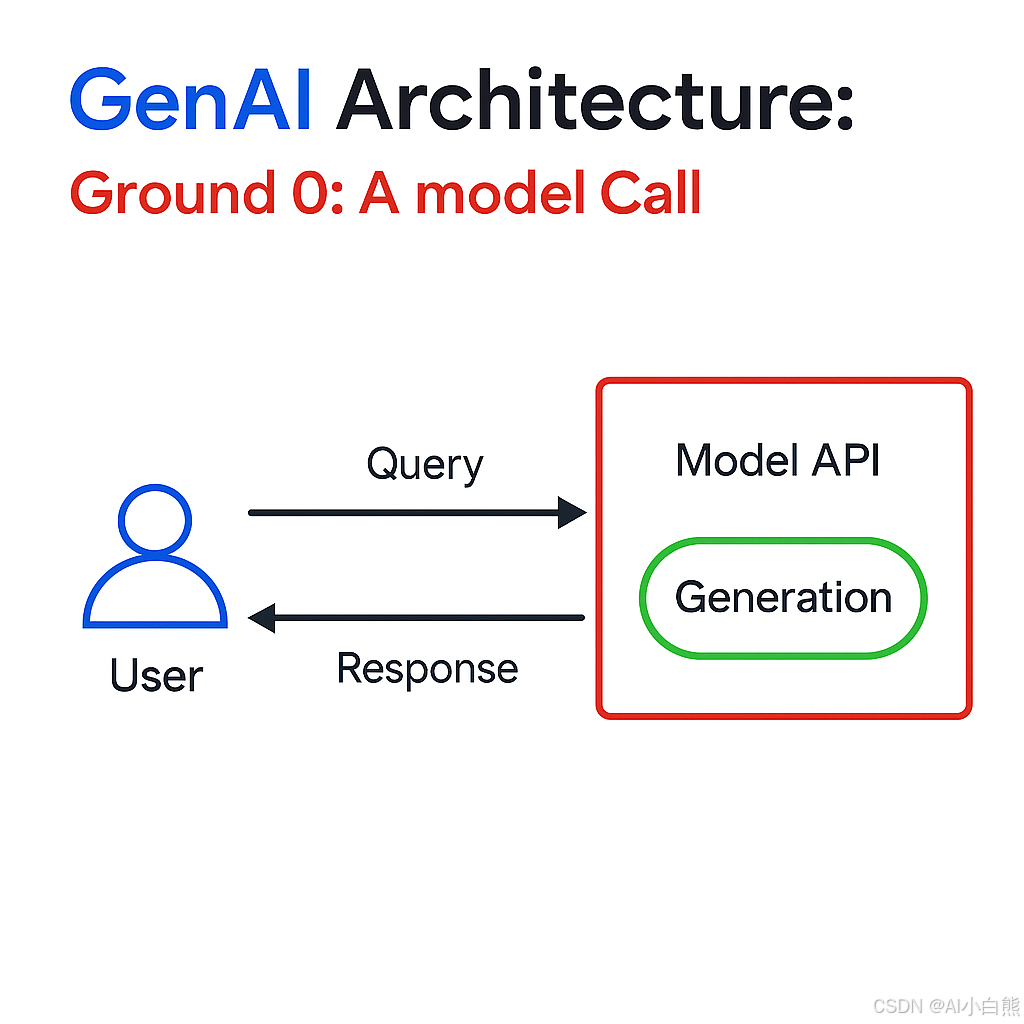

从以上定义,GenAI更多倾向于模型能力,及简单的RAG能力。

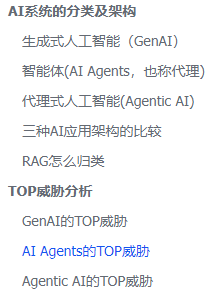

关于GenAI的架构,从简单到复杂,有多种(详细介绍推荐阅读 https://peerlist.io/yashkavaiya/articles/building-intelligent-systems-how-agent-architecture-is-revol)

1.2 智能体(AI Agents,也称代理)

AI Agents代表了AI系统演进的重要阶段,它们不仅能够生成内容,还具备了执行特定任务和与外部环境交互的能力。

按OWASP 代理式人工智能——威胁与缓解(参考资料2)

人工智能代理是一种智能软件系统,旨在感知其环境、进行推理、做出决策并采取行动以自主实现特定目标。

在这里,自主性很重要,与GenAI相比特别容易区别,GenAI不包含自主性。

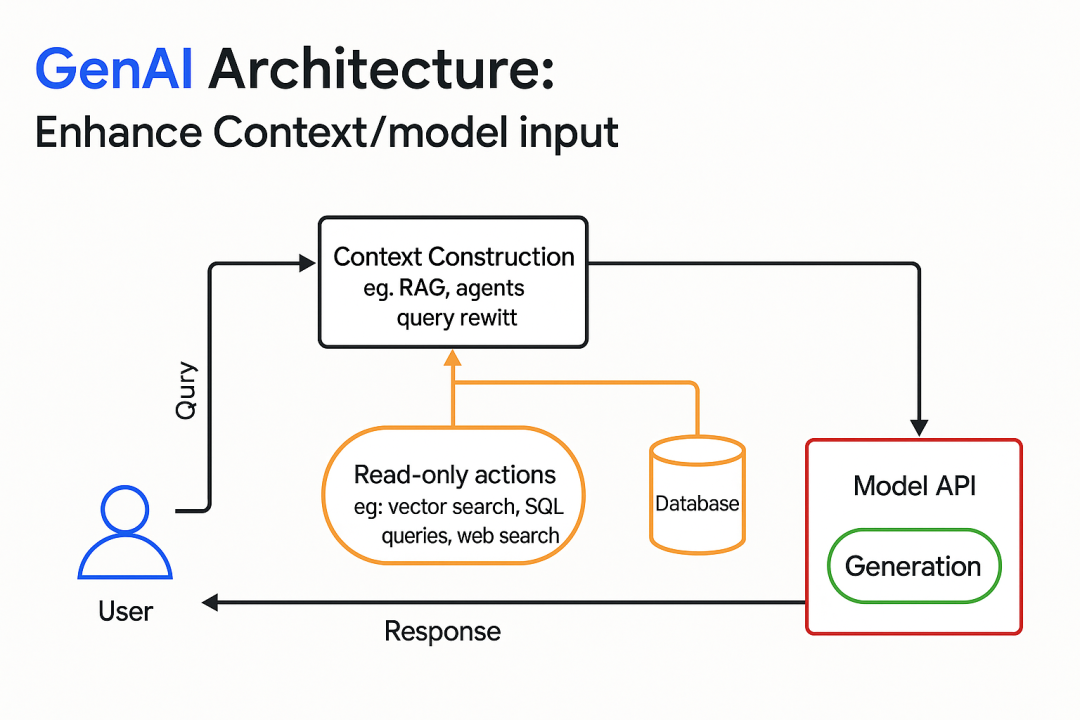

AI Agents的核心能力包括:

计划与推理能力:代理系统具备逻辑推理能力,能够自主决策达成目标所需的步骤。这包括制

定、跟踪和更新行动计划以应对复杂任务(即Reason+Act、ReAct模式 )。现代智能体普遍采用大

型语言模型(LLM)作为推理引擎,通过调用这些模型来控制应用程序的执行流程,这构成了智

能体自主性的核心要素。包括

反思,智能体通过评估过去的行为及其结果来确定未来计划或行为。自我批评 ,是反思的关

键部分,智能体通过批评自己的推理或输出来识别和纠正错误。

思维链是逐步推理过程,智能体通过该过程将复杂问题分解为连续的逻辑步骤。这可能涉

及多步骤工作流,包括不需要人工参与的工作流。

子目标分解,即把一个主要目标分成更小的、可管理的任务或里程碑,以实现总体目标

记忆/状态保持以保留和回忆信息。这可以是来自以前运行的信息,也可以是当前运行中它所采取

的先前步骤(即,其动作背后的推理、它们调用的工具、它们检索的信息等)。记忆可以是基于

会话的短期记忆或持久的长期记忆。

行动与工具使用:人工智能代理能够执行任务并调用工具作为操作环节。这些工具既包含内置功能

(如网页浏览、复杂数学运算、根据用户查询生成或运行可执行代码),也可通过外部API接口和

专用工具界面调用更高级的工具。此外,增强型语言模型为工具调用提供了新维度——通过调用

模型自动生成的代码 实现工具调用,这种形式属于工具使用的特殊类型。

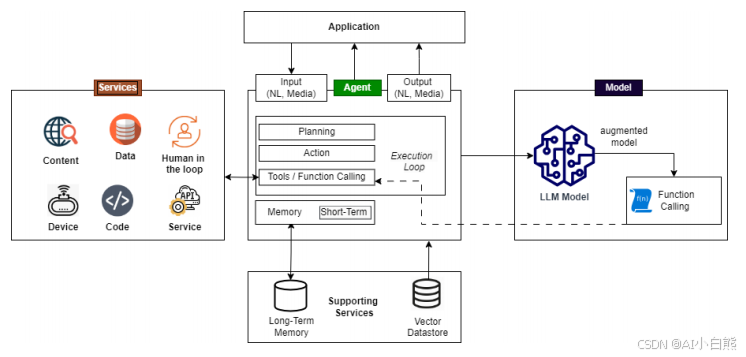

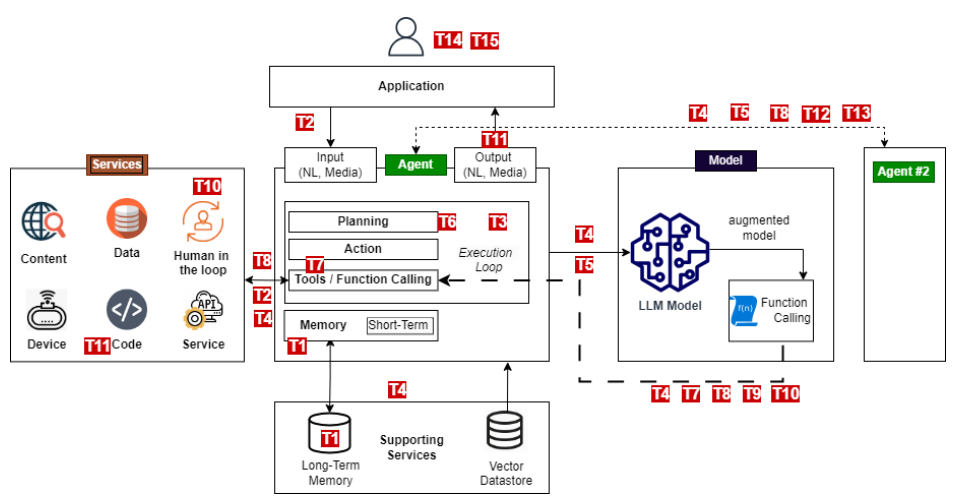

在架构上,该文档使用了一个我们很常见的图

1.3 代理式人工智能(Agentic AI)

维基百科给的定义是:

代理型人工智能(Agentic AI)是一类人工智能,专注于自主系统,这些系统能够在有或无人工干预的情况下做出决策并执行任务。这些独立系统能够自动响应各种情况,采用程序化、算法化和类似人类的创造性步骤,从而产生流程结果。该领域在流程自动化领域与代理自动化(也称为基于代理的流程管理系统)紧密相关。其应用领域包括软件开发、客户支持、网络安全和商业智能。

AWS也有个定义:

Agentic AI是一种自主的人工智能系统,能够独立行动以实现预定目标。传统软件遵循预定义的规则,传统的人工智能也需要提示和逐步指导。然而,Agentic AI 具有主动性,无需人工持续监督即可执行复杂任务。“Agentic”指的是自主性——这些系统能够独立行动,但以目标为导向。

按OWASP 代理式人工智能——威胁与缓解(参考文件2),列出了两种架构:

单一代理架构

代理通常会接收与自然语言处理模型类似的自然语言输入,包括文本提示以及文件、图像、声音

或视频等可选媒体。应用程序的代码实现了核心功能,很可能依赖于代理框架(如LangChain/LangFlow、AutoGen、Crew.AI等)提供的抽象化组件。

- 使用一个或多个LLM模型(本地或远程)进行推理

- 服务,包括内置函数、本地工具和本地应用程序代码、本地或远程外部服务

- 作为代理基础结构和核心功能一部分的支持服务:

a. 用于持久长期记忆的外部存储器

b. 其他数据源包括Vector数据库、其他数据以及RAG中使用的内容。虽然RAG相关数据源也可以视为工具的一部分,但在此我们将其重点强调为可在任何LLM应用中使用的核支持服务。

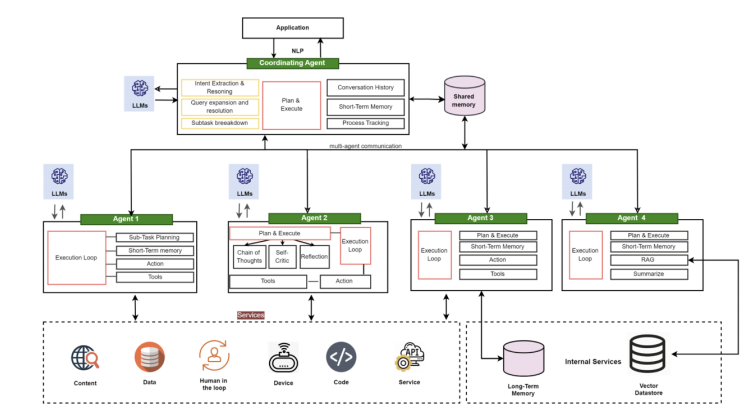

多代理架构

多智能体架构包含多个智能体,这些智能体能够在解决方案中扩展或整合专业角色与功能。无论是扩展

还是整合模式,其架构原理基本相似,区别主要在于引入了智能体间的通信机制,以及可选配置的协调

智能体。

1.4 三种AI应用架构的比较

| 特征维度 | GenAI(生成式AI) | AI Agents(AI智能体) | Agentic AI(自主AI) |

| 核心目标 | 内容生成 | 任务执行 | 自主决策与行动 |

| 主要功能 | 文本、图像、音频、视频等内容创建 | 完成特定任务,与环境交互 | 长期目标规划,自主运行 |

| 自主程度 | 低(依赖提示) | 中(任务导向) | 高(最小监督) |

| 交互方式 | 单轮或多轮对话 | 工具调用、API集成 | 多系统协调、环境感知 |

| 决策能力 | 基于统计模式 | 基于规则和推理 | 基于元认知和策略规划 |

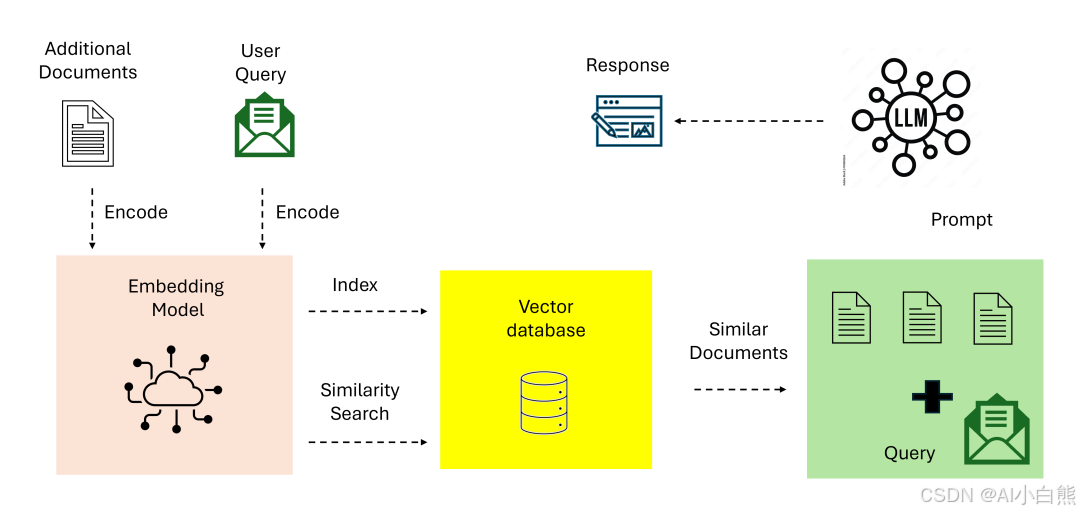

1.5 RAG怎么归类

有三种AI的应用架构,RAG应该算哪种? 参考文档3对此有详细的描述:

1.Naive RAG归性于GenAI的范围,Advanced RAG及Graph RAG应该都归于此类

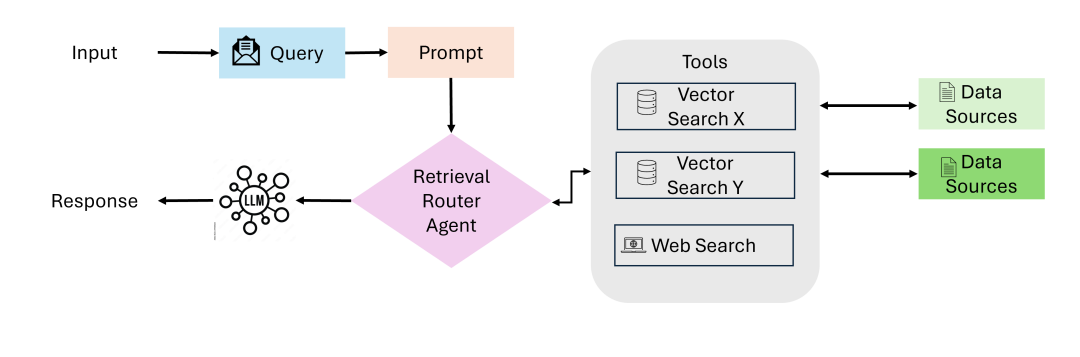

2.代理RAG应该归到AI Agents的范围,因为无论哪种RAG,还是以信息处理为基础,目标比较单一,但具备工具调用能力,符合AI Agents的特征。

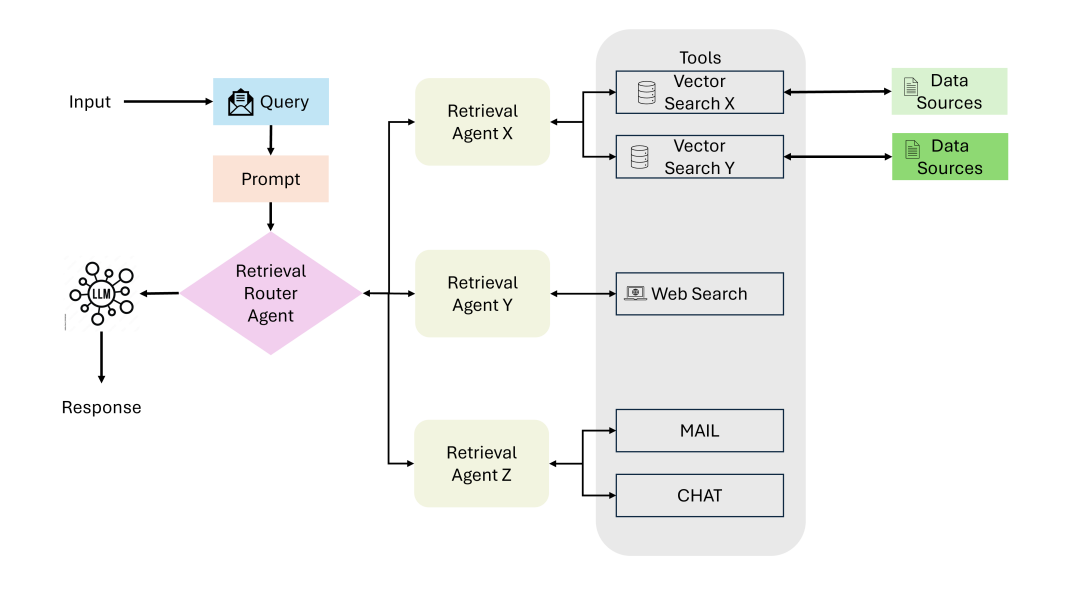

单代理RAG

多代理RAG

02 TOP威胁分析

2.1 GenAI的TOP威胁

GenAI的威胁,Paloalto的总结很好,威胁共分为12种:

- 即时注入攻击

- 人工智能系统和基础设施安全

- 不安全的AI生成代码

- 数据中毒

- 人工智能供应链漏洞

- 人工智能生成的内容完整性风险

- 影子人工智能

- 敏感数据泄露或泄漏

- 访问和身份验证漏洞

- 模型漂移和性能下降

- 治理和合规问题

- 算法透明度和可解释性

2.2 AI Agents的TOP威胁

OWASP在安全威胁方面有非常权威的位置,从Web 威胁开始被广为接受。AI出现后,他们从2023年8月发布了《Top 10 for LLMs and Gen AI Apps》1.0版,并在当年10月发布1.1版本的更新。2025年初发布了2.0版本,名字上稍微有点变化:OWASP Top 10 for LLM Applications 2025 从GenAI到LLM应用,体现了关注点从GenAI到智能体的变化,所以,2025版本应该归到AI Agents TOP威胁的类别。

基于OWASP LLM应用程序TOP 10威胁,AI Agents面临的主要安全威胁:

- 提示注入 (Prompt Injection)

LLM01 - 最严重威胁

- 直接注入:恶意用户通过精心构造的输入覆盖系统提示

- 间接注入:通过外部数据源(网页、文件)植入恶意指令

- 对AI Agents的影响:可能导致Agent执行非预期操作,如访问敏感数据或调用危险API

- 不安全的输出处理 (Insecure Output Handling)

LLM02

- AI Agent生成的内容未经充分验证就传递给下游系统

- 可能导致XSS、CSRF、SSRF、权限提升等攻击

- 特别危险,因为Agent输出通常直接影响系统行为

- 训练数据中毒 (Training Data Poisoning)

LLM03

- 恶意数据污染训练集,影响模型行为

- 对AI Agents而言,可能导致决策偏差或恶意行为模式

- 包括后门攻击和数据完整性破坏

- 模型拒绝服务 (Model Denial of Service)

LLM04

- 通过大量请求或资源密集型操作使Agent不可用

- 包括输入长度攻击、递归调用、复杂推理任务

- 对依赖实时响应的Agent系统尤为致命

- 供应链漏洞 (Supply Chain Vulnerabilities)

LLM05

- 第三方模型、数据集、插件的安全风险

- AI Agent通常依赖多个外部组件

- 包括模型后门、依赖库漏洞、数据源污染

- 敏感信息泄露 (Sensitive Information Disclosure)

LLM06

- Agent可能无意中泄露训练数据中的敏感信息

- 通过推理暴露未授权的内部数据

- 包括PII泄露、商业机密暴露

- 不安全的插件设计 (Insecure Plugin Design)

LLM07

- 对AI Agents极其关键,因为Agent核心功能依赖插件/工具

- 插件缺乏适当的访问控制和输入验证

- 可能导致远程代码执行、数据泄露

- 过度代理 (Excessive Agency)

LLM08

- Agent被赋予过多权限或自主性

- 缺乏适当的人工监督和控制

- 可能导致非预期的高风险操作

- 过度依赖 (Overreliance)

LLM09

- 用户过度信任AI Agent的输出

- 缺乏适当的验证和审查机制

- 可能导致错误决策和安全风险

- 模型盗取 (Model Theft)

LLM10

- 通过API查询重建或提取模型信息

- 知识产权盗取和竞争优势丧失

- 对商业AI Agent服务的直接威胁

2.3 Agentic AI的TOP威胁

针对Agentic AI,OWASP发布了OWASP Agentic AI - Threats and Mitigations(参考文档2) ,该文档基于一个单Agent架构,详细列出了Agentic的15项威胁,列表如下(表中编号与图中红字对应):

| 威胁编号 | 威胁名称 | 威胁描述 | 缓解措施 |

| T1 | 内存中毒 Memory Poisoning | 内存中毒涉及利用AI的短期和长期内存系统,引入恶意或虚假数据,并利用代理的 上下文。这可能导致决策改变和未经授权 的操作。 | 实施内存内容验证、会话隔离、内存访问的健壮 身份验证机制、异常检测系统和定期内存清理例 程。要求使用AI生成的内存快照进行取证分析, 如果检测到异常则回滚。 |

| T2 | 工具滥用 Tool Misuse | 工具滥用是指攻击者在授权权限范围内,通过欺骗性提示或指令操控AI智能体,滥用其集成工具的行为 。这包括智能体劫持,即AI智能体摄入被恶意篡改的数据后 执行非预期操作,可能触发恶意工具交互 | 实施严格的工具访问验证,监控工具使用模式,验证代理指令,并设置明确的操作边界,以检测和防止误用。实施执行日志,跟踪AI工具调用以进行异常检测和事件后审查。 |

| T3 | 特权受损 Privilege Compromise | 特权受损是指攻击者利用权限管理中的弱点 执行未经授权的操作。这通常涉及动态角色 继承或错误配置。 | 实施细粒度的权限控制、动态访问验证、对角色变 更的强有力监控以及对提升特权操作的彻底审计。 除非通过预定义的工作流明确授权,否则防止跨代理特权委派。 |

| T4 | 资源过载 Resource Overload | 资源过载利用AI系统的计算、内存和服务能力来降低性能或导致故障,利用其资源密集型的特性。 | 部署资源管理控制,实现自适应扩展机制,建立配额,并实时监控系统负载以检测和缓解过载尝试。实施AI速率限制策略,以限制每个代理会话的高频任务请求。 |

| T5 | 级联幻觉攻击 Cascading Hallucination Attacks | 这些攻击利用了人工智能生成上下文合理但虚假信息的倾向,这可能会通过系统传 播并破坏决策。这也可能导致破坏性的推 理,影响工具调用。 | 建立完善的输出验证机制,实施行为约束措施,部 署多源验证系统,并通过反馈循环确保系统持续优 化。在人工智能生成的知识被用于关键决策流程前, 必须进行二次验证。 |

| T6 | 意图破坏与目标操纵 Intent Breaking & Goal Manipulation | 这种威胁利用了AI代理的规划和 目标设定能力中的漏洞,使得攻 击者能够操纵或重定向代理的目 标和推理。一种常见方法是工具 滥用中提到的代理劫持。 | 实施规划验证框架,对反思流程进行边界管理,并 建立动态保护机制以实现目标对齐。通过部署AI行 为审计, 由另一模型检查代理并标记可能表明被操 纵的重大目标偏差。 |

| T7 | 错位与欺骗行为 Misaligned & Deceptive Behaviors | 利用推理和欺骗性反应执行有害或被禁 止的行动以实现其 目标的人工智能代 理。 | 训练模型识别并拒绝有害任务,执行政策限制,要 求对高风险行为进行人工确认,实施日志记录和监 控。利用欺骗检测策略,如行为一致性分析、真实 性验证模型和对抗性红队测试,评估AI输出与预期 推理路径之间的不一致。 |

| T8 | 否定与不可追溯性 Repudiation & Untraceability | 由于决策过程中的日志记录不足或透明度不足,AI代理执行的操作无法追溯或解释。 | 实施全面的日志记录、加密验证、增强元数据和实 时监控,确保问责和可追溯性。要求AI生成的日志 必须经过加密签名且不可更改, 以满足法规遵从 性。 |

| T9 | 身份欺骗和冒名顶替 Identity Spoofing & Impersonation | 攻击者利用身份验证机制来模拟人工智能 代理或人类用户,使他们能够以虚假的身 份执行未经授权的操作。 | 开发完整的身份验证框架,执行信任边界,并部署 持续监控以检测冒充尝试。使用涉及第二个模型的 行为分析,来检测AI代理活动的偏差,这些偏差可 能表明身份欺骗。 |

| T10 | 环路中的人类影响过大 Overwhelming Human in the Loop | 这种威胁针对的是具有人类监督和决策验 证的系统, 旨在利用人类认知局限或破坏 交互框架。 | 开发高级的人机交互框架和自适应信任 机制。这些动态AI治理模型采用动态干 预阈值,根据风险、信心和情境调整人 类监管与自动化程度。实施分层的人机 协作机制:低风险决策自动化处理,高 风险异常则优先人工介入。 |

| T11 | 意外RCE和代码攻击 Unexpected RCE and Code Attacks | 攻击者利用人工智能生成的执行环境注 入恶意代码,触发意外的系统行为,或 执行未经授权的脚本。 | 限制AI代码生成权限、沙盒执行以及监控AI生成的 脚本。实施执行控制策略,为标记具有提升权限的AI生 成代码进行人工审核。 |

| T12 | 代理通信中毒 Agent Communication Poisoning | 攻击者操纵AI代理之间的通信通道, 以传播虚假信息、破坏工作流程或影响决策。 | 部署加密消息认证,强制执行通信验证策略, 并监控代理间的交互以发现异常。要求多代理 共识验证用于关键任务决策过程。 |

| T13 | 多代理系统中的流氓代理 Rogue Agents in Multi-Agent Systems | 恶意或受损的人工智能代理在正常监控边界 之外运行,执行未经授权的操作或窃取数 据。 | 通过策略约束和持续行为监控来限制AI代理的自主 性。虽然目前尚未存在针对LLM的加密认证机制, 但可以通过受控托管环境、定期AI红队测试以及输 入/输出监控来维护代理的完整性,防止异常情况发 生。 |

| T14 | 对多代理系统的攻击 | 对手利用代理之间的委托、信任关系和工 作流依赖来提升特权或操纵人工智能驱动 的操作。 | 限制代理委派机制,强制执行代理间身份验证,并部署行为监控以检测操纵尝试。强制执行多代理任务分割,以防止攻击者跨相互连接的代理升级特权。 |

| T15 | 人为操纵 Human Manipulation | 在人工智能代理与人类用户直接交互的场景 中,信任关系会降低用户的怀疑心理,增加 对代理响应和自主性的依赖。这种隐性信任 和直接的人机交互会带来风险,攻击者可以 胁迫代理操纵用户、传播虚假信息和采取隐 蔽行动。 | 监视代理行为以确保其符合定义的角色和预期操 作。限制工具访问以最小化攻击面,限制代理打 印链接的能力,实施验证机制以检测和过滤使用 防护栏、审核API或其他模型操纵的响应 |

03 总结

目前,GenAI,AI Agents,Agentic AI代表AI应用发展的三个方向,仍然在持续发展,并非互相取代的关系。

从威胁上看,三个场景的威胁各有各的特点,但也有很多重合的地方。威胁本身也在快速发展,持续跟踪几个关键框架,是准确把握AI应用安全的重要方法。

普通人如何抓住AI大模型的风口?

领取方式在文末

为什么要学习大模型?

目前AI大模型的技术岗位与能力培养随着人工智能技术的迅速发展和应用 , 大模型作为其中的重要组成部分 , 正逐渐成为推动人工智能发展的重要引擎 。大模型以其强大的数据处理和模式识别能力, 广泛应用于自然语言处理 、计算机视觉 、 智能推荐等领域 ,为各行各业带来了革命性的改变和机遇 。

目前,开源人工智能大模型已应用于医疗、政务、法律、汽车、娱乐、金融、互联网、教育、制造业、企业服务等多个场景,其中,应用于金融、企业服务、制造业和法律领域的大模型在本次调研中占比超过 30%。

随着AI大模型技术的迅速发展,相关岗位的需求也日益增加。大模型产业链催生了一批高薪新职业:

人工智能大潮已来,不加入就可能被淘汰。如果你是技术人,尤其是互联网从业者,现在就开始学习AI大模型技术,真的是给你的人生一个重要建议!

最后

只要你真心想学习AI大模型技术,这份精心整理的学习资料我愿意无偿分享给你,但是想学技术去乱搞的人别来找我!

在当前这个人工智能高速发展的时代,AI大模型正在深刻改变各行各业。我国对高水平AI人才的需求也日益增长,真正懂技术、能落地的人才依旧紧缺。我也希望通过这份资料,能够帮助更多有志于AI领域的朋友入门并深入学习。

真诚无偿分享!!!

vx扫描下方二维码即可

加上后会一个个给大家发

大模型全套学习资料展示

自我们与MoPaaS魔泊云合作以来,我们不断打磨课程体系与技术内容,在细节上精益求精,同时在技术层面也新增了许多前沿且实用的内容,力求为大家带来更系统、更实战、更落地的大模型学习体验。

希望这份系统、实用的大模型学习路径,能够帮助你从零入门,进阶到实战,真正掌握AI时代的核心技能!

01 教学内容

-

从零到精通完整闭环:【基础理论 →RAG开发 → Agent设计 → 模型微调与私有化部署调→热门技术】5大模块,内容比传统教材更贴近企业实战!

-

大量真实项目案例: 带你亲自上手搞数据清洗、模型调优这些硬核操作,把课本知识变成真本事!

02适学人群

应届毕业生: 无工作经验但想要系统学习AI大模型技术,期待通过实战项目掌握核心技术。

零基础转型: 非技术背景但关注AI应用场景,计划通过低代码工具实现“AI+行业”跨界。

业务赋能突破瓶颈: 传统开发者(Java/前端等)学习Transformer架构与LangChain框架,向AI全栈工程师转型。

vx扫描下方二维码即可

本教程比较珍贵,仅限大家自行学习,不要传播!更严禁商用!

03 入门到进阶学习路线图

大模型学习路线图,整体分为5个大的阶段:

04 视频和书籍PDF合集

从0到掌握主流大模型技术视频教程(涵盖模型训练、微调、RAG、LangChain、Agent开发等实战方向)

新手必备的大模型学习PDF书单来了!全是硬核知识,帮你少走弯路(不吹牛,真有用)

05 行业报告+白皮书合集

收集70+报告与白皮书,了解行业最新动态!

06 90+份面试题/经验

AI大模型岗位面试经验总结(谁学技术不是为了赚$呢,找个好的岗位很重要)

07 deepseek部署包+技巧大全

由于篇幅有限

只展示部分资料

并且还在持续更新中…

真诚无偿分享!!!

vx扫描下方二维码即可

加上后会一个个给大家发

更多推荐

已为社区贡献61条内容

已为社区贡献61条内容

所有评论(0)