【必收藏】超越提示工程:上下文工程(Context Engineering)重塑大模型应用范式

上下文工程是超越传统提示工程的新兴学科,对LLM信息流进行系统性重构。它将上下文视为结构化集合(C=A(c_instr, c_know, c_tools, c_mem, c_state, c_query)),包含六大核心组件。文章详解了三大基础组件(检索生成、处理、管理)和四大前沿架构(RAG演进、记忆系统、工具集成、多智能体),为构建更强大可靠的AI系统提供了系统性方法论,标志着从"感性"调教到

导读:当全世界的目光还聚焦在“提示工程”的技巧上时,一场更深刻的范式革命——上下文工程(Context Engineering)——已经悄然兴起。这不仅是术语的升级,而是对如何设计、管理和优化大语言模型(LLM)信息流的系统性重构。本文基于对1400多篇前沿论文的系统性综述,将为您揭开这个正在重新定义AI系统架构的新兴学科的神秘面纱。

本文基于下面的论文解读为锚点,加入自己的解读和补充可落地的github。

在使用ClaudeCode解读论文的时候,Context engineering一瞥:

一、从混乱到有序:为什么我们需要上下文工程?

想象一下,如果把LLM比作一位才华横溢的学者,传统的“提示工程”就像是递给他一张写着问题的便条。而“上下文工程”则是为他打造一个完整的智能工作环境——包括一个动态更新的图书馆、一个高效的助理团队、一套连接现实世界的工具,以及一部记录着所有过往交流的备忘录。

随着AI应用的复杂化,我们面临着一系列严峻的挑战,传统的提示工程修修补补已无力应对。上下文工程的出现,正是为了系统性地解决这些问题。

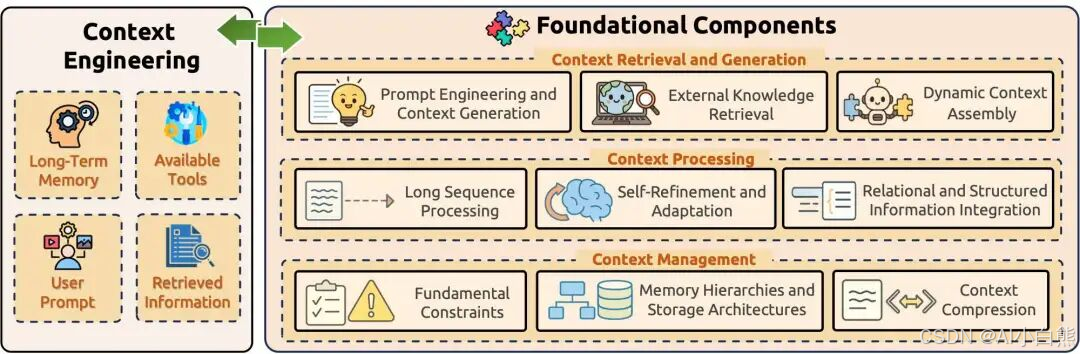

图1:上下文工程的核心框架,展示了从基础组件到系统实现的完整体系。

LLM固有限制的系统性分析

| 限制类型 | 问题表现 | 传统提示工程局限 | 上下文工程突破 |

|---|---|---|---|

| 扩展性问题 | • 自注意力O(n²)复杂度 • 长文档分析能力受限 • 代码库理解困难 | 只能通过缩短输入绕过问题 | • 状态空间模型实现线性扩展 • 分层注意力机制 • 智能分块与重组策略 |

| 成本问题 | • 每token处理成本累积 • 商业应用延迟增加 • 重复上下文处理浪费 | 无法根本解决成本结构问题 | • 上下文复用与缓存 • 动态压缩技术 • 智能信息过滤 |

| 可靠性问题 | • 生成虚假但合理的信息 • 忽略或曲解源材料 • 微小输入变化导致输出剧变 • 语法正确但语义浅薄 | 通过试错改进,缺乏系统性 | • 结构化验证机制 • 多层质量控制 • 鲁棒性工程设计 |

|

上下文工程的数学定义:从“艺术”到“科学”

从数学角度看,上下文工程的核心是从将上下文视为单一字符串(C = prompt)转变为一个动态组装的、结构化的信息集合。这个转变是理解其科学性的第一步。

C = A(c_instr, c_know, c_tools, c_mem, c_state, c_query)

这里的 A 代表一个编排函数(Orchestration Function),它就像一位指挥家,将各种不同来源的信息(c)智能地组合成一段连贯、高效的最终上下文,然后才送入大语言模型。

上下文的六大核心组件

为了更直观地理解这个动态组装过程,我们可以将其想象成一个信息装配流水线。下表详细解释了每个组件的含义和作用,这本身就是一幅结构图:

组件 (c) |

名称 | 描述 | 示例 |

|---|---|---|---|

c_instr |

指令 (Instructions) | 定义模型的核心行为、角色、规则和输出格式。这是模型的“操作手册”。 | “你是一位专业的医疗助手。请使用通俗易懂的语言回答,并始终引用来源。” |

c_know |

知识 (Knowledge) | 通过RAG等技术从外部数据源(如数据库、文档、API)检索到的实时或专业信息。 | 从公司内部知识库检索到的最新产品规格。 |

c_tools |

工具 (Tools) | 模型可以调用的外部API或函数的定义,使其能够与现实世界交互。 | {"name": "get_weather", "description": "获取指定城市的天气", ...} |

c_mem |

记忆 (Memory) | 从过去交互中提取并存储的持久化信息,包括用户偏好、对话历史等。 | “用户上次询问了关于Python的话题,并且偏好简洁的代码示例。” |

c_state |

状态 (State) | 关于用户、世界或多智能体系统当前状态的动态信息。 | “用户当前正在查看购物车页面,购物车中有3件商品。” |

c_query |

查询 (Query) | 用户在当前回合提出的原始、直接的请求。 | “帮我把它翻译成英文” |

这种结构化方法使得上下文不再是一个混沌的信息团,而是一个经过精心设计、每个部分都承载特定功能的高效信息体。基于此,上下文工程的优化目标便浮出水面。

其最终目标是找到一套最优的上下文生成函数 F*,使得模型在所有可能的任务 T 上的期望奖励最大化:

F* = argmax_F E[Reward(P_θ(Y|C_F(τ)), Y*_τ)]

这个公式看起来复杂,但其核心思想很直观:寻找一套最佳的信息准备和组织方法,让AI在资源(如上下文窗口长度 L_max)有限的情况下,面对真实世界的各种复杂任务时,能做出最优质的响应。

让我们用一个类比来逐步拆解它。

🔍 逐步解读:上下文工程的数学本质

想象你是一位大厨,要为各种不同的客人(任务)准备最完美的菜肴(输出)。上下文工程就是要找到那个最佳的“食谱和工具箱组合”。

| 符号 | 通俗含义 | 技术定义 | 厨师类比 |

|---|---|---|---|

| F * | 最优的工具包 | 理想的上下文生成函数集合 | 大厨的完美工具箱和食谱集 |

| argmax_F | 寻找最佳方案 | 在所有可能的F中找到最优的 | 从众多厨具和烹饪方法中选出最佳组合 |

| E[…] | 平均表现 | 数学期望 | 衡量厨师在应对所有可能客人时的平均水平 |

| τ ~ T | 一位随机客人 | 从任务分布中抽样 | 模拟真实世界中遇到的各种点餐需求 |

| C_F(τ) | 准备好的食材包 | 为任务τ生成的上下文 | 根据客人的口味和要求准备的一篮子食材 |

| **P_θ(Y | C_F(τ))** | 做出某道菜的概率 | 给定上下文,模型生成输出Y的概率 |

| Reward(…) | 菜品的评分 | 衡量模型输出质量的函数 | 客人对最终菜品的打分(口味、外观等) |

| ** | C | ≤ L_max** | 食材不能太多 |

这个数学框架将上下文工程从经验性的“艺术”转变为可量化、可优化的“科学”,并引入了更深层次的数学原理。

🔄 三层数学框架的深度剖析

**1. 动态上下文编排 (Dynamic Context Orchestration)**这就像总导演,决定信息如何组织呈现。它通过 Format 函数将原始信息(知识、工具、记忆等)处理成标准格式,再用 Concat 函数将它们拼接成最终的上下文。

2. 信息论最优检索 (Information-Theoretic Optimal Retrieval)当AI需要从海量知识库中检索信息时,它追求的是互信息量最大化。Retrieve* = argmax_Retrieve I(Y*; c_know | c_query)简单来说,就是找到那些“知道了它,就最可能知道答案”的知识。

**3. 贝叶斯上下文推理 (Bayesian Contextual Inference)**这是AI进行“智能猜测”的核心。面对不确定的情况,AI需要推断出最合适的上下文。

🕵️ 侦探破案类比

想象AI是一位侦探,c_query 是案件,它需要找到最可信的证据组合 C 来破案。贝叶斯公式告诉我们:P(C | c_query) ∝ P(c_query | C) · P(C | History)

- 后验概率 P(C | c_query):这个证据组合对破案的帮助有多大?(目标)

- 似然函数 P(c_query | C):如果证据是真的,案件发生的可能性有多大?(匹配度)

- 先验概率 P(C | History):根据过往经验,这个证据组合本身有多可靠?(可靠性)

💡 实际价值

这种方法让AI从“关键词匹配机器”进化为“智能推理助手”。例如,一个智能客服在收到“我的订单怎么还没到?”的查询时:

- 传统方法:匹配“订单”,给出通用的物流查询链接。

- 贝叶斯方法:

- 评估匹配度:问题和“实时物流数据”这个上下文高度匹配。

- 评估可靠性:结合用户历史(先验概率),发现该用户是VIP客户且首次投诉。

- 做出推断:推断出最佳策略不是简单回复,而是“提供详细物流状态,并附上安抚性的补偿方案”。

通过这种方式,上下文工程为构建更智能、更可靠的AI系统提供了坚实的理论基础。

📊 提示工程与上下文工程范式对比表

| 维度 | 提示工程 | 上下文工程 |

|---|---|---|

| 模型 | C = prompt (静态字符串) |

C = A(c₁, c₂, ..., cₙ) (动态结构化组装) |

| 目标 | `argmax_prompt P_θ(Y | prompt)` |

| 复杂度 | 在字符串空间上的手动或自动搜索 | F = {A, Retrieve, Select, ...} 的系统级优化 |

| 信息处理 | 信息内容在提示中固定 | 在约束` |

| 状态管理 | 主要是无状态的 | 本质上有状态,明确包含c_mem和c_state组件 |

| 可扩展性 | 随长度和复杂性增加而脆弱性增强 | 通过模块化组合管理复杂性 |

| 错误分析 | 手动检查和迭代改进 | 对单个上下文函数进行系统性评估和调试 |

注:此表格清晰展示了上下文工程相比传统提示工程在系统性、科学性和可扩展性方面的根本性进步。上下文工程将信息处理从"艺术"提升为"科学",提供了构建复杂AI系统的正式框架。

二、上下文工程的核心:三大基础组件

如同建造一座大厦需要钢筋、水泥和玻璃,构建复杂的AI系统也依赖于三大基础组件。

组件一:上下文检索与生成 (Context Retrieval and Generation)

这是信息流的源头,决定了模型“能看到什么”。

1. 推理框架的进化:从链式思维到图状思维

- 链式思维 (CoT): 将复杂问题分解为中间推理步骤,在MultiArith任务上准确率从17.7%提升到78.7%。

- 树状思维 (ToT): 将推理组织为层次化结构,在"24点游戏"中成功率从4%提升到74%。

- 图状思维 (GoT): 以图结构建模推理,相比ToT质量提升62%,成本降低31%。

2. 外部知识检索:为AI打开通往现实世界的大门

- 检索增强生成 (RAG): 这是对抗模型幻觉、连接实时数据的核心技术。它在模型回答前,先从外部知识库中检索相关信息。

- 高级RAG:如今的RAG已演变为Self-RAG(模型自主决定何时检索并评估质量)、GraphRAG(利用社区检测的层次化索引)和LightRAG(整合图结构和向量表示)等更智能的形态。

组件二:上下文处理 (Context Processing)

获取原始信息后,必须对其进行"精加工",以适应模型的处理能力。

1. 应对超长上下文的挑战

处理超长上下文面临着O(n²)复杂度的挑战。将Mistral-7B的输入从4K增加到128K token需要122倍的计算增长。为了解决这个问题,研究者们开发了多种创新技术:

| 技术类型 | 代表方法 | 关键优势 | 性能提升 |

|---|---|---|---|

| 状态空间模型 | Mamba, LongMamba | 线性复杂度 | 支持百万级token |

| 优化注意力 | FlashAttention, Ring Attention | 内存优化 | 22.2倍速度提升 |

| 智能缓存 | StreamingLLM, H₂O | 动态管理 | 29倍吞吐量提升 |

2. 自我精炼:让AI拥有"反思"能力

| 方法 | 核心特点 | 应用场景 |

|---|---|---|

| Self-Refine | 迭代反馈和精炼周期 | 通用文本改进 |

| Reflexion | 基于经验记忆的反思学习 | 长期任务优化 |

| N-CRITICS | 多评论员集成评估 | 复杂内容审查 |

| Agent-R | 动态反思的语言智能体 | 实时错误纠正 |

📊 长链推理方法详细对比表

| 方法 | 策略 | 效率 | 准确性 | 长度管理 | 可扩展性 |

|---|---|---|---|---|---|

| O1-Pruner | 强化学习微调 | N/A | +准确性,-开销 | 自动剪枝 | +效率 |

| InftyThink | 迭代+摘要 | 复杂度降低 | +3-13% | 迭代控制 | 可扩展 |

| Long-CoT Survey | 长CoT+推理 | +效率框架 | +复杂领域 | 深度探索 | 测试时扩展 |

| PREMISE | 提示优化+诊断 | 梯度启发优化 | 保持/+准确性 | -87.5% tokens | 性能保持 |

| Prune-on-Logic | 结构感知剪枝 | 选择性剪枝 | +准确性 | 选择性框架 | 基于逻辑优化 |

注:O1-Pruner使用强化学习风格的微调来缩短推理链同时保持准确性。InftyThink采用迭代推理与中间摘要来减少计算复杂度。Long-CoT Survey探索通过效率改进和增强知识框架提升推理能力的长思维链特征。PREMISE通过梯度启发优化使用轨迹级诊断优化提示,实现87.5%的token减少。Prune-on-Logic通过选择性移除低效用推理步骤对逻辑图进行结构感知剪枝。

组件三:上下文管理 (Context Management)

上下文窗口是宝贵且有限的资源,如何高效管理是关键。

1. 解决“迷失在中间”的问题研究发现,LLM对位于上下文开头和结尾的信息记忆最深,而中间的信息则容易“失忆”。

- 操作系统级的内存管理 (MemGPT/Letta): 这一革命性方法将LLM的上下文窗口比作计算机的RAM,将外部数据库比作硬盘。它像一个操作系统,智能地在两者之间进行“页面调度”,赋予LLM近乎无限的记忆能力。

- 上下文压缩: ICAE(In-context Autoencoder)能将长上下文压缩成紧凑的“记忆槽”,实现了高达4倍的压缩率,同时还能增强模型的处理能力。

三、从组件到系统:四大前沿架构实现

基础组件如同乐高积木,它们可以组合搭建成功能强大的真实世界系统。

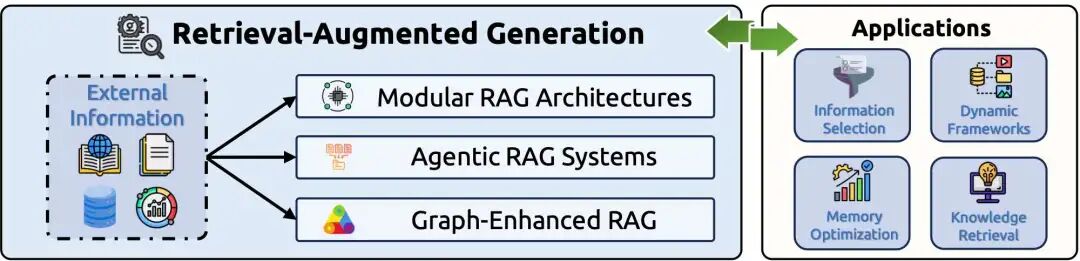

实现一:检索增强生成 (RAG) 的全面演进

RAG已从简单的信息注入器,进化为复杂的智能系统。

RAG演进之路

图2:RAG系统的演进,从模块化到智能体化,再到图增强。

- 模块化RAG: 现代RAG系统采用可插拔的模块设计,开发者可以像搭积木一样组合查询重写、智能路由、结果融合等模块。

- 智能体RAG (Agentic RAG): 将自主AI智能体嵌入RAG流程。智能体主动进行推理、规划、使用工具,甚至在检索失败时进行自我反思和调整。

- 图增强RAG (Graph-Enhanced RAG): 利用知识图谱的结构化优势,检索精确的实体和关系,进行复杂的多跳推理,并极大减少幻觉。

📊 RAG Systems GitHub项目热度排行榜

| 排名 | 项目名称 | GitHub地址 | ⭐ Star数 | 主要特性 | 应用场景 |

|---|---|---|---|---|---|

| 1 | RAGFlow | infiniflow/ragflow | 63.7k | 领先的开源RAG引擎,融合Agent能力 | 企业级智能问答系统 |

| 2 | Langchain-Chatchat | chatchat-space/Langchain-Chatchat | 36k | 基于LangChain的本地知识库RAG | 中文知识问答系统 |

| 3 | LLM-App | pathwaycom/llm-app | 31.5k | 实时RAG管道,企业搜索 | 实时数据处理和搜索 |

| 4 | Microsoft GraphRAG | microsoft/graphrag | 27.9k | 模块化图增强RAG系统 | 知识图谱检索 |

| 5 | STORM | stanford-oval/storm | 27.2k | LLM驱动的知识整理系统 | 研究报告生成 |

| 6 | Haystack | deepset-ai/haystack | 22.1k | AI编排框架,定制化RAG应用 | 语义搜索、问答系统 |

| 7 | RAG Techniques | NirDiamant/RAG_Techniques | 20.6k | 高级RAG技术教程集合 | RAG技术学习与实践 |

| 8 | LightRAG | HKUDS/LightRAG | 20.4k | 简单快速的RAG系统 | 轻量级知识检索 |

| 9 | LLMWare | llmware-ai/llmware | 14.4k | 企业RAG管道框架 | 专业模型部署 |

| 10 | txtai | neuml/txtai | 11.5k | 语义搜索和LLM编排 | 全栈AI应用开发 |

| 11 | FlagEmbedding | FlagOpen/FlagEmbedding | 10.5k | 检索和RAG-LLM嵌入 | 文本嵌入和相似性 |

| 12 | Verba | weaviate/Verba | 7.3k | Weaviate驱动的RAG聊天机器人 | 向量数据库对话 |

| 13 | R2R | SciPhi-AI/R2R | 7.3k | 生产级RAG系统 | 智能体检索增强 |

| 14 | AutoRAG | Marker-Inc-Korea/AutoRAG | 4.3k | 自动化RAG评估与优化 | RAG性能调优 |

| 15 | Cognita | truefoundry/cognita | 4.2k | 模块化RAG应用框架 | 生产级RAG部署 |

🔥 RAG系统发展趋势分析

- 多模态融合:MemVid等项目展示了将视频、音频等多模态数据融入RAG的创新

- 实时处理:LLM-App等强调与Sharepoint、Google Drive等实时数据源集成

- 图增强:LightRAG和GraphRAG引领知识图谱与向量检索的深度结合

- 中文生态:Langchain-Chatchat等项目在中文RAG应用中占据重要地位

- 企业级部署:RAGFlow、Haystack等注重生产环境的稳定性和可扩展性

📊 知识图谱集成方法详细对比表

| 方法 | 方法 | 性能表现 | 关键创新 |

|---|---|---|---|

| ODA | 观察驱动智能体框架 | 12.87%和8.9%提升 | 递归观察与动作反思 |

| RAG-KG | 历史问题知识图谱构建 | 77.6% MRR,0.32 BLEU改进 | 查询解析和子图检索 |

| KARPA | 免训练知识图谱适应 | 知识图谱问答最先进性能 | 预规划关系路径 |

| Faithful Reasoning | 规划-检索-推理框架 | N/A | LLM-KG协同与关系路径 |

注:ODA采用观察驱动智能体框架,通过递归观察和动作反思实现性能提升。RAG-KG通过历史问题知识图谱构建实现查询解析和子图检索。KARPA提供免训练的知识图谱适应方法,通过预规划关系路径达到最先进性能。Faithful Reasoning建立规划-检索-推理框架,实现LLM与知识图谱的协同工作。

📊 结构化数据集成方法详细对比表

| 方法 | 数据类型 | 集成方法 | 关键创新 | 任务范围 |

|---|---|---|---|---|

| K-LAMP | 知识图谱 | 基于检索增强 | KAPING框架 | 零样本问答 |

| Pan et al. | 知识图谱 | 预训练和推理集成 | 协同LLMs + KGs | 多领域推理 |

| StructLM | 表格、图谱、数据库 | 指令调优 | 110万样本数据集 | 18个数据集,8个SKG任务 |

| Shao et al. | 表格、数据库、KGs | 线性化方法 | 模式链接和语法预测 | 文本到SQL任务 |

注:K-LAMP使用KAPING框架实现基于检索的知识图谱增强,专注于零样本问答任务。Pan等人的方法将知识图谱与LLM进行预训练和推理时的深度集成,支持多领域推理。StructLM通过110万样本的大规模指令调优数据集,在18个数据集上进行8种结构化知识生成任务的训练。Shao等人专注于线性化方法,通过模式链接和语法预测优化文本到SQL的转换性能。

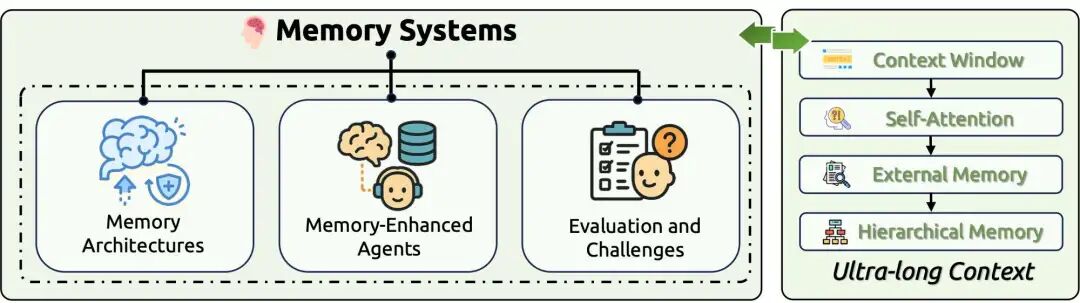

实现二:记忆系统 (Memory Systems):赋予AI持久的认知能力

为了让AI能进行连贯的长时程对话和持续学习,必须为其构建记忆系统。商业AI助手在长时间交互中准确率会下降30%,凸显了记忆系统的重要性。

AI记忆系统

图3:受人类认知科学启发的AI记忆系统层次结构。

Memory Systems GitHub项目热度排行榜

| 排名 | 项目名称 | GitHub地址 | Stars数量 | 主要特点 | 技术创新 |

|---|---|---|---|---|---|

| 🥇 | Mem0 | mem0ai/mem0 | 39.4k | 通用记忆层,支持MCP协议 | 标准化记忆接口 |

| 🥈 | Letta (原MemGPT) | letta-ai/letta | 18.3k | 状态感知智能体平台 | 操作系统级内存管理 |

| 🥉 | AGiXT | Josh-XT/AGiXT | 3.1k | 动态AI智能体自动化平台 | 指令管理与任务执行 |

| 4 | MemOS | MemTensor/MemOS | 2.4k | LLM操作系统,长期记忆 | 记忆调度算法 |

| 5 | Memobase | memodb-io/memobase | 2.1k | 基于档案的长期记忆 | 用户画像演化 |

| 6 | MIRIX | Mirix-AI/MIRIX | 1.4k | 多智能体个人助手 | 屏幕活动追踪 |

| 7 | MemoryOS | BAI-LAB/MemoryOS | 679 | 个性化AI智能体记忆操作系统 | 长期记忆管理 |

| 8 | Memori | GibsonAI/memori | 506 | 开源LLM记忆引擎 | 多智能体系统记忆 |

📊 记忆系统实现模式详细对比表

| 模型 | 完整文本 | 最新文本 | 检索文本 | 外部知识 | 微调 | 编辑 |

|---|---|---|---|---|---|---|

| 核心记忆系统 | ||||||

| MemoryBank | ❌ | ❌ | ✅ | ❌ | ❌ | ❌ |

| RET-LLM | ❌ | ❌ | ✅ | ❌ | ❌ | ❌ |

| ChatDB | ❌ | ❌ | ✅ | ❌ | ❌ | ❌ |

| TiM | ❌ | ❌ | ✅ | ❌ | ❌ | ❌ |

| Voyager | ❌ | ❌ | ✅ | ❌ | ❌ | ❌ |

| MemGPT | ❌ | ✅ | ✅ | ❌ | ❌ | ❌ |

| RecMind | ✅ | ❌ | ❌ | ❌ | ❌ | ❌ |

| Retroformer | ✅ | ❌ | ❌ | ✅ | ✅ | ❌ |

| ExpeL | ✅ | ❌ | ✅ | ✅ | ❌ | ❌ |

| Synapse | ❌ | ❌ | ✅ | ❌ | ❌ | ❌ |

| 智能体系统 | ||||||

| ChatDev | ✅ | ❌ | ❌ | ❌ | ❌ | ❌ |

| InteRecAgent | ❌ | ✅ | ✅ | ✅ | ❌ | ❌ |

| TPTU | ✅ | ❌ | ❌ | ✅ | ❌ | ❌ |

| MetaGPT | ✅ | ❌ | ❌ | ❌ | ❌ | ❌ |

| S³ | ❌ | ❌ | ✅ | ❌ | ❌ | ❌ |

| Mem0 | ❌ | ❌ | ✅ | ❌ | ❌ | ❌ |

| 高级记忆架构 | ||||||

| Larimar | ❌ | ✅ | ✅ | ❌ | ❌ | ✅ |

| EM-LLM | ❌ | ✅ | ✅ | ❌ | ❌ | ❌ |

| Controllable Working Memory | ✅ | ✅ | ✅ | ❌ | ✅ | ❌ |

| Working Memory Hub | ✅ | ✅ | ✅ | ✅ | ❌ | ❌ |

| 新兴系统 | ||||||

| LLM-based Opinion Dynamics | ❌ | ❌ | ✅ | ❌ | ❌ | ❌ |

| Memory Sandbox | ❌ | ❌ | ✅ | ❌ | ❌ | ✅ |

| A-MEM | ❌ | ❌ | ✅ | ❌ | ❌ | ✅ |

| MemEngine | ❌ | ❌ | ✅ | ✅ | ❌ | ❌ |

| HIAGENT | ❌ | ✅ | ✅ | ❌ | ❌ | ❌ |

| MemInsight | ❌ | ❌ | ✅ | ✅ | ❌ | ❌ |

| Memory Sharing (MS) | ❌ | ❌ | ✅ | ✅ | ❌ | ❌ |

| MemoRAG | ✅ | ❌ | ✅ | ✅ | ✅ | ❌ |

| Echo | ✅ | ✅ | ✅ | ✅ | ✅ | ❌ |

注:✅ = 已采用,❌ = 未采用。此表展示了不同记忆系统在文本形式(完整、最新、检索、外部)和参数形式(微调、编辑)实现方式上的差异。

发展趋势洞察

- 标准化趋势:

Mem0的高热度反映了对统一记忆层标准的需求。 - 商业化成功:

Letta(原MemGPT) 展示了从研究到产品的成功路径。 - 系统级创新:

MemOS代表了操作系统级记忆管理的新方向。 - 生态整合: 支持MCP等标准协议成为重要竞争力。

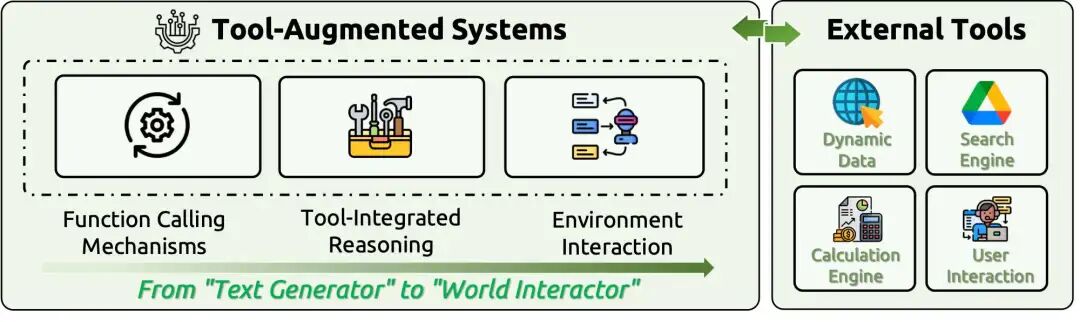

实现三:工具集成推理 (TIR):赋予AI与现实世界交互的“双手”

为了让AI能查询实时天气、预定机票或执行代码,它需要使用工具。

工具集成

图4:工具集成推理框架,使LLM能够调用外部API并与现实世界交互。

- 严峻的现实差距: GAIA基准测试显示,人类在通用助手任务上的准确率为92%,而GPT-4只有15%,凸显了当前工具使用能力的巨大鸿沟。

- ReAct框架: 这是工具使用的核心思想,即“思考-行动-观察”的循环。

- 训练策略的突破: ReTool等框架通过强化学习,仅用400个训练步骤就在AIME2024上达到了67%的准确率。APIGen等数据生成系统能创建覆盖数千个API的高质量训练数据。

📊 Tool-Integrated Reasoning GitHub项目热度排行榜

| 排名 | 项目名称 | GitHub地址 | ⭐ Star数 | 主要特性 | 应用场景 |

|---|---|---|---|---|---|

| 1 | LangChain | langchain-ai/langchain | 115k | 完整工具链生态系统 | 企业级工具集成 |

| 2 | LlamaIndex | run-llama/llama_index | 44.1k | 数据连接器和工具 | 结构化数据查询 |

| 3 | LangGraph | langchain-ai/langgraph | 8.5k | 多步工具推理图 | 复杂工作流编排 |

| 4 | ToolLLaMA | OpenBMB/ToolBench | 5.2k | 工具学习基准 | 工具使用训练 |

| 5 | ReAct | ysymyth/ReAct | 3.8k | 推理行动框架 | 交互式问题解决 |

| 6 | OpenInterpreter | OpenInterpreter/open-interpreter | 55.2k | 本地代码解释器 | 自然语言代码执行 |

| 7 | AgentGPT | reworkd/AgentGPT | 32.2k | 浏览器中的自主AI智能体 | 目标导向任务执行 |

| 8 | AutoGPT | Significant-Gravitas/AutoGPT | 170k | 自主GPT-4实验 | 自动化任务处理 |

| 9 | Semantic Kernel | microsoft/semantic-kernel | 22.8k | Microsoft AI编排SDK | 企业级AI集成 |

| 10 | Instructor | jxnl/instructor | 8.1k | 结构化LLM输出 | 函数调用数据验证 |

| 11 | Marvin | prefecthq/marvin | 5.4k | AI工程库 | 自然语言接口 |

| 12 | GPT Engineer | gpt-engineer-org/gpt-engineer | 52.7k | 代码生成智能体 | 全栈开发自动化 |

| 13 | Phidata | phidatahq/phidata | 15.1k | AI助手框架 | 智能体构建平台 |

| 14 | LangFlow | langflow-ai/langflow | 36.8k | 拖拽式AI应用构建 | 可视化工作流 |

| 15 | Composio | ComposioHQ/composio | 10.5k | AI智能体工具集成平台 | 150+工具集成 |

📊 工具增强语言模型架构对比表

| 方法 | 搜索检索 | 计算代码执行 | 知识库问答 | API外部服务 | 多模态工具 | 语言处理 | 交互环境 | 领域专用工具 |

|---|---|---|---|---|---|---|---|---|

| ReAct | ✅ | ❌ | ✅ | ❌ | ❌ | ❌ | ✅ | ❌ |

| Toolformer | ✅ | ✅ | ✅ | ❌ | ❌ | ✅ | ❌ | ✅ |

| ToolkenGPT | ✅ | ✅ | ✅ | ✅ | ❌ | ❌ | ✅ | ❌ |

| ToolLLM | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ |

| ToRA | ❌ | ✅ | ❌ | ❌ | ❌ | ❌ | ❌ | ❌ |

| PAL | ❌ | ✅ | ❌ | ❌ | ❌ | ❌ | ❌ | ❌ |

| HuggingGPT | ❌ | ❌ | ❌ | ✅ | ✅ | ❌ | ❌ | ❌ |

| GPT4Tools | ❌ | ❌ | ❌ | ❌ | ✅ | ❌ | ❌ | ❌ |

| CRITIC | ✅ | ✅ | ✅ | ❌ | ❌ | ❌ | ❌ | ❌ |

| Chain of Code | ❌ | ✅ | ❌ | ❌ | ❌ | ❌ | ❌ | ❌ |

| TRICE | ✅ | ✅ | ✅ | ❌ | ❌ | ✅ | ❌ | ❌ |

| TP-LLaMA | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ |

| AlignToolLLaMA | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ |

| ReTool | ❌ | ✅ | ❌ | ❌ | ❌ | ❌ | ❌ | ❌ |

| Tool-Star | ✅ | ✅ | ❌ | ❌ | ❌ | ❌ |

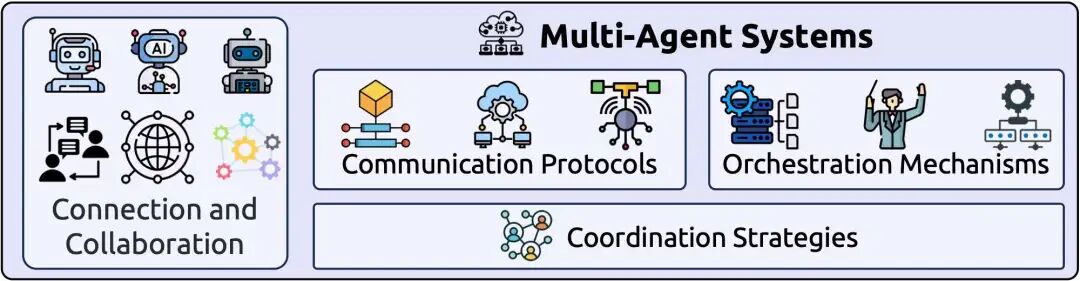

实现四:多智能体系统 (MAS):协作智能的最高形态

如果说单个带工具的AI是一个“超级个体”,那么多智能体系统就是一个“超级团队”。

图5:多智能体系统,其中多个专业化的AI智能体通过标准化协议进行协作。

- 标准化通信协议: 为了让不同来源的智能体能够顺畅协作,社区正在制定统一的通信标准,如MCP(模型上下文协议)(被誉为“AI的USB-C”)、A2A(点对点通信)和ANP(基于去中心化标识符的开放互联网协议)。

- 智能编排: AutoGen和CrewAI等框架允许我们定义不同角色的智能体(如"产品经理"、“程序员”、“测试工程师”),并编排它们的协作流程。

📊 Multi-Agent Systems GitHub项目热度排行榜

| 排名 | 项目名称 | GitHub地址 | ⭐ Star数 | 主要特性 | 应用场景 |

|---|---|---|---|---|---|

| 1 | MetaGPT | geekan/MetaGPT | 58.3k | 软件公司级多智能体协作 | 代码生成和项目管理 |

| 2 | CrewAI | crewAIInc/crewAI | 37.7k | 角色扮演协作框架 | 业务流程自动化 |

| 3 | OpenAI Swarm | openai/swarm | 20.4k | 轻量级多智能体协调 | 实验性智能体编排 |

| 4 | TaskWeaver | microsoft/TaskWeaver | 15.2k | 代码优先智能体框架 | 数据分析和插件系统 |

| 5 | AutoGen | microsoft/autogen | 14.8k | 多智能体对话框架 | 协作式问题解决 |

| 6 | ChatDev | OpenBMB/ChatDev | 12.3k | 虚拟软件公司 | 软件开发全流程 |

| 7 | Camel-AI | camel-ai/camel | 8.7k | 大规模智能体模拟 | 社会模拟和研究 |

| 8 | LangGraph | langchain-ai/langgraph | 8.5k | 图状态智能体工作流 | 复杂工作流编排 |

| 9 | XAgent | OpenBMB/XAgent | 8.2k | 自主智能体,工具使用 | 复杂任务自动化 |

| 10 | Multi-Agent-GPT | rumpfmax/Multi-Agent-GPT | 5.8k | 多智能体协作系统 | 团队决策和协作 |

| 11 | BabyAGI | yoheinakajima/babyagi | 21.2k | 任务驱动自主智能体 | 目标导向任务执行 |

| 12 | Agents | aiwaves-cn/agents | 3.1k | 开源智能体平台 | 多模态智能体构建 |

| 13 | AG2 | ag2ai/ag2 | 3.5k | AutoGen社区版 | 智能体操作系统 |

| 14 | AgentVerse | OpenBMB/AgentVerse | 3.9k | 多智能体环境框架 | 智能体社会模拟 |

| 15 | Composio | ComposioHQ/composio | 10.5k | 智能体工具集成平台 | 150+工具和API集成 |

🚀 多智能体系统发展趋势洞察

- 生态系统成熟度:MetaGPT和CrewAI的高星数反映了产业级多智能体需求爆发

- 标准化进程:OpenAI Swarm代表了大厂对轻量级协调标准的探索

- 图状态管理:LangGraph展示了基于图的智能体状态管理新方向

- 开放治理:AG2从Microsoft分离展示了开源多智能体项目的治理创新

四、评估的挑战与未来展望

我们如何衡量这些复杂系统的性能?传统的NLP指标(如BLEU)已然失效。我们需要全新的、多维度的评估体系。

新一代评估基准

| 基准测试 | 评估对象 | 关键发现 |

|---|---|---|

| WebArena | 网页浏览智能体 | 最好的系统(IBM CUGA)也只有61.7%的任务成功率。 |

| GAIA | 通用AI助手 | 人类准确率92%,GPT-4只有15%,差距悬殊。 |

| LongMemEval | 记忆系统 | 揭示了商业AI助手在长对话中30%的准确率下降。 |

| BFCL | 函数调用 | 推动了对多轮、复杂工具使用的标准化评估。 |

📊 WebArena基准测试排行榜详细对比

| 发布日期 | 开源状态 | 方法/模型 | 成功率(%) | 来源 |

|---|---|---|---|---|

| 2025-02 | ❌ | IBM CUGA | 61.7 | 领先的企业级解决方案 |

| 2025-01 | ❌ | OpenAI Operator | 58.1 | OpenAI官方网页操作智能体 |

| 2024-08 | ❌ | Jace.AI | 57.1 | 商业化网页自动化平台 |

| 2024-12 | ❌ | ScribeAgent + GPT-4o | 53.0 | 结合多模态能力的写作智能体 |

| 2025-01 | ✅ | AgentSymbiotic | 52.1 | 开源协作智能体框架 |

| 2025-01 | ✅ | Learn-by-Interact | 48.0 | 交互式学习智能体 |

| 2024-10 | ✅ | AgentOccam-Judge | 45.7 | 基于判断的简化智能体 |

| 2024-08 | ❌ | WebPilot | 37.2 | 网页导航专用智能体 |

| 2024-10 | ✅ | GUI-API Hybrid Agent | 35.8 | 图形界面与API混合方案 |

| 2024-09 | ✅ | Agent Workflow Memory | 35.5 | 工作流记忆增强智能体 |

| 2024-04 | ✅ | SteP | 33.5 | 步骤感知推理智能体 |

| 2025-06 | ✅ | TTI | 26.1 | 思考-然后-实施框架 |

| 2024-04 | ✅ | BrowserGym + GPT-4 | 23.5 | 基于强化学习的浏览器操作 |

注:WebArena是评估网页智能体在真实网站上执行复杂任务能力的基准测试。即使是最佳系统的成功率也只有61.7%,显示了网页自动化任务的巨大挑战。开源方案中AgentSymbiotic表现最佳,达到52.1%的成功率。

🔍 WebArena评估挑战分析

关键发现:

- 人机差距巨大:人类在类似任务上的成功率接近95%,而最好的AI系统仅达61.7%

- 开源vs闭源:开源系统最高52.1%,与闭源系统仍有显著差距

- 复杂度影响:涉及多步骤操作和上下文理解的任务成功率显著下降

- 可靠性问题:系统在处理动态网页内容和异常情况时表现不稳定

未来方向:机遇与挑战并存

- 统一理论的探寻:我们需要一个能解释所有上下文工程技术的底层理论,如信息论和计算复杂性理论,将“术”提升为“道”。

- 高级推理与多模态融合:AI需要从简单的信息检索,进化到能进行因果、反事实和时序推理,并无缝融合文本、图像、音频等多种信息。

- 安全、可靠与对齐:随着智能体越来越自主,如何确保其行为安全、可控,并始终与人类价值观对齐,是未来十年最核心的挑战。

结论:一个新学科的黎明

上下文工程不仅仅是提示工程的延伸,它是一个全新的、独立的工程学科。它为我们提供了一套系统性的方法论,用以构建更强大、更可靠、更智能的AI系统。它将我们从对LLM的“感性”调教,带入了“理性”设计的时代。

普通人如何抓住AI大模型的风口?

领取方式在文末

为什么要学习大模型?

目前AI大模型的技术岗位与能力培养随着人工智能技术的迅速发展和应用 , 大模型作为其中的重要组成部分 , 正逐渐成为推动人工智能发展的重要引擎 。大模型以其强大的数据处理和模式识别能力, 广泛应用于自然语言处理 、计算机视觉 、 智能推荐等领域 ,为各行各业带来了革命性的改变和机遇 。

目前,开源人工智能大模型已应用于医疗、政务、法律、汽车、娱乐、金融、互联网、教育、制造业、企业服务等多个场景,其中,应用于金融、企业服务、制造业和法律领域的大模型在本次调研中占比超过 30%。

随着AI大模型技术的迅速发展,相关岗位的需求也日益增加。大模型产业链催生了一批高薪新职业:

人工智能大潮已来,不加入就可能被淘汰。如果你是技术人,尤其是互联网从业者,现在就开始学习AI大模型技术,真的是给你的人生一个重要建议!

最后

只要你真心想学习AI大模型技术,这份精心整理的学习资料我愿意无偿分享给你,但是想学技术去乱搞的人别来找我!

在当前这个人工智能高速发展的时代,AI大模型正在深刻改变各行各业。我国对高水平AI人才的需求也日益增长,真正懂技术、能落地的人才依旧紧缺。我也希望通过这份资料,能够帮助更多有志于AI领域的朋友入门并深入学习。

真诚无偿分享!!!

vx扫描下方二维码即可

加上后会一个个给大家发

大模型全套学习资料展示

自我们与MoPaaS魔泊云合作以来,我们不断打磨课程体系与技术内容,在细节上精益求精,同时在技术层面也新增了许多前沿且实用的内容,力求为大家带来更系统、更实战、更落地的大模型学习体验。

希望这份系统、实用的大模型学习路径,能够帮助你从零入门,进阶到实战,真正掌握AI时代的核心技能!

01 教学内容

-

从零到精通完整闭环:【基础理论 →RAG开发 → Agent设计 → 模型微调与私有化部署调→热门技术】5大模块,内容比传统教材更贴近企业实战!

-

大量真实项目案例: 带你亲自上手搞数据清洗、模型调优这些硬核操作,把课本知识变成真本事!

02适学人群

应届毕业生: 无工作经验但想要系统学习AI大模型技术,期待通过实战项目掌握核心技术。

零基础转型: 非技术背景但关注AI应用场景,计划通过低代码工具实现“AI+行业”跨界。

业务赋能突破瓶颈: 传统开发者(Java/前端等)学习Transformer架构与LangChain框架,向AI全栈工程师转型。

vx扫描下方二维码即可

本教程比较珍贵,仅限大家自行学习,不要传播!更严禁商用!

03 入门到进阶学习路线图

大模型学习路线图,整体分为5个大的阶段:

04 视频和书籍PDF合集

从0到掌握主流大模型技术视频教程(涵盖模型训练、微调、RAG、LangChain、Agent开发等实战方向)

新手必备的大模型学习PDF书单来了!全是硬核知识,帮你少走弯路(不吹牛,真有用)

05 行业报告+白皮书合集

收集70+报告与白皮书,了解行业最新动态!

06 90+份面试题/经验

AI大模型岗位面试经验总结(谁学技术不是为了赚$呢,找个好的岗位很重要)

07 deepseek部署包+技巧大全

由于篇幅有限

只展示部分资料

并且还在持续更新中…

真诚无偿分享!!!

vx扫描下方二维码即可

加上后会一个个给大家发

更多推荐

已为社区贡献63条内容

已为社区贡献63条内容

所有评论(0)