机器人快速适应新任务的元强化学习技术

强化学习是一种人工智能代理与环境交互并根据获得的奖励学习策略的技术。虽然强化学习在Atari等游戏中已展现人类水平的表现,但将其应用于现实场景(如装配线机器人或助老机器人)仍面临两大挑战:首先,机器人结构复杂且脆弱,随机动作可能导致损坏;其次,实际运行环境往往与训练环境存在差异。在《国际学习表征会议》上发表的一篇论文中,研究人员提出名为MQL的元强化学习算法,该算法能使AI代理快速适应熟悉任务的新

机器人快速适应新任务的新方法

强化学习是一种人工智能代理与环境交互并根据获得的奖励学习策略的技术。虽然强化学习在Atari等游戏中已展现人类水平的表现,但将其应用于现实场景(如装配线机器人或助老机器人)仍面临两大挑战:首先,机器人结构复杂且脆弱,随机动作可能导致损坏;其次,实际运行环境往往与训练环境存在差异。

在《国际学习表征会议》上发表的一篇论文中,研究人员提出名为MQL的元强化学习算法,该算法能使AI代理快速适应熟悉任务的新变体。

学会学习

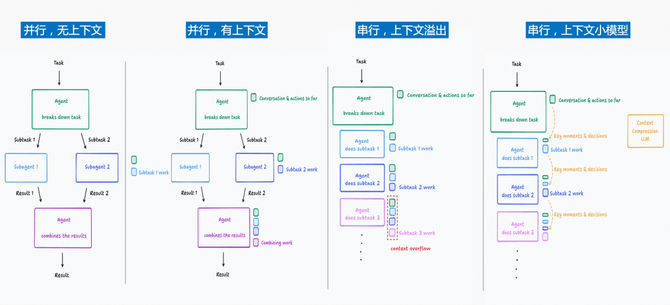

MQL与其他元学习算法类似,通过在大量相关任务上训练代理,测试其学习任务新变体的能力。该算法的两大核心创新包括:

- 任务特定情境变量:训练过程中,代理学习计算每个任务特有的情境变量,从而为不同任务建立独立模型(例如抓取咖啡杯与足球的动作模型截然不同)

- 倾向性估计技术:测试阶段通过统计方法从训练数据中筛选与新任务相似的过往交互记录,以最少交互实现快速适应

数据复用机制

以抓取物体的机器人为例,传统强化学习需通过反复试错学习通用策略。而MQL通过门控循环单元神经网络创建任务表征,使系统能基于情境预测新任务的处理模型。此外,倾向性评分可评估样本来源分布,帮助模型从相关训练数据中采样(如抓取水瓶更接近抓取马克杯而非足球),有效提升适应效率。

该团队在2019年《人工智能不确定性会议》上发表的P3O算法也应用了倾向性估计技术,显著降低了强化学习算法的训练样本需求。随着AI应用场景的扩大,MQL这类技术能够利用现有数据加速新任务学习,大幅降低训练成本。

图片来源:Stacy Reilly

更多精彩内容 请关注我的个人公众号 公众号(办公AI智能小助手)或者 我的个人博客 https://blog.qife122.com/

公众号二维码

更多推荐

已为社区贡献29条内容

已为社区贡献29条内容

所有评论(0)