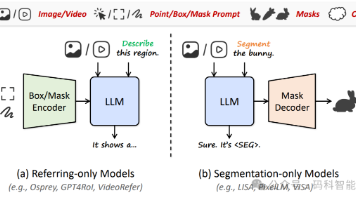

RAG+Agent人工智能平台:RAGflow实现GraphRA知识库问答,打造极致多模态问答与AI编排流体验

RAGflow是一个全面优化的检索增强生成工作流系统,支持多种文件处理和大模型配置。它提供可视化文本切片、多路召回、答案溯源等功能,强调可控性和可解释性。系统部署要求CPU≥4核、内存≥16GB、磁盘≥50GB,并需配置Docker环境。启动时需调整Linux内核参数vm.max_map_count至262144以上,通过Docker Compose启动服务。若遇到资源不足或索引构建问题,可修改内

1.RAGflow简介

-

- 全面优化的 RAG 工作流可以支持从个人应用乃至超大型企业的各类生态系统。

- 大语言模型 LLM 以及向量模型均支持配置。

- 基于多路召回、融合重排序。

- 提供易用的 API,可以轻松集成到各类企业系统。

- 支持丰富的文件类型,包括 Word 文档、PPT、excel 表格、txt 文件、图片、PDF、影印件、复印件、结构化数据、网页等。

- 文本切片过程可视化,支持手动调整。

- 有理有据:答案提供关键引用的快照并支持追根溯源。

- 不仅仅是智能,更重要的是可控可解释。

- 多种文本模板可供选择

- 基于深度文档理解,能够从各类复杂格式的非结构化数据中提取真知灼见。

- 真正在无限上下文(token)的场景下快速完成大海捞针测试。

- “Quality in, quality out”

- 基于模板的文本切片

- 有理有据、最大程度降低幻觉(hallucination)

- 兼容各类异构数据源

- 自动化的 RAG 工作流

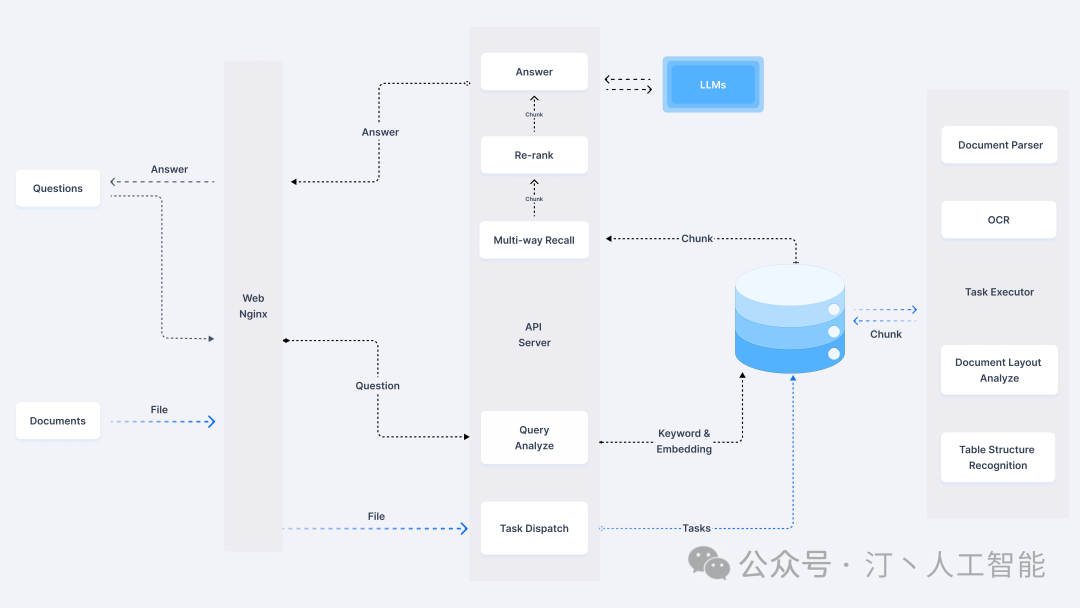

- 系统架构

👉[CSDN大礼包🎁:全网最全《LLM大模型入门+进阶学习资源包》免费分享(安全链接,放心点击)]()👈

2.快速开始

-

环节要求

-

-

CPU >= 4 核

-

RAM >= 16 GB

-

Disk >= 50 GB

-

Docker >= 24.0.0 & Docker Compose >= v2.26.1

如果你并没有在本机安装 Docker(Windows、Mac,或者 Linux), 可以参考文档 Install Docker Engine 自行安装。

-

2.1 启动服务器

vm.max_map_count是Linux内核中的一个重要参数,它定义了一个进程可以拥有的最大内存映射区域数。内存映射区域通常指的是内存映射文件、匿名内存映射等。

-

性能优化:通过增加vm.max_map_count的值,可以允许应用程序创建更多的内存映射区域,从而提高性能和效率。特别是对于需要频繁访问大量文件或数据的应用程序,这种优化效果尤为明显。 -

稳定性保障:如果应用程序尝试创建的内存映射区域数超过了系统设置的限制,可能会导致映射失败,进而引发性能问题或直接导致应用程序崩溃。因此,合理设置vm.max_map_count参数有助于保障系统的稳定性。 -

设置方法

-

临时设置:可以通过sysctl命令临时修改vm.max_map_count的值,但这种更改在系统重启后会失效。例如,要将vm.max_map_count的值设置为262144,可以执行sudo sysctl -w vm.max_map_count=262144命令。永久设置:为了确保在系统重启后vm.max_map_count的值仍然有效,需要将该值写入到/etc/sysctl.conf文件中。添加或更新vm.max_map_count=262144(或其他所需的数值)到该文件中,并保存更改。之后,可以通过执行sudo sysctl -p命令使更改立即生效。

-

确保

vm.max_map_count不小于 262144:如需确认

vm.max_map_count的大小:$ sysctl vm.max_map_count如果

vm.max_map_count的值小于 262144,可以进行重置:# 这里我们设为 262144: $ sudo sysctl -w vm.max_map_count=262144你的改动会在下次系统重启时被重置。如果希望做永久改动,还需要在 /etc/sysctl.conf 文件里把

vm.max_map_count的值再相应更新一遍:vm.max_map_count=262144 -

克隆仓库:

$ git clone https://github.com/infiniflow/ragflow.git -

进入 docker 文件夹,利用提前编译好的 Docker 镜像启动服务器:

$ cd ragflow/docker $ chmod +x ./entrypoint.sh $ docker compose -f docker-compose-CN.yml up -d请注意,运行上述命令会自动下载 RAGFlow 的开发版本 docker 镜像。如果你想下载并运行特定版本的 docker 镜像,请在 docker/.env 文件中找到 RAGFLOW_VERSION 变量,将其改为对应版本。例如 RAGFLOW_VERSION=v0.11.0,然后运行上述命令。

核心镜像文件大约 9 GB,可能需要一定时间拉取。请耐心等待。

镜像拉在太慢的化参考链接:镜像拉去提速

-

服务器启动成功后再次确认服务器状态:

$ docker logs -f ragflow-server出现以下界面提示说明服务器启动成功:

如果您跳过这一步系统确认步骤就登录 RAGFlow,你的浏览器有可能会提示

network abnormal或网络异常,因为 RAGFlow 可能并未完全启动成功。

-

在你的浏览器中输入你的服务器对应的 IP 地址并登录 RAGFlow。

上面这个例子中,您只需输入 http://IP_OF_YOUR_MACHINE 即可:未改动过配置则无需输入端口(默认的 HTTP 服务端口 80)。

-

在 service_conf.yaml 文件的

user_default_llm栏配置 LLM factory,并在API_KEY栏填写和你选择的大模型相对应的 API key。详见 llm_api_key_setup。

部署遇到问题解决(🔺)

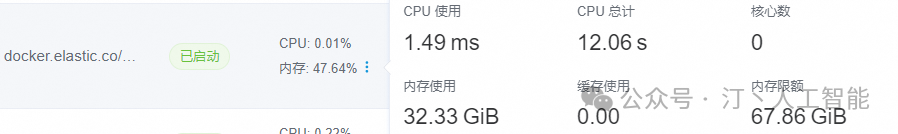

资源不足问题,ES会占用较多资源建议设置大一些

修改.env文件,根据自己内存资源进行设置,我就设置了70G,es默认吃一半

#Increase or decrease based on the available host memory (in bytes)

MEM_LIMIT=72864896288

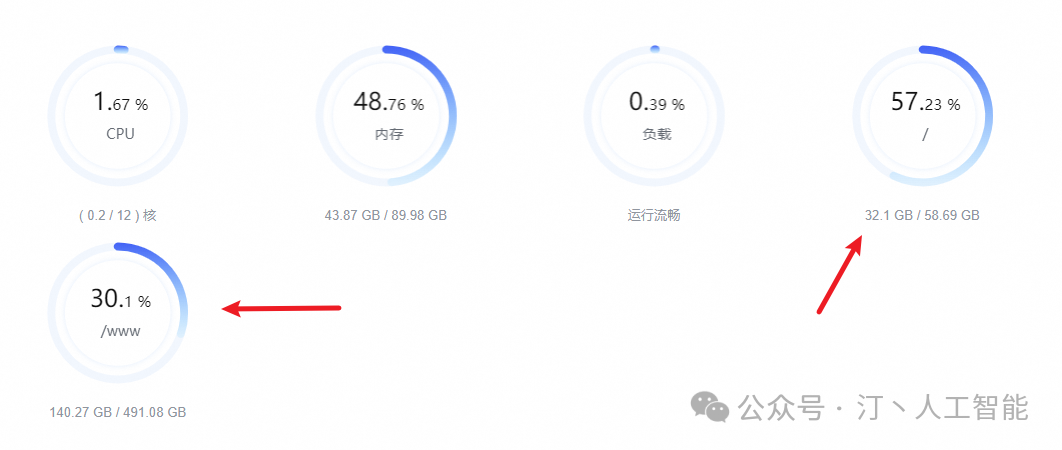

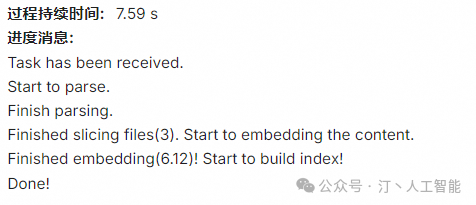

遇到知识库构建,索引构建卡住无法解析

问题描述:索引构建过程一直卡着,经过排查发现是系统盘空间不够95%+了,报错如下

ApiError('search_phase_execution_exception', meta=ApiResponseMeta(status=503, http_version='1.1', headers={'X-elastic-product': 'Elasticsearch', 'content-type': 'application/vnd.elasticsearch+json;compatible-with=8', 'content-length': '365'}, duration=0.004369974136352539, node=NodeConfig(scheme='http', host='es01', port=9200, path_prefix='', headers={'user-agent': 'elasticsearch-py/8.12.1 (Python/3.11.0; elastic-transport/8.12.0)'}, connections_per_node=10, request_timeout=10.0, http_compress=False, verify_certs=True, ca_certs=None, client_cert=None, client_key=None, ssl_assert_hostname=None, ssl_assert_fingerprint=None, ssl_version=None, ssl_context=None, ssl_show_warn=True, _extras={})), body={'error': {'root_cause': [{'type': 'no_shard_available_action_exception', 'reason': None}], 'type': 'search_phase_execution_exception', 'reason': 'all shards failed', 'phase': 'query', 'grouped': True, 'failed_shards': [{'shard': 0, 'index': 'ragflow_304817a205d211efa4de0242ac160005', 'node': None, 'reason': {'type': 'no_shard_available_action_exception', 'reason': None}}]}, 'status': 503})

- 如果系统盘空间不够,请对docker迁移

修改Docker默认存储路径参考

迁移后问题解决:

不得不说,ragflow的文档解析能力还挺强的

2.2 系统配置

系统配置涉及以下三份文件:

- .env:存放一些基本的系统环境变量,比如

SVR_HTTP_PORT、MYSQL_PASSWORD、MINIO_PASSWORD等。 - service_conf.yaml:配置各类后台服务。

- docker-compose-CN.yml: 系统依赖该文件完成启动。

请务必确保 .env 文件中的变量设置与 service_conf.yaml 文件中的配置保持一致!

./docker/README 文件提供了环境变量设置和服务配置的详细信息。请一定要确保 ./docker/README 文件当中列出来的环境变量的值与 service_conf.yaml 文件当中的系统配置保持一致。

如需更新默认的 HTTP 服务端口(80), 可以在 docker-compose-CN.yml 文件中将配置 80:80 改为 :80。

所有系统配置都需要通过系统重启生效:

$ docker compose -f docker-compose-CN.yml up -d

2.3 源码编译、安装 Docker 镜像

如需从源码安装 Docker 镜像:

2.4 源码启动服务

如需从源码启动服务,请参考以下步骤:

- 克隆仓库

$ git clone https://github.com/infiniflow/ragflow.git

$ cd ragflow/

- 创建虚拟环境(确保已安装 Anaconda 或 Miniconda)

$ conda create -n ragflow python=3.11.0

$ conda activate ragflow

$ pip install -r requirements.txt

如果 cuda > 12.0,需额外执行以下命令:

$ pip uninstall -y onnxruntime-gpu

$ pip install onnxruntime-gpu --extra-index-url https://aiinfra.pkgs.visualstudio.com/PublicPackages/_packaging/onnxruntime-cuda-12/pypi/simple/

- 拷贝入口脚本并配置环境变量

$ cp docker/entrypoint.sh .

$ vi entrypoint.sh

使用以下命令获取python路径及ragflow项目路径:

$ which python

$ pwd

将上述 which python 的输出作为 PY 的值,将 pwd 的输出作为 PYTHONPATH 的值。

LD_LIBRARY_PATH 如果环境已经配置好,可以注释掉。

- 启动基础服务

$ cd docker

$ docker compose -f docker-compose-base.yml up -d

- 检查配置文件 确保docker/.env中的配置与conf/service_conf.yaml中配置一致, service_conf.yaml中相关服务的IP地址与端口应该改成本机IP地址及容器映射出来的端口。

- 启动服务

$ chmod +x ./entrypoint.sh

$ bash ./entrypoint.sh

- 启动WebUI服务

- 部署WebUI服务

3. 案例快速实践

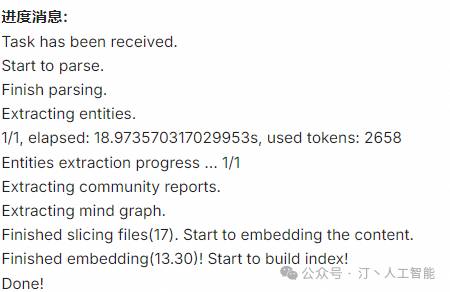

3.1 模型接入

- 商业模型接入:

参考链接:国内大模型LLM选择以及主流大模型快速使用教程

- ollama接入

参考链接:Ollama简化流程,OpenLLM灵活部署,LocalAI本地优化

- xinference 接入

Xinference实战指南

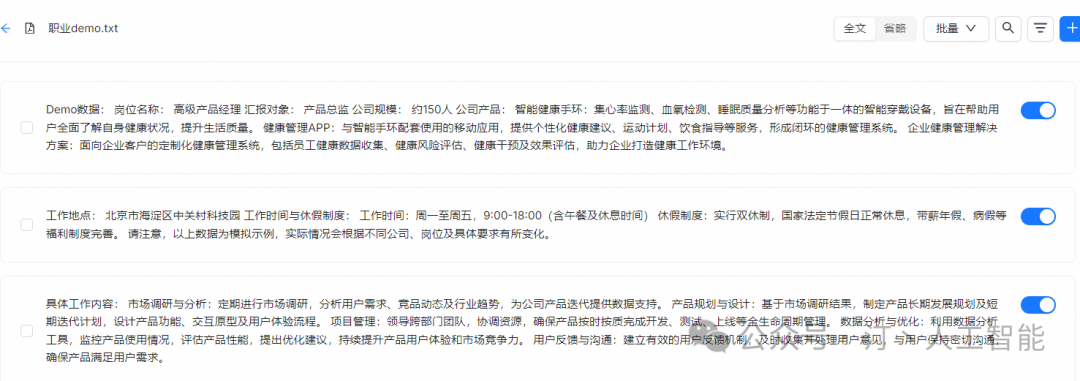

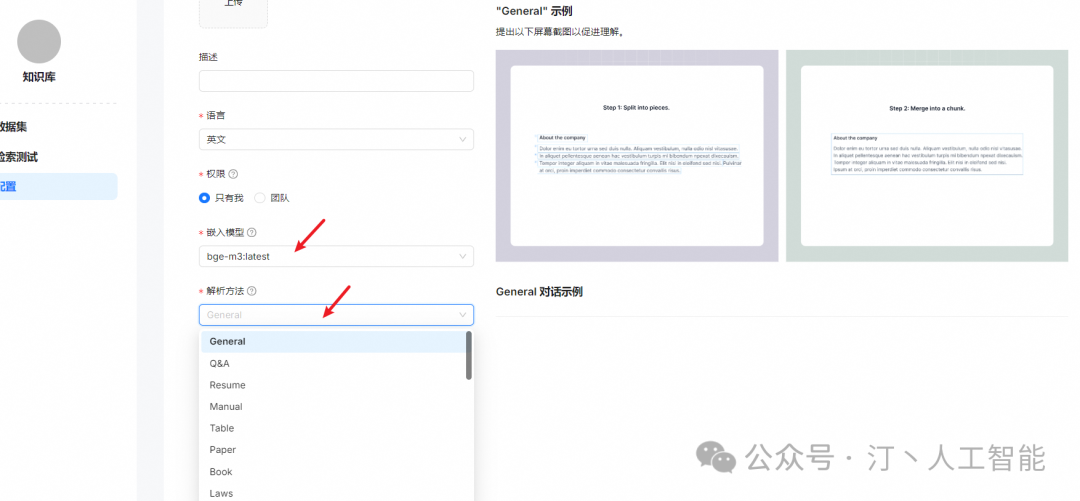

3.0 知识库构建

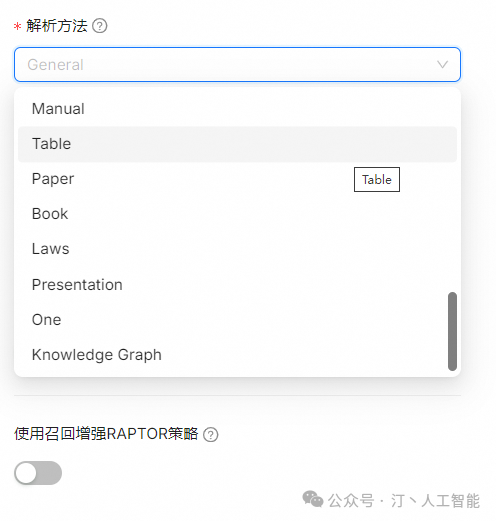

| Template | Description | File format |

|---|---|---|

| General | Files are consecutively chunked based on a preset chunk token number. | DOCX, EXCEL, PPT, PDF, TXT, JPEG, JPG, PNG, TIF, GIF |

| Q&A | EXCEL, CSV/TXT | |

| Manual | ||

| Table | EXCEL, CSV/TXT | |

| Paper | ||

| Book | DOCX, PDF, TXT | |

| Laws | DOCX, PDF, TXT | |

| Presentation | PDF, PPTX | |

| Picture | JPEG, JPG, PNG, TIF, GIF | |

| One | The entire document is chunked as one. | DOCX, EXCEL, PDF, TXT |

| Knowledge Graph | DOCX、EXCEL、PPT、IMAGE、PDF、TXT、MD、JSON、EML |

- “General” 分块方法说明 支持的文件格式为DOCX、EXCEL、PPT、IMAGE、PDF、TXT、MD、JSON、EML、HTML。

此方法将简单的方法应用于块文件:

系统将使用视觉检测模型将连续文本分割成多个片段。接下来,这些连续的片段被合并成Token数不超过“Token数”的块。

- “Q&A” 分块方法说明 此块方法支持 excel 和 csv/txt 文件格式。

如果文件以 excel 格式,则应由两个列组成 没有标题:一个提出问题,另一个用于答案, 答案列之前的问题列。多张纸是 只要列正确结构,就可以接受。如果文件以 csv/txt 格式为 用作分开问题和答案的定界符。未能遵循上述规则的文本行将被忽略,并且 每个问答对将被认为是一个独特的部分。

- “Knowledge Graph” 分块方法说明 支持的文件格式为DOCX、EXCEL、PPT、IMAGE、PDF、TXT、MD、JSON、EML

文件分块后,使用分块提取整个文档的知识图谱和思维导图。此方法将简单的方法应用于分块文件:连续的文本将被切成大约 512 个 token 数的块。

接下来,将分块传输到 LLM 以提取知识图谱和思维导图的节点和关系。

-

支持embedding model

-

- BAAI/bge-large-zh-v1.5

- BAAI/bge-base-en-v1.5

- BAAI/bge-large-en-v1.5

- BAAI/bge-small-en-v1.5

- BAAI/bge-small-zh-v1.5

- jinaai/jina-embeddings-v2-base-en

- jinaai/jina-embeddings-v2-small-en

- nomic-ai/nomic-embed-text-v1.5

- sentence-transformers/all-MiniLM-L6-v2

- maidalun1020/bce-embedding-base_v1

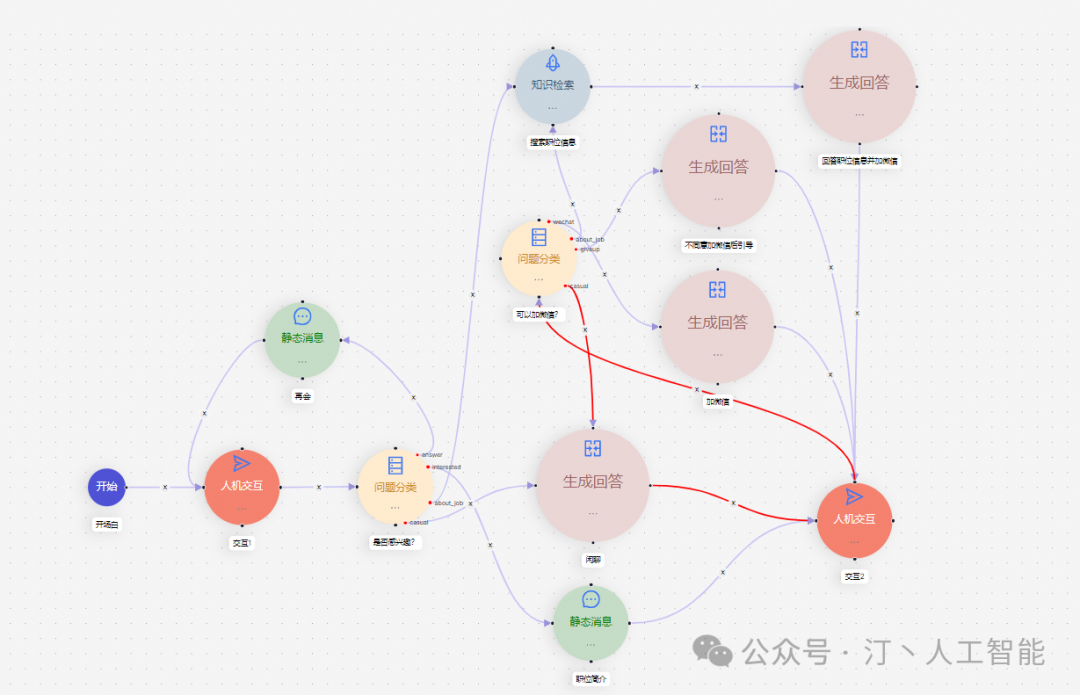

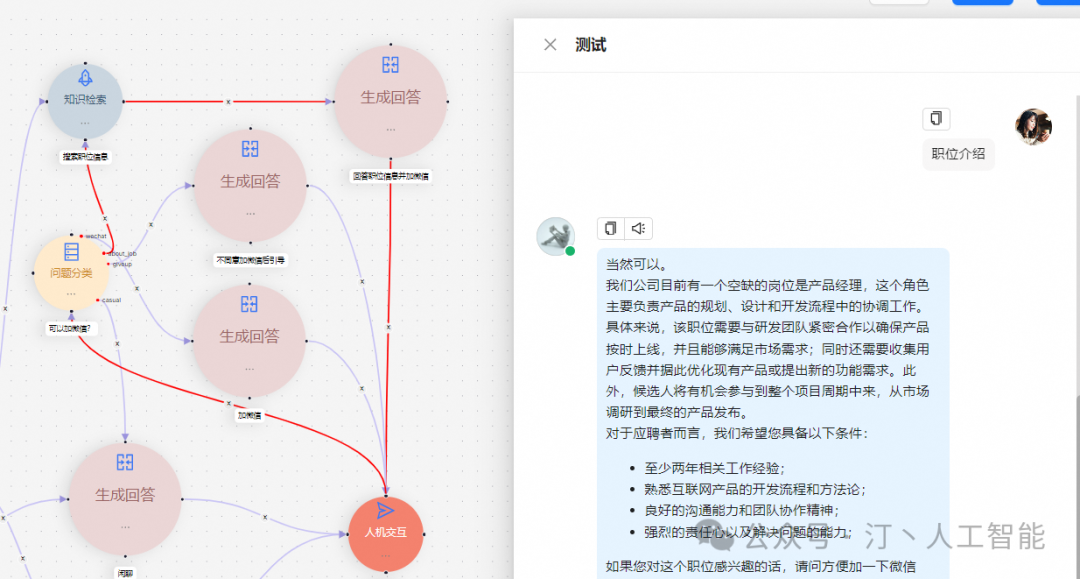

智能问答 & AI 编排流

Agent模块—>模板选择—>HR招聘助手

- 技术文档

- Quickstart

- User guide

- References

- FAQ

AI产品经理,0基础小白入门指南

作为一个零基础小白,如何做到真正的入局AI产品?

什么才叫真正的入局?

是否懂 AI、是否懂产品经理,是否具备利用大模型去开发应用能力,是否能够对大模型进行调优,将会是决定自己职业前景的重要参数。

你是否遇到这些问题:

1、传统产品经理

- 不懂Al无法对AI产品做出判断,和技术沟通丧失话语权

- 不了解 AI产品经理的工作流程、重点

2、互联网业务负责人/运营

- 对AI焦虑,又不知道怎么落地到业务中想做定制化AI产品并落地创收缺乏实战指导

3、大学生/小白

- 就业难,不懂技术不知如何从事AI产品经理想要进入AI赛道,缺乏职业发展规划,感觉遥不可及

为了帮助开发者打破壁垒,快速了解AI产品经理核心技术原理,学习相关AI产品经理,及大模型技术。从原理出发真正入局AI产品经理。

这里整理了一些AI产品经理学习资料包给大家

📖AI产品经理经典面试八股文

📖大模型RAG经验面试题

📖大模型LLMS面试宝典

📖大模型典型示范应用案例集99个

📖AI产品经理入门书籍

📖生成式AI商业落地白皮书

学习路线

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

🔥作为AI产品经理,不仅要懂行业发展方向,也要懂AI技术,可以帮助大家:

✅深入了解大语言模型商业应用,快速掌握AI产品技能

✅掌握AI算法原理与未来趋势,提升多模态AI领域工作能力

✅实战案例与技巧分享,避免产品开发弯路

这份《AI产品经理学习资料包》已经上传CSDN,还有完整版的大模型 AI 学习资料,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

资料包: 完整版本链接获取

👉[CSDN大礼包🎁:《

AI产品经理学习资料包》免费分享(安全链接,放心点击)]👈

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)