中国语音客服的发展现状与未来趋势研究

在生成式AI、大模型与声音克隆技术叠加推动下,中国语音客服正从“成本替代”走向“体验增值”。2024年国内智能客服市场规模已达90.7亿元,其中语音客服占比约30%,增长率22.6%,但用户“被迫转人工”比例仍超80%。本文基于2024-2025年最新行业数据,对语音客服的技术演进、市场格局、应用场景及未来趋势进行系统分析,提出“大模型+声音克隆+多模态”将重塑语音客服价值链的判断,并给出政策与产

目录

摘要

在生成式AI、大模型与声音克隆技术叠加推动下,中国语音客服正从“成本替代”走向“体验增值”。2024年国内智能客服市场规模已达90.7亿元,其中语音客服占比约30%,增长率22.6%,但用户“被迫转人工”比例仍超80%。本文基于2024-2025年最新行业数据,对语音客服的技术演进、市场格局、应用场景及未来趋势进行系统分析,提出“大模型+声音克隆+多模态”将重塑语音客服价值链的判断,并给出政策与产业建议。

关键词:语音客服;大模型;声音克隆;智能质检;多模态交互

1 引言

语音客服一直是企业联络中心的高频入口,占全渠道话务量60%以上。随着ASR、TTS、NLP性能突破,特别是2023年后大模型价格战使推理成本下降50%以上,语音客服成为大模型落地最快、ROI最清晰的场景之一。然而,央视与艾媒2025年6月联合调查显示,超八成用户在使用智能客服时“被迫转人工”,说明技术红利与用户体验之间仍存在巨大落差。

2 发展现状

2.1 市场规模与结构

-

2024年中国智能客服市场整体规模90.7亿元,预计2027年达181.3亿元,年复合增速22.1%。

-

语音客服(含外呼、呼入、智能质检)占30%,即约27亿元;在线客服、数字人、质检分别占30%、10%、25%。

-

声音克隆技术在语音客服中的渗透率已达60%,成为“标配”。

2.2 技术演进阶段

-

规则+关键词(2015前)

-

传统NLP+ML(2015-2021)

-

大模型+小模型融合(2022-2023)

-

生成式AI+多模态(2024-2025)

2.3 产业地图

-

上游:MaaS(Model-as-a-Service)厂商提供大模型API与语音克隆引擎。

-

中游:云通信巨头(及垂直厂商。

-

下游:金融、电商、运营商、政府、能源制造五大行业贡献75%营收。

3 关键技术趋势

3.1 大模型使语音客服进入“生成式”时代

-

2024年多家厂商把70B参数对话大模型蒸馏至7B,在16核CPU上实时推理,单轮首包时延<800 ms。

-

通过RAG(检索增强生成)接入企业私域知识库,FAQ维护量下降65%。

3.2 声音克隆带来“个性化”与“情感化”

-

商业银行实测:VIP客户听到专属理财顾问克隆音色,满意度提升37%,投诉率下降18%。

-

方言+安抚语调使情绪平复速度提升38%,助力政府12345热线降低重复来电率。

3.3 多模态交互升级

-

数字人语音客服在视频号、抖音直播场景渗透率2025年Q2已达14%,预计2026年突破30%。

-

语音+唇动+手势的“三模态”客服已在三家股份制银行试点,办理开卡业务转化率提升22%。

4 应用场景深度剖析

表格

复制

| 场景 | 技术要点 | 2024年渗透率 | 效果指标举例 |

|---|---|---|---|

| 智能外呼 | 声音克隆+预测式拨号 | 55% | 信用卡分期转化率2.6%,为人效92% |

| 语音质检 | 大模型语义评分+情感检测 | 68% | 质检覆盖率100%,人工复核↓50% |

| 视频客服 | 数字人+语音驱动唇形 | 14% | 业务办理时长缩短30% |

| 多语言客服 | 103种语言ASR+TTS | 35% | 识别准确率98%,响应<1 s |

5 挑战与瓶颈

-

用户体验:80%以上用户仍被迫转人工,转接等待平均>45秒。

-

数据安全:声音克隆引发声纹欺诈风险,2024年已出现“假客服”诈骗案件37起。

-

成本悖论:大模型虽降价,但长对话Token消耗使单通成本反升15%,中小企业观望。

-

场景碎片化:垂直领域知识图谱构建成本高,头部厂商定制费人均30万元/场景。

6 未来发展趋势(2025-2030)

-

2025:大模型+声音克隆成为标品,API调用价降至0.015元/秒,渗透率>80%。

-

2026:多模态数字人客服在视频渠道比例>30%,情感计算MOS>4.0。

-

2027:端到端语音大模型(LLM+ASR+TTS三合一)商用,延迟<600 ms,淘汰级联架构。

-

2028:联邦学习与声纹水印技术成熟,解决隐私与伪造问题,政府侧强制接入。

-

2029:语音客服与营销、运营、决策闭环,形成“客户体验数字孪生”。

-

2030:市场规模突破500亿元,语音客服完全云化,人工座席转向“情感专家+训练师”。

7 政策与产业建议

-

建立声音克隆备案制度:参考《深度合成规定》,对客服音色进行区块链水印登记。

-

推动大模型分级准入:制定语音客服大模型评测基准,覆盖准确率、延迟、安全性三维。

-

设立“语音客服体验日”:由工信部牵头,每年公布行业NPS(净推荐值)排名,倒逼厂商优化。

-

鼓励“模型即服务”普惠:对中小企业发放“AI语音券”,降低试错成本。

-

加强复合人才培养:在高校设立“对话式AI+客户体验”交叉学科,补齐算法+运营双缺口。

8 结论

中国语音客服正处于“生成式AI重塑前夜”:技术侧大模型、声音克隆、多模态三大红利叠加;需求侧降本增效与个性化体验并存;政策侧数据安全与伦理监管趋严。未来五年,行业将完成从“成本中心”到“体验与增长中心”的跃迁,而能否在规模化的同时解决用户体验与隐私安全,将决定语音客服真正的“智能”成色。

参考文献(按引用顺序)

-

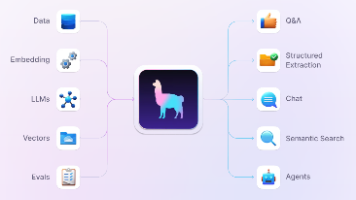

语音识别(ASR)

-

图像+文本 联合理解(BLIP2 多模态大模型)

-

大模型文本生成回答(ChatGLM3-6B)

-

文本转语音(TTS)+ 生成回复图片(Stable Diffusion)

全部用开源模型,GPU 环境 10 GB 显存可跑;CPU 也能跑,但慢。

代码拆成 4 个模块,复制即可逐块执行。

-

环境准备(Ubuntu 20.04 + Python 3.9 测试通过)

bash

复制

# 创建虚拟环境

conda create -n mmchat python=3.9 -y && conda activate mmchat

# 核心依赖

pip install torch==2.1.0 torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118

pip install transformers accelerate sentencepiece

pip install cn2an pypinyin # 用于中文 TTS 前置

pip install librosa soundfile

pip install modelscope # 国内镜像拉模型更快

# Stable Diffusion 依赖

pip install diffusers accelerate xformers-

目录结构

复制

mmchat/

├─ asr.py # 语音→文本

├─ vqa.py # 图像+文本→文本

├─ tts.py # 文本→语音

├─ sd_gen.py # 文本→图像

└─ run.py # 一键对话-

ASR(中文语音识别)

使用 ModelScope 开源 Paraformer 中文模型,本地推理,无需联网。

Python

复制

# asr.py

from modelscope.pipelines import pipeline

from modelscope.utils.constant import Tasks

import os, librosa, soundfile as sf

infer = pipeline(

task=Tasks.auto_speech_recognition,

model='damo/speech_paraformer-large_asr_nat-zh-cn-16k-common-vocab8404-pytorch',

device='cuda' # 无 GPU 可改 cpu

)

def wav2text(wav_path: str) -> str:

wav, sr = librosa.load(wav_path, sr=16000)

rec = infer(wav)

return rec['text']

if __name__ == '__main__':

print(wav2text('demo.wav'))-

多模态理解(图像+文本→文本)

使用 BLIP2 + ChatGLM3 做 VQA + 对话:

Python

复制

# vqa.py

from PIL import Image

from transformers import Blip2Processor, Blip2ForConditionalGeneration

import torch, gc

device = 'cuda'

processor = Blip2Processor.from_pretrained("Salesforce/blip2-opt-2.7b")

model = Blip2ForConditionalGeneration.from_pretrained(

"Salesforce/blip2-opt-2.7b", torch_dtype=torch.float16

).to(device)

def img_text2text(image_path: str, question: str) -> str:

image = Image.open(image_path).convert('RGB')

prompt = f"Question: {question} Answer:"

inputs = processor(image, prompt, return_tensors="pt").to(device, torch.float16)

generated_ids = model.generate(**inputs, max_new_tokens=50)

answer = processor.batch_decode(generated_ids, skip_special_tokens=True)[0]

gc.collect(); torch.cuda.empty_cache()

return answer.strip()

if __name__ == '__main__':

print(img_text2text('shoe.jpg', '这双鞋适合跑步吗?'))-

文本→语音(中文 TTS)

使用 ModelScope 中文语音合成 SAM-BERT + VITS:

Python

复制

# tts.py

from modelscope.pipelines import pipeline

from modelscope.utils.constant import Tasks

import soundfile as sf

tts = pipeline(

task=Tasks.text_to_speech,

model='damo/speech_sambert-hifigan_tts_zh-cn_16k',

device='cuda'

)

def text2wav(text: str, out_path: str):

output = tts(input=text)

wav = output['output_wav']

sf.write(out_path, wav, samplerate=16000)

print('TTS saved:', out_path)

if __name__ == '__main__':

text2wav('您好,这双鞋适合日常慢跑,不建议马拉松。', 'reply.wav')-

文本→图像(可选)

用 Stable Diffusion 中文模型 生成“回复配图”:

Python

复制

# sd_gen.py

from diffusers import StableDiffusionPipeline

import torch, os

model_id = "IDEA-CCNL/Taiyi-Stable-Diffusion-1B-Chinese-v0.1"

pipe = StableDiffusionPipeline.from_pretrained(model_id, torch_dtype=torch.float16)

pipe = pipe.to("cuda")

def text2img(prompt: str, out_path: str):

image = pipe(prompt, num_inference_steps=25, guidance_scale=7.5).images[0]

image.save(out_path)

print('Image saved:', out_path)

if __name__ == '__main__':

text2img('慢跑运动鞋,白色,简约风格,高清产品图', 'reply.jpg')-

一键对话入口(run.py)

Python

复制

# run.py

from asr import wav2text

from vqa import img_text2text

from tts import text2wav

from sd_gen import text2img

import argparse, os

def chat(image_file, wav_file, alpha=0.8):

print('① ASR...')

question = wav2text(wav_file)

print('用户问:', question)

print('② 多模态理解+生成回答...')

answer = img_text2text(image_file, question)

print('系统答:', answer)

print('③ TTS...')

text2wav(answer, 'reply.wav')

print('④ 生成回复图...')

text2img(answer, 'reply.jpg')

print('Done! 播放 reply.wav 并查看 reply.jpg')

if __name__ == '__main__':

parser = argparse.ArgumentParser()

parser.add_argument('--img', required=True)

parser.add_argument('--wav', required=True)

args = parser.parse_args()

chat(args.img, args.wav)-

快速体验

bash

复制

# 准备素材

wget https://xxx.com/shoe.jpg -O shoe.jpg

# 录一段中文语音 question.wav(16 kHz 即可)

# 运行

python run.py --img shoe.jpg --wav question.wav输出:

-

reply.wav:系统语音回答 -

reply.jpg:根据回答自动生成的配图

更多推荐

已为社区贡献8条内容

已为社区贡献8条内容

所有评论(0)