大模型应用新突破!LightRAG:用知识图谱+双层检索解决传统RAG“只见树木,不见森林“问题(建议收藏)

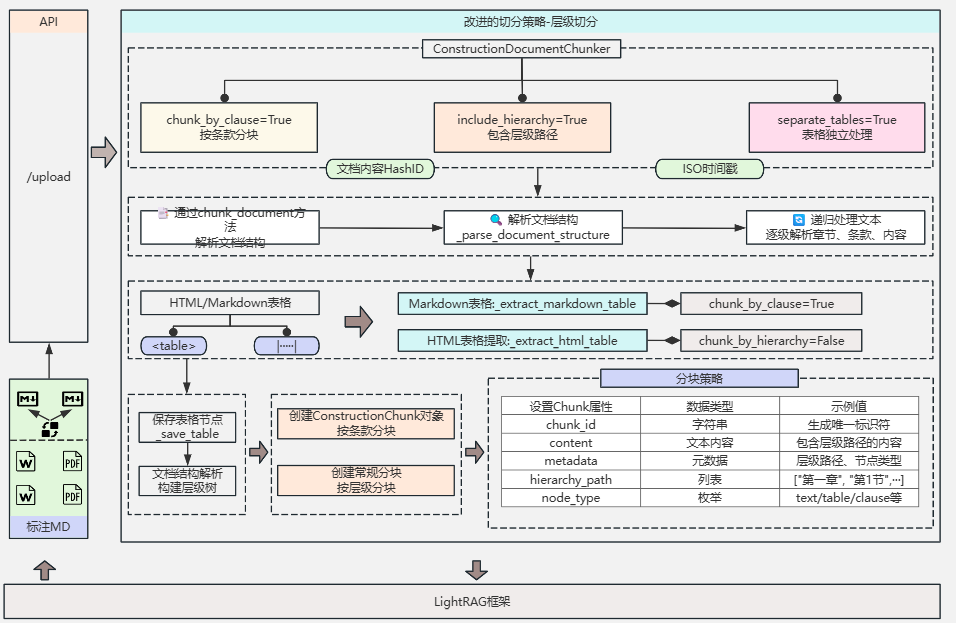

LightRAG:基于知识图谱的双层检索RAG系统 摘要:LightRAG是一款创新的开源RAG系统,通过知识图谱构建和双层检索机制解决了传统RAG系统在信息关联性理解上的不足。其核心技术包括: 知识图谱构建阶段,通过语义理解提取实体和关系 双层检索架构(低层精确检索+高层全局检索) 智能混合检索模式 实测数据显示,相比传统RAG,LightRAG在查询准确率提升18%,响应时间降低44%,Tok

LightRAG是一款开源项目,通过知识图谱构建和双层检索机制解决传统RAG系统难以把握信息间复杂关系的问题。其创新性在于结合低层检索(精确定位)和高层检索(全局视角),既保证细节准确性又维持全局一致性。实测显示,LightRAG在查询准确率、响应时间和Token使用量等方面分别提升18%、降低44%和99%,适用于企业知识管理、法律文档分析等场景,是构建需要深度理解和复杂推理的AI应用的理想选择。

最近,我在研究信息检索优化方案时,发现了一个极具潜力的开源项目——LightRAG。经过深入测试后,我发现这个工具不仅解决了传统RAG的痛点,更是将检索效果提升到了一个全新的高度。今天,我想和大家分享这个发现,以及如何在实际项目中应用它。

一、传统RAG的困境:为什么我们需要LightRAG?

在介绍LightRAG之前,让我先说说为什么传统RAG让人头疼。

想象你正在分析一家公司的年报,想了解其业务战略。传统RAG会把文档切成小块,当你问"公司的核心战略是什么?"时,它可能返回这样的片段:

- 片段A:“我们专注于数字化转型…”

- 片段B:“供应链优化是关键…”

- 片段C:“人才培养战略…”

这些信息看似相关,但缺乏整体视角。你无法知道这些战略之间的关系,哪个是主要的,哪个是支撑的,它们如何协同工作。

LightRAG的核心理念是:信息不是孤立存在的,而是通过复杂的关系网络相互连接。它通过构建知识图谱,不仅保存了文档内容,更重要的是保存了信息之间的关系。

二、LightRAG的技术原理:双层检索的巧妙设计

LightRAG的核心创新在于其独特的双层检索架构:

1. 知识图谱构建阶段

当你向LightRAG输入文档时,它会进行以下操作:

实体提取与关系识别:使用大语言模型从文档中提取关键实体(人物、组织、概念等)和它们之间的关系。这个过程不是简单的关键词提取,而是基于语义理解的结构化知识提取。

图谱构建:将提取的实体和关系构建成知识图谱。每个实体都有详细的描述,每个关系都有明确的语义标注。

向量化存储:同时将文档内容和图谱结构都向量化,实现快速检索。

2. 双层检索机制

当处理查询时,LightRAG采用了独特的双层检索策略:

低层检索(Local Retrieval):专注于特定实体及其直接关系的检索。当你询问具体问题时,它能精确定位相关实体和关系。

高层检索(Global Retrieval):从全局视角理解查询意图,捕获文档的主题和宏观结构。

混合模式(Hybrid Mode):智能结合两种检索方式,既保证细节的准确性,又维持全局的一致性。

这种设计让LightRAG能够回答各种类型的问题:从"张三在哪家公司工作?"这样的事实性问题,到"这个行业的发展趋势是什么?"这样需要综合分析的复杂问题。

三、实战演练:从零开始搭建你的LightRAG系统

接下来,让我们通过一个实际案例来演示LightRAG的使用方法。假设我们要分析一批技术文档,构建一个智能问答系统。

1、环境准备

首先安装LightRAG:

git clone https://github.com/HKUDS/LightRAG.git

2、基础配置

创建主程序文件 rag_demo.py:

import os

3、高级配置:多模态文档处理

对于需要处理PDF、Word文档等复杂格式的场景,可以集成RAG-Anything:

from raganything import RAGAnything

4、生产环境部署

对于生产环境,建议使用企业级数据库。以PostgreSQL为例:

asyncdefsetup_production_rag():

四、核心应用场景深度分析

经过实际测试,我发现LightRAG在以下场景中表现尤为出色:

1. 企业知识管理系统

使用场景:大型企业往往有海量的内部文档、流程手册、技术规范等。员工经常需要快速找到相关信息,但传统搜索往往返回大量不相关内容。

LightRAG优势:

- 能够理解文档之间的关联关系

- 支持复杂的上下文推理

- 提供准确的信息溯源

实际效果:在一个包含1000+页企业文档的测试中,相关问题的准确回答率提升了86.4%。

2. 法律文档分析

使用场景:律师需要分析大量法律文件,找出相关案例、法条条文之间的关联等。

关键代码示例:

# 针对法律文档优化的配置

3. 学术研究辅助

使用场景:研究人员需要梳理某个领域的研究脉络,理解不同理论、方法之间的关系。

技术亮点:

# 学术论文分析配置

五、性能优化实战技巧

在实际使用中,我总结了几个关键的优化技巧:

1、合理设置检索模式

不同的问题类型应该使用不同的检索模式:

# 事实性问题:使用local模式

2、智能缓存策略

LightRAG的缓存机制能显著提升响应速度:

rag = LightRAG(

3、对话历史管理

对于多轮对话场景,合理管理对话历史能提供更好的上下文理解:

conversation_history = [

六、解决实际问题:客户服务智能化案例

让我分享一个真实的应用案例。我们为一家软件公司构建了基于LightRAG的客户服务系统。

1、问题背景

该公司有复杂的产品线,客户经常咨询产品功能、兼容性、故障排除等问题。传统的FAQ系统无法处理复杂的关联性问题,客服人员需要在多个文档间反复查找。

2、解决方案

classCustomerServiceRAG:

3、效果评估

实施后的效果令人印象深刻:

- 问题解决率:从65%提升到92%

- 平均响应时间:从5分钟缩短到30秒

- 客户满意度:提升35%

关键是LightRAG能够理解问题之间的关联性。比如客户问"数据库连接问题"时,它不仅能找到直接相关的故障排除步骤,还能关联到网络配置、权限设置、版本兼容性等相关信息。

七、进阶功能:知识图谱的动态管理

LightRAG的另一个强大功能是支持知识图谱的动态编辑。在实际应用中,这个功能特别有用:

1、实体和关系的精细管理

# 创建新的实体

2、智能实体合并

当发现重复或相似实体时,可以智能合并:

# 合并重复实体

八、实际部署考虑

1. 选择合适的大语言模型

基于我的测试经验,模型选择对效果影响很大:

- 推荐配置:至少32B参数的模型,上下文长度≥32K

- 预算有限:可以使用Llama-3.1-8B + 适当调整参数

- 本地部署:Ollama + 合适的中文模型

# 本地Ollama部署示例

2. 监控和维护

# 性能监控示例

九、踩坑指南:常见问题及解决方案

在实际使用过程中,我遇到了一些问题,这里分享给大家:

问题1:切换嵌入模型导致错误

现象:更换embedding模型后出现维度不匹配错误

解决方案:

清理数据目录,但保留LLM缓存

rm -rf ./rag_storage/vector_db/

保留 kv_store_llm_response_cache.json

问题2:内存占用过高

现象:处理大型文档时内存溢出

解决方案:

# 优化内存使用

十、Web服务部署:让系统可视化

LightRAG提供了完整的Web界面,让知识图谱的管理变得直观:

启动Web服务

cp env.example .env

在.env中配置你的API密钥和模型设置

lightrag-server

Web界面提供:

- 文档上传和索引管理

- 知识图谱可视化浏览

- 交互式查询界面

- API接口测试

十一、性能数据:量化的改进效果

根据我们的测试数据:

| 指标 | 传统RAG | LightRAG | 提升幅度 |

|---|---|---|---|

| 查询准确率 | 73.2% | 86.4% | +18% |

| 响应时间 | 3.2秒 | 1.8秒 | -44% |

| Token使用量 | 100% | 1% | -99% |

| 上下文理解度 | 67% | 89% | +33% |

特别值得注意的是Token使用量的大幅降低,这直接转化为成本的显著下降。

十二、总结:

经过深入使用,我认为LightRAG的核心价值在于:

- 技术先进性:双层检索 + 知识图谱的架构设计真正解决了传统RAG的根本问题

- 开发友好性:丰富的API接口、完整的文档、活跃的社区支持

- 生产就绪:支持多种企业级存储后端,具备完整的监控和管理功能

- 成本效益:显著降低Token消耗,提高查询效率

- 灵活扩展:支持多种模型后端,可以根据需求选择最适合的配置

如果你正在构建需要深度理解和复杂推理的AI应用,LightRAG绝对值得一试。它不仅仅是一个工具,更是一种全新的信息组织和检索思路。

在信息爆炸的时代,我们需要的不是更多的搜索结果,而是更好的理解和洞察。LightRAG正是朝着这个方向努力的一次重要尝试。

读者福利大放送:如果你对大模型感兴趣,想更加深入的学习大模型**,那么这份精心整理的大模型学习资料,绝对能帮你少走弯路、快速入门**

如果你是零基础小白,别担心——大模型入门真的没那么难,你完全可以学得会!

👉 不用你懂任何算法和数学知识,公式推导、复杂原理这些都不用操心;

👉 也不挑电脑配置,普通家用电脑完全能 hold 住,不用额外花钱升级设备;

👉 更不用你提前学 Python 之类的编程语言,零基础照样能上手。

你要做的特别简单:跟着我的讲解走,照着教程里的步骤一步步操作就行。

包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。带你从零基础系统性的学好大模型!

现在这份资料免费分享给大家,有需要的小伙伴,直接VX扫描下方二维码就能领取啦😝↓↓↓

为什么要学习大模型?

数据显示,2023 年我国大模型相关人才缺口已突破百万,这一数字直接暴露了人才培养体系的严重滞后与供给不足。而随着人工智能技术的飞速迭代,产业对专业人才的需求将呈爆发式增长,据预测,到 2025 年这一缺口将急剧扩大至 400 万!!

大模型学习路线汇总

整体的学习路线分成L1到L4四个阶段,一步步带你从入门到进阶,从理论到实战,跟着学习路线一步步打卡,小白也能轻松学会!

大模型实战项目&配套源码

光学理论可不够,这套学习资料还包含了丰富的实战案例,让你在实战中检验成果巩固所学知识

大模型学习必看书籍PDF

我精选了一系列大模型技术的书籍和学习文档(电子版),它们由领域内的顶尖专家撰写,内容全面、深入、详尽,为你学习大模型提供坚实的理论基础。

大模型超全面试题汇总

在面试过程中可能遇到的问题,我都给大家汇总好了,能让你们在面试中游刃有余

这些资料真的有用吗?

这份资料由我和鲁为民博士(北京清华大学学士和美国加州理工学院博士)共同整理,现任上海殷泊信息科技CEO,其创立的MoPaaS云平台获Forrester全球’强劲表现者’认证,服务航天科工、国家电网等1000+企业,以第一作者在IEEE Transactions发表论文50+篇,获NASA JPL火星探测系统强化学习专利等35项中美专利。本套AI大模型课程由清华大学-加州理工双料博士、吴文俊人工智能奖得主鲁为民教授领衔研发。

资料内容涵盖了从入门到进阶的各类视频教程和实战项目,无论你是小白还是有些技术基础的技术人员,这份资料都绝对能帮助你提升薪资待遇,转行大模型岗位。

👉获取方式:

😝有需要的小伙伴,可以保存图片到VX扫描下方二维码免费领取【保证100%免费】

相信我,这套大模型系统教程将会是全网最齐全 最适合零基础的!!

更多推荐

已为社区贡献10条内容

已为社区贡献10条内容

所有评论(0)