超越单边控制:介绍新一代对话智能体评测基准τ2-Bench

超越单边控制:介绍新一代对话智能体评测基准τ2-Bench

当用户不只是“说”,而是也能“做”时,AI 智能体还能否胜任?

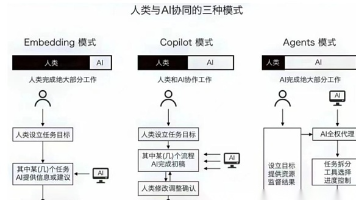

近年来,基于大语言模型(LLM)的对话智能体在任务型对话中表现出色,例如客服支持、预订系统等。然而,现有的评测基准(如T-Bench)大多建立在单边控制(single-control) 的环境下:只有 AI 智能体可以调用工具与环境交互,而用户仅能通过语言提供信息。

这种设定与真实世界存在明显差距。例如在技术支持场景中,用户可能需要亲自操作手机(如开关飞行模式、重启设备),而不仅仅是“描述问题”。为了弥补这一差距,Sierra 与多伦多大学的研究团队提出了 τ2-Bench,一个支持双边控制(dual-control) 的新型评测基准。

什么是τ2-Bench?

τ2-Bench 是一个用于评估对话智能体在双边控制环境下表现的系统。其核心思想是:用户和 AI 智能体都可以调用工具,共同操作一个共享的动态环境。

这种设定更贴近现实中的协作场景,例如技术故障排除、远程指导等,其中用户也具备执行动作的能力。

τ2-Bench 的四大核心贡献

1. 电信领域的双边控制环境

- 环境被建模为去中心化部分可观测马尔可夫决策过程(Dec-POMDP)。

- 用户和智能体各自拥有独立的工具集,可以观察和修改共享环境的状态。

- 实验显示,即使是当前最先进的 LLM(如 GPT-4.1、Claude-3.7-Sonnet 等),在这种环境下的任务通过率也显著下降(最低仅 34%),凸显了协调与沟通的挑战。

2. 组合式任务生成器

- 通过程序化方式从原子子任务组合出大量多样化且可验证的任务。

- 支持对任务复杂度的精确控制(如步骤数、问题类型),避免人工编写任务带来的偏差与局限性。

- 在电信领域中,共生成 2285 个任务,从中抽样 114 个构成平衡测试集。

3. 高可靠性的用户模拟器

- 用户行为受工具和环境状态严格约束,而非仅依赖自然语言提示。

- 在电信领域中,用户模拟器的错误率仅为 16%(关键错误 6%),远低于原有零售领域的 40%(关键错误 12%)。

- 提升了模拟的真实性与可控性。

4. 细粒度性能诊断

- 支持在不同模式下评估智能体:

- 默认模式:智能体与用户协作(双边控制)

- 无用户模式:智能体独自操作所有工具(测试纯推理能力)

- Oracle 计划模式:提供完整解决方案序列(测试执行与沟通能力)

- 实验发现:从“无用户”切换到“默认”模式时,智能体性能下降约 20%,说明沟通与协调是当前智能体的主要瓶颈。

为什么Tau2-Bench重要?

- 更真实的评估场景:双边控制更贴近实际应用,如技术支持、远程指导等。

- 揭示智能体短板:通过模式对比,明确区分“推理错误”与“沟通错误”。

- 推动智能体协作能力发展:为研究如何在复杂、动态的环境中引导用户提供了标准测试平台。

- 可扩展性与自动化:组合式任务生成方法支持快速扩展新领域,降低人工成本。

示例场景:电信故障排除

在 τ2-Bench 的电信任务中,用户可能会报告“无法使用移动数据”。智能体需要:

- 查询用户账户状态

- 指导用户检查网络设置、开关飞行模式、重新插拔 SIM 卡等

- 验证问题是否解决

整个过程涉及多次智能体-用户-工具的三方互动,智能体必须既懂技术,又会引导。

结语

τ2-Bench不仅是T-Bench 的自然延伸,更是对话智能体评测从“单边控制”迈向“双边协作”的重要一步。它为我们提供了一个更加真实、可控、可诊断的测试平台,助力构建真正能与人协同工作的 AI 系统。

🔗 项目地址:https://github.com/sierra-research/tau2-bench

📄 论文链接:https://arxiv.org/abs/2506.07982

为武汉地区的开发者提供学习、交流和合作的平台。社区聚集了众多技术爱好者和专业人士,涵盖了多个领域,包括人工智能、大数据、云计算、区块链等。社区定期举办技术分享、培训和活动,为开发者提供更多的学习和交流机会。

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)