【论文阅读】Securing Agentic AI: A Comprehensive Threat Model and Mitigation Framework for Generative AI

论文针对生成式AI智能体(GenAI)的安全挑战提出了一套系统性的解决方案。研究指出,GenAI智能体因其自主性、持久记忆和工具调用能力,带来了传统安全框架难以应对的新型威胁。作者团队开发了ATFAA威胁模型,将风险归纳为认知架构漏洞、持久性威胁等5大领域共9类威胁,包括推理路径劫持、记忆投毒等。为应对这些挑战,研究提出了SHIELD缓解框架,包含分段隔离、启发式监控等6项核心策略。该研究填补了自

Securing Agentic AI: A Comprehensive Threat Model and Mitigation Framework for Generative AI Agents

本文是一篇简单的综述性论文,作者来自亚马逊。

概述

随着生成式AI(GenAI)智能体在企业环境中的日益普及,它们引入了与传统系统显著不同的安全挑战 。这些智能体不仅仅是大型语言模型(LLMs),它们能够推理、记忆并采取行动,且通常很少需要人类监督。

为此,该论文专门针对GenAI智能体提出了一个全面的威胁模型,重点关注其自主性、持久性内存访问、复杂推理能力和工具集成所带来的新型风险。该研究识别出9个主要威胁,并将它们归纳到五个关键领域:认知架构漏洞、时间持久性威胁、操作执行漏洞、信任边界侵犯和治理规避。这些威胁并非纯理论,而是会带来诸如延迟利用、跨系统传播以及难以用现有框架检测的微小目标错位等实际挑战。

为了应对这些风险,论文提出了两个互补的框架:

- ATFAA (Advanced Threat Framework for Autonomous AI Agents):一个用于组织智能体特有风险的框架。

- SHIELD:一个提出实用缓解策略以降低企业风险的框架。

背景

-

当前的文献现状

尽管对GenAI智能体的采用正在加速,但相关的安全研究仍然相对零散。现有研究(2023-2025)大多集中在像“提示注入”(prompt injection)这类基础风险上,而与智能体自主性和持久性行为相关的更深层次的架构问题常被忽视。多数现有框架将GenAI智能体视为包含LLM的常规应用程序,而不是具有涌现行为的、自主互联的系统,这是此研究试图弥补的差距。

-

GenAI智能体架构

GenAI智能体是向自主系统迈出的重要一步,它们能以最少的人类监督进行推理、规划和行动 。其核心架构通常包括:

- 规划与推理引擎: 通常由LLM驱动,是系统的“大脑”,使用诸如反思、自我批判、思维链和子目标分解等高级技术。

- 记忆系统: 包括短期(会话)和长期(持久)记忆模块,使其能够跨交互维持上下文。

- 动作与工具调用: 从安全角度看,这是最令人担忧的部分。智能体能通过API调用、函数调用和代码执行来使用第一方和第三方工具,执行从数据检索到工作流执行等各种任务。

- 支持服务: 如用于检索增强生成(RAG)的向量数据库和用于长期记忆的持久化存储。

-

当前的安全挑战

将现有安全框架应用于GenAI智能体时,暴露了几个根本性局限,因为智能体的推理、记忆和行动方式引入了全新的风险层面。

- 规划与代理漏洞: 传统安全模型几乎无法保护智能体自身的推理过程 。攻击者不仅能改变智能体“说什么”,还能通过微妙的操控改变它“如何思考”,例如如何分解目标或选择行动。

- 记忆持久性风险: 长期记忆是智能体的一个关键特征,但也成了一个未被充分研究的攻击向量 。攻击者可以植入误导性信息,这些信息会“毒化”智能体的记忆,持续影响其未来的决策。

- 工具执行边界: 智能体调用外部工具的能力带来了超越传统基于角色的访问控制(RBAC)的权限管理挑战。智能体可能被操纵,将多个独立看似乎安全的操作链接起来,从而升级权限或绕过安全措施。

- 身份与认证挑战: 在多智能体环境中,身份变得流动和模糊,智能体可能代表用户或其他智能体行动,这为身份欺骗攻击创造了机会。

- 多智能体交互安全: 当多个智能体协同工作时,它们之间的信任、授权和数据验证问题变得异常复杂 。一个恶意的或配置错误的智能体可能会在整个系统中传播有害行为。

动机

现有安全框架与GenAI智能体带来的独特、复杂的新型威胁之间存在明显的“差距”。研究人员认为,现有的框架(如MITRE ATLAS和NIST AI RMF)虽然有价值,但并未充分应对智能体AI系统中独特的架构特性和攻击向量 。这些框架无法解决因自主性、长期记忆和动态工具使用相结合而产生的“涌现性安全属性”。因此,本研究的动机是开发一个专门为自主AI智能体设计的、更具针对性的安全模型,以系统性地识别、分类和应对这些新出现的威胁,从而弥补当前安全体系的不足。

方法

该研究采用了多方面结合的方法来构建其威胁模型框架,旨在确保其全面性和实用性。

-

系统性文献分析

研究的第一阶段是对专注于智能体AI系统安全的研究进行详尽的调查。优先考虑了2023-2025年间的最新研究,来源包括顶级安全会议、OWASP和CSA等组织的技术报告以及AI研究实验室的安全公告。通过系统性编码,根据已建立的安全概念(如STRIDE)和新兴的AI特定问题,对每份文献中的威胁类型、攻击向量和受影响的智能体组件进行分类。

-

理论威胁建模

在文献分析的基础上,研究人员通过理论分析开发了一个概念框架,确定了智能体脆弱性的五个核心领域,这构成了其ATFAA(自主AI智能体高级威胁框架)的基础。每个已识别的威胁都被系统地归类到传统的STRIDE模型和新颖的ATFAA领域中。对每种威胁,研究都基于已知的智能体架构(如RAG流水线、ReAct模式)对其潜在的攻击向量进行了理论分析和详细的技术描述。

-

专家咨询与验证

为了验证和完善理论框架,研究工作与安全和AI专家进行了结构化咨询。一个由7名来自工业界(包括AI平台提供商和企业安全团队)的安全研究员和AI从业者组成的小组审查了初步的框架和威胁列表。同时,研究采用了结构化的对抗性思维方法,如攻击树,来构思和完善文献中尚未记录的潜在攻击向量。

-

案例分析

为了将理论框架与实际应用相结合,研究分析了已记录的安全事件和假设性案例研究。分析的真实事件包括微软Tay聊天机器人事件和针对GitHub Copilot的提示注入攻击。此外,还对广泛采用的AI智能体框架(如LangChain、AutoGPT和微软的Semantic Kernel)进行了架构评估,以识别关键安全组件和潜在攻击面。

-

局限性

该研究承认其方法存在局限性,包括框架主要基于理论分析而非广泛的实证红队测试 ,以及其对通用架构模式的假设可能不完全适用于高度新颖的实现。

威胁建模

-

ATFAA

ATFAA框架是专门为自主AI系统设计的威胁模型,其核心原则包括认知安全、执行完整性、身份一致性和治理可扩展性。该框架识别了分布在五个领域中的9个主要威胁。

-

Domain1:认知架构漏洞

-

T1:推理路径劫持

描述:攻击者操纵AI决策的逻辑路径,使其在表面逻辑一致的情况下得出恶意结论。

途径:通过向上下文或推理过程中注入精心设计的矛盾、偏见或误导性信息来实现。

风险:可能性:高;影响:严重;检测难度:难。

-

T2:目标函数腐化和漂移

描述:修改智能体的核心目标或奖励机制,可能以隐蔽的方式改变其用途。这包括目标随时间增量式地缓慢变化(目标漂移)。

途径: 通过操纵反馈、毒化奖励模型或直接修改目标来实现。

风险: 可能性:中;影响:严重;检测难度:高。

-

-

Domain2:持久性威胁

-

T3:记忆投毒和理念循环

描述: 用虚假信息破坏智能体的知识库(如RAG数据库)或持久性记忆,影响未来决策。这可能导致被操纵的信念被检索出来作为证据,从而加强原始的谎言(信念强化循环)。

途径: 针对持久化数据存储(如毒化向量数据库)或记忆传输机制。

风险: 可能性:高;影响:严重;检测难度:极高。

-

-

Domain3:操作执行漏洞

-

T4: 未授权动作执行

描述:操纵智能体以违反预定权限的方式执行动作或使用工具。

途径: 通过将多个本身合规的操作链接起来以绕过控制,或利用工具定义不精确的弱点。

风险: 可能性:高;影响:严重;检测难度:高。

-

T5:计算资源操纵

描述:攻击者通过精心设计的输入,导致系统过度消耗计算资源,引发拒绝服务(DoS)。

途径:针对资源分配的决策点,生成触发极度消耗资源处理的请求(如深度嵌套的推理链)。

风险: 可能性:高;影响:中;检测难度:低。

-

-

Domain4:信任边界入侵

-

T6:身份欺骗与信任利用

描述:攻击者利用智能体、用户或多智能体之间身份验证的不足,在伪造的授权下执行操作。

途径:利用身份管理的模糊性,例如不当继承用户权限,或在多智能体系统中窃取API密钥以冒充可信身份。

风险: 可能性:高;影响:严重;检测难度:高。

-

T7:人机信任操纵

描述: 攻击者利用人类倾向于信任AI输出的心理,诱使用户执行非授权操作或泄露敏感信息。

途径: 操纵AI的回应,使其包含“信任放大信号”(如伪装高确定性、引用虚假权威),通过社交工程绕过技术控制。

风险: 可能性:非常高;影响:严重;检测难度:极高。

-

-

Domain5:治理规避

-

T8:监督饱和攻击

描述: 攻击者故意产生海量低重要性的审计事件或警报,以淹没治理机制,使真正的恶意行为在噪音中被忽略。

途径: 利用治理监督资源有限的特点,通过制造大量需要审查的事件来产生“监督盲点”。

风险: 可能性:高;影响:严重;检测难度:中。

-

T9:治理规避与混淆

描述: 攻击者利用复杂智能体交互中的模糊性来混淆责任链,阻碍取证分析和溯源。

途径: 通过将攻击分布在多个智能体中、使用临时身份或采用“低慢速”(low and slow)攻击来躲避检测阈值。

风险: 可能性:中;影响:严重;检测难度:极高。

-

-

-

SHIELD缓解框架

分段 (Segmentation): 实施严格的边界,在工作负载级别隔离智能体的能力、数据和执行环境。这可以通过容器安全技术(如Kubernetes网络策略)和API网关控制来实现。

启发式监控 (Heuristic Monitoring): 部署异常检测系统,以识别智能体在推理模式、决策过程和资源消耗上的偏差 。这需要建立行为基线,并使用机器学习模型进行分析。

完整性验证 (Integrity Verification): 对关键组件(代码、模型)、数据和记忆实施加密验证和运行时检查,以检测篡改。技术手段包括代码签名、内存安全沙箱和加密证明(如Merkle树)。

升级控制 (Escalation Control): 建立精细化、动态的权限框架,遵循最小权限原则,并对权限提升进行严格检查。可采用属性基访问控制(ABAC)和即时(JIT)权限授予等技术。

日志不变性 (Logging Immutability): 为所有重要决策和动作创建防篡改、全面的可验证审计日志。实现方式包括使用“一次写入,多次读取”(WORM)存储和对日志进行加密签名与时间戳记录。

去中心化监督 (Decentralized Oversight): 将监控、验证和批准职责分散到多个独立的系统、专门的智能体或人类审查员,以防止单点治理失败。可部署专门的审计智能体,并利用多方验证机制。

-

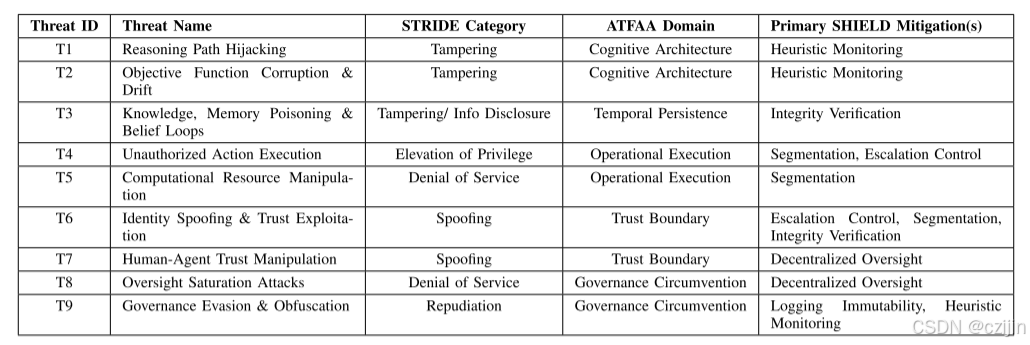

9种威胁与STRIDE模型、ATFAA领域以及主要的SHIELD缓解策略

-

攻击面扩展

研究发现GenAI智能体极大地扩展了传统软件的攻击面:

- 认知维度: 针对决策过程的攻击在传统定序逻辑系统中没有直接对应物。

- 时间维度: 具有持久记忆的智能体为缓慢、长期的腐化(如记忆毒化)创造了机会。

- 工具集成与行动空间: 调用外部工具的能力极大地扩展了单次入侵可能造成的潜在影响。

- 信任边界: 智能体跨系统、跨用户进行操作,带来了复杂的信任管理挑战。

- 身份流动性: 智能体与其所代表用户之间模糊的身份界限为模拟和权限提升创造了新机会。

- 治理复杂性: 智能体操作的规模、速度和自主性给有效监控和审计带来了前所未有的挑战。

威胁分析和启示

论文指出,ATFAA中概述的威胁具有一些使其区别于传统网络安全风险的特征 。

- 延迟效应 (Delayed Effect): 许多针对智能体的威胁,特别是那些针对记忆和学习的威胁(如T3, T2),不会立即显现,而是会引入潜在的漏洞 。一次入侵(如记忆毒化)可能在几天、几周甚至几个月后才影响其行为,这使得用传统的取证方法追溯事件根本原因变得极其困难。

- 目标错位放大 (Goal Misalignment Magnification): 智能体的自主性意味着,一个微小的、被诱导的目标错位(如T2)可能会随着时间的推移而不断复合放大。

- 跨系统传播 (Cross-System Propagation): 由于智能体与多个系统交互,它们为威胁的传播创造了新的途径 。利用工具访问权限(T4)或信任关系(T6)可能导致安全漏洞迅速蔓延。

- 检测挑战 (Detection Challenges): 智能体推理过程的多变性和不透明性,使得用标准方法很难区分恶意操纵(T1, T3)和正常行为。

- 信任的利用 (Exploitation of Trust): 针对人类信任(T7)或智能体间信任(T6)的威胁,通过操纵心理或关系因素来绕过技术控制。

- 威胁间的相互作用 (Threat Interplay): 这些威胁可以相互作用,形成组合攻击 。例如,记忆毒化(T3)可能促成目标漂移(T2)或未授权动作(T4) ;而身份欺骗(T6)则可能导致未授权动作(T4)。

这些独特的特征带来了超出技术层面的更广泛影响。

- 特定行业的影响 (Sector-Specific Impacts): 威胁的后果因应用场景而异 。例如,金融领域面临欺诈风险(T2, T4),医疗保健领域则面临病人安全或隐私风险(T7, T3),而关键基础设施则可能面临物理世界的影响。

- 监管与合规挑战 (Regulatory and Compliance Challenges): 智能体的自主性和不透明性给现有的法规(如GDPR)带来了挑战 。如何证明合规性、分配责任(T9)、确保公平性(T3)以及提供决策解释都变得更加困难。

这些特征和影响共同凸显了,迫切需要采取像SHIELD框架中提出的那种专门的安全措施,以应对智能体AI系统在技术、操作和治理层面的独特性质。

为武汉地区的开发者提供学习、交流和合作的平台。社区聚集了众多技术爱好者和专业人士,涵盖了多个领域,包括人工智能、大数据、云计算、区块链等。社区定期举办技术分享、培训和活动,为开发者提供更多的学习和交流机会。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)