DeepSeek+RAGFlow,搭建本地知识库!大模型入门到精通,收藏这篇就足够了!

有没有一种既能用 DeepSeek,又不用担心数据泄露的方法?当然有!今天就带大家搞定 DeepSeek + RAGFlow 本地知识库!

最近,AI 工具用得越来越多,DeepSeek 也火得不行。可问题来了——用 DeepSeek 网页版总是感觉怪怪的。

每次上传个文件都提心吊胆,生怕有一天自己的学习笔记、项目资料、甚至某些“小秘密”被偷走。

有没有一种既能用 DeepSeek,又不用担心数据泄露的方法?当然有!今天就带大家搞定 DeepSeek + RAGFlow 本地知识库!

1. 为什么不能直接用 DeepSeek 网页版?

1.1 隐私问题,心里没底DeepSeek 网页版虽然好用,但它要求你把所有数据都传到服务器上。这就像是你家门没锁,还得指望邻居不乱翻你的快递。

1.2 文件管理太麻烦

- 不能批量上传大量文件,每次都要手动拖拽,费时费力。

- 文件一旦修改或删除,又得重新上传,想高效管理知识库?别想了。

既然官方不给力,那我们就自己动手,打造属于自己的本地知识库!

2. 解决方案:本地部署 DeepSeek + RAGFlow

有了 RAGFlow 和本地 DeepSeek,世界清净了。

- 数据全在自己手里,安全无忧!

- 自由管理文件,想传多少传多少,再也不怕“超额”!

- 离线也能用,谁还怕网络抽风?

不仅如此,本地部署的 DeepSeek + RAGFlow 还能根据自己的需求进行个性化调整,比如优化检索策略、调整 AI 回答风格等等,就像给自己打造了一个专属 AI 助手。

接下来,我们一步步搭建!

3. RAG 是什么?

RAG(Retrieval-Augmented Generation)技术,本质上就是 检索 + 增强 + 生成,让 AI 变得更聪明。

3.1 工作流程

- 检索(Retrieval):先从本地知识库里找出相关信息。

- 增强(Augmentation):把这些信息加到用户问题里,丰富上下文。

- 生成(Generation):AI 再基于上下文生成答案,提高准确度。

这就像是你问了个问题,AI 不仅回答,还顺带把课本和参考资料都翻了一遍。

说白了,RAG 让 AI 更聪明、更精准、更懂上下文。

4. Embedding 是啥?为什么重要?

Embedding = 把语言变成计算机能懂的高维向量。

- 比如“苹果”和“水果”在向量空间里会很接近。

- 有了它,DeepSeek 才能更精准地检索内容。

简单理解,就是 让 AI 更聪明,更懂你在问啥。就像你问了一个问题,AI 先在“脑子”里找找相关的信息,再用自己的理解回答你,而不是像搜索引擎那样直接甩给你一堆网页链接。

5. 配置 Ollama(DeepSeek 运行环境)

5.1 安装 Ollama

Ollama 是 DeepSeek 的运行环境,就像车要加油一样,我们得先装上它。

macOS 版本

brew install ollama

ollama --version

Linux 版本

curl -fsSL https://ollama.ai/install.sh | sh

ollama --version

Docker 版本

docker pull ollama/ollama

5.2 配置环境变量

为了让 Ollama 正常运行,我们需要配置环境变量。

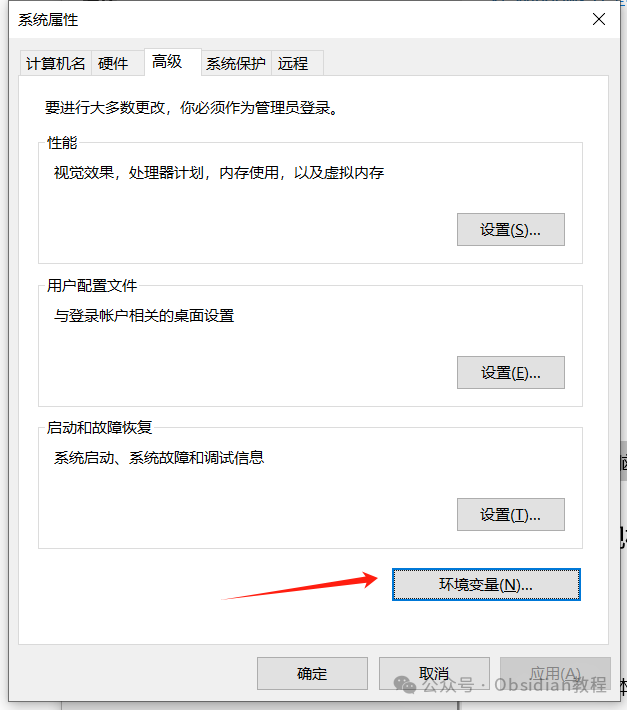

Windows 配置方法

系统设置 → 高级系统设置 → 环境变量

添加:

OLLAMA_HOST=0.0.0.0:11434OLLAMA_MODELS=E:\study\ollama

Mac/Linux 配置方法

export OLLAMA_HOST="0.0.0.0:11434"

export OLLAMA_MODELS="~/ollama_models"

source ~/.bashrc

5.3 运行 DeepSeek

ollama run deepseek-r1:7b

ollama list # 确保安装成功

ollama run deepseek-r1:7b # 启动模型

6. 下载 RAGFlow

6.1 Git 下载源码

git clone https://github.com/infiniflow/ragflow.git

6.2 直接下载(推荐)

这里我已经把源码整理到网盘了,大家自行下载就好。下载完成后解压即可。

点击下方公众号卡片,回复关键字:deepseek,获取网盘链接。

7. 安装 Docker

Docker 是用来运行 RAGFlow 的容器工具,相当于一个“AI 养殖场”,确保它能稳定运行。

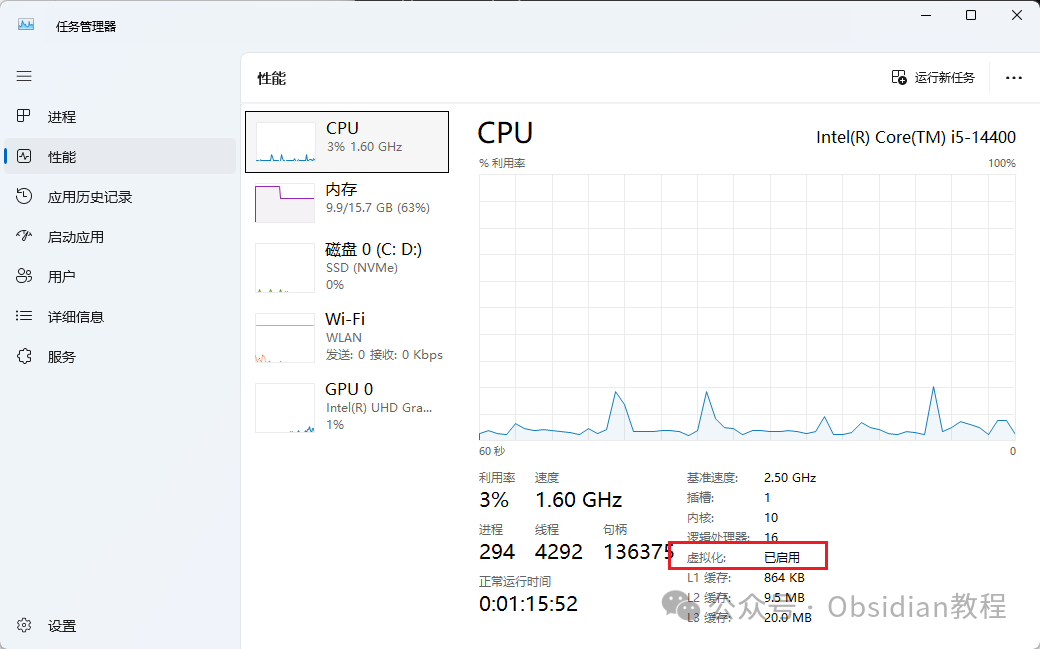

7.1 检查虚拟化是否启用

- Windows:任务管理器 → 性能 → “虚拟化”是否启用。

- 若未启用:进入 BIOS 开启 Intel VT-x/AMD-V。

7.2 安装 Docker

点击下方公众号卡片,回复关键字:deepseek,获取网盘链接。

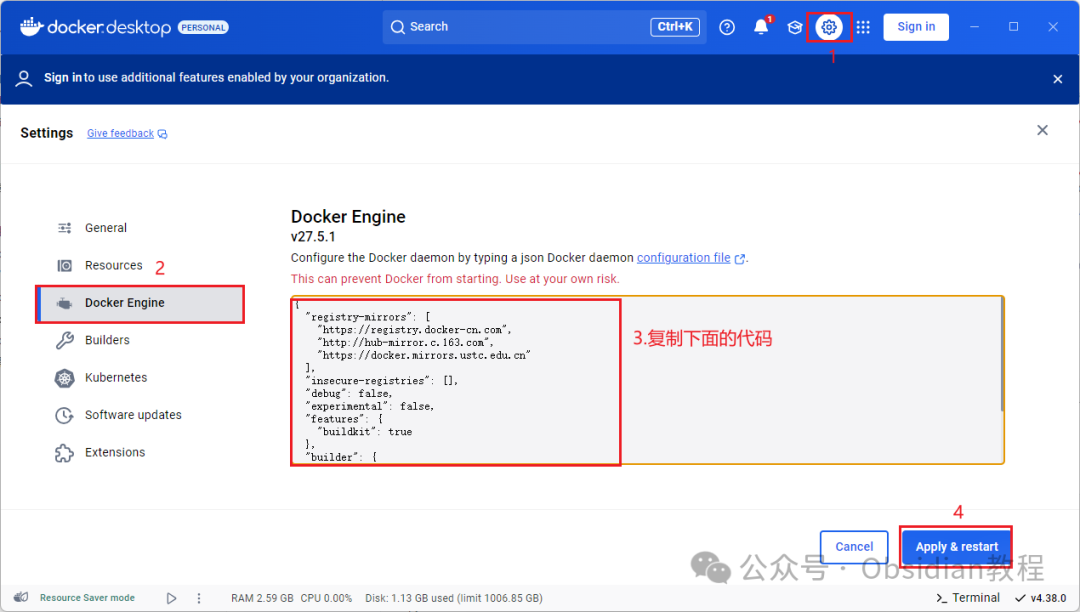

- 配置 Docker 镜像源

{

"registry-mirrors": [

"https://registry.docker-cn.com",

"http://hub-mirror.c.163.com",

"https://docker.mirrors.ustc.edu.cn"

]

}

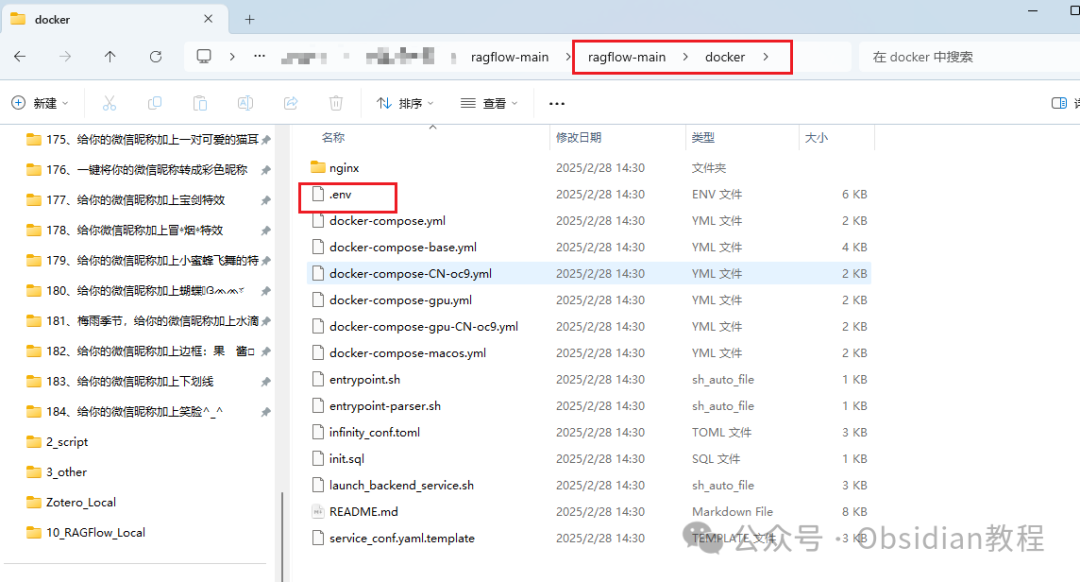

7.3 启动 RagFlow

cd docker

docker compose -f docker-compose.yml up -d

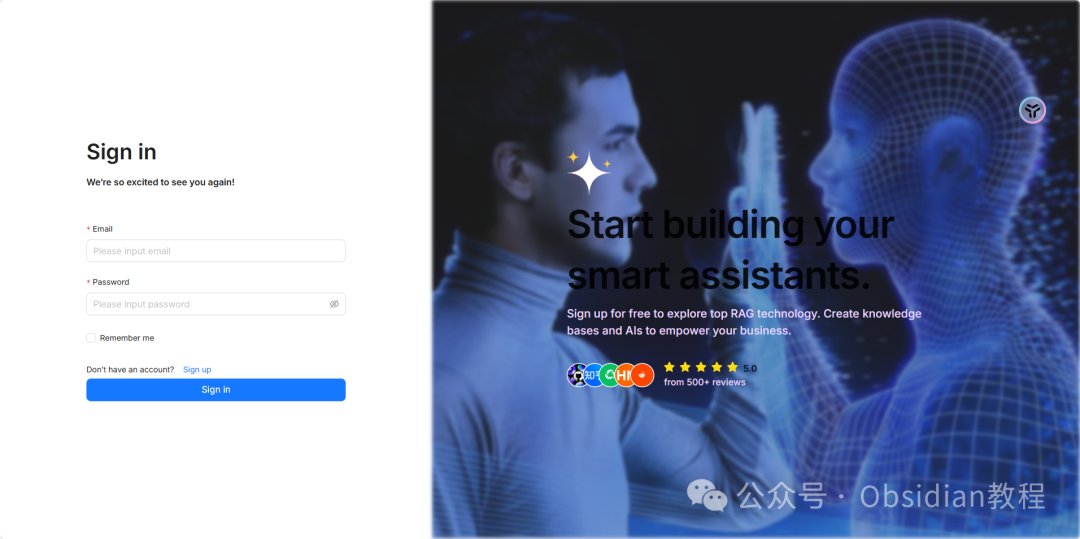

- 打开

http://localhost:80进入 RagFlow 页面。

8. 使用 RAGFlow 进行本地知识库管理

8.1 配置本地知识库

- 上传 PDF、TXT、Word 文件。

- RAGFlow 自动解析,建立索引。

8.2 创建对话助理

- 进入 RagFlow 页面。

- 模型设置 → 选择

deepseek-chat - 开始聊天,享受本地 AI 助理!

有了 DeepSeek + RAGFlow,你的本地 AI 助手就搭建好了!再也不用担心隐私泄露、网络不稳定或者数据管理麻烦。现在就去试试吧,让你的 AI 更懂你!

大模型算是目前当之无愧最火的一个方向了,算是新时代的风口!有小伙伴觉得,作为新领域、新方向人才需求必然相当大,与之相应的人才缺乏、人才竞争自然也会更少,那转行去做大模型是不是一个更好的选择呢?是不是更好就业呢?是不是就暂时能抵抗35岁中年危机呢?

答案当然是这样,大模型必然是新风口!

那如何学习大模型 ?

由于新岗位的生产效率,要优于被取代岗位的生产效率,所以实际上整个社会的生产效率是提升的。但是具体到个人,只能说是:

最先掌握AI的人,将会比较晚掌握AI的人有竞争优势。

这句话,放在计算机、互联网、移动互联网的开局时期,都是一样的道理。

但现在很多想入行大模型的人苦于现在网上的大模型老课程老教材,学也不是不学也不是,基于此我用做产品的心态来打磨这份大模型教程,深挖痛点并持续修改了近100余次后,终于把整个AI大模型的学习路线完善出来!

在这个版本当中:

您只需要听我讲,跟着我做即可,为了让学习的道路变得更简单,这份大模型路线+学习教程已经给大家整理并打包分享出来, 😝有需要的小伙伴,可以 扫描下方二维码领取🆓↓↓↓

一、大模型经典书籍(免费分享)

AI大模型已经成为了当今科技领域的一大热点,那以下这些大模型书籍就是非常不错的学习资源。

二、640套大模型报告(免费分享)

这套包含640份报告的合集,涵盖了大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。(几乎涵盖所有行业)

三、大模型系列视频教程(免费分享)

四、2025最新大模型学习路线(免费分享)

我们把学习路线分成L1到L4四个阶段,一步步带你从入门到进阶,从理论到实战。

L1阶段:启航篇丨极速破界AI新时代

L1阶段:了解大模型的基础知识,以及大模型在各个行业的应用和分析,学习理解大模型的核心原理、关键技术以及大模型应用场景。

L2阶段:攻坚篇丨RAG开发实战工坊

L2阶段:AI大模型RAG应用开发工程,主要学习RAG检索增强生成:包括Naive RAG、Advanced-RAG以及RAG性能评估,还有GraphRAG在内的多个RAG热门项目的分析。

L3阶段:跃迁篇丨Agent智能体架构设计

L3阶段:大模型Agent应用架构进阶实现,主要学习LangChain、 LIamaIndex框架,也会学习到AutoGPT、 MetaGPT等多Agent系统,打造Agent智能体。

L4阶段:精进篇丨模型微调与私有化部署

L4阶段:大模型的微调和私有化部署,更加深入的探讨Transformer架构,学习大模型的微调技术,利用DeepSpeed、Lamam Factory等工具快速进行模型微调,并通过Ollama、vLLM等推理部署框架,实现模型的快速部署。

L5阶段:专题集丨特训篇 【录播课】

全套的AI大模型学习资源已经整理打包,有需要的小伙伴可以微信扫描下方二维码,免费领取

为武汉地区的开发者提供学习、交流和合作的平台。社区聚集了众多技术爱好者和专业人士,涵盖了多个领域,包括人工智能、大数据、云计算、区块链等。社区定期举办技术分享、培训和活动,为开发者提供更多的学习和交流机会。

更多推荐

已为社区贡献17条内容

已为社区贡献17条内容

所有评论(0)