【神经网络】构成单元、网络结构、训练过程

人工神经网络用数学函数(神经元/节点) 和加权连接(权重) 来模拟这个过程,通过学习大量数据,自动调整连接强度,从而学会完成特定任务。:Sigmoid, Tanh, ReLU(最常用),Leaky ReLU, Softmax(用于多分类输出层)等。深度学习已成为人工智能革命的引擎,驱动了计算机视觉、自然语言处理、语音识别、推荐系统、自动驾驶等领域的突破性进展。:参数规模巨大、在广泛数据上预训练的模

一、核心思想:模仿人脑

神经网络是一种受生物神经系统启发而构建的计算模型。它的基本理念是:

生物基础:大脑由无数神经元相互连接而成,通过电化学信号处理信息。一个神经元接收多个输入信号,进行整合,如果信号足够强则产生输出,传递给其他神经元。

人工模拟:人工神经网络用数学函数(神经元/节点) 和加权连接(权重) 来模拟这个过程,通过学习大量数据,自动调整连接强度,从而学会完成特定任务。

二、基本构成单元:人工神经元

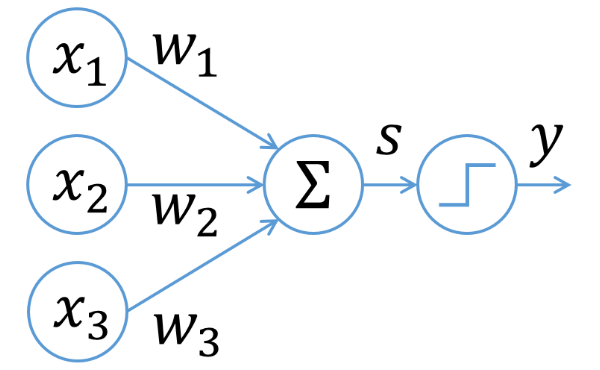

一个典型的人工神经元(或节点)工作如下:

输入:接收来自前一层或多个来源的数据 (x1, x2, …, xn)。

加权求和:每个输入乘以一个权重 (w1, w2, …, wn),然后加上一个偏置 (b)。得到:z = w1x1 + w2x2 + … + wn*xn + b。

激活函数:对 z 施加一个非线性激活函数 f。这是关键,它引入了非线性,使网络能够学习复杂模式。得到最终输出:a = f(z)。

输出:a 作为该神经元的输出,传递给下一层神经元。

常用激活函数:Sigmoid, Tanh, ReLU(最常用),Leaky ReLU, Softmax(用于多分类输出层)等。

三、网络结构:层与连接方式

神经元被组织成层:

- 输入层:接收原始数据(如图像像素、文本词向量)。

- 隐藏层:介于输入和输出层之间的一层或多层,是特征提取和转换的核心。层数越多,网络越“深”。

- 输出层:产生最终结果(如分类标签、预测数值)。

根据层间连接方式,主要分为:

- 前馈神经网络:信息单向流动,从输入层到输出层。最常见的多层感知机就是这种。

- 循环神经网络:神经元之间可以有循环连接,能处理序列数据(如时间序列、自然语言),具有“记忆”能力。常见变体:LSTM, GRU。

- 卷积神经网络:专门为网格状数据(如图像、音频)设计,使用卷积核在局部提取特征,具有参数共享和空间层次性,极大提升了图像等任务的性能。

四、如何学习:训练过程

神经网络的“智能”来自训练。这个过程的核心是:

- 前向传播:输入数据通过网络,层层计算,得到预测输出。

- 计算损失:使用损失函数比较网络预测值与真实值之间的差距。

- 反向传播:核心算法。将损失从输出层向输入层反向传播,计算损失相对于每个权重的梯度(即,权重应该如何微小调整才能减少损失)。

- 参数更新:使用优化器(最著名的是梯度下降及其变体,如Adam),根据梯度方向更新网络中的权重和偏置。

这个过程在大量数据上重复迭代,直到模型性能满意或收敛。

五、主要类型与应用

卷积神经网络:计算机视觉的绝对主力。

应用:图像分类、目标检测、人脸识别、图像生成。

循环神经网络/Transformer:自然语言处理和时序分析。

应用:机器翻译、文本生成、语音识别、股票预测。

生成对抗网络:学习数据分布并生成新数据。

应用:图像生成、风格迁移、数据增强。

Transformer:基于自注意力机制,已取代RNN成为NLP主流,并扩展至视觉和多模态领域。

应用:大语言模型(如GPT系列)、BERT、视觉Transformer。

六、深度学习的崛起与影响

当神经网络具有多个隐藏层时,就称为深度学习。21世纪10年代以来,其爆发得益于:

- 大数据:海量标注数据的可用性。

- 强大算力:GPU的并行计算能力。

- 算法进步:新的网络结构、激活函数、优化技术和正则化方法。

深度学习已成为人工智能革命的引擎,驱动了计算机视觉、自然语言处理、语音识别、推荐系统、自动驾驶等领域的突破性进展。

七、当前趋势与挑战

趋势:

大模型与AIGC:参数规模巨大、在广泛数据上预训练的模型,展现出强大的通用能力和生成能力。

多模态学习:让模型能同时理解和处理文本、图像、声音等多种信息。

可解释性AI:试图理解神经网络内部的决策逻辑,增加透明度。

轻量化与边缘部署:让模型能在手机、IoT设备上高效运行。

挑战:

需要大量数据和算力。

模型常被视为“黑箱”,决策过程难以解释。

可能存在偏见、安全和伦理问题。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)