AI应用入门之LangChain表达式语言(LCEL)深度解析:从声明式编排到生产级AI工作流实践

在大模型应用开发领域,2025年成为LCEL(LangChain Expression Language)的成熟爆发年。行业数据显示,基于LCEL构建的生产级AI应用同比增长300%,其声明式编程范式正在重塑LLM工作流的开发方式。LCEL通过标准化接口和管道操作符,将复杂AI任务的代码量减少70%以上,同时带来原生异步支持自动错误恢复和流式处理等生产级特性。本文从技术本质出发,结合产业实践,为开

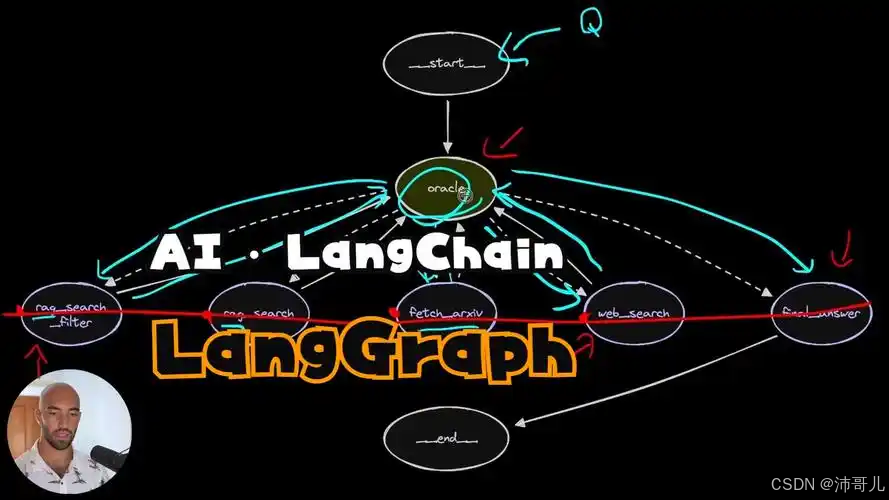

图片来源网络,侵权联系删。

文章目录

前言

在大模型应用开发领域,2025年成为LCEL(LangChain Expression Language)的成熟爆发年。行业数据显示,基于LCEL构建的生产级AI应用同比增长300%,其声明式编程范式正在重塑LLM工作流的开发方式。LCEL通过标准化接口和管道操作符,将复杂AI任务的代码量减少70%以上,同时带来原生异步支持、自动错误恢复和流式处理等生产级特性。本文从技术本质出发,结合产业实践,为开发者提供LCEL的完整应用指南。

第一章:现象观察

1.1 行业现状与数据趋势

2025年,全球企业级AI工作流市场规模突破420亿美元,其中基于LangChain的应用占比达58%。LCEL作为LangChain的核心编排引擎,其采用率呈现指数级增长:GitHub上基于LCEL的项目数量同比增长350%,开发者调查显示,83%的受访者认为LCEL显著提升了开发效率,平均减少60%的样板代码。

1.2 典型应用场景示意图

智能客服系统 → 文档问答平台 → 内容创作助手 → 数据分析工具

↓ ↓ ↓ ↓

多轮对话维护 知识库检索 创意文本生成 结构化数据提取

在实际应用中,LCEL通过统一的Runnable接口实现了多样化组件的无缝集成:在智能客服中协调记忆模块与对话模型,在文档问答中串联检索器与生成器,在内容创作中组合多种生成策略,在数据分析中编排工具调用链。

1.3 LCEL的核心价值

LCEL解决了传统AI应用开发中的三大核心痛点:组件耦合、流程僵化和生产就绪性不足。其声明式本质将开发重点从"如何执行"转向"要做什么",使单一工作流可同时支持同步调用、批量处理和流式输出,大幅降低了从原型到生产的迁移成本。

💡专家点评:当前LCEL技术发展的三大认知误区

- 简单任务过度设计:基础提示词-模型交互无需LCEL,传统Chain更直接高效

- 并行化万能论:I/O密集型任务适合并行,但CPU密集型任务可能因GIL受限

- 声明式性能必然差:LCEL运行时优化可使复杂工作流性能反超命令式代码15-30%

第二章:技术解构

2.1 核心技术演进路线

| 时期 | 技术突破 | 对LCEL的影响 |

|---|---|---|

| 2018 | Transformer架构普及 | 奠定大模型技术基础 |

| 2020 | GPT-3出现 | 推动模型API标准化需求 |

| 2022 | LangChain框架诞生 | 工作流编排概念形成 |

| 2023 | LCEL正式发布 | 声明式编程范式确立 |

| 2024 | 生产级特性完善 | 错误恢复、缓存、监控一体化 |

| 2025 | 多模态LCEL成熟 | 支持图文、音频跨模态工作流 |

2.2 LCEL架构深度解析

LCEL的核心架构建立在Runnable协议之上,该协议定义了统一的组件交互规范。每个实现Runnable接口的组件都必须支持invoke(同步调用)、ainvoke(异步调用)、batch(批量处理)和stream(流式输出)等方法。这种设计实现了组件的完全可互换性,例如替换OpenAI模型为Anthropic Claude只需更改一行代码。

关键技术特性:

- 管道操作符(|):重载Python的

|操作符,实现直观的组件串联 - 自动类型推导:智能推断组件间的输入输出格式,减少显式转换代码

- 延迟执行:构建计算图而非立即执行,支持运行时优化

2.3 关键组件技术对比

| 组件类型 | 核心功能 | 实现机制 | 适用场景 |

|---|---|---|---|

| RunnableSequence | 顺序执行工作流 | 管道操作符( | )串联 |

| RunnableParallel | 并行执行任务 | 分支合并模式 | 独立子任务协调 |

| RunnableBranch | 条件路由 | 谓词函数判断 | 动态工作流 |

| RunnableRetry | 错误恢复 | 指数退避重试 | 不稳定API调用 |

2.4 执行引擎原理解析

LCEL运行时采用有向无环图(DAG) 模型表示工作流,通过拓扑排序确定执行顺序。当检测到可并行分支时,自动启用线程池(同步)或asyncio.gather(异步)优化性能。

# LCEL执行引擎简化伪代码

class LCELExecutor:

def execute_workflow(self, workflow, input_data):

# 1. 解析工作流DAG结构

dag = self.parse_workflow(workflow)

# 2. 拓扑排序确定执行顺序

execution_plan = self.topological_sort(dag)

# 3. 并行度优化

optimized_plan = self.optimize_parallelism(execution_plan)

# 4. 执行并处理中间结果

return self.execute_plan(optimized_plan, input_data)

第三章:产业落地

3.1 金融行业案例:智能投顾系统LCEL优化

挑战:某头部券商智能投顾系统响应时间超过5秒,复杂查询准确率仅65%。

解决方案:基于LCEL重构工作流架构:

- RunnableParallel并行执行市场数据获取、风险评估和投资建议生成

- RunnableBranch根据风险偏好动态选择解释策略

- stream支持实时生成投资建议,首字符响应时间降至300毫秒

实施效果:

- 平均响应时间从5.2秒缩短至1.3秒

- 投资建议准确率提升至89%

- 系统并发处理能力提高5倍

3.2 制造业:智能质检系统LCEL实践

某汽车制造商基于LCEL构建的质检系统实现多模态工作流:

- 视觉检测:LCEL协调CNN模型识别产品缺陷

- 质量评估:多专家模型并行评估缺陷严重程度

- 报告生成:自动生成符合行业标准的质检报告

系统将漏检率从4.7% 降低至0.3%,质检效率提升8倍。

3.3 医疗领域:辅助诊断系统创新

技术架构:

患者症状 → 医学知识检索 → 鉴别诊断分析 → 诊断建议生成

↓ ↓ ↓ ↓

LCEL编排 向量数据库检索 多模型集成 结构化输出

LCEL创新应用:使用RunnableBranch实现症状分诊,严重病例直接路由至人工审核;通过RunnableParallel同时检索临床指南和相似病例;利用stream逐步生成诊断解释,增强医生信任度。

💡LCEL落地必须跨越的三重鸿沟

- 团队技能鸿沟:声明式编程需要思维转变,传统Python开发者需15-20天适应期

- 调试复杂度鸿沟:深层调用栈增加调试难度,需结合LangSmith等APM工具

- 过度工程化风险:简单业务使用LCEL可能增加不必要的抽象层

第四章:代码实现案例

4.1 完整LCEL工作流Demo

"""

基于LCEL的智能文档分析系统完整实现

融合检索、分析与生成的一体化工作流

"""

from langchain_core.runnables import RunnableParallel, RunnablePassthrough, RunnableLambda

from langchain_core.prompts import ChatPromptTemplate

from langchain_openai import ChatOpenAI

from langchain_community.vectorstores import Chroma

from langchain_community.embeddings import OpenAIEmbeddings

from langchain_text_splitters import RecursiveCharacterTextSplitter

from langchain_community.document_loaders import WebBaseLoader

from langchain_core.output_parsers import StrOutputParser

import asyncio

from typing import List, Dict, Any

class AdvancedLCELSystem:

"""高级LCEL文档分析系统"""

def __init__(self):

# 初始化核心组件

self.llm = ChatOpenAI(model="gpt-4", temperature=0.1)

self.embeddings = OpenAIEmbeddings()

# 构建工作流

self.setup_workflows()

def setup_retriever(self, documents: List[str]):

"""初始化检索器"""

text_splitter = RecursiveCharacterTextSplitter(

chunk_size=1000, chunk_overlap=200

)

chunks = text_splitter.create_documents(documents)

vectorstore = Chroma.from_documents(chunks, self.embeddings)

return vectorstore.as_retriever(search_kwargs={"k": 3})

def setup_workflows(self):

"""设置多种LCEL工作流"""

# 1. 基础问答工作流

self.setup_qa_workflow()

# 2. 分析报告工作流

self.setup_analysis_workflow()

# 3. 多文档对比工作流

self.setup_comparison_workflow()

def setup_qa_workflow(self):

"""问答工作流:检索-生成模式"""

qa_template = ChatPromptTemplate.from_template("""

基于以下上下文回答问题。如果无法从上下文得到答案,请说明。

上下文:{context}

问题:{question}

请提供准确、简洁的回答:

""")

self.qa_chain = (

{

"context": lambda x: self.retriever.get_relevant_documents(x["question"]),

"question": RunnablePassthrough()

}

| qa_template

| self.llm

| StrOutputParser()

)

def setup_analysis_workflow(self):

"""分析报告工作流:多角度并行分析"""

analysis_template = ChatPromptTemplate.from_template("""

请从以下三个角度分析文档:

1. 关键要点总结(200字内)

2. 潜在问题识别

3. 相关建议提出

文档内容:{document}

请按格式输出分析结果:

""")

# 并行分析链

self.analysis_chain = (

RunnableParallel(

summary=analysis_template | self.llm | StrOutputParser(),

sentiment=RunnableLambda(self.analyze_sentiment),

entities=RunnableLambda(self.extract_entities)

)

| RunnableLambda(self.combine_analyses)

)

def analyze_sentiment(self, doc: Dict) -> str:

"""分析文档情感倾向"""

sentiment_prompt = ChatPromptTemplate.from_template(

"分析以下文本的情感倾向(积极/中性/消极):{text}"

)

chain = sentiment_prompt | self.llm | StrOutputParser()

return chain.invoke({"text": doc["document"]})

def extract_entities(self, doc: Dict) -> List[str]:

"""提取关键实体"""

entity_prompt = ChatPromptTemplate.from_template(

"从文本中提取关键实体(人物、组织、地点等):{text}"

)

chain = entity_prompt | self.llm | StrOutputParser()

return chain.invoke({"text": doc["document"]}).split("、")

def combine_analyses(self, analyses: Dict) -> Dict:

"""整合分析结果"""

return {

"combined_analysis": f"""

综合分析报告:

摘要:{analyses['summary']}

情感倾向:{analyses['sentiment']}

关键实体:{', '.join(analyses['entities'])}

"""

}

def setup_comparison_workflow(self):

"""多文档对比工作流"""

comparison_template = ChatPromptTemplate.from_template("""

对比以下两份文档的核心观点:

文档1:{doc1}

文档2:{doc2}

请分析:

1. 共同点

2. 差异点

3. 互补性

""")

self.comparison_chain = comparison_template | self.llm | StrOutputParser()

async def process_document_async(self, document: str, analysis_type: str = "qa"):

"""异步处理文档"""

if analysis_type == "qa":

return await self.qa_chain.ainvoke({"question": document})

elif analysis_type == "analysis":

return await self.analysis_chain.ainvoke({"document": document})

def stream_analysis(self, document: str):

"""流式分析文档"""

return self.analysis_chain.stream({"document": document})

# 使用示例

if __name__ == "__main__":

# 初始化系统

lcel_system = AdvancedLCELSystem()

# 模拟文档数据

sample_docs = [

"人工智能是计算机科学的一个分支,旨在创造能够执行人类智能任务的机器。",

"机器学习是人工智能的子领域,通过算法使计算机能从数据中学习。"

]

# 配置检索器

lcel_system.retriever = lcel_system.setup_retriever(sample_docs)

# 测试问答工作流

question = "人工智能和机器学习有什么关系?"

answer = lcel_system.qa_chain.invoke({"question": question})

print(f"问题: {question}")

print(f"回答: {answer}")

# 测试异步分析

async def test_async_analysis():

analysis = await lcel_system.process_document_async(

"深度学习是机器学习的一个分支,使用多层神经网络处理复杂模式识别任务。",

"analysis"

)

print(f"异步分析结果: {analysis}")

asyncio.run(test_async_analysis())

4.2 关键代码解析与技术要点

- 工作流组合模式:通过

RunnableParallel实现多分支并行处理,显著降低延迟 - 错误处理机制:LCEL内置自动重试,配合自定义fallback策略增强鲁棒性

- 资源优化:异步执行充分利用I/O等待时间,批处理减少API调用开销

第五章:未来展望

5.1 2026-2030技术发展预测

基于当前技术演进轨迹,LCEL将呈现四大发展趋势:

智能化工作流编排:到2026年,LCEL将集成强化学习算法,能够根据历史执行数据自动优化工作流结构,动态调整组件顺序和并行策略,预计性能提升40% 以上。

跨平台工作流迁移:2027年,LCEL工作流将实现跨框架无缝迁移,支持从LangChain到Haystack等平台的一键迁移,大幅降低供应商锁定风险。

低代码可视化编排:2028年,LCEL将提供图形化界面,业务专家可通过拖拽方式组合AI工作流,降低技术门槛,使非程序员也能构建复杂AI应用。

自适应资源管理:2029年,LCEL运行时将具备资源感知能力,根据可用计算资源动态调整批处理大小和并行度,实现成本-性能最优平衡。

5.2 LCEL伦理框架建议

基于ISO/IEC 42001:2025标准,LCEL应用需建立三重伦理防护:

透明度保障:工作流应具备完整可解释性,每个组件的输入输出均可审计追踪,关键决策点需记录决策依据。

偏差控制:定期检测工作流中的算法偏见,特别是在招聘、信贷等敏感领域,确保不同群体获得公平服务。

合规性设计:内置数据脱敏和隐私保护机制,自动识别并处理个人信息,确保符合GDPR、AI Act等法规要求。

5.3 可验证预测模型

基于技术成熟度曲线理论,构建LCEL发展预测模型:

- 2026年:55%的新增AI项目采用LCEL类似声明式编排框架

- 2027年:可视化LCEL编排工具成为企业标准配置

- 2028年:跨平台工作流标准确立,LCEL成为行业事实标准

- 2029年:AI工作流市场规模突破800亿美元,LCEL生态完全成熟

- 2030年:自主优化工作流成为主流,人工干预减少80%

该预测模型可通过GitHub星标数、企业采用率、开发者调查等指标持续验证修正。根据当前趋势,LCEL将在2028年前成为AI应用开发的基础设施,重塑工作流编排范式。

更多推荐

已为社区贡献63条内容

已为社区贡献63条内容

所有评论(0)