程序员必备技能 - Ollama本地部署大模型完整教程

本文详细介绍Ollama这一本地部署大语言模型的开源工具的安装与配置过程。涵盖下载安装、环境变量参数设置(模型存储路径、服务监听地址等)及验证方法。通过合理配置,用户可优化本地大模型运行体验,适合想要在本地部署大模型的开发者和小白用户。

本文详细介绍Ollama这一本地部署大语言模型的开源工具的安装与配置过程。涵盖下载安装、环境变量参数设置(模型存储路径、服务监听地址等)及验证方法。通过合理配置,用户可优化本地大模型运行体验,适合想要在本地部署大模型的开发者和小白用户。

前排提示,文末有大模型AGI-CSDN独家资料包哦!

一、ollama是什么?

Ollama 是一个专注于本地部署和运行大语言模型(LLM)的开源工具,由美国公司 Ollama Inc. 开发。它提供了简单的命令行界面和 HTTP API,使开发者能够在本地环境快速部署、运行和交互各种开源 LLM,无需依赖云服务。

二、访问官网直接完成下载

-

访问官网主页

Ollama 下载:https://ollama.com/download

Ollama 官方主页:https://ollama.com

Ollama 官方 GitHub 源代码仓库:https://github.com/ollama/ollama/

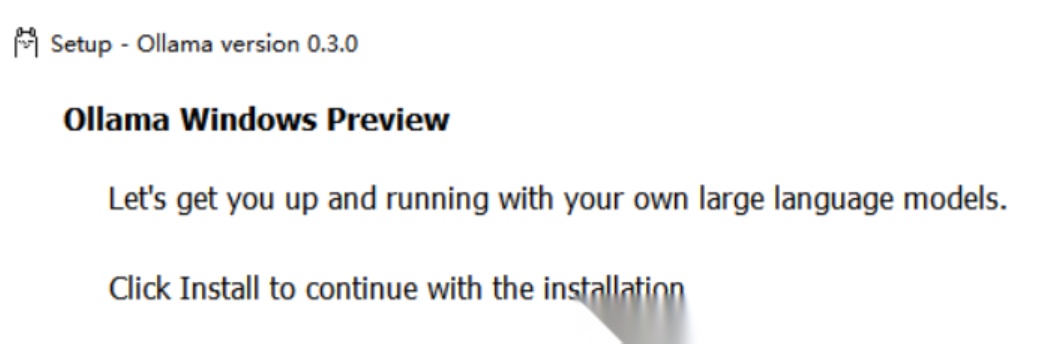

等待浏览器下载文件 OllamaSetup.exe,完成后双击该文件,出现如下弹窗,点击 Install 等待下载完成即可。

3.安装完成后,可以看到 Ollama 已经默认运行了。

也可用 命令安装:

- 找到下载的

OllamaSetup.exe文件(假设存放在D:\Temp目录); - 以管理员身份打开 CMD(按下

Win+R,输入cmd,右键 “以管理员身份运行”); - 在 CMD 中输入以下命令,定位到安装包目录:

cd /d D:\Temp - 执行安装命令(

DIR后填写自定义安装目录,如D:\Net_Program\Net_Ollama):OllamaSetup.exe /DIR="D:\Net_Program\Net_Ollama" - 弹出安装窗口后,点击 “Install”,等待安装完成。

安装后关键操作:退出 Ollama 临时服务

安装完成后,Ollama 会自动启动(任务栏右下角会出现 Ollama 图标),先右键图标选择 “Quit” 退出—— 后续配置环境变量后再重启,避免配置不生效。

三、配置环境变量

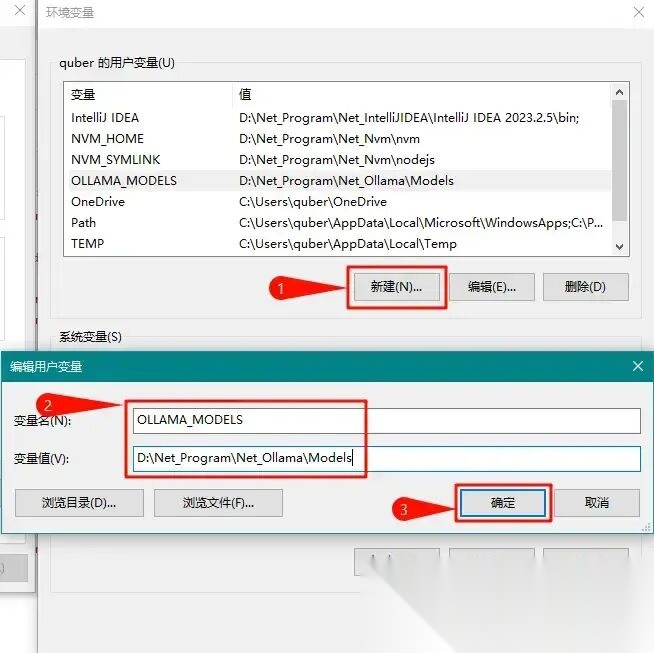

- 按下Win+R,输入sysdm.cpl,打开 “系统属性”→“高级”→“环境变量”;

• 在 “用户变量” 中找到Path,双击编辑,将原来的 Ollama 路径改为迁移后的路径(如D:\Net_Program\Net_Ollama);

• 点击 “确定” 保存。

Ollma可以像其他软件一样在电脑上完成一键安装,不同的是,建议按照实际需求配置下系统环境变量参数

| 参数 | 标识与配置 |

|---|---|

| OLLAMA_MODELS | 表示模型文件的存放目录,默认目录为当前用户目录即 C:\Users%username%.ollama\models Windows 系统 建议不要放在C盘,可放在其他盘(如 E:\ollama\models) |

| OLLAMA_HOST | 表示ollama 服务监听的网络地址,默认为127.0.0.1 如果想要允许其他电脑访问 Ollama(如局域网中的其他电脑),建议设置成 0.0.0.0 |

| OLLAMA_PORT | 表示ollama 服务监听的默认端口,默认为11434 如果端口有冲突,可以修改设置成其他端口(如8080等) |

| OLLAMA_ORIGINS | 表示HTTP 客户端的请求来源,使用半角逗号分隔列表 如果本地使用不受限制,可以设置成星号 * |

| OLLAMA_KEEP_ALIVE | 表示大模型加载到内存中后的存活时间,默认为5m即 5 分钟 (如纯数字300 代表 300 秒,0 代表处理请求响应后立即卸载模型,任何负数则表示一直存活) 建议设置成 24h ,即模型在内存中保持 24 小时,提高访问速度 |

| OLLAMA_NUM_PARALLEL | 表示请求处理的并发数量,默认为1 (即单并发串行处理请求) 建议按照实际需求进行调整 |

| OLLAMA_MAX_QUEUE | 表示请求队列长度,默认值为512 建议按照实际需求进行调整,超过队列长度的请求会被抛弃 |

| OLLAMA_DEBUG | 表示输出 Debug 日志,应用研发阶段可以设置成1 (即输出详细日志信息,便于排查问题) |

| OLLAMA_MAX_LOADED_MODELS | 表示最多同时加载到内存中模型的数量,默认为1 (即只能有 1 个模型在内存中) |

四、验证 Ollama 安装是否成功

配置完成后,通过简单命令验证 Ollama 是否正常工作:

- 打开 CMD(无需管理员身份);

- 输入以下命令查看版本:

ollama -v

若输出类似ollama version 0.1.30的信息,说明安装成功; - 输入

ollama -h可查看所有支持的命令,后续会常用到。

Ollama 默认将大模型存储在C:\Users[你的用户名].ollama\models,若 C 盘空间不足,需提前修改存储路径:

- 打开 “环境变量”(步骤同上);

- 在 “用户变量” 中点击 “新建”,输入:

-

变量名:

OLLAMA_MODELS -

变量值:

D:\Net_Program\Net_Ollama\Models(自定义的模型存储目录,需提前创建文件夹); -

点击 “确定” 保存,务必重启 CMD,确保环境变量生效。

读者福利:倘若大家对大模型感兴趣,那么这套大模型学习资料一定对你有用。

针对0基础小白:

如果你是零基础小白,快速入门大模型是可行的。

大模型学习流程较短,学习内容全面,需要理论与实践结合

学习计划和方向能根据资料进行归纳总结

包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。带你从零基础系统性的学好大模型!

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

👉AI大模型学习路线汇总👈

大模型学习路线图,整体分为7个大的阶段:(全套教程文末领取哈)

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

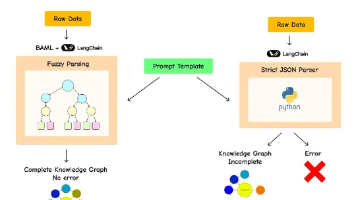

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉大模型实战案例👈

光学理论是没用的,要学会跟着一起做,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

👉大模型视频和PDF合集👈

这里我们能提供零基础学习书籍和视频。作为最快捷也是最有效的方式之一,跟着老师的思路,由浅入深,从理论到实操,其实大模型并不难。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

更多推荐

已为社区贡献73条内容

已为社区贡献73条内容

所有评论(0)