大模型量化技术完全指南:GPTQ、GGUF、PTQ和AWQ区别详解 | 程序员必藏

本文介绍了大模型量化技术的概念及四种主要方法:GPTQ、GGUF、PTQ和AWQ。量化通过将高精度数值转换为低精度数值,减少模型大小和资源占用,同时保持性能。GPTQ适合GPU加速,GGUF支持CPU运行,PTQ为训练后量化,AWQ则选择性量化非关键权重。量化技术可降低硬件需求、提高推理效率,使大模型在普通设备上也能高效运行。文中还提供了大模型学习资料获取方式,适合零基础开发者系统学习。

本文详细介绍了大模型量化技术,包括量化概念及GPTQ、GGUF、PTQ和AWQ四种主要量化方法的区别与应用。量化通过将高精度数值转换为低精度数值,减少模型大小和资源占用,同时保持模型性能。不同量化方法适用于不同场景,如GPTQ适合GPU加速,GGUF支持CPU运行,PTQ为训练后量化,AWQ则选择性量化非关键权重,帮助开发者根据硬件资源选择最合适的量化方案。

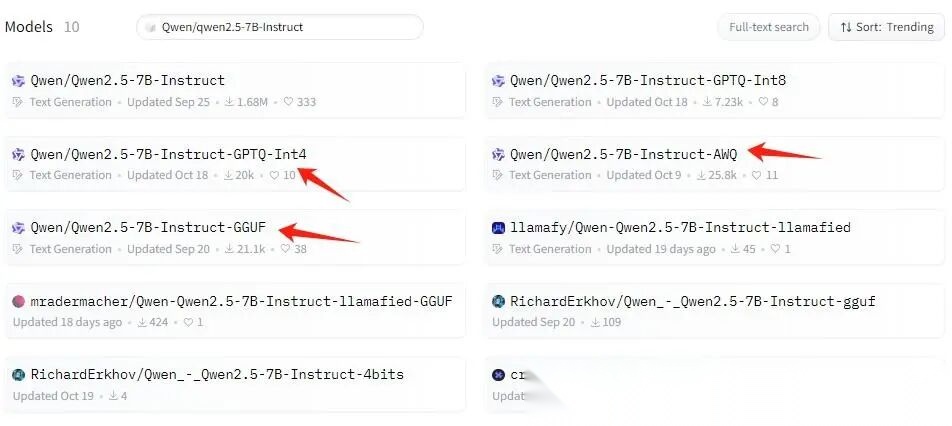

qwen 大模型

我们会看到这么多量化后的模型,到底他们之间有什么区别呢?

1.量化概念

量化是指的,将高精度的数值转换为低精度的数值,这样能够减少模型的大小,同时降低对服务器资源的占用,下面将通过一个具体例子来介绍量化的概念。

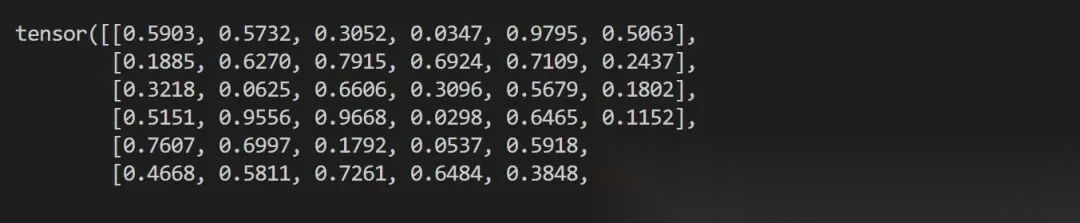

假设你有36个以半精度(fp16)表示的权重值,如下矩阵所示

fp16矩阵

我们希望对这些值记性int8量化。具体执行步骤如下:

(1)旧范围=fp16格式中的最大值-fp16格式中的最小值=0.9795 - 0.0298 = 0.9497

(2)新范围=int8包含从-128到127的数字,因此范围=127-(-128)= 255

(3)比例(scale)= 新范围的最大值/旧范围的最大值=127 / 0.9795 = 129.657

(4)量化值 = 四舍五入(比例*原始值)

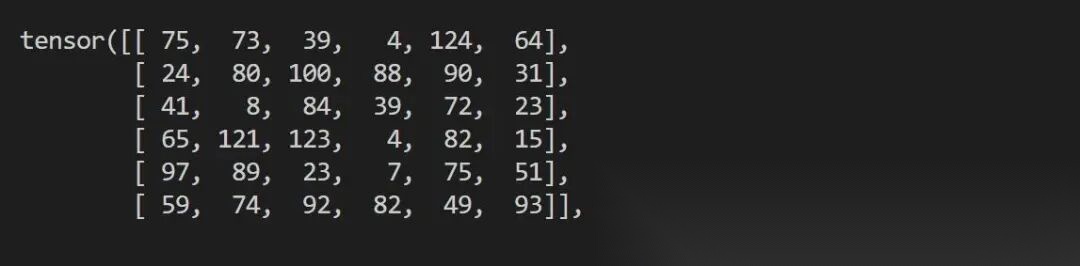

int8矩阵

(5)反量化值 = 量化值 / 比例

(6)四舍五入误差 = 当我们进行反量化到fp16时,可以看到数值并不完全相同。这是量化到反量化过程的结果所导致的误差。

- 量化方法

(1)GPTQ:GPT模型的训练后量化方法

GPTQ(Group-wise Precision Tuning Quantization)是一种静态后的训练量化技术。“静态”指的是预训练模型一旦确定,经过量化后量化参数不再更改。GPTQ量化技术是将fp16精度的模型量化为4-bit或8-bit,在节省了显存大小的同时大大的提高了推理的速度。

(2)GGUF && GGML

GGUF是GGML的新版本,尽管GPTQ在压缩方面表现出色,但如果没有运行它所需要的硬件,因为它对GPU的依赖可能会成为一个缺点。

GGUF是一种新的量化方法,是LLM库的C++复制品,支持多种LLM,比如LLaMA系列和Qwen系列等,它允许用户在CPU上运行LLM,同时将其部分层次转移到GPU上以加速运行。这种方法对于那些没有GPU资源的用户非常友好,是一种不错的选择。

这种量化方法提供了从2到8bit精度的不同级别的量化,我们通过获取原始的LLM大模型,将其转换为GGUF格式,然后再将GGUF格式量化为较低的精度。

(3)PTQ(Post-Training Quantization)

PTQ量化方法是在模型训练后,再对模型进行量化,将模型的浮点数权重和激活权重转换为较低精度的表示,从而减少模型大小和计算复杂度,同时保持模型的精度损失较小。PTQ方法分为两类:只量化模型权重的方法和同时量化权重与激活的方法。

(4)AWQ(Activation-aware Weight Quantization)

AWQ是一种激活感知的权重量化方法,这是一种类似于GPTQ的量化方法。其中AWQ与GPTQ方法之间最大的区别是AWQ假设并非所有的权重对LLM的性能都同等重要。也就是在量化过程中,不会对所有的权重进行量化,只会量化对于模型保持有效性不重要的权重,因此在论文中提到与GPTQ相比,该方法在保持类似甚至更好性能的同时实现了显著的加速

- 量化总结

将量化模型的权重内存占用减少为LLM推理带来了如下几个方面的优点:

(1)减少模型服务的硬件需求:量化后的模型可以使用更便宜的GPU服务器进行提供推理服务。

(2)为KV缓存提供更多的空间,以支持更大的批量处理大小和序列长度。

(3)更快的解码延迟,由于解码过程中受内存带宽限制,减少权重大小的数据移动能够改善这一点。

(4)更高的计算与内存访问比,这允许模型在解码期间充分利用可用的计算资源。

读者福利大放送:如果你对大模型感兴趣,想更加深入的学习大模型**,那么这份精心整理的大模型学习资料,绝对能帮你少走弯路、快速入门**

如果你是零基础小白,别担心——大模型入门真的没那么难,你完全可以学得会!

👉 不用你懂任何算法和数学知识,公式推导、复杂原理这些都不用操心;

👉 也不挑电脑配置,普通家用电脑完全能 hold 住,不用额外花钱升级设备;

👉 更不用你提前学 Python 之类的编程语言,零基础照样能上手。

你要做的特别简单:跟着我的讲解走,照着教程里的步骤一步步操作就行。

包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。带你从零基础系统性的学好大模型!

现在这份资料免费分享给大家,有需要的小伙伴,直接VX扫描下方二维码就能领取啦😝↓↓↓

为什么要学习大模型?

数据显示,2023 年我国大模型相关人才缺口已突破百万,这一数字直接暴露了人才培养体系的严重滞后与供给不足。而随着人工智能技术的飞速迭代,产业对专业人才的需求将呈爆发式增长,据预测,到 2025 年这一缺口将急剧扩大至 400 万!!

大模型学习路线汇总

整体的学习路线分成L1到L4四个阶段,一步步带你从入门到进阶,从理论到实战,跟着学习路线一步步打卡,小白也能轻松学会!

大模型实战项目&配套源码

光学理论可不够,这套学习资料还包含了丰富的实战案例,让你在实战中检验成果巩固所学知识

大模型学习必看书籍PDF

我精选了一系列大模型技术的书籍和学习文档(电子版),它们由领域内的顶尖专家撰写,内容全面、深入、详尽,为你学习大模型提供坚实的理论基础。

大模型超全面试题汇总

在面试过程中可能遇到的问题,我都给大家汇总好了,能让你们在面试中游刃有余

这些资料真的有用吗?

这份资料由我和鲁为民博士(北京清华大学学士和美国加州理工学院博士)共同整理,现任上海殷泊信息科技CEO,其创立的MoPaaS云平台获Forrester全球’强劲表现者’认证,服务航天科工、国家电网等1000+企业,以第一作者在IEEE Transactions发表论文50+篇,获NASA JPL火星探测系统强化学习专利等35项中美专利。本套AI大模型课程由清华大学-加州理工双料博士、吴文俊人工智能奖得主鲁为民教授领衔研发。

资料内容涵盖了从入门到进阶的各类视频教程和实战项目,无论你是小白还是有些技术基础的技术人员,这份资料都绝对能帮助你提升薪资待遇,转行大模型岗位。

👉获取方式:

😝有需要的小伙伴,可以保存图片到VX扫描下方二维码免费领取【保证100%免费】

相信我,这套大模型系统教程将会是全网最齐全 最适合零基础的!!

更多推荐

已为社区贡献226条内容

已为社区贡献226条内容

所有评论(0)