盘点六个超火的开源智能体开发平台,横向对比,哪个更适合你的场景

本文旨在对六个领先的开源智能体平台进行全面的比较分析,它们分别是:Dify、n8n、Ragflow、FastGPT、Flowise 和 Langflow。通过对它们的功能、易用性、可扩展性和适用场景进行深入探讨,本文旨在为技术专业人员和业务决策者提供选择最适合其需求的平台的指导。

1. 引言:开源智能体平台

智能体,作为能够感知环境并采取行动以最大化实现其目标的系统,在各行各业的重要性日益凸显。从自动化客户服务到优化复杂的工作流程,智能体的潜力正在被广泛探索和应用。在构建这些智能体的过程中,开源平台因其固有的灵活性、透明性和强大的社区支持而成为越来越受欢迎的选择。本文旨在对六个领先的开源智能体平台进行全面的比较分析,它们分别是:Dify、n8n、Ragflow、FastGPT、Flowise 和 Langflow。通过对它们的功能、易用性、可扩展性和适用场景进行深入探讨,本文旨在为技术专业人员和业务决策者提供选择最适合其需求的平台的指导。

- 平台深度解析

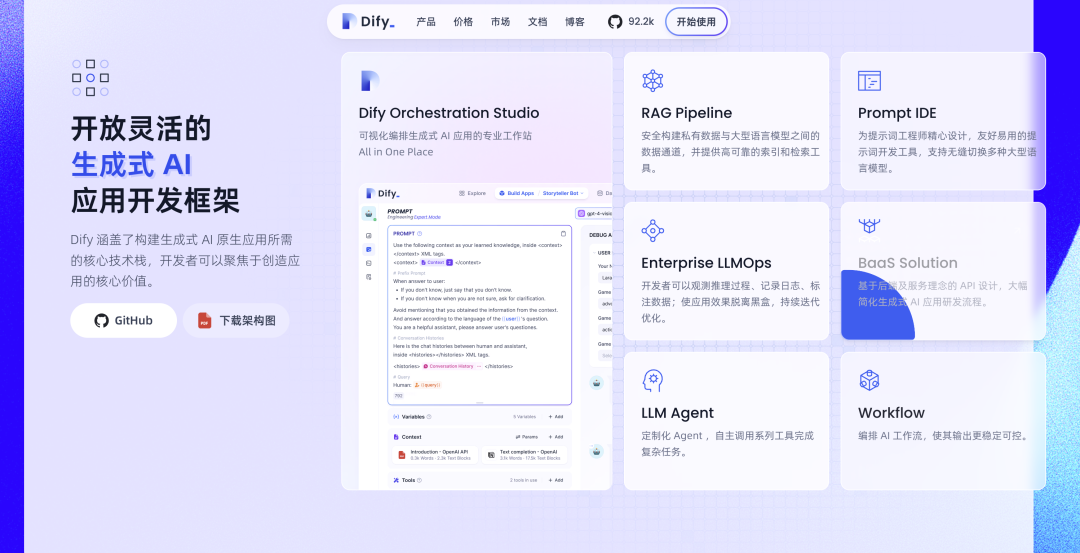

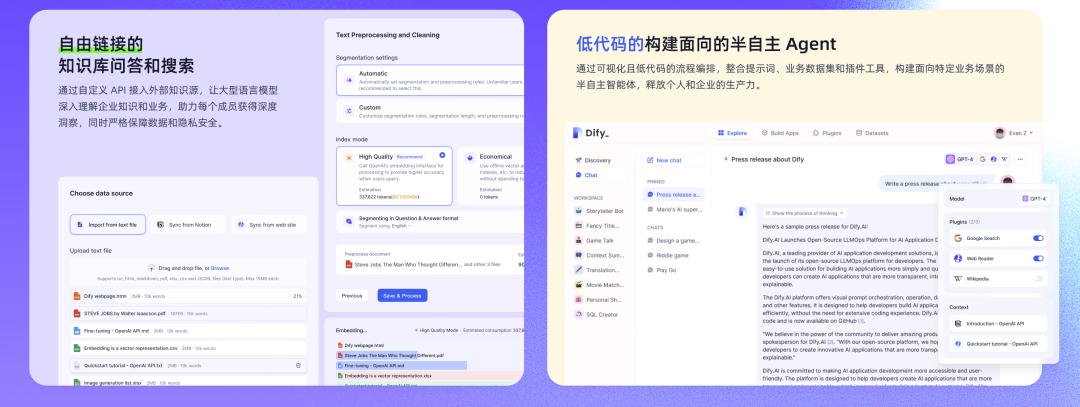

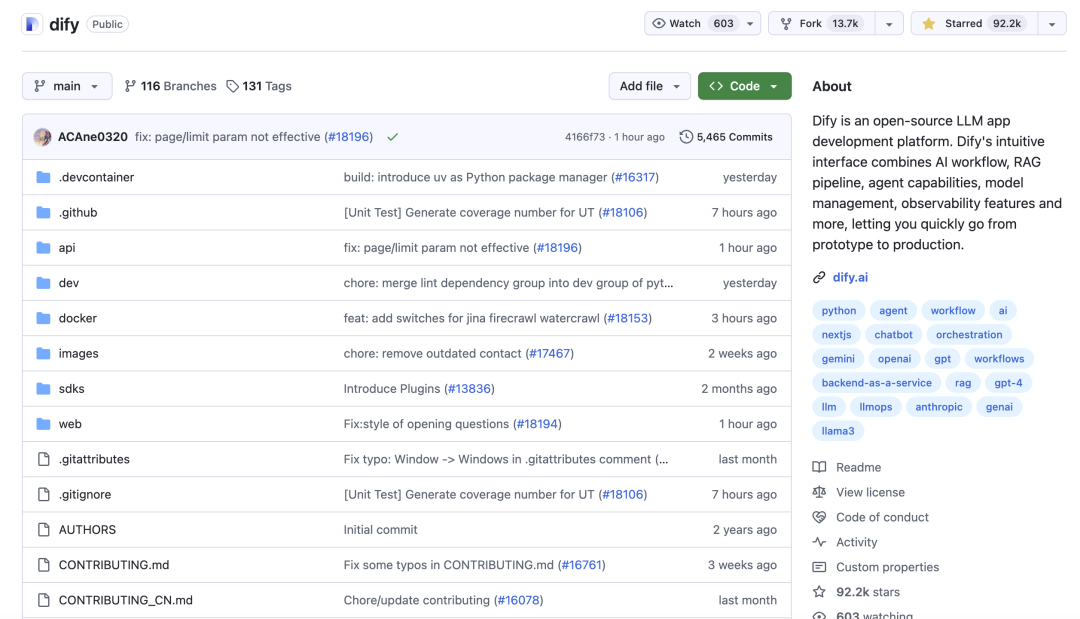

2.1. Dify

概览:**Dify 是一个开源的 LLM 应用开发平台,其目标是简化生成式 AI 应用的开发流程,提升开发效率。它强调将后端即服务(BaaS)与 LLMOps 的概念相结合,旨在提供一个更易于生产部署的解决方案,并声称在生产就绪**方面优于 LangChain。

主要功能:

- 可视化编排工作室: Dify 提供了一个一体化的工作空间,用户可以通过直观的拖拽界面来设计 AI 应用。这种可视化的特性降低了编程门槛,使得不具备深厚编码经验的用户也能快速上手构建复杂的应用流程。

- RAG 管道: 平台内置了**检索增强生成(RAG)**引擎,能够为 LLM 提供可靠的数据来源,从而增强应用的知识性和准确性。RAG 管道涵盖了从文档摄取到检索的整个流程,并支持从常见的文档格式(如 PDF 和 PPT)中提取文本。

- Prompt IDE: Dify 提供了一个专门的 Prompt 集成开发环境,用户可以在此设计、测试和优化应用的提示词。这个 IDE 能够帮助用户比较不同模型的性能,并添加诸如文本转语音等功能,以增强基于聊天的应用体验。

- LLM 代理能力: 用户可以基于 LLM 的函数调用或 ReAct 框架定义自定义代理,并为这些代理添加预构建或自定义的工具。Dify 提供了超过 50 个内置的 AI 代理工具,例如 Google 搜索、DALL·E、Stable Diffusion 和 WolframAlpha。

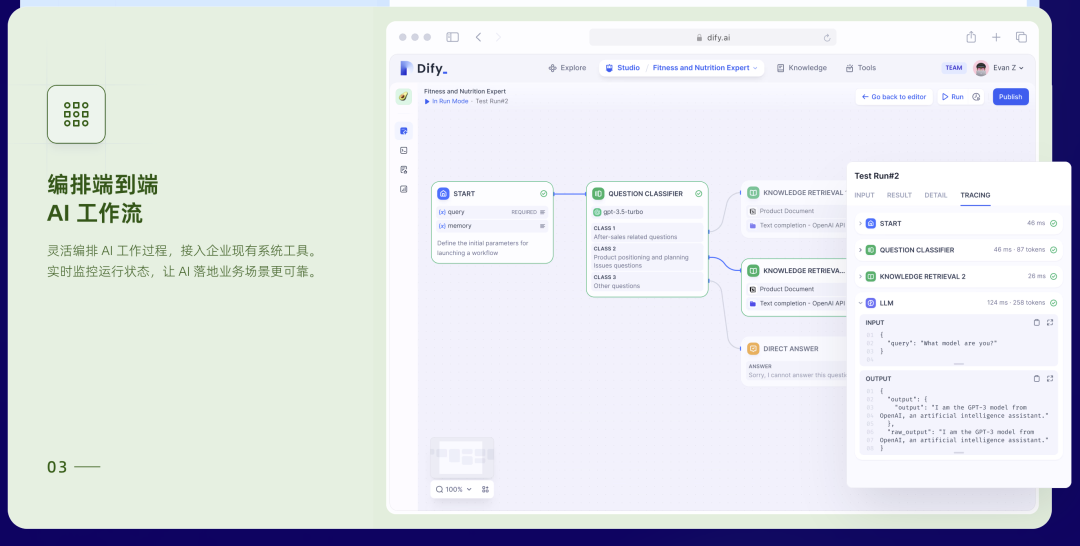

- 工作流编排: Dify 允许用户创建复杂的 AI 工作流程,将不同的组件和功能连接起来,以实现更可靠和可管理的应用效果。用户可以轻松地添加和删除工作流程中的组件,从而灵活地构建满足特定需求的 AI 应用。

- 模型管理: Dify 支持与数百个来自不同推理服务提供商的专有和开源 LLM 进行无缝集成,包括 GPT、Mistral、Llama3 以及任何与 OpenAI API 兼容的模型。这种广泛的模型支持为用户提供了极大的灵活性,避免了对特定供应商的依赖。

- 插件市场: Dify 拥有一个插件市场,用户可以在此浏览、搜索和一键安装各种插件,以扩展平台的功能。开发者也可以将自己的插件发布到市场中,与其他用户共享,从而促进了社区的贡献和平台的生态发展。

- 后端即服务(BaaS): Dify 的所有功能都提供了相应的 API,使得用户可以轻松地将 Dify 集成到自己的业务逻辑中。这为开发者将 AI 功能嵌入到现有产品或服务中提供了便利。

- 可观测性: Dify 允许用户监控和分析应用日志以及性能随时间的变化,从而能够基于生产数据和用户标注持续改进应用的提示词、数据集和模型。

易用性:Dify 的一个显著特点是其无代码/低代码的特性。平台提供了直观的可视化界面,用户无需具备深厚的编程知识也能创建复杂的代理。此外,Dify 还提供了各种模板和预定义的工作流程,可以帮助用户快速启动项目,并为不同用途的应用(从客户服务聊天机器人到销售助手)提供便利。

可扩展性:Dify 提供了云服务和自托管两种部署选项。自托管版本允许用户在自己的环境中部署平台,从而完全控制数据和安全性。对于有更高可用性要求的场景,Dify 还支持在 Kubernetes 上部署。此外,Dify 还提供了一些企业级特性,以满足大型组织的需求。

适用场景:Dify 适用于各种场景,包括为特定行业构建聊天机器人和 AI 助手,这些助手可以嵌入领域知识,实现人机协作。它还可以用于创意文档生成和长文档摘要。Dify 的低代码工具使得构建满足特定业务需求的定制化代理成为可能,从而提高生产力。此外,Dify 还可以利用企业内部知识库来驱动智能搜索和问答服务。

优势:

- 用户友好的无代码可视化界面。

- 全面的功能集,包括 RAG、代理和工作流程。

- 广泛的 LLM 支持。

- 插件市场提供强大的可扩展性。

- 提供云服务和自托管选项。

- 高度关注生产就绪和企业级特性。

劣势:

- 由于内置了多种模型,可能需要更多的计算资源。

官方链接:

- 官方网站:https://dify.ai/

- GitHub 仓库:https://github.com/langgenius/dify

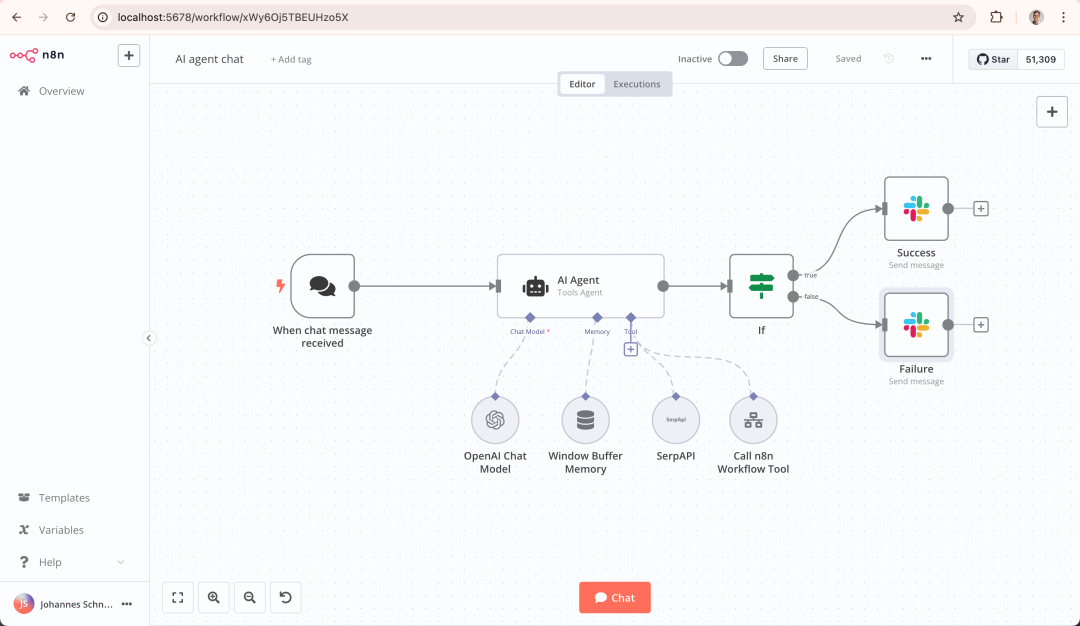

2.2. n8n

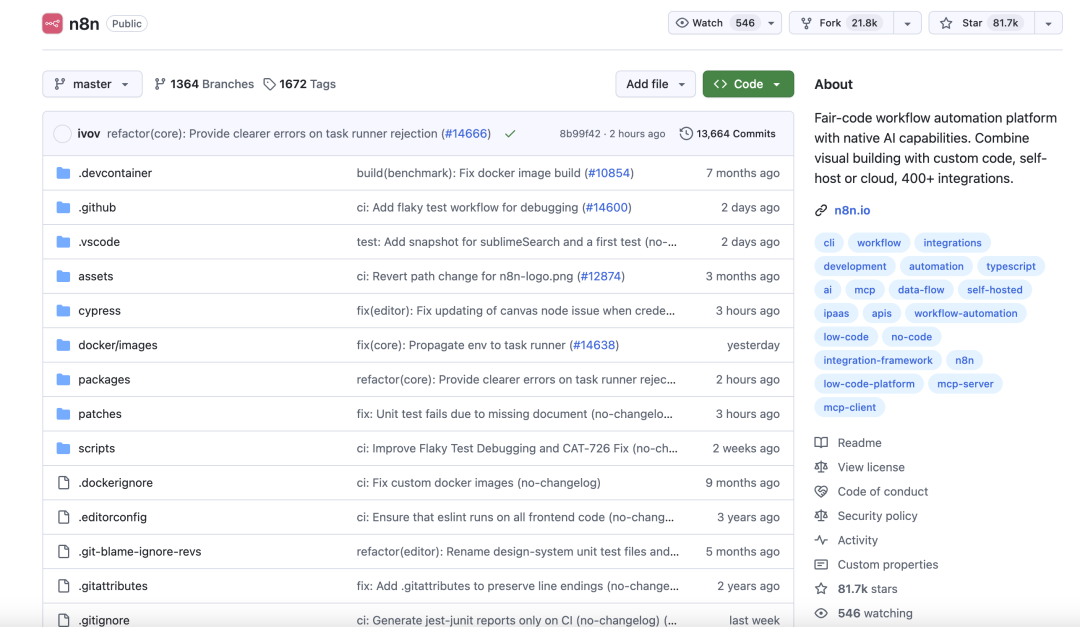

概览:**n8n 是一个采用公平代码许可的开源工作流程自动化平台**。它以其灵活性而著称,既提供了可视化的拖拽界面,也支持通过代码来创建自动化流程。n8n 专注于与其他应用和服务进行集成,目前已支持超过 400 个不同的节点。

n8n

主要功能:

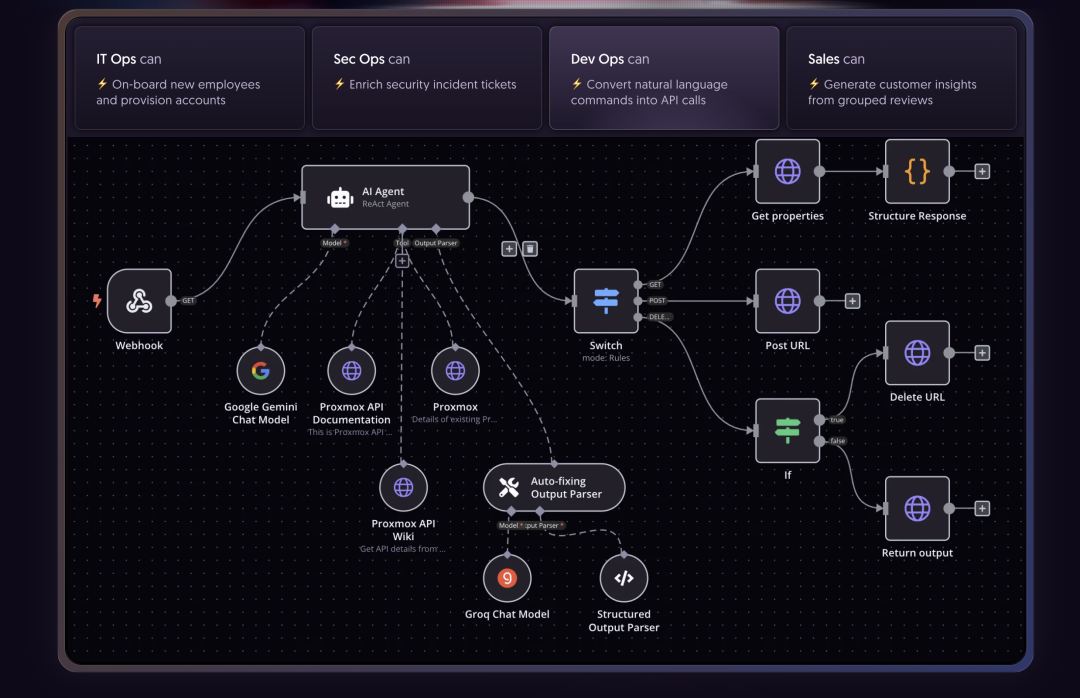

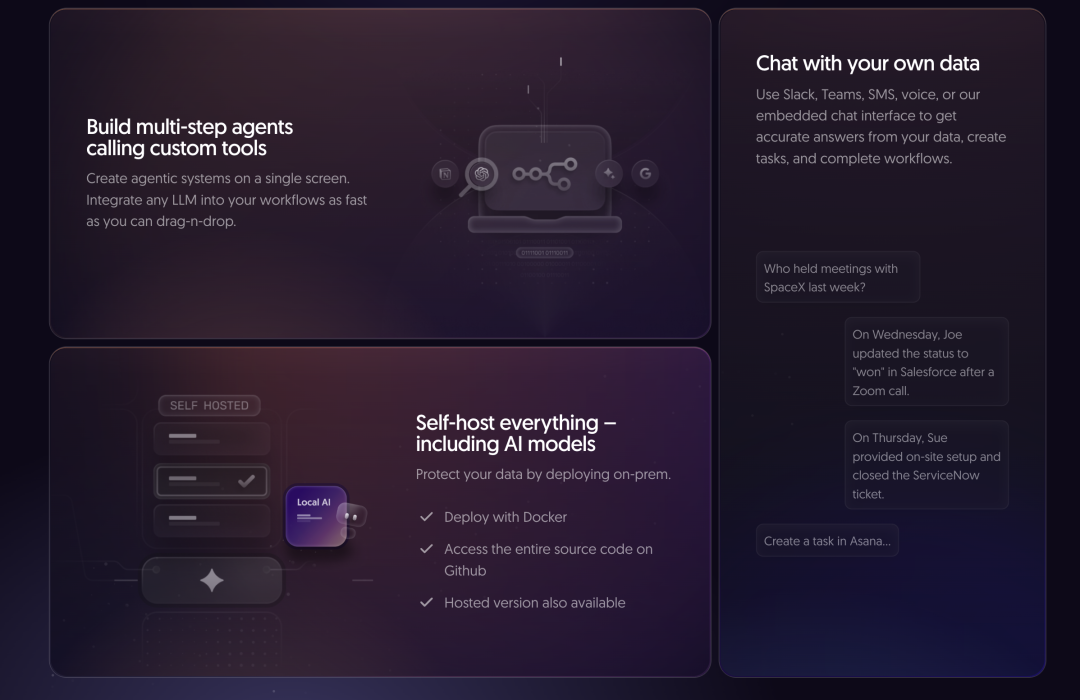

- 可视化工作流程构建器: n8n 提供了一个基于节点的界面,用户可以通过连接不同的节点来创建自动化工作流程。这种可视化的方式使得用户能够清晰地理解和管理复杂的自动化流程。

- 广泛的集成: n8n 拥有庞大的集成库(超过 400 个节点),支持与各种应用程序和服务进行连接。这使得用户能够轻松地将不同的系统整合到他们的自动化流程中。

- 代码灵活性: n8n 允许用户在工作流程中编写 JavaScript 或 Python 代码。这种混合方法为用户提供了在需要时进行高级自定义和控制的能力。

- AI 原生平台: n8n 支持基于 LangChain 构建 AI 代理工作流程,允许用户集成自己的数据和模型。这表明 n8n 非常重视将先进的 AI 功能融入到自动化流程中。

- 自托管选项: 用户可以选择自托管 n8n,包括 AI 模型,从而通过本地部署来保护数据安全。n8n 的完整源代码在 GitHub 上公开,同时也提供了云服务版本。

- 模板库: n8n 提供了超过 900 个预构建的工作流程模板,可以显著加快自动化流程的创建速度。这些模板覆盖了各种常见的自动化场景,用户可以直接使用或根据需要进行修改。

- 调试和迭代工具: n8n 提供了强大的工具来测试和优化工作流程。用户可以重新运行单个步骤、回放或模拟数据,并通过内联日志进行快速调试。

易用性:n8n 提供了一个可视化的拖拽界面,用于构建工作流程。大量的模板和示例为用户提供了一个快速学习和入门的途径。对于需要更复杂逻辑的用户,n8n 还提供了使用代码的选项。

可扩展性:****自托管的 n8n 实例可以根据用户的基础设施进行扩展。n8n 的云服务版本则提供了托管的可扩展性。此外,n8n 还提供了一些企业级特性,例如高级权限和单点登录(SSO),表明它能够满足大型组织的需求。

适用场景:n8n 适用于各种自动化场景,包括跨不同部门(如 IT、安全运营、开发运营和销售)的通用工作流程自动化。它还可以用于构建 AI 代理,并将 LLM 与自定义工具集成。n8n 也常用于数据集成和转换,以及通过嵌入式解决方案为客户提供自动化能力。

优势:

- 灵活的工作流程创建方式,既支持可视化也支持代码。

- 庞大的集成库。

- AI 原生,与 LangChain 集成。

- 提供自托管和云服务选项。

- 拥有大量的预构建工作流程模板。

- 具备企业级特性。

劣势:

- 自托管实例的 Webhook 需要能够从互联网访问(除非使用隧道服务)。

官方链接:

- 官方网站:https://n8n.io/

- GitHub 仓库:https://github.com/n8n-io/n8n

n8n.io - Screenshot

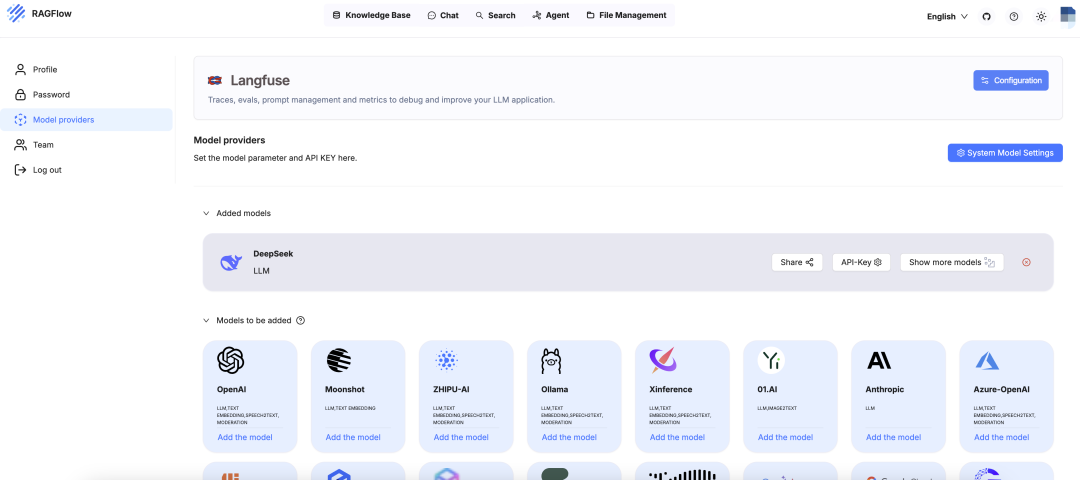

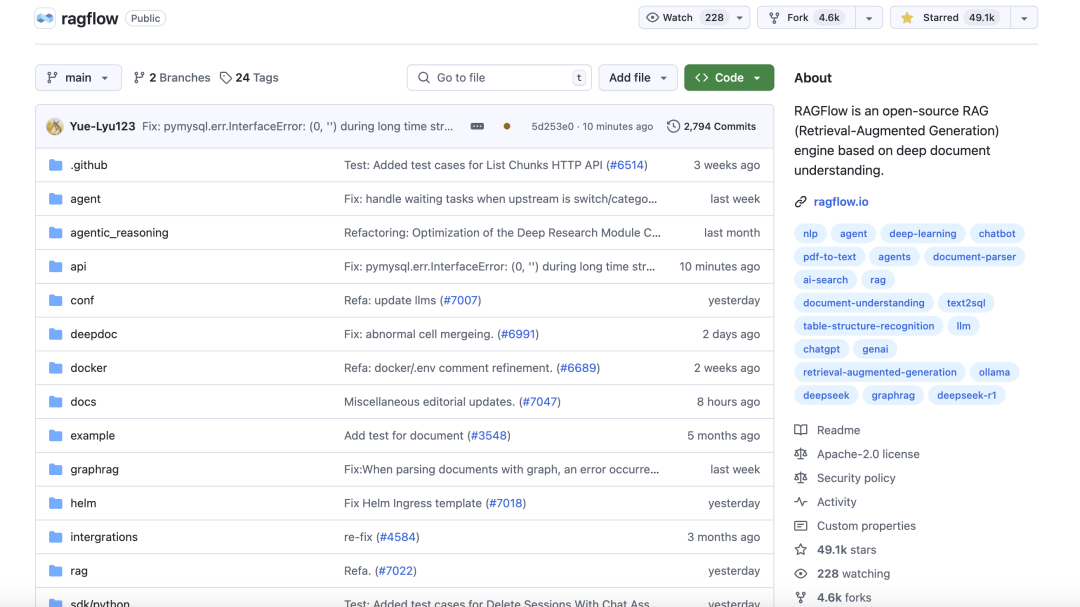

2.3. Ragflow

概览:**Ragflow 是一个开源的检索增强生成(RAG)引擎**,专注于深度文档理解。其目标是提供基于充分引用的真实问答能力。Ragflow 兼容各种数据格式和 LLM。

Ragflow

主要功能:

- 深度文档理解: Ragflow 强调从复杂的非结构化数据中提取高质量知识。它旨在从海量数据中找到特定的信息。

- 基于模板的分块: Ragflow 提供智能且可解释的模板选项用于数据分块。这种方法允许用户根据文档结构定制分块策略,以优化检索效果。

- 基于引用的答案: Ragflow 的一个关键特性是提供可追溯的答案引用,从而减少幻觉并提高答案的可靠性。用户可以查看支持答案的原始文本片段,从而验证信息的准确性。

- 异构数据源兼容性: Ragflow 支持多种文件格式,包括 PDF, DOCX, TXT, MD, CSV, XLSX, XLS, JPEG, JPG, PNG, TIF, GIF, PPT, PPTX。这种广泛的格式支持使得 Ragflow 能够处理各种类型的数据。

- 自动化 RAG 工作流程: Ragflow 为个人用户和大型企业提供了简化的 RAG 流程编排。它允许配置不同的 LLM 和嵌入模型,并采用多重召回机制与融合重排序相结合,同时提供直观的 API 以方便集成。

- 可配置的 LLM 和嵌入模型: Ragflow 允许用户灵活地选择和配置不同的 LLM 和嵌入模型。这使得用户可以根据具体需求和成本考虑来优化性能。

- GraphRAG 能力: Ragflow 支持构建知识图谱以增强检索效果。GraphRAG 可以发现数据中隐藏的关系,从而提高答案的准确性和相关性。

- 本地 LLM 部署支持: Ragflow 支持使用 Ollama 和 Xinference 等工具在本地部署 LLM。这为用户提供了更高的隐私性和对模型的控制权,并减少了对外部 API 的依赖。

- 多模态支持: Ragflow 能够理解文档中的图像。这扩展了 Ragflow 可以有效处理的文档类型,使其能够处理包含文本和图像的复杂文档。

易用性:Ragflow 提供了一个基于 Web 的用户界面,用户可以通过浏览器访问和操作。平台提供了快速入门指南和完善的文档,帮助用户快速上手。此外,Ragflow 还提供了一个演示环境,用户可以在此体验平台的功能。

可扩展性:Ragflow 支持部署在各种云平台和本地环境。它能够处理大型数据集和高并发应用。Ragflow 还集成了 Infinity 和 Elasticsearch 等数据库用于向量存储和全文索引,这些数据库具有良好的可扩展性。

适用场景:Ragflow 适用于处理大型数据集的文档问答。它也适用于需要从知识库中检索信息的研究和行业特定需求。Ragflow 可以用于构建具有实时知识访问能力的面向客户的聊天机器人,以及用于企业内部知识库和企业搜索。

优势:

- 在深度文档理解和处理复杂数据格式方面表现出色。

- 强大的 RAG 能力,并提供基于引用的答案。

- 支持 GraphRAG 等高级功能。

- 灵活的部署选项,包括本地 LLM 部署。

- 可扩展性强,能够处理高并发和大数据量应用。

劣势:

- 可能需要更多的计算资源。

- 部署过程可能相对复杂。

官方链接:

- 官方网站:https://ragflow.io/

- GitHub 仓库:https://github.com/infiniflow/ragflow

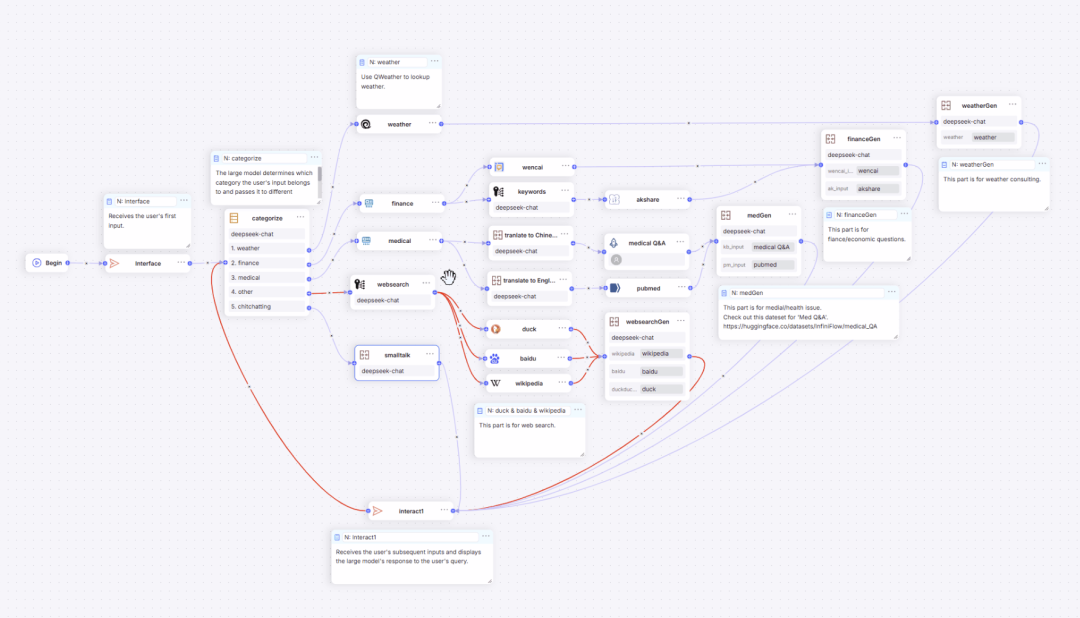

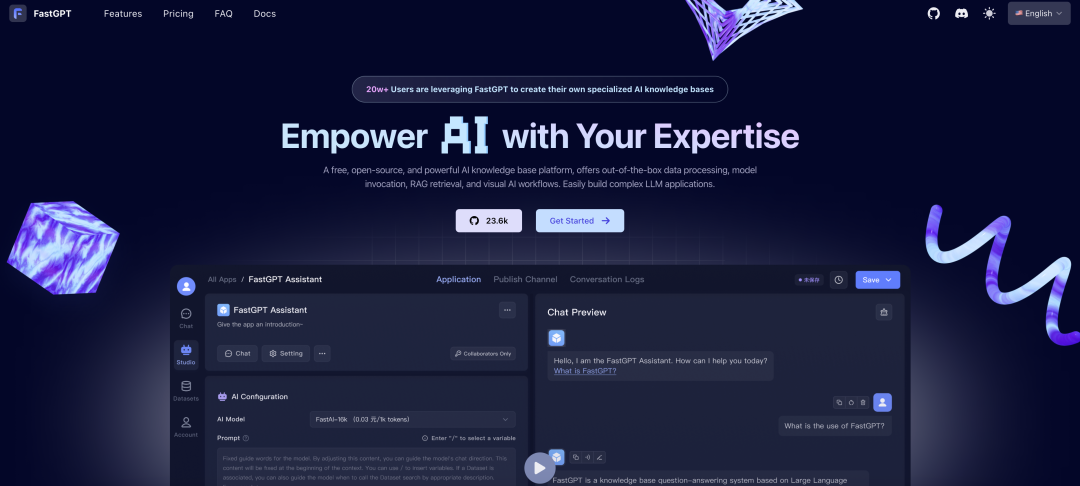

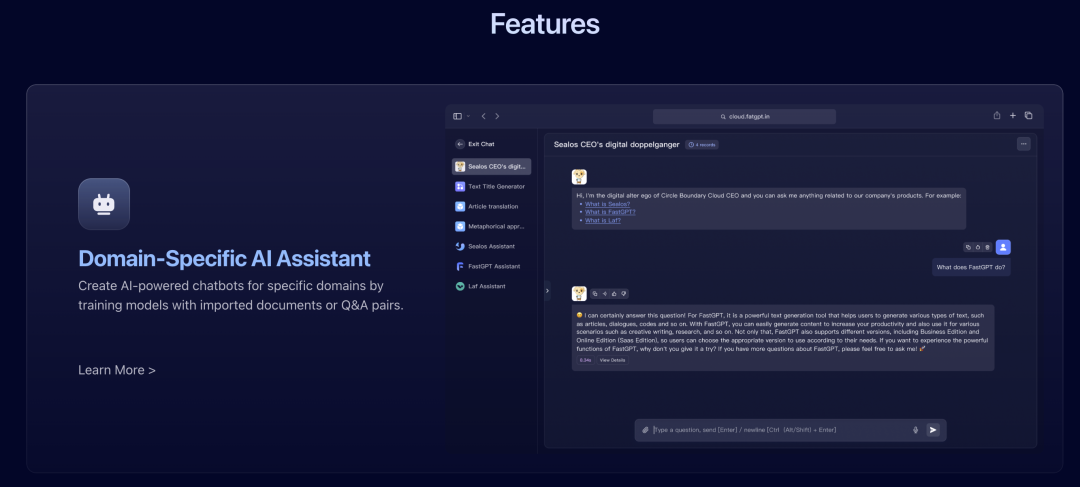

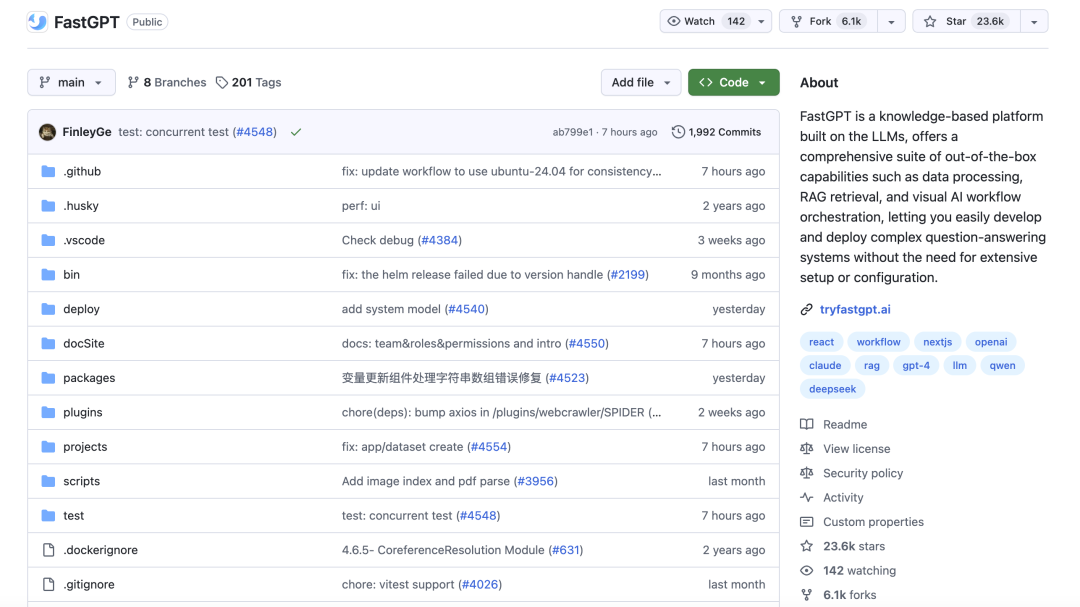

2.4. FastGPT

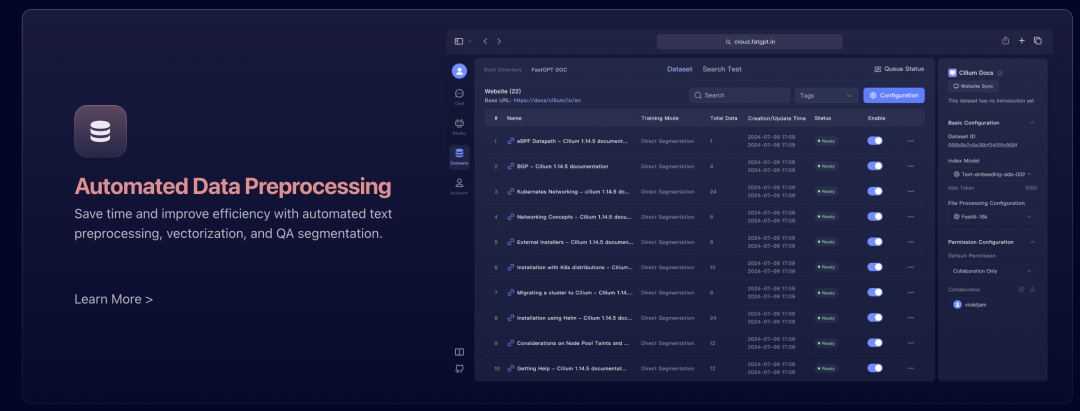

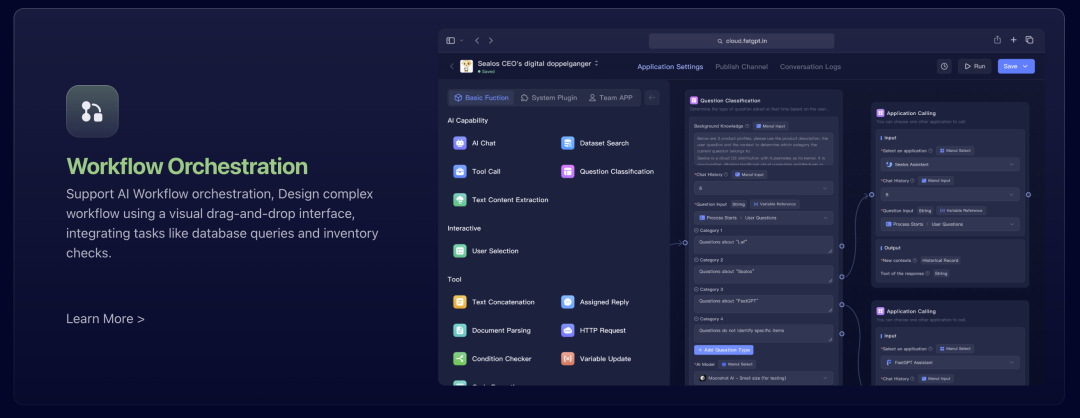

概览:**FastGPT 是一个基于 LLM 构建的知识库平台**。它提供了开箱即用的数据处理、RAG 检索和可视化 AI 工作流程编排能力。FastGPT 的目标是帮助用户轻松构建复杂的问答系统。平台提供开源版本和云服务版本。

FastGPT

主要功能:

- 可视化工作流编排(Flow): FastGPT 提供了一个拖拽式的可视化界面,用于设计复杂的工作流程。用户可以通过连接不同的模块来创建包含数据库查询和外部工具集成的复杂问答流程。

- 知识库管理: FastGPT 提供了丰富的功能来导入和管理来自各种数据源的知识。它支持多种文件格式 (PDF, DOCX, TXT, HTML, MD, CSV),还支持读取 URL 和批量导入 CSV 文件。

- RAG(检索增强生成): FastGPT 内置了 RAG 能力,可以通过外部知识来增强问答效果。这包括多库复用、混合检索和重排序等功能,以提高答案的准确性和相关性。

- 应用调试工具: FastGPT 提供了多种调试工具,帮助用户测试和优化 AI 应用。这些工具包括知识库单点搜索测试、对话时反馈引用并可修改与删除、完整上下文呈现和高级编排 Debug 模式。

- OpenAPI 接口: FastGPT 提供了 OpenAPI 接口,包括 completions 接口(与 GPT 的 chat 模式对齐)以及知识库和对话的 CRUD 操作接口。这使得用户可以方便地将 FastGPT 集成到其他系统中。

- 支持多种模型: FastGPT 支持多种 LLM 模型,包括 GPT、Claude 和文心一言等。用户可以根据自己的需求选择合适的模型。

- 部署选项: FastGPT 提供云服务和自托管(包括 Docker 部署)等多种部署选项,以满足不同用户的需求。

易用性:FastGPT 提供了一个用户友好的可视化界面,用于工作流程编排。它还提供了一个简易模式,无需复杂的编排即可快速上手。对话中清晰的下一步操作提示进一步提升了用户体验。

可扩展性:FastGPT 的云服务版本提供了托管的可扩展性。用户也可以选择自托管 FastGPT,并根据自己的基础设施进行扩展。

适用场景:FastGPT 适用于构建特定领域的 AI 助手和聊天机器人,例如客户服务、内部知识库等。它也可以用于增强客户服务,提供准确的问答。通过其工作流程编排能力,FastGPT 可以自动化涉及数据库查询和外部工具的复杂流程。此外,FastGPT 还支持创建无需登录即可共享的知识库应用。

优势:

- 全面的平台,集成了数据处理、RAG 和工作流程编排。

- 用户友好的可视化界面,用于构建应用和工作流程。

- 支持多种文档格式和数据导入方式。

- 提供 OpenAPI 方便集成。

- 提供云服务和自托管选项。

劣势:

- 本地部署的初始设置可能由于数据库配置而稍慢。

官方链接:

- 官方网站:https://tryfastgpt.ai/

- GitHub 仓库:https://github.com/labring/FastGPT

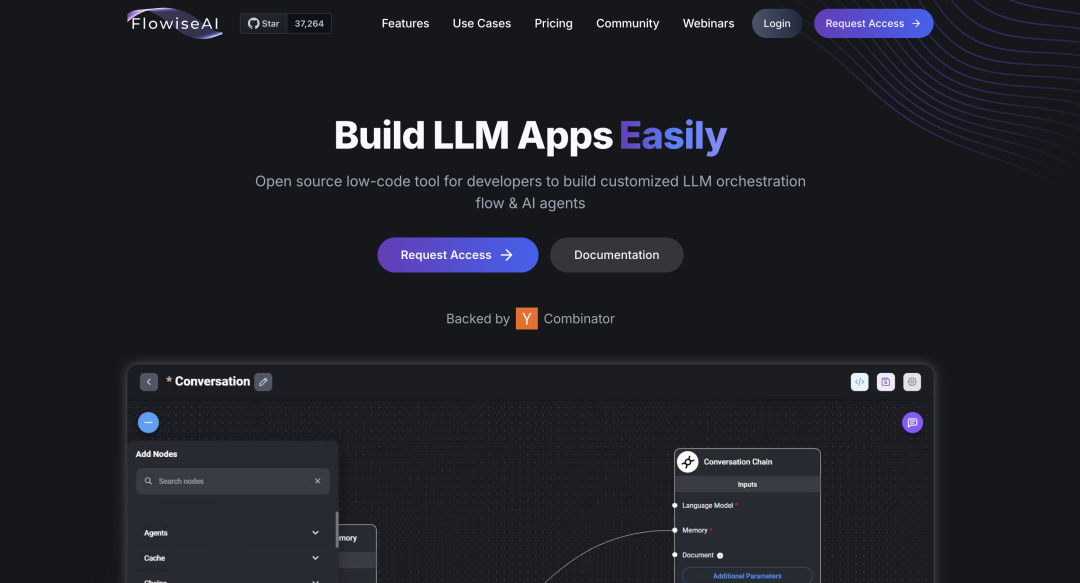

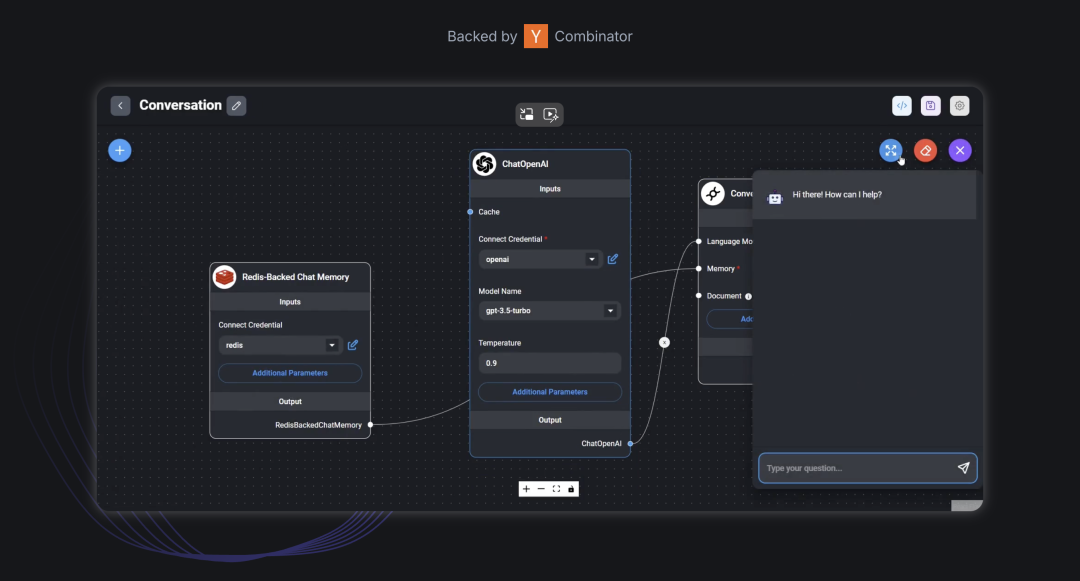

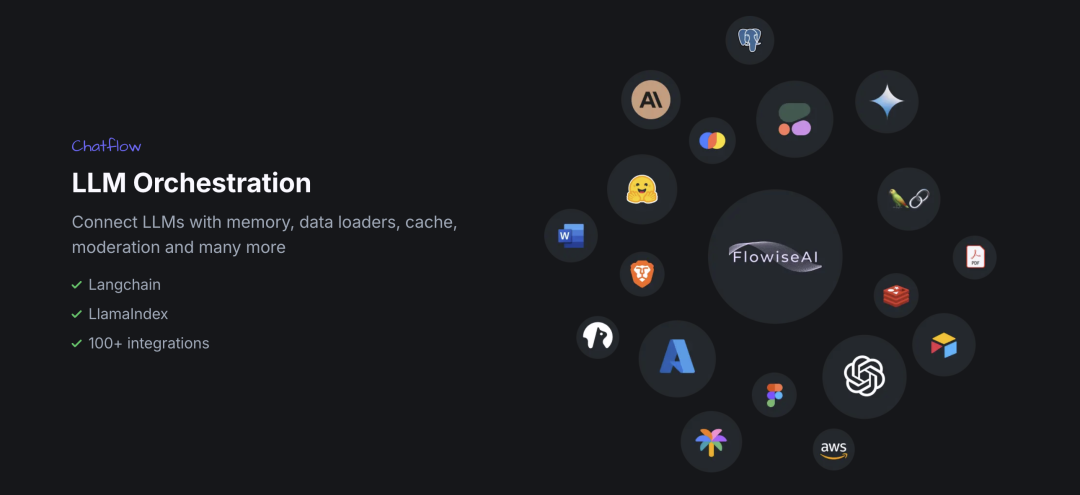

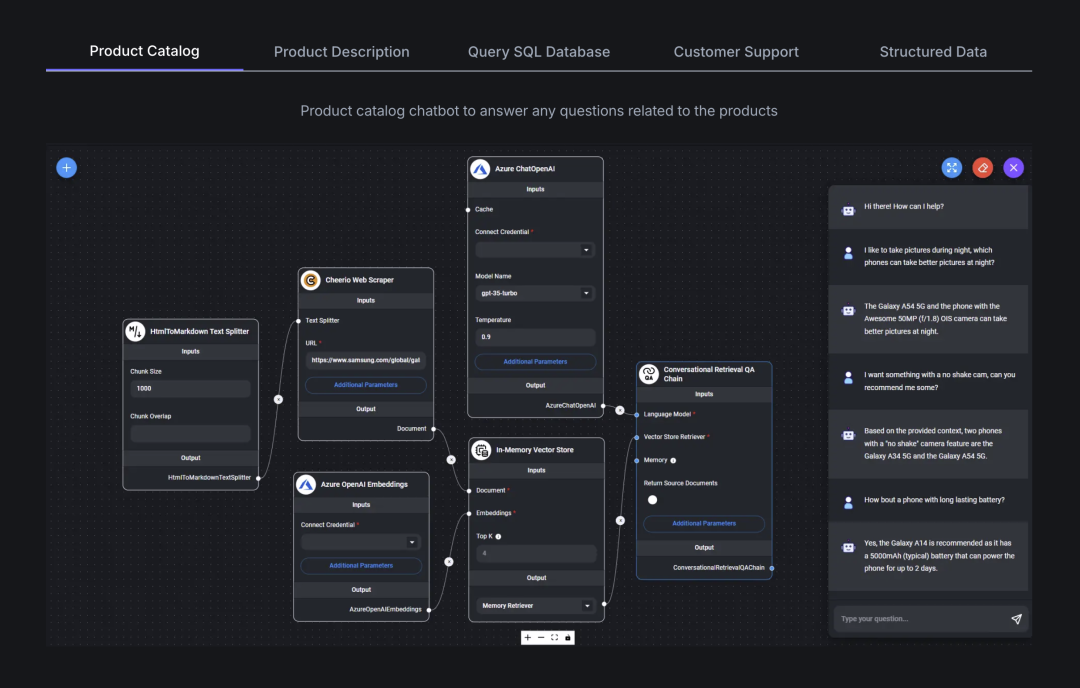

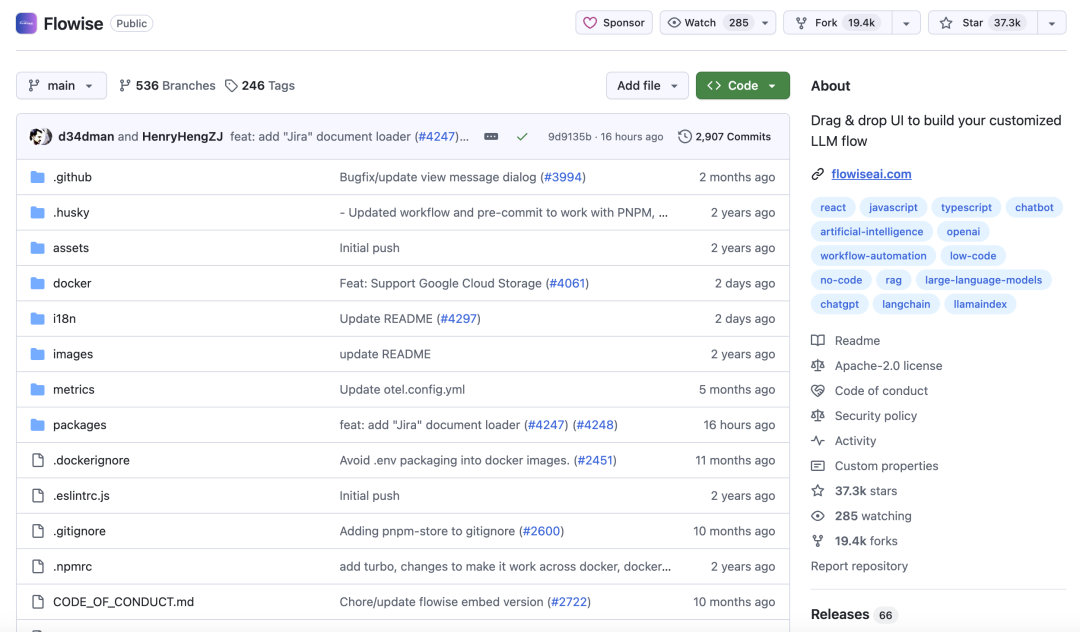

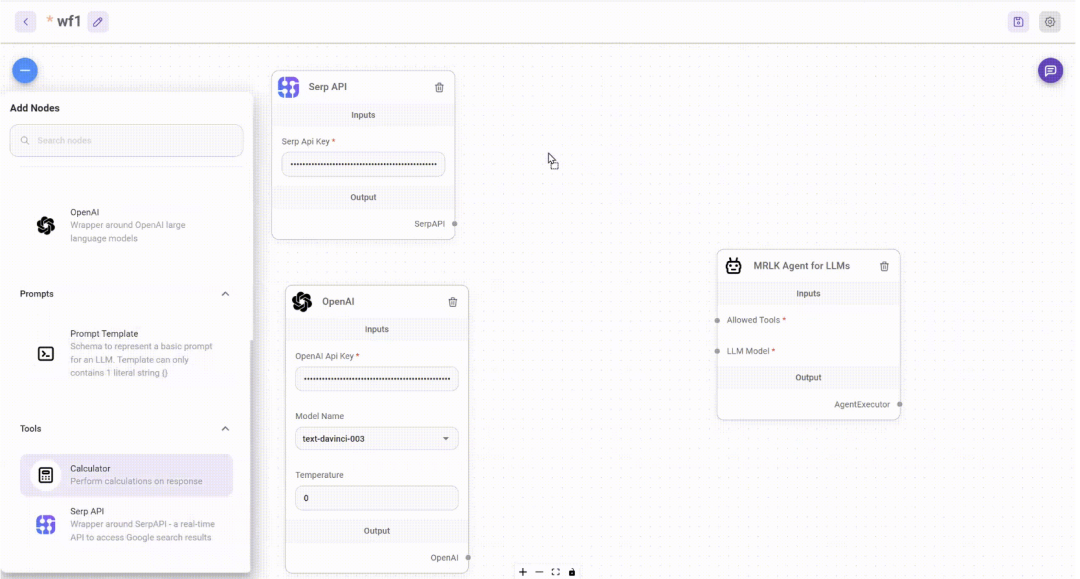

2.5. Flowise

概览:**Flowise 是一个开源的低代码工具**,专为开发者构建自定义的大语言模型(LLM)编排流程和 AI 代理而设计。它提供了一个拖拽式的用户界面,用于创建定制化的 LLM 流程。Flowise 基于 Langchain 和 LlamaIndex 的集成,并提供云服务和自托管两种部署选项。

Langflow

主要功能:

- 拖拽式 UI: Flowise 提供了一个用户友好的拖拽界面,使得构建 LLM 应用变得简单直观。用户可以通过可视化地连接不同的组件来创建复杂的 AI 流程。

- LLM 编排: Flowise 允许用户将 LLM 与各种组件(如内存、数据加载器和缓存)连接起来,以构建上下文感知和功能丰富的 AI 应用。

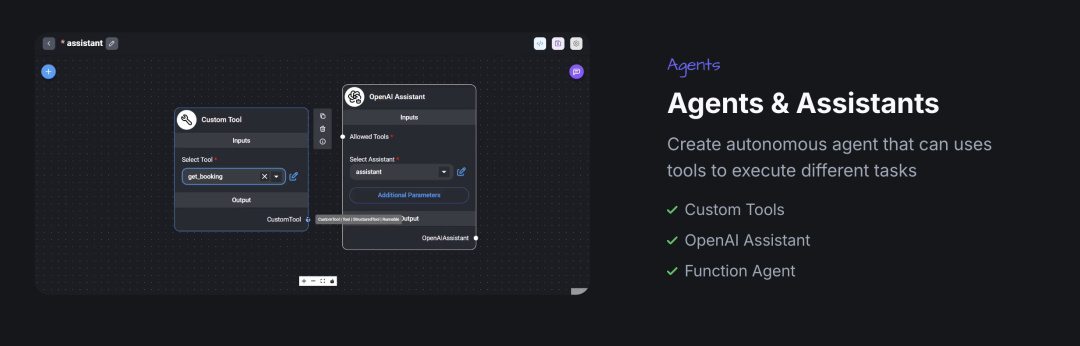

- 代理和助手: 用户可以创建能够使用各种工具自主执行任务的 AI 代理。这包括对自定义工具、OpenAI Assistant 和 Function Agent 的支持。

- 与 Langchain 和 LlamaIndex 集成: Flowise 与流行的 Langchain 和 LlamaIndex 框架无缝集成。这为用户提供了访问这两个框架中大量预构建组件和功能的便利。

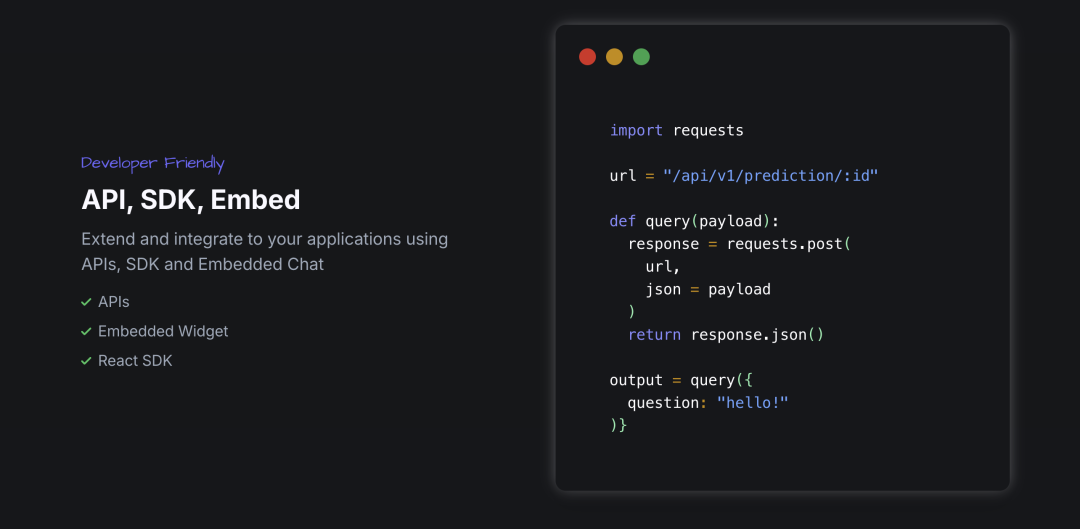

- API、SDK 和嵌入选项: Flowise 提供了 API、SDK(包括 React SDK)和嵌入式聊天小部件等多种方式,方便开发者将其功能集成到现有应用中。

- 支持开源 LLM: Flowise 兼容多种开源 LLM 和平台,如 Llama2, Mistral, Vicuna, Orca, HuggingFace, Ollama, LocalAI。这为用户提供了更多的模型选择和部署灵活性。

- 工具市场: Flowise 提供了一个工具市场,用户可以在此找到各种可以直接使用的工具,例如搜索 API 和计算器。这简化了向 AI 代理添加功能的流程。

易用性:Flowise 拥有直观的拖拽式可视化界面。通过 npm 可以快速安装。活跃的社区和不断增长的生态系统也为用户提供了丰富的学习资源和示例。

可扩展性:Flowise 支持在各种云平台和本地环境进行自托管,用户可以根据自己的需求扩展基础设施。Flowise 还提供了云服务版本,实现了托管的可扩展性。此外,Flowise 还提供了企业级计划,支持本地部署和高级功能。

适用场景:Flowise 适用于构建各种类型的聊天机器人(如客户支持、产品目录等)。它还可以用于查询数据库和处理结构化数据,创建 AI 个性化机器人和项目管理工具,以及构建 RAG 应用以实现与文档的交互。

优势:

- 高度用户友好,提供拖拽式界面。

- 与 Langchain 和 LlamaIndex 深度集成。

- 支持广泛的开源 LLM。

- 提供 API、SDK 和嵌入选项,方便集成。

- 灵活的部署选项,包括云服务和自托管。

- 拥有活跃的社区和不断增长的生态系统。

劣势:

- 自托管需要一定的技术水平进行设置和维护。

官方链接:

- 官方网站:https://flowiseai.com/

- GitHub 仓库:https://github.com/FlowiseAI/Flowise

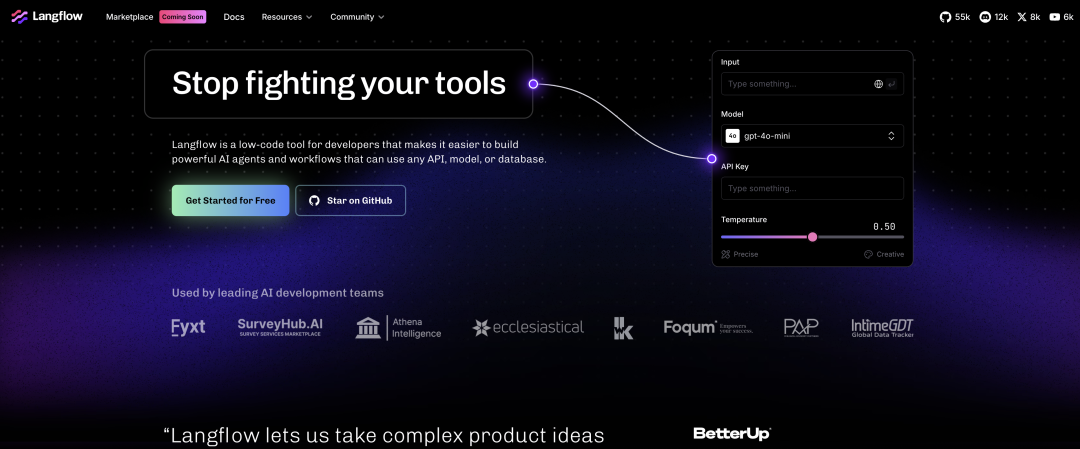

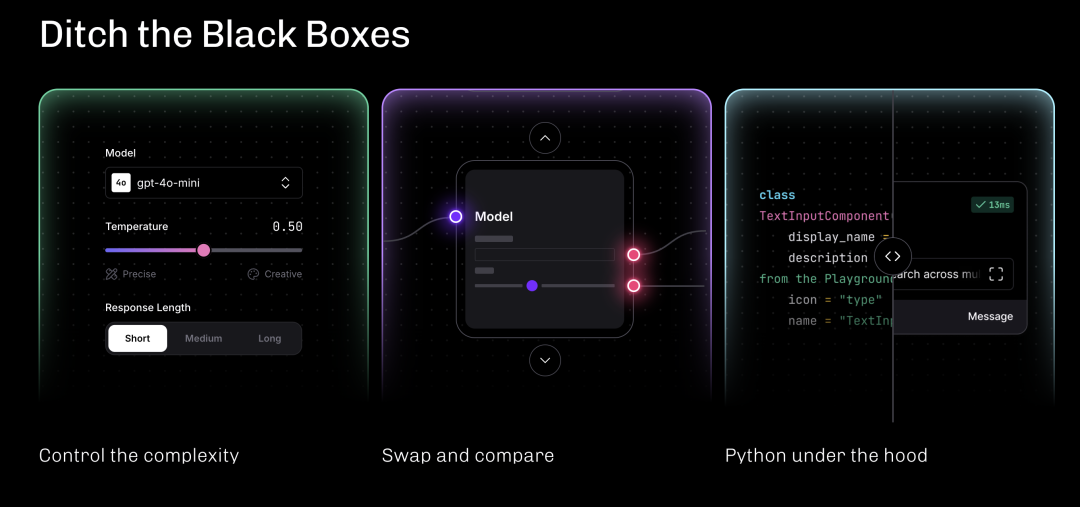

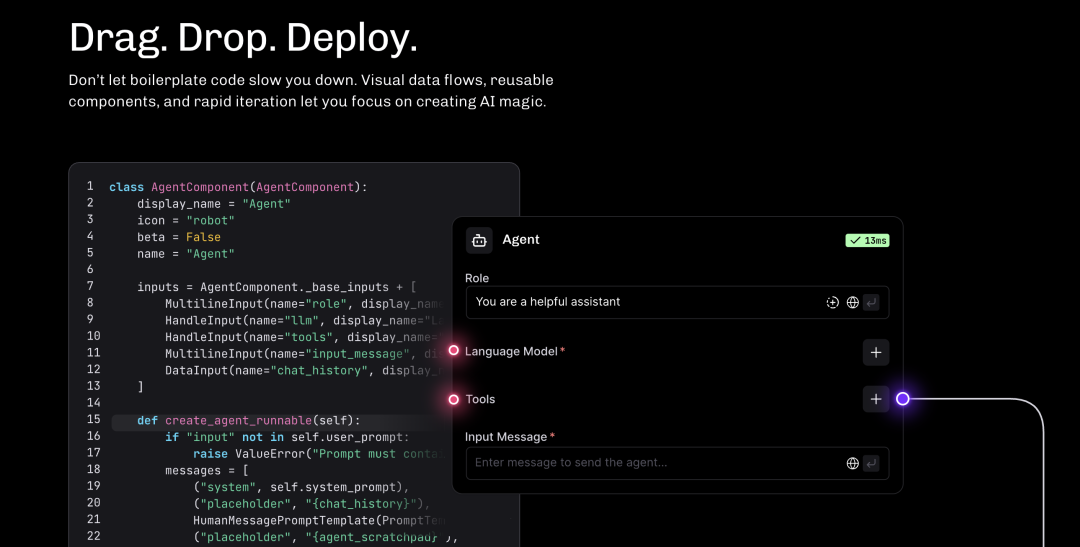

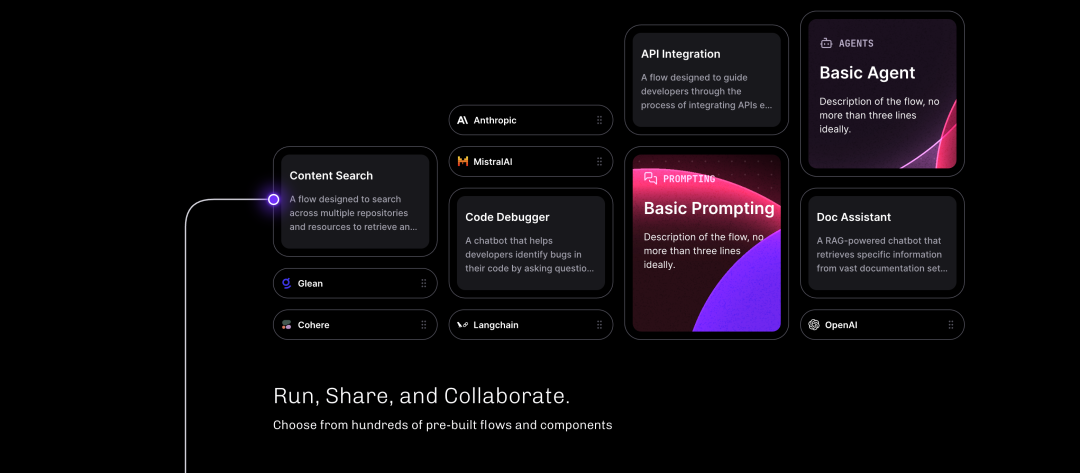

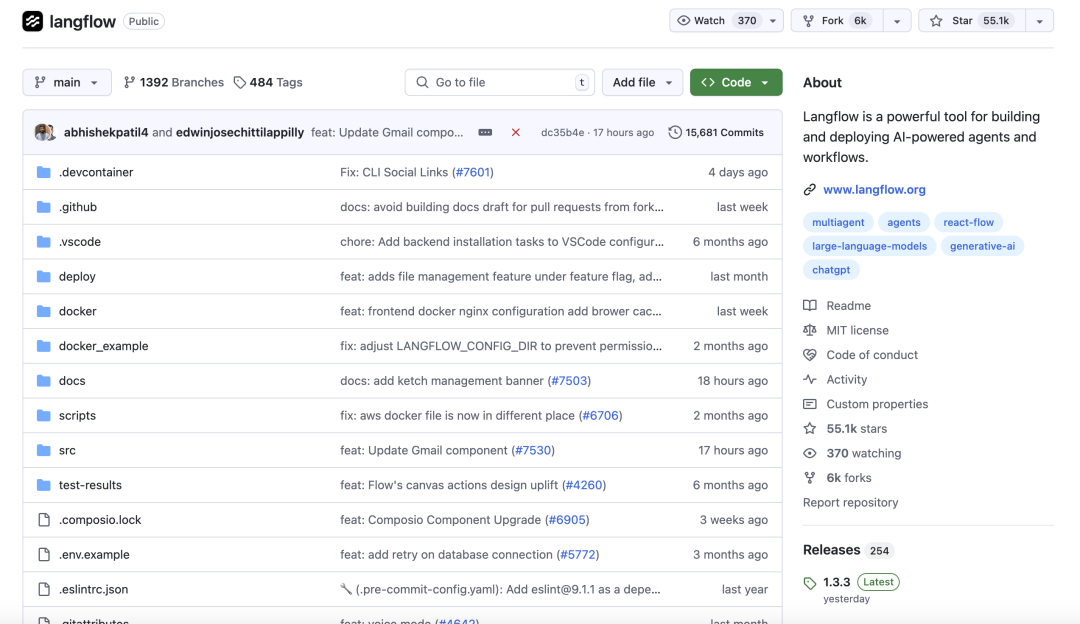

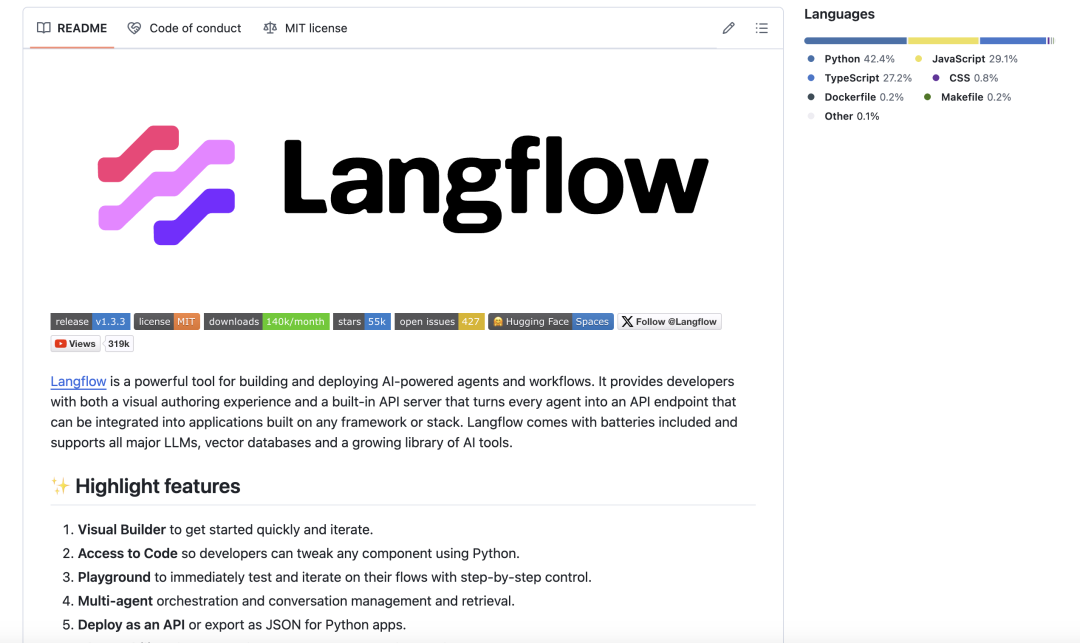

2.6. Langflow

概览:**Langflow 是一个低代码 AI 构建工具**,专注于代理式和 RAG 应用的开发。它提供了一个可视化的界面,用于构建 AI 代理和工作流程。Langflow 基于 LangChain 构建,并能够将每个代理转化为一个 API 端点。

Langflow

主要功能:

- 可视化构建器: Langflow 提供了一个拖拽式的可视化界面,用于创建 AI 流程。这使得用户能够轻松地设计和原型化 LangChain 管道。

- 与 LangChain 集成: Langflow 的核心是作为 LangChain 的一个用户界面。它充分利用了 LangChain 框架的强大功能。

- 代理和工作流程创建: Langflow 支持构建各种 AI 代理和复杂的工作流程。这使得用户能够开发广泛的 AI 驱动应用。

- Python 自定义: Langflow 允许开发者使用 Python 代码自定义组件,从而扩展平台的功能。

- 部署为 API: Langflow 可以将构建的流程部署为 API 端点。这使得将 Langflow 构建的 AI 功能集成到其他应用中变得非常简单。

- 预构建组件和流程: Langflow 提供了大量的可重用组件和预配置流程。这有助于加速开发过程。

- 与可观测性工具集成: Langflow 与 LangSmith 和 LangFuse 等工具集成,用于监控 AI 代理和工作流程的性能。

易用性:Langflow 提供了一个简单易用的可视化界面,用户可以通过拖拽组件来构建 AI 管道。内置的 API 服务器简化了部署过程。不断增长的预构建流程和组件库也使得用户能够快速上手。

可扩展性:Langflow 可以部署在包括云平台(如 DataStax Langflow)和自托管环境在内的各种平台上。它在设计时就考虑了安全性和可扩展性,以满足企业级应用的需求。

适用场景:Langflow 适用于构建各种 AI 代理和工作流程,特别是那些需要利用 LangChain 功能的应用。它也常用于开发 RAG 应用,以及原型化和实验 LangChain 管道。此外,Langflow 还可以用于创建基于先进技术的定制化数据解决方案。

优势:

- 直观的可视化界面,用于构建 AI 代理和工作流程。

- 与强大的 LangChain 框架深度集成。

- 提供 Python 自定义功能,满足高级用户的需求。

- 方便地将流程部署为 API 端点。

- 拥有庞大且活跃的社区。

劣势:

- 主要专注于 LangChain 生态系统,对于偏好其他框架的用户可能存在限制。

官方链接:

- 官方网站:https://www.langflow.org/

- GitHub 仓库:https://github.com/langflow-ai/langflow

- 对比分析:平台概览

下表总结了六个开源智能体平台的主要特性,以便进行更直观的比较:

| 特性 | Dify | n8n | Ragflow | FastGPT | Flowise | Langflow |

|---|---|---|---|---|---|---|

| 核心关注点 | LLM 应用开发、RAG、代理 | 工作流程自动化、AI 代理 | RAG 引擎、深度文档理解 | 知识库、RAG、工作流程编排 | LLM 编排、AI 代理 | AI 代理与工作流程 (LangChain) |

| 易用性 | 可视化、无代码/低代码 | 可视化 & 代码 | Web UI | 可视化、简易模式 | 可视化、低代码 | 可视化、低代码 |

| 可扩展性 | 云服务、自托管、Kubernetes | 云服务、自托管、企业级特性 | 云服务、自托管、企业级就绪 | 云服务、自托管 | 云服务、自托管、企业级就绪 | 云服务、自托管、企业级就绪 |

| 集成 | 广泛的 LLM 支持、插件市场 | 400+ 集成、LangChain | LLM、嵌入模型 | OpenAI 对齐 API、多种 LLM | Langchain、LlamaIndex、开源 LLM | LangChain |

| 自定义 | Prompts、代理、工作流程、插件 | JavaScript/Python 代码、自定义节点 | 分块模板、API | 可视化工作流程、API | 可视化流程、自定义节点、API、SDK | 可视化流程、Python 代码、自定义组件 |

| 社区 | 活跃的 GitHub、Discord、Twitter | 活跃的论坛、GitHub | GitHub、Discord、Twitter | 活跃的 GitHub、飞书 | 活跃的 GitHub、Discord | 活跃的 GitHub、Discord、Twitter、YouTube |

- 选择合适的平台:建议与指导

选择合适的开源智能体平台取决于项目的具体需求、技术栈和团队的专业知识。以下是一些基于不同使用场景和要求的建议:

- 对于优先考虑易用性和快速原型设计的用户: Dify 和 Flowise 由于其强大的可视化界面,可能是更合适的选择。它们都提供了直观的拖拽功能,使得用户能够快速构建和测试 AI 应用。

- 对于需要广泛集成和灵活工作流程自动化的用户: n8n 以其大量的集成和同时支持可视化和代码的方式而脱颖而出。这使得 n8n 能够连接各种不同的系统,并处理复杂的自动化需求。

- 对于高度关注知识库应用和深度文档理解的用户: Ragflow 和 FastGPT 是强大的竞争者,它们都提供了先进的 RAG 功能。Ragflow 尤其擅长处理复杂的文档格式,而 FastGPT 则提供了全面的知识库管理和可视化的工作流程编排。

- 对于在 LangChain 生态系统中投入较多的用户: Langflow 提供了与 LangChain 的无缝集成,并提供了一种可视化的方式来构建 LangChain 应用。这使得 Langflow 成为那些希望利用 LangChain 的强大功能但又希望降低开发复杂性的用户的理想选择。

在选择平台时,还需要考虑技术专长、项目复杂性、可扩展性要求和预算等因素。例如,对于技术团队来说,n8n 和 Langflow 提供的代码自定义选项可能更具吸引力,而对于非技术用户来说,Dify 和 Flowise 的无代码界面可能更容易上手。

下表总结了每个平台的优势和劣势,以帮助用户做出更明智的决定:

| 平台 | 优势 | 劣势 |

|---|---|---|

| Dify | 用户友好、功能全面、LLM 支持广泛、插件市场、适合生产和企业级应用 | 可能需要更多资源 |

| n8n | 灵活(可视化 & 代码)、集成丰富、AI 原生、支持自托管和云服务、模板库庞大、企业级特性 | 自托管 Webhook 需要互联网访问 |

| Ragflow | 深度文档理解、强大的 RAG 能力、高级功能(GraphRAG)、灵活部署(本地 LLM)、可扩展性强 | 可能需要更多资源、部署可能复杂 |

| FastGPT | 全面(数据处理、RAG、工作流程)、用户友好的可视化界面、支持多种格式、提供 OpenAPI、支持自托管和云服务 | 本地部署初始设置可能稍慢 |

| Flowise | 非常用户友好、与 Langchain & LlamaIndex 集成紧密、支持开源 LLM、提供灵活的集成选项、社区活跃 | 自托管需要一定的技术水平 |

| Langflow | 直观的可视化界面、与 LangChain 深度集成、支持 Python 自定义、易于部署为 API、社区庞大 | 主要专注于 LangChain |

- 结论:开源智能体平台的未来

开源智能体平台领域正在经历快速发展和创新。本文讨论的六个平台 (Dify, n8n, Ragflow, FastGPT, Flowise, Langflow) 都代表了该领域的前沿技术,它们在功能、易用性和可扩展性方面各有侧重。Dify 和 Flowise 致力于通过可视化界面降低 AI 应用开发的门槛;n8n 则专注于提供高度灵活和集成的自动化解决方案;Ragflow 和 FastGPT 在知识密集型应用和深度文档理解方面表现出色;而 Langflow 则为 LangChain 用户提供了一个强大的可视化工具。

选择正确的平台对于项目的成功至关重要。用户应仔细评估其具体需求、团队的技术能力以及平台的长期发展潜力。随着技术的不断进步,我们可以期待这些开源平台将继续演进,提供更强大、更易用的功能,并在更广泛的应用场景中发挥关键作用。

想入门 AI 大模型却找不到清晰方向?备考大厂 AI 岗还在四处搜集零散资料?别再浪费时间啦!2025 年 AI 大模型全套学习资料已整理完毕,从学习路线到面试真题,从工具教程到行业报告,一站式覆盖你的所有需求,现在全部免费分享!

👇👇扫码免费领取全部内容👇👇

一、学习必备:100+本大模型电子书+26 份行业报告 + 600+ 套技术PPT,帮你看透 AI 趋势

想了解大模型的行业动态、商业落地案例?大模型电子书?这份资料帮你站在 “行业高度” 学 AI:

1. 100+本大模型方向电子书

2. 26 份行业研究报告:覆盖多领域实践与趋势

报告包含阿里、DeepSeek 等权威机构发布的核心内容,涵盖:

- 职业趋势:《AI + 职业趋势报告》《中国 AI 人才粮仓模型解析》;

- 商业落地:《生成式 AI 商业落地白皮书》《AI Agent 应用落地技术白皮书》;

- 领域细分:《AGI 在金融领域的应用报告》《AI GC 实践案例集》;

- 行业监测:《2024 年中国大模型季度监测报告》《2025 年中国技术市场发展趋势》。

3. 600+套技术大会 PPT:听行业大咖讲实战

PPT 整理自 2024-2025 年热门技术大会,包含百度、腾讯、字节等企业的一线实践:

- 安全方向:《端侧大模型的安全建设》《大模型驱动安全升级(腾讯代码安全实践)》;

- 产品与创新:《大模型产品如何创新与创收》《AI 时代的新范式:构建 AI 产品》;

- 多模态与 Agent:《Step-Video 开源模型(视频生成进展)》《Agentic RAG 的现在与未来》;

- 工程落地:《从原型到生产:AgentOps 加速字节 AI 应用落地》《智能代码助手 CodeFuse 的架构设计》。

二、求职必看:大厂 AI 岗面试 “弹药库”,300 + 真题 + 107 道面经直接抱走

想冲字节、腾讯、阿里、蔚来等大厂 AI 岗?这份面试资料帮你提前 “押题”,拒绝临场慌!

1. 107 道大厂面经:覆盖 Prompt、RAG、大模型应用工程师等热门岗位

面经整理自 2021-2025 年真实面试场景,包含 TPlink、字节、腾讯、蔚来、虾皮、中兴、科大讯飞、京东等企业的高频考题,每道题都附带思路解析:

2. 102 道 AI 大模型真题:直击大模型核心考点

针对大模型专属考题,从概念到实践全面覆盖,帮你理清底层逻辑:

3. 97 道 LLMs 真题:聚焦大型语言模型高频问题

专门拆解 LLMs 的核心痛点与解决方案,比如让很多人头疼的 “复读机问题”:

三、路线必明: AI 大模型学习路线图,1 张图理清核心内容

刚接触 AI 大模型,不知道该从哪学起?这份「AI大模型 学习路线图」直接帮你划重点,不用再盲目摸索!

路线图涵盖 5 大核心板块,从基础到进阶层层递进:一步步带你从入门到进阶,从理论到实战。

L1阶段:启航篇丨极速破界AI新时代

L1阶段:了解大模型的基础知识,以及大模型在各个行业的应用和分析,学习理解大模型的核心原理、关键技术以及大模型应用场景。

L2阶段:攻坚篇丨RAG开发实战工坊

L2阶段:AI大模型RAG应用开发工程,主要学习RAG检索增强生成:包括Naive RAG、Advanced-RAG以及RAG性能评估,还有GraphRAG在内的多个RAG热门项目的分析。

L3阶段:跃迁篇丨Agent智能体架构设计

L3阶段:大模型Agent应用架构进阶实现,主要学习LangChain、 LIamaIndex框架,也会学习到AutoGPT、 MetaGPT等多Agent系统,打造Agent智能体。

L4阶段:精进篇丨模型微调与私有化部署

L4阶段:大模型的微调和私有化部署,更加深入的探讨Transformer架构,学习大模型的微调技术,利用DeepSpeed、Lamam Factory等工具快速进行模型微调,并通过Ollama、vLLM等推理部署框架,实现模型的快速部署。

L5阶段:专题集丨特训篇 【录播课】

四、资料领取:全套内容免费抱走,学 AI 不用再找第二份

不管你是 0 基础想入门 AI 大模型,还是有基础想冲刺大厂、了解行业趋势,这份资料都能满足你!

现在只需按照提示操作,就能免费领取:

👇👇扫码免费领取全部内容👇👇

2025 年想抓住 AI 大模型的风口?别犹豫,这份免费资料就是你的 “起跑线”!

更多推荐

已为社区贡献189条内容

已为社区贡献189条内容

所有评论(0)