谷歌放大招!Gemini 2.5 Flash九月版深度体验与开发者获取API Key步骤

摘要: Gemini 2.5 Flash九月预览版性能出色(速度快、成本低、支持多模态和长上下文),适合原型开发与高并发Agent任务,但存在响应截断、API不稳定等可靠性问题,暂不建议用于生产环境。其MoE架构和“思考模式”提升效率,但开发者需通过重试机制、截断检测等工程化手段规避风险。与竞品相比,Gemini主打性价比,但需等待正式版修复缺陷。当前建议:优先用于非核心场景,生产迁移需观望。 核

我用一句大白话先把话挑明:Gemini 2.5 Flash 九月预览版,性能真香,可靠性拉胯。像一辆能飙到300码的跑车,却总在关键时刻熄火。

一句话结论

- 性能与成本:快、便宜、会“思考”,很适合做原型和非核心任务,尤其是高并发的 Agent 工作流。

- 致命短板:响应截断和 API 不稳定,把它从“生产工具”往回拉成“实验品”。

- 实操建议:现在先玩,别上生产。等它转正(GA)且修完截断,再考虑迁移。

这一条主线会在文中反复出现:性能真香,可靠性拉胯。

为什么它这么快、还这么省

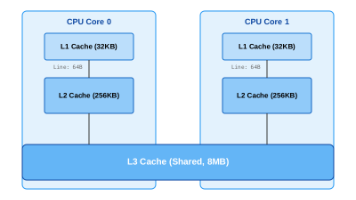

- MoE 架构=自动上号的“专家组”

- 每个Token只叫最合适的专家上场。参数很大,算力花得很小。既聪明,又省钱。

- 原生多模态+超大上下文

- 天生就看得懂图、听得懂音,100万Token的“胃口”,敢把一本书、一段会议、半个代码库一口吞。

- “思考模式”(Thinking)+思考预算

- 不再一口冒答案,先在“草稿纸”上琢磨。用 thinking_budget 调节“脑补”深度。小事不想,快;难题多想,准。省钱还灵活。

- 前瞻:Deep Think

- 并行思考+强化学习打难题。Flash 现在默认没上,但这是家族的进化方向。

翻译成人话:它不是更会写“漂亮段子”,而是更会“先想清楚再回答”。这,是质量上限的关键。

九月这波到底更了啥

- 输出更“短平快”

- 相比上一代,输出令牌减少约24%;Lite 版更狠,少50%。这意味着更低价格、更快响应。

- 多模态更稳

- 音频转录、图像理解、翻译质量同步提升。

- 对 RAG 的“降维冲击”

- 以前上下文小,必须上向量检索;现在上下文够大、输出又省,很多场景可以“直接塞大段材料给模型”。维护复杂RAG管道的必要性被动摇。

- 谷歌在暗示开发者:能用长上下文直接解决的,就少造管道。越简单,越稳。

还是那句:性能真香。但等等,别急着下生产。

Agent 能力:分数真不低

- 在 SWE-Bench Verified 上,官方宣布到了约54%(较前代+5个百分点)。第三方也有长周期Agent任务提升约15%的报告。

- 这个基准不是“刷题”,而是“真实修Issue”:读需求、看大仓、定方案、改代码、过测试。能跑分就意味着它会“干活”,不是只会聊天。

对构建自主智能体的团队,这是明确的正激励。但下一节会泼点冷水。

和竞品怎么打

- 谷歌的路数是“性价比王”。

- 不和最顶级模型硬刚最高分,而是用相近的质量,配更低的价格、更高的吞吐量,拿下80%通用企业任务。

- 速度是真快

- 独立测试里,Flash-Lite 输出速度可逼近“最快专有模型”梯队,实时对话、客服场景很吃这一口。

要点别忘:真香,但“香”不等于“能上生产”。先收割原型期的爽点,再谈大规模迁移。

开发者体验:一半是海水,一半是火焰

当它状态在线时,你会真心夸它能打;当它抽风时,你会质疑人生。

- 正常时的高光

- 问题理解到位,步骤清晰,工具使用更稳。长上下文场景几乎“指哪打哪”,Lite 版对结构化任务的稳健表现让人惊喜。

- 翻车时的痛点

- 响应截断:生成到一半突然断电。和令牌上限、安全策略都不总是有关,像是底层流控或服务层问题。

- API 不稳定:间歇性超时、连接中断、偶发 5xx;AI Studio 的小 Bug 更添堵。

- 工具调用与强制 JSON 不能同时用:要么工具可靠,要么结构化输出可靠,二选一。这对 Agent 工程是硬伤。

归根结底,这不是“能不能做出漂亮 demo”的问题,而是“能不能撑住生产 SLA”的问题。性能真香,可靠性拉胯。

工程化落地清单(可直接抄)

先给你“能落地”的,再谈理念。以下做法,能最大程度把坑踩成小坑。

- 重试与断路器

- 超时控制:客户端超时 < 服务端超时,避免死等;建议 20-60s 视任务设定。

- 指数退避 + 抖动重试,最多 2-3 次;对幂等请求加请求 ID。

- 熔断与降级:连续错误阈值触发熔断;降级到“简版回答”或备用模型(o4-mini/Claude Sonnet)。

- 截断检测与自愈

- 结构化校验:JSON Schema 校验不过即判截断,触发“补全请求”(带上前文+请继续完成字段X)。

- 语义哨兵:要求模型以特定“END_OF_OUTPUT”标记结尾;缺失则判不完整。

- 流式拼接:启用流式输出,落盘增量片段,失败时做“续写”而非重来。

- 输出约束与工具调用的折中方案

- 双阶段策略:第一阶段强制 JSON 产出工具参数;第二阶段实际调用工具并汇总结果。牺牲一次往返,换确定性。

- 或者工具优先:允许运行工具,最后用小模型做结构化“再包装”成 JSON(快且稳)。

- Prompt 侧最佳实践

- 明确输出长度上限和格式,避免“想到哪写到哪”。

- 不索要“详细推理过程”,只要关键依据或引用。Thinking 让它自己在里边想就好。

- 给出错误恢复提示词:“若因网络中断,请从上次中断字段继续,以END_OF_OUTPUT结尾。”

- 观测与成本看板

- 基础指标:成功率、P50/P95 延迟、超时率、截断率、重试率、工具调用成功率。

- 资源指标:输入/输出/思考令牌消耗、人均会话成本、thinking_budget 分布。

- 质量指标:结构化校验通过率、事实性抽检、敏感内容拦截率。

- 报警策略:截断率>1%、超时率>2%、重试率>5%立刻告警。

- 灰度与影子流量

- 上线先 5%-10% 灰度;同时跑“影子请求”比对输出质量与成本。

- 每次大版本更新(尤其是预览版)都要回归测试核心流程。

别做什么:

- 不要把预览版顶在关键业务路径上。

- 不要硬怼强制 JSON 和工具调用在同一轮次里“都要稳”。

- 不要把 API Key 写进客户端或仓库里(别问,问就是会泄漏)。

RAG 还要不要?

给你一个简单的决策逻辑。

- 可以先不用 RAG 的场景

- 语料规模有限(< 80-100 万 token)且更新不频繁。

- 更看重开发速度与迭代成本,允许“阅读整包材料”。

- 不强制可溯源引用。

- 仍然建议保留/引入 RAG 的场景

- 频繁更新、强合规、必须给出处的知识问答。

- 语料超大且分主题分库,长上下文会浪费令牌。

- 需要高可控的答案范围与重排策略。

经验法则:先用长上下文打基础,跑通闭环;随着规模与合规要求上升,再渐进引入轻量 RAG 模块(检索+重排+引用),而不是一开始就造复杂管道。

价格与“思考成本”

- 关键点:输出价格已包含“思考令牌”。核账更简单。

- 参考量级(美元/百万令牌)

- Flash 预览:输入文本约 $0.30,音频约 $1.00;输出 $2.50(含思考)

- Flash Lite 稳定:输入 $0.10;输出 $0.40

- 调参建议

- 默认 thinking_budget 先小再大:简单任务 0-32,复杂任务再上调。

- 输出尽量结构化、简短,少走“长篇大论”路线。

一句话:省钱的两把刀——短输出,聪明思考。

安全与可配置阈值:把“准星”掌握在你手里

- 四个维度可配:骚扰、仇恨、色情、危险内容。按场景设。

- 推荐预设

- 教育与企业助手:保守阈值,启用高审查,记录拦截日志。

- 游戏与社区:中等阈值,允许更多“角色语气”,但开启关键词报警。

- 内部研发:宽松阈值,外发前统一再审。

- 合规提醒

- 告知用户内容可能由 AI 生成;关键业务留“人工复核”出口。

- 记录策略版本与变更,便于审计与回溯。

获取你的 AI API Key 教程

这是你与 AI 对话的“钥匙”,务必妥善保管。

方式A:通过 Google AI Studio 获取 Gemini 2.5 Flash API Key

这是获取 Gemini 2.5 Flash API Key 的正确途径。

- 访问 Google AI Studio: [

https://aistudio.google.com/] - 登录你的 Google 账户。

- 在左侧导航栏中,找到并点击 “Get API Key” 或类似选项。 (具体位置可能因界面更新略有不同,通常在“API Access”或“Developers”部分)

- 按照提示生成你的 API Key。

- 立刻复制并妥善保存你的 Key。

方式B:国内加速模式(适用于特定服务商)

注意: 这种方式通常适用于通过服务商获取 Gemini 或其他模型的 API Key。请确认你选择的服务商支持你需要的模型。

借助国内技术团队(如: uiuiapi.com)提供的中转服务,连接可能更稳定,速度更快,许多资深用户都在用。

安全提示: 千万不要把 API Key 直接写在代码里!最佳实践是使用环境变量来存储和访问你的 API Key,以确保其安全性。

给不同角色的上手路线

- 学生/职场小白

- 用 Lite 版做学习卡片、作业讲解、会议纪要速记。提示词模板+结构化输出,省钱高效。

- 开发者

- 先用预览版做原型与内部工具;按上文清单把稳定性“装出来”。生产流量用稳定模型,影子流量喂给 Flash 做比对。

- 自媒体/运营

- 长上下文直接塞素材,快速出框架与要点;强制列大纲+要点摘要,避免水文;图文混排可试 Flash Image 流程化改稿。

最后结论:别急上生产,但别错过窗口

- 它的架构和“思考”范式,决定了上限很高;价格与速度,决定了普惠性强。

- 但预览期的可靠性,决定了“现在不适合扛大旗”。

主线再强调一次:性能真香,可靠性拉胯。现在最优解——原型尽情用,生产稳住等 GA。

互动与后续

- 你在什么场景遇到过“响应截断”?把复现提示词和返回片段贴在评论里,我会挑典型案例写一版“截断自愈模板”回馈大家。

- 想要“生产可用”级别的重试中间件与监控仪表板模板?点个赞、收藏此文,并在评论里留言“要模板”。集齐300个赞我就开源。

- 下一篇我会测:同一套 Agent 任务,在 Flash 预览 vs o4-mini vs Sonnet 的稳定性对比与成本/质控曲线,记得关注不迷路。

版权声明:本文由界智通(jieagi)团队原创,转载请注明出处。我们专注 AI 工具深测与工程化实践,欢迎交流。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)