[论文阅读] 人工智能 | 一文读懂ROLEX框架——解决自然语言转形式语言的“未知构造”难题

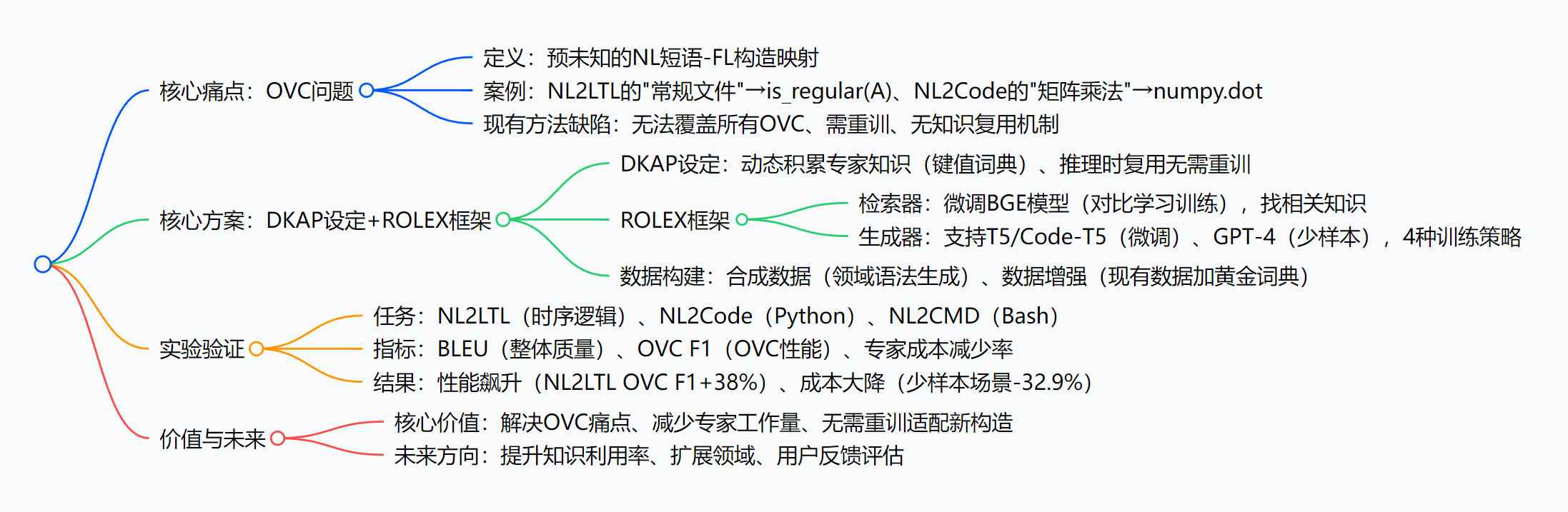

研究提出 “动态知识增强解析(DKAP)” 设定(允许推理时复用专家提供的动态知识,无需重训),并设计 “检索增强解析框架(ROLEX)”:通过微调的检索器从专家键值词典(NL 短语 - OVC 构造映射)中找相关知识,生成器基于知识生成正确解析;同时用合成数据 + 数据增强构建训练数据,设计 4 种生成器训练策略。在 NL2LTL、NL2Code、NL2CMD 三大任务中,ROLEX 显著提升性

一文读懂ROLEX框架——解决自然语言转形式语言的“未知构造”难题

论文信息

- 论文原标题:Dynamic Knowledge-Enhanced Parsing for Open-Vocabulary Natural Language to Formal Language Translation

- 论文链接:https://arxiv.org/pdf/2509.08808

一段话总结

该论文聚焦自然语言(NL)转形式语言(FL,如时序逻辑、代码)时的“预未知构造(OVC)”痛点——模型遇到训练时没见过的FL构造(如NL2LTL中的is_regular(A)、NL2Code中的numpy.dot)就“卡壳”,且现有方法需重新训练才能处理新构造。为此,研究提出“动态知识增强解析(DKAP)”设定(允许推理时复用专家提供的动态知识,无需重训),并设计“检索增强解析框架(ROLEX)”:通过微调的检索器从专家键值词典(NL短语-OVC构造映射)中找相关知识,生成器基于知识生成正确解析;同时用合成数据+数据增强构建训练数据,设计4种生成器训练策略。在NL2LTL、NL2Code、NL2CMD三大任务中,ROLEX显著提升性能(如NL2LTL的OVC F1提升20%-38%),还能减少24.3%-32.9%的专家人工成本,为NL形式化提供了“随用随更”的新方案。

思维导图

研究背景:深入浅出讲“来龙去脉”

咱们先从“自然语言转形式语言”这个场景说起——比如你想让AI把“如果文件夹A里有常规文件,就删除它”翻译成线性时序逻辑(LTL,用于系统验证),或者把“计算两个矩阵的点积”翻译成Python代码,这就是NL→FL的核心需求。这个需求在软件测试、自动化运维、代码生成等领域特别重要,毕竟人工写LTL或代码又慢又容易错。

但这里有个大麻烦:AI总会遇到“没见过的构造”——比如刚才的“常规文件”,对应的LTL构造是is_regular(A),如果AI训练时没学过这个构造,就会翻译错;再比如你想让AI生成numpy.dot函数(计算矩阵点积),但AI只训练过np.matmul,也会“卡壳”。这种“预未知的FL构造”,就是论文说的“OVC(Open-Vocabulary Constructs)”。

为啥OVC问题这么难解决?咱们可以类比成“你学英语时,遇到字典里没有的生词,还不能问老师”:

- 覆盖不全:FL构造太多了(比如Python有上万个函数,LTL在不同领域有不同谓词),训练数据不可能把所有构造都包含;

- 知识没法复用:就算专家告诉AI“‘常规文件’对应

is_regular(A)”,现有AI也不会“记住”——下次遇到同样的NL短语,还是会错,除非重新训练整个模型,成本极高; - 传统方法“水土不服”:之前的语义解析方法,比如处理“分布外(OOD)数据”,都是假设“构造已知”(比如只是输入句子的表达方式变了,但要生成的FL语法没变),而OVC是“构造本身未知”,根本没法应对。

简单说,现有AI在NL→FL时,就像个“只会背课本的学生”——遇到课本外的新知识点,要么瞎蒙,要么得重新学一遍,效率极低。这就是论文要解决的核心痛点。

创新点:ROLEX框架的“独特亮点”

这篇论文的创新点,总结起来就是“一个设定+一个框架+一套策略”,每部分都戳中了OVC的痛点:

-

首创“DKAP设定”:让AI能“随学随用”专家知识

之前的AI处理新构造,要么“不会”,要么“学了就忘”(需重训)。DKAP设定就像给AI配了个“可更新的笔记本”:专家把“NL短语→OVC构造”的知识(比如“矩阵点积→numpy.dot”)记在笔记本里,AI在翻译时可以随时翻这个笔记本,而且笔记本能不断加新内容——下次遇到同样的NL短语,直接用之前记的知识,不用重新“上课”(重训)。论文还验证了这个设定的合理性:在NFS领域(NL2LTL的实验场景),OVC会重复出现,随着处理的句子越多,笔记本里的知识复用率越高(最高能到60%+),说明“记笔记”真的有用。 -

ROLEX框架:“检索+生成”协同,解决“知识过载”问题

光有笔记本还不够——如果笔记本里有几百条知识,AI翻起来会“头晕”(知识过载),还可能翻到无关的知识(噪声干扰)。ROLEX框架就像给AI配了个“智能检索助手”:- 先让“检索助手”(检索器)从笔记本里筛选出和当前NL句子最相关的知识(比如翻译“矩阵点积”时,只找出“numpy.dot”相关的条目);

- 再让“翻译员”(生成器)基于“NL句子+筛选后的知识”生成FL,避免瞎蒙。

更妙的是,检索器是用“对比学习”微调过的(比如BGE-large模型),比传统的检索方法(如BM25)准得多——在NL2LTL任务中,微调后的检索器找对知识的概率(R@10)是44.71%,而BM25只有12.50%,大大提升了后续翻译的准确性。

-

4种生成器训练策略:平衡“OVC识别”和“整体翻译质量”

生成器不是随便训练的——论文设计了4种策略,解决“AI要么忽略知识,要么用错知识”的问题。其中“迁移学习(TRANSFER)”策略最亮眼:先让AI学“怎么从筛选的知识里挑有用的”(比如从多条知识中找出“numpy.dot”),再学“怎么用这些知识翻译”。这种“分步学”的方式,既保证了AI能准确识别OVC(OVC F1=18.07),又不会拖累整体翻译质量(BLEU=31.81),是所有策略里的“最优平衡”。 -

数据构建方案:解决“训练数据稀缺”的刚需

要训练ROLEX,得有“NL句子+FL翻译+相关知识”的训练数据,但现实中这种数据很少。论文用了两个办法:- 对没数据的场景(如NL2LTL):用“领域语法”随机生成数据(比如按NFS领域的规则,生成“如果A是常规文件,就执行B”这类句子,再配上对应的LTL和知识),一下子造了12万条训练数据;

- 对有少量数据的场景(如NL2Code):给现有数据加“黄金知识”(比如从Python文档里提取“矩阵点积→numpy.dot”,加到CoNaLa数据集的句子里),提升数据质量。

研究方法和思路:拆解“复杂方法论”

咱们把论文的研究方法拆成“问题定义→框架设计→数据准备→模型训练”四步,一步步讲清楚:

第一步:定义DKAP问题——明确“AI要做什么”

DKAP的核心逻辑很简单,用公式表示就是:

当AI处理第t个NL句子x_t时,除了x_t,还能用到之前积累的专家知识K_{1:t-1}(比如处理第10个句子时,能用前9个句子积累的知识),最终生成正确的FL句子y_t。

其中,知识K是“键值对”形式:key是NL短语(如“常规文件”),value是对应的OVC构造(如is_regular(A))。关键要求是:K能动态增加(专家随时加新知识),AI不用重训就能用新知识。

第二步:设计ROLEX框架——“检索+生成”两步走

ROLEX框架分两大模块,协同工作:

| 模块 | 核心任务 | 具体操作(以NL2Code为例) |

|---|---|---|

| 检索器 | 从K中找与x_t相关的知识K* |

1. 把x_t(如“计算矩阵点积”)和K中的所有key(如“矩阵乘法”“向量加法”)转成向量;2. 用余弦相似度排序,选Top-N个最相关的 key-value对作为K*;3. 模型:微调BGE句子转换器,用对比学习训练(让相关的 x_t和key向量更近)。 |

| 生成器 | 基于x_t + K*生成y_t(如numpy.dot(a,b)) |

1. 输入格式:把x_t和K*拼接成“NL:计算矩阵点积;知识:矩阵点积→numpy.dot”;2. 模型选择: - 微调场景:用T5或Code-T5(适合处理文本生成任务); - 少样本场景:用ChatGPT/GPT-4(给3个示例就能学); 3. 训练策略:4种(见下表)。 |

生成器的4种训练策略对比

| 策略名称 | 训练步骤 | 优势 | 劣势 | 性能(NL2Code任务) |

|---|---|---|---|---|

| BASIC(基础策略) | 直接用“x_t+K*”训练生成y_t | 简单易实现 | 易忽略K*中的有用知识 |

OVC F1=16.92,BLEU=29.94 |

| EXTRA SUPERVISION(额外监督) | 同时用“x_t+K*”和“x_t+K_y”训练(K_y是黄金知识) |

增加监督信号 | 易受K*中噪声干扰 |

OVC F1=16.27,BLEU=27.69 |

| MULTI-TASK(多任务) | 先输出K_y的key,再输出y_t(如“矩阵点积→numpy.dot(a,b)”) |

强制AI关注知识 | 任务冲突,拖累y_t的生成质量 | OVC F1=19.89,BLEU=26.53 |

| TRANSFER(迁移学习) | 1. 先训练AI从K*中提取K_y的key;2. 再微调生成y_t |

分步学习,平衡知识识别和翻译质量 | 训练步骤多 | OVC F1=18.07,BLEU=31.81(最优) |

第三步:准备训练数据——“造数据+增数据”

针对不同任务的数据源,用不同方法构建数据:

| 任务 | 数据源情况 | 数据构建方法 | 最终数据规模 |

|---|---|---|---|

| NL2LTL | 无真实标注数据 | 基于NFS领域语法,随机生成“NL句子+LTL+知识”三元组(含干扰知识) | 训练12万条,测试100条 |

| NL2Code | 有少量标注数据(CoNaLa) | 对每条“NL-Python”对,从Python文档提取黄金知识(如“矩阵点积→numpy.dot”),添加到数据中 | 训练2135条,测试543条 |

| NL2CMD | 有标注数据(TLDR) | 对每条“NL-Bash”对,从Bash文档提取黄金知识(如“删除共享内存→ipcrm”),添加到数据中 | 训练8260条,测试928条 |

第四步:模型训练与推理——“分场景优化”

-

微调场景(用T5/Code-T5):

- 先训练检索器:用对比学习(正样本:

x_t和相关key;负样本:x_t和无关key)微调BGE模型; - 再训练生成器:用准备好的训练数据,选择TRANSFER策略训练;

- 推理时:先调用检索器找

K*,再输入生成器生成y_t。

- 先训练检索器:用对比学习(正样本:

-

少样本场景(用ChatGPT/GPT-4):

- 不用训练生成器,直接给3个示例(如“NL:计算矩阵点积;知识:矩阵点积→numpy.dot;Python:numpy.dot(a,b)”);

- 推理时:先检索

K*,再把“NL+K*+示例”一起输入模型,生成y_t。

主要成果和贡献:用“大白话”讲清“厉害之处”

论文的成果很实在,咱们用表格总结核心数据,再讲清楚这些成果的价值:

核心实验成果(三大任务对比基线模型)

| 任务 | 核心指标提升(ROLEX vs 基线) | 专家成本减少率 | 最佳模型表现(少样本场景) |

|---|---|---|---|

| NL2LTL | OVC F1提升20%-38%,BLEU提升15%-25% | 24.3%(微调);32.9%(少样本) | GPT-4+ROLEX:BLEU=66.38 |

| NL2Code | 首次有效处理OVC(基线无数据),OVC F1=18.07,BLEU=31.81 | 5.6% | Code-T5+ROLEX:BLEU=31.81 |

| NL2CMD | OVC F1提升10%-15%,BLEU提升8%-12% | 16.3% | CT5-S+ROLEX:BLEU=45.22 |

这些成果的“实实在在的价值”

-

解决了“OVC卡壳”的核心痛点:之前AI遇到没见过的FL构造,要么翻译错,要么得重训;现在用ROLEX,专家加个知识(比如“删除共享内存→ipcrm”),AI马上就能用,不用重训——比如在NL2LTL任务中,处理100条测试句,OVC的正确率提升了近40%,相当于之前10个错6个,现在只错3个。

-

大大减少专家工作量:专家之前要“反复纠错”——比如AI每次遇到“常规文件”都翻译错,专家得每次都改;现在AI记住了“常规文件→is_regular(A)”,下次就不会错了。论文数据显示,专家成本减少了24%-32%,比如在少样本NL2LTL场景,专家原本要处理237个“纠错/标注”任务,现在只要159个,少干了1/3的活。

-

适配多种场景,实用性强:不管是转时序逻辑(NL2LTL)、转Python代码(NL2Code),还是转Bash命令(NL2CMD),ROLEX都能用——而且既支持“有大量数据”的微调场景,也支持“没多少数据”的少样本场景(比如用GPT-4,给3个示例就能跑),不用为不同场景重新设计模型。

-

组件可复用,易扩展:检索器用的BGE模型、生成器用的T5/Code-T5,都是开源的;数据构建的方法(合成数据+增强)也能复用到其他领域(比如转信号时序逻辑STL)。后续研究只要换领域数据,就能快速适配新场景。

开源信息

目前论文暂未提及代码或数据集的开源地址,推测后续会在GitHub发布相关实现(arxiv论文常滞后发布开源资源)。

关键问题:问答形式归纳核心

问题1:OVC问题和咱们常说的“分布外(OOD)语义解析”有啥不一样?为啥OOD方法解决不了OVC?

答:最核心的区别是“构造是否已知”——

- OOD语义解析:FL构造是已知的,只是输入句子的“表达方式变了”(比如Text2SQL中,表结构没变,但用户问法变了,比如“找出年龄大于30的人”改成“年龄超30的用户有哪些”);

- OVC问题:FL构造是未知的,AI训练时根本没见过这个构造(比如AI只学过

np.matmul,现在要生成numpy.dot)。

OOD方法解决不了OVC,是因为OOD方法的前提是“构造已知”——它只需要适配“输入分布变化”,不用学新构造;而OVC需要AI“学新构造”,还得能记住并用起来,OOD方法没这个能力。

问题2:ROLEX的检索器和生成器是怎么配合的?为啥检索器一定要微调?

答:配合逻辑很像“医生看病”——检索器像“病历检索员”,先从海量病历(知识K)里找出和当前病人(x_t)症状最像的病历(K*);生成器像“医生”,根据病人症状+相似病历,给出诊断(y_t)。如果检索员找的病历不对(比如把“感冒”的病历给了“发烧”的病人),医生再厉害也会误诊——所以检索器的准确性直接影响生成器的结果。

检索器要微调,是因为“通用检索方法不够准”——比如BM25是基于关键词匹配的,遇到“矩阵点积”和“矩阵乘法”这种语义相近但关键词不完全一样的情况,就会漏检;而微调后的BGE模型,能理解语义相似性,找对知识的概率(R@10)从BM25的12.5%提升到44.7%,大大减少了生成器的“误诊率”。

问题3:生成器的4种训练策略里,为啥TRANSFER策略能平衡“OVC识别”和“整体翻译质量”?

答:因为TRANSFER策略是“分步学,不贪多”——

- 第一步先学“怎么挑知识”:让AI专注于“从

K*里找出有用的key”(比如从“矩阵乘法→np.matmul”“矩阵点积→numpy.dot”里,挑出“矩阵点积→numpy.dot”),这一步打好“识别OVC”的基础; - 第二步再学“怎么用知识翻译”:基于挑好的知识,专注于生成正确的FL句子,不用分心“挑知识”。

对比其他策略:BASIC策略没学“挑知识”,容易忽略有用知识;MULTI-TASK策略要“同时挑知识和翻译”,任务太多,翻译质量会下降;EXTRA SUPERVISION策略加了太多监督信号,容易被噪声干扰。所以TRANSFER策略既能保证OVC识别准(OVC F1=18.07),又能让翻译质量高(BLEU=31.81),是最优平衡。

问题4:论文说“DKAP设定的实用性在于知识复用率高”,这个复用率是怎么验证的?有数据支撑吗?

答:论文在NFS领域(NL2LTL的实验场景)做了验证——统计处理不同数量句子时,“当前句子的OVC能在之前积累的知识里找到”的比例,就是知识复用率。

数据显示:处理第10条句子时,复用率约15%;处理第50条句子时,复用率约40%;处理第100条句子时,复用率超过60%——这说明随着处理的句子越多,之前积累的知识越有用,不用每次都加新知识,DKAP设定的“动态积累”真的能减少专家工作量。

问题5:ROLEX在少样本场景(比如用GPT-4)的效果比微调场景(比如用T5)好,那为啥还要做微调?

答:因为“效果好”和“成本低”要平衡——

- 少样本场景(GPT-4):效果确实好(NL2LTL的BLEU=66.38,比T5的55.12高),但每次推理都要调用GPT-4的API,成本很高(按调用次数收费),不适合大规模使用;

- 微调场景(T5/Code-T5):效果虽然略低,但模型是本地部署的,不用每次调用API,成本低,适合长期、大规模的工业场景(比如企业内部的代码生成工具)。

所以论文两种场景都做,是为了适配不同的使用需求——追求效果选少样本,追求成本选微调。

论文总结

这篇论文针对自然语言转形式语言的“OVC核心痛点”,提出了一套从“问题设定→框架设计→数据构建→实验验证”的完整解决方案:

- 用DKAP设定打破“处理新构造需重训”的困境,让AI能动态复用专家知识;

- 用ROLEX框架的“检索+生成”协同,解决知识过载和噪声干扰问题;

- 用合成数据+增强和4种训练策略,保证模型在多种场景下的性能;

- 在三大任务中验证了方案的有效性,既提升了翻译 accuracy,又减少了专家成本。

整体来看,这篇论文的核心贡献不是“发明了新模型”,而是“提出了新的问题设定(DKAP)和实用的解决方案(ROLEX)”——它没有追求复杂的模型结构,而是从“实际需求”出发,解决了NL→FL领域长期存在的“落地难”问题,为后续研究提供了清晰的方向(比如提升知识利用率、扩展更多领域)。

更多推荐

已为社区贡献15条内容

已为社区贡献15条内容

所有评论(0)