提示工程架构师必看:研发效能提升的完整解决方案

提示工程(Prompt Engineering)是AI应用的“翻译官”——将人类需求转化为机器能理解的指令,直接决定了大模型的输出质量。只关注提示设计,忽视需求分析的准确性(比如没搞清楚用户要“生成摘要”还是“提取关键信息”);只做人工评估,没有自动化测试(每次迭代都要手动跑几十条用例,效率极低);只靠个人经验,没有团队协作机制(新人入职要花1个月才能掌握常用提示模板)。研发周期长、效果不稳定、团

提示工程架构师必看:研发效能提升的完整解决方案

一、引言 (Introduction)

1. 钩子:你是否正在经历这些“提示工程之痛”?

作为一名提示工程架构师,你可能每天都在应对这样的场景:

- 产品经理拿着新需求来找你:“这个提示生成的结果总是不符合用户意图,能不能再改改?”你翻开历史版本,发现这已经是第8次迭代,每次都要重新调整逻辑、补充示例,耗时耗力;

- 团队里的提示设计师各自为战,有人用自然语言写长提示,有人用结构化标签,评审时还要花大量时间统一风格;

- 线上提示突然失效,你想回溯版本却发现没有完整的版本记录,只能从头排查;

- 明明优化了提示的准确率,却导致响应时间增加了2倍,运维团队找上门来要你“平衡效果与性能”。

这些问题的根源,不是“提示写得不够好”,而是缺乏一套系统的研发效能提升方案。提示工程不是“写提示”的单点工作,而是覆盖“需求-设计-评估-部署-优化”的全流程,每一个环节的低效都会传导到整体研发效能。

2. 定义问题:为什么提示工程需要“完整解决方案”?

提示工程(Prompt Engineering)是AI应用的“翻译官”——将人类需求转化为机器能理解的指令,直接决定了大模型的输出质量。但在实际研发中,很多团队陷入了“碎片化优化”的误区:

- 只关注提示设计,忽视需求分析的准确性(比如没搞清楚用户要“生成摘要”还是“提取关键信息”);

- 只做人工评估,没有自动化测试(每次迭代都要手动跑几十条用例,效率极低);

- 只靠个人经验,没有团队协作机制(新人入职要花1个月才能掌握常用提示模板)。

这些问题最终导致:研发周期长、效果不稳定、团队产出率低、资源浪费严重。而架构师的核心职责,就是通过流程规范、工具链建设、团队协作机制,将“碎片化的提示工作”转化为“可复制、可优化、可规模化”的研发体系。

3. 文章目标:给架构师的“效能提升地图”

本文将为你提供一套从“流程规范”到“智能优化”的完整解决方案,覆盖提示工程研发的全生命周期。读完本文,你将学会:

- 如何通过标准化流程减少重复劳动;

- 如何通过工具链建设提升协作与自动化水平;

- 如何通过智能优化实现“提示自我进化”;

- 如何通过团队机制将个人经验转化为团队能力。

接下来,我们从“基础认知”开始,逐步拆解这套方案。

二、基础知识铺垫:明确核心逻辑

在讲解决方案前,我们需要先统一两个关键认知——提示工程架构师的核心职责和研发效能的量化指标。这是后续方案设计的“底层逻辑”。

1. 提示工程架构师的核心职责

提示工程架构师不是“高级提示设计师”,而是研发体系的设计者。你的工作边界应该覆盖:

- 流程设计:定义“需求-设计-评估-部署-优化”的标准化流程,减少冗余环节;

- 工具选型:选择/开发适合团队的工具链(设计、评估、协作、部署),提升自动化水平;

- 团队协作:建立角色分工、知识共享、流程自动化机制,避免“信息差”;

- 性能优化:平衡提示的“效果”(准确率、相关性)与“性能”(响应时间、资源消耗);

- 风险控制:制定版本管理、故障回溯、安全合规策略,避免线上事故。

2. 研发效能的关键量化指标

效能提升不是“凭感觉”,而是“凭数据”。你需要跟踪以下指标,才能判断方案是否有效:

- 提示迭代周期:从需求提出到提示上线的时间(目标:缩短30%-50%);

- 提示准确率:生成结果符合需求的比例(目标:提升20%-40%);

- 团队产出率:人均每月交付的有效提示数量(目标:提升50%以上);

- 资源利用率:提示部署后的响应时间、Token消耗、并发处理能力(目标:降低20%的资源成本);

- 用户反馈率:用户对提示结果的满意度(目标:降低30%的负面反馈)。

有了这些基础认知,我们进入核心解决方案的设计。

三、核心内容:研发效能提升的完整方案

提示工程的研发效能提升,需要从**“流程标准化”“工具链自动化”“团队协作化”“优化智能化”**四个维度构建闭环。以下是具体落地步骤:

(一)维度一:流程标准化——从“拍脑袋”到“按规则办事”

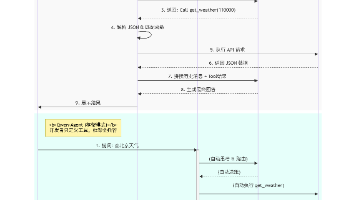

流程是研发效能的“地基”。没有标准化的流程,再厉害的工具也无法发挥作用。我们将提示工程的全流程拆解为4个阶段、8个关键步骤,每个步骤都定义了“输入、输出、责任角色、工具”。

1. 阶段一:需求分析——明确“做什么”(避免“伪需求”)

核心目标:将业务需求转化为可量化的提示目标,避免“为了优化而优化”。

关键步骤:

-

步骤1:业务目标对齐(责任角色:产品经理+提示架构师)

输入:产品需求文档(PRD)、用户调研数据;

输出:提示目标说明书(包含:业务场景(如电商客服回复)、用户意图(如解决用户投诉)、输出要求(如“礼貌、准确、包含解决方案”)、量化指标(如“投诉解决率提升20%”))。

示例:“针对电商用户的‘快递延迟’投诉,生成包含‘道歉+原因说明+解决方案(如补发优惠券)’的回复,要求语气亲切,解决率≥85%。” -

步骤2:用户意图拆解(责任角色:提示架构师+用户研究工程师)

输入:提示目标说明书、用户对话日志;

输出:意图分类表(将用户需求拆解为具体意图,如“询问快递进度”“投诉延迟”“要求赔偿”)。

工具:用CLUE(中文语言理解评测基准)或Intent Classification模型辅助拆解意图。

2. 阶段二:提示设计——明确“怎么做”(避免“反复试错”)

核心目标:用结构化方法设计提示,减少“凭经验写提示”的不确定性。

关键步骤:

-

步骤3:选择提示框架(责任角色:提示设计师)

根据业务场景选择合适的提示框架:- 结构化提示(适合需要明确约束的场景,如“生成产品描述”):格式为“[任务] + [约束条件] + [示例] + [输出要求]”;

示例:“[任务]:生成电商产品描述;[约束条件]:突出‘轻便’‘防水’‘续航12小时’;[示例]:‘这款无线耳机采用IPX7级防水设计,重量仅5g,续航可达12小时,适合运动时使用’;[输出要求]:100字以内,口语化。” - 思维链(Chain-of-Thought,适合复杂推理场景,如“数学题解答”):格式为“[问题] + [思考步骤] + [答案]”;

示例:“[问题]:小明有5个苹果,吃了2个,又买了3个,现在有多少个?[思考步骤]:先算吃了之后的数量(5-2=3),再算买了之后的数量(3+3=6);[答案]:6个。” - 多轮对话提示(适合交互场景,如“客服机器人”):格式为“[用户输入] + [系统回应] + [引导下一步]”;

示例:“用户:‘我的快递还没到’;系统:‘请问你的快递单号是多少?我帮你查询进度’;引导:‘请提供快递单号,我将为你实时跟踪’。”

- 结构化提示(适合需要明确约束的场景,如“生成产品描述”):格式为“[任务] + [约束条件] + [示例] + [输出要求]”;

-

步骤4:补充Few-shot示例(责任角色:提示设计师)

输入:意图分类表、历史有效示例;

输出:示例库(每个意图对应3-5个高质量示例,覆盖常见场景)。

技巧:示例要“多样化”(比如不同用户的表达方式)、“典型化”(比如包含边缘情况,如“快递延迟超过7天”)。

3. 阶段三:评估验证——确保“做得对”(避免“上线即翻车”)

核心目标:通过自动化+人工评审,确保提示符合需求。

关键步骤:

-

步骤5:自动化测试(责任角色:测试工程师)

输入:提示草稿、测试用例库(包含正常情况、边缘情况、异常情况);

输出:测试报告(包含准确率、召回率、响应时间等指标)。

工具:用LangChain的Evaluation框架或PromptLayer实现自动化测试,支持批量运行用例、生成可视化报告。

示例:针对“快递延迟投诉”提示,设计测试用例:- 正常情况:用户输入“我的快递已经延迟3天了”,期望输出包含“道歉+查询进度+优惠券”;

- 边缘情况:用户输入“快递延迟了,但我急着用”,期望输出包含“优先处理+加急配送”;

- 异常情况:用户输入“快递丢了”,期望输出包含“安抚+理赔流程”。

-

步骤6:人工评审(责任角色:产品经理+提示架构师+用户代表)

输入:测试报告、提示草稿;

输出:评审结论(通过/需要修改/重新设计)。

评审标准:是否符合业务目标、是否覆盖用户意图、是否存在歧义、是否符合性能要求。

4. 阶段四:迭代优化——确保“越做越好”(避免“停滞不前”)

核心目标:通过用户反馈和数据监控,持续优化提示效果。

关键步骤:

-

步骤7:上线监控(责任角色:运维工程师+提示架构师)

输入:上线后的提示服务;

输出:监控报表(包含响应时间、准确率、用户反馈率、资源消耗等指标)。

工具:用Prometheus+Grafana监控服务性能,用ELK收集用户反馈日志。 -

步骤8:迭代调整(责任角色:提示设计师+产品经理)

输入:监控报表、用户反馈;

输出:优化后的提示版本。

优化方向:- 效果优化(如提升准确率):调整提示的逻辑(比如增加“必须包含解决方案”的约束);

- 性能优化(如降低响应时间):压缩提示长度(比如将“请你帮我生成一个……”改为“生成……”);

- 体验优化(如提升用户满意度):调整语言风格(比如将“你的问题已收到”改为“您好,我们已收到您的问题”)。

流程标准化的价值:将“个人经验”转化为“团队流程”,新人入职可以快速上手,避免重复踩坑;每一步都有明确的输入输出,减少沟通成本;自动化测试和监控让问题早发现早解决,降低线上风险。

(二)维度二:工具链建设——从“手动操作”到“自动化流水线”

流程标准化需要工具链的支持。没有工具,流程只能停留在“纸面”。提示工程的工具链需要覆盖设计、评估、协作、部署、优化全环节,以下是关键工具的选型和使用指南:

1. 设计工具:提升提示设计效率

核心需求:支持结构化提示设计、示例管理、版本控制。

推荐工具:

- Prompt Studio(开源):支持可视化设计提示,内置结构化模板(如任务+约束+示例),可以保存历史版本,方便回溯;

- LangChain Prompt Template(库):用代码定义提示模板,支持变量替换(如{user_input}),适合需要动态生成提示的场景;

- Notion/Airtable(协作工具):用表格管理提示示例,支持团队成员共同编辑,适合小型团队。

使用示例:用Prompt Studio设计“电商产品描述”提示,模板如下:

[任务]:生成{product_type}的产品描述;

[约束条件]:突出{key_features}(如轻便、防水),符合{target_audience}(如年轻女性)的语言风格;

[示例]:“这款{product_type}采用{material}材质,{feature1},{feature2},适合{use_scenario}使用;

[输出要求]:{word_count}字以内,口语化,包含关键词{keywords}。”

设计师可以通过填写变量(如product_type=“无线耳机”,key_features=“轻便、防水”)快速生成提示,无需重复写模板。

2. 评估工具:实现自动化测试与量化评估

核心需求:支持批量运行测试用例、生成评估报告、对比不同提示版本的效果。

推荐工具:

- LangChain Evaluation(库):提供多种评估指标(如准确率、相关性、流畅度),支持自定义评估函数(如检查是否包含关键词);

- PromptLayer( SaaS):集成了大模型API,支持批量发送提示,自动收集输出结果,生成可视化评估报告;

- JUnit/Pytest(测试框架):用代码编写测试用例,适合需要频繁迭代的场景(如每天运行一次测试)。

使用示例:用LangChain Evaluation评估“快递延迟投诉”提示的准确率:

from langchain.evaluation import load_evaluator

from langchain.prompts import PromptTemplate

from langchain.llms import OpenAI

# 定义提示模板

prompt = PromptTemplate(

input_variables=["user_input"],

template="针对用户的投诉:{user_input},生成包含道歉、原因说明和解决方案的回复。"

)

# 加载评估器(准确率评估)

evaluator = load_evaluator("accuracy")

# 测试用例(输入+期望输出)

test_cases = [

{

"input": "我的快递已经延迟3天了,什么时候能到?",

"expected_output": "您好,非常抱歉您的快递延迟了。我们正在加急处理,预计明天就能送达。为了表达歉意,我们将为您发放一张5元无门槛优惠券,请注意查收。"

},

{

"input": "快递延迟了,我急着用,怎么办?",

"expected_output": "您好,非常抱歉给您带来不便。您的快递延迟是由于近期疫情导致的物流积压,我们已经为您优先安排配送,预计今天下午就能送达。同时,我们为您申请了一张10元优惠券,希望能弥补您的损失。"

}

]

# 运行评估

llm = OpenAI(temperature=0)

results = []

for case in test_cases:

# 生成提示输出

output = llm(prompt.format(user_input=case["input"]))

# 评估准确率

score = evaluator.evaluate_strings(

prediction=output,

reference=case["expected_output"]

)

results.append({"input": case["input"], "output": output, "score": score["score"]})

# 打印结果

print("评估结果:")

for res in results:

print(f"输入:{res['input']}")

print(f"输出:{res['output']}")

print(f"准确率:{res['score']:.2f}")

print("---")

运行后会输出每个测试用例的准确率,帮助你快速判断提示是否符合需求。

3. 协作工具:提升团队沟通效率

核心需求:支持版本管理、知识共享、任务跟踪。

推荐工具:

- Git(版本控制):用分支管理提示版本(如feature/optimize-complaint-prompt),提交记录可以回溯每一次修改的原因;

- Confluence(知识库):建立“提示工程wiki”,包含流程规范、工具使用指南、常见问题解答(FAQ)、优秀提示案例;

- Jira/Teambition(项目管理):用任务跟踪提示研发进度(如“设计快递延迟提示”“完成自动化测试”),支持分配责任人和截止日期;

- Slack/DingTalk(即时通讯):建立“提示工程”频道,分享最新的工具更新、优秀案例、用户反馈,方便团队成员实时沟通。

使用示例:用Git管理提示版本,流程如下:

- 设计师在本地创建分支(feature/new-prompt);

- 设计完成后,提交代码(包含提示模板和测试用例);

- 发起Pull Request(PR),邀请架构师评审;

- 评审通过后,合并到主分支(main);

- 运维工程师从主分支拉取代码,部署到线上环境。

4. 部署与优化工具:提升服务性能与稳定性

核心需求:支持快速部署、弹性扩容、实时监控、智能优化。

推荐工具:

- Serverless 平台(如AWS Lambda、阿里云函数计算):无需管理服务器,按需分配资源,适合高并发场景(如电商大促期间的提示服务);

- API 网关(如AWS API Gateway、阿里云API网关):统一管理提示服务的入口,支持流量控制、权限验证、缓存策略(如缓存高频有效提示);

- 监控工具(如Prometheus+Grafana、阿里云ARMS):监控服务的响应时间、错误率、资源消耗(如Token使用量),设置报警规则(如响应时间超过2秒时发送警报);

- 智能优化工具(如LangChain Memory、阿里云Prompt优化):用历史数据训练模型,推荐有效的提示模式(如“包含示例的提示准确率比不包含的高30%”),支持实时反馈调整(如根据用户输入动态增加约束条件)。

使用示例:用AWS Lambda部署提示服务,流程如下:

- 用Python编写提示处理函数(调用OpenAI API生成结果);

- 在AWS Lambda控制台创建函数,上传代码;

- 配置API Gateway作为入口,设置路径(如“/prompt/complaint”);

- 启用缓存(缓存有效期1分钟),减少重复调用;

- 用CloudWatch监控函数的调用次数、响应时间、错误率。

工具链建设的价值:将“手动操作”转化为“自动化流水线”,提升研发效率(如部署时间从几小时缩短到几分钟);支持弹性扩容,应对高并发场景;实时监控让问题早发现早解决,提升服务稳定性;智能优化工具让提示“自我进化”,减少人工干预。

(三)维度三:团队协作机制——从“各自为战”到“协同作战”

流程和工具是“硬件”,团队协作机制是“软件”。没有良好的协作机制,流程和工具无法发挥最大价值。以下是关键的协作机制设计:

1. 角色分工:明确责任边界

核心原则:“专业的人做专业的事”,避免职责重叠或遗漏。

常见角色与职责:

- 提示工程架构师:负责流程设计、工具选型、团队协作机制建立、性能优化;

- 提示设计师:负责根据需求设计提示模板、补充示例、参与迭代优化;

- 测试工程师:负责编写测试用例、执行自动化测试、生成评估报告;

- 运维工程师:负责部署提示服务、监控服务性能、处理线上问题;

- 产品经理:负责对齐业务目标、收集用户反馈、推动迭代优化;

- 用户研究工程师:负责拆解用户意图、分析用户反馈、提供设计建议。

2. 知识共享:避免“信息孤岛”

核心原则:“让每个人都能获得所需的知识”,减少重复学习成本。

常见方式:

- 内部wiki:建立“提示工程知识库”,包含流程规范、工具使用指南、常见问题解答、优秀案例、历史版本记录;

- 定期培训:每月组织一次培训,主题可以是“新工具介绍”“优秀案例分享”“用户反馈分析”,由团队成员轮流主讲;

- 师傅带徒弟:为新人分配“导师”,指导他们熟悉流程、工具、团队文化,快速上手工作;

- 知识分享会:每季度组织一次“提示工程峰会”,邀请其他团队的专家(如产品、技术、运营)分享经验,促进跨团队协作。

3. 流程自动化:减少“重复劳动”

核心原则:“能自动化的就不要手动做”,将团队成员从繁琐的重复工作中解放出来。

常见自动化场景:

- 提示生成自动化:用模板引擎(如LangChain Prompt Template)动态生成提示,无需手动修改;

- 测试自动化:用CI/CD工具(如Jenkins、GitHub Actions)自动运行测试用例,每次提交代码都触发测试;

- 部署自动化:用持续部署工具(如Argo CD、阿里云EDAS)自动部署代码到线上环境,无需手动操作;

- 反馈处理自动化:用机器人(如Slack Bot、DingTalk Bot)自动收集用户反馈,分类整理后发送给相关负责人。

示例:用GitHub Actions实现提示工程的CI/CD流程,步骤如下:

- 设计师提交代码到GitHub;

- GitHub Actions触发 workflow,运行测试用例(用Pytest);

- 测试通过后,构建Docker镜像(包含提示服务代码);

- 将镜像推送到Docker Hub;

- 用Argo CD自动部署镜像到Kubernetes集群;

- 部署完成后,发送通知到Slack频道。

(四)维度四:智能优化——从“人工迭代”到“智能进化”

流程标准化和工具链自动化解决了“效率问题”,但要实现“持续提升”,还需要智能优化——用机器学习和历史数据,让提示自动适应需求变化。以下是智能优化的关键方向:

1. 基于历史数据的提示推荐

核心逻辑:收集历史提示的“输入-输出-效果”数据,训练机器学习模型,推荐有效的提示模式。

实现步骤:

- 数据收集:用工具(如PromptLayer、LangChain Memory)收集历史提示数据(包含提示内容、用户输入、生成结果、准确率、用户反馈);

- 特征工程:提取提示的特征(如长度、结构(是否包含示例)、关键词)、用户输入的特征(如意图、场景)、效果特征(如准确率、响应时间);

- 模型训练:用分类模型(如随机森林、XGBoost)或深度学习模型(如BERT)训练“提示效果预测模型”,输入提示特征和用户输入特征,输出“预测准确率”;

- 提示推荐:当设计师需要设计新提示时,模型根据用户需求(如“生成电商产品描述”)推荐有效的提示模式(如“包含示例的结构化提示”)。

示例:用XGBoost训练提示效果预测模型,特征包括:

- 提示长度(number_of_words);

- 是否包含示例(has_examples,0/1);

- 是否包含约束条件(has_constraints,0/1);

- 用户意图(intent,如“投诉”“咨询”);

- 场景(scene,如“电商”“金融”)。

模型输出“预测准确率”(0-1),设计师可以根据推荐的提示模式快速设计,减少试错时间。

2. 实时反馈调整

核心逻辑:根据用户的实时输入和反馈,动态调整提示内容。

实现步骤:

- 实时监控:用工具(如LangChain Memory、阿里云Prompt优化)监控用户的输入和生成结果;

- 反馈收集:通过用户界面(如“是否满意本次回复?”)收集用户反馈;

- 动态调整:用规则引擎或机器学习模型,根据反馈调整提示(如用户反馈“结果不够详细”,则自动增加“包含更多细节”的约束条件)。

示例:用规则引擎实现实时反馈调整,规则如下:

- 如果用户反馈“结果不符合意图”,则自动在提示中增加“必须包含{user_intent}”的约束条件;

- 如果用户反馈“结果太长”,则自动在提示中增加“{word_count}字以内”的输出要求;

- 如果用户反馈“结果不够礼貌”,则自动调整语言风格(如将“你的问题已收到”改为“您好,我们已收到您的问题”)。

3. 性能优化

核心逻辑:用智能算法优化提示的“效果-性能”平衡(如在不降低准确率的前提下,减少提示长度,提升响应时间)。

实现技巧:

- 提示压缩:用自然语言处理技术(如文本摘要、关键词提取)压缩提示长度(如将“请你帮我生成一个包含产品特点、适合场景、目标用户的电商产品描述”改为“生成电商产品描述,包含产品特点、场景、目标用户”);

- 缓存策略:用缓存(如Redis、AWS ElastiCache)缓存高频有效提示(如“快递延迟投诉”的常见回复),减少重复调用大模型的次数;

- 分布式部署:用分布式系统(如Kubernetes)部署提示服务,将提示分配到多个节点,提升并发处理能力;

- 模型选择:根据场景选择合适的大模型(如用GPT-3.5处理简单场景,用GPT-4处理复杂场景),平衡效果与成本(GPT-4的准确率比GPT-3.5高,但价格贵5倍)。

智能优化的价值:将“人工迭代”转化为“智能进化”,减少设计师的重复劳动;让提示自动适应需求变化(如用户意图的变化、业务场景的扩展);提升提示的效果和性能,降低资源成本。

四、进阶探讨:常见陷阱与最佳实践

(一)常见陷阱:避免“踩坑”

- 过度依赖复杂提示:认为“提示越详细越好”,导致提示长度过长,增加模型负担,降低响应时间。解决方法:通过测试找到“最简有效提示”(如用自动化测试比较不同长度提示的效果)。

- 忽视用户反馈:认为“自己的设计更专业”,导致提示效果偏离用户需求。解决方法:建立用户反馈收集机制(如在回复中增加“是否满意?”的选项),定期分析反馈(如每周生成用户反馈报告)。

- 缺乏版本管理:没有保存历史版本,导致无法回溯问题(如“上次的提示为什么效果好?”)。解决方法:用Git或专门的提示管理工具(如Prompt Studio)保存历史版本,每一次迭代都提交记录。

- 不重视性能优化:只关注准确率,忽视响应时间和资源消耗,导致运维成本增加。解决方法:将性能指标(如响应时间、Token使用量)纳入评估标准,用缓存、分布式部署等技巧优化性能。

(二)最佳实践:专家级建议

- 将提示工程融入DevOps流程:将提示的设计、测试、部署、优化纳入DevOps pipeline,实现“持续集成、持续部署、持续优化”。

- 建立提示知识库:收集优秀的提示模板、示例、用户反馈,形成内部知识库,方便团队成员查阅和复用。

- 定期进行效能审计:每季度检查研发效能指标(如迭代周期、准确率、团队产出率),分析问题(如“迭代周期变长是因为测试环节耗时太久”),调整方案(如“增加自动化测试的覆盖率”)。

- 关注行业趋势:提示工程是一个快速发展的领域,定期关注最新的工具(如OpenAI的Function Calling)、技术(如思维链、自我一致性)、最佳实践(如Google的Prompt Design Guide),保持团队的竞争力。

五、结论 (Conclusion)

1. 核心要点回顾

- 提示工程的研发效能提升需要流程标准化、工具链自动化、团队协作化、智能优化四个维度的闭环;

- 流程标准化是基础,将“个人经验”转化为“团队流程”,减少重复踩坑;

- 工具链自动化是支撑,将“手动操作”转化为“自动化流水线”,提升效率;

- 团队协作化是关键,将“各自为战”转化为“协同作战”,发挥团队优势;

- 智能优化是升级,将“人工迭代”转化为“智能进化”,实现持续提升。

2. 展望未来:提示工程的发展趋势

- AI辅助提示设计:用大模型自动生成提示(如“帮我设计一个生成电商产品描述的提示”),设计师只需微调;

- 跨模态提示:支持文本+图像、文本+语音的提示(如“根据用户上传的图片生成产品描述”);

- 自动评估与优化:用大模型自动评估提示效果(如“这个提示的准确率是多少?”),并自动调整(如“增加示例可以提高准确率”);

- 提示工程平台化:出现专门的提示工程平台(如PromptHub、LangChain Platform),整合设计、评估、协作、部署、优化全环节,降低团队的工具选型成本。

3. 行动号召:从“知道”到“做到”

- 第一步:梳理当前团队的提示工程流程,找出瓶颈(如“测试环节耗时太久”);

- 第二步:选择1-2个关键工具(如Prompt Studio for 设计、LangChain Evaluation for 评估),试点应用;

- 第三步:建立团队协作机制(如Git版本管理、每周知识分享会);

- 第四步:尝试智能优化(如收集历史数据,训练提示推荐模型)。

如果你在实践中遇到问题,欢迎在评论区留言,我们一起探讨解决方法。也可以关注我的公众号,获取更多提示工程的实战技巧和工具推荐。

参考资源:

- 《Prompt Engineering Guide》(OpenAI官方指南);

- 《LangChain Documentation》(LangChain官方文档);

- 《AWS Serverless Developer Guide》(AWS Serverless官方指南);

- 《Google Prompt Design Best Practices》(Google官方最佳实践)。

(全文完)

作者:[你的名字]

公众号:[你的公众号]

知乎专栏:[你的知乎专栏]

GitHub:[你的GitHub地址]

更多推荐

已为社区贡献17条内容

已为社区贡献17条内容

所有评论(0)