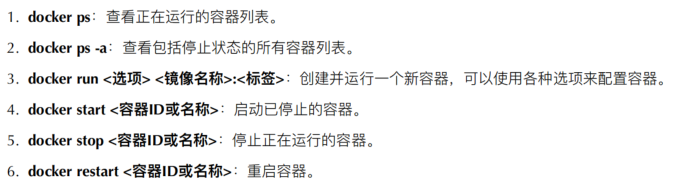

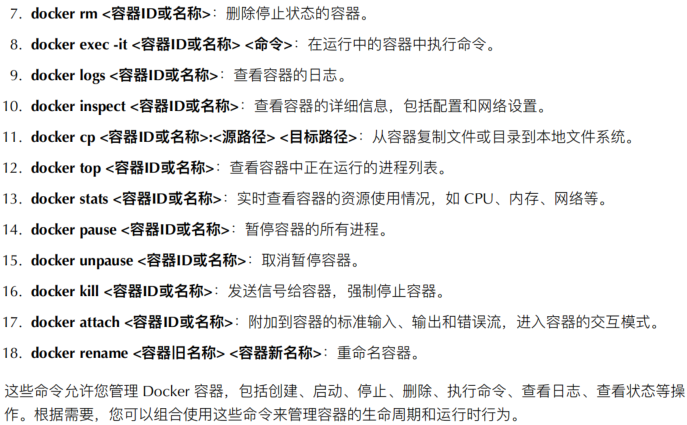

1.常用命令

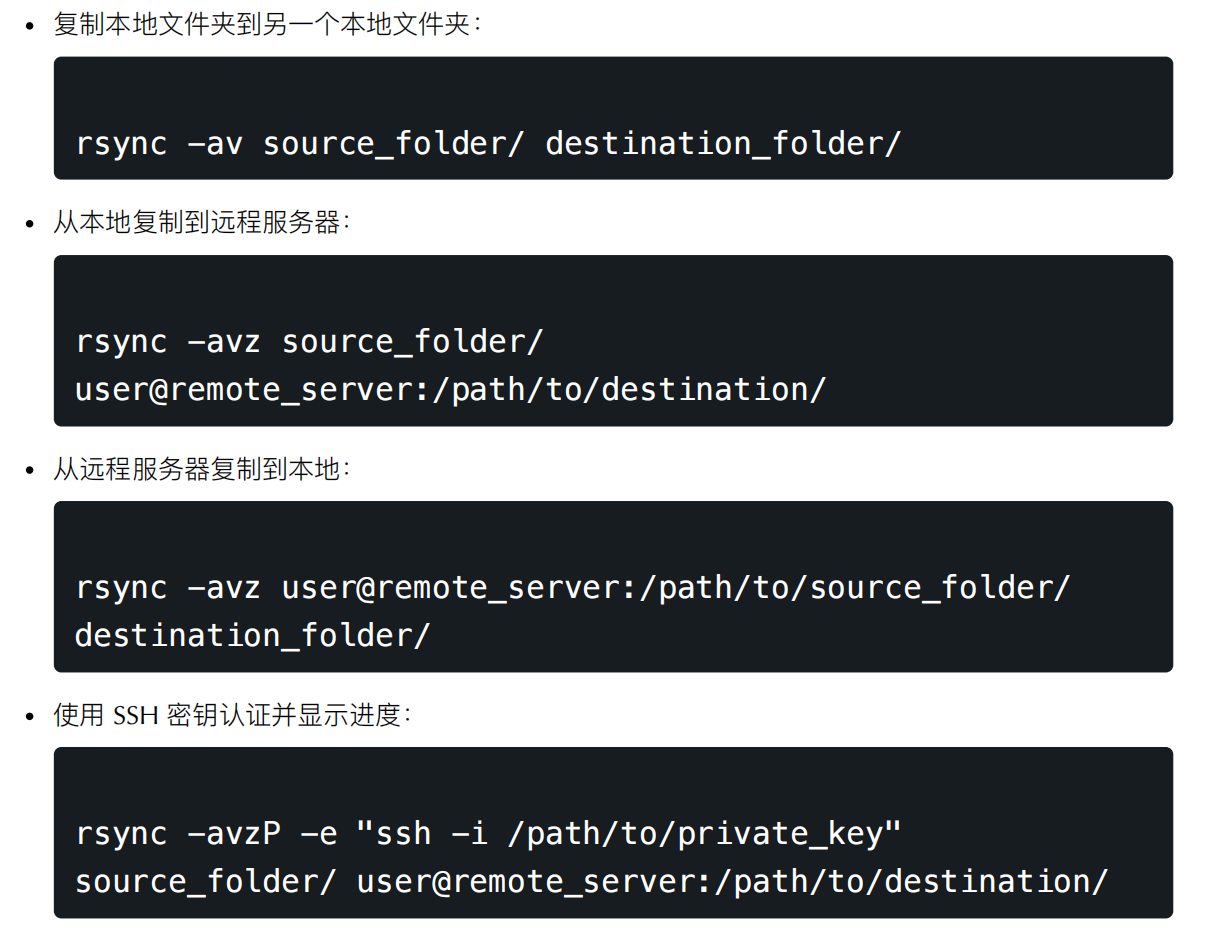

2.rsync常用命令

rsync 是⼀个强⼤的⽂件同步和复制⼯具,⽤于在本地和远程系统之间同步⽂件和目录。以下是⼀些常用的 rsync 命令和选项:

1. 基本的 rsync rsync 命令格式 :

bashCopy code

rsync [options] source destination

● source :源文件或目录的路径。

● destination :目标文件或目录的路径。

2. 常用选项 :

● -a 或 --archive :归档模式,用于递归复制文件和目录,并保留文件属性(权限、所有

者等)。

● -v 或 --verbose :显示详细输出,显示正在复制的⽂件列表。

● -z 或 --compress :启用压缩传输,减少数据传输量。

● -r 或 --recursive :递归复制子目录和⽂件。

● -u 或 --update :仅复制源中更新或新增的文件到目标。

● -n 或 --dry-run :模拟运行,显示将要执行的操作,但不实际执行复制。

● -h 或 --human-readable :以人类可读的格式显示文件大小。

● -P 或 --progress :显示复制进度信息。

3.示例:

这些命令和选项只是 rsync 的⼀部分, rsync 还有许多其他功能和选项,可以根据具体需求

进⾏定制化。要查看更多详细信息和其他选项,可以使⽤ man rsync 命令查看 rsync 的⼿

册页。

3.tar 用法

tar 是⼀个⽤于打包和解压⽂件的命令⾏⼯具,通常在 Linux 和 Unix 系统上使⽤。它的名称来⾃于

"tape archive" ,最初是⽤于在磁带上创建归档备份的⼯具。以下是⼀些常⻅的 tar 命令⽤法示例:

这些是 tar 命令的⼀些常见用法。 tar 还有其他选项和用法,可以根据需要进⾏进⼀步定制化。要

查看更多详细信息和选项,可以使⽤ man tar 命令查看 tar 的⼿册页。

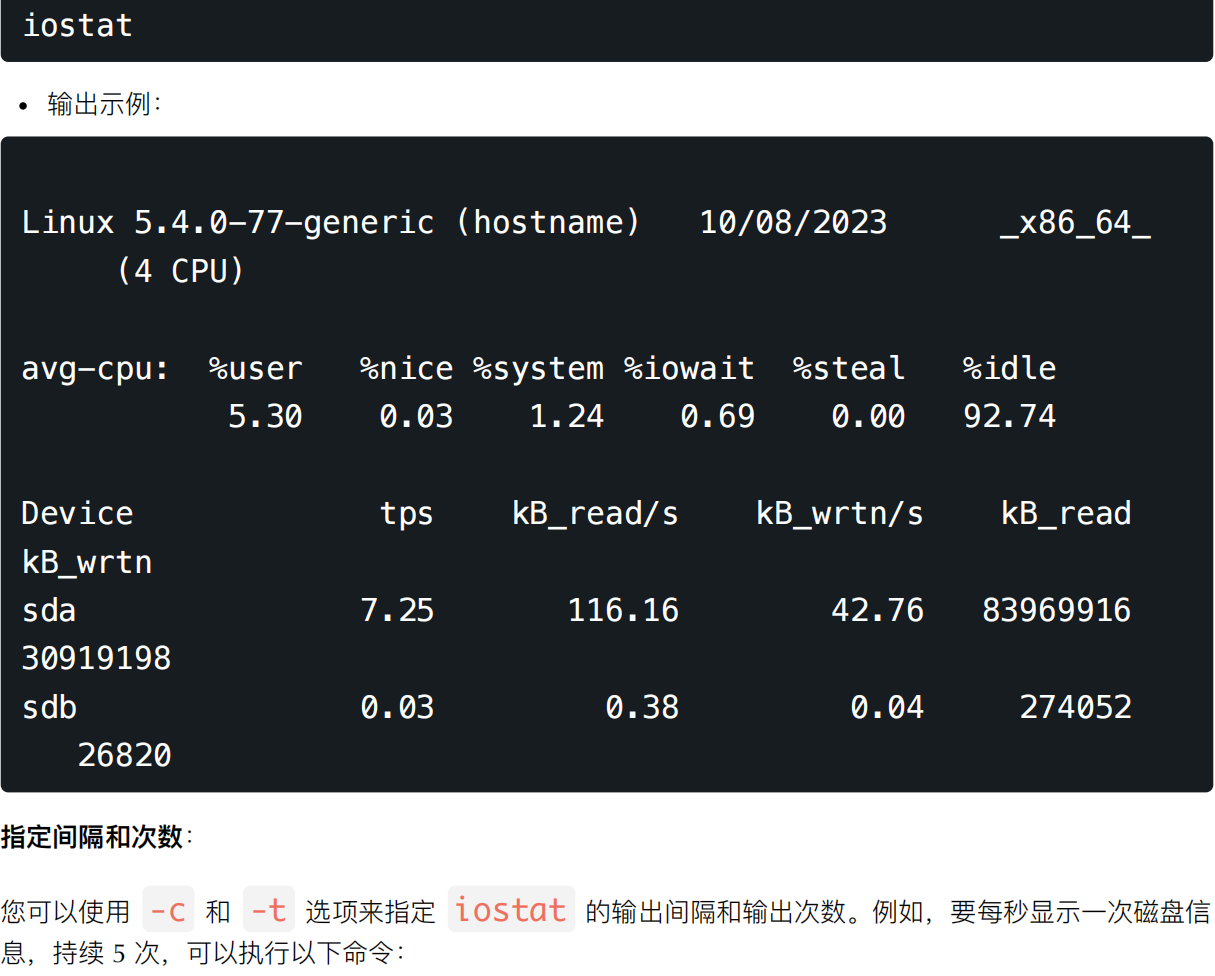

4.iostat用法

iostat 是⼀个⽤于监视系统磁盘输⼊ / 输出( I/O )性能的命令⾏⼯具。它通常包含在 sysstat 软件包中,可以在⼤多数 Linux 发⾏版上找到。 iostat 提供了有关磁盘活动、磁盘性能和负载的详细信息。以下是 iostat 命令的⽤法示例:

基本⽤法 :

默认情况下, iostat 显示的是平均值,显示的是⾃系统启动以来的平均值。要查看当前的瞬时值,可以使⽤ -t 选项。

5.运维工作的日常内容描述

运维(运维⼯作)是指对计算机系统、服务器、⽹络和应⽤程序等进⾏监控、维护、管理和优化的⼀系列⼯作,旨在确保系统的稳定性、可靠性和⾼性能运⾏。以下是运维⼯作的日常描述:

1. 监控系统状态 :

每天开始⼯作时,运维⼈员通常会⾸先检查各种监控⼯具,以确保系统运⾏正常。这包括检查服

务器的负载、内存、磁盘使⽤率以及⽹络流量等指标。

2. 处理报警 :

如果监控系统检测到任何异常或超过阈值的情况,运维⼈员会⽴即收到报警通知。他们需要快速

响应并解决问题,以防⽌系统故障或性能下降。

3. ⽇常维护 :

运维⼈员会执⾏各种⽇常维护任务,如系统升级、补丁管理、备份和恢复操作。这有助于确保系

统的安全性和稳定性。

4. 故障排除 :

如果⽤户或监控系统报告了问题,运维⼈员将进⾏故障排除。他们会分析⽇志⽂件、检查错误消

息并追踪问题的根本原因,然后采取措施解决问题。

5. 性能优化 :

运维⼈员努⼒确保系统的⾼性能。他们可以调整系统参数、优化数据库查询、缓存设置和负载均

衡配置,以提⾼系统的响应速度。

6. 安全管理 :

运维⼈员负责保护系统免受安全威胁。他们会定期更新防⽕墙规则、监控⽹络流量以检测异常⾏

为,并实施访问控制策略来保护敏感数据。

7. 容量规划 :

随着业务的增⻓,运维⼈员需要监控系统资源的使⽤情况,并进⾏容量规划。他们会预测未来资

源需求,确保系统可以满⾜业务需求。

8. ⽂档和记录 :

运维⼈员会记录系统配置、变更、故障排除过程和维护活动。这有助于建⽴历史记录和知识库,

以便未来的引⽤和培训。

9. 应急响应 :

在系统遇到紧急问题时,运维⼈员需要迅速响应,并采取必要的措施以最⼩化停机时间。这可能

包括修复硬件故障、恢复备份或实施紧急安全措施。

10. 通信与合作 :

运维人员需要与其他团队(如开发、安全和⽹络团队)进⾏协作,确保系统的整体健康和性能。

总之,运维⼯作涵盖了⼴泛的任务和责任,旨在确保系统的稳定性、可⽤性和安全性。这需要不断学习和适应新技术,以满⾜不断变化的业务需求。

6.你之前运维做过哪些工作

●看监控中⼼,处理警告问题:⽐如磁盘分区超过80% 、某台机器负载⻓时间偏⾼(超过 20 )、某 台nginx服务器偶尔出现 502 状态码。

●编写数据库备份脚本、监控脚本( web 服务、系统状态)、系统安全检测脚本、日志收集脚本、 ⽇常代码发布的脚本。

●根据开发或者运营同事的需求,部署或者配置环境。

●故障的处理:⽹站访问慢或访问不了、服务器宕机、某个服务宕掉、ddos 攻击、 cc 攻击、磁盘损 坏、存储损坏、磁盘空间撑满、mysql 主从不同步、 mysql 查询慢等。

●关注⼀线资讯,学习新技能:开源中国、51cto 、 CSDN 、博客园、 www.yuchaoit.cn

7.谈谈你对运维工程师的理解以及对工作的认识

运维⼯程师在公司当中责任重⼤,需要保证时刻为公司及客户提供最快、最稳定、最安全的服务。在日常工作中,需要做好监控和事故预案,在平时,运维不仅仅要给研发、测试提供协助,还要⾃发性地去研究和分析服务器上的⼀些性能指标和日志,从而给研发同事提供⼀些数据和线索来优化业务。

运维⼯程师( Operations Engineer )是 IT 领域中不可或缺的⼀部分,他们在确保系统和服务的可靠性、稳定性和安全性⽅⾯扮演着关键⻆⾊。以下是我对运维⼯程师的理解以及对⼯作的认识:

1. 系统稳定性的守护者 :运维⼯程师的主要职责之⼀是确保整个系统在正常运⾏时保持⾼度稳定。他们通过监控、故障排除和预防措施,致⼒于降低系统中断和故障的⻛险。

2. ⾃动化与脚本编写 :现代运维⼯作越来越强调⾃动化。运维⼯程师编写脚本和⼯具,以⾃动执⾏⽇常任务、配置管理和问题响应,从⽽提⾼效率并减少⼈为错误。

3. 安全性维护 :运维⼯程师在系统和应⽤程序的安全性⽅⾯发挥关键作⽤。他们负责定期更新和维护安全补丁,监测潜在的安全漏洞,并采取措施防⽌未经授权的访问。

4. 持续学习与适应 : IT ⾏业变化迅速,运维⼯程师需要不断学习新的技术和⼯具,以适应新的挑战。他们可能需要了解云计算、容器化、⾃动化部署等新兴技术。

5. 团队协作 :运维⼯程师通常需要与开发团队、⽹络团队和安全团队等其他部⻔紧密合作。有效的团队协作对于解决问题和实现项⽬⾄关重要。

6. 突发事件处理 :运维⼯程师必须迅速应对突发事件,如服务器宕机、数据丢失或安全攻击。他们需要冷静、有组织地处理这些问题,以最⼩化影响。

7. ⼯作的变化性 :运维⼯程师的⼯作往往具有⼀定的变化性,每天可能会⾯临不同的挑战。这使得⼯作充满活力和刺激。

总的来说,运维⼯程师是确保 IT 基础设施正常运行和安全的关键⻆⾊。他们的⼯作需要技术深度、不断学习和适应新技术的能⼒,同时也需要具备协作和问题解决的技能。运维⼯程师的⼯作对于维持业务的连续性和用户满意度⾄关重要。

8.linux上进程有5中状态

你提到的 Linux 上进程的 5 种状态是经典的进程状态分类,它们对于理解进程在操作系统中的运⾏状态⾮常重要。这5 种状态是:

1. 运行(Running ):进程当前正在 CPU 上执⾏,或者在运⾏队列中等待执⾏。这是进程处于活跃状态的时候。

2. 中断(Interruptible Sleep ):进程处于等待状态,通常在等待某些条件的形成或者等待信号的到来时会进⼊这个状态。这种状态是可被中断的,当条件满⾜或者收到信号时,进程会被唤醒。

3. 不可中断(Uninterruptible Sleep ):与中断状态类似,但进程在这种状态下是不可被中断的,通常是在等待硬件资源或者⽂件系统操作完成时进⼊。这种状态下的进程只能等待,⽆法被强制中断。

4. 僵死(Zombie ):僵⼫进程是已经终⽌但其⽗进程尚未调⽤ wait() 或 waitpid() 系统调⽤

来获取其退出状态的进程。这种状态下,进程的资源描述符还未完全释放,但进程已经不再执⾏。

5. 停止(Stopped ):进程处于停⽌状态,通常是因为收到了 SIGSTOP 、 SIGSTP 、 SIGTI

N 、 SIGTOU 等信号⽽停⽌运⾏。这种状态下的进程不会消耗 CPU 时间,可以通过 SIGCONT 信

号来唤醒。

了解这些进程状态对于诊断和管理系统中的进程⾮常重要,可以帮助管理员追踪问题和优化系统性能。

9.描述Linux运行级别0-6的各自含义

在 Linux 系统中,运⾏级别是指不同的系统运⾏模式或状态,每个级别对应着⼀组特定的服务和功能。以下是常建的Linux 运⾏级别 0 到 6 的含义:

1. 运行级别0 :关机状态。在这个级别下,系统会关闭所有服务,并安全地关闭电源,将计算机关闭。

2. 运行级别1 :单⽤户模式。也称为救援模式或维护模式。在这个级别下,系统启动到⼀个最⼩的环境,只有⼀个超级⽤户可以登录,⽤于系统故障修复和维护。

3. 运行级别2 :多⽤户模式,没有 NFS ( Network File System )。在这个级别下,系统启动到多⽤户模式,但不挂载⽹络⽂件系统(NFS )。

4. 运行级别3 :多⽤户模式。这是⼀个标准的多⽤户运⾏级别,系统启动后,所有正常服务都会运⾏,通常⽤于服务器环境。

5. 运行级别4 :保留级别。这个级别通常没有特殊⽤途,由系统管理员⾃⾏定义。

6. 运行级别5 :图形⽤户界⾯( GUI )模式。在这个级别下,系统启动到具有图形⽤户界⾯的多⽤户模式,通常是桌⾯Linux 发⾏版的默认模式。

7. 运行级别6 :重新启动。在这个级别下,系统会重新启动,类似于运⾏级别 0 ,但不会关闭源。

10.描述Linux系统从开机到登录界面的启动过程

Linux 系统的启动过程可以⼤致分为以下几个阶段:

1. BIOS/UEFI 阶段:当计算机启动时,⾸先会执⾏计算机的基本输⼊ / 输出系统( BIOS )或统⼀的扩展固件接⼝(UEFI )。在这个阶段,计算机会执⾏⾃检( POST )、初始化硬件设备,并且尝试引导操作系统。BIOS 会加载引导设备上的引导程序(通常是 GRUB ),而 UEFI 则会直接加载引导程序。

2. 引导加载程序(Boot Loader )阶段:引导加载程序是⼀个⼩型的程序,其主要任务是加载操作系统的内核(Kernel )。在 Linux 系统中, GRUB ( GRand Unified Bootloader )是常⽤的引导加载程序。GRUB会读取其配置⽂件,确定要加载的内核和启动选项,然后将内核加载到内存中。

3. 内核初始化阶段:⼀旦内核被加载到内存中,它会开始初始化系统的核心功能,包括文件系统、进程管理、内存管理等。内核还会检测和初始化硬件设备,并设置系统的运行环境。这个阶段的输出通常会显示在屏幕上,包括内核的启动消息。

4. Init系统(SysV Init或systemd )阶段:在过去, Linux 系统使⽤ SysV Init 作为初始化进程,现在许多系统已经转向了systemd 。这个初始化进程负责启动系统中的各种服务和进程。它会根据运行级别(或目标)来启动不同的服务,例如网络服务、文件系统挂载、日志记录等。在这个阶段,也会启动登录管理器(如GDM 、 LightDM 等)以显示登录界面。

5. 登录界⾯(Login Screen )阶段:一旦登录管理器启动,它会显示⼀个登录界面,等待用户输入用户名和密码。用户在此登录并进入桌面环境。

11.解释缓存雪崩、击穿、穿透

1. 缓存雪崩(Cache Avalanche ):

描述:缓存雪崩是指在某个时间点上,⼤量缓存中的数据同时失效或过期,导致所有相关请求都

需要从后端数据源重新加载,引发短时间内的⼤规模请求。这可能导致数据库或后端系统负载剧

增,甚至崩溃。

原因:通常由于缓存数据的失效时间相近或相同,或者缓存服务器重启等原因导致。

2. 缓存击穿(Cache Miss):

描述:缓存击穿是指某个请求需要访问缓存中不存在的数据,而这些数据同时被大量请求访问,

导致缓存无法起到应有的性能优化作用。

原因:通常由于缓存中没有请求的数据,而该数据又在数据库或后端数据源中存在,并且同时有

多个请求访问这个不存在的数据。

3. 缓存穿透(Cache Penetration):

描述:缓存穿透是指恶意请求或者⾮常频繁的请求访问不存在于缓存和后端数据源的数据,导致

这些请求都直接访问后端数据源,给系统带来不必要的负载。

原因:通常由于缓存中没有请求的数据,并且请求的数据本身不存在于后端数据源中,但是请求

频繁,导致多次无效访问。

解决这些问题的方法包括:

●对缓存数据的失效时间进行随机化,以避免缓存雪崩。

●使用互斥锁或分布式锁来避免缓存击穿,只允许⼀个请求加载数据。

●对于缓存穿透,可以使用布隆过滤器等方法在请求到达前快速检查数据是否有效。

总之,了解这些缓存问题并采取相应的预防措施对于维护系统的性能和稳定性非常重要。

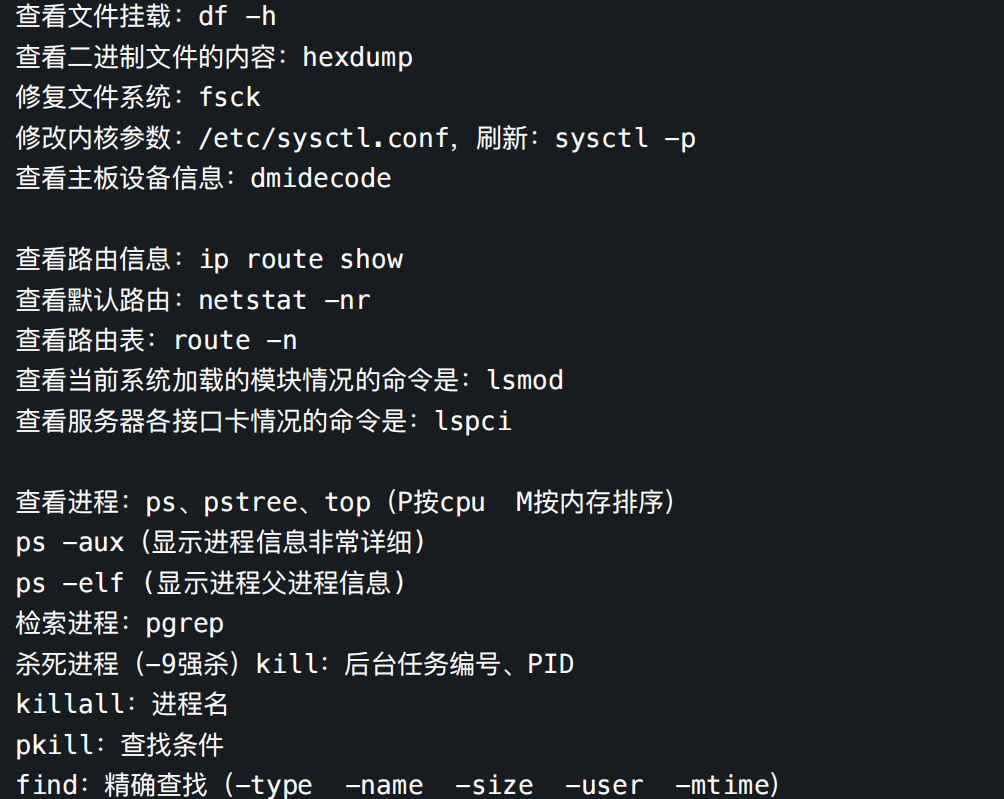

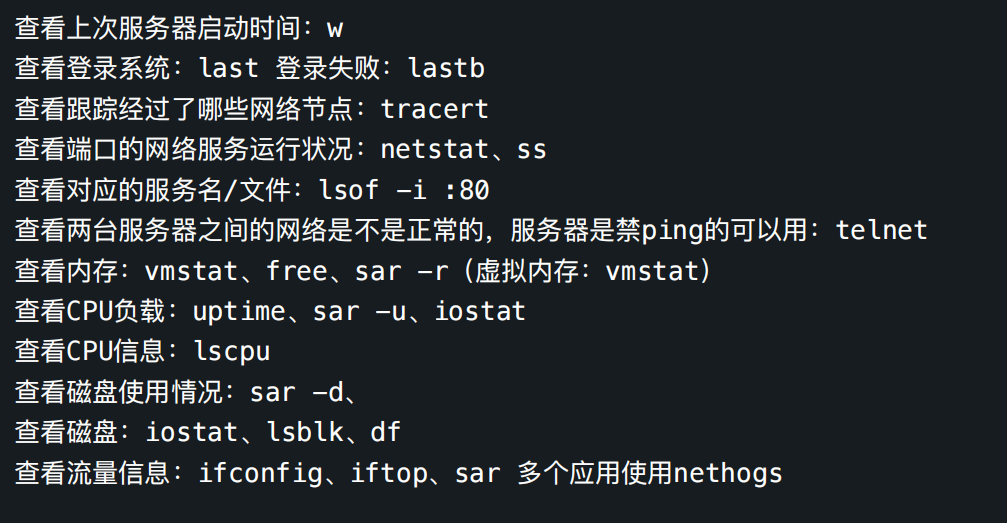

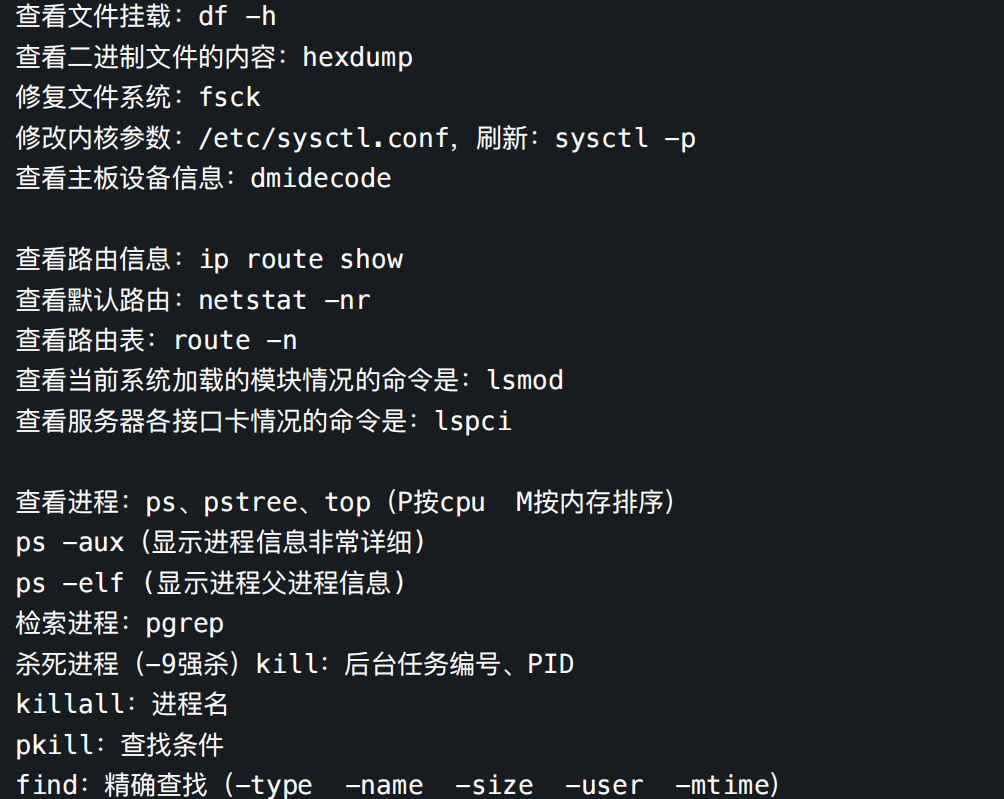

12.说出系统里用于维护系统的命令

1. 系统信息和状态 :

uname :显示系统信息。

top :实时查看系统状态和进程信息。

free :显示内存使⽤情况。

df :查看磁盘空间使⽤情况。

du :查看⽂件或⽬录的磁盘使⽤情况。

2. 进程管理 :

ps :显示进程信息。

kill :终⽌进程。

pkill :根据进程名终⽌进程。

pgrep :根据进程名查找进程 ID 。

3. ⽇志查看:

tail :查看⽂件尾部内容,常⽤于查看⽇志⽂件。

cat :查看⽂件内容。

grep :搜索⽂本⽂件。

4. 用户和权限:

useradd :添加⽤户。

passwd :修改⽤户密码。

userdel :删除⽤户。

chown :更改⽂件或⽬录的所有者。

chmod :更改⽂件或⽬录的权限。

5. ⽹络管理 :

ifconfig :显示和配置⽹络接⼝信息。

netstat :查看⽹络状态。

ping :测试⽹络连接。

ssh :远程登录和管理服务器。

iptables :配置防⽕墙规则。

6. 软件包管理 :

apt-get ( Debian/Ubuntu )或 yum ( Red Hat/CentOS ):安装、更新和删除软件包。

dpkg ( Debian/Ubuntu )或 rpm ( Red Hat/CentOS ):管理软件包。

wget :下载⽂件和资源。

tar :解压和打包⽂件。

7. 定时任务 :

cron :⽤于执⾏定时任务,编辑任务可以使⽤ crontab 命令。

8. ⽂件操作 :

mv :移动或重命名⽂件。

cp :复制⽂件。

rm :删除⽂件。

find :搜索⽂件和⽬录。

ln :创建链接。

9. 硬件信息 :

lscpu :查看 CPU 信息。

lshw :查看硬件信息。

lsblk :查看块设备信息。

lspci :查看 PCI 设备信息。

10. 服务管理 :

systemctl ( systemd )或 service ( SysV init ):管理系统服务。

systemctl start/stop/restart/service_name :启动 / 停止 / 重启服务。

13.shell脚本通常用在什么地方

Shell 脚本是⼀种⽤于⾃动化和批量执⾏任务的脚本语⾔,通常在以下地⽅得到⼴泛应⽤:

1. 系统管理和自动化 :管理员可以编写 Shell 脚本来⾃动执⾏常⻅的系统管理任务,如备份数据、清理日志、定期维护等。

2. 服务器配置和部署 :在服务器部署和配置过程中, Shell 脚本可以⽤来安装软件、配置环境变量、创建用户等。

3. 日 常任务自动化 : Shell 脚本可以⽤于定期执⾏任务,如⽣成报告、发送邮件通知、定时备份数据等。

4. 监控和日志分析 : Shell 脚本可⽤于监控服务器性能、分析⽇志⽂件,以及触发警报和通知。

5. 数据处理和转换 :在数据处理领域, Shell 脚本可以⽤来处理⽂本⽂件、 CSV ⽂件、⽇志⽂件等,提取所需信息或进⾏数据转换。

6. 自 动化测试 :开发⼈员可以编写 Shell 脚本来⾃动运⾏测试⽤例,检查应⽤程序的正确性。

7. 用 户和权限管理 : Shell 脚本可以⽤于创建、修改、删除⽤户账户,以及管理⽂件和⽬录的权限。

8. 定时任务 : Shell 脚本通常⽤于通过 crontab 或类似的⼯具执⾏定时任务,如每⽇备份数据库、定期清理临时⽂件等。

9. 部署和配置⼯具 : Shell 脚本在⼀些部署和配置⼯具中被⼴泛使⽤,如 Ansible 、 Chef 和 Puppet 。

10. 快速原型开发 : Shell 脚本是⼀种快速原型开发⼯具,可⽤于测试概念、快速编写⼩⼯具和实⽤程序。

11. ⽇常维护 :在⽇常维护任务中, Shell 脚本可⽤于检查系统健康状况、查找和解决问题,以及执⾏紧急修复。

总之, Shell 脚本是⼀个强⼤的⼯具,可以在各种环境中⽤于⾃动化、管理、分析和监控任务。它是系统管理员、开发⼈员和运维⼈员的重要⼯具之⼀,可以显著提⾼⼯作效率和系统可管理性。

14.nginx优化的地方有哪些

Nginx 是⼀款⾼性能的反向代理服务器和 Web 服务器,可以从多个⽅⾯进⾏优化,以提⾼性能、可靠性和安全性。以下是⼀些可以优化 Nginx 的方面:

1. 配置优化 :

精简配置文件:删除不必要的配置项,保持配置⽂件简洁。

使⽤ include :将配置信息拆分成多个⽂件,便于管理。

合理的 worker_processes 设置:根据服务器的 CPU 核⼼数量来设置⼯作进程数。

调整 worker_connections :根据并发连接数来设置。

启⽤ keepalive 连接:减少客户端和服务器之间的连接建⽴开销。

2. 性能优化 :

启⽤缓存:使⽤代理缓存或者 FastCGI 缓存来加速⻚⾯加载。

启⽤ Gzip 压缩:压缩响应内容,减少带宽消耗。

开启 HTTP/2 :提供更⾼的性能和并发连接。

启⽤ SSL 加速:使⽤ HTTPS 加速,可以使⽤缓存和更快的传输协议。

负载均衡:使用 Nginx 的负载均衡模块分发流量到多个后端服务器。

3. 安全优化 :

配置防⽕墙规则:限制对 Nginx 的访问,只允许特定 IP 或 IP 段。

防止 DDoS 攻击:使⽤ rate limiting 模块来限制请求速率。

启⽤安全头部:添加安全头部如 X-Content-Type-Options 、 X-Frame-Options 和 Content-Security-Policy。

定期更新 Nginx 版本:确保安全漏洞得到及时修复。

4. 日 志和监控优化 :

合理配置日志:控制⽇志级别和格式,避免过多的日志记录。

使用监控⼯具:集成监控⼯具如 Prometheus 、 Grafana 或 ELK Stack 来实时监控 Nginx 性能。

5. 静态资源优化 :

使⽤ CDN :将静态资源如图⽚、 CSS 和 JavaScript ⽂件放在 CDN 上,减轻服务器负载。

配置浏览器缓存:通过响应头部控制浏览器缓存,减少资源加载时间。

6. 容错和可用性优化 :

使⽤备份服务器:配置备份服务器,以备主服务器故障时切换流量。

配置健康检查:使⽤健康检查来监控后端服务器状态,⾃动排除不可⽤的服务器。

使⽤错误页面:自定义友好的错误⻚⾯,提供更好的⽤户体验。 7. 限制资源消耗 :

限制请求大小:通过配置 client_max_body_size 限制请求体⼤⼩,避免恶意请求。

限制请求速率:使⽤ limit_req 模块限制请求速率,防⽌过多的请求。

这些是⼀些常见的 Nginx 优化方案,具体的优化策略应根据你的应⽤需求和服务器性能来选择和调整。在优化之前,建议先进行性能测试和监测,以了解瓶颈所在,然后有针对性地进行优化。

15.tomcat的优化点有哪些

Tomcat 是⼀个⼴泛使⽤的 Java Web 应⽤服务器,⽤于托管 Java Web 应⽤程序。为了获得更好的性能和可用性,以下是⼀些 Tomcat 优化点:

1. 调整线程池参数 :

调整连接器( Connector )的线程池参数,包括最⼤线程数、最⼩线程数和超时时间,以适应服务

器的负载。

使⽤ NIO 连接器: NIO 连接器相对于传统的连接器(如 HTTP/1.1 连接器)具有更好的性能,尤

其是在⾼并发场景下。

2. 启⽤连接器 Keep-Alive :

启⽤ HTTP Keep-Alive ,允许多个 HTTP 请求共享⼀个 TCP 连接,减少连接的建⽴和关闭开销。

3. 使⽤连接池 :

对数据库连接、 JMS 连接等资源使⽤连接池,减少资源的创建和销毁开销。

4. 启⽤压缩 :

启⽤压缩(如 Gzip )来减小传输数据的大小,提高页面加载速度。

5. 静态资源缓存 :

对静态资源(如图片、 CSS 和 JavaScript 文件)启⽤浏览器缓存,减少不必要的请求。

6. 启⽤ HTTPS :

如果需要安全性,考虑启⽤ HTTPS ,但请确保正确配置 SSL/TLS ,以减少性能损耗。

7. 应⽤程序优化 :

优化应⽤程序代码,减少不必要的数据库查询和计算。

使⽤缓存机制,减少对后端服务的请求。

使⽤⾼性能的第三方库和框架。

8. 定期清理⽇志和临时⽂件 :

定期清理 Tomcat 的⽇志和临时⽂件,以防⽌磁盘空间耗尽。

9. 监控和性能测试 :

安装监控⼯具,如 JConsole 、 VisualVM 或专业的应⽤性能监控⼯具,以实时监测 Tomcat 的性

能。

定期进行性能测试,以了解应⽤程序的性能瓶颈。

10. 配置适当的 JVM 参数 :

调整堆⼤⼩、垃圾回收策略和线程数等 JVM 参数,以适应应⽤程序的需求。

11. 负载均衡 :

如果有多个 Tomcat 实例,考虑使⽤负载均衡器来分发流量,提⾼可⽤性和性能。

12. 容错和故障恢复 :

配置 Tomcat 集群,以实现容错和故障恢复。

13. 升级和优化 Tomcat 版本 :

定期升级 Tomcat 到最新版本,以获取性能改进和安全修复。

14. ⽹络优化 :

确保服务器的⽹络连接稳定,避免⽹络延迟和丢包。

15. 资源限制 :

针对恶意请求或 DDoS 攻击,使⽤防⽕墙或反向代理服务器进⾏流量控制。

这些优化点可以帮助提高 Tomcat 服务器的性能和可用性,但需要根据具体的应用和环境来选择和调整。在进行优化之前,建议进⾏性能测试和监测,以了解性能瓶颈和改进的方向。

16.Mysql优化点

MySQL 是⼀个常⽤的关系型数据库管理系统,为了提⾼其性能和可⽤性,以下是⼀些 MySQL 优化点:

1. 索引优化 :

确保表上的列使⽤适当的索引,以加速数据检索。

避免在⾼写⼊负载下使⽤过多的索引,因为索引会增加写⼊成本。

2. 查询优化 :

使⽤合适的 SQL 查询,避免不必要的 JOIN 和子查询。

使⽤ EXPLAIN 来分析查询计划,并优化查询性能。

3. 数据库设计 :

使⽤适当的数据类型,避免使⽤过⼤的数据类型,以减少存储和内存占⽤。 正确设计数据库模式,避免冗余和不必要的复杂性。

4. 缓存机制 :

启⽤查询缓存,以减少相同查询的执⾏次数。

使⽤应⽤程序级别的缓存,如 Memcached 或 Redis ,以减轻数据库负载。

5. 分区和分表 :

对⼤型表进⾏分区或分表,以减少查询的数据量。

6. 优化配置参数 :

调整 MySQL 的配置参数,如缓冲池⼤⼩、连接数、线程数等,以适应服务器硬件和负载。

7. 定期维护 :

定期进⾏数据库备份、优化和碎⽚整理。

清理不再需要的数据,以减⼩数据库⼤⼩。

8. ⾼可⽤性和容错 :

部署 MySQL 集群或主从复制来实现⾼可⽤性和容错性。

使用数据库代理或负载均衡器来分发流量。

9. 监控和性能分析 :

使⽤监控⼯具,如 MySQL Enterprise Monitor 、 Percona Monitoring and Management (PMM) 等,实时监测数据库性能。

使用性能分析⼯具来识别慢查询和性能瓶颈。

10. 事务管理 :

确保事务得到正确处理,避免⻓时间持有锁。

11. 升级数据库版本 :

定期升级 MySQL 到最新版本,以获取性能改进和安全修复。

12. 安全性 :

配置适当的安全性措施,如防⽕墙、访问控制和加密,以保护数据库免受恶意访问和攻击。

13. 存储引擎选择 :

根据应⽤程序的需求选择合适的存储引擎,如 InnoDB 、 MyISAM 、 Memory 等。

14. 连接池 :

使⽤连接池来管理数据库连接,以避免频繁创建和关闭连接。

15. 优化锁 :

使⽤合适的锁策略,避免锁冲突和死锁。

这些优化点可以帮助提高 MySQL 数据库的性能和可用性,但需要根据具体的应用和环境来选择和调整。

在进行优化之前,建议进行性能测试和监测,以了解性能瓶颈和改进的方向。

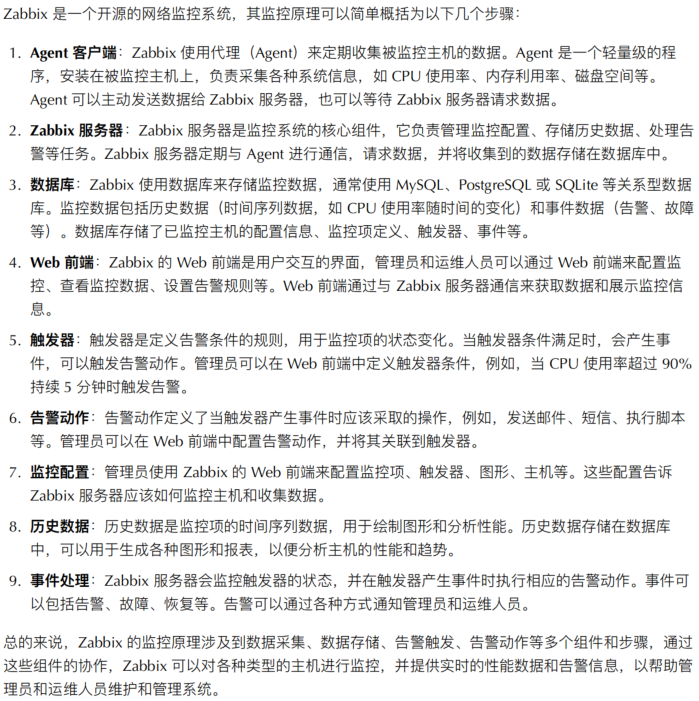

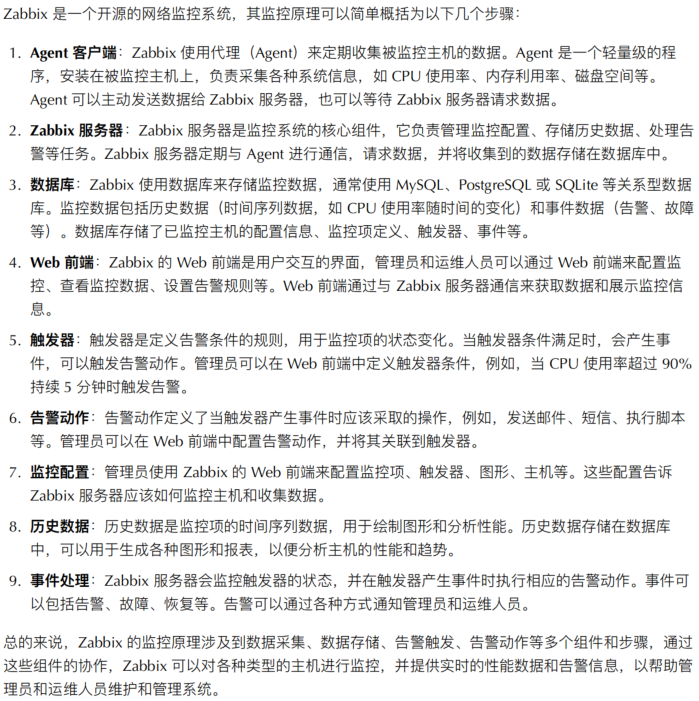

17.zabbix监控原理

18. zabbix可以监控什么

19.zabbix监控模版你了解多少

1. 直观的图形界⾯ : Zabbix 的⽤户界⾯设计直观,容易上⼿。管理员和运维⼈员可以轻松地导航、配置和监控各种资源。

2. ⾃定义仪表盘 : Zabbix 允许用户创建⾃定义仪表盘,将关键性能指标和事件信息汇总在⼀个界⾯上,方便快速查看系统和应⽤程序的状态。

3. 监控模板 : Zabbix 提供了大量的监控模板,这些模板包括了常见的操作系统、数据库、网络设备和应用程序的监控配置。管理员可以基于这些模板快速部署监控方案。

4. ⾃动发现 : Zabbix 具有自动发现功能,可以⾃动检测新的设备和服务,并自动应⽤相应的监控模板,从而减轻了手动配置的⼯作量。

5. 图形和报表 : Zabbix 可以⽣成各种图形和报表,⽤于可视化性能数据的趋势和历史。这些图形和报表可以帮助管理员分析和优化系统性能。

6. 告警和通知 : Zabbix 可以配置告警规则,当监控项达到预定的阈值时,会触发告警通知,支持多种通知方式,包括电子邮件、短信、Slack 等。

7. ⽤户权限和⻆⾊ : Zabbix 具有灵活的⽤户权限和角色管理,管理员可以定义不同的用户角色,并控制⽤户对监控系统的访问权限。

8. 可扩展性 :除了⾃带的监控模板, Zabbix 还⽀持⾃定义监控项和触发器,允许管理员根据实际需求创建新的监控配置。

20.mysql数据库备份策略

1. 定期完整备份 :

每⽇或每周执⾏完整的数据库备份,以确保所有数据都得到备份。

定期将这些完整备份存储在安全的位置,例如另⼀台服务器或云存储。

2. 增量备份 :

使⽤增量备份来减少备份时间和存储空间的需求。增量备份只备份⾃上次备份以来发⽣更改的数

据。可以每⼩时或每隔⼀定时间执⾏增量备份。

3. 事务⽇志备份 :

MySQL 的⼆进制⽇志( Binary Log )记录了所有数据库中的更改。定期备份这些事务⽇志以便在需要时进⾏恢复。

4. 备份测试和验证 :

定期恢复备份以确保备份⽂件没有损坏,且可以成功还原数据库。

5. ⾃动化备份 :

使⽤⾃动化⼯具或脚本来执⾏备份任务,确保备份的⼀致性和可靠性。

6. 备份加密 :

如果备份包含敏感数据,考虑将备份⽂件进⾏加密以保护数据隐私。

7. 远程备份 :

将备份文件存储在远程位置,以防⽌物理损坏或灾难发⽣时的数据丢失。

8. 定期清理备份 :

定期清理不再需要的备份⽂件,以释放存储空间并保持备份环境整洁。

9. 监控和报警 :

设置监控和报警,以便在备份失败或其他问题发⽣时及时采取⾏动。

10. 多备份源 :

如果可能,使⽤不同的备份源来存储备份,以提高冗余性。

11. 数据库快照 :

使⽤数据库快照技术(如 LVM 快照)来创建⼀致性的数据库备份,而不必停⽌数据库。

12. 版本控制备份 :

保留多个备份版本,以便能够恢复到不同的时间点。

13. 备份⽂档和策略 :

记录备份过程的⽂档和策略,以便团队成员了解如何执⾏和恢复备份。

21.mysql主从同步的原理

以下是 MySQL 主从同步的基本原理:

1. 主数据库:主数据库是数据的源头,它负责处理所有写操作( INSERT 、 UPDATE 、 DELETE )和⼀部分读操作(SELECT )。在主数据库上启⽤⼆进制⽇志( Binary Log ),将所有写操作记录到⼆进制⽇志⽂件中。

2. 从数据库:从数据库是主数据库的副本,它负责处理读操作。从数据库通过连接到主数据库,并请求复制主数据库上的⼆进制⽇志⽂件,然后将这些⽇志⽂件中的操作应⽤到⾃⼰的数据上,以保持与主数据库的数据⼀致性。

3. 主从同步的启动:在从数据库上配置主从同步,指定主数据库的地址和认证信息。从数据库连接到主数据库,请求同步的开始位置,然后开始复制主数据库上的⼆进制⽇志。

4. 数据传输:主数据库会将写操作记录到⼆进制⽇志中,并将这些⽇志⽂件传输给从数据库。从数据库不断地轮询主数据库,检查是否有新的⼆进制⽇志需要复制。

5. 数据应⽤:从数据库接收到⼆进制⽇志后,将其中的操作应⽤到⾃⼰的数据上,保持与主数据库的数据⼀致性。从数据库的数据与主数据库的数据保持近乎实时的同步。

6. 复制位置:每个从数据库都会记录⾃⼰复制的位置,以便在断线重连或者切换到其他主数据库时,能够继续从上次的位置进⾏复制。

7. 错误处理:主从同步过程中可能会出现各种错误,包括网络问题、权限问题、主数据库宕机等。从数据库需要能够处理这些错误情况,进⾏错误重试或者切换到其他主数据库。

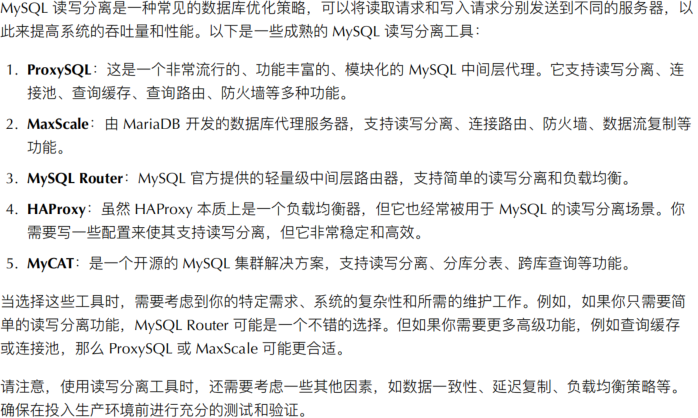

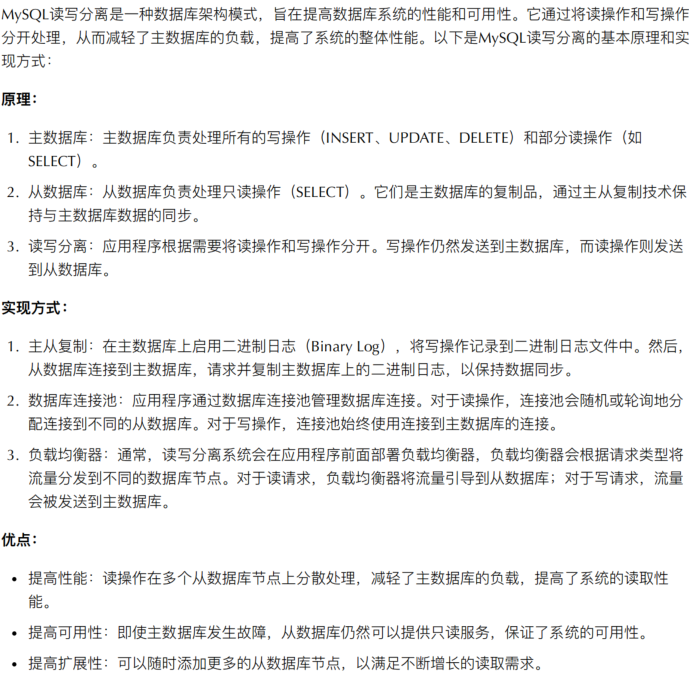

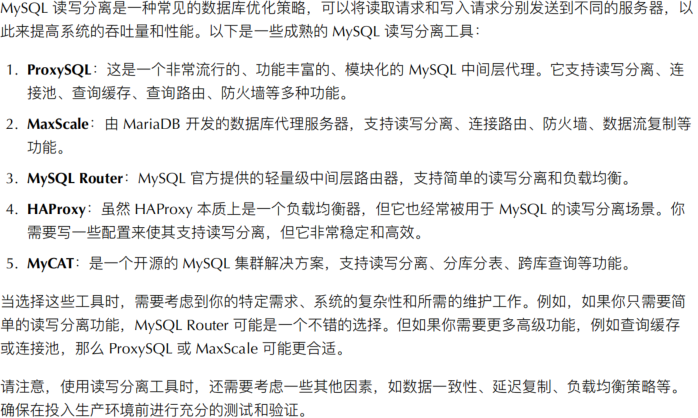

22.说说mysql的读写分离

注意事项:

数据同步延迟:由于主从复制存在⼀定的延迟,所以在读写分离架构中,读操作可能会读取到稍旧的数据。需要根据应⽤场景权衡数据⼀致性和性能。

数据库版本兼容性:主从数据库的版本和配置需要兼容,以确保主从复制正常运行。

数据库连接管理:应⽤程序需要合理管理数据库连接,确保连接池的配置和性能调优。

总之, MySQL 读写分离是⼀种常见的数据库架构模式,可以提高数据库系统的性能和可用性。但在实施时需要根据具体的应⽤场景和需求来进行设计和配置。

23.用过哪些mysql读写分离工具

24.你是怎么备份数据,包括数据库备份的

1. ⽂件和数据备份 :

全备份 :复制所有⽂件。

差异备份 :自上次全备份后更改的所有⽂件。

增量备份 :自上次任何类型的备份后更改的⽂件。

2. 数据库备份 :

全备份 :备份整个数据库,包括所有表和数据。

增量备份 :备份自上次备份以来发⽣变化的数据。

⽇志备份 :备份数据库日志文件。

对于 MySQL ,你可以使⽤以下命令:

mysqldump :⽤于创建数据库的文本文件格式的备份。

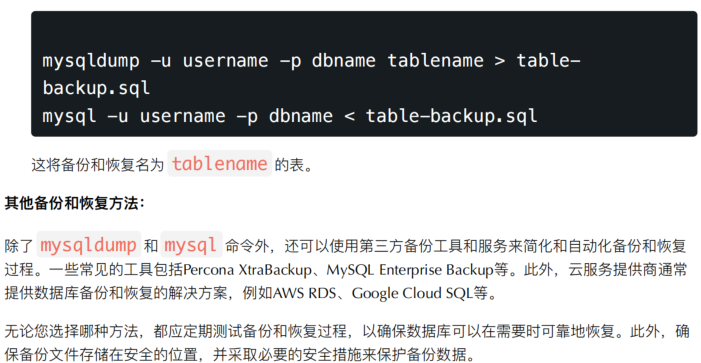

25.你如何对mysql数据库进行备份和恢复

3. 备份和恢复单个表 :

您可以使⽤ mysqldump 备份单个表,然后使⽤ mysql 命令将其恢复。例如:

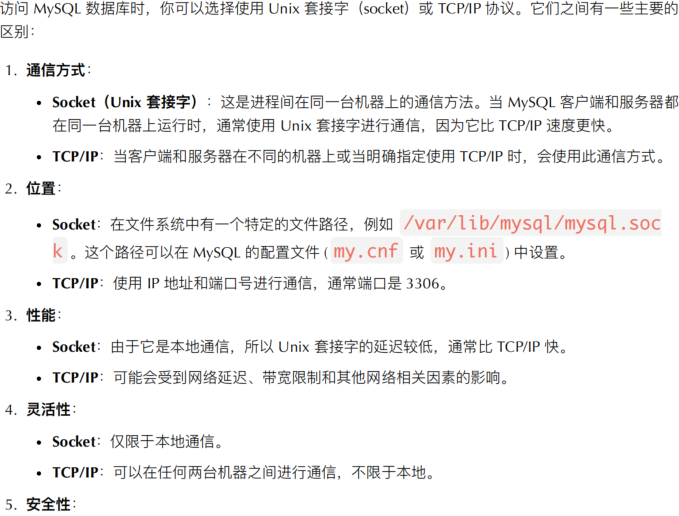

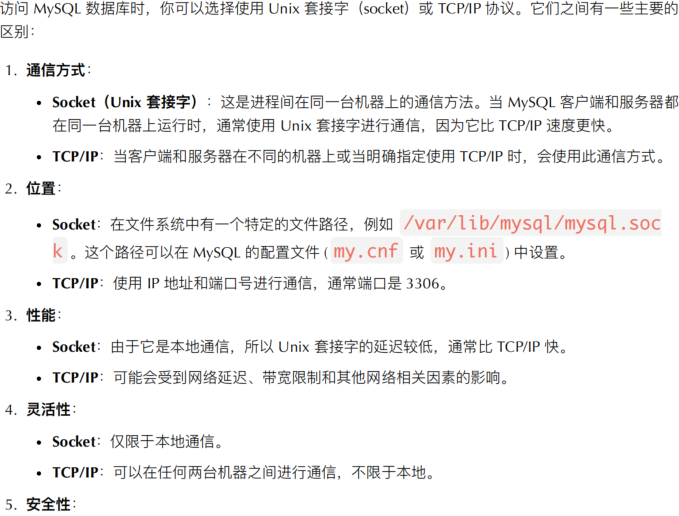

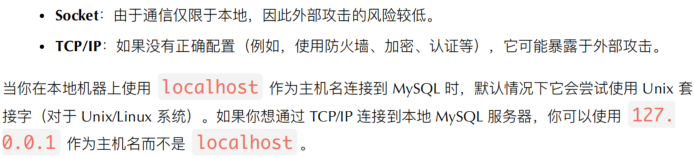

26.socket和tcp访问mysql的区别

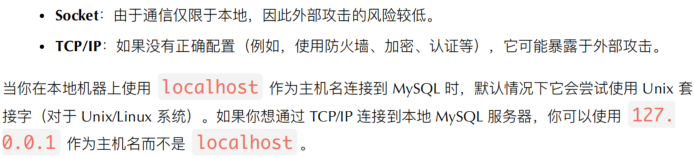

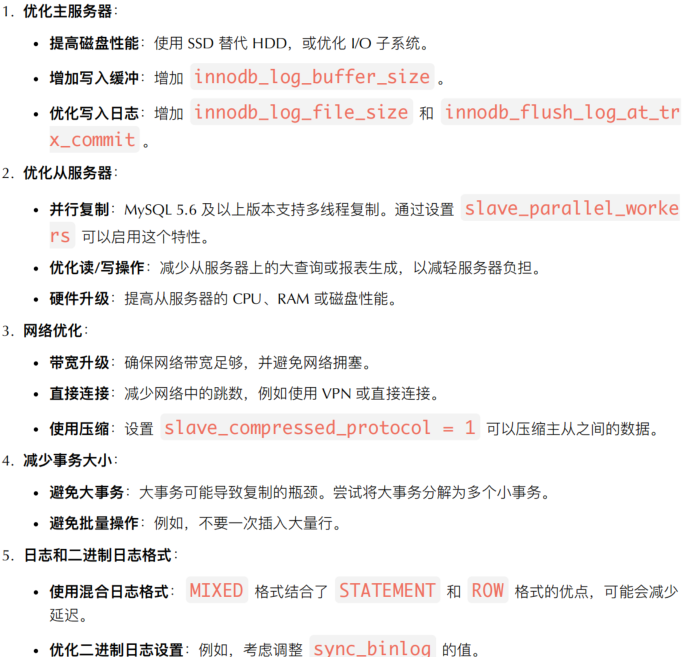

27.mysql如何减少主从复制的延迟

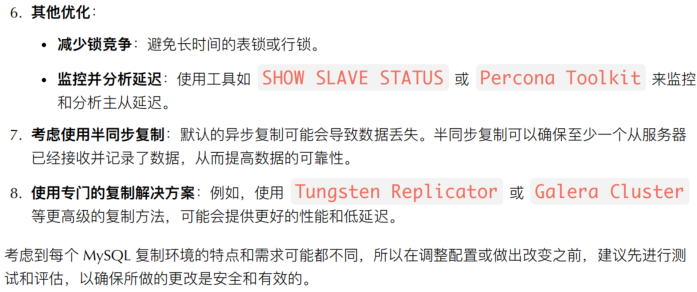

28.TCP/IP原理说⼀下?TCP有哪几个状态,分别是什么意思?

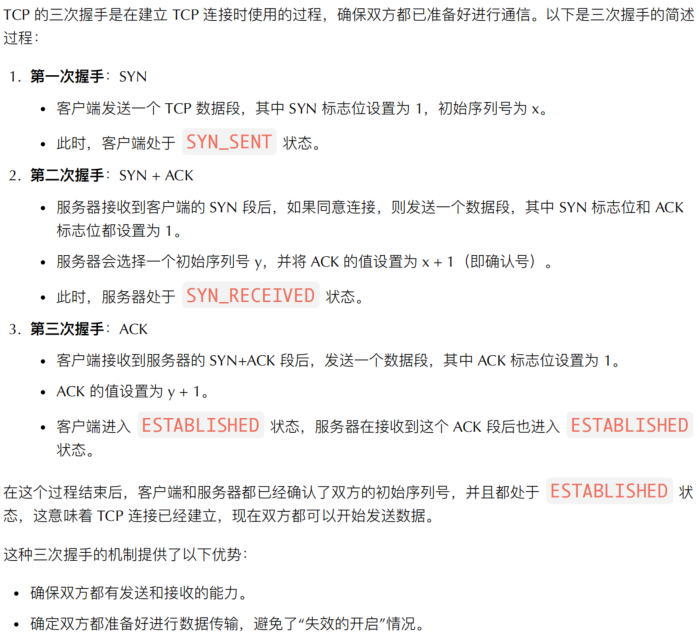

29.简述TCP三次握手的过程?

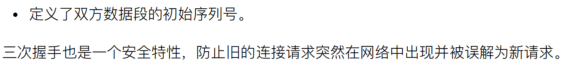

30.为什么连接的时候是三次握手,关闭的时候却是四次握手?

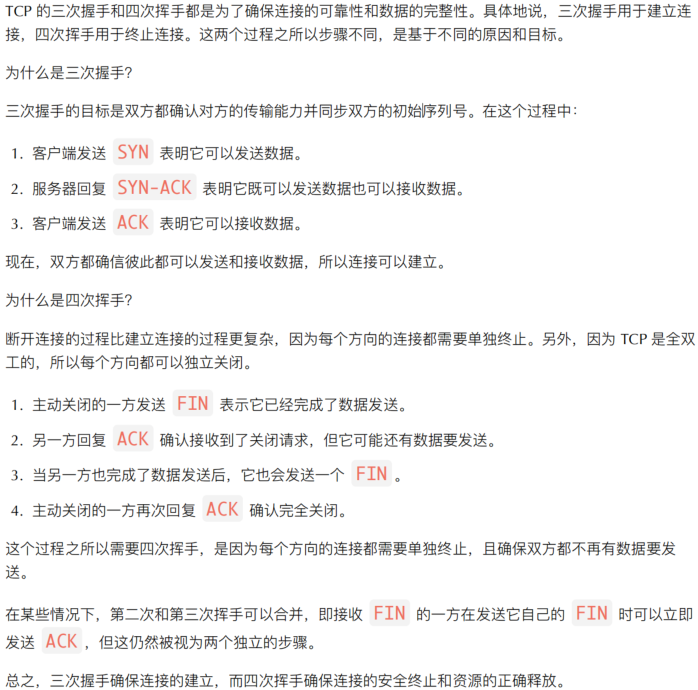

31.dns既采用了tcp协议,又采用了udp协议,什么时候采用tcp协议?什么时候采用udp协议?为什么要这么设计?

32.如何优化Linux系统?

优化 Linux 系统是⼀个⼴泛的话题,具体取决于⽬标应⽤和预期性能。以下是⼀些常⻅的 Linux 系统优化方法和建议:

1. 硬件优化 :

SSD :考虑使⽤固态硬盘 (SSD) 替代传统的机械硬盘,以提⾼ I/O 性能。

增加 RAM :更多的内存可以减少对交换空间的依赖,提⾼系统响应速度。

多核 CPU :对于多线程或多进程的任务,使⽤多核 CPU 可以明显提⾼性能。

2. 文 件系统选择与调优 :

选择最适合你⼯作负载的⽂件系统,如 ext4 、 XFS 、 Btrfs 等。

使用 noatime 或 relatime 挂载选项来减少磁盘 I/O 。

定期进行文件系统检查和碎⽚整理(如果适⽤)。

3. ⽹络调优 :

调整内核参数,如增⼤ net.core.rmem_max 和 net.core.wmem_max 来调整接

收和发送缓冲区大小。

使⽤更快的网络接口和设备,例如 10G 或更⾼的以太⽹卡。

4. 服务与进程管理 :

关闭不必要的后台服务和守护进程 ,释放更多资源给关键任务。

使⽤ nice 和 renice 来调整进程优先级。

使⽤ cgroups 或 systemd 为关键服务分配资源。

5. 内核和系统参数 :

使⽤ sysctl 调整内核参数。例如, vm.swappiness 可以控制系统使⽤交换空间的倾

向。

更新到最新版本的内核,以利⽤最新的性能优化和特性。

6. 存储优化 :

使⽤ I/O 调度器,如 CFQ , Deadline , 或 NOOP ,选择最适合你存储和⼯作负载的调度

器。

考虑使⽤ RAID 配置,特别是 RAID 10, RAID 5, 或 RAID 6 ,根据需要进⾏冗余和性能平衡。

考虑使⽤ tmpfs ( RAM 盘)存放经常读写的临时文件。

7. 安全与稳定性 :

定期更新系统和所有软件包,确保系统安全且性能最佳。

使⽤安全性增强机制如 SELinux 或 AppArmor ,但同时确保不影响关键服务的性能。

8. 性能分析与监控 :

使用工具如 top , vmstat , iostat , htop , nmon 等定期检查系统性能。

对于深度分析,使⽤ perf , strace , dtrace 等⼯具。

9. 其他优化 :

使用轻量级版本的 Linux 发行版,减少不必要的功能和服务。

对于特定任务,如 web 服务或数据库,进行相关的应用级优化。

在进行任何优化之前,最好先对现有的系统性能进⾏基准测试,以便之后可以比较优化的效果。此外,始终确保在⽣产环境应⽤任何更改之前,在测试环境中进行充分测试。

33.从运维角度讲⼀下怎么预防cc攻击和ddos攻击

34.如果你们公司的网站访问很慢,你会如何排查?

如果公司的⽹站访问很慢,排查问题的原因需要⼀个系统性的⽅法。以下是⼀些建议的步骤和⽅法来诊断和解决问题:

1. 确认问题 :

使⽤不同的⽹络和地理位置进⾏测试,确保问题不仅限于某个特定的⽹络或地区。

使用网站速度测试工具(如 Google PageSpeed Insights 、 GTmetrix 、 Pingdom )来获取性能指标。

2. 查看服务器负载和资源 :

使⽤ top 、 htop 、 vmstat 、 iostat 等⼯具检查服务器的 CPU 、内存、磁盘和网络利用率。

检查服务器的带宽使⽤情况,看是否已接近或超出上限。

3. Web 服务器和应⽤服务器检查 :

查看 Web 服务器(如 Apache 、 Nginx )的错误和访问⽇志,查找任何异常或错误。

检查应⽤服务器(如 Tomcat 、 Node.js 、 Django )的⽇志和性能指标。

对于数据库驱动的应⽤,检查数据库查询性能。

4. 数据库优化 :

使⽤数据库性能分析⼯具(如 EXPLAIN 对于 SQL 数据库)来诊断缓慢的查询。

检查数据库的 CPU 、内存和磁盘利⽤率。

考虑增加索引、优化查询或使⽤缓存来改善性能。

5. ⽹络和带宽 :

使⽤ ping 和 traceroute ⼯具来检查⽹络延迟和可能的瓶颈。

使⽤ iftop 或 nload 来查看服务器的⽹络流量。

检查是否存在 DDoS 攻击或其他恶意流量。

6. ⽹站内容优化 :

优化⼤型图⽚或其他媒体⽂件。

使⽤前端性能优化技巧,如合并和压缩 CSS 和 JavaScript ⽂件,利⽤浏览器缓存,使⽤ CDN 。

7. 查看外部服务 :如果你的⽹站依赖于外部 API 或其他第三⽅服务,确保它们的性能和可⽤性。

8. 应⽤代码审查 :可能存在不合理的循环、冗余的代码或其他可以优化的部分。

9. 使⽤性能分析⼯具 :

对于 PHP ,可以使⽤ Xdebug 或 Blackfire 。

对于 Python ,可以使⽤ cProfile 或 Pyflame 。

对于 JavaScript ,使⽤浏览器的开发者⼯具进⾏分析。

10. 检查配置 :

检查 Web 服务器、数据库服务器和其他中间件的配置,确保它们已优化并适用于生产环境。

11. 硬件和托管考虑 :

●如果你自己托管服务器,考虑硬件升级或优化。

●如果使用云服务,考虑增加实例大小、扩展或使用更高性能的实例。

通过系统性地排查上述各个领域,你应该能够定位和解决使公司⽹站变慢的原因。在进行更改或优化之前,始终确保有备份和回滚计划,并在可能的情况下在非⽣产环境中进行测试。

35.网站打不开,排查故障的思路?(网络-服务端⼝-流量-负载-进程-配置-抓包)

当网站无法打开时,可以按照以下思路来排查故障:

1. ⽹络连接 :

检查本地⽹络连接是否正常,确保可以访问互联⽹。

使⽤ ping 命令测试⽬标服务器的可达性。

2. 服务端⼝ : 确保⽬标服务器的服务端⼝是开启的,尤其是 HTTP ( 80 端⼝)或 HTTPS ( 443 端⼝)。

使⽤ telnet 或 nc 命令测试是否可以连接到服务器的特定端⼝。

3. 流量问题 :

查看服务器的⼊⼝和出⼝流量,确保流量没有达到带宽限制。

使⽤流量分析⼯具检查是否有异常的数据包或⼤量的连接请求。

4. 负载问题 :

检查服务器的负载情况,确保服务器资源( CPU 、内存、磁盘)没有达到极限。

使⽤⼯具如 top 或 htop 查看系统负载情况。

5. 进程状态 :

确保⽹站的 Web 服务器(如 Nginx 、 Apache )或应⽤程序服务正在运⾏。

使⽤ ps 命令检查相关进程的状态。

6. 配置问题 :

检查⽹站的配置⽂件,确保没有错误的配置导致服务不可⽤。

查看错误⽇志⽂件,以查找可能的错误信息。

7. 抓包分析 :

使用抓包工具(如 Wireshark )捕获⽹络数据包,以查看通信是否正常。

分析抓包数据,查找异常的⽹络流量或请求。

8. DNS 问题 :

确保 DNS 解析正常,可以通过修改本地 hosts ⽂件测试。

使⽤ nslookup 或 dig 命令测试 DNS 解析是否正确。

9. 防⽕墙和安全组 :

检查服务器上的防⽕墙规则和云服务提供商的安全组设置,确保它们没有限制流量。

解除可能的防⽕墙屏蔽或限制。

10. 硬件故障 :

检查服务器硬件健康状态,包括磁盘、内存和电源供应。

如果是虚拟机,确保宿主机的健康状态。

11. ⽇志分析 :

查看服务器的系统⽇志、 Web 服务器日志和应用程序日志,以查找异常或错误信息。

12. 服务提供商问题 :

如果使⽤云服务提供商,检查他们的服务状态⻚⾯,了解是否有计划维护或故障。

13. 备份和恢复 :

如果有备份,可以考虑还原备份数据,以恢复⽹站服务。

注意备份的频率和可⽤性。

根据问题的具体表现和排查的结果,逐步缩小故障范围,找到并解决问题的根本原因。

36. 简单介绍一下您所知道的减少和加速 web 服务器的请求的方法?

优化 Web 服务器的请求和提高其响应速度是提高用户体验和搜索引擎排名的关键。以下是减少和加速 Web 服务器请求的常见方法:

- 内容传输网络(CDN):使用 CDN 可以将静态资源(如图片、CSS、JavaScript)缓存到地理位置更近的服务器上,从而加速内容的传输速度。

- 浏览器缓存:通过适当的 HTTP 头设置(如 Expires 和 Cache-Control),可以告诉浏览器缓存某些资源,从而减少重复的请求。

- 图片优化:

- 压缩图片以减小文件大小。

- 使用适当的格式,如 WebP 对于现代浏览器。

- 延迟加载图片(Lazy loading),仅在用户滚动到图片时才加载它。

- 合并和压缩资源:

- 将多个 CSS 或 JavaScript 文件合并为单一文件,减少 HTTP 请求的数量。

- 使用工具(如 UglifyJS 或 CSSNano)压缩 JavaScript 和 CSS 文件。

- 使用 HTTP/2:HTTP/2 允许多路复用,这意味着可以通过单一的 TCP 连接并行传输多个请求和响应。

- 减少第三方请求:限制使用的第三方脚本,如广告、追踪器或社交媒体插件,因为它们可能会增加额外的请求和加载时间。

- 优化服务器配置:

- 启用 Gzip 或 Brotli 压缩来减少传输的文本资源大小。

- 调整 Web 服务器的配置(如 Nginx、Apache)以优化连接和资源传输。

- 预取和预连接:

- 使用

<link rel="prefetch/preload"> 提前加载关键资源。

- 使用

<link rel="preconnect"> 预先建立与第三方域的连接。

- 优化数据库查询:

- 对于动态内容,确保数据库查询是高效的。

- 使用缓存机制,如 Memcached 或 Redis,来缓存频繁查询的数据。

- 使用服务器端缓存:对于动态页面,使用如 Varnish 或 Nginx 的缓存功能,可以缓存页面的静态版本以减少数据库查找。

- 减少重定向:避免多余的 301 或 302 重定向,因为它们增加了额外的请求 - 响应循环。

- 减少 DNS 查询时间:限制所请求域的数量,或考虑使用 DNS 预取来加速查询。

- 优化 Web 应用后端逻辑:确保服务器端代码高效,避免资源密集型操作。

通过综合应用上述策略,可以显著减少 Web 服务器的请求数量和响应时间,提高网站性能和用户体验。

37. 你在工作的过程中,遇到过你印象最深的是什么故障问题,你又是如何解决?

某天早上,一家受欢迎的在线零售网站突然变得不可访问。监控系统向运维团队发出了警报,显示主数据库服务器的 CPU 利用率为 100%。

故障排查:

- 首先确认问题范围:

- 运维团队使用外部监控工具(如 Pingdom、UptimeRobot)确认网站的确不可访问。

- 内部监控工具显示,除了数据库服务器,其他服务(如 Web 服务器、缓存服务器)都运行正常。

- 查看日志:数据库的日志显示了大量相同的查询正在运行,这是一个复杂的 JOIN 操作,似乎是导致高 CPU 利用率的原因。

- 临时解决:为了迅速恢复服务,运维团队决定重启数据库服务器。重启后,CPU 利用率恢复正常,网站再次可访问。

- 深入排查原因:

- 团队开始分析出问题的查询,确定是由于前一天上线的新功能引入的。

- 开发团队没有对新功能进行足够的性能测试,导致这个问题在生产环境中暴露出来。

- 长期解决方案:

- 开发团队对查询进行了优化,添加了必要的数据库索引,并更改了查询结构以减少 JOIN 操作。

- 运维团队增强了监控策略,对此类查询设置了超时限制,以防止它们长时间运行。

- 为了避免此类问题再次发生,公司决定实施更严格的代码审查和性能测试流程,确保所有新功能在上线前都经过充分的测试。

38. 突然发现一台 Linux 系统只读,应该怎么处理,请写出详细步骤?

当 Linux 系统变为只读(read-only)状态时,通常是因为文件系统遇到了一些错误或者硬盘可能存在问题。以下是处理此类问题的步骤:

- 确认状态:使用

mount 或 df -h 命令查看当前的挂载状态。如果文件系统确实处于只读模式,你通常会在输出中看到 ro 标志。

- 尝试重新挂载为读写:使用命令

mount -o remount,rw /dev/sdXY /mount/point。其中 /dev/sdXY 是文件系统的设备路径,/mount/point 是挂载点。这一步可能不总是成功,但如果成功,你至少可以再次写入系统,进行进一步的诊断。

- 检查文件系统:

- 在尝试任何文件系统修复之前,请确保你已经备份了重要数据。

- 首先需要卸载文件系统,使用

umount /mount/point。如果它是 root 文件系统,你可能需要进入单用户模式或使用救援模式。

- 使用

fsck /dev/sdXY 对文件系统进行检查和修复。这可能会发现并尝试修复任何损坏或不一致的区域。

- 检查硬盘健康:

- 使用

smartctl(需要 smartmontools 包)检查硬盘的 SMART 数据:smartctl -a /dev/sdX。

- 如果发现硬盘有坏道或其他问题,考虑更换硬盘。

- 查看日志:使用

dmesg 或查看 /var/log/syslog 或 /var/log/messages 来查找任何硬盘或文件系统相关的错误消息。这可能会为你提供更多的线索。

- 恢复正常挂载:如果你已经成功地修复了文件系统,使用

mount -o rw /dev/sdXY /mount/point 重新挂载文件系统为读写模式。

- 防范措施:

- 定期备份数据。

- 使用 RAID 或其他冗余存储方案,以便在硬盘发生故障时能够快速恢复。

- 定期检查硬盘和文件系统健康。

总之,当 Linux 系统变为只读模式时,这通常意味着存在底层问题,需要进行仔细的诊断和修复。确保在采取任何修复措施之前备份重要数据,以防止数据丢失。

39. 一台 Linux 服务器负载高,连接慢,怎么查看?

当一台 Linux 服务器的负载高并且连接变慢时,你可以采取以下步骤来查看问题:

- 使用

top 或 htop 命令查看系统负载和进程情况:top或者 htop

●在 top 或 htop 中,你可以查看系统的负载平均值以及消耗 CPU 和内存资源最多的进程。这可以帮助你确定哪些进程可能导致负载高和连接变慢。

- 使用

free 命令查看内存使用情况:free -m

●这将显示系统内存的使用情况,包括可用内存和已使用内存。如果内存不足,可能会导致交换分区的使用,从而导致性能下降。

- 使用

netstat 或 ss 命令查看网络连接情况:

netstat -tuln或者 ss -tuln- 这将列出当前正在运行的网络连接和监听的端口。你可以查看是否有大量的连接积压或异常的网络活动。

- 查看系统日志文件,特别是

/var/log/syslog 或 /var/log/messages 文件,以查看是否有任何异常或错误消息。

- 使用

dmesg 命令查看内核消息,以检查是否有硬件或内核级别的问题:dmesg

- 使用

iotop 命令查看磁盘 I/O 情况,以确定是否存在磁盘性能问题:iotop

- 使用

ps 命令查看当前运行的进程,并检查是否有异常进程占用资源:ps aux

- 如果服务器是虚拟化的,检查宿主机的资源利用情况,可能宿主机资源不足导致虚拟机性能下降。

根据上述信息,你可以识别可能导致服务器负载高和连接变慢的问题,并采取相应的措施来解决它们。在解决问题之前,确保及时备份数据和系统,以免造成数据丢失。如果问题超出了你的技能范围,考虑寻求专业支持或咨询系统管理员。

40. 如何判断当前服务器的 80 端口是否被监听,如果被监听,怎么知道被哪个进程监听?

在 Linux 系统中,可以通过以下几种方法判断 80 端口是否被监听,并找出监听该端口的进程:

- 使用

netstat 命令:

netstat -tuln | grep :80- 选项说明:

-t:显示 TCP 连接。-u:显示 UDP 连接(可选,80 端口通常用 TCP)。-l:仅显示监听状态的连接。-n:以数字形式显示 IP 地址和端口号,不进行域名解析。

- 如果输出结果中包含

:80,则表示 80 端口正在被监听。例如:tcp 0 0 0.0.0.0:80 0.0.0.0:* LISTEN。

- 若要查看具体进程,可加上

-p 选项(需要 root 权限):netstat -tulnp | grep :80,输出结果中会包含进程 ID(PID)和进程名。

- 使用

ss 命令(netstat 的替代工具,效率更高):

- 查看 80 端口监听状态:

ss -tuln | grep :80。

- 查看进程信息(需 root 权限):

ss -tulnp | grep :80,同样会显示 PID 和进程名。

- 使用

lsof 命令(列出打开的文件和端口相关进程):

lsof -i :80- 该命令直接显示占用 80 端口的进程信息,包括 PID、进程名、用户等,无需额外过滤,且结果直观。

- 通过

/proc 文件系统查看(适用于无相关命令的极简环境):

- 先查找监听 80 端口的进程 PID:

find /proc -name "fd" -type d | xargs -I {} ls -l {} | grep "tcp.*:80"。

- 根据 PID 查看进程名:

cat /proc/<PID>/comm(将 <PID> 替换为实际找到的进程 ID)。

通过以上方法,可快速判断 80 端口是否被监听,并精准定位到对应的进程,便于后续的服务管理或故障排查。

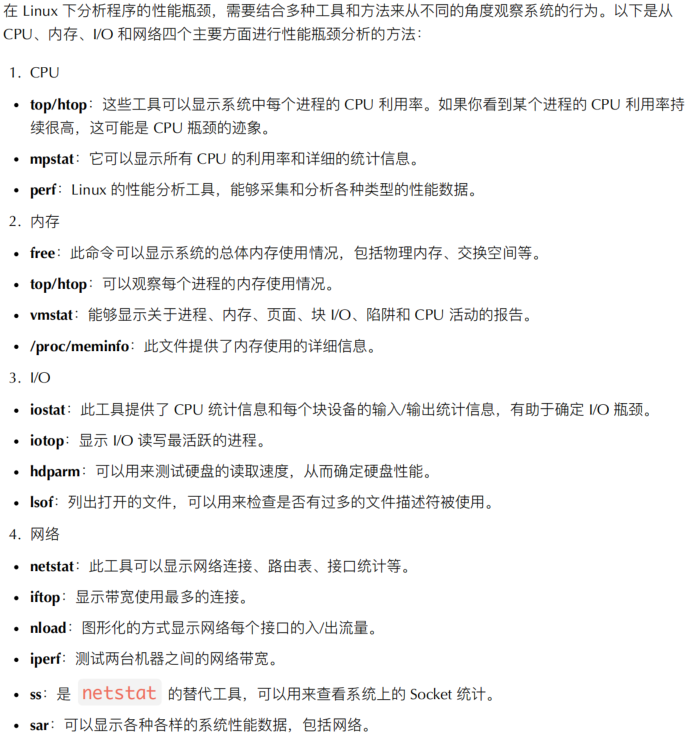

41. 在 Linux 下,如何分析一个程序达到性能瓶颈的原因,请分别从 CPU、内存、IO、网络的角度判断是谁导致的瓶颈?

在 Linux 下分析程序的性能瓶颈,需要结合多种工具和方法来从不同的角度观察系统的行为。以下是从 CPU、内存、I/O 和网络四个主要方面进行性能瓶颈分析的方法:

1. CPU 瓶颈判断

top/htop:这些工具可以实时显示系统中每个进程的 CPU 利用率。若某个进程的 CPU 利用率持续接近 100%(单核)或总和接近 CPU 核心数 ×100%(多核),可能存在 CPU 瓶颈。同时,top 中 %us(用户态 CPU 占比)高可能是程序计算密集,%sy(内核态 CPU 占比)高可能是系统调用频繁。mpstat:可查看每个 CPU 核心的利用率,命令 mpstat -P ALL 1(每秒输出一次所有核心信息),若单个核心利用率极高而其他核心空闲,可能是程序未做好多核优化(如单线程运行)。perf:Linux 性能分析核心工具,可采样 CPU 热点。例如 perf top -p <进程PID>,能实时显示进程中占用 CPU 最多的函数,快速定位代码层面的 CPU 消耗点(如循环、复杂计算)。pidstat:针对特定进程分析 CPU 使用,pidstat -u 1 -p <PID> 每秒输出该进程的用户态、内核态 CPU 占比,判断进程是否持续消耗大量 CPU。

2. 内存瓶颈判断

free:查看系统整体内存使用,free -h 以人类可读格式显示总内存、已用内存、缓存(buffer/cache)和交换分区(swap)。若 available 内存持续过低,且 swap 使用率不断升高,可能存在内存不足。top/htop:在进程列表中,关注 %MEM(内存占比)和 VIRT(虚拟内存)、RES(物理内存)列。若目标进程 RES 持续增长且无法释放,可能存在内存泄漏;若多个进程 RES 总和接近物理内存上限,易导致内存瓶颈。vmstat:查看内存交换和页错误情况,vmstat 1 每秒输出一次。si( swap 读入)、so(swap 写出)持续非零,说明内存不足导致频繁换页;pgfault(页错误)过高且 pgmajfault(大页错误,需访问磁盘)增加,也可能是内存紧张。/proc/meminfo:查看详细内存细分,如 Cached(页缓存)、Slab(内核缓存)等。若 AnonPages(匿名内存,进程堆 / 栈)过大,可能是程序占用过多物理内存。valgrind(memcheck 工具):针对程序本身检测内存泄漏,valgrind --tool=memcheck --leak-check=full ./程序名,可定位未释放的内存块,适用于开发阶段排查内存问题。

3. I/O 瓶颈判断

磁盘 I/O 瓶颈

iostat:分析磁盘读写性能,iostat -x 1 每秒输出一次详细磁盘统计。关键指标:

%util:磁盘利用率,若持续接近 100%,说明磁盘繁忙,存在 I/O 瓶颈。rMB/s/wMB/s:磁盘读写速率,对比磁盘理论速率(如 SSD 通常 300-500MB/s),若接近上限且 %util 高,可确认瓶颈。await:I/O 请求平均等待时间(毫秒),正常应低于 10ms,若持续过高(如超过 50ms),说明磁盘响应缓慢。

iotop:实时显示进程的磁盘 I/O 情况,iotop -o 只显示有 I/O 活动的进程。若目标进程 DISK READ/DISK WRITE 速率高且持续,同时 %IO(I/O 占比)接近 100%,则该进程是磁盘 I/O 瓶颈源头。dd:测试磁盘读写速度,如 dd if=/dev/zero of=/tmp/test bs=1G count=1 oflag=direct(写测试)、dd if=/tmp/test of=/dev/null bs=1G count=1 iflag=direct(读测试),对比实际速率与理论速率,判断磁盘硬件是否达标。lsof:查看进程打开的文件,lsof -p <PID> 若进程打开大量文件且频繁读写,可能导致磁盘 I/O 压力。

文件系统 I/O 瓶颈

stat:查看文件系统属性,若使用机械硬盘且文件系统为 ext4 未开启 noatime,频繁的文件访问会产生大量元数据 I/O,可通过 mount -o remount,noatime /分区 优化。df -i:查看 inode 使用率,若某个分区 IUse% 接近 100%,即使磁盘空间充足,也无法创建新文件,导致 I/O 异常。

4. 网络瓶颈判断

iftop:实时监控网络带宽使用,iftop -i <网卡名>(如 eth0),显示各连接的上行 / 下行速率。若目标进程对应的连接速率持续接近网卡带宽上限(如 1G 网卡约 120MB/s),说明网络带宽不足。nload:图形化显示网卡总流量,nload <网卡名>,直观查看实时入 / 出流量是否达到瓶颈,以及流量波动情况(如突发流量峰值是否超过带宽)。netstat/ss:查看网络连接状态,netstat -an | grep ESTABLISHED | wc -l 统计已建立连接数,若连接数过多(如超过系统默认 net.core.somaxconn),可能导致新连接无法建立;ss -t state ESTABLISHED -p | grep <进程名> 查看目标进程的网络连接,若存在大量慢连接(如长时间未关闭),可能占用网络资源。

上面的是AI 下面是总结来的

综合⼯具

dstat :是⼀个多功能的⼯具,可以同时观察 CPU 、内存、磁盘 I/O 、⽹络、进程等。

glances :提供了⼀个全⾯的系统监视界⾯,其中包括上述所有⽅⾯的数据。

在进⾏性能分析时,⾸先要确保你知道系统的正常⾏为是什么样的(即基准性能数据)。只有这样,当问题出现时,你才能准确地判断哪些指标的变化可能与性能下降有关。

42.网站时常出现too many connection的错误,请给出解决的⽅案?

"Too many connections" 错误通常是由于数据库连接池中的连接数达到了最⼤限制⽽导致的。解决这个问题可以考虑以下⼏种⽅法:

1. 增加数据库连接池的⼤⼩ :

在 MySQL 中,可以通过修改数据库服务器的配置⽂件(如 my.cnf 或 my.ini )来增加连接池⼤⼩。找

到 max_connections 参数,并将其增加到⼀个更⼤的值。然后重启 MySQL 服务器以使更改

⽣效。但要⼩⼼不要设置得过⾼,以免消耗过多系统资源。

2. 检查数据库连接的释放 :

确保你的应⽤程序在使⽤完数据库连接后及时将其释放。不释放连接会导致连接池中的连接被占

⽤,最终耗尽。

3. 使⽤连接池管理⼯具 :

考虑使⽤连接池管理⼯具,如 C3P0 、 HikariCP 或 Apache DBCP 。这些⼯具可以帮

助你更有效地管理数据库连接,包括连接的创建、释放和回收。

4. 优化数据库查询 :

优化你的数据库查询,确保它们是⾼效的。使⽤索引、避免全表扫描、限制查询返回的⾏数等⽅

法来减少数据库负载。

5. 增加硬件资源 :

如果你的服务器负载很⾼,可能需要考虑增加硬件资源,包括 CPU 、内存和磁盘速度,以提⾼数

据库性能和容量。

6. 检查应⽤程序代码 :

审查应⽤程序代码,确保数据库连接被正确地创建、使⽤和释放。确保没有连接泄漏或⽆效的连

接。

7. 使⽤缓存 :

使⽤缓存来减轻数据库的压⼒,特别是对于⼀些读取频繁但不经常变化的数据。这可以减少数据

库连接的需求。

8. 分流和负载均衡 :

如果可能的话,将数据库连接分流到多个数据库服务器上,并使⽤负载均衡来平衡负载。这可以

提⾼系统的容错性和性能。

9. 监控和警报 :

设置监控系统,以便在连接数达到警戒阈值时及时发出警报。这样你可以在问题变得严重之前采

取措施。

10. 数据库优化 :

定期对数据库进⾏性能优化,包括索引优化、查询优化和数据表维护。

根据你的具体情况,可以采取⼀个或多个上述⽅法来解决 "Too many connections" 错误。最终⽬标是确保数据库连接得到有效管理,以满⾜应⽤程序的需求并维持系统的性能和稳定性。

43.Tomcat和Resin有什么区别,⼯作中你怎么选择?

Tomcat 和 Resin 都是⽤于部署 Java Web 应⽤程序的 Servlet 容器 / 应⽤服务器,但它们有⼀些区别,⼯作中的

选择通常取决于项⽬需求和性能要求。

Tomcat:

1. 开源性 : Tomcat 是⼀个开源的项⽬,由 Apache 维护。它具有⼴泛的社区⽀持,有⼤量的插件和扩展可用。

2. 成熟度 : Tomcat 是⼀个⾮常成熟的 Servlet 容器,⼴泛⽤于⽣产环境。

3. 部署灵活性 : Tomcat 可以部署各种 Java Web 应⽤程序,包括基于标准的 WAR ⽂件 JSP/Servlet 应用程序。

4. 可扩展性 : Tomcat ⽀持多种扩展和插件,可以根据需要⾃定义和扩展。

Resin:

1. 性能 : Resin 以⾼性能和低内存消耗⽽闻名。它在某些情况下可能⽐ Tomcat 更快。

2. 商业⽀持 : Resin 有⼀个商业版本( Caucho Resin Professional ),提供了更多⾼级功能和技术⽀持。如果需要商业⽀持,Resin 是⼀个选择。

3. 嵌⼊式容器 : Resin 可以作为⼀个嵌⼊式容器使⽤,这意味着它可以更轻松地集成到其他 Java 应⽤程序中。

4. 内置集群⽀持 : Resin 提供了内置的集群⽀持,使得构建分布式应⽤程序更加容易。

5. 全文搜索⽀持 : Resin ⽀持全⽂搜索,这在某些应⽤中可能是⼀个重要的功能。

在选择 Tomcat 或 Resin 时,需要考虑项⽬的需求、性能要求、预算和团队的熟悉程度。如果你需要更高的性能,并且可以接受商业⽀持,Resin 可能是⼀个好的选择。如果你更倾向于开源和成熟的解决方案,并且需要更大的灵活性,那么Tomcat 可能更适合你。

44.tomcat进程出现假死的情况?

45.有个客户说访问不到你们的⽹站,但是你们自己测试内网和外网访问都没问题。

1. 确认问题是否客户端特定 :

请客户确认他们使⽤的是正确的 URL ,并且浏览器没有任何拼写错误。

询问客户是否可以访问其他⽹站,以确定问题是否局限于您的⽹站。

2. 检查服务状态 :

确保您的⽹站服务器正常运⾏并且没有崩溃或停⽌响应。

查看服务器上的⽇志⽂件,以查找是否有任何异常或错误消息。

3. 检查⽹络连接 :

确保您的服务器和客户端之间的⽹络连接正常。您可以使⽤ ping 命令来测试服务器的可访问

性。

检查防火墙规则和⽹络安全组设置,确保它们没有阻⽌客户端访问您的网站。

4. 查看 DNS 配置 :

确保您的域名解析到了正确的 IP 地址。可以使⽤ nslookup 或 dig 等⼯具来检查 DNS 记录是

否正确。

确保 DNS 服务器没有问题,客户端可以成功解析域名。

5. 检查 HTTP 响应 :

使⽤命令行工具如 curl 或 wget 从客户端的⻆度访问您的⽹站,查看是否有任何错误消息或

不正常的 HTTP 响应码。 确保网站的HTTP 服务器正常响应请求。

6. 考虑 CDN 和负载均衡 :

如果您使⽤ CDN (内容分发⽹络)或负载均衡器,请确保它们配置正确,并且没有任何问题。

确保 CDN 或负载均衡器没有被客户端访问限制。

7. 检查访问⽇志 :

查看您的⽹站访问⽇志,以确定客户端的请求是否已经到达服务器。

如果请求已经到达服务器,请检查⽇志⽂件是否包含有关客户端请求的信息。

8. 协助客户端 :

如果所有上述步骤都没有解决问题,可以尝试协助客户端进⾏进⼀步的排查,例如帮助他们清除

浏览器缓存、更换浏览器或操作系统等。

9. 提供备⽤链接 :

如果问题无法解决,可以考虑提供客户⼀个备⽤的链接或域名,以确保他们能够访问您的⽹站。

10. 与客户沟通 :

保持与客户的沟通,汇报您的排查进展,并根据需要提供解决方案。

最终,解决客户⽆法访问⽹站的问题可能需要深入的技术排查,可能涉及多个方面,包括网络、服务器配置、域名解析等。与客户沟通和协作是解决问题的关键。

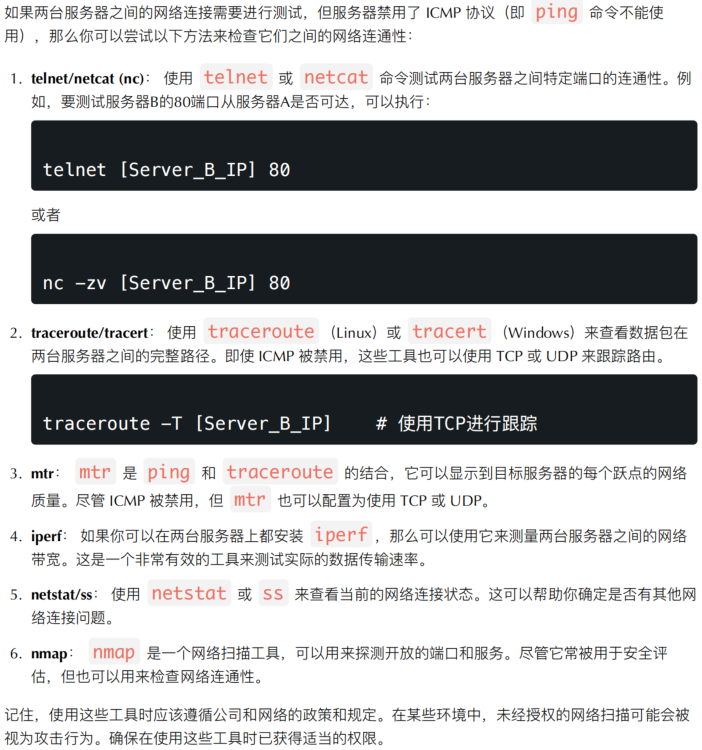

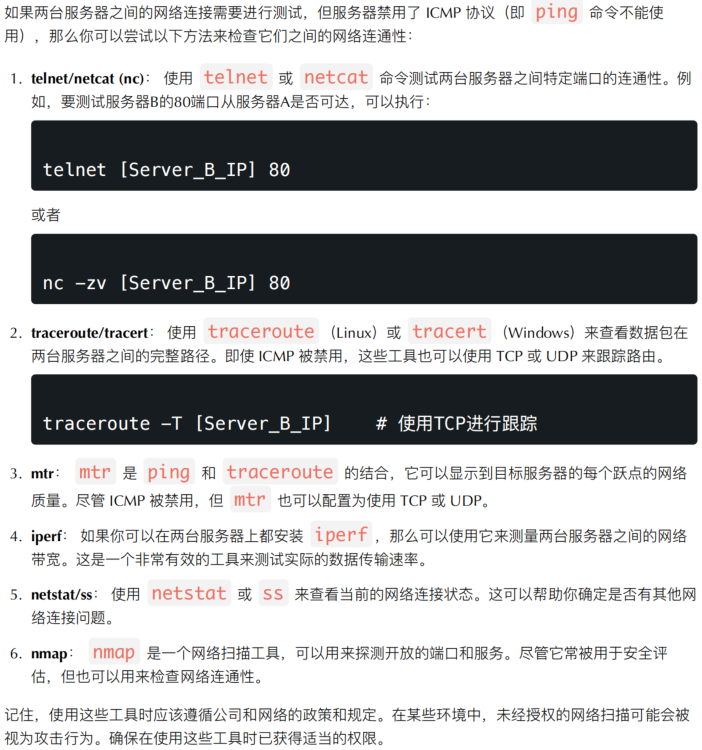

46.怎么查看两台服务器之间的⽹络是不是正常的,服务器是禁ping的?

47.Linux系统中病毒怎么解决?

在 Linux 系统中,由于其安全性较⾼,恶意软件和病毒相对较少,但仍然有可能遭受到恶意软件的攻击。以下是解决Linux 系统中病毒问题的⼀些步骤和⽅法:

1. 使用可信赖的源 :确保只从官方或可信赖的软件源安装软件。避免从不可靠或非官方的源下载和安装软件。

2. 定期更新系统 :及时应用系统和软件的安全补丁,以确保已修复已知的安全漏洞。

3. 安装防病毒软件 :考虑在Linux 系统上安装⼀些可⽤的防病毒软件,例如 ClamAV 等。这些⼯具可以扫描⽂件系统以检测潜在的威胁。

4. 审查系统⽇志 :定期审查系统日志文件,特别是 /var/log/ ⽬录下的⽂件,以查找异常活动或异常登录尝试。

5. 限制 root 权限 :避免在正常情况下使⽤ root ⽤户登录系统,使⽤普通⽤户并使⽤ sudo 来执⾏需要特权的操作。

6. 使⽤防⽕墙 :配置防⽕墙规则,仅允许必要的⽹络流量访问您的系统,阻止不必要的端⼝和服务。

7. 审查系统进程 :使⽤命令如 ps 和 top 来监视系统进程,查找异常的或不认识的进程。

8. 不打开不明附件 :不要在电⼦邮件或其他来源中打开不明附件,这有可能包含恶意代码。

9. 定期备份数据 :定期备份重要数据,以便在遭受攻击或数据损坏时可以进⾏恢复。

10. 监视系统⽂件 :使⽤⼯具如 tripwire 等来监视系统⽂件的更改,以检测是否有未经授权的修改。

11. 教育⽤户 :

对系统⽤户进⾏安全意识培训,教育他们如何避免点击不明链接和下载不明⽂件。

如果您怀疑系统已受到恶意软件感染,可以采取以下步骤:

1. 隔离系统 :隔离受感染的系统,确保它不会继续对⽹络上的其他系统造成威胁。

2. 运⾏杀毒⼯具 : 使⽤安装的防病毒软件运⾏系统扫描,以查找并清除恶意软件。

3. 审查系统⽇志 :仔细审查系统⽇志,以查找感染的迹象,例如异常的⽂件活动或登录尝试。

4. 还原备份 : 如果可能的话,可以考虑使⽤备份还原系统到未受感染的状态。

5. 重新安装系统 :如果感染严重或⽆法清除,最后的⼿段可能是重新安装操作系统。

总之,在 Linux 系统中防⽌和解决病毒问题的关键是采取安全措施,定期更新系统,并保持警惕。及早发现和隔离潜在威胁是确保系统安全的重要步骤。

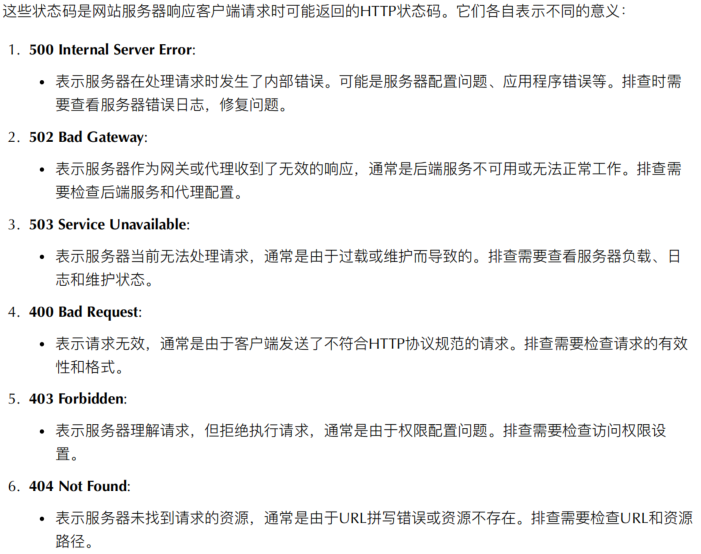

48.网站出现500,502,503,400,403,404都是什么意思,怎么排查和解决?

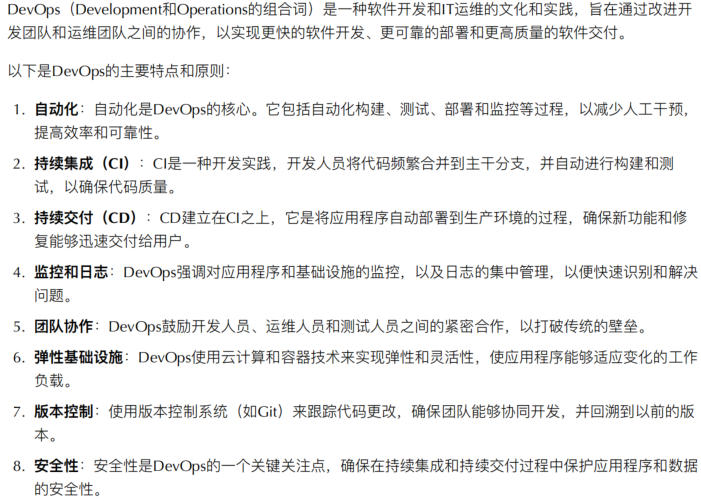

49.请简述devops是什么?

总之, DevOps 旨在缩短软件开发周期,提⾼软件交付的质量和可靠性,同时提⾼团队的协作和效率。它是⼀种将开发和运维紧密结合的⽅法,通过⾃动化和持续改进来实现更好的软件交付和运维管理。

50.简述集中式版本控制系统与分布式版本控制系统的区别?

DVCS :通常依赖于外部⼯具或托管平台(如 GitHub 、 GitLab )来提供访问控制。

总之,集中式和分布式版本控制系统在版本历史的存储、网络需求、性能、故障恢复和分⽀管理等方面有显著的不同。选择哪⼀种主要取决于团队的需要和项目的特点。

51.请简述git本地仓库有哪三⼤区, 中间的那个区主要有什么作⽤?

52.CI/CD流程

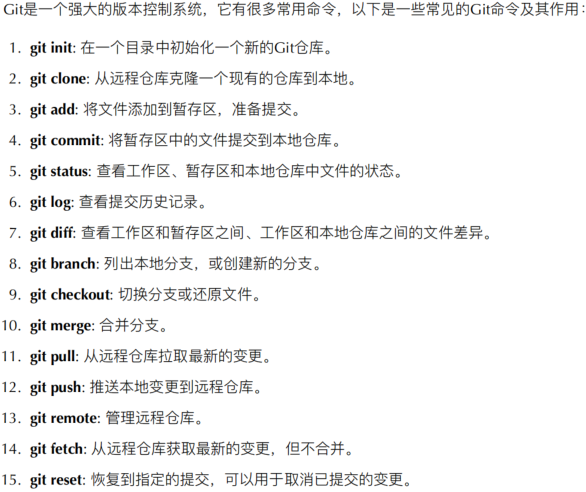

53.说出git常⽤命令

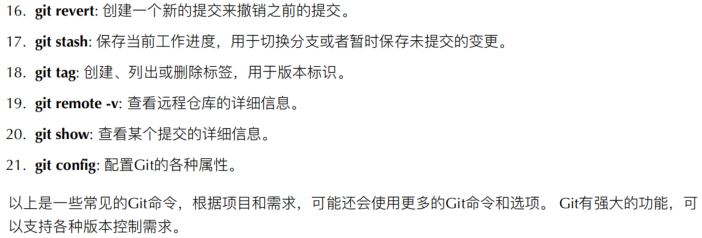

54.说⼀下你们公司怎么发版的(代码怎么发布的)?

55.简述raid0 raid1 raid5 三种⼯作模式的⼯作原理及特点

RAID ( Redundant Array of Independent Disks )是⼀种将多个磁盘驱动器组合成⼀个逻辑单元以提⾼性能、可靠性或两者兼顾的技术。以下是RAID 0 、 RAID 1 和 RAID 5 的⼯作原理和特点:

1. RAID 0 (条带化) :

⼯作原理 : RAID 0 通过将数据分成块并分布到多个磁盘上,以提⾼读写性能。数据被分成块后,

每个块都被写⼊不同的磁盘,这样可以并⾏读写,提⾼了数据传输速度。

特点 :

提⾼性能:由于数据被分散存储在多个磁盘上,所以可以同时读取和写⼊数据,提⾼了性能。

⽆冗余: RAID 0 没有数据冗余,如果⼀个磁盘故障,所有数据都将丢失。

⽤途:常⽤于需要⾼性能⽽不需要数据冗余的应⽤,如临时数据存储。

2. RAID 1 (镜像) :

⼯作原理 : RAID 1 通过将数据同时写⼊两个磁盘驱动器来创建镜像。这意味着两个磁盘上的数据

完全相同,如果⼀个磁盘故障,数据仍然可以从另⼀个磁盘恢复。

特点:

数据冗余: RAID 1 提供了数据冗余,可以容忍⼀个磁盘故障。

读性能:读性能较⾼,因为可以从两个磁盘中的任何⼀个读取数据。

写性能:写性能通常⽐ RAID 0 差,因为需要同时写⼊两个磁盘。

⽤途:常⽤于需要⾼可靠性和数据冗余的应⽤,如数据库服务器。

3. RAID 5 :

⼯作原理 : RAID 5 通过将数据分成块并将校验数据分布到所有磁盘上,实现数据冗余和性能提

升。当写⼊数据时,校验数据也会⼀同更新,以确保数据的完整性。

特点:

数据冗余: RAID 5 提供了数据冗余,可以容忍⼀个磁盘故障。如果⼀个磁盘损坏,可以通过

校验数据和其它磁盘上的数据来恢复。

性能:性能相对较⾼,因为数据被分散存储在多个磁盘上,可以并⾏读写。

⽤途:常⽤于需要兼顾性能和数据冗余的应⽤,如⽂件服务器。

总结: RAID 0 提供了性能提升但没有冗余, RAID 1 提供了数据冗余但写性能较低, RAID 5 在性能和冗余之间取得了平衡。选择哪种RAID 级别取决于具体的应⽤需求和数据保护要求。

56.描述raid 0、1、5的特点和优点?

RAID (冗余独⽴磁盘阵列)是⼀种存储虚拟化技术,它将多个磁盘驱动器组合成⼀个逻辑单元,⽬的是为了增加性能和/ 或数据冗余。以下是 RAID 0 、 RAID 1 和 RAID 5 的特点和优点:

RAID 0 (条带化)

特点 : 数据被等分并且“ 条带化 ” 存储在两个或多个磁盘上。 不提供冗余。

性能 :由于数据条带化地存储在多个磁盘上,读写操作可以同时在多个磁盘上进⾏,从⽽增加了吞吐量。

最大化存储 :所有磁盘的存储都⽤于数据,没有浪费。

注意 :由于 RAID 0 没有冗余,所以只要其中⼀个磁盘失败,你将失去所有数据。

RAID 1 (镜像)

特点 :数据被完整地复制到两个或多个磁盘上,每个磁盘都是其他磁盘的镜像。 提供⼀份冗余。

数据冗余 :由于数据被复制到所有磁盘,所以只要有⼀个磁盘仍然正常,数据就是安全的。

读取性能 :在某些情况下,读取性能可能会得到提⾼,因为数据可以从任何⼀个健康的磁盘上读取。

RAID 5 (带奇偶校验的条带化)

特点 : 数据和奇偶校验信息被条带化地存储在三个或多个磁盘上。 如果⼀个磁盘失效,数据可以从奇偶校验信息中恢复。

数据冗余 :尽管使⽤了少量的磁盘空间来存储奇偶校验信息,但 RAID 5 仍然可以在⼀个磁盘失败时保持数据的完整性。

性能和存储的平衡 : RAID 5 提供了 RAID 0 的性能增益和 RAID 1 的冗余。虽然不如 RAID 0 快,也不如 RAID 1 安全,但它提供了⼆者的平衡。

存储效率 :相⽐ RAID 1 , RAID 5 在冗余存储上更为⾼效,因为它不需要为每⽚磁盘都保持完整的数据副本。

57.现在给你三百台服务器,你怎么对他们进行管理?

管理三百台服务器是⼀项复杂的任务,需要综合考虑的⾃动化、监控、备份和安全策略。以下是⼀些建议的步骤和最佳实践:

1. 硬件和资产管理 :

为每台服务器标记并记录详细信息,例如型号、配置、序列号、所在位置、⽤途等。

使⽤资产管理⼯具或 CMDB (配置管理数据库)来跟踪所有硬件资产。

2. 统⼀的命名约定 :

为所有服务器实施统⼀、描述性的命名策略,帮助快速识别服务器的⻆⾊和位置。

3. ⾃动化部署和配置管理 :

使⽤⼯具如 Ansible 、 Puppet 、 Chef 或 SaltStack 来⾃动化部署和配置管理。

确保所有服务器都安装有相同的基础软件、安全补丁和配置。

4. 集中式⽇志管理 :

使⽤⼯具如 ELK Stack (Elasticsearch, Logstash, Kibana) 或 Graylog 来集中管理和分析服务器⽇志。 设置⽇志保留策略和备份。

5. 监控和警报 :

使⽤⼯具如 Nagios 、 Zabbix 、 Prometheus 或 Grafana 来实时监控服务器状态。

设置警报通知,以便在出现问题时⽴即知道。

6. 备份和恢复 :

确定每台服务器的备份策略和频率。 定期测试恢复流程以确保备份是可靠的。

7. 安全策略 :

为每台服务器配置防⽕墙,并只打开必要的端⼝。

使⽤⼯具如 Fail2Ban 或 denyhosts 来保护 SSH 访问。

定期运⾏安全扫描和漏洞评估。

8. 软件更新和补丁管理 :

使⽤如 Spacewalk 、 Foreman 或 Landscape 的⼯具来管理软件包和补丁。

定期对所有服务器进⾏更新,确保它们都在最新的安全补丁级别。

9. 远程访问管理 :

使⽤⼯具如 SSH key management 、 LDAP 或 Active Directory 来统⼀管理访问凭证。 限制哪些⽤户可以访问哪些服务器,并使⽤ sudo 权限来控制他们可以执⾏的操作。

10. ⽂档 :

为所有的流程、策略和特殊配置创建详细的⽂档。

确保其他团队成员或新⼈能够理解和遵循已有的规范。

11. 定期审计 :

定期检查所有服务器,确保它们遵循已定义的策略和最佳实践。

管理三百台服务器需要持续的努⼒、良好的团队协作和不断的技能更新。使⽤适当的⼯具和策略可以确保服务器群的稳定、安全和⾼效运⾏。

58.常用的Nginx模块,用来做什么?

Nginx 是⼀个⾼性能的开源反向代理服务器,它⽀持许多模块,⽤于扩展其功能。以下是⼀些常⽤的Nginx 模块及其主要功能:

1. HttpProxyModule :⽤于配置 Nginx 作为反向代理服务器,将请求代理到后端应⽤服务器。

2. HttpSslModule :提供了 HTTPS 协议的⽀持,⽤于配置 SSL/TLS 加密连接。

3. HttpRewriteModule :允许在请求到达后端服务器之前重写 URL ,⽤于 URL 重定向和重写。

4. HttpLoadBalancingModule :⽤于配置负载均衡,将请求分发到多个后端服务器,以提⾼性能和可⽤性。

5. HttpCacheModule :⽤于配置 HTTP 缓存,提⾼访问速度并减轻后端服务器的负载。

6. HttpGzipModule :⽤于启⽤ Gzip 压缩,减⼩传输数据的⼤⼩,提⾼⽹站加载速度。

7. HttpAuthBasicModule :提供基本身份验证,⽤于保护⽹站的某些部分需要登录的情况。

8. HttpSecurityModule :⽤于配置安全策略,防⽌恶意请求和攻击。

9. HttpHeadersModule :允许配置 HTTP 响应头,包括添加、修改和删除头部信息。

10. HttpLogModule :⽤于记录访问⽇志,可以定制⽇志格式和存储位置。

11. HttpLimitReqModule :⽤于限制客户端请求的速率,防⽌滥⽤和 DoS 攻击。

12. HttpWebDAVModule :⽀持 WebDAV ( Web-based Distributed Authoring and Versioning )协议,⽤于文件共享和管理。

13. HttpRealIpModule :⽤于获取真实的客户端 IP 地址,通常与代理服务器⼀起使⽤。

14. HttpLuaModule :允许通过 Lua 脚本扩展 Nginx 的功能,执⾏⾃定义逻辑。

15. HttpEchoModule :⽤于输出自定义响应,可用于测试和调试。

这些是常见的 Nginx 模块, Nginx 还有许多其他模块可以根据需求进⾏配置和扩展。不同的模块可以帮助管理员实现各种功能,使 Nginx 成为⼀个灵活且功能强⼤的 Web 服务器和反向代理服务器。

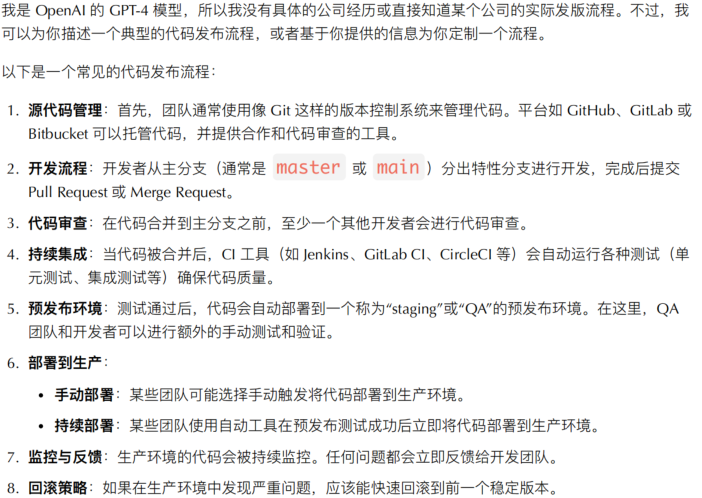

59.Nginx 如何实现后端服务的健康检查?

Nginx 可以通过以下两种主要⽅式来实现后端服务的健康检查:

1. 基于 HTTP 的健康检查 :通过配置⼀个 HTTP 负载均衡模块来检查后端服务器的健康状态。这通常包括配置⼀个⽤于健康检查的特殊路径(例如 /health )以及⼀个后端服务器的列表。 Nginx 定期发送 HTTP 请求到这些后端服务器的健康检查路径,检查服务器是否响应正常。如果服务器响应正常,Nginx 将将流量分配给它。如果服务器未响应或响应异常, Nginx 将暂时将其从负载均衡池中移除, 直到下⼀次健康检查成功后重新加⼊。

示例配置:

2. TCP 健康检查 :对于不⽀持 HTTP 的后端服务, Nginx 可以进⾏基于 TCP 的健康检查。在这种情况下,Nginx 会定期尝试建⽴到后端服务器的 TCP 连接,检查服务器是否处于正常运⾏状态。如果服务器未能建⽴连接或连接失败,Nginx 将认为服务器不可⽤,并将其从负载均衡池中暂时移除。

示例配置:

上述示例中, stream 模块⽤于配置基于 TCP 的健康检查。

这些方法使得 Nginx 能够动态地管理后端服务器的健康状态,并根据需要进⾏负载均衡,从⽽提⾼系统的可用性和稳定性。

60.为什么Nginx性能这么⾼?

61.Nginx怎么处理请求的?

Nginx 是⼀个⾼效的、轻量级的 Web 服务器和反向代理服务器,它使⽤异步事件驱动的⽅式来处理请求,这使得 Nginx 能够在⾼并发环境下保持低资源消耗和⾼性能。

以下是 Nginx 如何处理请求的简化流程:

1. 启动与 Master/Worker 模式 :

当 Nginx 启动时,⾸先启动⼀个 master 进程。

Master 进程主要负责读取和验证配置⽂件、管理 worker 进程等管理任务。

根据配置⽂件和系统资源, master 进程会启动多个 worker 进程。这些 worker 进程负责处理实际

的请求。

2. 监听请求 :每个 worker 进程都会监听指定的 IP 地址和端⼝,等待 HTTP 、 HTTPS 或其他协议的请求。

3. 事件驱动模型 :

Nginx 使⽤异步⾮阻塞的事件驱动模型来处理请求。当⼀个新的连接到达时, worker 进程会异步

地处理它,而不需要为每个请求创建⼀个新的线程或进程。

这种处理方式使 Nginx 能够很好地处理⾼并发请求,因为每个 worker 进程都可以处理数千个并发

连接。

4. 处理请求 :

请求首先经过配置⽂件中定义的各种模块,例如: rewrite 、 access 、 try_files 等。

根据配置规则, Nginx 可以直接返回静态⽂件、重写请求、限制访问、负载均衡到后端服务器等。

5. 代理与负载均衡 :

如果配置为反向代理模式, Nginx 会将请求转发到配置的后端服务器,这可能是另⼀个 Web 服务

器、应⽤服务器或 API 端点。

Nginx ⽀持多种负载均衡策略,如轮询、最少连接、 IP 哈希等。

6. 响应 :

对于直接由 Nginx 处理的请求,例如静态⽂件请求, Nginx 会直接从磁盘读取⽂件并返回给客户

端。

对于代理到后端的请求, Nginx 会从后端服务器接收响应,然后将其传递给客户端。

7. 连接关闭 :

默认情况下, Nginx 使⽤ keep-alive 连接,这意味着连接在传送数据后不会⽴即关闭,从⽽减少了

建⽴和关闭连接的开销。

当 keep-alive 超时或达到配置的最⼤请求数时,连接将被关闭。

8. ⽇志记录 :

在整个请求处理过程中, Nginx 会记录相关的信息到访问⽇志和错误⽇志中,以供分析和故障排

查。

Nginx 的⾼效性和可扩展性部分归功于其事件驱动模型和优雅的配置机制。正确地配置和优化 Nginx 可以使其处理的请求数量⼤⼤增加,同时保持响应时间和资源使⽤的稳定。

62.Nginx 如何实现页面的动静分离?

63.nginx安全?

1. 最新版本 :

始终使⽤最新的稳定版本的 Nginx 。新版本通常会修复已知的安全漏洞。

2. 使⽤ HTTPS :

使⽤ SSL/TLS 来加密传输的数据。这不仅保护数据的隐私性,还确保数据的完整性。

定期更新和替换 SSL/TLS 证书,并使⽤安全的加密套件。

3. 隐藏 Nginx 版本号 :

在响应头中不显示 Nginx 的版本号可以减少暴露给潜在攻击者的信息。可以在配置中设置 serv

er_tokens off; 。

4. 限制请求⼤⼩ :

为了防⽌⼤型的恶意请求,可以使⽤ client_max_body_size 限制允许的请求体的⼤

⼩。

5. 限制请求速率 :

使⽤ limit_req_module 限制请求速率,从⽽抵御 DoS 攻击或暴⼒破解尝试。

6. 防⽌点击劫持 :

通过添加适当的响应头,例如 add_header X-Frame-Options "SAMEORIGI

N"; ,来避免您的⽹站被嵌⼊到其他⽹站的 iframe 中,从⽽预防点击劫持攻击。

7. 限制访问 :

使⽤ allow 和 deny 指令限制对某些位置或路径的访问。

例如,对配置⽂件、私有数据等敏感路径,应限制外部访问。

8. 使⽤ HTTP Basic 认证 :

对于管理界⾯或其他敏感区域,可以使⽤ HTTP Basic 认证作为额外的安全层。

9. 关闭不必要的模块 :

编译 Nginx 时,只启⽤你真正需要的模块,关闭或不编译不必要的模块。

10. 防⽌⽬录遍历 :

通过使⽤ location 块确保⽤户不能访问到 Nginx 的根⽬录之外的路径。

11. 禁⽤不安全的 HTTP ⽅法 :

限制允许的 HTTP ⽅法,通常只允许 GET 、 POST 和 HEAD ,禁⽤如 TRACE 和 DELETE 的⽅法。

12. 使⽤ WAF (Web Application Firewall) :

使⽤如 ModSecurity 这样的 WAF 可以帮助你检测和阻⽌⼤部分 Web 攻击。

13. 定期审计和更新 :

定期审核你的 Nginx 配置,确保没有任何安全漏洞或误配置。

关注 Nginx 及相关软件的安全公告,确保系统及时得到更新和补丁。

结合上述最佳实践,并保持对当前的安全威胁和漏洞的关注,可以⼤⼤增强你的 Nginx 服务器的安全性。

64.LVS的优点是

65.LVS的缺点是

65.LVS的缺点是

LVS ( Linux Virtual Server )虽然有许多优点,但也存在⼀些潜在的缺点,包括:

1. 复杂性 :配置和管理 LVS 可以相对复杂,特别是对于新⼿来说。需要⼀定的 Linux 系统和⽹络知识,以确保正确设置和运⾏。

2. 单点故障 :尽管 LVS 本身可以提⾼系统的可⽤性,但如果 LVS 控制节点成为单点故障,整个负载均衡

架构可能会受到影响。为了解决这个问题,通常需要使⽤⾼可⽤性解决⽅案,如基于 Pacemaker 或Keepalived 的冗余控制节点。

3. 有限的⽀持协议 :虽然 LVS ⽀持许多常⻅的⽹络协议,但并不⽀持所有协议。对于某些特殊的应⽤程序和协议,可能需要考虑其他负载均衡解决⽅案。

4. 维护⼯作 :定期维护和监视 LVS 集群是必要的,以确保正常运⾏。这可能需要额外的管理⼯作,特别是在⼤规模或复杂的部署中。

5. 学习曲线 :对于没有经验的管理员来说,学习如何配置和管理 LVS 可能需要⼀些时间。因此,需要不断学习和培训,以熟练掌握 LVS 。

6. 资源消耗 : LVS 控制节点需要⼀定的系统资源来处理负载均衡决策,这可能在极端⾼负载情况下成为性能瓶颈。

7. 不适⽤于所有场景 : LVS 适⽤于⼤多数负载均衡需求,但并不适⽤于所有场景。某些应⽤程序可能需要更⾼级的负载均衡功能,如内容缓存、SSL 加速等,这些功能可能需要额外的硬件或软件⽀持。

总之,尽管 LVS 是⼀个功能强⼤的负载均衡解决⽅案,但在部署和管理时需要考虑⼀些潜在的复杂性和挑战。管理员需要根据具体的需求和环境来评估是否选择使⽤ LVS 。

66.LVS、Nginx、HAproxy有什么区别?⼯作中你怎么选择?

LVS ( Linux Virtual Server )、 Nginx 和 HAproxy 都是在不同场景下⼴泛使⽤的负载均衡解决⽅案。它们有各⾃的特点和应⽤场景。下⾯简述它们的区别及选择的建议:

LVS(Linux Virtual Server)

特点 :

LVS 主要⼯作在⽹络的第 4 层,即传输层。

它提供基于 IP 的负载均衡,即 TCP 和 UDP 负载均衡。

有三种主要的⼯作模式: NAT 、 DR ( Direct Routing )和 TUN 。

适⽤场景 :

处理⼤量并发的短连接。

当后端服务器需要在同⼀个⼦⽹时。

Nginx

特点 :

Nginx 除了是⼀个 Web 服务器外,还可以作为反向代理和负载均衡器。

它⼯作在第 7 层,即应⽤层,主要进⾏ HTTP 和 HTTPS 的负载均衡。

⽀持多种负载均衡策略,例如轮询、权重轮询、 IP 哈希等。

适⽤场景 :

当需要 HTTP 功能如缓存、重写、重定向等。

对于 SSL/TLS 终⽌和管理。

当你同时需要 Web 服务器和负载均衡功能。

HAproxy

67.⽹站做了负载均衡,发现有些⽤户访问的时候经常需要重新登录是什么原因?

⽹站在引⼊负载均衡后,⽤户经常需要重新登录可能是由于会话状态管理不⼀致或不正确的问题导致的。

以下是可能导致此问题的⼀些原因和解决⽅法:

1. 会话粘性( Session Affinity )未配置 :在负载均衡环境中,如果没有配置会话粘性(也称为会话持久性

或 Session Affinity ),⽤户的请求可能会被分发到不同的后端服务器,⽽这些服务器之间不共享会话信息。这导致⽤户在不同的服务器上看到不同的会话状态,从⽽需要重新登录。

解决⽅法 :确保负载均衡器配置了会话粘性,以确保⽤户的请求始终被分发到同⼀台后端服务

器。

2. 会话信息未正确共享 :如果⽹站使⽤会话信息存储在后端数据库或共享存储中,确保所有后端服务器可以正确地访问和更新这些共享资源。如果某些服务器⽆法访问会话信息,⽤户可能需要重新登录。

解决⽅法 :确保会话信息的存储和访问是⼀致的,确保后端服务器之间可以正确地访问共享资

源。

3. 会话超时设置不⼀致 :不同的后端服务器可能具有不同的会话超时设置,这可能导致某些服务器上的会话在其他服务器上过期,从⽽要求⽤户重新登录。

解决⽅法 :确保所有后端服务器上的会话超时设置是⼀致的,以防⽌会话在不同服务器上过期。

4. 负载均衡配置问题 :有时,负载均衡器的配置可能会导致会话丢失或重新分配的问题。这可能是由于配置错误、会话粘性设置不正确或其他配置问题引起的。

解决⽅法 :仔细审查负载均衡器的配置,确保它正确地处理会话,并根据需要进⾏调整。

5. 应⽤程序问题 :最后,问题可能源⾃应⽤程序本身,例如,应⽤程序可能不正确地处理会话或会话信息存储在不稳定的位置。

解决⽅法 :在应⽤程序层⾯进⾏调查和测试,确保会话管理和存储在所有后端服务器上正常⼯

作。

综上所述,要解决⽤户需要重新登录的问题,需要仔细检查负载均衡配置、会话管理和共享⽅式,以确保⼀致性和可靠性。在负载均衡环境中,会话状态的⼀致性⾮常重要,以提供良好的⽤户体验。

68.apache与nginx的区别?

Apache 和 Nginx 都是两个⾮常流⾏的 Web 服务器软件,各⾃具有其独特的特点和优势。以下是它们之间的⼀些主要区别:

1. 架构设计 :

Apache :使⽤⼀个进程 / 线程处理⼀个请求的多进程 / 多线程模型。即使使⽤了像 MPM ( 多处理模

块 ) 这样的模块来优化,它仍然倾向于使⽤更多的系统资源,尤其是在⾼并发场景下。

Nginx :使⽤事件驱动的架构,可以异步处理⼤量请求,这意味着它可以处理数千个并发连接,⽽

只使⽤很少的内存。

2. 性能 :

Apache :对于静态内容和低并发的环境中, Apache 的性能表现⾮常出⾊。但在⾼并发场景下,它可能会消耗更多的资源。

Nginx :在⾼并发场景中, Nginx 通常表现得更好,因为它的事件驱动架构使其能够更⾼效地处理

⼤量并发连接。

3. 功能和模块化 :

Apache : Apache 提供了⼤量的模块,如 mod_php 、 mod_proxy 等,使其功能⾮常丰富。它还允

许动态加载模块,增强了其灵活性。

Nginx :虽然 Nginx 也⽀持模块,但它们在编译时被包含,⽽不是运⾏时动态加载。这意味着增加

或更改 Nginx 的功能可能需要重新编译。

4. 配置 :

Apache :使⽤ .htaccess ⽂件,可以在⽬录级别进⾏配置。这为⽤户提供了很⼤的灵活

性,但可能降低性能。

Nginx :不⽀持 .htaccess 类似的⽬录级别配置,这意味着所有的配置都在主配置⽂件中。

这可以提供更好的性能,但可能牺牲了⼀些灵活性。

5. ⽀持的语⾔和⼯具 :

Apache :有⼀个内建的 PHP 模块( mod_php ),可以⾮常⾼效地运⾏ PHP 。

Nginx :不包含 PHP 处理器,需要与 PHP-FPM 或其他⼯具⼀起使⽤来处理 PHP 。

6. 历史和社区⽀持 :

Apache : Apache Web 服务器已经存在了很⻓时间,拥有⼤量的⽂档、教程和社区⽀持。

Nginx :尽管是相对较新的服务器,但由于其⾼性能和灵活性,它已经积累了⼤量的⽤户和社区⽀

持。

怎么选择:

选择 Apache 或 Nginx 应该基于你的具体需求、你的团队熟悉哪种技术、预期的并发量以及你需要哪些特定功能。

对于需要⾼并发、低延迟的应⽤, Nginx 可能是更好的选择。

对于需要丰富功能、模块和⾼级配置的应用, Apache 可能更适合。

在某些场景下, Apache 和 Nginx 可以⼀起使⽤,例如使⽤ Nginx 作为反向代理,⽽ Apache 处理后端应⽤。

69.docker三⼤服务模式

70.容器核心要素

71.容器解决了什么问题

72.容器你觉得有什么缺点,哪些场景不适合用容器

容器技术,如 Docker ,带来了许多优势,如快速部署、环境⼀致性、微服务架构的便利性等。然⽽,容器并不是万能的,它们也有⾃⼰的限制和缺点。以下是⼀些容器的潜在缺点以及不适合使⽤容器的场景:

缺点:

1. 安全性问题 :

容器与主机共享相同的内核,如果容器被破坏,攻击者可能会获得对主机的⾼级权限。

⼀些默认配置可能不是安全的,需要专⻔进⾏安全加固。

2. 存储复杂性 :

持久化存储在容器化环境中仍然是⼀个挑战。虽然有各种解决⽅案,但它们往往增加了复杂性。

3. ⽹络性能 :

容器网络层可能会引⼊⼀些性能开销,尤其是在⾼流量的⽹络通信中。

4. ⽇志管理 :

容器化的应⽤可能会产⽣分散的⽇志,需要集中的⽇志解决⽅案,如 ELK Stack 或 Loki 。

5. 监控与调试 :

传统的监控和调试⼯具可能不适⽤于容器。尽管有新的⼯具出现,但这可能需要运维和开发团队

进⾏调整。

不适合使⽤容器的场景:

1. ⾼性能计算应⽤ :对于需要充分利⽤硬件资源、低延迟或特定硬件优化的应⽤,容器可能会带来不必要的开销。

2. Bare-metal 性能需求 :对于需要直接访问硬件资源的应⽤(例如,某些数据库或⾼性能计算应⽤), 直接在裸机上运⾏可能更为合适。

3. 复杂的图形处理 :对于需要复杂图形处理的应⽤,容器可能不是最佳选择,尤其是那些依赖于特定图形硬件的应⽤。

4. 传统⼤型企业应⽤ :⼀些⼤型、多部分的传统应⽤可能不容易容器化,尤其是那些与硬件、⽹络配置或存储深度集成的应⽤。

5. 不⽀持容器的软件 :某些商业软件可能不⽀持在容器内运⾏,或者在容器中运⾏时不提供技术⽀持。

总的来说,虽然容器技术带来了很多好处,但在决定是否采⽤它之前,仍然需要进⾏仔细的评估,确保它满足特定的需求和约束。

73.容器通信模式

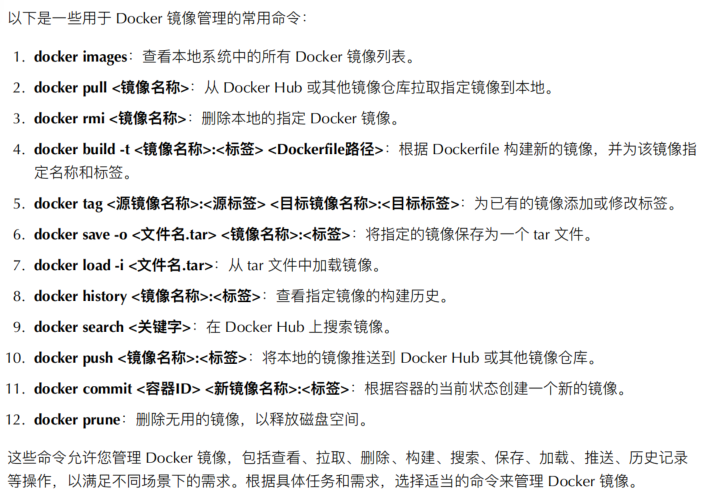

74.镜像管理命令

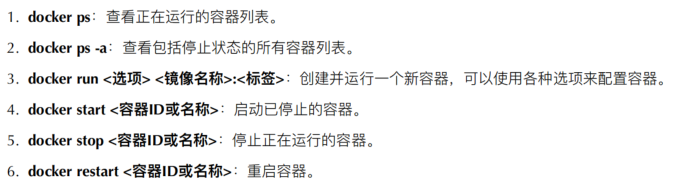

75.容器管理命令

76.dockerfile常用指令

-

FROM

指定基础镜像,所有后续指令都基于此镜像构建。

示例:FROM ubuntu:22.04(基于 Ubuntu 22.04 镜像)

-

WORKDIR

设置工作目录,后续的命令(如 RUN、CMD 等)会在此目录下执行。

示例:WORKDIR /app(将工作目录切换到 /app)

-

COPY

将本地文件或目录复制到镜像中。

示例:COPY ./src /app/src(复制本地 src 目录到镜像的 /app/src)

-

ADD

功能类似 COPY,但支持自动解压压缩文件和从 URL 下载文件。

示例:ADD https://example.com/file.tar.gz /app(下载并解压文件到 /app)

-

RUN

在镜像构建过程中执行命令(如安装软件、配置环境等)。

示例:RUN apt-get update && apt-get install -y python3(更新包并安装 Python3)

-

CMD

定义容器启动时默认执行的命令,一个 Dockerfile 中只能有一个有效的 CMD,若指定多个则最后一个生效。

示例:CMD ["python3", "app.py"](容器启动时运行 app.py)

-

ENTRYPOINT

与 CMD 类似,但更适合定义容器的 "入口程序",CMD 的内容会作为其参数。

示例:ENTRYPOINT ["python3"] + CMD ["app.py"](等效于执行 python3 app.py)

-

ENV

设置环境变量,可在构建过程和容器运行时使用。

示例:ENV APP_PORT=8080(设置环境变量 APP_PORT 为 8080)

-

EXPOSE

声明容器运行时监听的端口(仅为文档说明,不实际映射端口)。

示例:EXPOSE 8080(声明容器使用 8080 端口)

-

VOLUME

创建数据卷,用于持久化数据(避免容器内数据丢失)。

示例:VOLUME ["/data"](创建 /data 目录作为数据卷)

-

USER

指定后续命令执行的用户(默认使用 root)。

示例:USER appuser(切换到 appuser 用户执行后续命令)

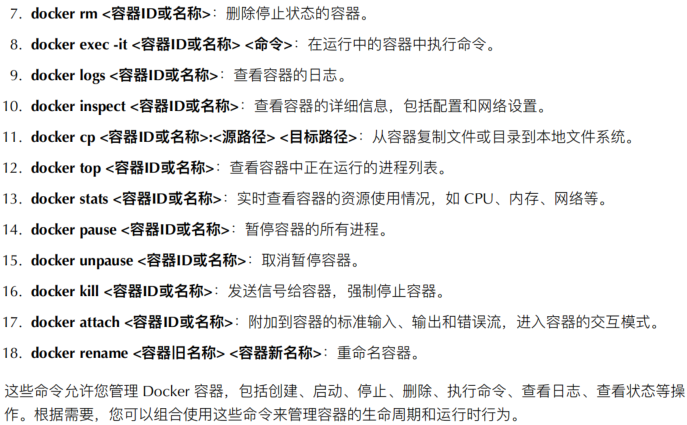

77.如何发布容器

78.容器卷怎么用

容器卷( Volumes )是 Docker 中⽤于持久化存储数据的⼀种机制。它们允许您在容器之间或容器与主机之间共享和存储数据。以下是如何使⽤容器卷的⼀些常见操作:

1. 创建容器卷: 您可以使⽤以下命令创建容器卷: docker volume create myvolume

2. 将容器卷挂载到容器中 : 在运⾏容器时,您可以使⽤ -v 或 --volume 选项将容器卷挂载到容

器的特定路径。例如: docker run -v myvolume:/path/in/container myimage

这将将名为 myvolume 的容器卷挂载到容器中的 /path/in/container 。

3. 将容器卷挂载到多个容器中 : 您可以将同⼀个容器卷挂载到多个容器中,以实现数据共享。

4. 查看容器卷列表 : 您可以使⽤以下命令列出所有容器卷: docker volume ls

5. 查看容器卷详细信息: docker volume inspect myvolume

6. 删除容器卷: docker volume rm myvolume

容器卷的主要优点是数据持久性和容器之间的数据共享。它们对于将数据从容器中保留到宿主机或将数据 从⼀个容器传递到另⼀个容器非常有用。容器卷还可以在容器被删除时保留数据,使数据在容器重新创建时可用。

79.容器私有仓库怎么用

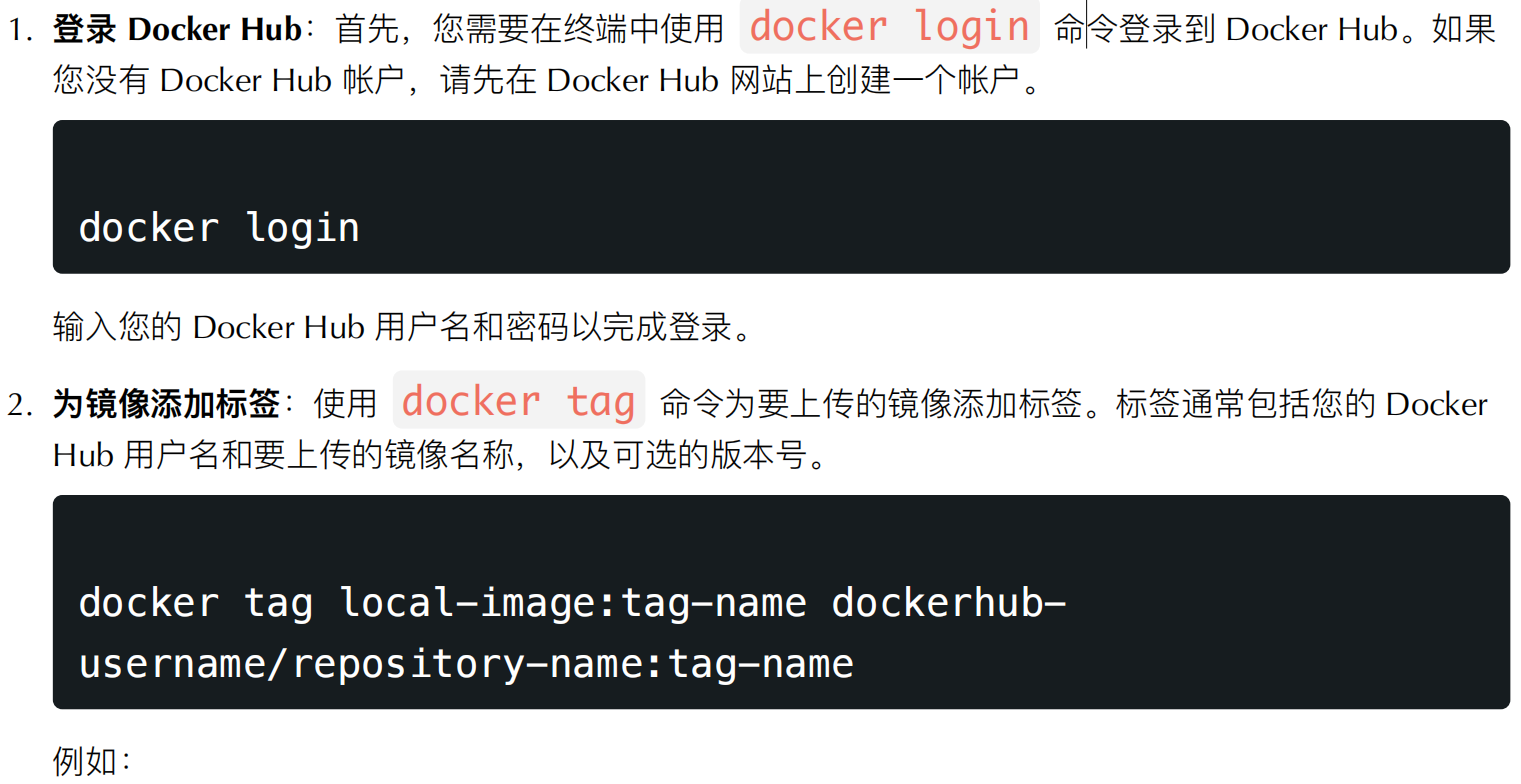

要使⽤容器私有仓库,您可以按照以下步骤操作:

1. 安装和配置 Docker : 确保您的系统上安装了 Docker ,并且 Docker 守护程序正在运⾏。您还需要确保Docker客户端已正确配置,以便能够与私有仓库进⾏交互。

2. 安装容器私有仓库 : 您可以选择不同的容器私有仓库软件,例如 Docker Registry 、 Harbor 等。按照所选软件的⽂档,按照说明进⾏安装和配置。

3. 启动私有仓库 : 启动您选择的容器私有仓库软件。通常,这可以通过运⾏⼀个特定的 Docker 容器来完成,该容器包含了私有仓库服务。

4. 构建和推送镜像 : 使⽤ Docker 客户端构建您的 Docker 镜像,并将其推送到私有仓库。要推送镜像,首先需要登录到私有仓库。例如,如果您使⽤Docker Registry ,可以使⽤以下命令登录:

docker login your-private-registry-url

然后,使⽤ docker build 命令构建您的镜像,并使⽤ docker push 命令将其推送到私有仓库。

5. 从私有仓库中拉取镜像: docker pull your-private-registry-url/your-image-name

6. 设置适当的权限: 根据您的私有仓库软件,可能需要设置适当的访问权限和身份验证,以确保只有授权的用户可以访问和拉取镜像。

7. 管理和维护私有仓库: 定期管理和维护您的私有仓库,包括清理不再需要的镜像和监视存储使⽤情况,以确保它不会耗尽磁盘空间。

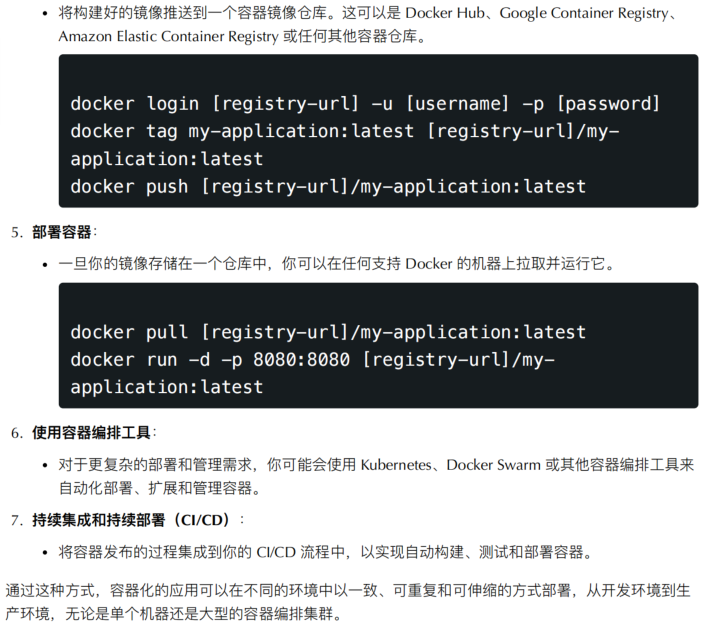

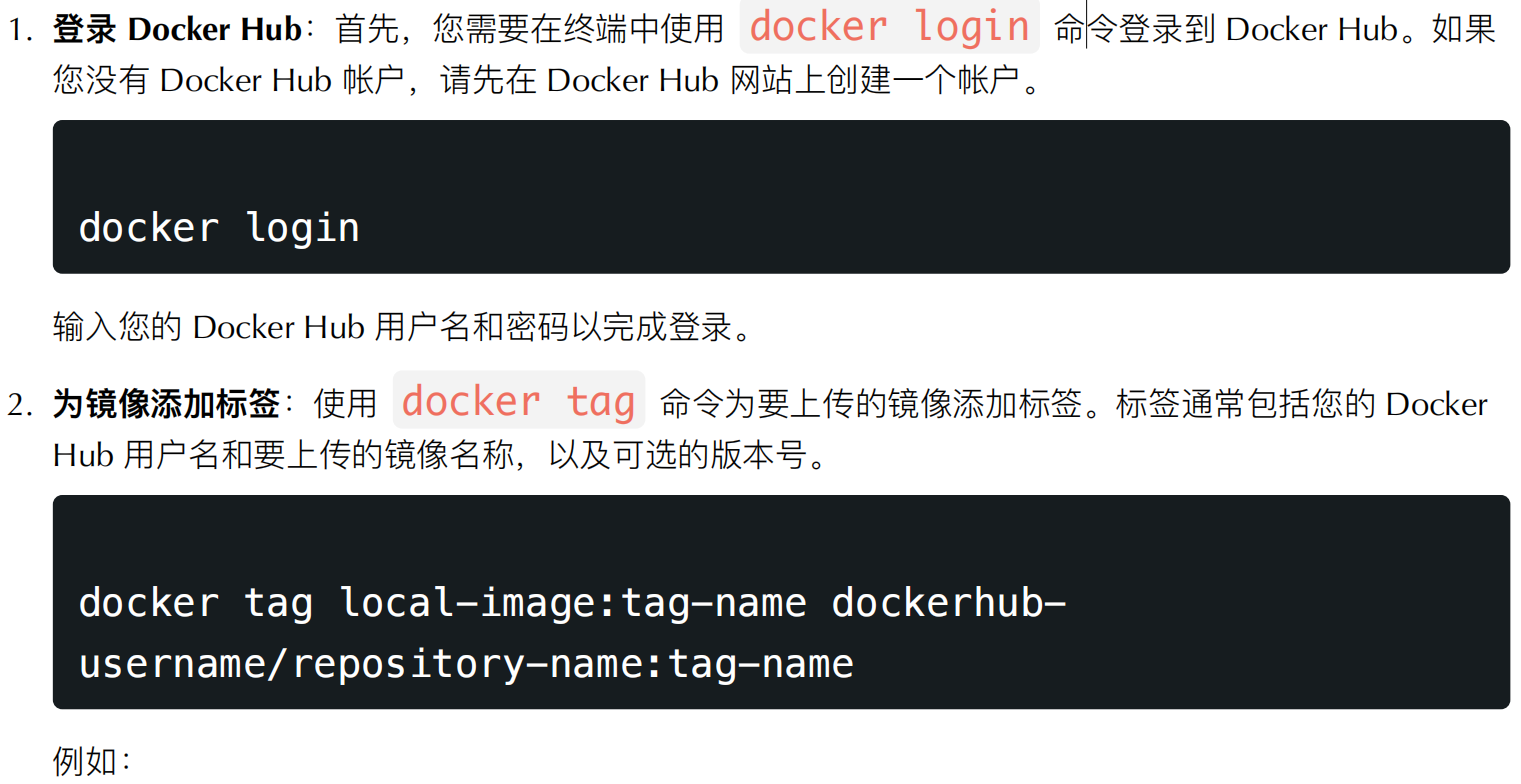

80.如何上传镜像

cker pull your-private-rgistry-url/your-image-name

65.LVS的缺点是

65.LVS的缺点是

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)