某环保科技公司AI架构优化:从云到边的算力下沉实践

本文将以“某环保科技公司”(为保护隐私,文中将使用化名“绿境科技”)的真实实践为蓝本,详细阐述其如何洞察传统云端AI架构的痛点,如何规划并实施“从云到边”的算力下沉战略,以及在这一过程中面临的技术挑战、解决方案、取得的成效与宝贵经验。

好的,作为一位资深软件工程师和技术博主,我很乐意为您撰写这篇关于“某环保科技公司AI架构优化:从云到边的算力下沉实践”的技术博客文章。

标题:某环保科技公司AI架构优化实战:从云端集中到边缘智能的算力下沉之路与最佳实践

副标题:打破数据洪流与实时性瓶颈,构建高效、智能、经济的下一代环保监测AI平台

关键词: 环保科技、AI架构优化、算力下沉、边缘计算、云计算、云边协同、物联网(IoT)、实时监测、人工智能、机器学习、深度学习

一、引言:环保AI的“云端困境”与算力下沉的呼唤

1.1 环保科技的AI革命:守护绿水青山的智能引擎

随着全球环境问题日益严峻,环境保护已成为人类社会可持续发展的核心议题。环保科技公司作为这场攻坚战中的重要力量,正积极拥抱人工智能(AI)、物联网(IoT)、大数据等前沿技术,以提升环境监测的精度、效率和智能化水平。从大气质量实时监控、水质污染溯源、噪声自动识别,到工业三废排放预警、固废智能分拣,AI技术正深度融入环保业务的各个环节,为精准治污、科学决策提供了强大的数据支撑和智能洞察。

1.2 云端AI架构的辉煌与隐忧

回顾过去几年,“云原生”理念深入人心,许多环保科技公司的AI系统也自然而然地采用了“终端设备采集数据 -> 云端集中训练与推理”的经典架构。这种架构在初期展现了巨大优势:

- 强大的算力支持: 云端服务器集群能够提供海量算力,支撑复杂AI模型(如深度学习)的训练和大规模推理。

- 便捷的开发与维护: 模型训练、更新和维护均在云端进行,开发者无需关注底层硬件细节。

- 数据集中管理与分析: 所有监测数据汇聚云端,便于进行全局分析、趋势预测和模型优化。

然而,随着环保监测点位的指数级增长、监测参数的多样化(图像、视频、各类传感器数据)以及对实时响应、低延迟决策需求的日益迫切,传统的纯云端AI架构逐渐显露出其局限性,如同一个“甜蜜的负担”:

- 海量数据传输的“带宽噩梦”与成本高企: 大量高清视频流、高频传感器数据持续上传至云端,对网络带宽提出了极高要求,不仅可能导致传输延迟,更带来了巨额的带宽成本和存储成本。想象一下,成千上万个水质监测点的高清摄像头,24小时不间断上传视频,这将是多么庞大的数据洪流。

- 实时性响应的“致命延迟”: 对于诸如突发污染事件预警、危险气体泄漏实时报警等场景,数据从终端到云端,经过推理分析后再返回控制指令,这一来一回的延迟可能会错失最佳处置时机,造成不可挽回的损失。

- 网络稳定性的“阿喀琉斯之踵”: 许多环保监测设备部署在偏远地区或网络基础设施薄弱地带,网络连接不稳定甚至时常中断,导致数据上传失败或AI服务不可用,影响监测的连续性和可靠性。

- 数据隐私与安全的“达摩克利斯之剑”: 部分环境监测数据可能涉及敏感信息或企业隐私,将所有原始数据上传至云端,增加了数据泄露和滥用的风险,也可能面临更严格的数据合规挑战。

- 云端资源的“潮汐困境”与算力浪费: 环保监测数据往往具有周期性或突发性,导致云端算力需求波动巨大。为应对峰值需求而过度配置云端资源,在非峰值时段则造成算力闲置和资源浪费。

1.3 算力下沉:边缘计算带来的“及时雨”

面对上述挑战,环保科技公司的AI架构亟需一场深刻的变革。“算力下沉”——即将部分AI计算任务从云端迁移至数据产生的“边缘侧”(Edge),成为破解困局的关键战略。

边缘计算(Edge Computing)将计算能力、存储资源和应用服务部署在靠近数据源或用户的网络边缘节点,实现数据的本地处理和实时分析。这不仅可以显著减少数据传输量、降低网络带宽压力和成本,更能大幅提升AI应用的实时响应速度,增强系统在弱网或断网环境下的鲁棒性,并更好地保护数据隐私。

1.4 本文概述:一次环保AI架构的“从云到边”转型之旅

本文将以“某环保科技公司”(为保护隐私,文中将使用化名“绿境科技”)的真实实践为蓝本,详细阐述其如何洞察传统云端AI架构的痛点,如何规划并实施“从云到边”的算力下沉战略,以及在这一过程中面临的技术挑战、解决方案、取得的成效与宝贵经验。我们将深入探讨:

- 绿境科技在环保AI应用中遇到的具体“云端困境”。

- 为何选择边缘计算进行算力下沉,以及云边协同架构的优势。

- 算力下沉的具体实施路径:从需求分析、技术选型、架构设计到落地部署。

- 关键技术点剖析:边缘AI模型轻量化、边缘节点管理、云边数据协同、安全策略等。

- 实际应用案例与性能对比,量化算力下沉带来的价值提升。

- 实践过程中的经验总结、教训反思以及对未来边缘智能在环保领域发展的展望。

希望通过绿境科技的案例,能为更多身处类似困境、渴望通过技术创新提升核心竞争力的环保科技企业,乃至其他行业的AI实践者提供有益的借鉴和启示。

二、背景:绿境科技的AI应用与“云端困境”

2.1 绿境科技简介与核心AI应用场景

绿境科技是一家致力于提供智慧环保整体解决方案的高新技术企业。公司业务涵盖大气环境监测与治理、水环境监测与修复、土壤污染评估、工业污染源在线监控、智慧垃圾分类与回收等多个领域。为提升监测精度、预警效率和管理智能化水平,绿境科技早在数年前就积极布局AI技术研发与应用,主要场景包括:

- 智能视觉监测:

- 大气黑臭水体识别: 通过部署在河道、湖泊沿岸的高清摄像头,利用计算机视觉算法实时识别水面漂浮物、藻类爆发、黑臭现象等。

- 秸秆焚烧与火情监测: 对广阔区域进行视频监控,AI模型自动识别秸秆焚烧、垃圾焚烧等火点及烟雾。

- 工业排污口异常行为监测: 监控企业排污口,识别偷排、超标排放、非法倾倒等行为。

- 智慧工地扬尘与噪声监测: 结合图像识别和传感器数据,判断工地扬尘等级和违规作业。

- 多源传感器数据融合分析:

- 空气质量多参数智能预警: 融合部署在不同区域的PM2.5、PM10、SO2、NO2、O3等传感器数据,结合气象数据,进行空气质量预测和污染溯源。

- 水质参数实时分析与异常检测: 对pH值、溶解氧、浊度、COD、氨氮等水质传感器数据进行实时分析,快速识别异常波动,预警污染事件。

- 智能语音与声学监测:

- 工业噪声源识别与定位: 通过麦克风阵列采集声音,识别特定工业设备的异常噪声或超标排放噪声,并进行声源定位。

- 野生动物(或特定生物)声音监测: 在生态保护区,通过识别特定鸟类或动物的声音,进行物种监测和生态评估。

- AI辅助决策支持:

- 污染扩散模拟与应急指挥: 基于实时监测数据和AI模型,模拟污染物扩散路径和影响范围,辅助应急决策。

- 垃圾智能分类与回收优化: 在垃圾中转站或分拣中心,利用AI视觉识别技术对垃圾进行自动分类。

2.2 “云原生”AI架构的初期构建与优势

在AI应用初期,绿境科技自然而然地选择了当时主流的“云原生”架构模式。其典型的数据流和处理流程如下:

- 数据采集: 各类IoT感知设备(摄像头、传感器、麦克风等)采集原始数据。

- 数据上传: 原始数据通过4G/5G/NB-IoT/LoRa等网络实时或准实时上传至云端数据中心。

- 数据存储与预处理: 云端服务器接收数据后,进行清洗、格式转换、标注(如需)等预处理,并存储于云数据库或数据湖中。

- 模型训练: 数据科学家在云端利用大规模数据集训练AI模型(如CNN、RNN等深度学习模型)。

- 模型部署与推理: 训练好的模型部署在云端AI推理服务集群。

- 结果反馈与应用: 云端推理结果发送给业务应用系统(如监测平台、预警系统、APP等),供管理人员查看或触发相应的控制指令。

这种架构在初期为绿境科技带来了诸多便利:

- 快速迭代: 集中式开发、训练和部署,便于AI模型的快速更新和迭代。

- 资源弹性: 可根据业务需求弹性扩展云端计算和存储资源。

- 数据集中化管理: 所有数据汇聚云端,便于进行全局分析和挖掘。

- 降低终端复杂度: 终端设备仅需完成数据采集和上传,对硬件性能要求较低。

2.3 业务扩张下的“云端困境”日益凸显

随着绿境科技业务的快速扩张,监测点位从最初的数百个增长到数千甚至上万个,监测设备种类和数据量呈爆炸式增长。原本运行顺畅的云端AI架构,逐渐暴露出难以承受的压力和诸多痛点,具体表现如下:

-

2.3.1 数据洪流:带宽成本与传输延迟的双重压迫

这是最直接、最显著的问题。以智能视觉监测为例,一个1080P的高清摄像头每小时产生的数据量约为4-8GB(取决于压缩率和帧率)。如果部署1000个这样的摄像头,即使采用H.265等高效压缩算法,每天的数据上传量也高达数十TB。这导致:- 高昂的带宽成本: 大量的数据传输需要购买巨额的4G/5G流量套餐或专线带宽,这成为了绿境科技一项沉重且持续增长的运营成本。

- 严重的网络延迟: 在网络带宽有限或不稳定的情况下,视频流经常出现卡顿、丢包现象。数据从产生到上传至云端,再到推理结果返回,整个链路的延迟往往高达数秒甚至数十秒,难以满足实时监测和预警的需求。例如,对于秸秆焚烧监测,延迟可能导致火势蔓延,错失最佳扑灭时机。

-

2.3.2 云端算力资源紧张与成本高企

海量数据的预处理、存储以及大量并发的AI推理请求,对云端算力和存储资源提出了极高要求。- 推理压力大: 成千上万个监测点同时上传数据并请求AI推理,云端推理服务器集群面临巨大压力,高峰期甚至出现请求排队、响应超时的情况。

- 存储成本高: 长时间保存海量原始监测数据(尤其是视频数据),云端存储成本也急剧攀升。虽然可以通过数据生命周期管理策略(如冷备份、定期删除)缓解,但对于需要长期回溯分析的数据而言,仍是一笔不小的开支。

- 资源利用率不均: 环保监测数据往往具有时段性(如白天数据多,夜晚数据少;特定季节数据多),导致云端资源在高峰期需要扩容,低谷期则出现闲置,整体资源利用率不高,进一步推高了TCO(总拥有成本)。

-

2.3.3 实时性与可靠性挑战

环保监测,特别是应急预警场景,对实时性和系统可靠性有极高要求。- 实时性不足: 如前所述,数据上传和云端推理的总延迟过长,导致异常事件发现不及时,影响处置效率。

- 网络依赖性强: 一旦终端设备与云端之间的网络连接中断(这在偏远地区或恶劣天气下时有发生),整个监测点将陷入“失明”或“失聪”状态,无法进行任何AI分析和预警,造成监测数据断层和业务中断风险。

-

2.3.4 数据隐私与安全顾虑

部分环境监测数据可能涉及企业生产信息、特定区域敏感图像等。- 隐私泄露风险: 大量原始数据(尤其是视频)上传至云端,增加了数据在传输和存储过程中被非法获取、泄露或滥用的风险。

- 合规性压力: 随着《数据安全法》、《个人信息保护法》等法律法规的出台和完善,数据跨境流动、敏感数据处理等方面的合规要求日益严格,纯云端架构在某些场景下可能面临合规挑战。

-

2.3.5 终端设备“傻气化”导致的功能受限

由于所有智能分析都在云端进行,前端感知设备基本是“傻终端”,仅具备数据采集和传输功能。这使得一些需要本地快速响应的功能(如本地声光报警、简单的设备联动控制)难以实现,必须依赖云端指令,进一步增加了延迟和对网络的依赖。

2.4 “痛点”量化:一组触目惊心的数据

为了更直观地展示“云端困境”的严重性,绿境科技曾对其某省大气环境监测项目进行了专项统计分析(选取了1000个视频监测点和5000个传感器监测点作为样本):

- 日均数据产生量: 约120TB(其中视频数据占比超过95%)。

- 日均4G/5G流量消耗成本: 超过10万元人民币。

- 平均端到端推理延迟: 视频分析类任务平均延迟8-15秒,传感器数据融合分析平均延迟3-5秒。

- 网络中断率: 偏远地区监测点月均网络中断时长可达2-8小时,极端天气下更长。

- 云端算力资源利用率: 高峰期CPU利用率可达85%以上,低谷期(凌晨)仅15-20%。

- 误报与漏报: 由于网络延迟和带宽限制导致视频流卡顿、丢包,间接导致AI模型误报率上升约5%,漏报风险增加。

这些数据清晰地表明,传统的纯云端AI架构已成为制约绿境科技业务进一步发展、提升服务质量和控制运营成本的主要瓶颈。一场深刻的架构变革,势在必行。

三、破局之道:为何选择边缘计算与算力下沉

面对日益严峻的“云端困境”,绿境科技的技术团队开始积极探索解决方案。经过对多种新兴技术和架构模式的调研与评估,边缘计算及其倡导的“算力下沉”理念,逐渐成为他们眼中破局的关键。

3.1 边缘计算的崛起:定义与核心优势

边缘计算(Edge Computing)是一种将计算、存储和网络资源放置在靠近数据产生源头(即网络“边缘”)的分布式计算范式。其核心思想是将原本完全在云端处理的任务,部分或全部迁移到数据产生的边缘节点进行,从而减少数据传输、降低延迟、提高响应速度、增强数据隐私保护能力和系统可靠性。

边缘节点可以是:

- 智能网关/工业网关: 部署在监测现场的小型计算设备。

- 边缘服务器: 部署在区域级机房或基站的服务器。

- 智能摄像头/传感器: 内置AI加速芯片(如NPU、GPU)的智能终端设备。

- 边缘云/微数据中心: 具有一定规模计算和存储能力的本地化小型数据中心。

边缘计算的核心优势,恰好能够针对性地解决绿境科技在云端架构中遇到的痛点:

- 低延迟,高实时性: 数据在本地处理,无需远距离传输至云端,可显著降低端到端延迟,满足毫秒级或秒级实时响应需求。

- 减少带宽消耗与成本: 原始数据在边缘进行过滤、预处理、分析后,通常只需将关键特征、分析结果或异常事件上报云端,可大幅减少上传数据量,从而降低网络带宽成本。

- 提升系统可靠性与鲁棒性: 边缘节点可在断网或弱网情况下独立工作,保证基本业务的连续性,避免“一断全断”的风险。

- 数据隐私保护与数据主权: 敏感数据在本地处理和存储,原始数据无需出境或上传至第三方云平台,有效降低隐私泄露风险,更好地满足数据本地化和合规性要求。

- 优化云端资源利用: 将大量实时性要求高、简单重复的AI推理任务分流到边缘,可减轻云端算力压力,使云端资源能更专注于复杂模型训练、全局数据分析、长期趋势预测等任务,提升整体资源利用率。

- 赋能终端智能化: 边缘计算使前端设备具备了本地智能分析和决策能力,可实现更丰富的本地化应用和快速联动控制。

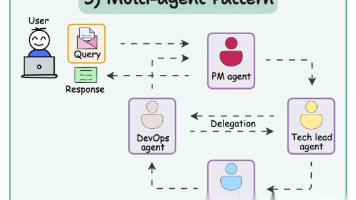

3.2 从“云”到“边”:不是取代,而是协同

需要强调的是,算力下沉至边缘,并非意味着要完全抛弃云计算。云计算在大规模数据存储、复杂模型训练、全局优化决策、业务协同等方面仍具有不可替代的优势。

理想的模式是“云边协同”:云计算与边缘计算各司其职、优势互补,共同构建一个高效、智能、弹性的AI服务体系。

- 边缘侧: 负责实时数据采集、本地数据预处理、实时AI推理与决策、低延迟响应、本地数据存储、设备控制等。

- 云端: 负责大规模数据存储与全局分析、复杂AI模型训练与优化、边缘模型分发与更新、业务应用平台支撑、多边缘节点协同管理、长期趋势预测与战略决策支持等。

这种“云边协同”模式,既能发挥边缘计算在实时性、带宽效率、隐私保护方面的优势,又能保留云计算在全局优化、资源弹性、复杂计算方面的长处,是绿境科技架构转型的核心指导思想。

3.3 绿境科技的边缘计算适用性评估

在决定采用边缘计算进行算力下沉之前,绿境科技的技术团队对其主要AI应用场景进行了细致的边缘适用性评估,重点考虑以下几个维度:

- 实时性需求: 任务是否需要毫秒级/秒级响应?

- 数据量大小: 原始数据量是否巨大,传输成本高昂?

- 网络依赖性: 网络连接是否稳定可靠?断网情况下是否需要继续工作?

- 隐私敏感度: 数据是否涉及隐私或敏感信息,不宜上传云端?

- 计算复杂度: AI模型推理复杂度如何?边缘设备能否承载?

- 交互频率: 是否需要频繁与本地其他设备进行交互和联动?

评估结果显示,绿境科技的大部分AI应用场景都非常适合引入边缘计算:

- 高度适合边缘部署: 智能视觉监测(黑臭水体识别、秸秆焚烧监测、排污口异常行为监测)、噪声实时识别、本地设备联动控制。这些场景数据量大(尤其是视频)、实时性要求高、对网络稳定性依赖强。

- 部分适合边缘部署(边缘预处理+云端深度分析): 多源传感器数据融合分析(边缘做实时数据清洗、异常值检测和特征提取,云端做全局趋势分析和预测)。

- 仍适合云端部署: 大规模AI模型训练、全局污染扩散模拟、长期历史数据挖掘与报告生成。

3.4 算力下沉的战略决策与目标设定

基于上述评估和对边缘计算优势的深刻认识,绿境科技管理层与技术团队共同决策,正式启动“AI架构算力下沉”战略,旨在构建新一代“云边协同”的智慧环保AI平台。

其核心战略目标设定为:

- 降低数据传输成本: 在保证监测效果的前提下,将整体上传数据量减少50%-80%。

- 提升实时响应速度: 将关键AI推理任务的端到端延迟降低至秒级甚至毫秒级(如视频分析延迟控制在1秒以内)。

- 增强系统鲁棒性: 实现边缘节点在断网情况下的独立工作能力,核心监测业务不中断。

- 强化数据隐私安全: 减少原始敏感数据上传,满足相关法律法规要求。

- 优化整体算力成本: 通过云边算力合理分配,降低整体IT基础设施TCO(总拥有成本)15%-30%。

- 提升AI服务质量: 降低因网络问题导致的误报率和漏报率,提高监测精度和预警准确性。

这一战略决策,标志着绿境科技的AI架构正式进入“云边协同”的新时代。接下来,便是具体的技术选型、架构设计与实施落地阶段。

四、算力下沉实践:绿境科技的云边协同AI架构设计与实施

战略方向确定后,绿境科技的技术团队开始了紧锣密鼓的云边协同AI架构设计与实施工作。这是一个系统性的工程,涉及技术选型、架构规划、模型适配、平台搭建、试点验证和全面推广等多个环节。

4.1 需求分析与场景适配细化

在正式动手前,团队再次对各AI应用场景进行了更细致的梳理,并针对算力下沉的需求进行了参数化定义,明确了每个场景在边缘侧需要实现的功能、性能指标、数据处理流程等。

例如,针对“秸秆焚烧与火情监测”场景:

- 边缘AI任务: 实时视频流分析,检测火焰、烟雾。

- 性能指标: 检测准确率>95%,误报率<3%,单帧处理延迟<200ms,支持1080P/30fps视频流。

- 数据处理: 边缘设备本地分析视频流,仅将火情事件(附带关键帧截图和时间戳)上报云端。

- 本地响应: 检测到火情后,本地触发声光报警,并尝试联动附近的喷淋设备(如有)。

- 网络断连策略: 断网时,继续本地检测,缓存事件记录,网络恢复后自动补传。

- 边缘硬件需求: 需要具备一定AI加速能力(如NPU),能够高效运行目标检测模型。

针对“水质多参数传感器监测”场景:

- 边缘AI任务: 传感器数据实时采集、清洗、异常值检测、特征提取、短期趋势预测。

- 性能指标: 数据采样频率1Hz,异常检测延迟<100ms。

- 数据处理: 边缘设备对原始传感器数据进行滤波、校准,识别出异常值后,将异常数据及特征值(而非原始高频数据)上报云端。

- 本地响应: 检测到水质参数严重超标时,本地发出预警信号。

- 网络断连策略: 断网时,本地缓存关键数据,网络恢复后补传。

- 边缘硬件需求: 计算能力要求相对较低,注重低功耗和稳定性。

通过这种方式,为每个场景“量身定制”边缘计算方案,确保资源投入的精准性和有效性。

4.2 核心技术选型:硬件、软件与算法

云边协同架构的构建,离不开关键技术组件的选型。绿境科技团队进行了广泛调研、POC(概念验证)测试和综合评估。

-

4.2.1 边缘计算硬件平台选型

边缘硬件是算力下沉的物理载体,其选型需综合考虑算力需求、功耗、成本、环境适应性(温度、湿度、防尘、抗震)、尺寸、网络接口等因素。绿境科技根据不同场景的算力需求,选择了多种形态的边缘硬件:- 高性能边缘网关/服务器: 针对视频分析等算力密集型场景,选择搭载了NVIDIA Jetson系列(如Jetson Xavier NX, Jetson Orin)、Intel Movidius VPU、华为昇腾310/610 NPU等AI加速芯片的边缘网关或小型服务器。这类设备通常具备较强的并行计算能力,能够运行复杂的深度学习模型。

- 嵌入式AI模块/SoC: 针对传感器数据处理、简单图像识别等中等算力需求场景,选择集成了NPU的嵌入式开发板或SoC模块(如树莓派+ Coral Dev Board, 各类国产AI开发板)。

- 智能摄像头/传感器: 直接采购内置AI加速芯片和基础AI算法的智能摄像头(如支持ONVIF协议的AI相机)和智能传感器,实现“端侧智能”与“边缘智能”的结合。

- 边缘节点部署方式: 根据监测点位的分布情况,采用“单点独立边缘节点”(一个监测点一个边缘网关)或“区域汇聚边缘节点”(多个临近监测点共享一个边缘服务器)的部署方式。

-

4.2.2 边缘操作系统与中间件选型

- 边缘操作系统: 主流选择包括Linux(如Ubuntu Server, Debian, CentOS Stream)的定制版,以及专为边缘设计的轻量级操作系统(如Ubuntu Core, Yocto Project, Rancher OS, 鸿蒙OS等)。绿境科技主要采用基于Linux的定制系统,兼顾了兼容性和灵活性。

- 容器化技术: 为了简化边缘应用的部署、更新和管理,采用Docker作为容器运行时。

- 边缘编排与管理平台: 这是云边协同的核心。绿境科技评估了多种方案:

- Kubernetes生态: K3s, MicroK8s, OpenYurt, KubeEdge等轻量级Kubernetes发行版或边缘扩展项目。KubeEdge和OpenYurt因其对云边协同、边缘节点管理、离线自治等特性的良好支持,成为重点考察对象。

- 商业边缘平台: 如AWS IoT Greengrass, Microsoft Azure IoT Edge, Google Cloud IoT Edge, Aliyun Link IoT Edge, Huawei Cloud IoT Edge等。这些平台集成度高,提供了丰富的工具链和服务,但可能存在一定的厂商锁定。

- 最终选择: 经过POC测试,绿境科技最终选择了 KubeEdge 作为其主要的边缘编排与管理平台。原因在于:

- 与Kubernetes生态深度融合,便于开发人员理解和使用。

- 提供了可靠的云边消息同步机制(EdgeHub)和元数据管理。

- 支持边缘节点的离线自治能力。

- 开源免费,可定制性强,避免厂商锁定。

- 社区活跃,国内支持较好。

-

4.2.3 AI模型框架与工具链选型

- 训练框架: 云端模型训练继续沿用成熟的TensorFlow, PyTorch等主流深度学习框架。

- 推理框架: 边缘端推理需要轻量级、高性能的框架。绿境科技主要选用了:

- TensorFlow Lite (TFLite): 广泛支持各种硬件平台,模型转换方便。

- ONNX Runtime: 支持ONNX格式模型,跨框架兼容性好,性能优异。

- OpenVINO: 针对Intel硬件优化,在Intel平台上性能突出。

- TensorRT: 针对NVIDIA GPU/NPU优化,推理速度快。

- 模型优化工具:

- TensorFlow Model Optimization Toolkit / PyTorch Quantization: 用于模型量化、剪枝等优化。

- OpenVINO Model Optimizer: 用于模型转换和优化。

- Netron: 模型可视化与分析。

- 数据处理库: OpenCV (图像处理), NumPy, Pandas (数据处理)。

-

4.2.4 云边数据协同与消息通信

- MQTT协议: 作为边缘节点与云端、边缘节点之间轻量级消息通信的主要协议,适合IoT场景。

- HTTP/HTTPS: 用于非实时性的数据上报、配置下发、文件传输等。

- Kafka/RabbitMQ: 云端用于高吞吐、高可靠的消息队列。

- 数据同步策略: 采用增量同步、断点续传、定时同步与事件触发同步相结合的方式。

-

4.2.5 安全技术选型

- 设备身份认证: X.509证书、设备密钥。

- 通信加密: TLS/DTLS加密传输。

- 边缘节点安全: 防火墙、最小权限原则、安全启动、可信执行环境(TEE,如适用)。

- 容器安全: 容器镜像签名与验证、运行时隔离。

4.3 云边协同AI总体架构设计

在完成关键技术选型后,绿境科技团队设计了其“云边协同”智慧环保AI平台的总体架构。该架构遵循分层设计原则,自下而上分为:

- 感知层(Edge Devices / Endpoints)

- 边缘层(Edge Layer)

- 云层(Cloud Layer)

- 应用层(Application Layer)

- 安全体系(Security System) - 贯穿所有层次

![绿境科技云边协同AI总体架构图] (此处应有架构图,实际写作时可配图)

-

4.3.1 感知层

- 组成: 各类智能/非智能传感器(水质、大气、噪声传感器)、智能摄像头、麦克风阵列、无人机、巡检机器人等。

- 功能: 原始环境数据的采集。智能设备可具备初步的感知和预处理能力。

- 与边缘层交互: 将采集的数据发送给边缘节点进行处理。

-

4.3.2 边缘层

这是算力下沉的核心执行层,部署在靠近感知设备的现场或区域机房。- 组成: 边缘网关、边缘服务器、边缘AI加速卡、KubeEdge边缘节点组件(EdgeCore, EdgeHub, DeviceTwin, MetaManager等)。

- 功能:

- 数据接入与汇聚: 接收来自感知层的各类数据。

- 本地数据预处理: 数据清洗、滤波、格式转换、压缩。

- 实时AI推理: 运行轻量化AI模型,进行实时事件检测、异常识别(如火焰、烟雾、污染物)。

- 本地决策与控制: 根据推理结果进行本地快速响应和设备联动。

- 数据过滤与汇聚上传: 仅将关键事件、分析结果、异常数据或必要的特征数据上传至云端,大幅减少上传带宽。

- **本地数据存储:**缓存关键数据和事件记录,支持断网续传。

- 设备管理: 对本地感知设备进行管理和控制。

- 边缘节点自治: 在与云端断连时,保持核心功能正常运行。

-

4.3.3 云层

部署在公有云或私有云数据中心,负责全局管理和复杂计算。- 组成: 云服务器集群、Kubernetes集群(云端控制面)、KubeEdge云端组件(CloudCore等)、AI模型训练平台、数据存储与管理系统(关系型数据库、时序数据库、数据湖)、大数据分析引擎、API网关。

- 功能:

- 模型训练与优化: 利用全局数据进行AI模型的训练、评估和优化。

- 模型管理与分发: 管理模型版本,将优化后的轻量化模型下发到边缘节点。

- 边缘节点管理与编排: 通过KubeEdge等平台对边缘节点、应用、容器进行远程管理、监控和编排。

- 全局数据存储与分析: 存储来自边缘的汇聚数据,进行全局趋势分析、报表生成、长期预测。

- 业务应用支撑: 为上层业务应用提供数据和AI能力支撑。

- 跨边缘节点协同: 协调多个边缘节点的数据和任务。

-

4.3.4 应用层

- 组成: 各类智慧环保业务应用系统,如环境监测大屏、污染源管理系统、应急指挥系统、移动APP、报表系统等。

- 功能: 面向环保管理人员、决策者提供可视化界面、业务流程管理、告警通知、决策支持等服务。

-

4.3.5 安全体系

贯穿于架构的每一层,确保整个系统的安全可信。- 设备安全: 设备身份认证、安全启动、固件更新。

- 通信安全: TLS/DTLS加密、安全信道。

- 数据安全: 数据加密(传输、存储)、数据脱敏、访问控制。

- 应用安全: 应用认证授权、漏洞防护。

- 边缘与云平台安全: 操作系统安全加固、容器安全、防火墙、入侵检测/防御。

4.4 关键技术实施细节

从设计蓝图到实际落地,绿境科技团队攻克了多个关键技术难关:

-

4.4.1 AI模型轻量化与边缘部署

这是算力下沉成功的核心技术之一。云端训练的大型、高精度模型(如ResNet-50, YOLOv5/YOLOv8等)无法直接在资源受限的边缘设备上高效运行。绿境科技采用了多种模型优化技术:- 模型量化(Quantization): 将模型权重和激活值从32位浮点(FP32)转换为16位浮点(FP16)、8位整数(INT8)甚至更低位,在精度损失可接受的前提下,显著减小模型体积、降低计算量和内存占用,提升推理速度。例如,将一个FP32的YOLOv5模型量化为INT8后,模型体积减少约75%,推理速度提升2-3倍。

- 模型剪枝(Pruning): 移除模型中冗余的连接、神经元或卷积核,简化模型结构,在保持精度的同时减小模型大小和计算复杂度。

- 知识蒸馏(Knowledge Distillation): 用一个复杂的“教师模型”(Teacher Model)的知识(输出概率分布、中间层特征等)来训练一个更简单的“学生模型”(Student Model),使学生模型在保持接近教师模型性能的同时,具有更小的体积和更快的速度。

- 模型架构搜索(NAS): 针对特定边缘硬件平台和任务,自动搜索最优的轻量化模型结构。

- 算子优化与融合: 针对特定硬件的指令集,对模型中的计算算子进行优化和融合,提升执行效率。

- 实践案例: 针对“秸秆焚烧监测”场景,绿境科技将原本在云端运行的YOLOv5s模型(FP32,约27MB)进行量化(INT8)和部分剪枝优化后,模型体积减小到约6MB,推理速度在Jetson Xavier NX上从约15 FPS提升到30+ FPS,同时mAP(平均精度均值)仅下降约1.5%,完全满足实时监测需求。

-

4.4.2 云边协同数据治理与流动

云边之间的数据如何高效、有序、安全地流动,是保证整个架构顺畅运行的关键。- 数据分类分级: 根据数据的重要性、实时性、隐私性等对数据进行分类分级,制定不同的传输策略。

- 实时关键数据: 如火灾报警、重大污染事件,优先、快速上传。

- 统计汇总数据: 如小时均值、日均值,定时批量上传。

- 原始非关键数据: 如正常视频流,经边缘分析后仅上传异常片段或关键帧。

- 数据压缩与编码: 对上传数据进行压缩(如视频H.265编码比H.264更高效),进一步降低带宽占用。

- 增量同步与断点续传: 对于历史数据补传或大文件传输,采用增量同步和断点续传机制,提高效率和可靠性。

- 元数据管理: 通过DeviceTwin(设备孪生)等机制,同步边缘设备和云端的数据模型、配置信息。

- 数据一致性保障: 设计合理的同步策略和冲突解决机制,确保云边数据的最终一致性。

- 数据分类分级: 根据数据的重要性、实时性、隐私性等对数据进行分类分级,制定不同的传输策略。

-

4.4.3 边缘节点管理与运维

边缘节点数量众多且分布广泛(甚至偏远地区),其管理和运维挑战巨大。- 远程部署与升级: 基于KubeEdge实现边缘应用、容器、配置的远程推送和升级,无需人工到现场操作。

- 状态监控与告警: 实时监控边缘节点的CPU、内存、磁盘、网络、温度等运行状态,以及AI模型推理性能、应用健康状况,异常时自动告警。

- 日志收集与分析: 边缘节点日志本地缓存并定期上传至云端集中日志平台(如ELK Stack),便于问题排查和审计。

- 能耗管理: 对部分电池供电或对能耗敏感的边缘节点,优化算法和调度策略,降低功耗。

- 故障自愈: 对于简单故障,如应用崩溃,边缘节点尝试自动重启恢复;复杂故障则通知运维人员介入。

- 离线运维能力: 支持运维人员携带便携式设备到现场进行本地诊断和修复。

-

4.4.4 云边一体的安全防护体系构建

边缘节点分布在物理环境复杂的现场,安全风险更高,需要构建全方位的安全防护。- 身份认证与访问控制:

- 边缘节点与云端之间采用双向证书认证。

- 为边缘应用和管理人员分配最小权限的账户。

- 采用SSH密钥、VNC加密等方式进行远程访问。

- 通信安全:

- 云边之间、边边之间、边与设备之间的所有通信均采用TLS/DTLS加密。

- 敏感指令和数据进行额外加密保护。

- 边缘节点自身安全:

- 操作系统最小化安装,关闭不必要的服务和端口。

- 部署轻量级防火墙(如iptables),严格控制网络访问。

- 对边缘节点存储的数据进行加密。

- 定期进行安全漏洞扫描和补丁更新。

- 容器安全:

- 使用可信镜像源,对容器镜像进行签名和验证。

- 限制容器的资源使用和权限。

- 物理安全: 边缘设备安装在安全可控的箱体或机房内,防止物理接触和破坏。

- 身份认证与访问控制:

4.5 实施步骤与阶段

绿境科技的算力下沉并非一蹴而就,而是采用了“试点-评估-优化-推广”的渐进式实施策略:

-

第一阶段:概念验证与技术选型(2个月)

- 明确试点场景(选择了“秸秆焚烧监测”和“水质传感器数据异常检测”两个典型场景)。

- 搭建小型测试环境,对边缘硬件、KubeEdge平台、AI模型优化方案进行POC验证。

- 完成核心技术选型和初步架构设计。

-

第二阶段:试点场景部署与调优(3个月)

- 选取10个秸秆焚烧监测点和20个水质监测点进行实际部署。

- 部署边缘硬件、KubeEdge云边环境。

- 开发并优化试点场景的边缘AI模型。

- 进行系统联调,解决遇到的兼容性、性能、稳定性问题。

- 持续监测和收集试点数据,与纯云端方案进行对比评估(延迟、带宽、准确率等)。

- 根据试点结果优化架构设计和技术方案。

-

第三阶段:经验总结与平台完善(2个月)

- 总结试点阶段的经验教训,完善边缘管理平台功能(监控、告警、日志)。

- 优化模型优化流程和工具链。

- 制定标准化的部署流程、运维规范和安全策略。

- 开发更多场景的边缘AI应用模块。

-

第四阶段:规模化推广与全面落地(6个月以上)

- 按照优化后的方案,在更多监测点位和业务场景中推广部署边缘计算节点。

- 持续进行平台运维、性能监控和优化迭代。

- 对运维人员进行全面培训。

- 逐步将大部分适合边缘处理的AI推理任务迁移至边缘。

这种分阶段、小步快跑的实施策略,有效降低了大规模变革的风险,确保了算力下沉战略的平稳落地和成功。

五、成效与价值:算力下沉带来的变革

经过近一年的规划、试点和规模化推广,绿境科技的“从云到边”算力下沉战略取得了显著成效。无论是在技术指标、成本控制还是业务价值层面,都实现了跨越式提升。

5.1 关键技术指标大幅改善

通过对比实施算力下沉前后(选取相同数量和类型的监测点作为样本)的关键技术指标,算力下沉的优势得到了充分验证:

-

数据传输量与带宽成本:

- 上传数据量: 平均每个视频监测点的日均上传数据量从约100GB(原始视频流)降至5-15GB(仅事件视频片段+分析结果),整体上传数据量减少约85%-90%。

- 带宽成本: 4G/5G流量成本随之降低约80%,每年可为公司节省数千万元的网络开支。

-

AI推理延迟:

- 视频分析类任务: 端到端延迟从原来的8-15秒,降至0.5-1秒,满足了实时性监测和预警的需求。

- 传感器数据异常检测: 延迟从原来的3-5秒,降至50-200毫秒。

-

系统可靠性与连续性:

- 断网自治能力: 边缘节点在网络中断情况下,能够独立进行AI分析和本地告警,核心业务连续性达到99.9%以上。

- 数据完整性: 通过断网缓存和自动续传机制,数据丢失率降至0.1%以下。

-

AI模型推理性能与资源利用率:

- 边缘节点AI推理帧率: 秸秆焚烧识别模型在Jetson Xavier NX上的推理帧率稳定在30 FPS以上(1080P视频)。

- 云端CPU利用率: 由于大量推理任务分流至边缘,云端CPU平均利用率从原来的波动于15%-85%,降至更为平稳的30%-50%,资源利用更均衡高效。

-

AI识别准确率与业务质量:

- 误报率: 由于视频流更稳定(本地处理,无网络抖动影响)和模型针对边缘环境的优化,误报率降低了约2.5个百分点。

- 漏报率: 由于实时性提升和断网不中断,漏报率降低了约3个百分点。

5.2 业务价值显著提升

算力下沉带来的技术指标改善,直接转化为显著的业务价值提升:

- 应急响应能力增强: 对于秸秆焚烧、非法排污等突发事件,从发现到告警的时间大幅缩短,为应急处置争取了宝贵时间,有效降低了环境危害。例如,某地区试点后,秸秆焚烧火点平均处置响应时间从原来的20-30分钟缩短至5-10分钟。

- 监测覆盖范围扩大: 带宽成本的降低和对网络依赖性的减弱,使得绿境科技可以在更多偏远、网络条件较差的地区部署AI监测点,监测网络的覆盖密度和广度得到显著提升。

- 运维效率提高: 边缘节点的远程管理和自治能力,减少了现场运维的频次和成本。据统计运维工作量减少了约40%,运维人员可以更专注于核心问题解决。

- 数据隐私与合规性提升: 原始敏感视频和数据在本地处理,不上传或仅上传脱敏后的结果,更好地保护了数据隐私,满足了

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)