ChatGLM3——基于AutoDl平台的部署及LorA微调实践

本文旨在记录项目的进度及试错过程,本文根据清华大学的开源项目ChatGLM3进行实现,本次实现基于AutoDl的GPU算力平台(相交便宜)的ubuntu操作系统,使用pytorch2.1.1 , python3.10.12 (建议大于3.10),cuda版本为11.8。如有问题欢迎指出!

本文旨在记录项目的进度及试错过程,本文根据清华大学的开源项目ChatGLM3进行实现,本次实现基于AutoDl的GPU算力平台(相较便宜)的ubuntu操作系统,使用pytorch2.1.1 , python3.10.12 (建议大于3.10),cuda版本为11.8。

如有问题欢迎指出!

一:部署

本文参考GitHub - THUDM/ChatGLM3: ChatGLM3 series: Open Bilingual Chat LLMs | 开源双语对话语言模型

chatglm3-6b · 模型库 (modelscope.cn)

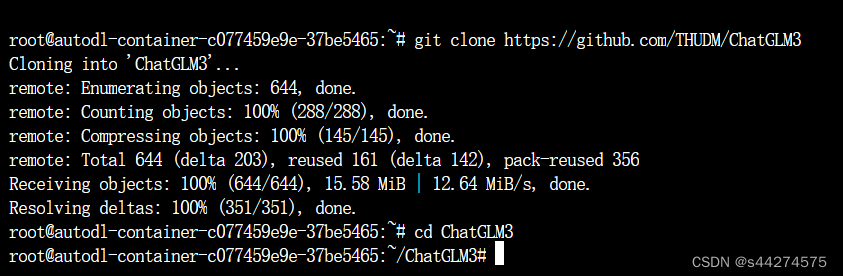

1.1打开终端下载项目仓库并且打开项目文件

git clone https://github.com/THUDM/ChatGLM3

cd ChatGLM3

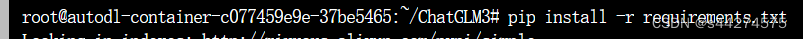

1.2安装项目依赖库

pip install -r requirements.txt

1.3下载模型实现和参数

因为从huggingface下载模型较慢及对网络有要求,本文将从ModelScops社区进行下载模型。

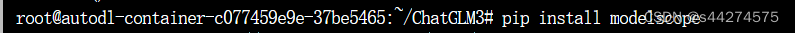

首先下载modelscope API

pip install modelscope

进入python

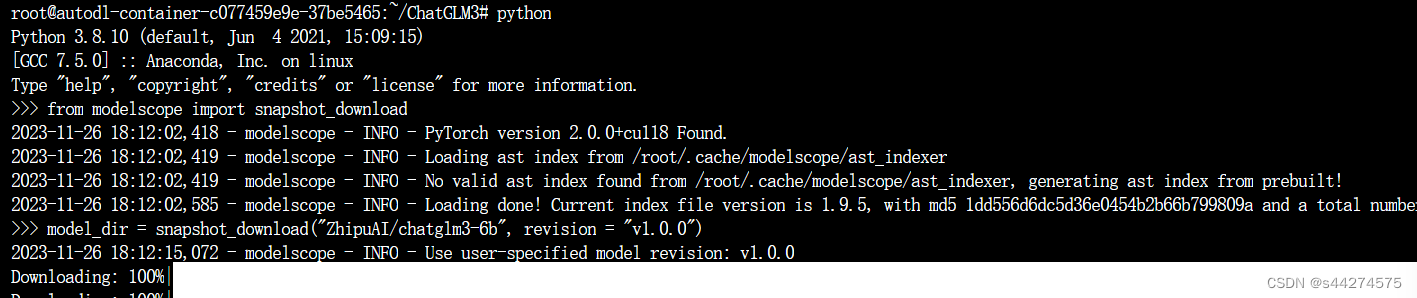

python输入下列代码:

from modelscope import snapshot_download

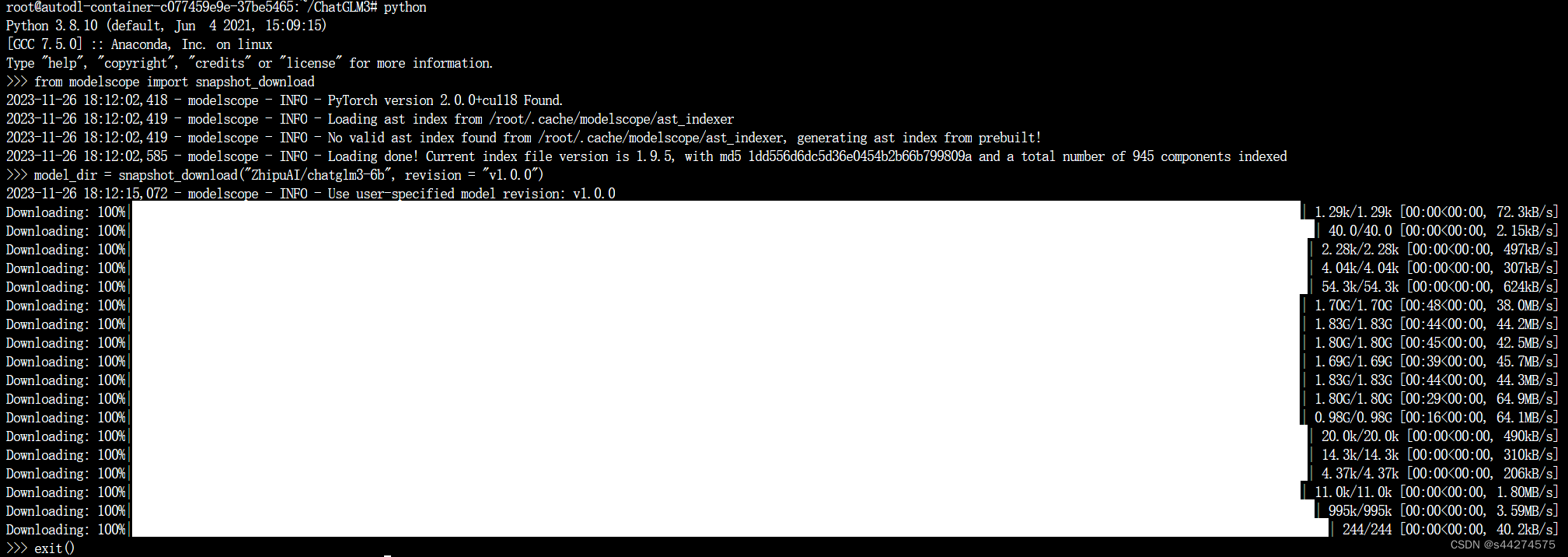

model_dir = snapshot_download("ZhipuAI/chatglm3-6b", revision = "v1.0.0") 模型自动开始下载 如图下载完成

模型自动开始下载 如图下载完成

exit()exit()退出pyhon

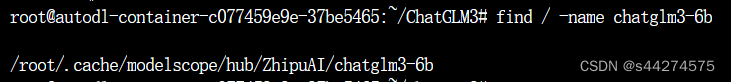

1.4寻找模型实现和参数路径

find / -name chatglm3-6b

复制改路径。

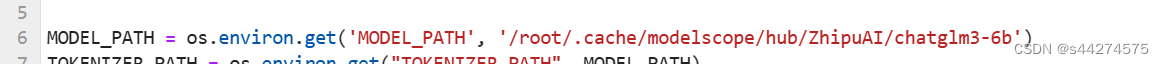

1.5进入ChatGLM3/basic_demo/cli_demo.py文件夹修改第六行

将'THUDM/chatglm3-6b'

修改为'/root/.cache/modelscope/hub/ZhipuAI/chatglm3-6b'(刚才复制的路径)

并按Ctrl+S保存修改

1.6运行cli_demo.py程序

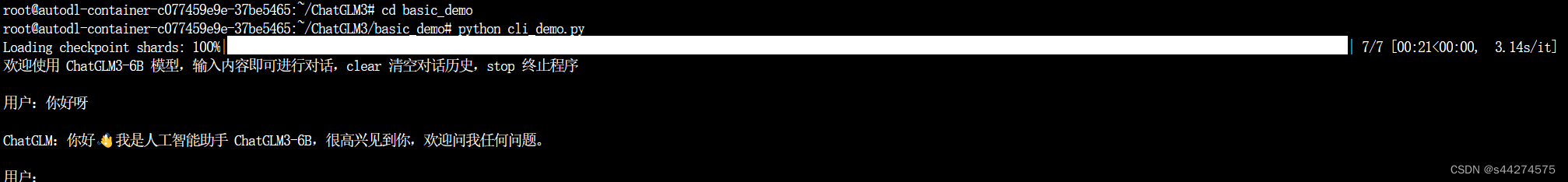

进入终端打开cli_demo.py所在文件夹

cd basic_demopython cli_demo.py

如图成功加载参数并且运行程序就算部署成果,web端也使用同样的方法修改模型权重路径

二.使用Lora方法微调(python要求在3.10以上\)

2.1上传微调文件

文件格式:

{"context": "hello", "target": "hi,I am ChatGLM3"}

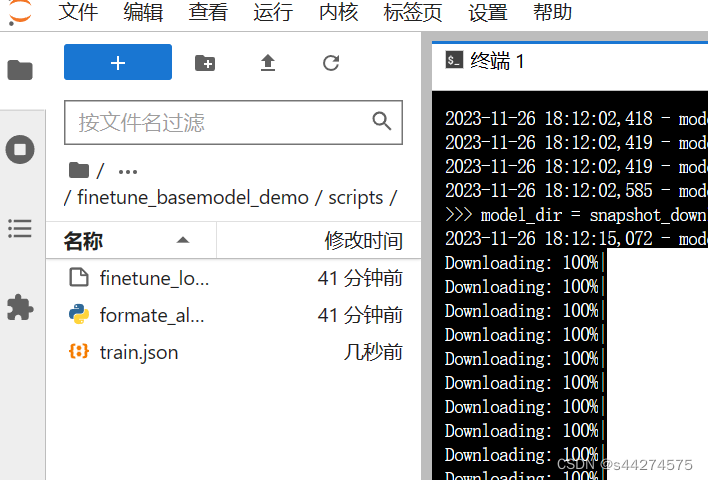

将微调数据集上传到ChatGLM3/finetune_basemodel_demo/scripts目录下(autodl平台下直接拖就可以了)

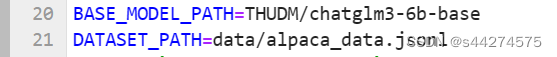

2.2修改finetune_lora.sh文件

寻找train.json文件地址

find / -name train.json

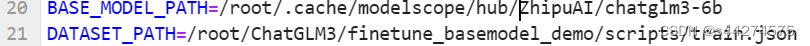

将这两行修改成模型参数文件的绝对路径,和train.json的绝对路径

改为:

修改gpu_num 根据自己的情况而写

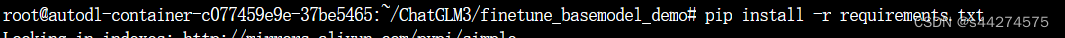

2.3 更新python>3.10,并且安装依赖库

终端输入:

conda install python==3.10.12

进入finetune_basemodel目录安装依赖库

pip install -r requirements.txt

2.4进行微调训练

python finetune.py进行微调:

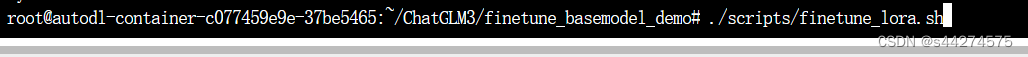

进入finetune_basemod

命令行输入下列添加执行权限给 finetune_lora.sh 脚本

chmod +x ./scripts/finetune_lora.sh

运行脚本:

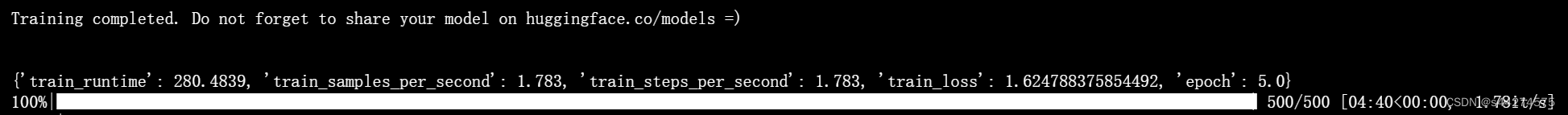

./scripts/finetune_lora.sh微调训练完成:

2.5测试微调结果

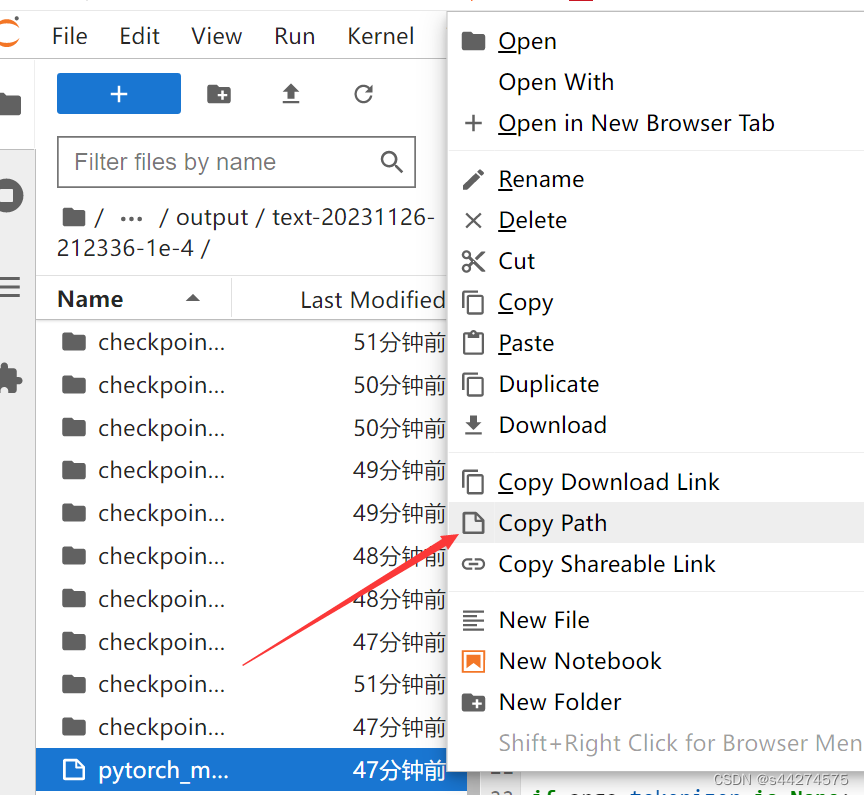

进入ChatGLM3/finetune_basemodel_demo/output/text-20231126-212336-1e-4/pytorch_model.plt 复制改文件路径

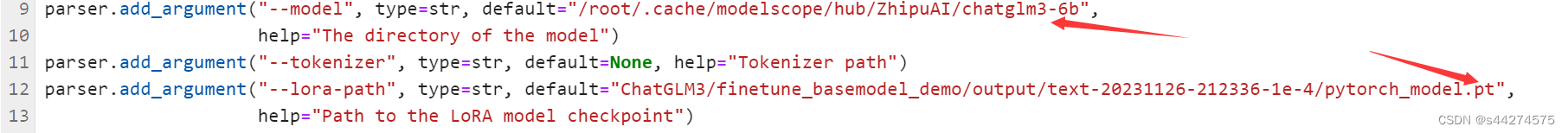

如图修改inference.py 原模型路径和微调参数路径:

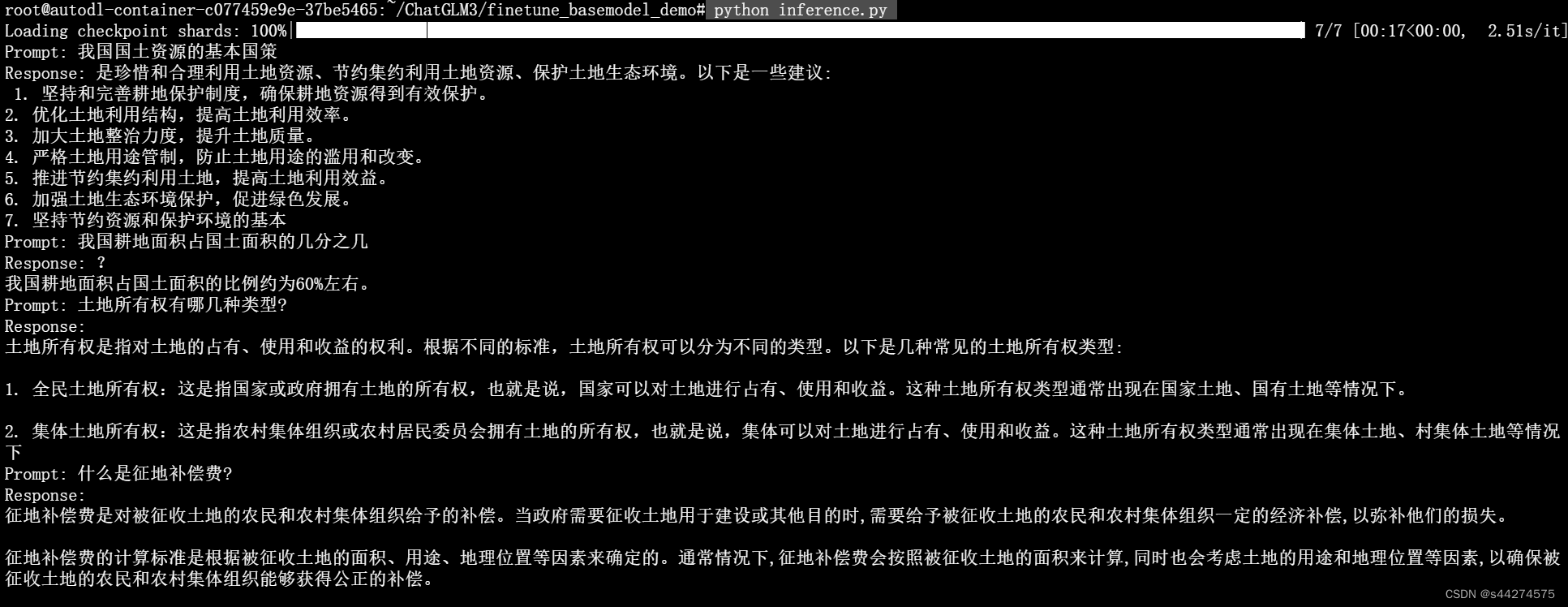

运行测试程序:

python inference.py

微调成功

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)