如何理解FastReid中的IBN?

IBN原论文链接:https://arxiv.org/pdf/1807.09441.pdfIBN是由Instance Normalization(IN)和Batch Normalization构成,有增强学习和泛化能力的作用;BatchNorm:batch方向做归一化,算NHW的均值,对小batchsize效果不好;BN主要缺点是对batchsize的大小比较敏感,由于每次计算均值和方差是在一个b

·

什么是IBN?

IBN原论文链接:https://arxiv.org/pdf/1807.09441.pdf

IBN是由Instance Normalization(IN)和Batch Normalization构成,有增强学习和泛化能力的作用;

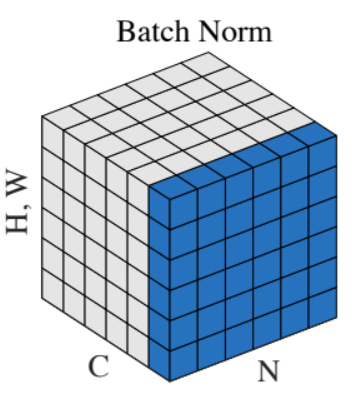

BatchNorm:batch方向做归一化,算NHW的均值,对小batchsize效果不好;BN主要缺点是对batchsize的大小比较敏感,由于每次计算均值和方差是在一个batch上,所以如果batchsize太小,则计算的均值、方差不足以代表整个数据分布;

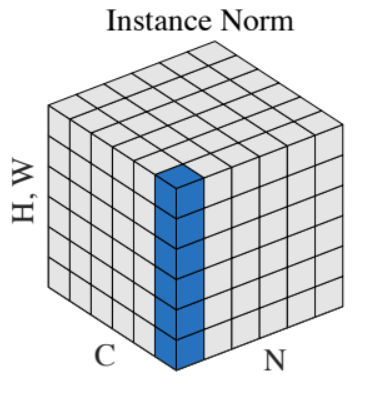

InstanceNorm:一个channel内做归一化,算H*W的均值,用在风格化迁移;因为在图像风格化中,生成结果主要依赖于某个图像实例,所以对整个batch归一化不适合图像风格化中,因而对HW做归一化。可以加速模型收敛,并且保持每个图像实例之间的独立。

IBN实现方法

pytorch代码

class IBN(nn.Module):

def __init__(self, planes, bn_norm, **kwargs):

super(IBN, self).__init__()

half1 = int(planes / 2)

self.half = half1

half2 = planes - half1

self.IN = nn.InstanceNorm2d(half1, affine=True)

self.BN = get_norm(bn_norm, half2, **kwargs)

def forward(self, x):

split = torch.split(x, self.half, 1)

out1 = self.IN(split[0].contiguous())

out2 = self.BN(split[1].contiguous())

out = torch.cat((out1, out2), 1)

return out

调用方法

if with_ibn:

self.bn1 = IBN(planes, bn_norm)

else:

self.bn1 = nn.BatchNorm2d(planes)

更多推荐

已为社区贡献17条内容

已为社区贡献17条内容

所有评论(0)