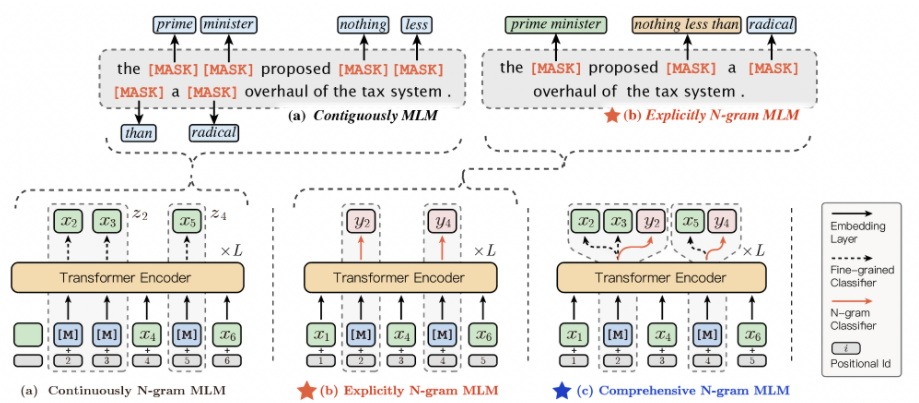

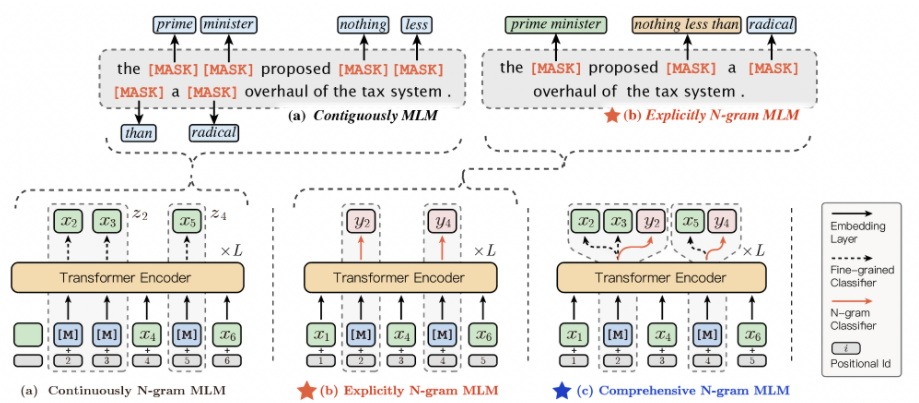

Ernie-gram, 显式、完备的 n-gram 掩码语言模型,实现了显式的 n-gram 语义单元知识建模。

从 ERNIE 1.0 起,百度研究者们就在预训练中引入知识增强学习,通过掩码连续的词、phrase、named entity 等语义知识单元,实现更好的预训练学习。本次开源的通用语义理解模型 ERNIE-Gram 更进一步,提出的显式、完备的 n-gram 掩码语言模型,实现了显式的 n-gram 语义单元知识建模。ERNIE 多粒度预训练语义理解技术作为自然语言处理的基本语义单元,更充分的语言

模型框架

从 ERNIE 1.0 起,百度研究者们就在预训练中引入知识增强学习,通过

掩码连续的词、

phrase、

named entity 等语义知识单元,

实现更好的预训练学习。本次开源的通用语义理解模型 ERNIE-Gram 更进一步,提出的显式、完备的 n-gram 掩码语言模型,实现了显式的 n-gram 语义单元知识建模。

ERNIE 多粒度预训练语义理解技术

作为自然语言处理的基本语义单元,更充分的语言粒度学习能帮助模型实现更强的语义理解能力:

- ERNIE-Gram 提出显式完备的 n-gram 多粒度掩码语言模型,同步建模 n-gram 内部和 n-gram 之间的语义关系,实现同时学习**细粒度(fine-grained)和粗粒度(coarse-grained)**语义信息

- ERNIE-Gram 采用双流结构,在预训练过程中实现了单一位置多语义粒度层次预测,进一步增强了语义知识学习

ERNIE-Gram 多粒度预训练语义理解技术,在预训练 (pre-training) 阶段实现了显式的多粒度语义信号学习,在微调 (fine-tuning) 阶段采用 bert-style 微调方式,在不增加参数和计算复杂度的前提下,取得 10 项英文权威任务的 SOTA。在中文任务上,ERNIE-Gram 在包括 NLI、阅读理解等需要丰富、多层次的语义理解任务上取得公开 SOTA。

ERNIE-Gram 工作已被 NAACL-HLT 2021 作为长文收录,更多细节见 link。

ERNIE-Gram: Pre-Training with Explicitly N-Gram Masked Language Modeling for Natural Language Understanding

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)