简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

ffmpeg默认是使用cpu版的但是机器上有gpu,又不能不充分利用gpu进行加速安装之前需要准备其他环境:(1)cmakeapt install cmake(2)x265_2wget http://ftp.videolan.org/pub/videolan/x265/x265_2.6.tar.gztar -xvf x265_2.6.tar.gzcd x265_v2.6/build/linux/s

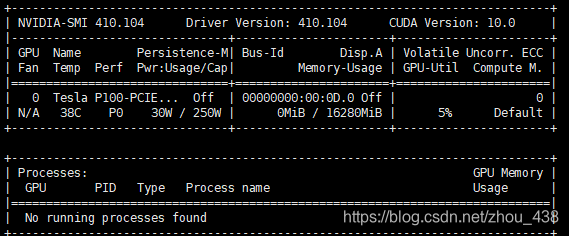

通常情况下,停止进程显存会释放但是如果在不正常情况关闭进程,可能不会释放,这个时候就会出现这样的情况:Mon Oct 19 16:00:00 2020+-----------------------------------------------------------------------------+| NVIDIA-SMI 410.104Driver Version: 410.104CUD

这里使用的是anaconda进行安装,因为anaconda集成了很多插件确实好用很多,省去了很多麻烦一、安装anaconda1)下载安装包https://mirrors.tuna.tsinghua.edu.cn/anaconda/archive/这里我是采用的最新版的2)bash 安装包https://blog.csdn.net/u010414589/article/details/...

apex可以在深度学习训练的时候使用自动混合精度(amp)apex安装直接使用pip install apm能够安装但是不能使用直接使用源码安装就行git clone https://github.com.cnpmjs.org/NVIDIA/apex.gitcd apexpython setup.py install这样就可以使用apex了...

原生的torch是float32的,我们可以借鉴模型量化的思想将其变成float16,而且pytorch自身就定义了半精度的tensor假设我训练的一个模型为model,我们在运算的时候直接将模型转成半精度的模型,怎么做的呢?直接使用model.half()就行model.half()model.cuda()假设我们有个float32的tensor的变量img,为了使用半精度的模型,同样需要将其输

bsds500数据集在轮廓和分割使用很频繁,但是数据本身是保存成.mat的,不是我们常用的图片格式,.mat实际上是一堆json格式的文件,是MATLAB保存的,为了方便我们常规使用,我打算将其转成.jpg数据集下载:链接:提取码:3faz打印.mat文件x=io.loadmat('D:\\BSR_bsds500\\BSR\BSDS500\\data\\groundTruth\...

导入keras_contribfrom keras_contrib.layers.normalization import InstanceNormalization的时候出现这个错误,说明我们没安装此模块ImportErrorTraceback (most recent call last)<ipython-i...

原生的torch是float32的,我们可以借鉴模型量化的思想将其变成float16,而且pytorch自身就定义了半精度的tensor假设我训练的一个模型为model,我们在运算的时候直接将模型转成半精度的模型,怎么做的呢?直接使用model.half()就行model.half()model.cuda()假设我们有个float32的tensor的变量img,为了使用半精度的模型,同样需要将其输

torchscript作为pytorch的模型保留方式这里主要介绍3种类型:1.单变量输入x = torch.randn(1, 3, 256, 256, requires_grad=True).cuda()script_module = torch.jit.trace(model,x,strict=False)torch.jit.save(script_module, "model.pt")2.多

使用TF进行计算,出现:Traceback (most recent call last):File "infer.py", line 14, in <module>logits = classifier.get_output_for(image, None)File "/opt/stylegan2/dnnlib/tflib/network.py", line 219, in get_