简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

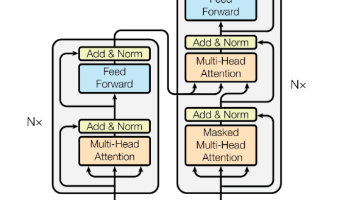

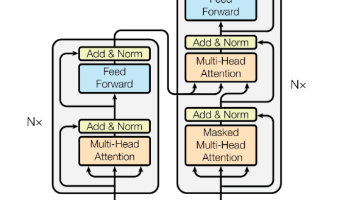

《Attention Is All You Need》提出了一种基于自注意力机制的Transformer架构,完全取代了传统的循环和卷积结构。该模型通过多头注意力机制实现了跨距离的上下文联系,提高了并行计算效率。关键创新包括:1)自注意力机制计算输入序列内部关联;2)多头注意力从不同维度提取信息;3)位置编码处理序列顺序。实验表明该架构性能超越当时SOTA模型,并启发了CV、语音等领域的应用。文章

《Attention Is All You Need》提出了一种基于自注意力机制的Transformer架构,完全取代了传统的循环和卷积结构。该模型通过多头注意力机制实现了跨距离的上下文联系,提高了并行计算效率。关键创新包括:1)自注意力机制计算输入序列内部关联;2)多头注意力从不同维度提取信息;3)位置编码处理序列顺序。实验表明该架构性能超越当时SOTA模型,并启发了CV、语音等领域的应用。文章

本文档详细阐述基于LORA微调的Qwen2.5-vl多模态大模型智能解析系统框图。该系统针对电子工程领域文档自动分析中的数据稀缺与模型低效问题,通过数据收集优化、逻辑解析数据集创建、LORA微调等核心技术,实现系统框图的智能识别分析、逻辑拓扑重构及结果结构化输出,为电子工程领域文档自动化处理提供高效解决方案。

本文档详细阐述基于LORA微调的Qwen2.5-vl多模态大模型智能解析系统框图。该系统针对电子工程领域文档自动分析中的数据稀缺与模型低效问题,通过数据收集优化、逻辑解析数据集创建、LORA微调等核心技术,实现系统框图的智能识别分析、逻辑拓扑重构及结果结构化输出,为电子工程领域文档自动化处理提供高效解决方案。