简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

下载AMD64版本安装完以后需要重启一下电脑,启动DockerDesktop,无需登录(登录需要翻墙),直接进去。

下载AMD64版本安装完以后需要重启一下电脑,启动DockerDesktop,无需登录(登录需要翻墙),直接进去。

2.centos安装yum,可以从指定的服务器自动下载RPM包并且安装,自动处理依赖性关系并且直接安装所需要的所有依赖,省时省力。我先用的测试,基础模型是llama2,但是后续测试发现问题一直不回答,就换成了小模型qwen:0.5b-chat再测试就可以了。第二部创建知识库,根据你自己需要的内容去导入文档,不是所有的格式都能导入,我使用的是txt。总结一下,问了几个问题,有点傻瓜了,回答的牛头不对

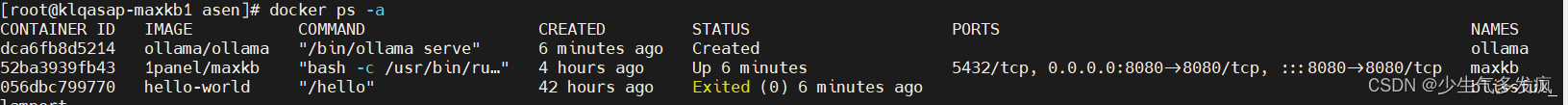

输入命令 dockerstartID去启动需要的容器,但是出现端口被占用,后面无论怎么杀进程(ss -lntup | grep 端口 命令可以查看这个端口下的进程,kill -9 pid杀死进程),总是会出现新的进程。输入命令 docker ps -a,可以看到有三个,我们需要maxkb和ollama,但是maxkb的status不是启动状态。在maxkb里面添加ollama模型时,API域名无效

2.centos安装yum,可以从指定的服务器自动下载RPM包并且安装,自动处理依赖性关系并且直接安装所需要的所有依赖,省时省力。我先用的测试,基础模型是llama2,但是后续测试发现问题一直不回答,就换成了小模型qwen:0.5b-chat再测试就可以了。第二部创建知识库,根据你自己需要的内容去导入文档,不是所有的格式都能导入,我使用的是txt。总结一下,问了几个问题,有点傻瓜了,回答的牛头不对

下载AMD64版本安装完以后需要重启一下电脑,启动DockerDesktop,无需登录(登录需要翻墙),直接进去。

下载AMD64版本安装完以后需要重启一下电脑,启动DockerDesktop,无需登录(登录需要翻墙),直接进去。

下载AMD64版本安装完以后需要重启一下电脑,启动DockerDesktop,无需登录(登录需要翻墙),直接进去。

2.centos安装yum,可以从指定的服务器自动下载RPM包并且安装,自动处理依赖性关系并且直接安装所需要的所有依赖,省时省力。我先用的测试,基础模型是llama2,但是后续测试发现问题一直不回答,就换成了小模型qwen:0.5b-chat再测试就可以了。第二部创建知识库,根据你自己需要的内容去导入文档,不是所有的格式都能导入,我使用的是txt。总结一下,问了几个问题,有点傻瓜了,回答的牛头不对